社会性发展迟滞大学生的情绪韵律识别特点 *

刘建榕 谢林君 郑 琳

(1 福建师范大学心理学院,福州 350117) (2 福建省心之力心理学研究院,福州 350025)

1 引言

个体适应社会生活所发展出相关能力与品质的过程称之为个体的社会性发展(social development,SD)(陈会昌, 1994)。无论个体的认知发展状况如何,只要其SD 未能表现出该阶段应具有的发展状态即为广义的社会性发展迟滞。狭义的社会性发展迟滞为认知发展正常,仅SD 水平低于同龄人的状态(刘建榕, 连榕, 2012)。本研究的对象属于狭义社会性发展迟滞个体。

情绪韵律(emotional prosody)是一种独立于言语内容之外的情感信息,即不考虑词汇意义和句法结构,仅靠不同声学参数线索的变化反映个体不同情绪状态的情感信息(Monrad-Krohn, 1947)。它在个体社会化过程中起着重要作用,如在婴幼儿时期情绪韵律能为个体提供重要的情感信息;5 个月大的婴儿就对积极与消极的声音有不同的行为反应(Fernald, 1992)。情绪韵律识别具有跨文化一致性,以英语为母语的被试识别用五种语言(英、德、汉、日语和塔加拉族语)录制的四种情绪韵律(喜、怒、悲、惧),结果显示被试对所有语言中的情绪韵律识别准确性均高于随机水平(Thompson & Balkwill, 2006)。可见,个体虽会受到自身语言与文化的限制,但对情绪韵律的识别是独立于言语理解之外的能力(Pell et al., 2009)。

对他人情绪的理解与个体的SD 息息相关。大学生处于刚完成自我同一性的建立,正为建立亲密关系做准备的阶段。此时,个体若能准确解读他人情绪,并做出恰当的反应,则有助于其建立亲密感。但研究发现,社会性发展迟滞大学生(college students with social delay, CSSD)情绪识别能力不足(魏碧芬, 2017)。在CSSD 的面孔情绪识别方面探究发现,CSSD 对他人面部表情的识别能力比正常个体更弱(刘建榕 等, 2018)。在六种基本面部表情中,CSSD 对愤怒表情存在识别困难的情况,这种面部表情识别障碍可能是由其在认知上无法准确感知情境中的重要视觉线索,在行为上消极逃避所造成的(魏碧芬, 2017)。除面部表情传达情绪外,声音也是传达情绪常用的媒介,那么,CSSD 在听觉通道上的情绪韵律识别又有何特点?CSSD 与社会性发展正常大学生的情绪韵律识别是否会存在差异?本研究在CSSD 面孔情绪加工研究的基础上,进一步明确CSSD 对声学情绪线索的认知特点。

以往研究发现,个体在对他人状态解读时依赖韵律信息,即存在情绪韵律识别偏好(Hortaçsu &Ekinci, 1992)。当他人所传递的情绪韵律与语义信息相矛盾时,语义信息在一定程度上影响个体对他人情绪的判断。以往研究采用词-韵律干扰范式,要求被试在快乐、恐惧、厌恶、惊讶、愤怒五种情绪句子与韵律一致与否的情况下判断韵律情绪种类,发现正常被试对情绪韵律识别的准确性显著高于孤独症患者,尤其是在情绪韵律与语义不一致的情况下(Stewart et al., 2013)。同时,CSSD 在与人交谈过程中易受无关信息干扰(连榕,刘建榕, 2014),且有时抓不住对方话语中的重点(刘建榕, 连榕, 2014),以不太恰当的方式与人交往,造成社交困难。以上问题是否与CSSD 无法有效整合他人韵律与语义中的情绪信息有关?语义线索对CSSD 的情绪韵律识别又存在什么影响?在语音通话逐渐成为主要交流方式的今天,语义判断显得尤为重要。因此本研究通过控制词与韵律之间的一致性程度,探讨语义对CSSD 的情绪韵律加工存在何种影响。

2 实验1:CSSD 情绪韵律识别的基本特点

实验1 采用分类范式研究CSSD 是否对不同情绪韵律的敏感性不同,以及CSSD 对情绪韵律的辨别是否与社会性发展正常大学生存在差异。本研究提出假设1:CSSD 对不同情绪韵律的识别存在差异;假设2:CSSD 比对照组的情绪韵律识别的准确性更低。

2.1 研究方法

2.1.1 被试

使用大学生社会性发展水平评定量表(修订版),在高校中随机发放问卷701 份,回收有效问卷666 份,其中CSSD75 名(男17 名)。从75 名CSSD 中抽取迟滞组29 名(男10 名),平均年龄20.86±0.95 岁,社会性发展水平量表得分为8.32±0.57,属于发展迟滞;从其他被试中抽取对照组30 名(男12 名),平均年龄20.10±1.42 岁,量表得分为10.83±0.87,属于发展中等。两组量表得分差异显著,t=12.89,p<0.001。

2.1.2 实验设计

采用2(SD 水平:迟滞组、对照组)×5(情绪韵律:高兴、悲伤、愤怒、厌恶、恐惧)混合实验设计,SD 水平为被试间变量,情绪韵律为被试内变量,因变量为反应时和正确率。

2.1.3 实验材料

大学生社会性发展水平评定量表(修订版)。采用刘建榕(2012)编制的大学生社会性发展水平评定量表,5 点计分,因该量表项目冗长且随时间的推移项目的实效性有所减弱,故本研究以此为蓝本进行修订。基于1078 名高校大学生对该量表结果进行项目分析、探索性因素分析、验证性因素分析、信度分析和相关分析,保留34 个项目,归纳为3 个因素。修订后的量表信效度良好,Cronbach’s α 系数为0.92;结构拟合良好:NC(χ2/df)=3.67,RMSEA=0.07,GFI=0.97,AGFI=0.93,TLI=0.95,CFI=0.98。此次施测的Cronbach’s α 系数为0.90。量表总分3~6 分表示发展较严重迟滞;6~9 分表示发展迟滞;9~12 分表示发展中等;12~15 分表示发展良好。

中性词材料。从《新编现代汉语词典》(吉林教育出版社, 2008 年版)选取250 个中性双字词,15 名不参与实验的被试从愉悦度、唤醒度、具体性、熟悉性方面对词汇进行7 点评定(实验2 的情绪词汇材料一同评定),1 为“非常不”,4 为“中等”,7 为“非常”。有效数据为13 份,1 个中性词因被重复评定将其删除,最终参与评定为248 个中性词。删除所有维度评分在3 个标准差以外的词汇,剩余词汇按愉悦度从小到大排列,再以愉悦度4 分为中心进行词汇筛选,愉悦度评分相同则以熟悉性高、唤醒度低的词汇优先,最终筛选出50 个词汇。

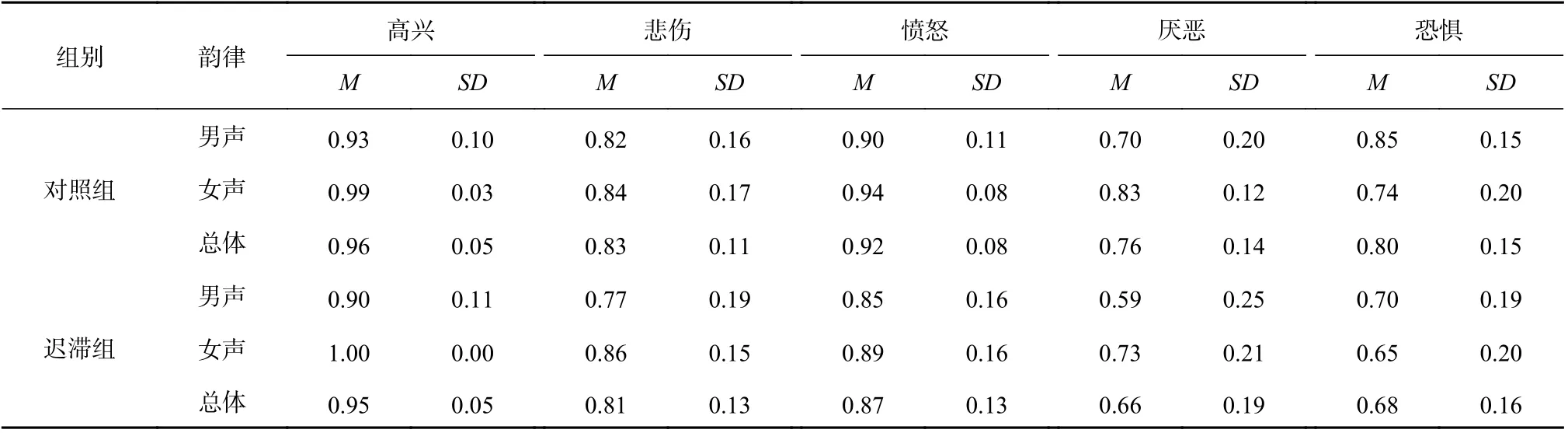

情绪韵律材料。男、女专业配音员各1 名,分别用高兴、悲伤、愤怒、惊讶、厌恶、恐惧六种情绪朗读25 个中性词并录制。录制全程在隔音房中进行,语音材料采样频率为44.1 kHz,采样精度为16 bit。使用音频编辑软件Adobe Audition CC 2018 进行降噪处理及语音剪切,最终录制男、女声音频各150 个。为确保韵律材料符合情绪要求,邀请15 名(男7 名)不参与实验的被试对音频进行情绪识别,被试平均年龄为20.80±2.73 岁。因被试难以准确识别惊讶情绪韵律,故正式实验将惊讶情绪韵律的识别删除。在每种情绪韵律中随机选取20 个音频(男声10 个;抽象词10 个),共100 个音频作为正式实验材料。最终情绪韵律材料识别正确率见表1。用Praat 软件对实验材料的声学线索进行分析,各情绪韵律在音强、音高、音长这些韵律要素方面均存在显著差异,ps<0.001。高兴与愤怒韵律的音强显著高于厌恶、恐惧及悲伤韵律,愤怒韵律呈现最高音强;高兴、愤怒、恐惧韵律表现出较高的音高,厌恶与悲伤韵律表现出较低的音高;厌恶与悲伤韵律表现出较长的音长,愤怒韵律表现出较短的音长,与前人研究相符(Juslin & Laukka, 2001)。

表1 实验1 情绪韵律材料识别正确率及其声学特征(M)

2.1.4 实验程序

被试在实验室内单独测验。使用耳机给被试双耳传递音频,音频呈现软件为E-Prime 3.0。实验分为练习(20 个试次,单个试次流程与正式实验一致,若被试在练习阶段正确率低于80% 则继续练习)与正式实验(2 个组块,男、女声各一个组块,每个组块50 个试次,共100 个试次)。单个试次流程:红色注视点“+”呈现在屏幕中心800 ms,接着播放情绪韵律刺激,要求被试做出分类判断并进行按键反应。被试做出判断后,注视点消失,呈现空屏,800 ms 后进入下一个试次。若被试未在5000 ms 内做出判断,则直接进入下一个试次。为消除顺序效应,在被试间对情绪韵律材料和两个组块的呈现顺序进行完全随机化处理。实验约15 分钟。

2.1.5 数据收集与处理

数据整理,剔除数据标准:(1)剔除错误反应的反应时数据;(2)剔除每组条件下超过2.5 个标准差的反应时数据(方丹, 2016)。最终有效被试数据为对照组和迟滞组各27 人。所有实验数据使用E-Prime 3.0 采集,通过Excel 2016 与SPSS22.0整理与分析,并使用OriginPro 9.1 进行作图。

2.2 结果

2.2.1 不同SD 水平大学生的情绪韵律识别正确率

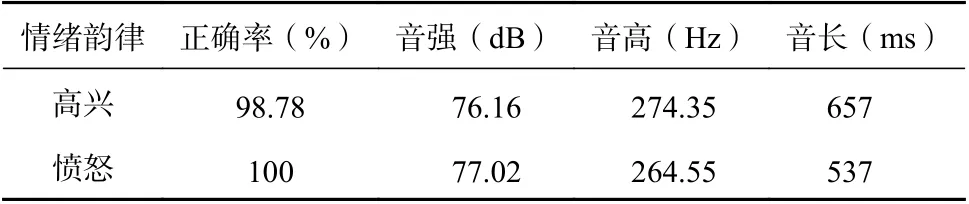

不同SD 水平大学生的情绪韵律识别正确率的描述性统计如表2 所示。

表2 不同SD 水平大学生对不同情绪韵律的识别正确率

重复测量方差分析表明,SD 水平主效应显著,F(1, 51)=9.08,p<0.01,=0.15,进一步检验发现,对照组识别正确率显著高于迟滞组被试;情绪韵律主效应显著,F(4, 204)=4.91,p<0.01,=0.09,进一步检验发现,被试对厌恶与恐惧的识别正确率不存在显著性差异,其余情绪韵律两两间均存在显著差异,具体为:被试对高兴韵律的识别正确率最高,接着是愤怒、悲伤、恐惧和厌恶韵律。SD 水平与情绪韵律的交互作用显著,F(4, 204)=2.50,p<0.05,=0.05,简单效应检验发现,在识别厌恶和恐惧韵律时,两组被试识别正确率存在显著差异,F(1, 52)厌恶=5.16,p<0.05,=0.09;F(1, 52)恐惧=8.43,p<0.01,=0.14,对照组对厌恶与恐惧韵律的识别显著高于迟滞组;两组被试对高兴、悲伤、愤怒韵律的识别不存在显著差异,ps>0.05。

不同SD 水平大学生在不同性别的韵律类型中识别正确率的配对样本t检验。对照组在对不同性别类型的高兴、厌恶与恐惧韵律的识别上存在差异,t(26)高兴=-2.75,p=0.011,Cohen’sd=0.53;t(26)厌恶=-3.72,p=0.010,Cohen’sd=0.72;t(26)恐惧=2.98,p=0.006,Cohen’sd=0.57;对照组对女声的高兴与厌恶韵律识别好于对男声的识别,而对男声的恐惧韵律识别好于对女声的识别。迟滞组在不同性别类型的高兴与厌恶韵律的识别上存在差异,t(26)高兴=-5.11,p<0.001,Cohen’sd=0.98;t(26)厌恶=-2.66,p=0.013,Cohen’sd=0.58;CSSD 对女声的高兴与厌恶韵律识别好于对男声的识别。

2.2.2 不同SD 水平大学生的情绪韵律识别反应时

不同SD 水平大学生的情绪韵律识别反应时的描述性统计结果如表3 所示。

表3 不同SD 水平大学生对不同情绪韵律正确反应的反应时(ms)

不同SD 水平大学生对不同情绪韵律正确反应的反应时进行重复测量方差分析,结果显示SD 水平主效应不显著,p=0.084;情绪韵律主效应显著,F(4, 204)=20.01,p<0.001,=0.28,进一步检验发现,被试对悲伤与恐惧韵律的识别反应时差异不显著,剩余情绪韵律两两之间均存在显著差异,具体为:被试对高兴韵律的识别速度最快,随后是愤怒、恐惧、悲伤和厌恶韵律;SD 水平与情绪韵律的交互作用不显著,p=0.861。

3 实验2:CSSD 的情绪韵律识别受语义影响的程度

实验1 关注没有语义情绪干扰下,CSSD 在识别情绪韵律时表现出的基本特征。在日常交流中常有语义情绪不一致的情况,恰当的情绪韵律能增强语义线索,能提高他人对说话者意图的理解(钟毅平 等, 2011)。实验2 采用词-韵律干扰范式探究语义中的情绪信息是否会对不同SD 水平大学生的情绪韵律识别造成不同影响,以及不同情绪效价的语义线索造成的影响是否存在差异。本研究提出假设3:不同的语义线索对CSSD 的影响不同,CSSD 在语义与韵律不一致比语义与韵律一致的情况下更容易受到干扰;假设4:相比对照组,语义情绪线索对CSSD 的影响更大。

3.1 研究方法

3.1.1 被试

被试抽取方法同实验1,迟滞组共29 名(男10 名),平均年龄20.86±0.95 岁,使用大学生社会性发展水平评定量表(修订版)测量得分为8.32±0.57,属于发展迟滞;对照组共30 名(男12 名),平均年龄20.19±1.42 岁,量表得分为10.89±0.87,属于发展中等。两组量表得分差异显著,t=13.20,p<0.001。

3.1.2 实验设计

采用2(SD 水平:迟滞组、对照组)×2(词-韵律一致性:一致、不一致)两因素混合实验设计,SD 水平为被试间变量,词-韵律一致性为被试内变量,因变量为反应时和正确率。

3.1.3 实验材料

大学生社会性发展水平评定量表(修订版)。同实验1。

情绪词汇材料。情绪词汇抽取方法和筛选同实验1,抽取数量略有不同。从《新编现代汉语词典》选取积极和消极双字词各100 个,最终筛选出的50 个词汇材料平均分为:消极词愉悦度1.84±0.16,积极词愉悦度5.68±0.30,二者愉悦度差异性显著,t=-80.45,p<0.001;消极词唤醒度4.65±0.49,积极词唤醒度4.78±0.43,二者唤醒度差异不显著,t=-1.42,df=98,p>0.05;消极词熟悉性5.91±0.32,积极词熟悉性5.98±0.39,二者熟悉性差异不显著,t=-1.06,p>0.05;具体性方面,消极具体词5.76±0.67,消极抽象词3.47±0.49;积极具体词5.90±0.67,积极抽象词3.65±0.27。

情绪韵律材料。情绪韵律材料录制方法同实验1,录制数量略有不同,男女专业配音员分别用高兴和愤怒情绪朗读积极词、消极词各25 个并录制,最终录制男女声音频各100 个。删除识别正确率低于80%的音频,最终选取80 个音频作为正式实验材料,男女声各占一半。具体包括:40 个词-韵律一致音频,即积极-高兴音频、消极-愤怒音频各20 个;40 个词-韵律不一致音频,即积极-愤怒音频、消极-高兴音频各20 个。用Praat 软件对音频进行分析,其具体声学特征见表4。相比于高兴韵律,愤怒韵律的音强更强,音长更短,t音强=-0.39,p<0.05;t音长=5.76,p<0.001;二者在音高上没有显著差异,p>0.05。

表4 实验2 情绪韵律材料识别正确率及其声学特征(M)

3.1.4 实验程序

被试在实验室单独测验。使用耳机给被试双耳传递音频,音频呈现软件为E-Prime 3.0。实验包括练习(16 个试次)与正式实验(2 个组块,男女声各1 个组块,每个组块有40 个试次)。试次流程同实验1。为消除顺序效应,在被试间对情绪韵律材料和2 个组块的呈现顺序进行随机化处理,并对按键顺序进行了平衡处理。实验全程约10 分钟。

3.1.5 数据收集与处理

正式数据分析之前,对数据进行整理,剔除每种条件超过2.5 个标准差的反应时数据,最终有效被试数据为对照组29 人,迟滞组28 人。所有实验数据使用E-Prime 3.0 采集,通过Excel 2016 与SPSS22.0 整理与分析,并使用OriginPro 9.1 进行作图。

3.2 结果

3.2.1 韵律判断下不同SD 水平大学生的情绪韵律识别正确率

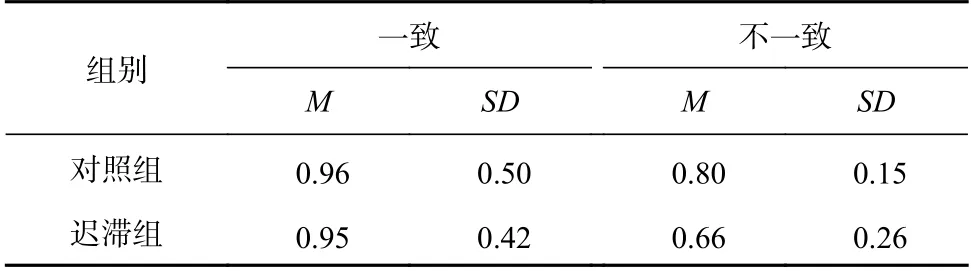

以韵律判断为标准,对迟滞组与对照组的判断正确率进行描述性统计分析,结果如表5 所示。

表5 韵律判断下不同SD 水平大学生的情绪韵律识别正确率

重复测量方差分析表明,SD 水平主效应显著,F(1, 55)=6.15,p<0.05,=0.10,进一步检验发现,对照组被试的识别正确率显著高于迟滞组被试;情绪韵律主效应显著,F(1, 55)=70.17,p<0.001,=0.56,进一步检验发现,相比于词-韵律不一致的情况下,被试在词-韵律一致的情况下对情绪韵律的识别正确率更高。SD 水平与词-韵律一致性的交互作用显著,F(1, 55)=5.44,p<0.05,=0.09,简单效应检验发现,在词-韵律一致条件下,两组被试对韵律的识别正确率没有显著差异,p>0.05,但在词-韵律不一致条件下,对照组对韵律的识别正确率显著高于迟滞组对韵律的识别正确率,F(1, 55)=6.07,p<0.05,=0.10。

比较不同性别韵律条件下,对照组与迟滞组的情绪韵律识别情况,独立样本t检验结果显示,当韵律类型为男声时,对照组与迟滞组在词-韵律一致与不一致条件下的情绪韵律识别正确率均存在显著差异,t(55)男声一致=2.44,p<0.05,Cohen’sd=0.65;t(40.21)男声不一致=2.04,p<0.05,Cohen’sd=0.54,CSSD 的情绪韵律识别正确率显著低于对照组。当韵律类型为女声时,对照组与迟滞组在词-韵律一致条件下的情绪韵律识别正确率不存在显著差异,p=0.714;而在词-韵律不一致条件下的情绪韵律识别正确率存在显著差异,t(44.74)女声不一致=2.49,p<0.05,Cohen’sd=0.66,迟滞组的情绪韵律识别正确率显著低于对照组。再比较不同词-韵律一致性条件下,两组大学生对男女声韵律识别的情况,配对样本t检验结果显示,无论是词-韵律一致还是不一致的条件下,对照组与迟滞组对男声韵律与女声韵律的识别均不存在显著差异,ps>0.05。

3.2.2 韵律判断下不同SD 水平大学生的情绪韵律识别反应时

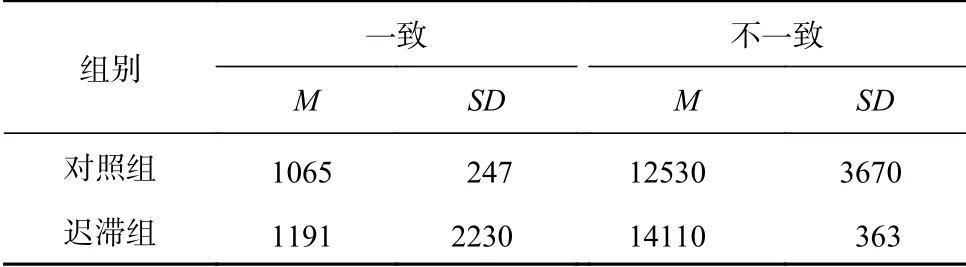

以韵律判断为标准,对迟滞组与对照组的识别反应时描述性统计结果如表6 所示。

表6 韵律判断下不同SD 水平大学生的情绪韵律识别反应时(ms)

对情绪韵律识别反应时进行重复测量方差分析。结果显示,SD 水平主效应不显著,p=0.068。词-韵律一致性的主效应显著,F(1, 55)=3.48,p<0.001,=0.48,进一步检验发现,相比于词-韵律一致的情况下,被试在词-韵律不一致的情况下,对情绪韵律的识别反应时更慢。SD 水平与词-韵律一致性的交互作用不显著,p=0.585。

4 讨论

4.1 CSSD 情绪韵律识别的基本特点

CSSD 情绪韵律识别的准确性显著低于对照组。以往研究也发现,CSSD 对面孔情绪识别的正确率显著低于对照组(刘建榕 等, 2018),他们在情绪识别方面存在困难,可能是因为他们的心智化能力(mentalizing)存在障碍,如连榕和刘建榕(2014)发现CSSD 在进行人际交往时,与他人互动较少,容易心不在焉,难以准确捕获他人传递的信息。根据Baron-Cohen(2005)的心智化模型,个体随着年龄增长会发展出越来越复杂的心智化能力。但CSSD 可能在共享注意机制上存在缺陷,难以整合觉察器提供的信息,导致其在情绪韵律识别过程中,不能有效地提取关键的声学线索,从而造成其情绪韵律识别困难。

CSSD 的情绪韵律识别趋势与对照组一致,正确率方面依次为高兴、愤怒、悲伤、恐惧与厌恶韵律。首先,被试对高兴韵律的识别成绩最好,这可能是因为实验中只有高兴韵律属于积极情绪,在没有相似情绪干扰下,高兴韵律的识别障碍相对较小(Juslin & Laukka, 2001)。其次,迟滞组被试对愤怒韵律的识别准确率与识别速度都仅次于高兴韵律。情绪识别包括面部表情的识别、情绪韵律和肢体情绪的识别等,情绪韵律能够实时地调节口语情绪词的识别,从而调节口语情绪词的加工(郑志伟 等, 2013),因此迟滞组被试也许在用声音线索来弥补视觉线索中对愤怒情绪搜索不足的影响。最后,CSSD 对厌恶韵律的识别准确性与识别速度都最差,且正确率显著低于对照组。在SD 方面,CSSD 与孤独症患者、述情障碍者有许多相似的特征,如与他人相处时难以识别他人情绪,也难以针对他人情绪做出恰当反应等(刘建榕, 2012; Heaton et al., 2019)。如前文所述,这可能是因为迟滞个体大脑中缺少复杂的韵律图式,难以有效地提取关键的声学线索与之相匹配,最终造成了其对厌恶韵律的识别障碍。

4.2 CSSD 情绪韵律识别受语义影响的程度

不同SD 水平的大学生的情绪韵律识别都会受到语义影响,但CSSD 比对照组更容易受到语义干扰,此研究结果符合实验假设。现实中人们常遇到语义信息与声音情绪不一致的情况,而在此时,个体更倾向于依据声音中的情绪线索而非话语内容来判断说话者的情绪(Hortaçsu & Ekinci,1992)。实验2 中CSSD 与对照组在判断说话者情绪时,对韵律线索的判断均大于随机水平(0.5),可见,不同SD 水平大学生在面对词-韵律不一致的情况时,都更倾向于通过韵律来判断他人情绪。

同时,本研究发现,当词-韵律一致时,迟滞组与对照组的情绪韵律识别没有显著差异;但当词-韵律相矛盾时,迟滞组比对照组更易依据语义来判断说话者情绪。Stewart 等(2013)的研究发现,孤独症患者在词-韵律不一致的情况下,更容易依赖语义线索对情绪进行判断。Castagna 等(2013)对于精神分裂症患者的研究也发现,当要求被试将注意力集中于声音所表达的情感上,忽略句子所代表的(不一致的)意义时,精神分裂症患者的成绩显著差于正常被试。说明CSSD 也同这些特殊个体一样,在进行情绪韵律识别时更容易表现出语义依赖效应。研究结果帮助了解CSSD 的情绪识别缺陷也存在于声学刺激识别的层面,为后续的综合干预提供了一定方向与启示。

迟滞个体对语义进行加工可能是一种替代性补偿。Schirmer 和Kotz(2006)认为个体在情绪韵律加工后期需要将声学线索中的情绪信息与语义线索中的情绪信息相整合,最终达成对他人情绪的理解。CSSD 智力正常,不存在语义方面的认知障碍,但在提取与识别他人传递的情绪韵律信息时存在困难,故他们可能在情绪韵律与语义线索相矛盾时,用语义线索的加工弥补其在情绪韵律识别方面的缺陷。郑志伟等(2013)的研究发现情绪韵律可以调节情绪词的音韵编码,因此迟滞个体可以将情绪韵律当作背景信息使用,对词汇在语义记忆中进行激活和选择,从而实现对语义加工的补偿。

本研究主要通过行为实验的方法,对被试外显的行为数据指标进行考察,虽在一定程度上揭示了不同SD 水平大学生在情绪韵律识别上的差异,但仍未能了解其内在的加工机制。研究已发现个体在进行情绪韵律加工时,存在右半球优势效应(Grandjean, 2021),故未来的研究可考虑结合ERP、fMRI 等技术,从认知神经科学角度对CSSD 在情绪韵律识别时的神经机制进行探索。

5 结论

(1)CSSD 情绪韵律识别正确率趋势与对照组一致,从高到低分别为高兴、愤怒、悲伤、恐惧和厌恶韵律,但CSSD 情绪韵律识别正确率显著低于对照组,尤其是在恐惧、厌恶韵律上。(2)词-韵律矛盾时,CSSD 比对照组更容易受语义干扰。