利用Re-YOLOv5和检测区域搜索算法获取大豆植株表型参数

郭希岳,李劲松,郑立华,张 漫,2,王敏娟,2

利用Re-YOLOv5和检测区域搜索算法获取大豆植株表型参数

郭希岳1,李劲松1,郑立华1,张 漫1,2,王敏娟1,2※

(1. 中国农业大学智慧农业系统集成研究教育部重点实验室,北京 100083;2. 中国农业大学烟台研究院,烟台 264670)

为了解决目标检测区域中冗余信息过多导致无法准确检测大豆分枝的缺陷,同时快速获取大豆植株表型参数,该研究提出了一种基于Re-YOLOv5和检测区域搜索算法的大豆植株表型参数获取方法。Re-YOLOv5引入圆形平滑标签技术(Circular Smooth Label,CSL)实现旋转目标检测,解决了传统目标检测中检测区域冗余信息过多导致无法准确检测大豆分枝的缺陷,并加入协调注意力机制(Coordinate Attention,CA)获取目标位置信息以提升检测精度,此外,将原始骨干网络中的3×3卷积结构替换为RepVGG结构进一步增强模型的特征提取能力。基于Re-YOLOv5提出一种检测区域搜索算法(Detection Area Search,DAS),该算法将检测到的大豆分枝区域作为待搜索区域,通过该区域中的茎节点坐标信息判断各分枝的茎节点,然后将其进行顺序连接,重构大豆植株骨架,最终获取相关的表型参数。试验结果表明,Re-YOLOv5可以实现检测旋转目标的能力,而且在各项性能指标上都优于YOLOv5,其mAP提升了1.70个百分点,参数量下降0.17 M,针对茎节点的检测精确率提升了9.90个百分点,检测小目标的能力明显增强。检测区域搜索算法也能够准确地定位每个分枝上的茎节点从而重构大豆植株骨架,并得到比较准确的大豆植株表型参数,其中,株高、茎节点数、大豆分枝数的平均绝对误差分别为2.06 cm、1.37个和0.03个,在能够满足实际采集的精度要求的同时,也为获取大豆植株表型信息提供参考。

模型;算法;大豆植株;目标检测;YOLOv5;区域搜索

0 引 言

中国大豆主要依赖进口[1],究其原因,是国产大豆在产量、出油率等方面都不及进口大豆,因此,选育国产优质高产大豆品种就成了提升中国大豆质量的关键任务。目前,选育大豆品种最主要也是最重要的参考依据是大豆的各类表型信息。使用传统方法获取大豆表型信息时,育种学家只能实际测量大豆植株来获得大豆表型参数,并绘制记录大豆的性状,其具有费时、成本过高、所得数据量小及数据丢失的缺点,不利于推广应用。

随着计算机技术和图像处理技术的不断发展,将其应用于农业领域,以实现农业领域中的自动化提取表型信息成为了当前的研究热点,具有巨大的发展潜力[2-3],目标检测作为计算机技术中的一个热门领域,已经在农业中获得了广泛的应用,例如,精准农业中的作物检测[4]、植物病虫害检测[5-6]、大豆豆荚检测[7]等。目前,目标检测主要有传统目标检测方法和基于深度学习的目标检测方法。其中,传统目标检测方法主要有尺度不变特征变换(Scale Invariant Feature Transform,SIFT)[8]特征检测器、提取目标对象的方向梯度直方图(Histogram of Oriented Gradient,HOG)[9]特征、支持向量机(Support Vector Machine,SVM)[10]等进行特征识别。但是,传统目标检测算法检测流程较为复杂,需多个步骤共同完成,耗时较长,且其通常采用滑动窗口方式进行特征提取。不同检测对象的大小不同,在使用固定尺寸的窗口进行特征提取时会导致选取的特征提取区域相较于检测对象过大或过小。特征提取区域过大会造成所包含的冗余信息过多,过小则只能提取检测对象的部分特征,导致出现误检或漏检,造成检测精度下降,识别效果降低。

为了避免此种情况则需针对不同检测对象设计不同尺寸的滑动窗口,这不仅增加计算量,运行速度也会下降。因此,传统目标检测算法具有检测精度低、计算量大、运行速度慢等缺点,已不能很好地满足目前目标检测所要求的高精度、速度快的要求。深度学习所拥有的强大特征提取能力以及快速的数据处理能力能够有效弥补传统方法的不足,随着深度学习在图像领域中的迅速发展,越来越多的研究人员将其应用于农业领域的目标检测中。Liu等[11]基于双目立体视觉和改进YOLOv3网络用于检测与定位自然环境中的菠萝,改进后YOLOv3在所有测试模型中表现最好,其平均精度达到了0.91。文献[12]将YOLOv4与卷积神经网络(Convolutional Neural Networks, CNN)结合,用于检测大豆上的成年粉虱,以此确定粉虱的生长阶段,该方法的精确度达到了0.96,比原始YOLOv4高出0.15。彭红星等[13]开发出基于多重特征增强和特征融合的SSD(Single Shot MultiBox Detector)用于荔枝检测,精确、有效地实现了对无人机拍摄的荔枝图像检测,也为小目标农作物的检测开拓了思路。目前,基于深度学习的目标检测算法主要分为两类,一类是基于区域候选的目标检测算法,也称为二阶段目标检测方法,其通过形成一系列候选区域作为样本,再利用CNN[14]进行分类,如R-CNN[15](Convolutional Neural Network)、Faster R-CNN[16](FasterConvolutional Neural Network)、R-FCN[17](Region-based Fully Convolutional Network)等。另一类是基于一体化卷积网络的算法,也称为单阶段目标检测方法,该算法将物体边界框的定位问题转化为分类问题,不需要生成候选区域,其标志性算法包括SSD[18]和YOLO[19]系列。相比于二阶段目标检测方法,由于单阶段目标检测方法直接作用于整张图片上,不需要候选区域,因此具有较快的检测速度,使得本研究更倾向于使用单阶段目标检测算法。YOLOv5作为典型的单阶段目标检测算法,具有检测精度高、推理速度快的特点,其检测速度最快可达到140帧/s[20],并且可以针对全局信息进行编码,减少背景对检测精度所造成的误差,因此具有很强的泛化性,而且相比于SSD等单阶段目标检测算法,其在小目标的检测上更有优势[21]。本研究要获取的大豆表型信息包括大豆茎节点数,是典型的小目标。

但是,使用YOLOv5进行大豆分枝和茎节点检测,会造成分枝候选框内冗余信息过多,进而影响检测精度,无法准确检测大豆分枝。此外,在同一分枝检测框中可能会包含其他分枝的茎节点信息,也会对后续判断茎节点所属分枝造成影响。为了解决上述问题同时能够快速、准确地获取大豆植株的表型信息,本研究提出一种Re-YOLOv5,在YOLOv5的Neck部分引入圆形平滑标签技术(Circular Smooth Label,CSL)使其能够检测旋转目标的模型,使检测框中所包含的冗余信息大大减少,使其能够最大程度地减少分枝检测区域中的冗余信息,使后续获取表型信息更加方便快捷。为了弥补引入CSL所带来的精度不足问题,本研究添加了协调注意力机制(Coordinate Attention,CA)用于嵌入目标的位置信息并扩展了特征提取的范围,然后利用RepVGG结构替换骨干网络(backbone)中的卷积操作,利用其多分枝卷积结构进行特征提取,并将不同卷积层所提取的特征进行融合,进一步增强了模型的特征提取能力。在后续的大豆植株表型获取中,本研究将已经得到的大豆分枝检测区域作为搜索区域,利用检测区域搜索算法对其进行搜索,从而得到每个分枝区域中的茎节点信息,对每个区域中的茎节点进行重新分类,依据这些坐标与类别信息重构大豆植株的骨架,进而得到株高、分枝数、茎节点数等表型参数,也为进一步获取分枝夹角、大豆株型等表型信息提供了基础。

1 材料与方法

1.1 数据采集

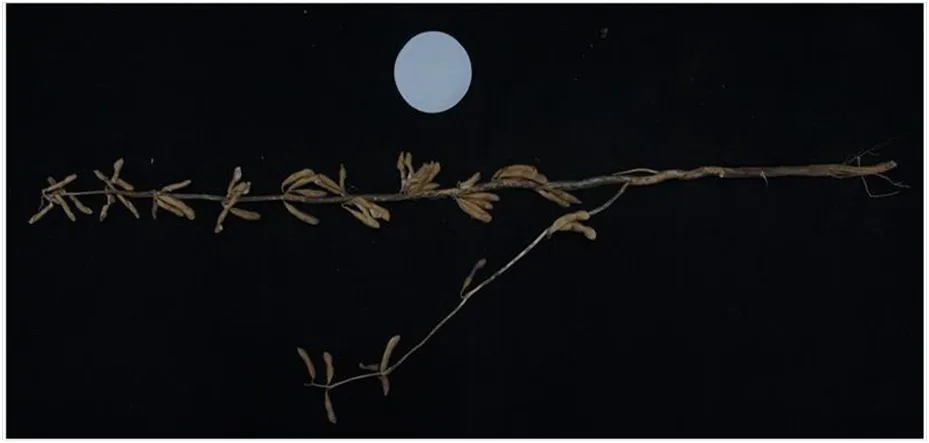

本研究的研究对象为成熟期大豆植株,由中国农业科学院顺义大豆研究基地提供,从大田人工采摘多个品种的完整大豆植株以增强本研究所提方法的鲁棒性,采摘得到包括中黄系列、吴疆系列、东农系列、东庆系列等30个品种共306株大豆,所采集大豆植株包括单分枝大豆植株、双分枝大豆植株、复杂分枝大豆植株,采摘后开始进行图像采集,共采集1 653张成熟期大豆植株图像。拍摄设备为SONY/ILCE-6400L相机,为了避免相机受自然光线的影响造成图片曝光、背景复杂造成大豆植株与背景对比度较低等问题,数据采集时间持续4 d,选择每天07:00-09:00和20:00-22:00两个时间段对大豆进行拍摄,拍摄过程中使用LED光源进行补光,并且将大豆植株平铺放置在专门试验台上,以白色圆纸作为标定物,黑色吸光布作为背景,减少背景复杂度对试验带来的干扰。同时,为了减少复杂根系对试验带来的影响,对大豆从第一个茎节点以下进行裁剪,去除大豆根系。此外,为了扩充大豆植株的基本数据量以及增强模型的鲁棒性,在拍摄过程中保持相机垂直拍摄植株的同时,对每个大豆植株进行人工的随机放置、旋转变换,每株大豆旋转或随机放置2~3次,这样每株大豆就有了不同的摆放姿态,同时,随机调整相机的拍摄高度,针对植株较小的大豆拍摄高度调整为81 cm,植株较大的大豆拍摄高度调整为86 cm,使所有大豆植株所占背景空间相似,在增强数据集多样性的同时,将每株大豆图像增加了3~4张,有效地扩充了原始数据集的数量,原始图像大小为2 736像素×1 824像素,通道数为3(RGB),为了减少图中无关背景,本研究利用Python工具将图像统一裁剪为813像素×357像素,处理后的图像如图1所示。

图1 处理后的大豆植株图像

在拍摄的同时,本研究针对每株大豆的表型信息进行了人工计数和测量,包括人工记录大豆主茎节点的数量、分枝数、株高等。其中,大豆株高测量方法为测量平铺大豆植株顶端茎节点到子叶节点的直线距离。本研究使用直尺对其进行测量,结果保留一位小数。

本研究中,茎节点连接大豆豆荚与大豆茎秆。虽然不同品种的大豆果实大小、性状不完全相同,但是这种差异对茎节点特征并无太大影响,因此,不同大豆的茎节点具有近似相同的特征,可以采用同一方法对不同品种的大豆茎节点进行检测。同时,为了增强人工测量株高的准确性,降低误差,对每株大豆植株株高进行3次测量,取平均值作为最终结果。

本研究获取的大豆植株表型参数有株高、茎节点数、分枝数。大豆株高的定义为从子叶节点到顶端茎节点的直线距离,在本研究中,针对每张图片中的茎节点坐标进行排序并得出横坐标值最大与最小的两个点,将两点作为该株大豆最顶端茎节点与子叶节点,两点的直线距离即为该图片对应大豆植株样本的株高。

1.2 数据标注与增强

本研究使用rolabelimg软件进行数据标注,该工具专门用于标注进行旋转目标检测任务的数据集,每个标注完成的矩形框会生成对应的xml文件,该文件包含矩形框的中心坐标以及该框的长、宽和旋转角度信息。本研究所用大豆植株数据集中包括茎节点和大豆植株分枝两种类型,将茎节点记为“point”类,大豆植株分枝记为“branch”类,茎节点数为检测到的point类个数,分枝数为检测到的branch类个数,标注茎节点时,仅标注大豆豆荚与大豆植株的相连部分,在进行分枝标注时,必须使标注框尽可能贴合大豆分枝,减少冗余信息且不能包含其他分枝的部分区域,大豆植株样本如图2所示。

图2 大豆植株样本标注

目前,虽然基于深度学习的目标检测算法性能比传统的机器学习算法有了显著提升,但是其优异的性能依赖于大量的数据训练[18]。数据增强可以有效解决数据量不足的问题。受采集的大豆植株数量限制,本研究目前共采集了1 653张图像,虽然在拍摄过程中人为扩充了数据集,依然无法满足目标检测所需数据量,因此,为了解决数据量不足的问题,本研究对大豆植株数据集进行了随机翻转、随机旋转、随机光照等方法增强数据多样性,从而降低了光强不一、拍摄角度不同、图像模糊等对模型造成的影响,并提升模型的鲁棒性,数据增强后共获得3 719张大豆植株图像,并按照7∶2∶1的比例随机划分训练集、测试集与验证集,最终训练集、测试集与验证集的图像数量分别为2 603、744、372张。

1.3 改进的YOLOv5模型

本研究选用了YOLOv5-5.0版本的YOLOv5s作为基础模型,YOLOv5s 结构简单,在保证了模型推理速度的同时又降低了参数量[22],其推理速度可以满足快速获取表型参数的目的,因此,本研究选用YOLOv5s作为基础模型,并针对其精度低的特点进行进一步优化以提升其检测精度,使模型能够更加快速准确地检测对应目标。

1.3.1 引入CSL处理角度信息

大豆植株具有弯曲性,使用YOLOv5网络在进行大豆分枝检测时得到的分枝区域中会包含大量不属于该分枝的冗余信息,这使得进行检测区域搜索时无法准确判断每个分枝中的主茎节点信息,导致重构的大豆植株与原始植株偏差较大,无法精确地获取大豆植株的表型参数,因此,本研究提出使用旋转目标检测方法,使检测区域中尽可能只包含大豆分枝信息,减少过多冗余信息造成的影响。YOLOv5使用矩形检测框,其损失函数仅包括回归损失、置信度损失以及分类损失,为了能够实现针对旋转目标的检测,加入用于处理角度信息的角度损失函数。在传统卷积神经网络中,针对旋转目标进行检测时会出现检测框的边界不连续问题,在边界处产生损失值,影响检测效果[23],因此,针对目前旋转目标检测中存在的缺陷,本研究提出在YOLOv5网络中引入CSL[23]来解决这个问题并实现对旋转目标的检测。本研究在YOLOv5网络中引入了CSL[23]分类损失,使角度回归问题转化为分类问题,CSL可以解决当前分类损失无法衡量检测结果和标签真值的角度损失值问题,并通过分类使角度预测更加精确,避免了边界不连续问题带来的影响,CSL表达式如下:

式中()为窗口函数;为()的半径,像素;为检测框的倾斜角度,(°)。

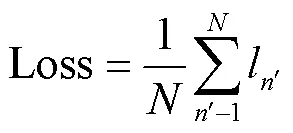

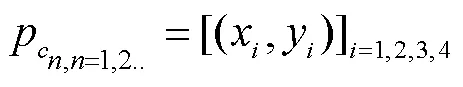

CSL中的窗口函数满足周期性、单调性、对称性、和最大值为1的四个属性,利用其四个属性解决因角度的周期性而造成损失的问题,并且由于角度回归任务已经转化为分类任务,角度信息经过CSL处理后,利用二元交叉熵损失函数(Binary Cross Entropy With Logits Loss,BCEWithLogits)进行损失计算,其式为

式中为模型训练的批次大小(batch_size);l为第个样本对应的损失值;x为经过sigmod激活函数处理后的第个样本的输出;y为第个样本对应的类别;ω为超参数。

1.3.2 引入协调注意力机制

引入CSL模块后,角度回归任务转化为简单的分类任务,使其能够更精确地进行旋转目标检测。但是,在能够检测旋转目标的同时,相当于为模型新增加了一个分类任务和一个分类损失,因此,其对该模型的整体检测精度必然会造成一定影响,因此,本研究将协调注意力机制[24](Coordinate Attention,CA)引入YOLOv5网络的Neck[25]部分,结构如图3所示。本研究在C3模块后添加协调注意力机制,网络不仅可以获取跨通道信息,还可以捕获位置以及方向信息,有助于网络更准确地定位和识别目标对象,同时,经过注意力机制模块处理后,原有的特征相关部分的区域被赋予了较高的权重,而与特征无关的背景区域被赋予了较低的权重,使得网络能够专注于特征相关部分的处理,减轻了背景等无关信息对检测结果造成的影响,提升检测准确性。

注:Concat为特征融合操作;Upsample为上采样操作;Conv表示卷积,括号内数值分别为步长和卷积核大小;C3表示使用m个残差结构(ResUnit)组成的卷积模块,CA为协调注意力机制。

1.3.3 引入RepVGG 结构

在模型Neck部分添加注意力机制来提升网络的检测性能的基础上,还提出了Re-YOLOv5,其通过改进YOLOv5的backbone以进一步增强网络的特征提取能力。RepVGG[26]由卷积(Convolution,Conv)、归一化操作(Batch Normalization,BN)和激活函数(Rectified Linear Units,ReLU)组成,其具有结构简单、性能良好的特点,在训练中,它是一个多分枝结构,除了一个3´3的卷积层外,还有一个1´1的卷积分支。因此,为了加强其特征提取能力,本研究将backbone中原有的3´3卷积替换为RepVGG,使两个卷积层同时用于特征提取,并将得到的结果进行归一化处理,这种结构融合了不同卷积模块提取的特征信息,利用其多个卷积层并行融合的特点,提升了整体结构的信息提取能力的同时降低了模型参数量。

1.4 检测区域搜索算法

首先利用Re-YOLOv5对大豆图像进行检测,得到大豆分枝检测区域的四点坐标和茎节点的中心坐标。其次通过检测区域搜索算法对每个大豆分枝检测区域进行编号,并在该区域中搜索所有茎节点的中心坐标,从而判断该区域中茎节点的个数,并根据上述信息得出每张图片中单个大豆植株分枝的茎节点个数,然后进行顺序连接重构出大豆植株骨架。首先,利用Re-YOLOv5获取“point”类的中心坐标并将坐标保存于p中,获取“branch”类的四点坐标,并将坐标保存于与分枝检测区域编号相对应的h中。

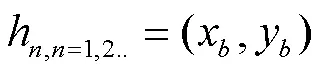

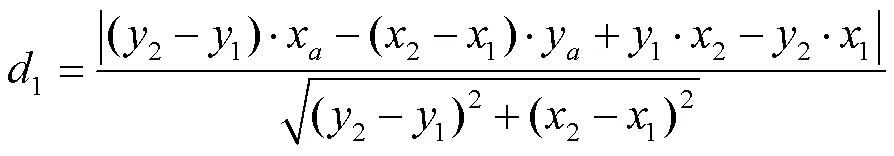

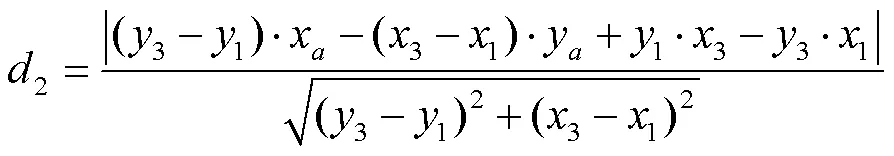

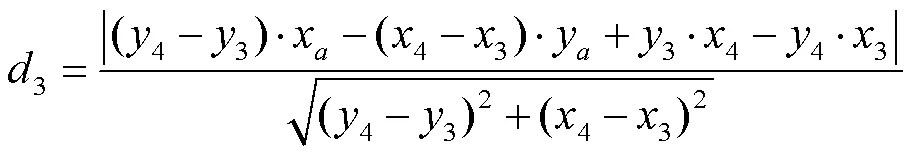

式中p为所有“point”类的中心坐标数组;为第个分枝检测区域所包含的“point”的中心坐标;h为第个分枝检测区域的四点坐标;(x,y)为分枝检测框的四个顶点;通过计算“point”的中心坐标到分枝检测区域四边距离判断该茎节点是否处于该区域中,其距离公式如下:

式中(x,y)为茎节点的中心坐标;1为茎节点的中心坐标到检测框上边的像素距离;1为茎节点的中心坐标到检测框左边的像素距离;3为茎节点的中心坐标到检测框底边的像素距离;4为茎节点的中心坐标到检测框右边的像素距离;为分枝检测框的像素长度;为分枝检测框的像素宽度;若(1+3)=且(2+4)=,则该茎节点属于此分枝,保存到对应的p数组中,完成所有点的判断后,将所有点的坐标按照的大小顺序链接从而重构大豆植株的骨架,其整个骨架检测过程如图4所示。

注:branch1、branch2为大豆分枝类,图S3中1、2、3为茎节点编号。

如图4所示,将原始图像输入至Re-YOLOv5中,得到检测后的如图S1所示图像,获取“branch”类的四点坐标及“point”类的中心坐标(图S2),然后将得到的“point”类矩形检测框用其中心坐标代替,作为该“point”类的坐标(图S3),将所得到的分枝检测框作为待搜索区域分别进行搜索,通过距离判定该区域内的主茎节点数以及坐标信息并将不同分枝的主茎节点重新赋予不同的类并用不同颜色区分(图S4),由图S3可知,点3同时属于两个分枝,因此将其作为连接点从而连接两个分枝的骨架,将属于同一“branch”类的“point”类进行连接(图S5),最终重构出完整的大豆植株骨架(图S6)。

2 试验与结果分析

2.1 试验环境与参数

本试验使用硬件环境包括12G显存的NVIDIA RTX-3060GPU显卡,1TB机械硬盘,AMD Ryzen 5 3600 6-Core CPU,操作系统为Ubuntu18.04版本、torch1.6.0以及torchvision0.7.0。训练时初始学习率为0.01,batch-size设置为64,使用马赛克数据增强的概率为0.2,共迭代300次。

2.2 评价指标

在目标检测算法中,常用的评价指标有平均精度(Average Precision,AP),平均精度均值(mean Average Precision,mAP)、精确度(Precision)、召回率(Recall)、浮点运算量、交并比(Intersection-over-Union,IoU)[27]等。其中,IoU用来衡量真实框与检测框之间的匹配程度,因此,在本研究中,IoU设置为0.4,即重合度高于0.4即可视为检测的正样本,选用精确度、召回率以及 AP和mAP来衡量模型的检测性能。针对使用Re-YOLOv5模型获取到的大豆植株表型参数,本研究使用4个评价指标来评估其准确性,分别为平均绝对误差(Mean Absolute Error,MAE)、最大绝对误差(Highest Absolute Error,MAE)、平均相对误差(Mean Relative Error,MRE)、最大相对误差[28-29](Highest Relative Error,HRE)。

2.3 对比试验与分析

为了验证本研究所选用的YOLOv5模型及其改进网络相比于其他目标检测模型性能有所提升且能够满足获取表型参数的需要,本研究训练了两类的目标检测网络进行了对比试验,分别为二阶段目标检测模型的典型代表Faster R-CNN,单阶段目标检测模型中的SSD以及原始YOLOv5模型,所有模型均经过300次迭代,YOLOv5(CSL)、Re-YOLOv5、YOLOv5这3种模型的总损失曲线进行对比,结果如图5所示。

注:CSL代表引入圆形平滑标签技术

由图5可知,在相同的网络参数下,Re-YOLOv5的总损失值最小,但收敛速度与YOLOv5差异较小,YOLOv5(CSL)的损失值最大,其原因是由于YOLOv5中新增加了一个分类任务和分类损失,最终必定会对YOLOv5的总损失造成影响,因此对其进行进一步改进,最终得到Re-YOLOv5,使其总损失比YOLOv5进一步降低,解决了YOLOv5(CSL)总损失较高的缺点。

本研究对Re-YOLOv5、YOLOv5的精确率和召回率曲线进行比较,结果如图6所示。通过对比Re-YOLOv5与YOLOv5的精确率曲线和召回率曲线可知,Re-YOLOv5的最终精确率比YOLOv5略高,且在迭代100次后其精确率曲线均位于YOLOv5精确率曲线的上方,但两者的收敛速度相似。Re-YOLOv5与YOLOv5的召回率曲线差异略小,两者的最终召回率也接近相同,因此,改进后的Re-YOLOv5在保持了与原始网络召回率相似的同时,精确率有所提升。

图6 YOLOv5与Re-YOLOv5的精确率与召回率曲线

本研究利用精确率、召回率、AP、mAP以及参数量对各个对比模型进行评价,结果如表1所示。由表1可知,二阶段目标检测模型具有最高的参数量,因此具有最慢的计算速度,所需要占用的GPU资源也最多,且其精度相比于单阶段检测模型中的YOLO系列并没有提升,此外,Faster R-CNN针对茎节点的检测能力不足,平均精度仅为0.01%,在所有模型中精度最低,几乎无法检测,这是由于Faster R-CNN中的锚框需要人工设置,茎节点目标过小造成人工设置锚框无法满足该小目标检测的需要,造成最小的锚框都要比茎节点目标大得多,因此造成针对小目标的检测效果太差,无法满足检测需求。SSD相比于YOLO系列网络,针对大豆分枝的召回率不相上下,但其精确率、AP以及mAP与YOLO系列相差较大,针对茎节点的平均精度仅为4.87%,无法满足正常的检测需求,而YOLO系列的YOLOv3以及YOLOv5的mAP均为80%以上,YOLOv3虽然在大豆分枝上的准确率、召回率及AP和YOLOv5接近,但是其针对茎节点的检测能力不足,该类别的平均精度与YOLOv5相差6个百分点,mAP值相差3.85个百分点,其参数量达到了61.50 M,约为YOLOv5的9倍。综合考虑Faster R-CNN、SSD、YOLOv3、YOLOv5的检测效果以及参数量,本研究选用了小目标检测能力较强且mAP值最高的YOLOv5作为基础网络并在此基础上进行改进得到最终使用的Re-YOLOv5。

表1 各种模型检测结果的比较

注:AP表示精度均值;mAP表示平均精度均值。

Note: AP is average precision; mAP is mean average precision.

但是,使用YOLOv5进行检测会造成有些大豆分枝检测区域中包含许冗余信息,对检测结果造成影响,如图7所示。对于多分枝大豆植株样本,使用原始YOLOv5检测时,其检测区域并不能完全包含该分枝的所有信息,例如图8a、8b中的分枝检测区域并没有包含最顶端茎节点的信息,此外,大豆分枝的矩形框检测区域中虽然能够包含该分枝的部分信息,但是同样包含许多其他分枝以及其他分枝的主茎节点信息,在进行检测区域搜索时这些信息会造成信息误判,使得本应属于其他分枝的主茎节点被错误判定为该分枝的主茎节点,从而对重构大豆植株骨架以及获取后续表型信息造成较大影响,因此,本研究在其基础上改进得到Re-YOLOv5,使其不仅能够检测旋转目标,尽可能去除多余信息,且检测精度能够进一步提升。

注:图中框线为检测框,数值为检测精度。

图8 基于Re-YOLOv5的大豆植株样本检测效果图

由图8可知,Re-YOLOv5具有检测旋转目标的能力,且每个大豆分枝旋转检测框中都尽可能地仅包含该分枝的所有信息,最大程度地减少了其他分枝信息的干扰,避免了在进行检测区域搜索时其他分枝信息对结果造成的干扰,使其能够得到精确的大豆植株骨架,为后期进行大豆分枝夹角的计算、大豆株型的判断提供了精确的参考依据。

由表1可知,YOLOv5(CSL)的mAP比YOLOv5有所下降,参数量则上升了大约0.5 M,为了提升模型的检测效果,在其基础上加入了协调注意力机制以及RepVGG提升其检测精度。由表1可知,YOLOv5(CSL+CA)针对茎节点的准确率、召回率、AP相比于YOLOv5(CSL)和YOLOv5均有提升,其mAP值比YOLOv5(CSL)提升了4.44个百分点,比YOLOv5提升了0.62个百分点。Re-YOLOv5针对两类目标的准确率、召回率、AP以及mAP相比YOLOv5(CSL+CA)又有了进一步提升,其中,mAP比YOLOv5(CSL+CA)提升了约1.08个百分点,比.YOLOv5提升了1.70个百分点,检测小目标的能力有所上升,针对茎节点的检测精确率比YOLOv5(CSL+CA)提升了1.90个百分点,比YOLOv5提升了9.90个百分点,参数量则下降到了6.85 M,比YOLOv5(CSL)下降了0.65 M,比YOLOv5参数量下降了0.17 M,但是比YOLOv5(CSL+CA)有所上升。考虑到整体的检测精度以及参数量的大小,本研究改进的Re-YOLOv5,不仅可以检测旋转目标,实现最优检测效果的同时,参数量也比YOLOv5有所下降。

2.4 大豆植株表型数据结果分析

本研究通过对验证集进行测试,最终得到了验证集中每张图像所对应的大豆植株样本的3种表型参数,将其与人工测量真值进行比较,评估结果如表2所示。可以看出,在验证集中,对分枝的判断准确率最高,其平均绝对误差仅为0.03个,几乎可以准确识别出大豆植株的分枝,这是由于分枝在大豆植株中相较于其他表型具有最明显的特征,因此,获取分枝参数的准确率最高。

针对大豆茎节点,大豆茎节点数的平均绝对误差为1.37个,最大绝对误差仅为5.00个。大豆植株中会存在大豆豆荚遮挡植株主茎和分枝的情况,这种情况在复杂分枝样本中比较常见,单分枝和双分枝大豆植株样本由于分枝少,豆荚分布较为稀疏,因此遮挡情况并不普遍。

表2 大豆植株表型参数分析结果

注:MAE为平均绝对误差;HAE为最大绝对误差;MRE为平均相对误差;HRE为最大相对误差。

Note: MAE is mean absolute error; HAE is highest absolute error; MRE is mean relative error; HRE is highest relative error.

为了探究遮挡情况对检测大豆茎节点检测是否造成较大影响,本研究对复杂分枝大豆植株进行检测,图9为图8c的部分截取图,由图9可知,大豆豆荚的颜色特征与大豆茎秆有明显区别,且遮挡特征与茎节点特征并不相似,所有遮挡部分并未被误检为茎节点,因此不会对茎节点的检测造成较大影响。大豆植株株高的平均误差为2.06 cm,最大误差为14.52 cm。最大误差较高的主要原因是由于大豆子叶节点的特征并不明显,一些植株中的子叶节点甚至肉眼也难以分辨,造成模型在进行检测时针对子叶节点会有漏检的情况,导致计算株高时会缺少子叶节点到第一个茎节点的距离。

注:图中框1和3为豆荚遮挡分枝情况;框2为豆荚遮挡主茎情况。

虽然本研究仅获得了3种表型参数,但是可以根据这3种表型参数获取更多的表型参数,例如利用茎节点数计算茎节数、主茎长、茎节长等,通过得重构的植株骨架利用霍夫变换来计算每个分枝与主茎之间的夹角,进而判断株型等参数,因此,该方法也为后续继续进行表型参数获取提供了良好基础。整体来看,该方法检测精度高,能够满足自动采集大豆植株表型参数的要求。

3 结 论

1)本研究提出了一种基于Re-YOLOv5的大豆植株茎节点与大豆分枝的检测方法。试验证明,该方法具有较高的检测精度,其平均精度均值(mean Average Precision,mAP)达到了93.40%,达到了能够检测旋转目标的能力,且能够最大限度地减少大豆分枝检测区域中的冗余信息。

2)Re-YOLOv5网络,相比于YOLOv5, 其mAP提升了1.70个百分点,茎节点类的平均精度(Average Precision,AP)提升了9.90个百分点,具有较强的小目标检测能力,且其参数量相比于只引入圆形平滑标签技术(Circular Smooth Label,CSL)的YOLOv5下降了0.65 M,比YOLOv5降低了0.17 M。

3)采用检测区域定位算法重构大豆植株骨架,可以准确得到大豆植株的株高、茎结点数、分枝数等表型信息。验证集测试结果表明,株高的平均绝对误差为2.06 cm,茎节点数的平均绝对误差为1.37个,分枝数的平均绝对误差最低,为0.03个,上述表型参数的误差均在可接受的范围内,因此,可以证明该方法能够较为准确地获取大豆植株的部分表型参数以及大豆植株骨架图,并为获取大豆分枝夹角、大豆株型等表型信息提供了基础。

[1] 刘梅芳,樊琦. 中国大豆消费、生产和进口现状及存在的问题[J]. 粮食科技与经济,2021,46(6):28-35.

Liu Meifang, Fan Qi. Study on the current situation and problems of soybean consumption, production and import in China[J]. Food Science and Technology and Economy, 2021, 46(6): 28-35. (in Chinese with English abstract)

[2] Kamilaris A, Prenafeta-Boldú F X. Deep learning in agriculture: A survey[J]. Computers and Electronics in Agriculture, 2018, 147: 70-90.

[3] Santos L, Santos F N, Oliveira P M, et al. Deep learning applications in agriculture: A short review[C]//Iberian Robotics Conference. Porto: Springer, 2019: 139-151.

[4] Zhao W, Yamada W, Li T, et al. Augmenting crop detection for precision agriculture with deep visual transfer learning: A case study of bale detection[J]. Remote Sensing, 2020, 13(1): 23.

[5] Mohanty S P, Hughes D P, Salathé M. Using deep learning for image-based plant disease detection[J]. Frontiers in Plant Science, 2016, 7: 1419.

[6] Lippi M, Bonucci N, Carpio R F, et al. A yolo-based pest detection system for precision agriculture[C]//2021 29th Mediterranean Conference on Control and Automation (MED).Puglia: IEEE, 2021: 342-347.

[7] 闫壮壮,闫学慧,石嘉,等. 基于深度学习的大豆豆荚类别识别研究[J]. 作物学报,2020,46(11):1771-1779.

Yan Zhuangzhaung, Yan Xuehui, Shi Jia, et al, Classification of soybean pods using deep learning[J]. Acta Agronomica Sinica , 2020, 46(11): 1771-1779. (in Chinese with English abstract)

[8] Lowe D G. Object recognition from local scale-invariant features[C]//Proceedings of the Seventh IEEE International Conference on Computer Vision. IEEE, 1999: 1150-1157.

[9] Ma X, Najjar W A, Roy-Chowdhury A K. Evaluation and acceleration of high-throughput fixed-point object detection on FPGAs[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2014, 25(6): 1051-1062.

[10] Said Y, Atri M, Tourki R. Human detection based on integral Histograms of Oriented Gradients and SVM[C]//2011 International Conference on Communications, Computing and Control Applications (CCCA). Hong Kong: IEEE, 2011: 1-5.

[11] Liu T H, Nie X N, Wu J M, et al. Pineapple () fruit detection and localization in natural environment based on binocular stereo vision and improved YOLOv3 model[J/OL]. Precision Agriculture, 2022, 1(22). (2022-04-20) https://doi.org/10.1007/s11119-022-09935-x

[12] de Castro Pereira R, Hirose E, de Carvalho O L F, et al. Detection and classification of whiteflies and development stages on soybean leaves images using an improved deep learning strategy[J]. Computers and Electronics in Agriculture, 2022, 199: 107132.

[13] 彭红星,李荆,徐慧明,等. 基于多重特征增强与特征融合SSD的荔枝检测[J]. 农业工程学报,2022,38(4):169-177.

Peng Hongxing, Li Jing, Xu Huiming, et al. Litchi detection based on multiple feature enhancement and feature fusion SSD[J].Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE),2022,38(4):169-177. (in Chinese with English abstract)

[14] Albawi S, Mohammed T A, Al-Zawi S. Understanding of a convolutional neural network[C]//2017 International Conference on Engineering and Technology (ICET). Antalya: IEEE, 2017: 1-6.

[15] Xie X, Cheng G, Wang J, et al. Oriented R-CNN for object detection[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021: 3520-3529.

[16] Ren S, He K, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. Advances in Neural Information Processing Systems, 2015, 28.

[17] Dai J, Li Y, He K, et al. R-FCN: Object detection via region-based fully convolutional networks[EB/OL]. (2016-06-21)[2022-04-20). https://arxiv.org/abs/1605.06409.

[18] Liu W, Anguelov D, Erhan D, et al. Ssd: Single shot multibox detector[C]//European Conference on Computer Vision. Amsterdam: Springer, Cham, 2016: 21-37

[19] Xiao Y, Tian Z, Yu J, et al. A review of object detection based on deep learning[J]. Multimedia Tools and Applications, 2020, 79(33): 23729-23791.

[20] 王嘉琳. 基于YOLOv5和DeepSORT的多目标跟踪算法研究与应用[D]. 济南:山东大学,2021.

Wang Jialin. Research and Application of Multi-Target TrackingAlgorithm Based on YOLOV5 and DEEPSORT[D]. Jinan: Shandong University, 2021. (in Chinese with English abstract)

[21] Liu Y, Sun P, Wergeles N, et al. A survey and performance evaluation of deep learning methods for small object detection[J]. Expert Systems with Applications, 2021, 172: 114602.

[22] Wang D, He D. Channel pruned YOLO V5s-based deep learning approach for rapid and accurate apple fruitlet detection before fruit thinning[J]. Biosystems Engineering, 2021, 210: 271-281.

[23] Yang X, Yan J. On the arbitrary-oriented object detection: Classification based approaches revisited[J]. International Journal of Computer Vision, 2022, 130(5): 1340-1365

[24] Hou Q, Zhou D, Feng J. Coordinate attention for efficient mobile network design[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Virtual: IEEE, 2021: 13713-13722.

[25] 白强,高荣华,赵春江,等. 基于改进YOLOV5s网络的奶牛多尺度行为识别方法[J]. 农业工程学报,2022,38(12):163-172.

Bai Qiang, Gao Ronghua, Zhao Chunjiang, et al. Multi-scale behavior recognition method for dairy cows based on improved YOLOV5s network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(12): 163-172. (in Chinese with English abstract)

[26] Ding X, Zhang X, Ma N, et al. Repvgg: Making vgg-style convnets great again[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Virtual: IEEE, 2021: 13733-13742.

[27] 孙丰刚,王云露,兰鹏,等. 基于改进YOLOv5s和迁移学习的苹果果实病害识别方法[J]. 农业工程学报,2022,38(11):171-179.

Sun Fenggang, Wang Yunlu, Lan Peng, et al. Identification of apple fruit diseases using improved YOLOv5s and transfer learning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(11): 171-179. (in Chinese with English abstract)

[28] 李彬,杜丁香,王兴国,等. 基于平均绝对误差的海上风电经柔直送出系统交流海缆纵联保护[J]. 电测与仪表,2022,59(6):122-129.

Li Bin, Du Dingxiang, Wang Xingguo, et al. AC submarine cable pilot protection for offshore wind power through MMC-HVDC system based on mean absolute error[J]. Electrical Measurement and Instrumentation, 2022, 59(6): 122-129. (in Chinese with English abstract)

[29] 薛帅,王光霞,郭建忠,等. 顾及最大绝对误差的频率域矢量数据压缩算法[J]. 武汉大学学报(信息科学版),2018,43(9):1438-1444.

Xue Shuai,Wang Guangxia, Guo Jianzhong, et al. Vector map data compression of frequency domain with consideration of maximum absolute error[J]. Geomatics and Information Science of Wuhan University, 2018, 43(9): 1438-1444. (in Chinese with English abstract)

Acquiring soybean phenotypic parameters using Re-YOLOv5 and area search algorithm

Guo Xiyue1, Li Jinsong1, Zheng Lihua1, Zhang Man1,2, Wang Minjuan1,2※

(1.,,,100083,; 2.,264670,)

The phenotypic information of soybean has been one of the most important indicators for the variety selection of soybean. Most research has been focused on soybean pods for phenotypic traits at present. However, the phenotypic information of soybean plants can also be a very important indicator for soybean seed breeding. Furthermore, the current manual measurement cannot fully meet the large-scale production in recent years, due to the time and labor-consuming. More recently, computer technologies have been started to automatically acquire the soybean phenotypic parameters. For instance, some shallow machine learning and image description were used for the image feature extraction and target detection, such as the Scale-Invariant Feature Transform (SIFT), Histogram of Oriented Gradient (HOG), and Support Vector Machine (SVM). Although the automatic acquisition of phenotypic data was realized to a certain extent, the high generalization ability can be a high demand suitable for practical application scenarios. In this study, an improved model was proposed to rapidly and accurately acquire the soybean plant phenotype using Re-YOLOv5 and area search algorithm. The circular smooth labels were also introduced in the Re-YOLOv5 to process the angle information for the detection of the rotating objects. The angle regression was then converted into a simple classification. As such, the rotating objects were accurately detected to reduce the redundant information in the detection area during object detection. In addition, the Coordinate attention mechanism was added to the Neck part of YOLOv5 (CSL). The cross-channel information was then obtained to capture the position and orientation information. As such, the improved network was used to more accurately locate and recognize the soybean branching than before. The weights greatly contributed to the YOLOv5 on the processing of feature-related parts. More importantly, the original 3×3 convolution kernels were placed in the backbone with a RepVGG block structure. The feature information was then fused to extract using different convolution modules. The information extraction of the overall structure was enhanced for the parallel fusion of the multiple convolution layers while reducing the number of model parameters. Taking the detected branch as the search area, an area search algorithm was also proposed to input into the algorithm, in order to extract the relevant information of the stem nodes in the area, and then connect the nodes in sequence. Thus, the soybean skeleton was reconstructed to obtain phenotypic information about soybean. The experimental results showed that the improved Re-YOLOv5 performed better to detect the rotating objects in various phenotypic indicators, compared with the YOLOv5. Specifically, the mAP of the improved Re-YOLOv5 increased by 1.70 percentage points, the number of parameters decreased by 0.17 M, and the detection accuracy of stem nodes was improved by 9.90 percentage points. An excellent ability was also achieved to detect the small targets suitable for the acquisition of the soybean plant phenotype information. Among them, the average absolute errors of plant height, and the number of stem nodes and branches were 2.06 cm, 1.37, and 0.03, respectively, fully meeting the accuracy requirements of actual collection. At the same time, the detection area search algorithm can also be expected to accurately locate the stem nodes on each branch for the single-, double-, and complex-branched soybean plants, and then reconstruct an accurate soybean skeleton. Anyway, the improved model can also be used to accurately and efficiently acquire the phenotypic information of soybean branch angle, and soybean plant type. The finding can provide a strong reference for the subsequent acquisition of phenotypic information during soybean production.

models; algorithms; soybean; object detection; YOLOv5; area search

10.11975/j.issn.1002-6819.2022.15.020

S643.7; TP391.4

A

1002-6819(2022)-15-0186-09

郭希岳,李劲松,郑立华,等. 利用Re-YOLOv5和检测区域搜索算法获取大豆植株表型参数[J]. 农业工程学报,2022,38(15):186-194.doi:10.11975/j.issn.1002-6819.2022.15.020 http://www.tcsae.org

Guo Xiyue, Li Jinsong, Zheng Lihua, et al. Acquiring soybean phenotypic parameters using Re-YOLOv5 and area search algorithm[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(15): 186-194. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2022.15.020 http://www.tcsae.org

2022-06-03

2022-07-22

国家自然科学基金项目(31971786);山东省自然科学基金面上项目(ZR2021MC021)

郭希岳,研究方向为计算机视觉技术。Email:gxy529708425@163.com

王敏娟,副教授,博士生导师,研究方向为计算机视觉技术。Email:minjuan@cau.edu.cn