基于梯度感知的单幅图像超分辨

周乐,徐龙,刘孝艳,张鑫泽,张选德*

(1.陕西科技大学 电子信息与人工智能学院,陕西 西安710021;2.中国科学院 国家天文台,北京100101;3.西安石油大学 理学院,陕西 西安710065)

1 引 言

图像超分辨(Super Resolution,SR)与图像去噪、图像去雾等问题同为图像恢复领域的研究内容,它们的共同目标是提升图像质量。图像超分辨的特定目标是从低分辨率(Low Resolution,LR)图像恢复得到具有清晰纹理与边缘的高分辨率(High Resolution,HR)图像。根据输入的LR图像个数可以将图像超分辨分为单帧图像超分辨(Single Image Super Resolution,SISR)与多帧图像超分辨(Multiple Image Super Resolution,MISR),本文主要研究SISR,简称SR。在SR中,由于可能会有多幅不同的HR图像退化得到同样的LR图像,因此SR问题是一个难解的病态问题。如今,图像超分辨已经广泛应用于遥感图像[1]、医学图像等领域,随着智能边缘设备的普及,比如智能手机、VR眼镜等,在这些设备上部署高性能的SR算法已成为实际生产的关键一环。

从SRCNN[2]首 次 将CNN引 入 图 像 超 分 辨领域至今,SR性能相较于传统的对自然图像的先验信息进行建模的SR方法有了很大的提升,但已有的高性能SR算法仍然存在两个方面的缺陷:(1)大多数方法以峰值信噪比(PSNR)为主导,仅以像素损失训练网络,会导致得到的SR图像趋于平滑,难以恢复出精细的纹理与尖锐的边缘;(2)模型的计算量与参数量呈现随性能增长的趋势。SR网络模型近些年不断地向更深更宽的方向发展。比如最早将生成对抗网络(GANs)引入图像超分辨的SRGAN[3],其参数量与每秒浮点运算次数(Floating-Number Operations,FLOPs)分别为0.73M与7.05G,发展到近期参数量与FLOPs分 别 为24.80M与265.14G的SPSR[4],可以看出,参数量和计算量均是成倍增长的。其中FLOPs以100×100的LR图像为输入计算得来,参数量与计算量的增长极大地限制了高性能SR算法在智能边缘设备上的应用。

为了解决PSNR主导的SR方法恢复的高分辨图像趋于平滑的问题,Justin等人[5]将内容损失引入到训练SR网络的损失函数中,使用含有语义信息的特征图计算损失,使得超分辨图像的感知质量得到改善,有效减少了人工伪影。在生成对抗网络(GAN)提出之后,Ledig等人[3]又将对抗损失引入训练SR网络的损失函数中,提出SRGAN,得到了更加逼真的重建图像。近期提出的SPSR利用LR图像的梯度图为重建过程提供丰富的结构信息,得到了具有更好感知质量的SR图像。虽然SPSR的性能优于先前的感知驱动的SR方法,但其存在参数量与计算量过大的问题。

为了缓解SR领域存在的问题,本文利用图像梯度信息,构建较轻量的双分支SR网络,其中包括SR分支与梯度分支。梯度分支为SR分支提供梯度信息,帮助SR分支重建出具有更好感知质量的SR图像。同时,为了更充分、准确地利用图像的梯度信息,首先要避免SPSR中将图像域特征图与梯度域特征图串联所带来的域冲突问题。本文将梯度域特征图作为作用在图像域特征图上的卷积核使用,如此可以有效避免域冲突所带来的性能损失;其次,为了使得用作卷积核的梯度域特征图更加符合卷积核特性,在SR分支与梯度分支之间添加了两个过渡卷积层;最后,通过调整网络中的卷积核大小,使得两个分支对应位置所输出的图像域和梯度域特征图的感受野一致,达到更准确地利用梯度信息的目的。通过有效的网络结构设计,本文所提出的SR算法在感知质量与PSNR之间取得了一个比较好的平衡。除了性能提升之外,本文利用梯度感知获得了性能优势,通过减少网络通道数与基础构建块数目有效减少了SR网络的计算量与参数量,与SPSR相比,以将近1/6的计算量与1/10的参数量取得了与SPSR相近的性能。

2 相关工作

相比于传统的对先验信息进行建模的SR方法,基于深度学习的SR方法在性能上有了很大的提升。SRCNN[2]使用3层卷积层首次将CNN引入SR领域,并使用传统的稀疏表示的思想对这3层CNN的原理进行了解释,实现了从传统SR方法到基于深度学习的SR方法的过渡。之后,Kim等人[6]结合残差网络提出了更深的超分辨网络VDSR,得到了更好的SR结果。Zhang等人[7]指出CNN主要是对图像的先验信息进行建模,并论证了单一的模型可以处理图像去块、去噪以及超分辨问题。上述基于深度学习的图像超分辨模型的输入都是LR图像经过双三次插值之后的粗糙SR图像,再通过后续的网络细化,得到具有较好纹理细节的SR图像,称之为预上采样框架。然而,这样的预上采样框架不仅会导致网络内部计算量的成倍增加,并且还不利于感受野的有效扩充。

为了解决上述问题,Dong等人[8]提出了加速的SRCNN,称之为FSRCNN,直接将未插值的LR图像作为网络的输入,在网络末端使用一个反卷积层执行图像的上采样,称之为后上采样框架。后上采样框架不仅可以减少计算量,扩充感受野,还可以充分利用CNN端到端学习精度高的优势,提高SR性能。使用此框架的性能优越的SR方法还有很多。RCAN[9]使用通道注意力机制构建了超过400层的SR网络,RDN[10]使用密集连接策略构建SR网络,均获得了较高的PSNR值。RFANet[11]利用残差特征融合与增强的空间注意力模块再次提升了PSNR值。然而,以提升PSNR为目标的SR方法会产生趋于平滑的SR图像,难以恢复出复杂的纹理与尖锐的边缘,影响了SR图像的视觉感知质量。为此,Justin等人[5]在将内容损失引入到训练SR网络的损失函数中,使得超分辨图像的感知质量得到改善,有效减少了人工伪影。在生成对抗网络(GAN)[12]提出之后,Ledig等人[3]又将对抗损失引入训练SR网络的损失函数中,得到了更加逼真的重建图 像。之 后,Wang等 人[13]使 用 残 差 密 集 块 对SRGAN加以改进,提出了ESRGAN,获得了具有更好视觉质量的SR结果。Cheng等人提出的SPSR[4]利用梯度信息为重建过程提供了丰富的结构信息,使得SR网络可以更好地恢复出图像的细节纹理。然而,SPSR将图像域的特征图与梯度域的特征图相串联,会带来域冲突的问题,从而导致性能的损失。本文提出梯度感知的图像超分辨重建,将梯度域的特征图作为作用在图像域特征图上的卷积核,以此避免域冲突所带来的性能损失,实验论证了此策略的有效性。

近些年的SR研究除了注重性能的提升之外,为了将高性能的算法部署在智能边缘设备上,也逐渐开始关注模型的轻量化问题。ClassSR[14]将LR图像分块处理,按照恢复难度将其分为3个类,分别使用具有不同容量的模型处理这3类图像块,有效地减少了已有模型的计算量。AdderSR[15]利用在图像识别领域非常有效的AdderNet优化SR模型,使用能量消耗较小的加法器替代已有网络中的乘法操作,达到节省计算资源的目的。SMSR[16]利用稀疏表示理论减少SR模型在图像的平滑区域所消耗的计算量。从近年来SR领域的研究趋势可以看出,模型的轻量也是评估SR算法不可忽视的重要因素之一,因此,GASR不仅关注所重建出的SR图像的感知质量,同时关注模型的轻量化。

3 梯度感知图像超分辨重建

3.1 GASR框架

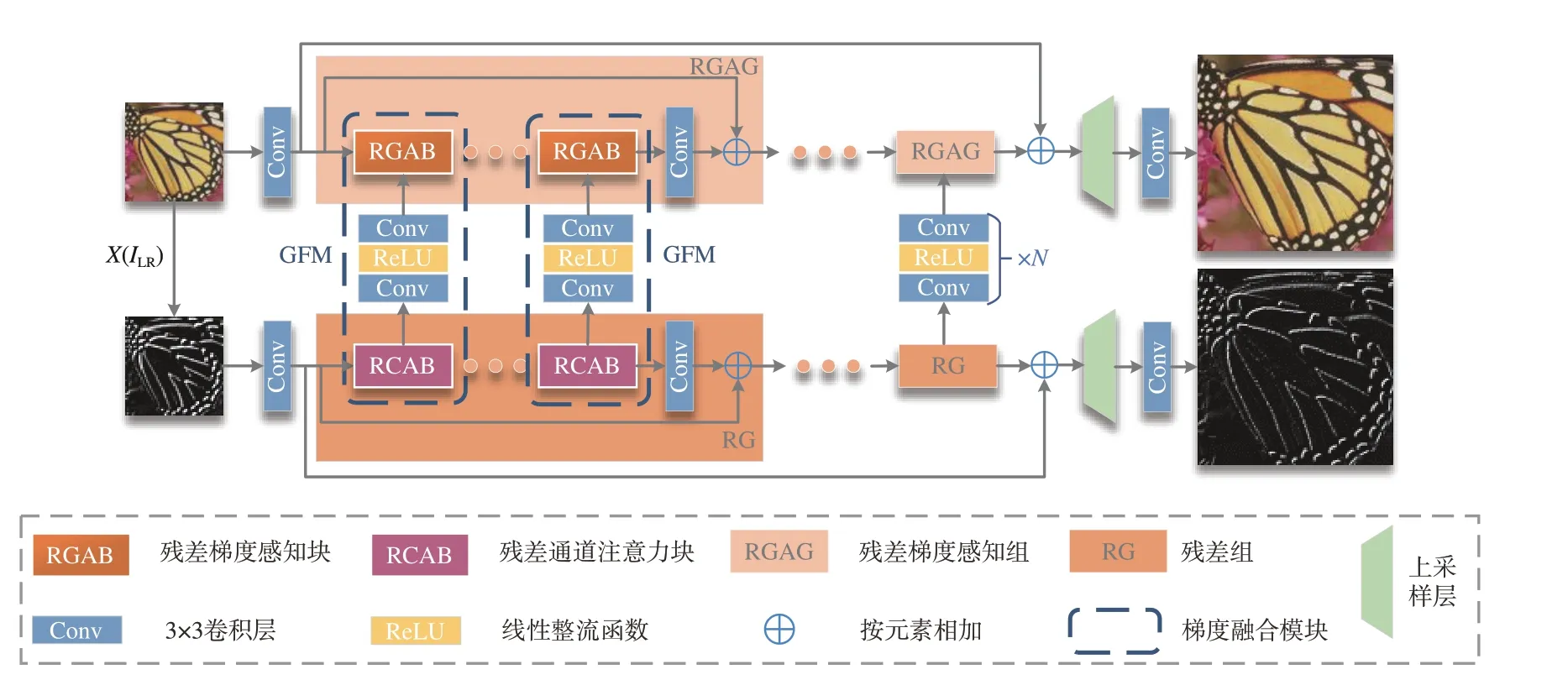

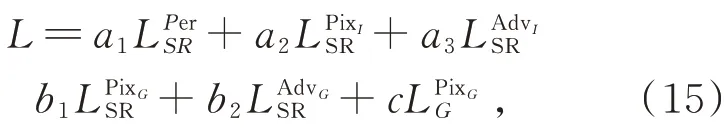

本文构建相对轻量的双分支图像超分辨网络,SR分支用于提取LR图像的深度特征,梯度分支用于提取LR图像梯度图的深度特征。SR分支是图像超分辨的主分支,梯度分支作为图像超分辨的辅助分支,为SR分支提供梯度信息,帮助SR分支重建出更准确的纹理信息。GASR整体结构如图1所示。

图1 GASR的总体框架Fig.1 Overall framework of GASR

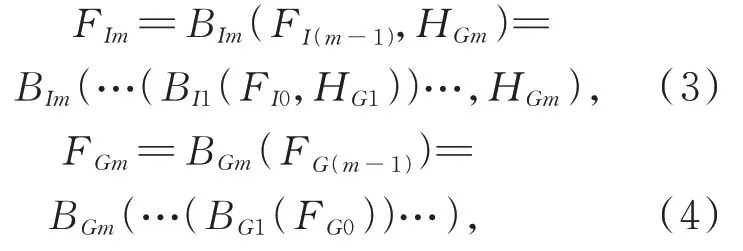

首先,提取LR图像及其梯度图的浅层特征:

其中HI(·)与HG(·)分别表示SR分支与梯度分支的浅层特征提取函数,均为一个3×3的卷积层;X(·)是计算梯度图的函数。将提取的LR图像的浅层特征及其梯度图的浅层特征作为主干网络的两个输入。SR分支与梯度分支的主干网络分别由M个残差梯度感知组(Residual Gradient Aware Group,RGAG)和M个RCAN中的 残差组(Residual Group,RG)组成,而RGAG与RG分别由N个RGAB与N个RCAB组成。此 外,在主干网络中还存在一条全局跳跃连接。LR图像及其梯度图的深层特征提取可以表示为:

其 中,BIm(·,·)与BGm(·,·)为 第m个RGAG和RG的函数 表示;FIm是第m个RGAG的 输出;HGm表示第m个RG中每个RCAB的输出特征图,此特征图是RGAG的输入之一;FG(m-1)和FGm分别是第m个RG的输入和输出。式(3)表明,GASR的两个分支并不相互独立,即BIm需要以第m个RG的中间特征图HGm为另一个输入以融合梯度信息。最后,将深层特征FIM和FGM分别作为SR分支和梯度分支重建层的输入:

其 中,RI(·)和RG(·)分 别 表 示SR分 支 和梯 度 分 支的重建函数,ΛI(·)和ΛG(·)分别表示SR分支与梯度分支。

与SPSR类似,本文采用像素损失、感知损失和对抗损失相结合的方式训练网络,使网络能够重建出具有更好视觉质量的SR图像。其中,像素损失可以有效地提升PSNR,但会导致SR图像趋于平滑,难以恢复出尖锐的边缘以及复杂的纹理。典型的像素损失有L1损失与L2损失,研究表明,L1损失相较于L2损失具有更好的收敛性,并且恢复出的SR图像视觉质量更好,因此选用L1损失作为像素损失:

其中,与分别是作用在SR分支输出的SR图像及其梯度图上的损失是作用在梯度分支输出的SR梯度图上的损失。

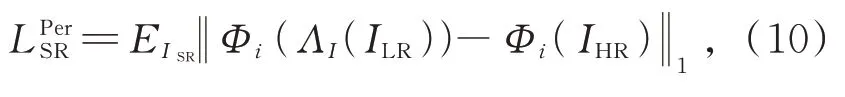

为了提升图像的感知质量,Justin等人[5]使用预训练的VGG网络提取SR图像和HR图像含有语义信息的中间层特征,计算它们之间的L1损失:

其 中,Φi(·)表 示 预 训 练 的VGG模 型 第i层 的输出。

为了在放大因子较大时能够恢复出逼真的纹理细节,Ledig等人将生成对抗网络(GANs)引入到SR任务中,判别器DI也作为优化的目标之一。受到SPSR的启发,本文不仅使用判别器DI对SR分支输出的SR图像进行判别,也使用判别器DG判别其梯度图。优化DI、DG与ΛI的损失函数分别是:

其中,与是作用在SR分支输出的SR图像上的损失,与是作用其的梯度图上的损失。GASR是一个高度对称的双分支网络结构,即RGAG与RG在数量上保持一致、结构上保持相似,如此使得梯度图的深层特征与同样位置处LR图像的深度特征在深度上一致,以便于主分支更好地利用梯度信息。此外,梯度分支输出梯度图上的L1损失也更好地保证了这一点。

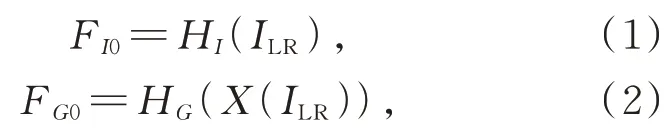

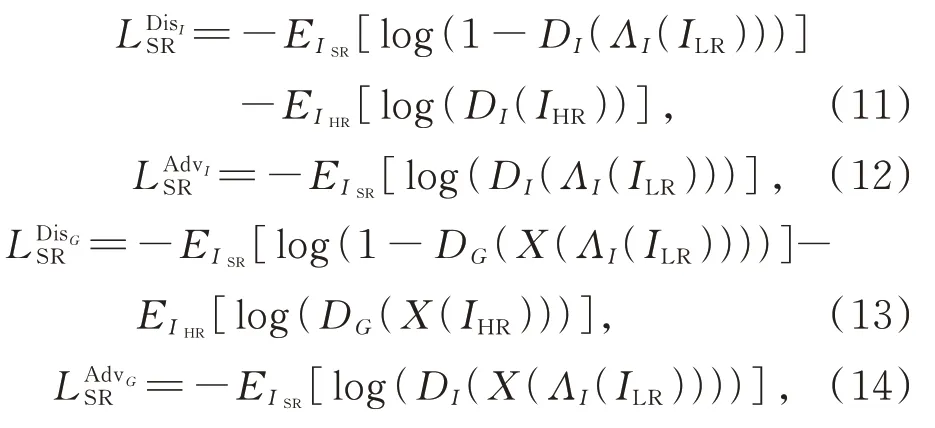

3.2 残差梯度感知块(RGAB)

在阐述RGAB结构之前,首先介绍RCAN中残差通道注意力块(Residual Channel Attention Block,RCAB)的结构。RCAB是对基础残差块的改进,在基础残差块的残差分支尾端添加了通道注意力(Channel Attention,CA),促使网络可以根据各通道之间的依赖自适应地为不同通道的特征图赋予不同的权重。如图2所示,CA首先通过全局平均池化将输入的大小为c×w×h的特征图转化为一个c维向量,即将特征在空间维度压缩,然后通过两个1×1的卷积层对其进行通道降维与升维操作,最后经过Sigmoid函数得到每个通道的权重,将其与输入特征图按通道相乘得到加权的输出特征图。

RGAB是对RCAB的改进,具体地,就是在RCAB的第一个“卷积层+ReLU”与CA之间插入了梯度感知卷积层(Gradient Aware Convolution,GAConv)。如图2所示,GAConv由两个子分支组成。第一个子分支保留原有RCAB的卷积层;第二个子分支为梯度感知分支,以梯度分支的特征图(图中绿色长方体)为输入,其尺寸为k2×w×h。输入的梯度特征图每个位置可以组成一个k×k的卷积核(图中橙色),使用此卷积核在SR分支特征图(图中浅灰色)的对应位置进行卷积,得到此位置的梯度感知结果。最后将两个子分支的输出特征图串联,通过1×1的卷积层恢复通道数后输入到CA中,得到一个RGAB的输出。

图2 残差梯度感知块结构图Fig.2 Residual gradient aware block structure

RGAB的设计既保留了原有的RCAB结构,同时避免了直接将梯度域特征图与图像域特征图串联而带来的域冲突问题,也就是将梯度域的特征图作为卷积核作用在图像域的特征图上。实验证明,将梯度域的特征图作为SR分支卷积核的策略可以有效避免域冲突所带来的性能损失。

3.3 梯度融合模块(GFM)

如图1所示,梯度融合模块(Gradient Fusion Module,GFM)由两个分支对应位置的RGAB与RCAB以及两个过渡卷积层组成。GFM的输入输出均有两个,分别是梯度域的特征图与感知梯度的图像域特征图。为了尽可能地确保GFM的两个输出深度一致,RGAB和RCAB是结构相似且数量相同的。此外,为了促使RGAB更准确地利用梯度的深度特征,在不考虑CA层的前提下,GFM两个输出特征图的感受野也是一致的。假设输入特征图的感受野为x,除了特定的1×1卷积层之外,RGAB和RCAB中其余卷积层的核大小均为k×k,则RCAB输出的梯度域特征图的感受野为x+2(k-1),即图2中绿色长方体所代表的特征图的感受野为x+2(k-1)。由于图2中浅灰色所表示的特征图感受野为x+(k-1),因此,GAConv的输出特征图感受野则为x+2(k-1),与梯度域的输出特征图感受野一致。

此外,GASR并不直接将梯度分支的特征图作为卷积核参数,而是在梯度分支的RCAB与SR分支的RGAB之间添加了两个过渡卷积层。经过大量的有监督训练,GFM中的两个过渡卷积层可以使得最终作为卷积核的梯度域特征图更加满足卷积核特性,获得性能上的提升。实验证明,直接地将梯度分支的特征图作为SR分支的卷积核参数会使性能有一定的损失。

4 实验设置及结果分析

4.1 数据集与细节实现

实验中使用的训练数据集为DIV2K[17],其中训练集包含800幅2K的高清图像。在图像超分辨常用的测试数据集上测试模型性能,如Set5[6]、Set14[18]、BSD100[19]、General100[8]等。参考SPSR,选用感知指数(PI)[20]、学习的感知图像块相似度(LPIPS)[21]、峰值信噪比(PSNR)和结构相似性(SSIM)[22]为主要评价指标,其中LPIPS与PI越低表示SR图像的感知质量越好。

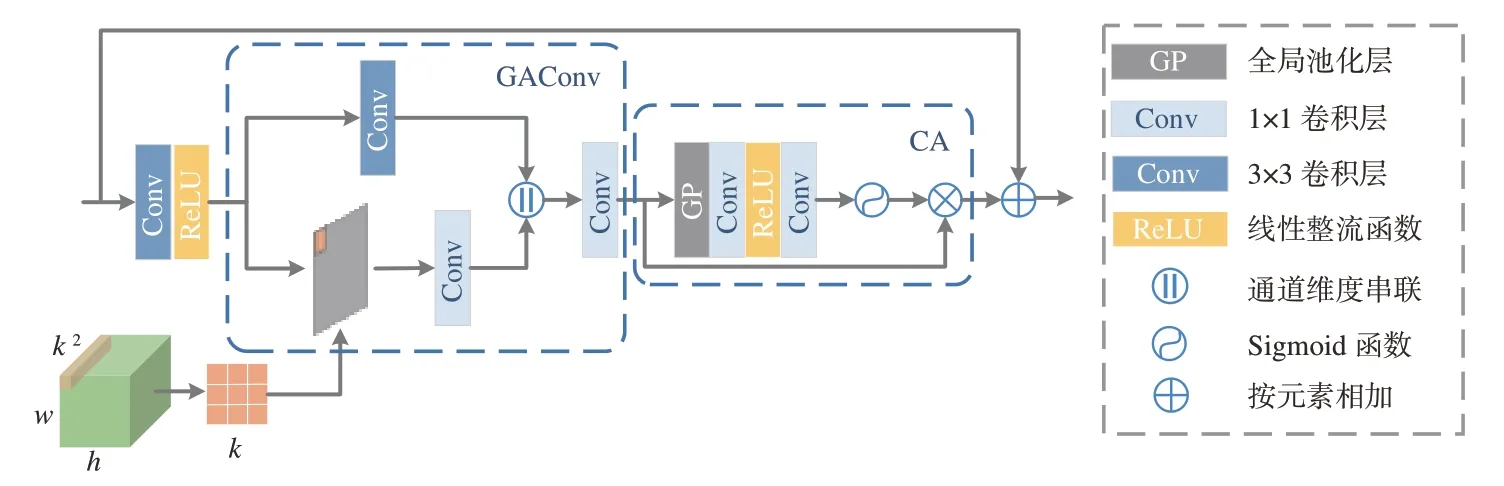

在训练过程中,首先在DIV2K的800个LRHR图像对中随机裁剪16个对应的LR图像块与HR图像块,其中LR图像块大小为48×48,对其进行随机旋转与水平翻转,以变换后的16个图像对为一批对网络中参数进行更新。具体训练步骤有3步:(1)训练放大因子为2的SR模型,即裁剪的HR图像块大小为96×96,损失函数仅保留SR图像上的L1损失;(2)以损失收敛后的2倍的模型为预训练模型训练放大因子为4的SR模型,即裁剪的HR图像块大小为192×192,同样地仅保留L1损失;(3)结合内容损失与对抗损失对4倍的模型进行微调得到可以生成具有更好感知质量的SR模型。其中第(1)、(2)步是为了保证SR图像中图像内容的正确性,第(3)步可以达到提升SR图像感知质量的目的。损失函数如式(7)~(14)所示,最后一步训练所采用的损失函数为:

其中:a1=1,a2=0.01,a3=0.005,b1=0.01,b2=0.005,c=0.5。优 化 器 使 用ADAM优 化器[23],参数设置为β1=0.9,β2=0.999,ε=10-8。由于2倍的SR模型是随机初始化的,因此初始学习率设置为10-4,4倍的SR模型与最终的SR模型均设置初始学习率为6-5,每2×105次迭代学习率衰减为原来的1 2。此外,每1 000次迭代在Set14数据集上测试一次,可以直观地观察当前的训练效果。经过反复实验,最终确定RGAG与RG的数 目M=7,每个RGAG中的RGAB与RG中 的RCAB的数目N=14,未进行特殊说明的卷积核尺寸均为3×3,网络通道数为32。所有实验均使用PyTorch实 现,在GeForce RTX 2080 Ti GPUs上运行。

4.2 消融实验

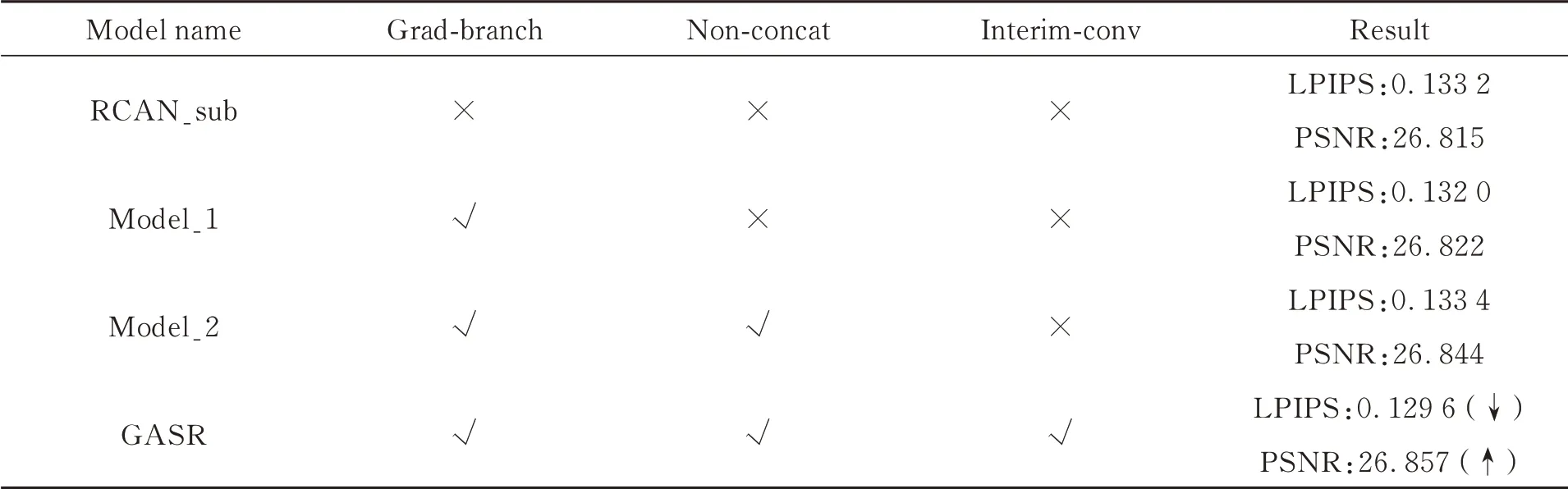

本文对GASR所提出的改进点做消融实验,以支撑本文论点的正确性,消融实验的结果如表1所示,均为Set14上测试结果的平均值。

(1)梯度分支的有效性。本文构建了双分支网络模型GASR,其中梯度分支作为SR分支的辅助分支,为LR图像的超分辨过程提供梯度信息。为了证明梯度分支的有效性,在对比实验中,我们构建了减少通道数与基础构建块数目的RCAN模型,相当于去除GASR中的梯度分支,记为RCAN_sub。对比表1中RCAN_sub与GASR的实验结果可以发现,GASR的LPIPS优于RCAN_sub,并且RCAN_sub在PSNR上也逊色于有梯度分支的GASR。这有效地验证了梯度分支的存在对于更准确地重建高分辨图像的边缘结构起着积极的作用,有助于提升SR图像的视觉质量。

(2)域冲突的影响。为了证明本文所提出的避免不同域特征图串联来缓解域冲突问题策略的有效性,本实验构建了直接将图像域与梯度域特征图在通道维度串联的网络模型,记为Model_1。Model_1模型的上下分支均以RCAB为基础构建块,梯度分支的每个RCAB输出不仅作为下一个RCAB的输入,同时要与SR分支对应位置的RCAB的输出在通道维度串联,再经过一个1×1卷积层恢复通道数,此输出作为SR分支下一个RCAB的输入。从表1的实验结果可以发现,不同域的特征图直接串联造成了LPIPS与PSNR不同程度的恶化,表明直接将图像域与梯度域的特征图串联所造成的域冲突问题会导致图像超分辨性能的下降。

表1 消融实验各评价指标结果(Set14×4)Tab.1 Evaluation index of ablation experiment(Set14×4)

(3)过渡卷积层的必要性。本实验将GASR中RGAB与RCAB之间的两个过渡卷积层移至梯度分支的相邻RCAB之间,以证明过渡卷积层的有效性。首先在GASR中去除两个过渡卷积层,接下来在梯度分支的相邻RCAB之间添加两个1×1卷积层。第一个卷积层将上一个RCAB输出的梯度域特征图的通道数转换为3×3=9个通道,此卷积层所输出的特征图不仅用于下一个卷积层的输入,同时也要作为对应位置RGAB中卷积层的卷积核参数。第二个卷积层起到恢复通道数的作用,记此网络为Model_2。由表1的实验结果可知,去除了过渡卷积层的Model_2在LPIPS和PSNR指标上均逊色于GASR,此结果验证了过渡卷积层可以起到使得梯度域特征图更加符合卷积核特性的作用。

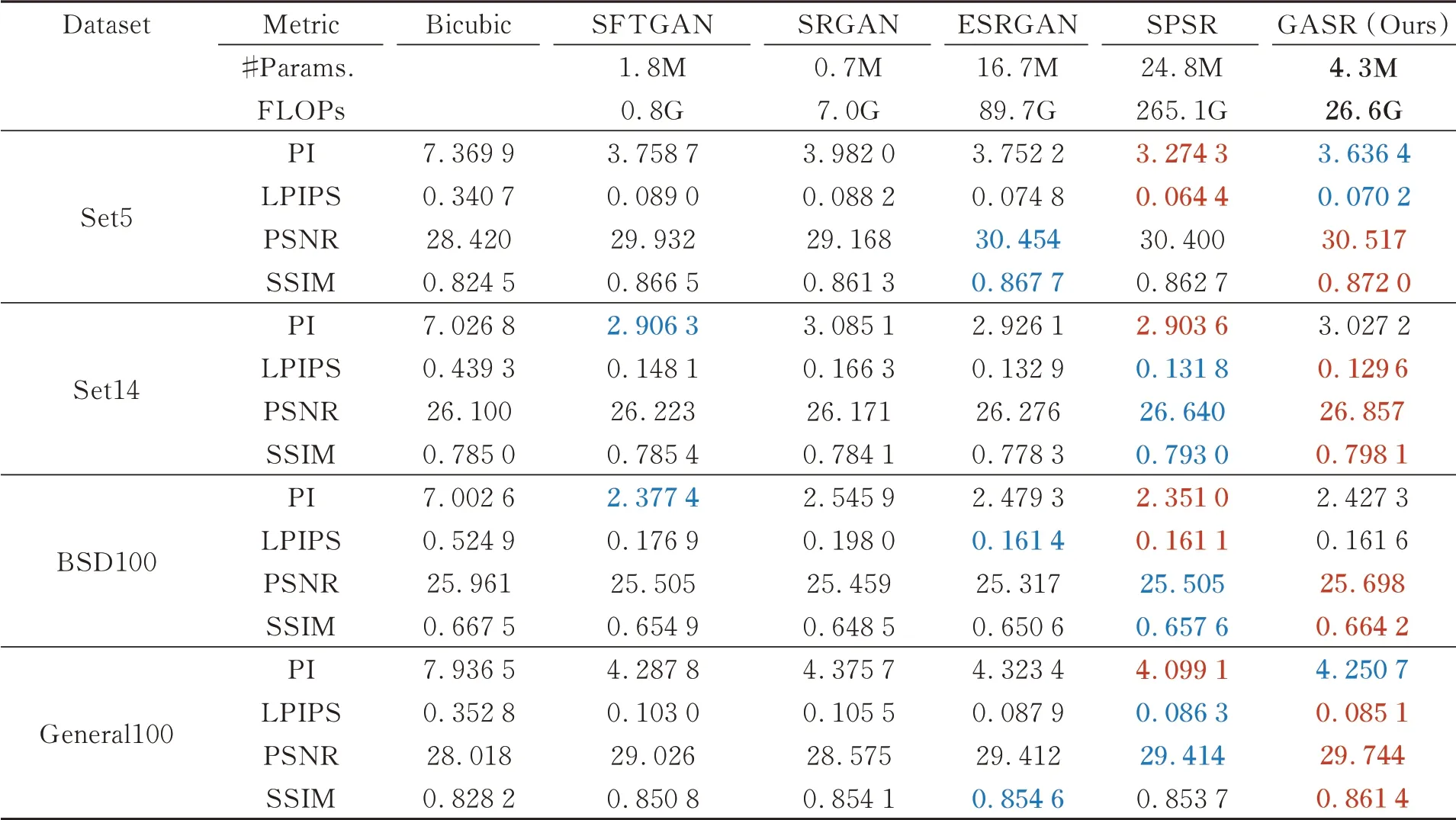

4.3 基准数据集的对比实验

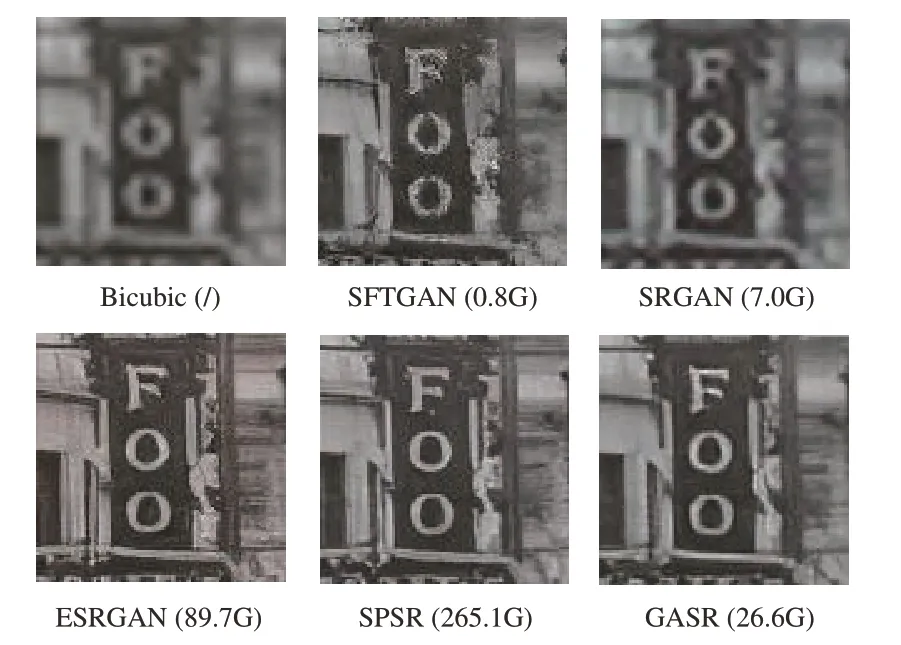

本文将GASR的实验结果与之前性能较好的感知驱动的SR算法做定量与定性上的比较,对比算法包括SFTGAN[24]、SRGAN[3]、ESRGAN[13]、EnhenceNet[25]与SPSR[4]。定 量 比 较 结 果 如 表2所示,定性比较结果如图3所示。

(1)定量对比。从表2可以看出,虽然SPSR达到了比较好的LPIPS与PI,但其参数量与计算量较大,其中参数量是GASR的5.7倍,FLOPs是GASR的10.2倍,GASR以绝 对 的 参 数 量 与计算量优势达到了与SPSR相近的性能。与ESRGAN相比,GASR也以更少的参数量与计算量取得了更好的性能,其中ESRGAN的参数量是GASR的3.9倍,FLOPs是GASR的3.4倍。虽然SFTGAN与SRGAN参数量与计算量较少,但其性能上逊色于其余的对比算法。此外,与感知驱动的对比SR算法相比,GASR在所有数据集上取得了最好的PSNR与SSIM,表明其在感知质量与平滑度之间取得了更好的平衡。表2中的结果表明,本文所提出的GASR相较于其余感知驱动的SR算法以较少的参数量达到了优越的性能。

表2 与先进的感知驱动的SR方法的比较结果(×4)Tab.2 Results compared with advanced perception-driven SR method(×4)

(2)定性对比。图3展示了GASR与其余感知驱动的SR算法在视觉效果上的对比。从第1组对比图可以看出,SRGAN所恢复的图像趋于平滑,难以恢复塔尖的细节;EnhenceNet、SFTGAN与ESRGAN虽然能够恢复出塔尖的大体结构,但对于细节的恢复还有待提升;SPSR虽然能够恢复出部分塔尖的细节,但GASR的细节更为准确,与HR图像更为贴合。观察第2、3、4组对比结果可知,SRGAN均会产生过度平滑的SR结果,EnhenceNet、SFTGAN、ESRGAN与SPSR会产生一些杂乱的纹理,导致SR图像严重失真,而GASR在平滑度与纹理生成之间取得了更好的平衡,获得了更好的视觉效果。这有效地验证了GASR可以更准确地恢复图像的结构信息,产生视觉质量更优的SR图像的结论。

图3 与先进的感知驱动的SR方法的视觉比较结果(×4)Fig.3 Results compared visually with perceptual-driven SR methods(×4)

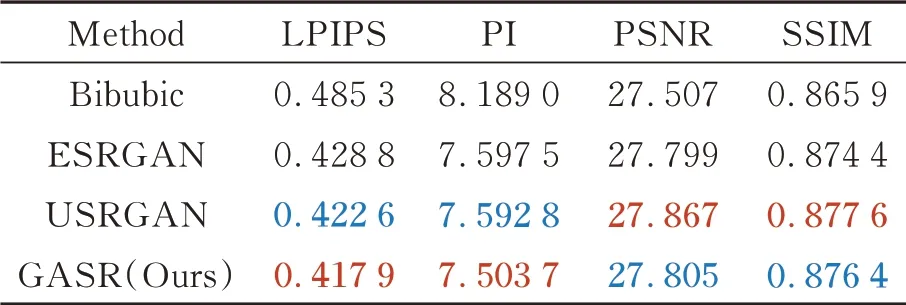

4.4 真实图像的对比实验

除了在基准数据集上对GASR做定量与定性分析之外,也在真实图像上分析了GASR的有效性。本实验选取感知驱动的SR算法如SFTGAN[24]、SRGAN[3]、ESRGAN[13]、USRGAN[26]、SPSR[4]与GASR做比对。

RealSR[27]是通过调节相机焦距并利用图像配准算法获得的真实LR-HR图像对的数据集。本实验随机选取RealSR中的46对LR-HR图像对作为测试图像,将GASR与双三次(Bibubic)插值、ESRGAN与USRGAN进行比较,定量比较结果如表3所示。与计算复杂度更高的ESRGAN相比,GASR以复杂度低的优势在各个评价指标上均胜出,而USRGAN虽然取得了更高的PSNR与SSIM,但其所得SR图像的感知质量不及GASR。定性比较结果如图4所示。SFTGAN与ESRGAN均会产生不同程度的杂乱纹理或失真现象,SRGAN难以恢复图像的边缘,而GASR虽然有少量人工伪影,但其相较于上述3种算法所恢复出的图像边缘更加清晰。虽然SPSR可以构建出更清晰的图像边缘,但从图4括号中所标注的FLOPs看出,SPSR的计算量是GASR的10倍左右,这极大地限制了SPSR在真实场景中的应用。

表3 RealSR数据集上的比较结果(×4)Tab.3 Comparison results on RealSR datasets(×4)

图4 真实图像上的对比实验结果(×4)Fig.4 Comparison of experimental results on real images(×4)

5 结 论

本文提出了一种较轻量的梯度感知图像超分辨(GASR)算法,可以更准确地利用图像的梯度域信息,产生具有更好感知质量的SR图像。GASR主要从以下两个方面达到准确利用梯度域信息的目的:首先,将梯度域的特征图作为作用在图像域特征图上的卷积核,如此可以有效地避免不同域特征图串联所带来的域冲突问题;其次,为了保证梯度域特征图和图像域特征图在对应位置的感受野一致,在卷积核尺寸等模型细节上进行了一定设计。最终GASR以4.3M的参数量与26.6G FLOPs的计算量达到了比其他感知驱动的SR算法更好的性能,在纹理生成与平滑度之间取得了更好的平衡。