面向地外天体表面智能感知与操控研究的多源数据集

邢 琰,姜甜甜,贾 永,刘 磊,杨孟飞

1. 北京控制工程研究所,北京 100094 2. 空间智能控制技术国防科技重点实验室,北京100094 3. 中国空间技术研究院,北京 100094

0 引 言

月球、火星等地外天体表面自主探测需要在有限资源约束下, 解决自主导航, 复杂环境感知识别, 安全高效路径规划以及平稳协调运动控制等关键技术,我国已经实施了两次月球表面巡视探测和一次火星表面巡视探测,未来月球、火星等地外探测任务对表面探测位置、范围和效率的需求明显提高,着陆精度由公里级提升到百米级,探测范围从公里级扩展到百公里级以上,移动时速从百米级提高到公里级以上,并能实现对感兴趣科学目标的精准采样. 新的任务需求要求探测系统具有更强的地外环境适应能力,并具有更强的智能水平,解决复杂环境的感知理解、多任务多约束下的规划与决策,以及地外移动与作业等精准操控,以满足未来复杂地外环境下的大范围远距离高效科学探测任务需求.

未来的地外探测已展现出人工智能的广阔应用前景,探测器可根据任务目标、自身状态和未知环境特点,主动感知环境、理解环境,发现高价值目标,进行可靠推理和有效决策,并通过高精度导航和操控实现决策任务目标.

智能模型的训练与测试需要合适的数据集做支撑. 美国JPL实验室于2017年11月发布了火星科学实验室表面数据集[1](MSL surface dataset),该数据集来自好奇号漫游车第3~1060个火星日(2012年8月-2015年7月)用安装在桅杆上的左右桅杆相机(mast camera,MastCam)和安装在火星车机械臂顶端的透镜相机(Mars hand lens imager,MAHLI)采集的图像数据,包含24类6,691张尺寸约为256pixel×256 pixel火星表面环境图像,24类标签由火星科学家确定,包括阿尔法粒子X射线光谱仪(Alpha particle X-ray spectrometer,APXS)、MAHLI、车轮等漫游车上的多类设备,以及地面、水平线等火星星表目标. 2020年9月,又发布了MSL surface data set v2数据集[2-3],该数据集的来源与MSL Surface Data相同,具体由6,820张大小为227 pixel×227 pixel的图像组成,标签为19类感兴趣的科学和工程目标,增加了沙地、车轮轨迹等类别.

DORAN等[4]于2020年9月发布了HiRISE火星轨道器图像数据集v3.2(HiRISE orbital data set version 3.2),由火星勘测轨道器(Mars reconnaissance orbiter, MRO)的高分辨率图像试验相机(high resolution imaging science experiment, HiRISE)采集的232张灰度图像中检测、提取和增强生成的64,947张地标图像组成,其中10,815张为原始地标图像,其余54,132张地标图像通过对原始地标图像进行旋转、翻转、亮度调整等生成. 该数据集中图像尺寸为227 pixel×227 pixel,分辨率为30cm/pixel,包含陨石坑、沙丘、斜坡条纹等8类地标标签(Bright dune, Crater, Dark dune, Impact ejecta, Slope strak, Spider, Swiss cheese, other). WILHELM等[5]利用火星勘测轨道器(MRO)背景相机(context camera,CTX)拍摄的163张灰度图像,建立了更加多样化的DoMars16数据集. 该数据集包含了由火星表面常见的15种不同地形地貌组成的16,150个样本(沙丘、悬崖、山脊、沟渠、峡谷等),样本图像大小为200 pixel×200 pixel,分辨率为6m/pixel,可用来构建火星表面地形地貌图,并用于着陆区域选取. 以上数据集中,单张图像对应一个标签,可用于行星科学、地质地貌学的研究,也可用于火星星表图像识别算法的训练.

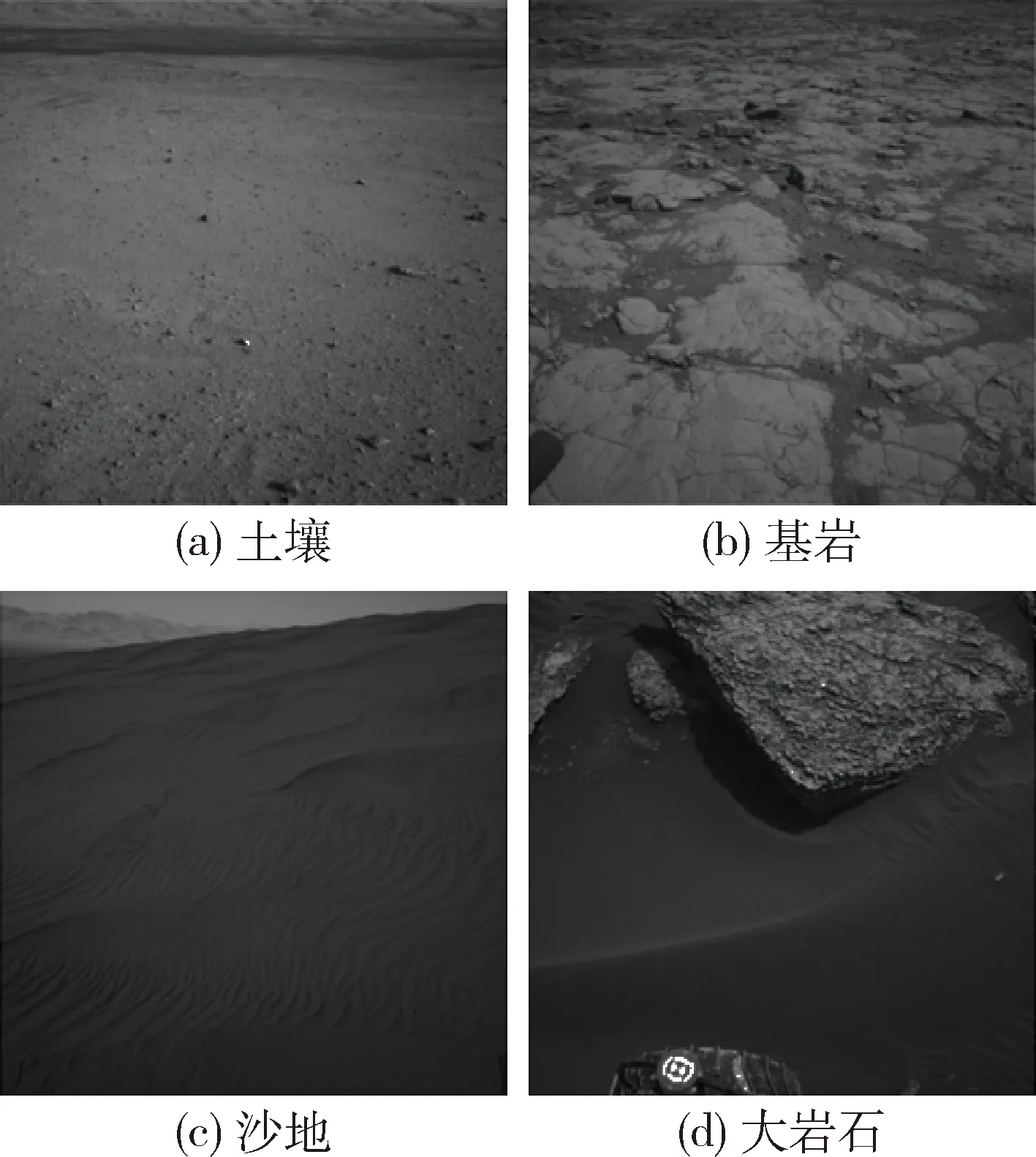

近年来,为推动深度学习技术等在火星巡视探测任务中的应用,提升火星探测器的自动驾驶能力,发展出多个用于训练和验证火星地形分类模型的语义分割图像数据集. 欧空局(ESA)发起的LabelMars项目,实现了对勇气号、机遇号和好奇号5,000张导航图像的语义分割和标注,标注的标签涉及约20个地质/地形地貌类别(例如:“concretions/nodules”,“dark-toned magmatic outcrop”,“light-toned sedimentary float rock”)[6].然而,这些类别具有很强的专业性,只能由训练有素的相关领域专家给出准确解释,对于数据集的高质量扩充提出了挑战.SWAN等[7]进一步发布了具有4类简化标签的AI4Mars数据集,该数据集由来自好奇号导航相机(NavCam)灰度图像和桅杆相机(MastCam)彩色图像、以及机遇号和勇气号导航相机(NavCam)灰度图像共计约35,000张,人工生成约326,000张带有沙地、土壤、基岩和大岩石4类语义标签的图像样本(图1),其中还包含由领域专家标注生成的约1,500张标注样本数据,可用于火星地形分类模型的训练和性能评估.

图1 AI4Mars四类样本图例Fig.1 Representative examples of four classes of AI4Mars

此外,德国航空航天中心(German aerospace center,DLR)下属的机器人学和机电学研究中心(institute of robotics and mechatronics)发布了用于视觉-惯性导航的火星模拟探索MADMAX(morocco-acquired data set of Mars-Analog exploration)数据集[8-9],该数据集包含在摩洛哥8个火星模拟站采集的36组导航实验数据,其轨迹长度约9.2 km,最长轨迹1.5 km,提供了带有时间戳的黑白立体相机、单个彩色相机、全景立体相机、以及惯性测量单元IMU的实测数据,以及基于全球导航卫星系统GNSS获得的位置和方位真值数据,还给出了真值数据的不确定程度. 该数据集可用于评估导航算法的准确性和鲁棒性.

与地面结构化路面无人驾驶不同,地外天体表面场景原始复杂,图像信息能够提供地形地貌特征,但无法反应内部物理化学特性,如土壤颗粒度、硬度、紧实度以及成分组成等,而上述特性会影响地外天体表面探测时的移动通过性能及机械臂采样成功率,因此除表面地形地貌精细化重建之外,对内部浅表层的感知和识别,是影响地外天体探测安全性和效率的重要因素,也是地外天体精准感知与操控研究的关键.目前已有数据集不能满足上述研究需求.

北京控制工程研究所建立了月球及火星巡视探测GNC物理仿真试验系统,并面向我国未来深空探测重大工程任务需求,持续开展地外天体探测研究与地面试验验证条件和能力建设,目前已建成“智能无人系统实验室”. 智能无人系统实验室能够实现对地外天体表面地形地貌的模拟,并基于我国“祝融号”火星车的六轮摇臂悬架式移动机构研制了智能无人系统地面样机,能够获得模拟地外天体表面环境的多源数据及火星车作业过程中的状态数据,为月球、火星等地外探测智能无人系统提供制导、导航与控制技术研究与验证条件,并为基于人工智能的深空探测感知、识别与操控等理论方法研究和应用提供学习训练和推理验证条件. 基于实验室条件,构建了面向地外精准感知识别与操控理论方法研究的多源数据集“天衢1.0”. 本文首先介绍了生成“天衢1.0”数据集的模拟地外场景建设情况,在此基础上详细介绍了数据集内容及构建情况,最后给出了数据集的公开发布链接.

1 模拟地外场景

地外场景模拟主要针对与感知理解、规划决策与作业操控性能相关的地形地貌、光照及不同目标的表面热特性进行模拟,对空间辐射环境暂不考虑.

(1)地形地貌模拟

与地面无人驾驶相比,月球和火星等地外天体表面地形地貌的特点是原始自然,无道路、桥梁和建筑等人工目标. 月球和火星表面环境有较大差异,月球表面覆盖松软月壤,颗粒度小,最表层的粉末状月尘,粒径一般小于1 mm[10-12].火星和地球一样拥有多样的地形,有高山、平原和峡谷,火星基本上是沙漠行星,地表沙丘、砾石遍布. 由于重力较小等因素,地形尺寸与地球相比亦有不同的地方. 南北半球的地形有着强烈的对比:北方是被熔岩填平的低原,南方则是充满陨石坑的古老高地,而两者之间以明显的斜坡分隔;火山地形穿插其中,众多峡谷亦分布各地,南北极则有以干冰(固态的二氧化碳)和水冰组成的极冠,风成沙丘亦广布整个星球[13].

智能无人系统实验室采用基础地形和表面地貌两部分以模拟地外地形地貌特征. 基础地形包括平坦地形(坡度小于5°)、坑地(深度大于10 cm,直径大于1 m)、坡地(坡度5°~20°,坡长不小于1.5 m)和沟壑、山脊、山谷等陡峭地形(坡度大于20°). 表面地貌部署均匀板岩、粗糙板岩、密集尖利碎石群、零散分布露岩和基岩露头等不同地物,以及材质粒度和成分不同的包括粗沙、细沙和细尘等. 同时,为获得更多类型物理和化学特性不同的目标物体数据集,在沙石场地内还布设了煤、塑料、橡胶、木块、金属等目标,获得的多源数据可支持多类型目标精准感知与采集作业精准操控方法研究与验证.

模拟场地全景如图2所示.

(2)光照模拟设备

地外天体因大气环境和对日距离与地球不同,表面光照条件与地球表面有较大差异. 月球表面无大气,太阳光入射到月球表面时无散射现象,因此月表光照为平行光,在光照遮挡区域为全黑阴影,可见光相机无法清晰成像. 火星表面有微弱大气(大气密度约为地球的1%),太阳光照透过火星大气时会产生漫反射和Mie散射,因此火星表面光照为非平行光. 火星距太阳平均距离约为1.52AU,火星表面的最大光照强度约为地球的43%.

为同时满足平行光和散射光照条件模拟需求,智能无人系统实验室采用大面积平行光灯阵和顶部光源的光照模拟设备. 室内大面积平行光模拟是技术难点. 传统太阳模拟器通常以氙灯、卤素灯为光源,光照面积一般在1m2以内,面积增大会导致成本和能耗急剧增大. 空间智能无人系统实验室创造性采用基于LED光源、非球面聚光透镜和菲涅尔透镜准直的方案,LED光源具有光效高、发热量小、响应快和寿命长等特点,经聚光和准直产生大面积平行光. 光照模拟系统采用9800个LED光源,10 m×10 m的光照模拟,且入射角度可调,能够在场地内产生10 m×20 m的平行光照射区域,平行度优于±2°,为地外平行光条件下智能无人系统验证提供有效的光照条件.图3所示为室内平行光模拟设备.

图3 室内平行光模拟设备Fig.3 Indoor parallel light simulation equipment

(3)热特性模拟设备

天体表面热特性也是影响感知和操控的因素之一. 室内封闭环境下温度平衡后,难以准确反映地外天体表面昼夜表面温度变换情况,为验证热特性变换并提供热特性研究条件,实验室建立了具有主动加热和制冷能力的热特性模拟设备,可以模拟地外天体一个昼夜的温度变换规律,并通过温度测量设备和热惯量计算软件进行测量和计算,用于辅助判断热辐射不同的地形,辅助识别可见光难以判断的危险.

上述环境模拟设备提供的3个环境特征要素,能够反映影响精准感知和操控效能的关键因素,通过组合能够模拟地外天体表面的复杂场景,用于精准感知与操控学习训练数据集构建,支持研究人员通过表面地形地貌测量、温度和多光谱测量进行对地外环境的深层学习感知与理解研究,实现规划决策与精准操控.

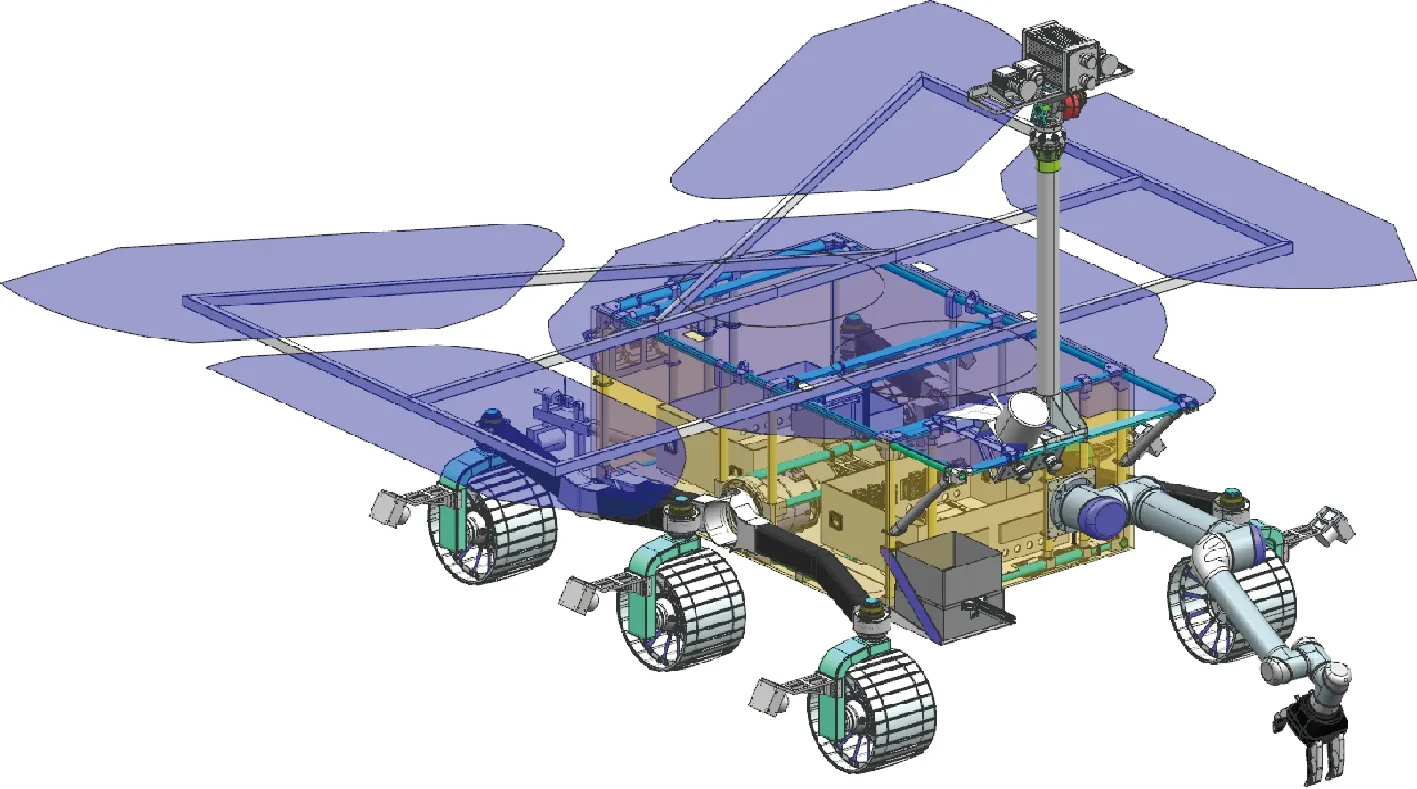

2 数据采集与验证平台

数据采集与验证平台为基于我国“祝融号”火星车的六轮摇臂悬架式移动机构的智能无人系统地面样机,如图4所示. 地面样机上配备可见光相机、热成像仪、多光谱相机、激光雷达和深度相机共五类环境感知敏感器,并配备集成三正交安装的光纤陀螺和石英挠性加速度计的惯性测量单元用于获得惯性导航信息,6个轮的轮轴上各安装一套六维力/力矩传感器,测量轮轴3个方向的受力和力矩情况. 采用高精度绝对编码器,获得机构转速和转角信息. 样机配备CPU+GPU异构智能计算平台,数据采集与存储软件运行在智能计算平台上,并通过并行采集链路和时序优化设计保证多源数据采集同步性.

图4 数据采集与验证平台—智能无人系统样机Fig.4 Data acquisition and verification platform—intelligent unmanned system prototype

3 数据类别及属性

数据集由多源环境感知数据、自身状态测量数据、外测精准位姿数据和外测精准地形数据四个部分组成,不同数据带有时间戳,保证多类数据的时间一致性.

3.1 多源环境感知数据

为支持对地外复杂场景的精准感知和透彻理解研究,数据集提供5类多源环境感知数据.

(1)可见光图像

可见光图像包括RGB彩色图像和黑白图像两类. 彩色图像和黑白图像均为成对图像,其中彩色图像对基线长度为0.3 m的成对图像,图像分辨率为2048 pixel×2048 pixel,视场大小为50.28°×50.28°. 视线高度为1.5 m,视线方向下俯30°. 黑白图像对基线长度为0.1 m,图像分辨率为1024 pixel×1024 pixel,视场大小为150.83°×120.66°,视线高度为0.6 m.

(2)热图像

热图像由热成像仪采集,图像分辨率为640 pixel×512 pixel,视场大小为24.6°×19.8°,温度范围为-20℃-150℃,采集视线高度和方向与彩色可见光图像获取方式一致.

(3)多光谱图像

多光谱图像是由9通道多光谱相机采集的光谱反照率图像,9个光谱谱段分别为400 nm、480 nm、525 nm、650 nm、700 nm、800 nm、900 nm、950 nm、1000 nm. 相机视场为19.2°×16.1°,图像分辨率为2448 pixel×2048 pixel,采集视线高度和朝向与彩色可见光图像获取方式一致.

(4)激光雷达数据

激光雷达数据由40线激光雷达采集获取,精度为±2 cm,扫描视场角为360°(H)×40°(V),角分辨率为0.5° (H)×0.3°(V). 激光雷达安装高度约为0.6 m,扫描视线与黑白可见光图像一致.

(5)深度相机数据

深度相机数据包括点云、深度、置信度和强度,由TOF机制的深度相机采集获得. 相机分辨率为640 pixel×480 pixel,视场为67°(H)× 51°(V), 5 m内测量精度为±5 mm.

多源环境感知数据以图像和PCD点云文件形式表示,具体定义及属性如表1所示.

表1 多源环境感知数据定义与属性Tab.1 Definition and attributes of multi-source environment perception data

3.2 自身状态测量数据

为支持对地外复杂场景的精准感知和透彻理解研究,数据集提供四类反映智能无人系统运动及受力情况的自身状态测量数据,由配备在智能无人系统样机上的敏感器采集获得,包括惯性测量数据、运动机构测量数据、轮地接触力与力矩测量数据及沉陷测量数据.

(1)惯性测量数据

惯性测量数据由安装在智能无人系统上的惯性测量敏感器采集获得,惯性测量单元(IMU)由3个正交安装的光纤陀螺和3个石英挠性加速度计组合而成,3个陀螺输出三轴角速率,单位为(°)/s,零偏稳定性和重复性均小于0.1(°)/h. 三轴加速度计输出数据量纲为g,绝对精度优于1mg.

(2)运动机构测量数据

运动机构测量数据为智能无人系统样机六轮摇臂式移动机构的运动数据,包括六轮速度、六轮转角、六轮转向速度、摇臂角度、悬架角度和角速度,以及六轮和悬架驱动电机电流. 角度量纲为度(°),速度量纲为度/秒((°)/s),电流量纲为安培(A).

(3)轮地接触力与力矩测量数据

轮地接触力与力矩测量数据由内置在6个车轮中的六维力/力矩传感器采集获得,包括6个车轮与地面的三维接触力和三维接触力矩,量纲分别为N和N·m.

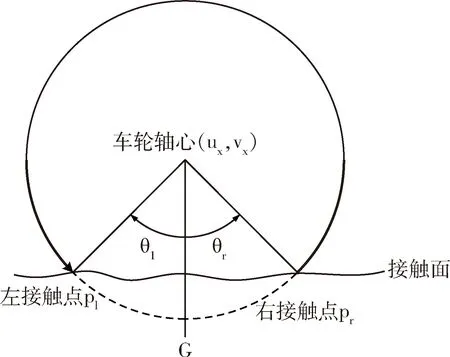

(4)沉陷测量数据

沉陷测量数据包括6个车轮与地面接触后的沉陷量,量纲为mm. 每个车轮沉陷量由前端沉陷量和后端沉陷量两个数据表征,分别反映车轮与地面的前后接触点处的沉陷量,如图5所示.

图5 沉陷量测量示意图Fig.5 Schematic diagram of subsidence measurement

自身状态测量数据以数据文件形式存储. 自身状态数据每200 ms采集一次,每一帧数据包含以上4类测量数据.

3.3 外测精准位姿数据

外测精准位姿数据是通过高精度摄影测量设备测量并处理获得的智能无人系统准确的位置和姿态信息,位置精度优于2 mm级,姿态精度优于0.1°. 位置参考坐标系为场地内固定原点处的北东地坐标系,姿态为智能无人系统本体坐标系(前-右-下)相对北东地坐标系的欧拉角,转序为1-2-3.

外测精准位姿数据以数据文件形式给出,每一行记录某一时间的一组位姿信息,分别为:外测时间戳、位置X、位置Y和位置Z,姿态Rx、姿态Ry和姿态Rz(1-2-3转序). 其中位置量纲为m,姿态量纲为(°).

3.4 外测精准地形数据

外测精准地形数据是对全场地形事先进行精准扫描,并利用精准位姿信息获得智能无人系统前方10 m(前)×5 m(宽)区域内的地形数据,并转换到获得左RGB图像的相机坐标系下. 精准地形数据精度优于2 mm,可用于深度学习双目匹配重建和精确定位模型训练及性能评估.

外测精准地形数据以PTS文件形式给出,每个.pts文件为某一位姿对应的三维地形数据,文件按当前时刻的外测精准位姿数据的时间戳命名,以便与位姿信息对应. 如当前外测精准位姿文件时间戳为13521468,则该位姿下前方指定区域内的精准地形数据文件为13521468.pts.

4 数据集构建

模拟地外场景下,利用智能无人系统样机对场地里布设的各类地形地貌、目标和场景进行多源数据采集;采集方式包括静态采集、微动态采集(同一目标场景微调视角采集)和全场地移动采集.

4.1 静态数据集

对场景内多位置多视角进行多源数据采集,采集方式包括多位置静态采集和微动态采集(同一位置微调姿态后采集).每次数据采集时无人系统均处于静止状态,避免多源数据之间的时间同步性误差.采集数据为多源环境感知数据,按可见光图像、热图像、多光谱图像、激光雷达数据和深度相机数据分别进行记录并存储,每个位置和视角下采集的多源数据存储为一个数据文件夹,全部位置和视角下的多源数据构成一套静态数据集.

4.2 动态数据集

对模拟场地进行精准地形扫描重建后,获得外测精准地形数据. 智能无人系统样机在全场地内移动并采集多源环境感知数据和自身状态测量数据,采集的数据存储为ROS动态数据包形式. 移动采集过程中,同时获得并存储外测精准位姿数据和外测精准地形数据,并通过时间戳建立对应关系. 动态数据包里每帧数据包含采集时间戳和精确外测位姿信息,用于与外测地形数据对应,保证数据集内每一帧数据时间同步.

动态数据集采集过程中,无人系统移动速度设为50 m/h,既保证数据连续性,又保证数据具有良好的时间同步性,同时避免大动态导致的数据误差. 动态数据集中既包含自采集的多源环境感知数据和自身状态数据,同时给出了相应时刻的精准外测位姿和地形三维信息,能够支持双目匹配、基于多源数据的目标检测、分割与定位等智能方法研究与验证.

4.3 数据集发布

第一版数据集“地外探测智能精准感知与操控多源数据集天衢1.0”将在北京控制工程研究所所刊《空间控制技术与应用》官方网站www.acabice.cn上公开发布,为国内外专家学者开展复杂自然场景下的智能感知、识别、导航、规划与操控等相关研究提供训练与测试基础数据.

5 结 论

“天衢”数据集1.0既包含了复杂自然场景下的图像、点云、温度、多光谱反照率等反映环境特性的多源数据,又包含了智能无人系统移动作业过程中的姿态、位置、速度、力/力矩及沉陷量等自身状态数据,同时还提供了精准的外测基准位姿数据与三维地形数据,能够为地外探测智能感知、识别、导航、规划与操控研究提供数据集,用于智能算法的学习训练和测试验证. 后续在初始数据集基础上,将进一步完善并扩充,提供更加丰富、真实和准确的环境数据和自身状态数据,包括低重力条件下移动过程中的轮土接触力/力矩信息、受沙尘污染或光照影响的图像信息、以及热特性信息等,以期推动我国深空探测领域人工智能理论方法与应用技术深入研究.