基于小波池的图像分类算法研究

车大庆,吕建秋

(1.华南农业大学数学与信息学院,广东广州 510642;2.华南农业大学创新方法研究所,广东广州 510642;3.广东省科技管理与规划研究院,广东广州 510642)

1 引言

卷积神经网络(CNN)已经成为图像和目标分类的标准载体[1]。由于层结构符合输入的形状,CNN拥有比基于矢量的深度学习技术更高的准确率,并对图像、视频等目标进行了精确的分类。这种算法的优点促使研究人员不断地更新和优化CNN 的关键组成部分,即卷积层和池化层,以提高CNN的准确性和效率,超越以往的模型。

池化操作起源于CNN 的前身Neocognitron 和Cresceptron,前者由用户手动进行二次采样,后者在深度学习中引入了第一个max池操作。合并对卷积层的结果进行子采样,从而逐渐减小整个网络中数据的空间尺寸。它的好处是减少了参数,提高了计算效率,并减少了过度拟合[2]。

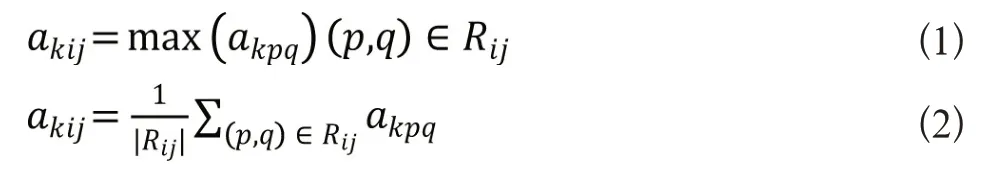

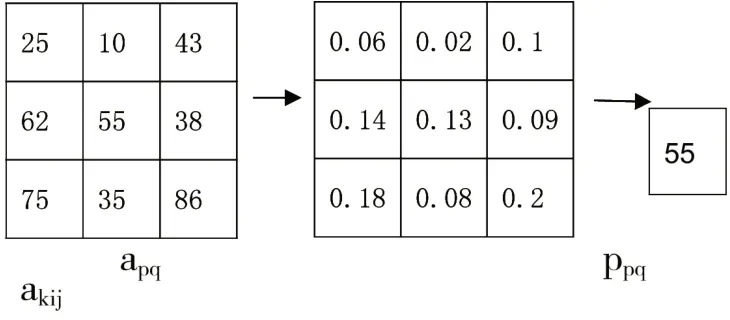

池化是子采样的另一个术语。在该层中,卷积层的输出的维数被压缩,最常用的是最大池化和平均池化。最大池化获取区域的最大值并将其选择为压缩特征图,平均池计算区域的平均值并将其选择为压缩特征图。最大池函数如公式1所示,平均池函数如公式2所示。虽然最大池化和平均池化都是有效的、简单的方法,但它们也有缺点。根据数据的不同,最大池化会消除图像中的细节。平均池取决于数据,它会从图像中淡化相关细节[3]。图1使用示例说明了这些缺点。其他池操作,特别是混合池和随机池,使用概率方法来减少前述池化方法存在的问题。

图1 使用平均池化和最大池化的缺点

2 混合池化

为了解决这些问题,研究人员创建了概率合并方法[4]。混合池在训练过程中通过随机选择一种方法而不是固定使用一种方法来组合最大池和平均池。可通过三种不同方式来创建混合池:

(1)用于层内的所有特征;

(2)混合在层内的特征之间;

(3)混合用于层内不同特征的区域之间。

混合池由公式3所示:

其中,是α随机值0或1,表示区域特征的最大池化或平均池化。

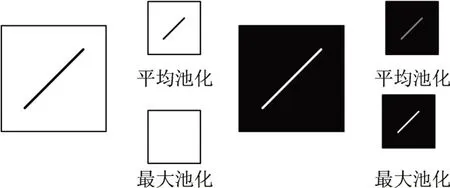

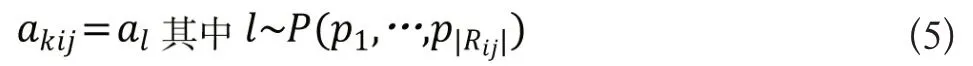

另一种称为随机池的概率池方法,通过基于每个激活的概率值从邻域随机抽样,改进了最大池方法。通过规范化区域内的激活,计算每个区域的这些概率p:

集合激活从基于p的多项式分布中采样,以在区域内选择位置I。这个过程在公式5中得到:

图2显示了3×3区域上随机池的可视化示例:

图2 随机池示例

在图2中,显示了一个激活区域,在相邻区域中,它们的对应概率基于公式5。在任何给定的区域中,具有最高概率的激活具有更高的选择机会。但是,可以选择任何激活。在本例中,随机池方法选择了概率为13%的中程激活。随机池以概率为基础,不具有确定性,避免了最大池化和平均池化的缺点,同时也具有最大池化的一些优点。

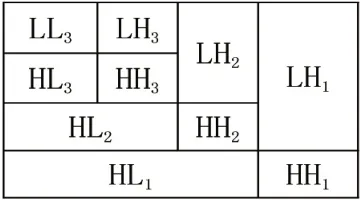

3 小波域

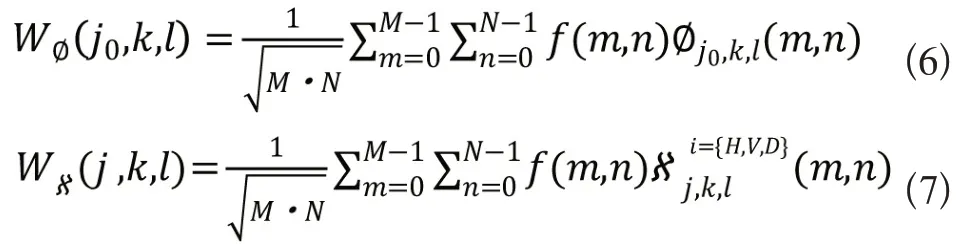

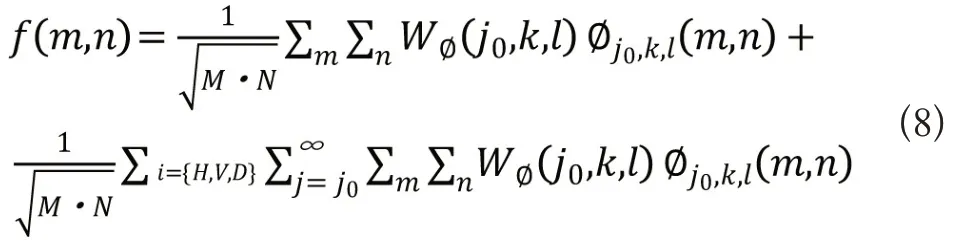

小波理论涉及到在不同的尺度和位置,用更简单、固定的构造块(称为“小波”)来表示一般函数[5]。离散小波变换(DWT)可以看作是对某一连续函数进行采样的数字序列。当以多分辨率处理数字图像时,DWT 是一种可行的数学工具。除了高效、高度直观的多分辨率图像表示和存储框架外,DWT 还提供了对图像空间和频率特性的强大洞察力。我们将二维DWT(2D-DWT)变换对定义为:

其中m和n表示图像的位置,而k和l表示小波的位置。我们将二维离散小波逆变换(2D-IDWT)定义为:

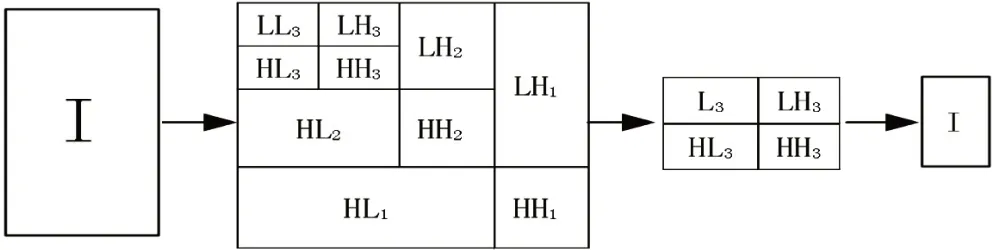

与一维小波变换类似,2D-FWT在分辨率j+1级对近似值进行滤波,以获得j 分辨率下的近似值和细节。然而,在2D情况下,我们期望在水平、垂直和对角线方向上存在三组细节系数。图3给出了3级多级小波分解的表示:

图3 三级小波分解

子带LHj、HLj和HHj,j=1、2,…、J 是细节系数,如上所述,其中j是尺度,J表示分解中最大或最粗糙的尺度[6]。小波分解细节系数允许在每个子带中执行图像处理应用,如果需要,独立地寻址每个子带。一旦在每个期望的子带中进行了处理,就使用IDWT来重建图像。

4 方法概述

池化方法使用邻域来进行子采样,这与最近邻插值很相似[7]。我们提出的合并方法使用小波来降低特征映射的维数,我们使用小波变换来最小化由邻域减少引起的伪影,并且抛弃了一阶子带,更有机地捕获数据压缩。因此,这种有机还原减少了锯齿状边缘和其他可能妨碍正确图像分类的伪影的产生。

4.1 正向传播

本文所提出的小波池方案通过在小波域中根据公式6和公式7 中的二维离散小波变换(DWT)进行二阶分解来汇集特征[8]。在我们的算法中,j=1,2和j0=2。在进行二阶分解后,我们重建图像特征,但只使用二阶小波子带。该方法使用公式8 中的逆DWT(IDWT)将图像特征合并为2 倍,其中j=j0=2。图4给出了小波池正向传播算法的示例:

图4 小波池正向传播算法

4.2 反向传播

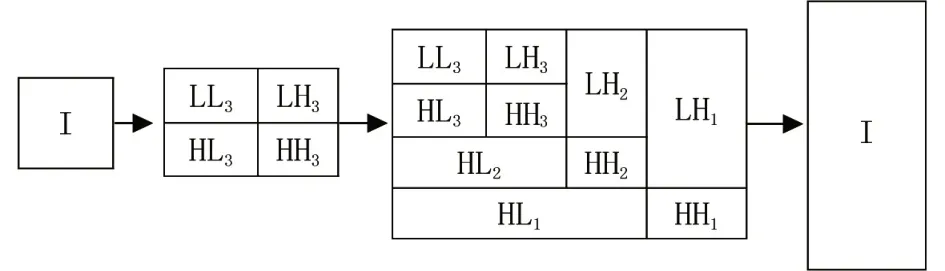

提出的小波池化算法通过对一般的小波传播过程进行反向操作几,即执行反向传播。首先,对后向传播的图像特征进行一阶小波分解;分解后,细节系数子带向上采样2 倍以创建新的第一级分解;接着,初始分解成为第二级分解;最后,这种新的二阶小波分解利用IDWT重构图像特征以进一步进行反向传播。图5详细说明了小波池的反向传播算法:

图5 小波池反向传播算法

5 实验结果与讨论

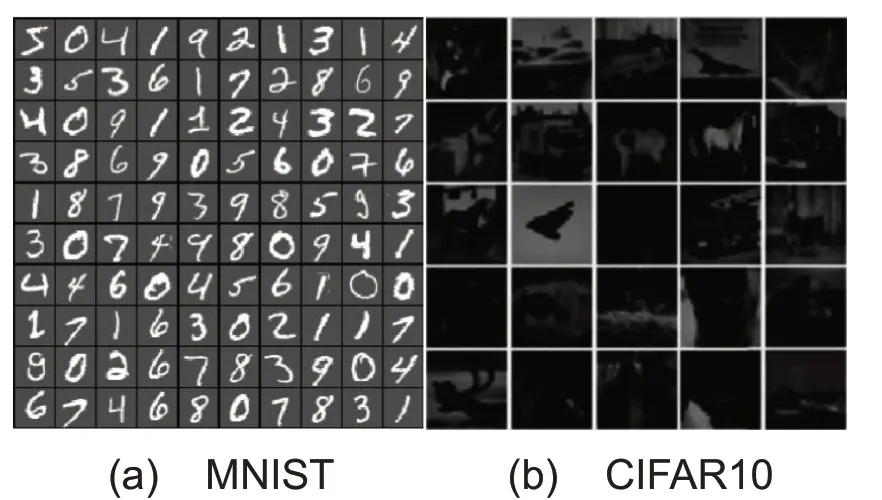

本文在MNIST 和CIFAR-10 数据集上进行试验,以测试本文所提框架的性能。对于我们提出的方法,小波基础是Haar 小波,主要用于其偶数平方子带[9]。在每个我们使用Dropout重复实验,并将CIFAR-10的局部响应规范化替换为批处理规范化,以检查这些规范化技术如何更改变合并结果。为了测试每个数据集上每个池方法的有效性,我们只对该网络中的所有池层使用该方法进行池。所有方法都使用2x2窗口与小波池进行均匀比较。图6给出了每个数据集的选择示例:

图6 数据集选择示例

5.1 MNIST试验

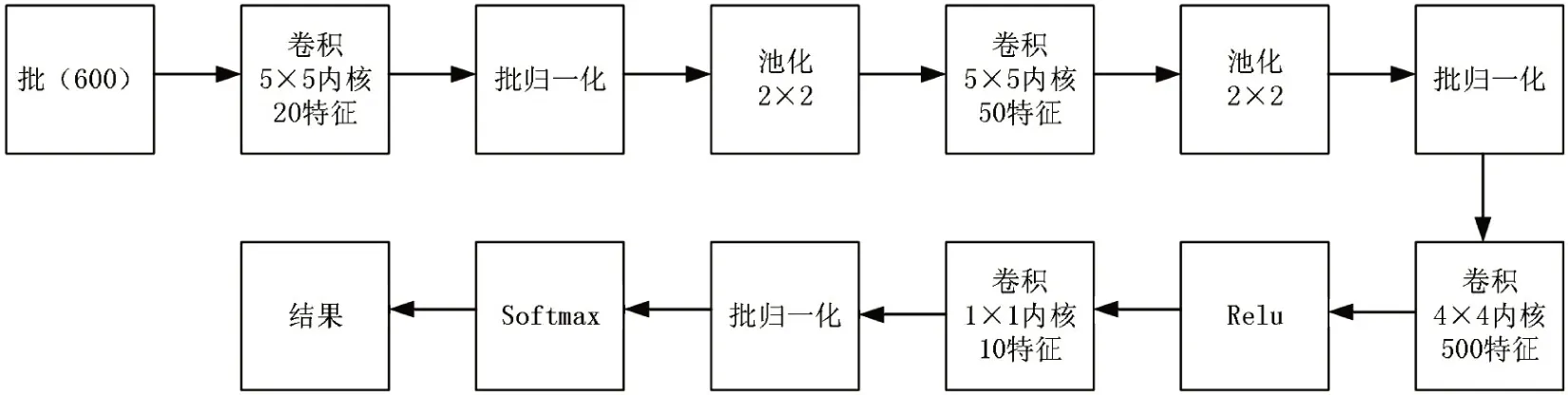

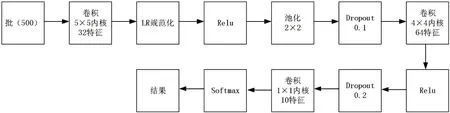

对于MNIST 数据集的实验,所使用的神经网络结构如图7所示。

图7 卷积神经网络结构图

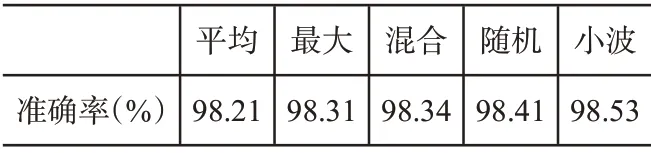

输入的训练数据和测试数据均来自MNIST手写数字数据库。使用了60000 张图片的完整训练集,以及10000 张图片的完整测试集。考虑到epoch的数值很小,最大池是开始训练过程中过度拟合数据的唯一方法。表1显示了每种方法的精度。

表1 五种方法精度表

5.2 CIFAR10试验

我们使用合并方法进行了两组实验。首先是没有Dropout层的常规网络结构。我们使用此网络来观察每种池化方法,而无需进行额外的正则化。第二个使用Dropout方法和批处理规范化,并执行30 多个epochs 以观察这些更改的影响。图8显示了CIFAR-10实验的网络结构。

图8 卷积神经网络CIFAR-10结构图

输入的训练和测试数据来自CIFAR-10 数据集。使用50000 张图片的完整训练集,以及10000 张图片的完整测试集。对于没有Dropout的情况,我们提出的方法具有第二高的精确度。最大池化过容易产生过拟合效果,而小波池操作过拟合不明显[10]。学习率的变化防止了我们的方法过度拟合,并且它继续显示出一种较慢的学习倾向。混合池和随机池保持了一致的学习进度,它们的验证集的趋势与我们提出的方法相似,但速度更好。平均池显示了学习和减少错误方面最平滑的下降。表2和表3分别显示了不同情况下的精度情况。

表2 五种方法精度表

表3 加入Dropout的五种方法精度表

6 结束语

证明了小波池具有与卷积神经网络中目前使用的一些传统方法相同或更好(例如在MNIST实验中)的作用。提出的方法在MNIST和CIFAR-10数据集中进行测试,测试结果与传统方法相近,加上Dropout方法和批处理规范化表明了该方法对网络正则化的响应。此外,许多网络在不同的池方法之间交替,以最大限度地提高每种方法的效率。