低照度环境的车辆检测算法研究

邹莹,龙伟,李炎炎,刘寿鑫

低照度环境的车辆检测算法研究

邹莹,龙伟,李炎炎*,刘寿鑫

(四川大学 机械工程学院,四川 成都 610065)

夜间等低照度环境下,光源复杂、采集图像伴有噪声,图像细节信息弱化,造成夜间车辆目标特征提取困难,误检率、漏检率高。本文以夜间微弱路灯下车辆为研究目标,采集低照度环境中车辆图片,构造夜间车辆数据集,对低照度车辆数据集中部分较暗图像进行低照度图像增强处理,并使用增强后的图片对夜间车辆数据集进行扩展。采用YOLOv5s建立夜间车辆检测模型,并在此基础上采用ShuffleNetv2的思想对网络继续优化,结构改进后的检测网络对夜间远处车辆和被遮挡车辆的检测效果更好。

低照度;车辆检测;卷积神经网络

智能交通系统(Intelligent Transportation System,ITS)依靠机器视觉技术对道路车辆进行检测,可以实时报告车辆违规行为,高效协助交管人员执行任务,监管交通安全。然而,在夜间等低照度环境下,光源来源复杂、强弱不一,车辆图像欠曝光、对比度亮度低,图像质量差,提取车身轮廓、车辆纹理等全局特征是一大难题。

有研究指出,图像的去噪和增强技术可使目标检测准确率提高[1-3]。

本文将夜间图像增强技术与检测技术有效结合,在保证对车辆具有一定识别准确率的同时,更有较好的实时性,为当前夜间车辆检测准确率的提升难题提供一种有效的技术手段。

1 夜间车辆检测研究现状

夜间由于路灯灯光微弱,车灯、路面反光等干扰,车辆检测面临巨大挑战。当前的夜间车辆检测方法主要有基于特征、基于运动信息和基于深度学习这三种。

(1)基于特征的夜间车辆检测

利用车辆典型特征,如车底阴影、纹理、车灯等,进行车辆检测。然而夜间车辆典型特征信息损失严重,大部分研究只能提取车灯特征。此方法检测速度较快,但十分容易受到光照、背景、遮挡等因素影响,鲁棒性差。

(2)基于运动信息的夜间车辆检测

在ITS中,视频图像相比图片图像涵盖更多信息,相邻帧具备关联性,对于固定背景的视频图像,提取运动车辆的特征更加容易。当前基于运动信息的车辆检测主要有三种:背景差分法、帧差法、光流法。

(3)基于深度学习的夜间车辆检测

CNN(Convolutional Neural Network,卷积神经网络)是一种深度网络模型,通过大量车辆样本提取出特征,确定车辆目标位置[4]。基于CNN的目标检测网络主要分为两类:先分类再检测的2阶段检测模型(R-CNN[5])和端到端的1阶段模型(YOLO、SSD)。如图1所示。

图1 目标检测网络框架

保持夜间车辆检测稳定性与精度的同时提升检测的实时性是本文面临的挑战。本文以夜间微弱路灯下的车辆为研究目标,采集低照度环境中的车辆图片,使用图像增强算法得出修复图像,与原始图片组成图像对作为训练集,输入卷积神经网络YOLOv5训练检测模型,并对网络主干结构进行轻量化改进,提升检测实时性。

2 目标检测算法

(1)YOLO算法

YOLO(You Only Look Once,你只需看一次)[6-9]通过主干网络Darknet提取特征,将图像划分为×个栅格,各自负责检测栅格内目标物体坐标中心点,利用回归思想得出目标置信度和边界框坐标,从三种尺度特征图进行预测。YOLOv4[10]总结了大量检测技巧,通过各种调优方法的组合与对比总结,使得YOLOv4能适应单GPU(General Processing Unit,通用处理器)训练,降低训练门槛。

(2)YOLOv5目标检测算法

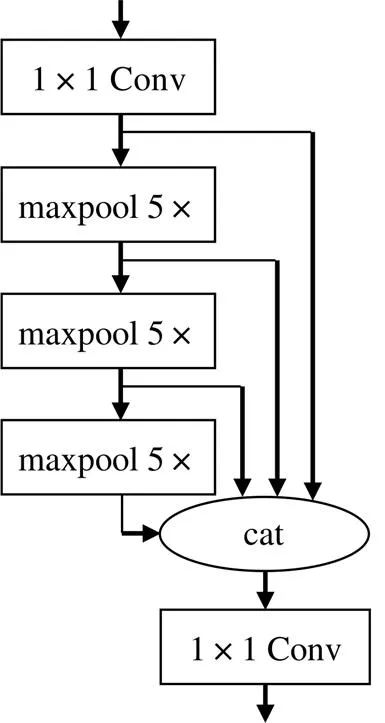

Ultralytics在YOLOv4发表后两个月,在开源网站Github上发布了YOLOv5[11]的第一个正式版本。YOLOv5有以下显著特点:①创建focus层(图2),用于替换YOLOv3的前三层,版本6.0中使用下采样卷积层‘Conv(64, 6, 2, 2)’以代替focus层达到相同效果,网络结构更加精简;②将SPP(Spatial Pyramid Pooling,空间金字塔池化)层中并行最大池化层结构,改变为池化层堆叠结构SPPF(Spatial Pyramid Pooling-Fast,快速空间金字塔池化),如图3、图4所示,输出结果相同,而池化核的减小降低计算内存,提升网络速度;③增设depth_ multiple和width_multiple两个配置参数,分别用于调整网络的深度和宽度,通过不同参数值的组合,使得YOLOv5有5个不同规模的结构。

此外,当数据集较大且类别多时,尽管在准确率上YOLOv4较YOLOv5系列有优势,但YOLOv5能够适应不同规模的训练学习,并在小规模数据集上具有和YOLOv4几乎相同的效果。另一方面,较小规模的YOLOv5(n, s, m)在模型存储方面有明显优势,且推理速度也更快。因此本文采用YOLOv5s作为夜间车辆的检测方法。

图2 focus切片原理

(3)ShuffleNetv2轻量化网络模型

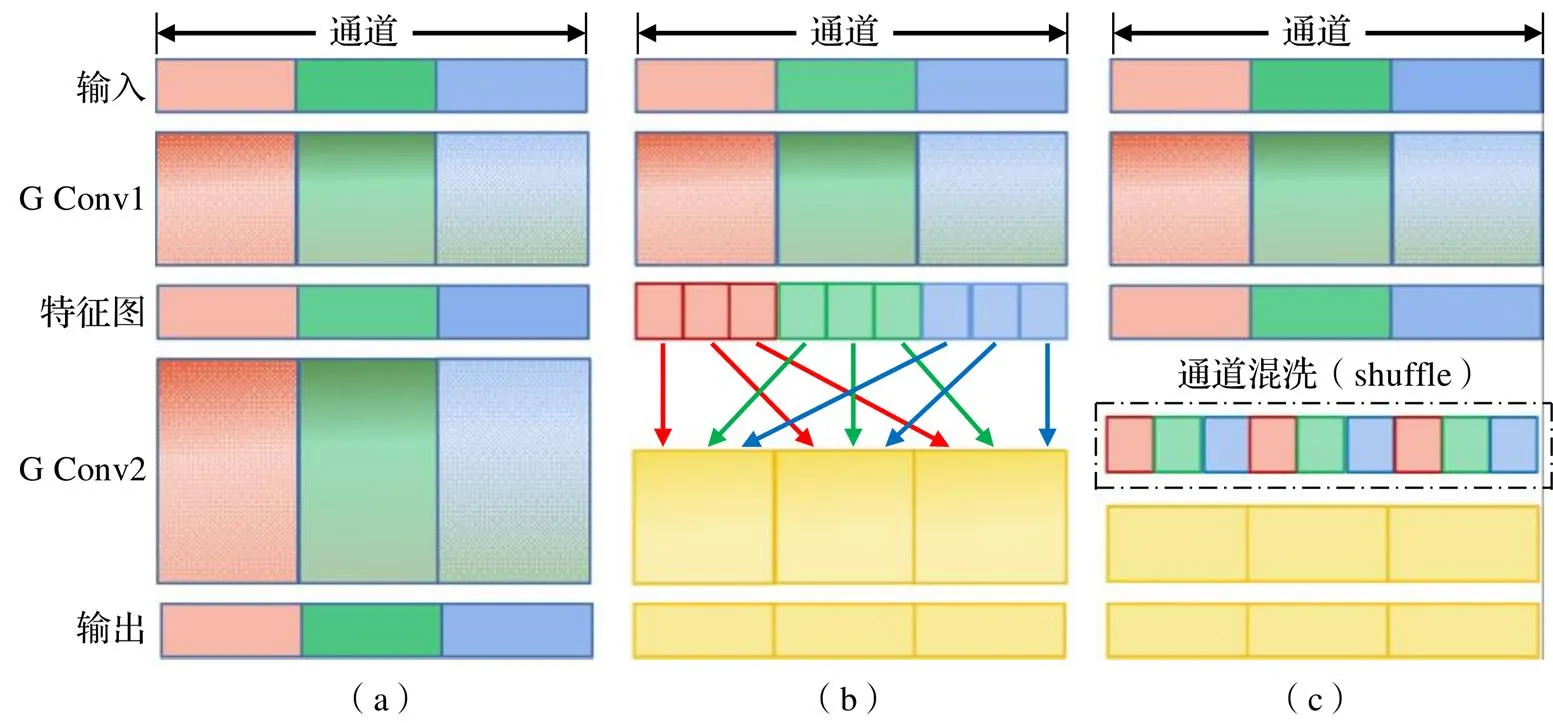

网络的加深虽然可以提高准确率,但存储问题和推理速度问题接踵而至。ShuffleNet通过提出通道混洗(shuffle)解决了由多个分组卷积(G Conv)堆叠在一起产生的组与组之间“信息流通不畅”的问题(图5)。为更好地提升网络效率,对计算量(FLOPs)相同的1×1卷积层,根据提出的四条网络优化设计准则[12],ShuffleNetv2的网络单元如图6所示。

图3 SPP层

图4 SPPF层

图5 使用两个堆叠组卷积的通道混洗原理

图6 ShuffleNetv2网络模块

在图5(a)、(b)中的网络模块右侧分支第一个1×1 Conv前添加一个卷积核为3×3的DW(Depthwise Convolution,逐通道卷积)层,使GPU速度很小程度降低的同时,检测准确率有所提升。因此,ShuffleNetv2在网络轻量设计中既降低了FLOPs,也考虑了访问内存占用问题,四条准则确保了网络的轻量与快速。

3 低照度车辆数据集

目前低照度车辆数据集较少,本文通过四个途径获取共计1768张低照度车辆图像,如图

7所示:①从ExDark[13]数据集中选择car和bus两个类别共1165张单一类别图片;②从UA-DETRAC[14]数据集中截取50非连续帧夜间多类别车辆图像;③从BIT-Vehicle[15]数据集中截取258张夜间卡车图像;④通过摄像机自行拍摄295张夜间多类别车辆图像。采用开源工具LabelImg对训练和测试图像集进行人工标注,标注后生成对应标签文件。本文只标注car、bus、truck三个类别。

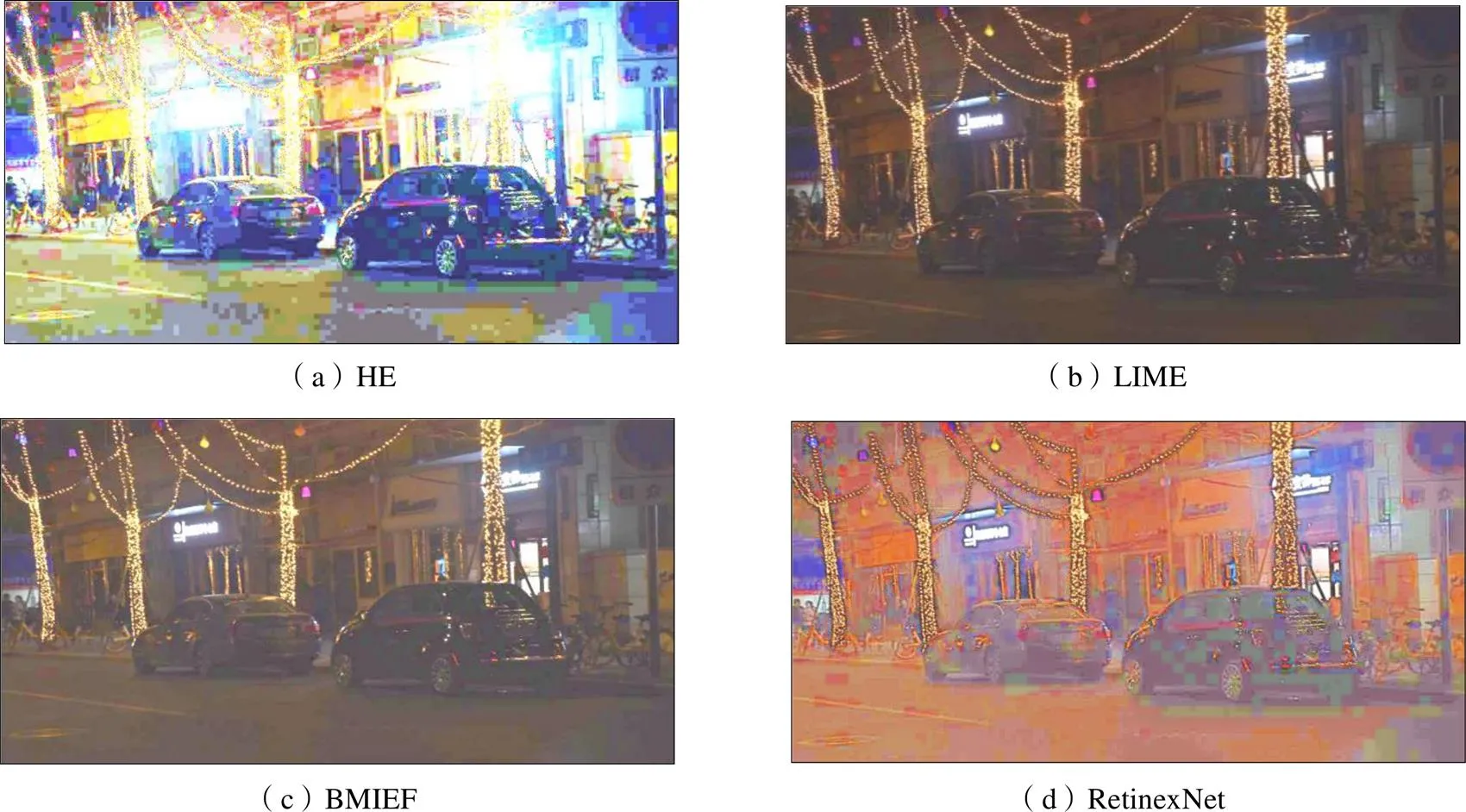

本文选取四种不同算法对数据集中原始低照度车辆图像(图8)进行增强,并列出对比效果,如图9所示。

图7 低照度车辆数据集组成

图8 原始低照度车辆图像

可见,采用HE[16]算法,图片色彩偏差严重,有许多噪点,图片细节丢失严重;采用LIME[9]算法,图片亮度和对比度改善明显,图片暗部细节出现,车身纹理噪声少,车身轮廓边缘也较清晰;采用BMIEF[17]算法,图像亮度和对比度改善效果也很好,但是车身尤其图像中第二辆车车门处噪声较LIME更多;采用RetinexNet[12]算法,由于静态权值,模型泛化能力不足,图片整体亮度很高,色彩有所偏差,但算法对车辆的轮廓细节保留较完整。综上,LIME在本文数据集的增强效果较好,故本文使用LIME对所提数据集进行离线增强,与原有数据集形成低照度-增强图像数据对,以扩展数据集,提升网络特征提取能力。

最后,将1768张图片随机分为三组。其中,测试集占比10%,为177张;训练集和验证集占比90%,训练集1272张,验证集319张。利用LIME对训练集中220张较暗图像和验证集中55张较暗图像进行增强。最终,数据集图片总量为2043张,测试集177张,训练集1492张,验证集374张。

4 基于YOLOv5的低照度车辆检测方法研究

4.1 YOLOv5检测模型的建立与改进

(1)在线数据增强

在每个epoch的图像输入网络训练之前都对数据做随机的增强,一定程度上等价于扩展数据量,可以提升网络面对旋转、平移、剪切、噪声、亮度、对比度等变化的鲁棒性(视所用增强方式),但是效果在一定程度上受限于原始数据的数量,在数据集数量较少时,是提升网络性能的有效办法。

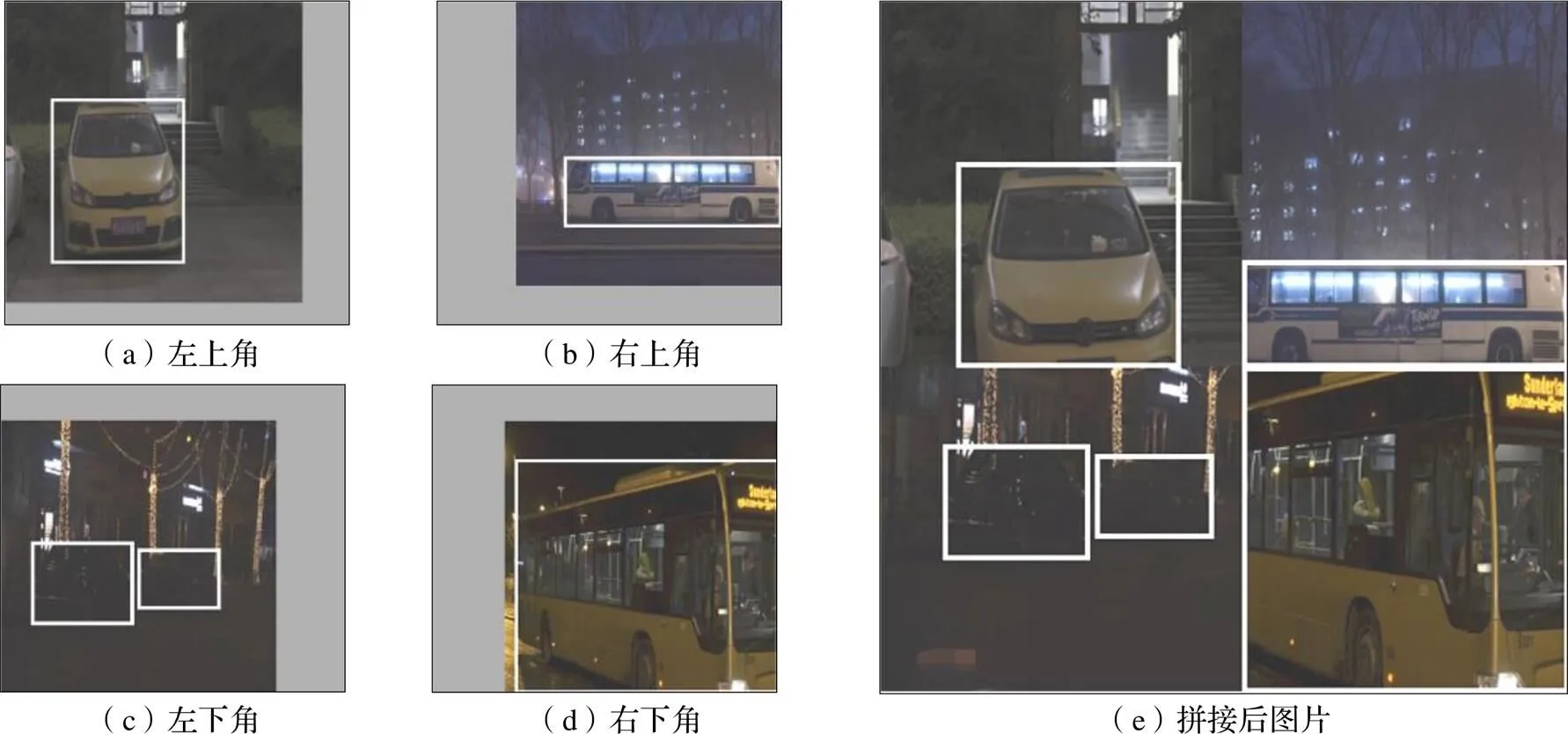

Mosaic对4张图片随机缩放、裁切、排布再拼接。如图10所示,首先随机输入4张图片,进行颜色变换、缩放和裁切等,标签数据也随之变化,将不同的四张图片置于新图片的四个角,最后将其拼接。Mosaic数据增强策略可丰富夜间车辆目标的背景,提升网络的泛化能力。

图9 四种低照度增强方法结果

图10 Mosaic数据增强原理图示

(2)特征提取网络的轻量化改进

基于ShuffleNetv2的思想,对YOLOv5s的主要网络模块C3(图11a)进行改变。首先,对于ShuffleNetv2中=1的模块(图6a,以下简称Shu2-1),使用Shu2-1替换掉C3中Bottleneck层中的1×1 Conv层和3×3 Conv层,如图11(a)虚线框所示。考虑替换以后Shu2-1仅含一层3×3 DW用于提取特征,相较替换之前,参数大大减少,特征会减弱,受ShuffleNetv2*启发,在Shu2-1的右侧分支第一个1×1 Conv层前添加卷积核为3×3的DW层。考虑Shu2-1右侧分支第二个1×1 Conv与C3模块最后一层1×1 Conv特征融合作用相同,为减少计算量,将其删除。最终,改进后的C3模块如图11(b)虚线框内结构,将改进后的模块称为CShu3,用于替换YOLOv5s中的C3模块。各网络层的激活函数设置为:

SiLU:()=·() (1)

式中:SiLU为YOLOv5所用激活函数的名称;()为常见激活函数。

(3)损失函数

在本文研究中,类别数为3,最终用于检测目标车辆的输出为一个多维向量:

=[p, b, b, b, b,1,2,3, p, b, …](3)

式中:p为置信度,表示该特征点有目标的概率;b、b、b、b为预测框的定位和尺寸;1、2、3为类别,当类别为0时,1激活,值为1,2、3均为零。

根据输出的这三类数据,得到基于改进YOLOv5的夜间车辆检测模型的损失函数为:

=·+·+·(4)

式中:为置信度损失;为预测框损失;为类别损失;、、为损失权重系数,,,∈[0,1],++=1。

4.2 基于改进YOLOv5的夜间车辆检测模型训练

本实验训练硬件参数为:CPU i7-10875H CPU @ 2.30 GHz,RAM 32.0 GB,系统Windows 10,GPU NVIDIA GeForce RTX 2070 Super(8G)。软件参数:Python3.7,Pytorch。

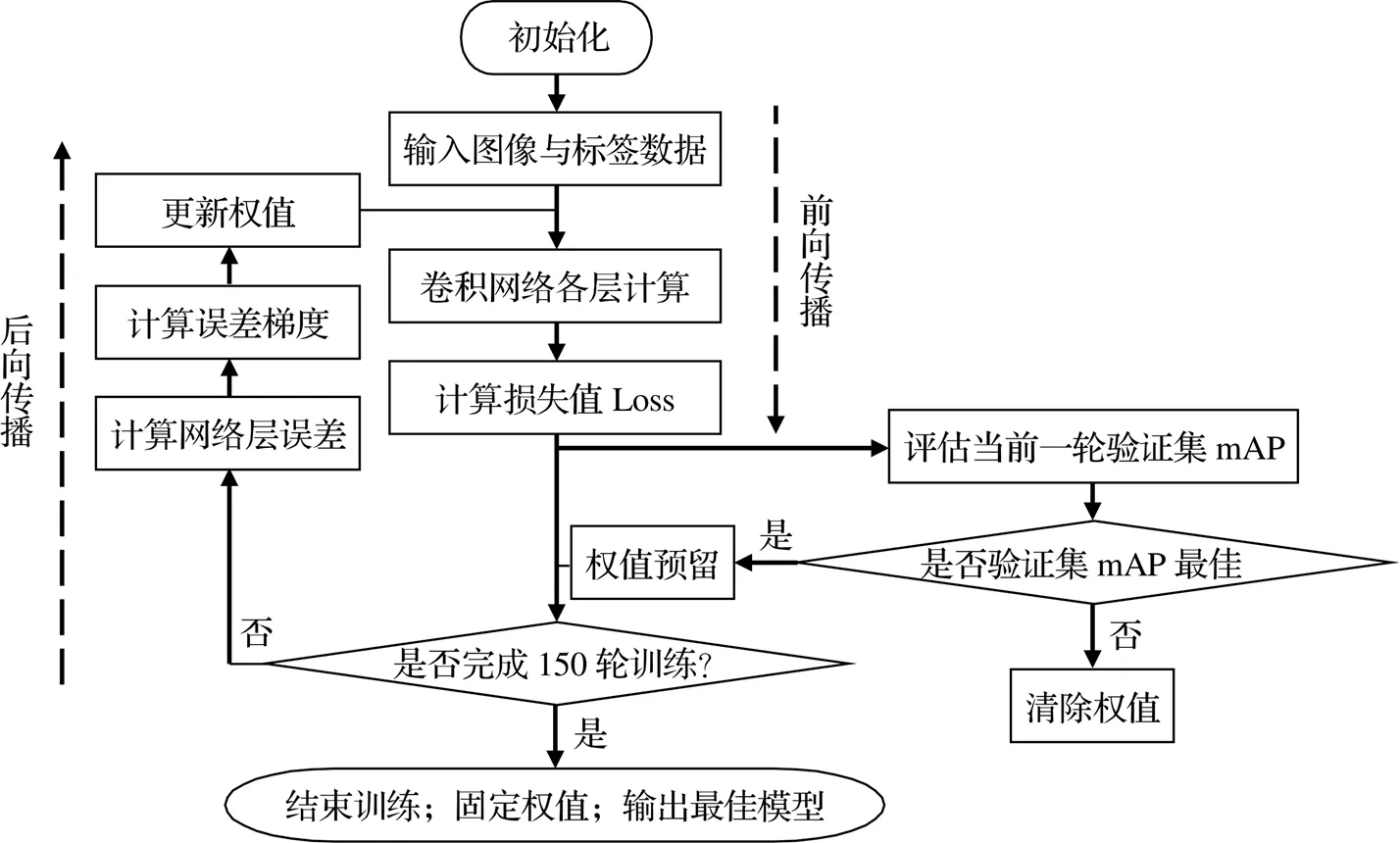

设置网络参数,开始训练:输入图像尺寸初始化为608×608,初始化学习率赋值0.01,衰减下限10-5,Batch_Size定为16,训练150轮(epochs);其中数据集增强策略参数包括随机Mosaic、随机剪切、翻转、旋转等。具体训练流程如图12所示。

图11 特征提取网络模块的修改

mAP(mean Average Precision,均值平均精确度)表示多个类别的平均精确度。

4.3 结果与讨论

(1)改进模型训练结果

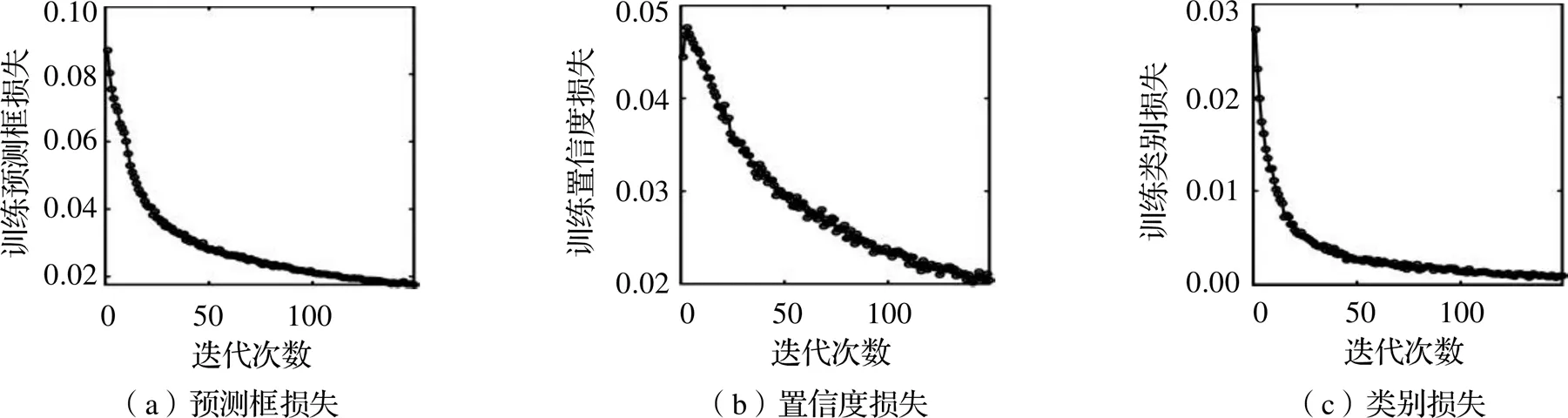

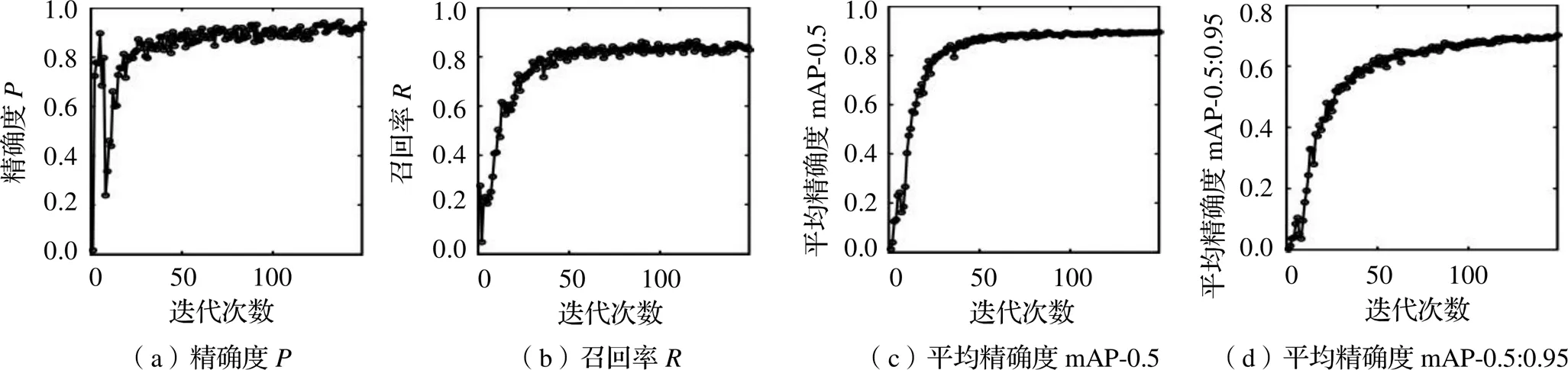

使用4.1节算法输入第3节数据集对网络进行训练,得到训练模型性能,如图13所示。其中,1为一综合评价指标,是精确度和召回率的综合调和值,1=2×/(+)。

由图14~16可知,训练集和验证集上三项损失值收敛良好,在接近100 epochs时损失逐渐趋于水平;由本文数据集上的检测准确率来看,在接近100 epochs时趋势逐渐平缓,并处于较高水平。由图13可知,truck类别的识别检测效果最好,其次是bus,最后是car类别。

图13 训练模型性能

图14 训练集

图15 验证集

图16 本文数据集上的检测准确率

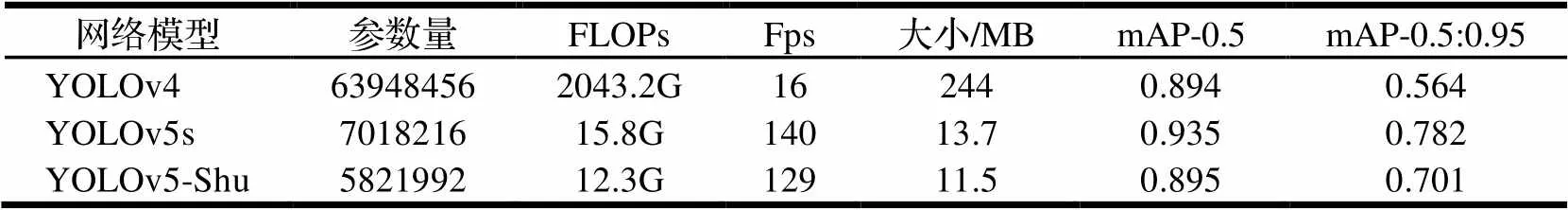

(2)与YOLOv4、YOLOv5s的检测效果对比

将改进的网络YOLOv5-Shu与现有的YOLOv4和YOLOv5s做对比,使用相同的训练集对YOLOv4、YOLOv5s重新训练。分别在三个网络中输入相同的夜间图片,对比三者检测效果,如图17所示。可见,改进的YOLO夜间检测车辆模型相比于YOLOv4、YOLOv5s的检测效果略有优势,尤其是对于遮挡车辆和远处小尺寸车辆的检测。

图17 不同检测效果对比图

表1列出了基于本文数据集的YOLOv4、YOLOv5s和改进网络YOLOv5-Shu的不同参数,当统一输入图像尺寸为(16, 3, 608, 608)时,可以看出,YOLOv5-Shu具有最少的网络参数、最小的存储大小,同时在检测准确率和推理速度上也能满足实时和夜间检测的工作需求。

表1 不同网络模型在本文数据集表现

注:输入为(16, 3, 608, 608);Fps为每秒处理的图片张数,表征处理速度;G为10亿次的浮点运算数(Giga Floating-point Operations),用以衡量算法/模型复杂度。

5 结论

本文构造了夜间车辆数据集,并对部分较暗图像进行低照度图像增强处理扩展数据集。使用了ShuffleNetv2的网络轻量设计准则改进YOLOv5s的主干网络,在保持一定检测准确率的同时降低了网络的参数量和计算量。改进后的检测网络对夜间环境较远处车辆和被遮挡车辆的检测效果相比YOLOv4和YOLOv5s有一定提升。

[1]H. Kuang,X. Zhang,Y. Li,et al. Nighttime Vehicle Detection Based on Bio-Inspired Image Enhancement and Weighted Score-Level Feature Fusion[J]. IEEE Transactions on Intelligent Transportation Systems,2017,18(4):927-936.

[2]周敏飞. 低照度图像增强与车辆识别技术研究[D]. 上海:东华大学,2020.

[3]曾锦华,邱秀莲,卞新伟,等. 图像降噪和增强对人脸识别系统识别性能的影响[J]. 刑事技术,2021,46(1):6.

[4]董雪雪. 夜间车辆检测算法研究及其应用[D]. 江苏:南京信息工程大学,2017.

[5]Girshick R, Donahue J, Darrell T, et al. Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[C]. IEEE Computer Society,2013.

[6]Redmon J, Divvala S, Girshick R, et al. You Only Look Once: Unified, Real-Time Object Detection[C]. Computer Vision & Pattern Recognition. IEEE,2016.

[7]Redmon J, Farhadi A. YOLO9000: Better, Faster, Stronger[C]. IEEE Conference on Computer Vision & Pattern Recognition. IEEE,2017:6517-6525.

[8]Redmon,J.,Farhadi,A. YOLOv3: An Incremental Improvement [J]. IEEE Trans. Pattern Anal.,2018(15):1125-1131.

[9]邓人玮,熊瑞平,卢文翔,等. 基于YOLO神经网络模型的自动喷涂线工件分类识别方法[J]. 机械,2022,49(3):65-73.

[10]Bochkovskiy,A.,Wang,C. Y.,Liao,H. Y. M. YOLOv4: Optimal Speed and Accuracy of Object Detection[J]. arXiv 2020:arXiv.2004. 10934.

[11]Ultralytics. YOLOv5 2020[EB/OL]. https://github. com/ ultralytics/yolov5.

[12]Ma N,Zhang X,Zheng H T,et al. ShuffleNet V2: Practical Guidelines for Efficient CNN Architecture Design[J]. European Conference on Computer Vision(ECCV),2018:116-131.

[13]Loh Y P, Chan C S. Getting to know low-light images with the Exclusively Dark dataset[C]. Computer Vision and Image Understanding,2019.

[14]Wen L,Du D,Cai Z,et al. UA-DETRAC: A New Benchmark and Protocol for Multi-Object Detection and Tracking[C]. Computer Science,2015.

[15]Dong Z,Pei M,He Y,et al. Vehicle Type Classification Using Unsupervised Convolutional Neural Network[C]. IEEE transactions on intelligent transportation systems,2014.

[16]JAIN A K. Fundamentals of digital image processing[M]. New Jersey:Prentice-Hall, Inc.,1989.

[17]YING Zhen qiang,LI Ge,REN Yu rui,et al. A new low-light image enhancement algorithm using camera response model[C]. 2017 IEEE International Conference on Computer Vision Workshop. Venice,Italy:IEEE,2017:3015.

Research on Vehicle Detection Algorithm Based on Low Illumination Environment

ZOU Ying,LONG Wei,LI Yanyan,LIU Shouxin

( School of Mechanical Engineering, Sichuan University, Chengdu 610065, China )

At night or in other low illumination environments, the light source is complex, the acquisition image is accompanied by noise, and the detail information of the image is weakened, which result in the difficulty of vehicle target feature extraction, high false detection rate and high missed rate at night. The vehicle images under weak street lights at night is taken as the research target. The vehicle data sets in low illumination environment are constructed, and part of the darker images of the data sets are enhanced. Next, the enhanced image is paired with the original image as a training set and input into YOLOv5 to establish the vehicle detection model at night, and ShuffleNetv2 is adopted to further optimize the network. The improved detection network performs better on detecting distant vehicles and blocked vehicles at night.

low illumination;vehicle detection;convolutional neural network

U491.1+16

A

10.3969/j.issn.1006-0316.2022.07.011

1006-0316 (2022) 07-0066-09

2022-01-05

2021四川大学-遂宁市校地合作科技项目(2021CDSN-12)

邹莹(1994-),女,四川成都人,硕士研究生,主要研究方向为智能交通,E-mail:scuzouying@163.com。*通讯作者:李炎炎(1979-),女,辽宁沈阳人,博士,副研究员,主要研究方向为车辆/交通智能技术,E-mail:liyanyan@scu.edu.cn。