联合一二阶池化网络学习的遥感场景分类

边小勇,费雄君,陈春芳,阚东东,丁胜

联合一二阶池化网络学习的遥感场景分类

边小勇1,2,3*,费雄君1,陈春芳1,阚东东1,丁胜1,2,3

(1.武汉科技大学 计算机科学与技术学院,武汉 430065; 2.武汉科技大学 大数据科学与工程研究院,武汉 430065; 3.智能信息处理与实时工业系统湖北省重点实验室(武汉科技大学),武汉 430065)(*通信作者电子邮箱xyongwh04@163.com)

目前大多数池化方法主要是从一阶池化层或二阶池化层提取聚合特征信息,忽略了多种池化策略对场景的综合表示能力,进而影响到场景识别性能。针对以上问题,提出了联合一二阶池化网络学习的遥感场景分类模型。首先,利用残差网络ResNet-50的卷积层提取输入图像的初始特征。接着,提出基于特征向量相似度的二阶池化方法,即通过特征向量间的相似度求出其权重系数来调制特征值的信息分布,并计算有效的二阶特征信息。同时,引入一种有效的协方差矩阵平方根逼近求解方法,以获得高阶语义信息的二阶特征表示。最后,基于交叉熵和类距离加权的组合损失函数训练整个网络,从而得到富于判别性的分类模型。所提方法在AID(50%训练比例)、NWPU-RESISC45 (20%训练比例)、CIFAR-10和CIFAR-100数据集上的分类准确率分别达到96.32%、93.38%、96.51%和83.30%,与iSQRT-COV方法相比,分别提高了1.09个百分点、0.55个百分点、1.05个百分点和1.57个百分点。实验结果表明,所提方法有效提高了遥感场景分类性能。

遥感场景分类;深度学习;一阶池化;二阶池化;协方差矩阵平方根

0 引言

遥感图像场景分类是将航空或卫星图像按照不同的特征划分为土地利用类的集合。在过去的几十年里,遥感图像场景分类引起了大量的关注,广泛地应用于图像检索、土地资源利用和土地覆盖监测等任务中。但由于类内存在大的多样性,类间存在高的相似性,同时受平移、视点、空间分辨率、旋转、姿态、背景和遮挡等多种变化的影响,使得遥感图像场景分类任务依然面临挑战。

近年来,由于卷积神经网络(Convolutional Neural Network,CNN)在各种图像任务中取得了突破性的进展,基于CNN的方法层出不穷,在包括场景分类在内的遥感领域中占据了主导地位。传统的CNN仅使用全连接层对特征图进行分类,如AlexNet[1]、VGG(Visual Geometry Group)[2]等,而全连接层容易过拟合。针对以上问题,Lin等[3]提出在卷积层和全连接层中间使用全局平均池化(Global Average Pooling, GAP)层来防止过拟合,同时加强特征图和类别信息之间的对应关系,在多个图像分类任务中取得了不错的效果;但是,通过GAP计算得到的特征统计量受特征图中频繁出现的描述符影响较多,受罕见但信息量高的描述符影响较少,对特征图的表示能力存在一定的局限性。针对以上问题,Murray等[4]提出广义最大池化(Generalized Max Pooling,GMP),迫使池化层输入和输出的外积是常量,更好地使用特征图中频繁出现和携带高信息量的描述符。Xie等[5]提出任务驱动池化(Task-Driven Pooling, TDP),将表示学习和分类器训练结合在一个统一的框架中,能够针对不同的输入特征图使用不同的池化策略,是一种有监督的池化方法。Wu等[6]将广义最大池化和TDP两种池化方法嵌入到CNN中,并融合不同卷积层特征图的池化结果进行分类,在遥感图像场景分类任务中取得了不错的效果。此外,针对CNN仅支持对固定尺寸输入图像进行处理的问题,He等[7]提出空间金字塔池化网络(Spatial Pyramid Pooling Network,SPP-Net),通过将特征图分割成多个不同尺寸的网格,然后对每个网格进行最大池化,使CNN对任意尺寸输入图像都能够得到固定长度的特征表示,在多个图像分类和目标检测任务中取得了不错的成绩。以上池化方法能够在各自的任务中取得不错的效果,但是这些方法依旧是通过计算特征的一阶统计量得到特征表示,携带的特征信息仍然不够充分。

最近,基于高阶(2阶及以上)池化方法的CNN在图像分类任务中取得了不少进展。Lin等[8]提出了双线性卷积神经网络(Bilinear-CNN)模型。Bilinear-CNN模型是由两个特征提取网络构成的体系结构,通过不同的特征提取网络获得包含不同信息的局部特征,并使用外积对局部特征相互关系进行建模,得到信息量更丰富的特征表示,在细粒度图像分类任务中取得了不错的成绩。Li等[9]提出矩阵能量归一化协方差(Matrix Power Normalized COVariance, MPN-COV),采用协方差池化计算特征的高阶统计量,并对协方差矩阵进行矩阵幂规范化,提取特征图的高阶特征表示,提高了CNN在ImageNet数据集上的分类精度。尽管MPN-COV取得了不错的效果,但是在矩阵幂规范化的计算过程中需要对协方差矩阵进行奇异值分解,而在GPU上没有矩阵奇异值分解的高效实现。针对以上问题,Li等[10]提出迭代矩阵平方根归一化的协方差池化(iterative matrix SQuare RooT normalization of COVariance pooling,iSQRT-COV),使用牛顿迭代法对协方差矩阵进行矩阵幂规范化的方法,并应用到CNN的前向传递和反向传播中,有效提高了MPN-COV的计算效率。此外,高阶池化也经常同其他深度学习方法结合使用。Wang等[11]基于高阶池化方法提出门限混合的二阶池化(Gated Mixture of Second-Order Pooling,GM-SOP),通过稀疏门控模块自适应地为输入样本选择多个候选样本,并在门控模块中使用参数化协方差矩阵计算特征图的高阶特征表示,最后对所有候选样本进行加权求和,在小尺度ImageNet数据集上取得了不错的结果。Kim等[12]提出双线性注意力网络(Bilinear Attention Network, BAN),在输入的两个通道群组中用双线性交互,提取两个通道的联合表示,尽可能地利用视觉和语言信息,为多模态学习提供了一种有效学习视觉信息的方法。He等[13]提出高阶自注意力(High-order Self-Attention, HoSA)网络,将高阶注意力模块嵌入到CNN中,提取高阶注意力特征,并使用高阶池化得到特征的高阶统计量,在遥感场景分类任务中取得了较好的效果。薛永杰等[14]等提出一种基于长短期记忆(Long Short-Term Memory, LSTM)神经网络和CNN的融合深度神经网络室内场景识别方法,使用基于注意力机制的LSTM模型融合CNN模型进行分类。以上方法虽然取得了不错的性能,但是这些方法缺少针对性,针对遥感场景的复杂性需重新设计和优化。另外,二阶池化描述了特征向量间的相互关系,能够得到特征间的相似性信息。

针对以上问题,本文在笔者前期工作[15]的基础上,提出了联合一二阶池化模块以及基于特征向量相似度的二阶池化方法。不同于MPN-COV中基于协方差矩阵计算特征向量的二阶信息,本文针对遥感场景中存在多个小对象且对象间相关性程度不同的特点,提出基于特征向量相似度的二阶池化方法;然后,将一阶池化特征融入二阶池化特征学习中,以获得更富判别性的特征表示用于遥感场景分类。本文主要工作如下:1)给出了联合一二阶池化模块,将一阶池化和二阶池化融入统一的框架中进行学习;2)提出了基于特征向量相似度的二阶池化方法,获得语义信息更丰富的二阶信息;3)引入了一种有效的协方差矩阵平方根逼近求解方法,以保证网络模型的收敛性和稳定性。

1 联合一二阶池化网络学习

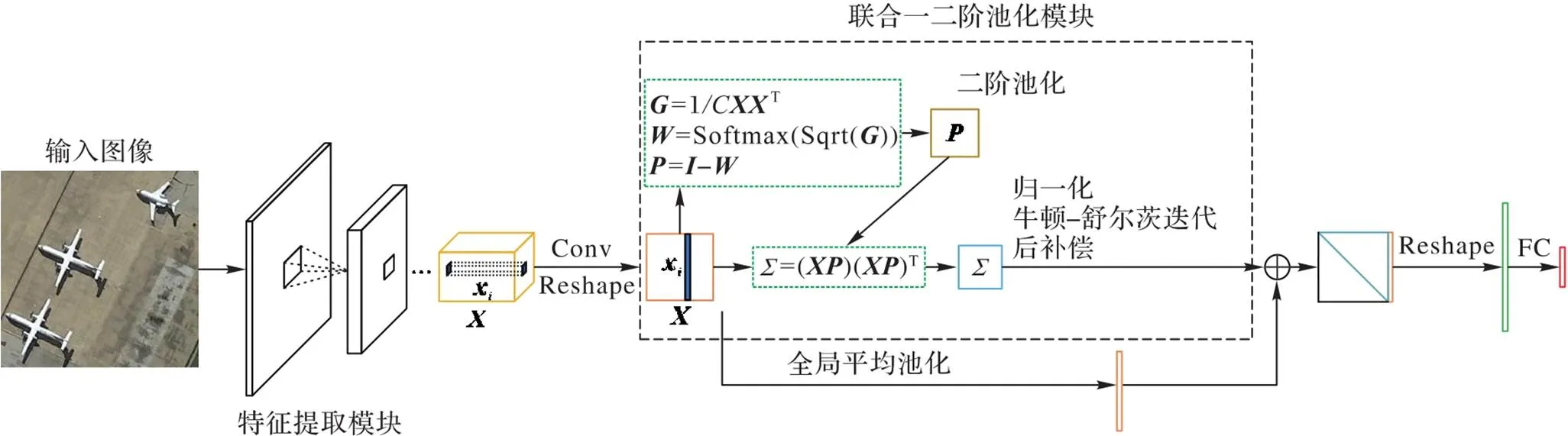

基于协方差矩阵的二阶池化仅使用特征值的平均值函数计算特征向量间的协方差矩阵获得二阶池化特征,具有更丰富的语义信息,而一阶池化特征较好地保留了特征的空间信息。受此启发,本文提出了联合一二阶池化模块和基于特征向量相似度的二阶池化方法,并以此为基础构建了联合一二阶池化网络,如图1所示。联合一二阶池化网络利用卷积层、残差块等结构提取输入图像的高级特征,分别通过基于特征向量相似度的二阶池化和一阶池化得到输出特征的二阶信息和一阶信息,并联合一阶和二阶特征信息对遥感场景进行分类预测。其中,基于特征向量相似度的二阶池化通过特征向量间的相似度获得其权重信息来调制特征值的信息分布,从而获得富含语义信息的二阶特征表示。本文方法有效聚合了一阶池化特征的特征空间信息和二阶池化特征的特征向量间相互关系,获得更富判别性的场景表示。

图1 联合一二阶池化网络学习的遥感场景分类

1.1 总体网络结构

1.2 联合一二阶池化模块

常用的一阶池化方法包括全局最大池化、全局平均池化、GMP和TDP等。其中,全局最大池化仅保留每个特征通道上信息量最高的特征值,丢失了大量的特征信息。全局平均池化对特征图空间信息进行了汇总,对输入图像中存在的空间转换具有较好的适应性。广义最大池化和TDP虽然能够平衡频繁出现的特征和高信息量的特征对池化结果的影响,但不能端到端学习。一阶池化特征汇总了特征向量的空间信息,而二阶池化特征包含了描述特征向量间潜在的相关性信息,自然地,它们具有一定的互补性。

然后,将一阶特征表示和二阶特征表示M在列上堆叠,得到联合特征表示。由于二阶特征表示M是一个对称矩阵,为了避免特征重复,减少网络参数,本文仅提取M的上三角特征和V组成最终的特征表示,最终的特征维度为的向量,输入到分类层。

1.3 基于特征向量相似度的二阶池化

二阶池化特征主要通过计算特征向量间的协方差得到特征图的二阶统计信息[9]。现有二阶池化方法中的协方差矩阵计算过程是先利用中心化矩阵对输入特征矩阵进行去均值处理,再乘上自身的转置,得到输入特征矩阵的协方差矩阵。现有二阶池化方法的中心化矩阵计算采用了固定参数,忽略了特征间潜在的重要性信息。针对此问题,本节提出了基于特征向量相似度的二阶池化方法,包括中心化矩阵计算、二阶特征计算及其逼近求解。

1.3.1 中心化矩阵计算

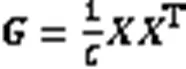

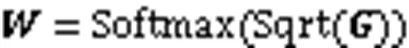

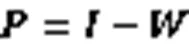

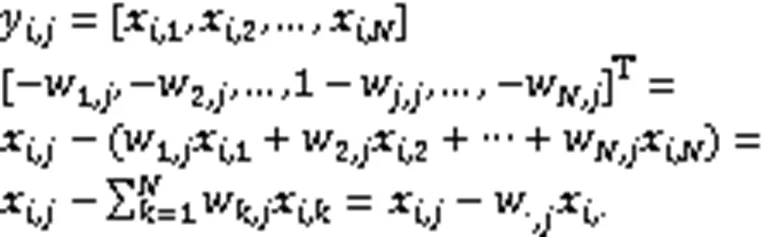

矩阵中心化是求解协方差矩阵的重要计算过程,矩阵中心化参数在协方差矩阵计算过程中起着调制特征值信息量的作用。不同于以往矩阵中心化计算过程中以特征向量的均值为中心点、平等对待每个维度特征的做法,本文基于特征向量的格拉姆矩阵,经过规范化处理和激活函数后能够得到每个特征向量本身及其相互之间的重要性信息,这些信息使得在矩阵中心化过程中,不同维度特征具有不同的权重,为每组特征向量中心化提供一个基准。其中,格拉姆矩阵对角线上的元素表示每个特征向量携带的信息量,其他元素则描述了特征向量之间的相似性。具体来说,对于输入矩阵,首先,根据下式计算特征矩阵的格拉姆矩阵:

1.3.2 二阶特征计算

根据中心化矩阵计算二阶特征,公式如下:

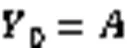

1.3.3 协方差特征逼近求解

1.3.4 更高阶池化特征推导

1.4 损失函数

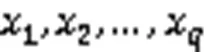

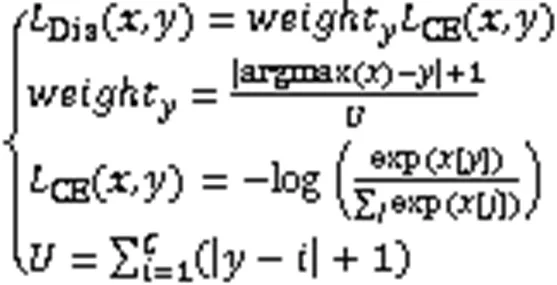

传统的交叉熵损失没有考虑不同类别之间的距离[17]。针对类不平衡的数据集,本文将其类别标签按样本数从小到大排序,样本数量越少标签越小,并引入样本距离加权的损失函数,与交叉熵损失一起构成组合损失,减少损失值和精度的反差(损失越小精度反而降低),并改进模型收敛性。组合的损失函数计算公式为:

其中:表示样本的真实标签;表示网络模型的输出向量;表示类别数。距离加权的损失函数定义了预测类别和实际标签的差值来计算不平衡类间的差距,有助于模型收敛,获得更好的分类结果。

2 实验与分析

本文实验基于Pytorch框架,使用NVIDIA Tesla V100进行网络训练,在Ubuntu v16系统上进行实验验证。

2.1 数据集与实验设置

在大尺度遥感图像场景数据集AID[18]和NWPU-RESISC45[19],以及自然场景数据集CIFAR-10、CIFAR-100[20]上进行实验验证。数据集AID包含30个类别,总共有10 000幅图像。该场景数据集具有从大约8 m到0.5 m的不同分辨率,每幅图像的大小被固定为600像素×600像素大小,以覆盖各种不同分辨率的场景。NWPU-RESISC数据集包含45个类别,每类有700幅图像,每幅图像的大小被固定为256像素×256像素大小,总共有31 500幅图像,且空间分辨率从每像素约30 m到0.2 m不等。CIFAR-10和CIFAR-100都有60 000幅图像,每幅图像的大小为32像素×32像素大小,训练集和测试集划分为5∶1,前者有10类每类包括6 000幅图像,而后者有100类,每类只有600幅图像。图3给出了AID数据集的示例图像。

实验中,将输入图像尺寸调整为224×224,并进行预处理,包括随机翻转、归一化等方法。本文使用随机梯度下降(Stochastic Gradient Descent, SGD)优化器,初始学习率为0.001,动量为0.9,权重衰减为0.000 5,牛顿-舒尔茨迭代次数设置为3。使用ImageNet预训练模型进行微调,批处理大小为16,网络完全训练90次,每训练30次将学习率乘0.1。组合损失函数中的在AID数据集上设置为1,其他数据集为0。实验结果取5次随机划分的平均准确率。

2.2 不同方法的实验对比

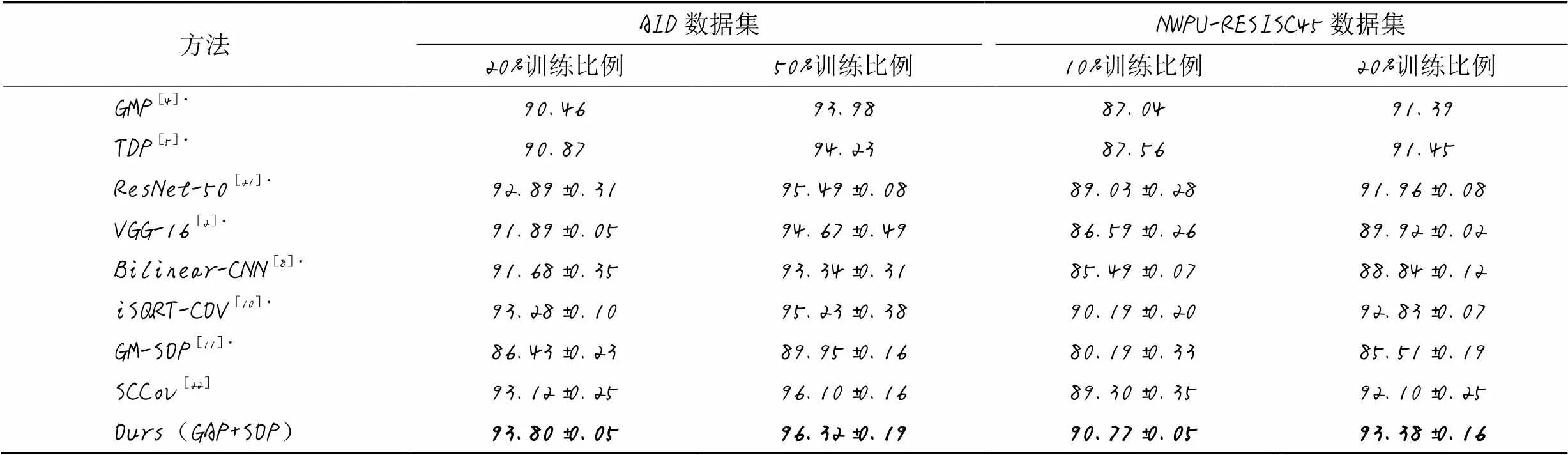

为验证本文方法的有效性,首先将它与其他不同池化方法进行对比实验。由于大多数池化方法没有在场景数据集上的分类性能报告,本文根据相关文献中的实验配置和开源代码在场景数据集上进行实验,得到相应的分类准确率,这些方法在表格中用*标明。例如,残差网络ResNet-50[21]。与跳跃协方差(Skip-Connected Covariance, SCCov)网络[22]、宽残差网络(深度28,宽度因子10,WRN-28-10)[23]、挤压-激励的宽残差网络(SE-WRN)[24]、Gabor卷积网络(GCN)[25]上的实验结果进行了引用对比。为了简化说明,本文方法统称为Ours(GAP+SOP)。按照2.1节的实验配置,联合一二阶池化网络学习在AID、NWPU-RESISC45、CIFAR-10和CIFAR-100上的实验结果分别如表1、2所示。

由表1的实验结果可知,本文提出的联合一二阶池化网络学习的场景分类方法在AID数据集50%训练比例的条件下获得了96.32%的分类准确率,与单独的一阶池化方法GMP和TDP相比,准确率分别提高了2.34和2.09个百分点;与单独的二阶池化方法iSQRT-COV相比,准确率提高了1.09个百分点;与SCCov池化网络方法相比,准确率提高了0.22个百分点。以上结果表明,联合一二阶池化网络提取的特征携带的有效信息优于单独的一阶池化特征和二阶池化特征,有助于提高CNN的分类性能。

图3 AID数据集的示例图像

表1 大尺度遥感图像场景数据集上的分类准确率对比 单位: %

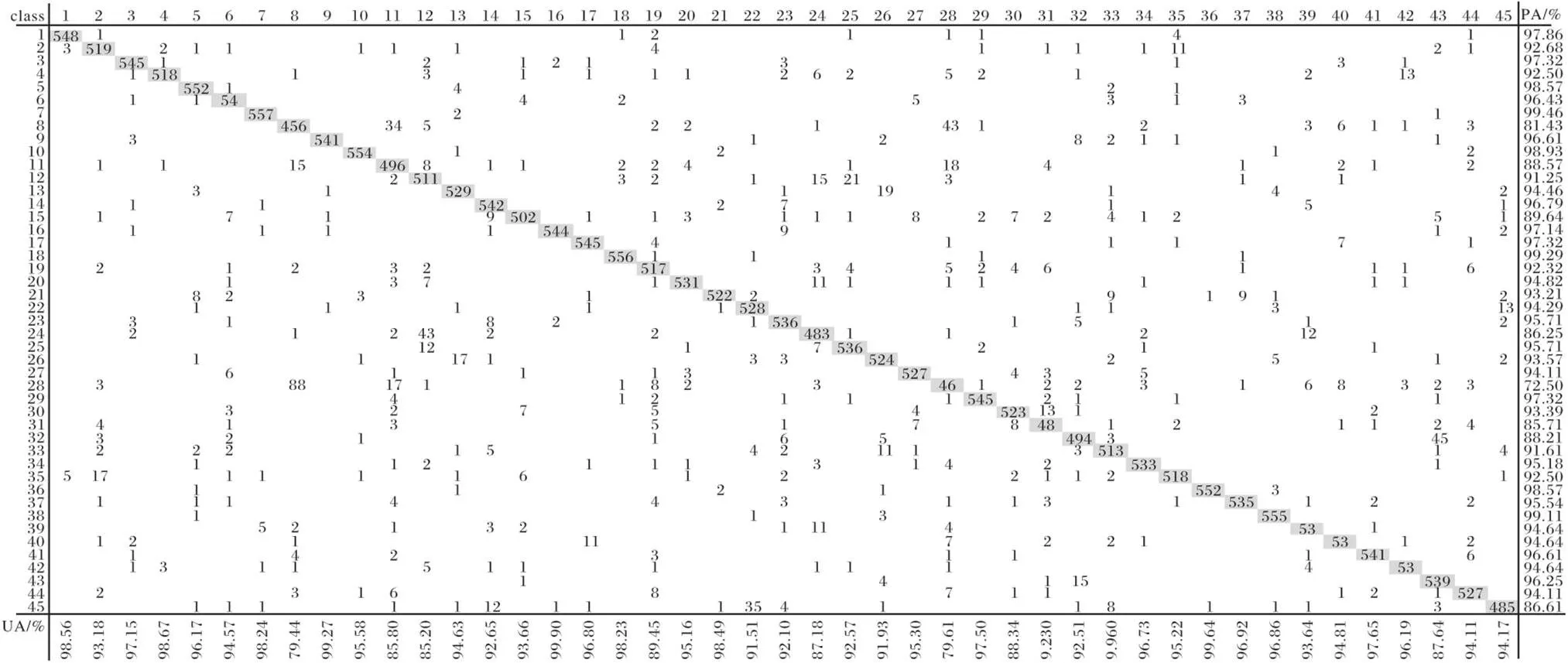

本文方法在NWPU-RESISC45数据集20%训练比例的条件下的准确率达到了93.38%,与GMP和TDP相比,准确率分别提高了1.99和1.93个百分点;与iSQRT-COV方法相比,准确率提高了0.55个百分点;与SCCov方法相比,准确率提高了1.28个百分点。本文方法在NWPU-RESISC45数据集20%训练比例上的混淆矩阵如图4所示。以上结果说明了本文方法的有效性。

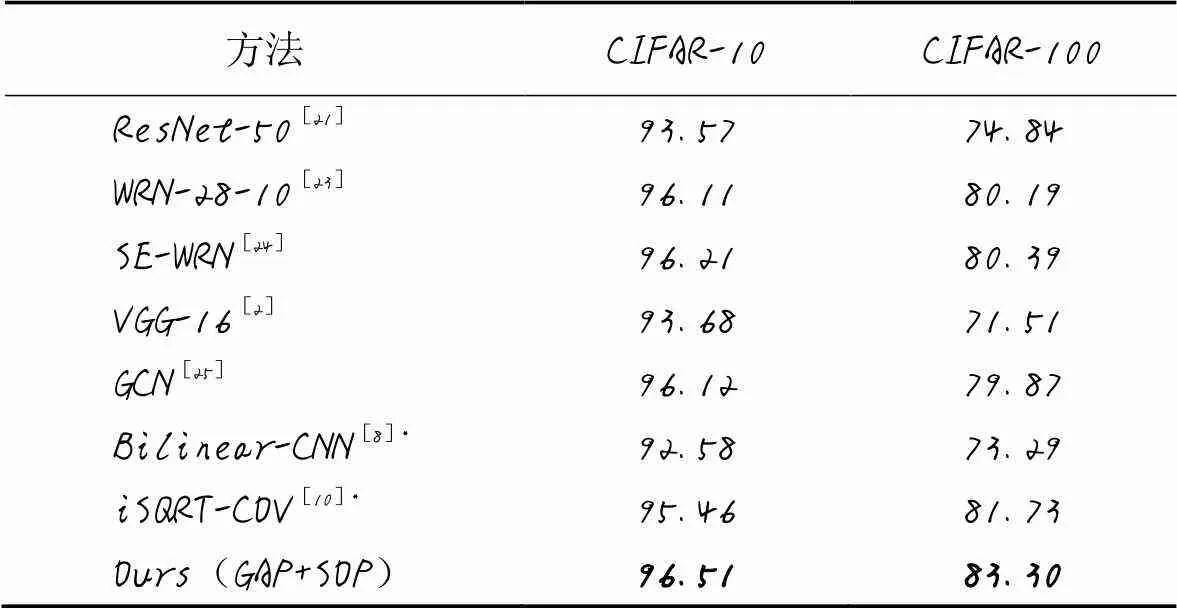

为进一步验证本文方法的有效性,表2给出了本文方法在CIFAR-10和CIFAR-100数据集上的实验结果。由表2中数据可知,本文方法在CIFAR-10和CIFAR-100数据集上的分类准确率分别达到了96.51%和83.30%,与经典CNN结构VGG16相比,准确率分别提高了2.83、11.79个百分点;与WRN-28-10方法相比,准确率分别提高了0.4和3.11个百分点;与基于注意力的SE-WRN方法相比,准确率分别提高了0.3、2.91个百分点;与GCN方法相比,准确率分别提高了0.39和3.43个百分点。以上结果表明,本文提出的联合一二阶池化网络学习方法在自然图像数据集上是有效的。

表2 自然场景数据集上的分类准确率对比 单位: %

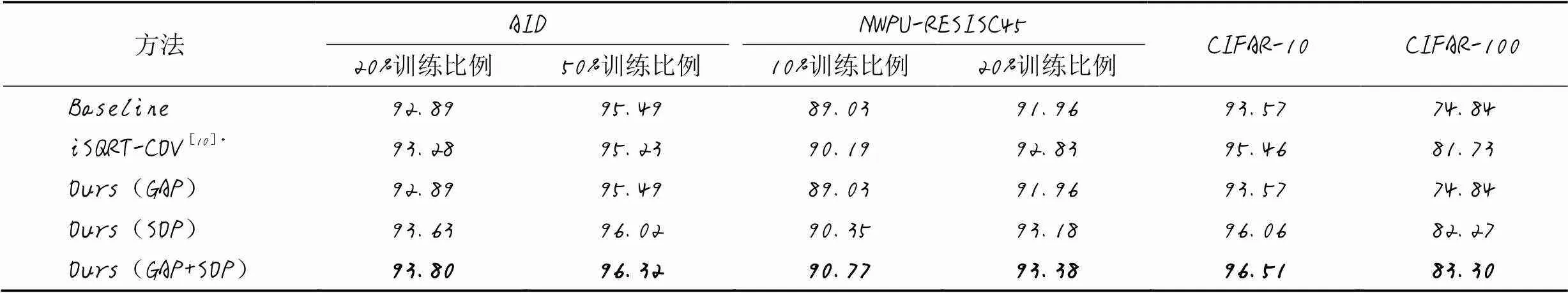

2.3 消融实验

为进一步验证本文提出的联合一二阶池化模块和二阶池化计算方法的有效性,分别使用一阶池化、二阶池化和联合一二阶池化模块进行实验。实验以ResNet-50网络作为基础网络,不同方法组合的实验结果如表3所示。由表3可知,本文联合一二阶池化网络分类结果要优于单独使用一阶池化方法Ours(GAP)和二阶池化方法Ours(SOP):在AID数据集50%训练比例的条件下,准确率分别提高了0.83和0.30个百分点;在NWPU-RESISC45数据集20%训练比例的条件下,准确率分别提高了1.42和0.20个百分点;在CIFAR-10数据集上的准确率分别提高了2.94和0.45个百分点;在CIFAR-100数据集上的准确率分别提高了8.46和1.03个百分点。同时,本文提出的二阶池化模块(SOP)分类结果要优于iSQRT-COV中所述的二阶池化方法,在AID数据集50%训练比例的条件下,准确率提高了0.79个百分点;在NWPU-RESISC45数据集20%训练比例的条件下,准确率提高了0.35个百分点;在CIFAR-10和CIFAR-100数据集上准确率分别提高了0.60和0.54个百分点。这说明本文提出的二阶池化模块可以有效地提取区分特征。从实验结果还可以看出,一阶池化和二阶池化特征信息有一定的互补性,提高了场景分类性能。

表3 各数据集上消融实验的分类准确率对比 单位: %

图4 本文方法在NWPU-RESISC45数据集20%训练比例上的混淆矩阵

3 结语

本文提出了一种有效的二阶池化计算方法和联合一二阶池化学习模块,并以此为基础构建了联合一二阶池化网络的分类模型。其中,基于特征向量相似度的二阶池化方法通过特征向量间的相似度获得其权重信息,并根据权重信息计算特征向量的加权平均来调制特征值的信息分布,有效地聚合特征向量,获得语义信息更丰富的二阶特征表示。随后,联合一二阶池化模块进行学习,提取了特征空间汇总信息和特征向量间相互关系的特征表示,提高了特征的区分能力。在4个基准数据集上的实验结果验证了本文方法的有效性。接下来将探索自注意力的高阶池化特征提取,并作出改进。

)

[1] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]// Proceedings of the 25th International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2012:1097-1105.

[2] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. [2021-02-17].https://arxiv.org/pdf/1409.1556.pdf.

[3] LIN M, CHEN Q, YAN S C. Network in network[EB/OL]. (2015-04-10)[2021-02-17].https://arxiv.org/pdf/1312.4400.pdf.

[4] MURRAY N, PERRONNIN F. Generalized max pooling[C]// Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2014:2473-2480.

[5] XIE G S, ZHANG X Y, SHU X B, et al. Task-driven feature pooling for image classification[C]// Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2015:1179-1187.

[6] WU M X, CHENG G, YAO X W, et al. Performance comparison of two pooling strategies for remote sensing image scene classification[C]// Proceedings of the 2019 IEEE International Geoscience and Remote Sensing Symposium. Piscataway: IEEE, 2019: 3037-3040.

[7] HE K M, ZHANG X Y, REN S Q, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916.

[8] LIN T Y, RoyCHOWDHURY A, MAJI S. Bilinear CNN models for fine-grained visual recognition[C]// Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2015:1449-1457.

[9] LI P H, XIE J T, WANG Q L, et al. Is second-order information helpful for large-scale visual recognition?[C]// Proceedings of the 2017 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2017:2089-2097.

[10] LI P H, XIE J T, WANG Q L, et al. Towards faster training of global covariance pooling networks by iterative matrix square root normalization[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018:947-955.

[11] WANG Q L, GAO Z L, XIE J T, et al. Global gated mixture of second-order pooling for improving deep convolutional neural networks[C]// Proceedings of the 32nd International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2018:1284-1293.

[12] KIM J H, JUN J, ZHANG B T. Bilinear attention networks[C]// Proceedings of the 32nd International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2018:1571-1581.

[13] HE N J, FANG L Y, LI Y, et al. High-order self-attention network for remote sensing scene classification[C]// Proceedings of the 2019 IEEE International Geoscience and Remote Sensing Symposium. Piscataway: IEEE, 2019: 3013-3016.

[14] 薛永杰,巨志勇. 注意力机制融合深度神经网络的室内场景识别方法[J]. 小型微型计算机系统, 2021, 42(5): 1022-1028.(XUE Y J, JU Z Y. Method for recognizing indoor scene classification based on fusion deep neural network with attention mechanism[J]. Journal of Chinese Computer Systems, 2021, 42(5):1022-1028)

[15] 边小勇,江沛龄,赵敏,等. 基于多分支神经网络模型的弱监督细粒度图像分类方法[J]. 计算机应用, 2020, 40(5):1295-1300.(BIAN X Y, JIANG P L,ZHAO M, et al. Multi-branch neural network model based weakly supervised fine-grained image classification method[J]. Journal of Computer Applications, 2020, 40(5):1295-1300.)

[16] LIN T Y, MAJI S. Improved bilinear pooling with CNNs[C]// Proceedings of the 2017 British Machine Vision Conference. Durham: BMVA Press, 2017: No.117.

[17] ZHAO Z Y, ZHANG K R, HAO X J, et al. BiRA-Net: bilinear attention net for diabetic retinopathy grading[C]// Proceedings of the 2019 IEEE International Conference on Image Processing. Piscataway: IEEE, 2019:395-399.

[18] XIA G S, HU J W, HU F, et al. AID: a benchmark data set for performance evaluation of aerial scene classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(7):3965-3981.

[19] CHENG G,HAN J W, LU X Q. Remote sensing image scene classification: benchmark and state of the art[J]. Proceedings of the IEEE, 2017, 105(10):1865-1883.

[20] KRIZHEVSKY A. Learning multiple layers of features from tiny images[R/OL]. (2009-04-08)[2021-02-17].https://www.cs.toronto.edu/~kriz/learning-features-2009-TR.pdf.

[21] HE K M, ZHANG X Y, REN S Q. Deep residual learning for image recognition[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016:770-778.

[22] HE N J, FANG L Y, LI S T, et al. Skip-connected covariance network for remote sensing scene classification[J]. IEEE Transactions on Neural Networks and Learning Systems, 2020, 31(5): 1461-1474.

[23] ZAGORUYKO S, KOMODAKIS N. Wide residual networks[C]// Proceedings of the 2016 British Machine Vision Conference. Durham: BMVA Press, 2016: No.87.

[24] ZHONG X, GONG O B, HUANG W X, et al. Squeeze and excitation wide residual networks in image classification[C]// Proceedings of the 2019 IEEE International Conference on Image Processing. Piscataway: IEEE, 2019: 395-399.

[25] LUAN S Z, CHEN C, ZHANG B C, et al. Gabor convolutional networks[J]. IEEE Transactions on Image Processing, 2018, 27(9): 4357-4366.

Joint 1-2-order pooling network learning for remote sensing scene classification

BIAN Xiaoyong1,2,3*, FEI Xiongjun1, CHEN Chunfang1, KAN Dongdong1, DING Sheng1,2,3

(1,,430065,;2,,430065,;3(),430065,)

At present, most pooling methods mainly extract aggregated feature information from the 1-order pooling layer or the 2-order pooling layer, ignoring the comprehensive representation capability of multiple pooling strategies for scenes, which affects the scene recognition performance. To address the above problems, a joint model with first- and second-order pooling networks learning for remote sensing scene classification was proposed. Firstly, the convolutional layers of residual network ResNet-50 were utilized to extract the initial features of the input images. Then, a second-order pooling approach based on the similarity of feature vectors was proposed, where the information distribution of feature values was modulated by deriving their weight coefficients from the similarity between feature vectors, and the efficient second-order feature information was calculated. Meanwhile, an approximate solving method for calculating square root of covariance matrix was introduced to obtain the second-order feature representation with higher semantic information. Finally, the entire network was trained with the combination loss function composed of cross-entropy and class-distance weighting. As a result, a discriminative classification model was achieved. The proposed method was tested on AID (50% training proportion), NWPU-RESISC45 (20% training proportion), CIFAR-10 and CIFAR-100 datasets and achieved classification accuracies of 96.32%, 93.38%, 96.51% and 83.30% respectively, which were increased by 1.09 percentage points, 0.55 percentage points, 1.05 percentage points and 1.57 percentage points respectively, compared with iterative matrix SQuare RooT normalization of COVariance pooling (iSQRT-COV). Experimental results show that the proposed method effectively improves the performance of remote sensing scene classification.

remote sensing scene classification; deep learning; first-order pooling; second-order pooling; square root of covariance matrix

This work is partially supported by National Natural Science Foundation of China (61972299,61806150), Graduate Innovation Foundation of Wuhan University of Science and Technology (JCX201927, JCX201924).

BIAN Xiaoyong, born in 1976, Ph. D., associate professor. His research interests include machine learning, remote sensing scene classification.

FEI Xiongjun, born in 1992, M. S. candidate. His research interests include high-order pooling.

CHEN Chunfang, born in 1992, M. S. candidate. Her research interests include deep multi-instance learning.

KAN Dongdong, born in 1998, M. S. candidate. His research interests include high-order pooling.

DING Sheng, born in 1975, Ph. D., associate professor. His research interests include object detection, deep learning.

TP391.4

A

1001-9081(2022)06-1972-07

10.11772/j.issn.1001-9081.2021040647

2021⁃04⁃23;

2021⁃07⁃30;

2021⁃08⁃05。

国家自然科学基金资助项目(61972299, 61806150);武汉科技大学研究生创新基金资助项目(JCX201927, JCX201924)。

边小勇(1976—),男,江西吉安人,副教授,博士,主要研究方向:机器学习、遥感场景分类;费雄君(1996—),男,湖北黄冈人,硕士研究生,主要研究方向:高阶池化;陈春芳(1996—),女,湖北荆州人,硕士研究生,主要研究方向:深度多示例学习;阚东东(1998—),男,湖北黄石人,硕士研究生,主要研究方向:高阶池化;丁胜(1975—),男,湖北武汉人,副教授,博士,主要研究方向:目标检测、深度学习。