国内教育技术领域元分析方法学质量研究*

程 薇 凡正成 杨淑婷

国内教育技术领域元分析方法学质量研究*

程 薇1凡正成2杨淑婷3

(1.南京邮电大学 教育科学与技术学院,江苏南京 210023;2.北京师范大学 中国基础教育质量监测协同创新中心,北京 100875;3.华东师范大学 教育信息技术学系,上海 200063)

元分析被视为指导教育实践与制定教育政策的“最佳证据”。然而,这并不意味着元分析的研究结论一定是可靠的。基于此,文章试图分析发表在国内教育技术领域期刊中关于元分析的研究质量,首先通过文献检索和筛选共纳入39篇元分析文献;接着编制了包含25个题项的元分析方法学质量评价工具;随后对39篇文献进行文献编码与资料提取。研究发现,虽然国内教育技术领域元分析的发表数量和研究质量呈整体上升趋势,但研究报告质量参差不齐;纳入研究的元分析文献普遍存在概念泛化、文献检索不充分、关键研究过程缺失、忽视研究结果的普遍性和局限性等问题。文章期望通过研究为规范元分析在教育技术领域的应用提供参考。

教育技术;元分析;方法学质量;报告质量

引言

自2002年起,美国国家研究理事会开始提倡使用元分析进行教育科学知识的积累[1]。作为一种定量的系统化文献综述方法,元分析为整合已有研究成果提供了方法学意义上的指导,被视为指导教育实践与制定教育政策的“最佳证据”,这在教育技术领域也不例外[2][3]。《教育技术研究与开发》(,)杂志主编也曾鼓励开展元分析研究,以改善教育实践[4]。事实上,自1976年Glass[5]提出“元分析”的概念后,教育技术领域关于元分析的研究数量不断增长[6]。

虽然元分析能够提供高可信度的研究结果,但这并不意味着元分析的研究结论一定是可靠的。近年来,元分析的发表数量每年以成倍速度增长,并在教育研究领域得到了广泛应用[7][8],但缺乏价值或“粗制滥造”的元分析也随之不断涌现——许多元分析的研究方法缺乏规范,质量参差不齐,其研究结果或结论可能会误导研究者、实践者和管理者。近年来,国内教育技术领域相关期刊发表了不少元分析的研究,其研究质量如何?本研究采用系统化文献综述法,分析发表在国内教育技术领域期刊上的元分析的研究质量,以期为规范元分析在教育技术领域的应用提供参考,并助力教育实践者和政策决策者开展循证教育实践。

一 文献综述

1 元分析的内涵、价值及研究过程

(1)元分析的内涵

“元分析”(Meta-Analysis)也称荟萃分析、整合分析、综合分析等[9],是利用统计分析方法对同一类问题的已有实证研究结果进行综合分析与评价,从而概括出其研究结果所反映的共同效应[10]。作为定量的系统化文献综述方法,元分析使用“效应量”这一指标衡量实验干预的强弱或变量间关系的强弱。效应量是一种标准化均值差,能够将同一主题使用不同研究工具和样本的研究结果用“统一尺度”进行量化、比较和分析[11]。例如,Hattie[12]整合教育研究领域的800余项元分析所得出的影响学业成就的“仪表盘”就是以效应量为指标。

(2)元分析的价值

教育领域长期存在关于“教育研究难以指导教学实践”的争论,而元分析是构建教育教学实践“知识库”的工具[13]。元分析被认为是寻找“最佳证据”的有效方法,也是开展循证教育实践的首要环节[14]。在教育领域,研究者使用元分析方法提供“最佳证据”;管理者则协调各方“冶炼”有效教学的策略和方法;编制有效教学指南,进而帮助教育实践者开展循证教学。

(3)元分析的研究过程

元分析的研究过程是证据整合的过程,主要包含形成问题、文献检索、文献筛选、文献编码、整合数据、解释证据等环节[15]。其中,形成问题环节主要包含明确概念定义、聚焦研究问题、阐明研究意义等;文献检索环节主要采用电子数据库检索、手动检索关键期刊、网络检索、参考文献回溯、联系专家等方式;文献筛选环节包含浏览标题和摘要、浏览全文两项内容;文献编码环节一般需要确定独立比较的单位,有时需要对编码者进行编码培训,至少需要两名编码者背对背编码,严格意义上还需要进行编码者一致性分析;整合数据环节也可称数据分析环节,主要包含计算效应量、发表偏倚、灵敏度分析、异质性检验等;解释证据环节主要讨论研究结果的普适性和局限性。

2 元分析研究质量的评价方式

元分析的质量评价方式有两种:方法学质量(Methodological Quality)和证据质量(Quality of the Evidence)[16]。

①方法学质量评价即报告质量(Reporting Quality)评价,是对元分析研究报告质量的评估。目前来说,AMSTAR及其升级版AMSTAR2是常用的方法学质量评价工具[17][18]。Shea等[19]设计开发的AMSTAR评价清单旨在评估基于随机对照实验的系统化文献综述的方法学质量,而其升级版AMSTAR2是用于评价基于随机、非随机对照实验的系统化文献综述的方法学质量评价工具[20]。虽然AMSTAR的应用范围较广,但其在教育研究领域的应用少之又少。同时,该工具评估研究问题以及纳入纳出标准是否采用PICO格式,而PICO格式是医学领域在提出问题时的专门格式,是英文中病人(Patient)、干预(Intervention)、对照(Comparison)以及结果(Outcome)四个单词的首字母缩写,其在教育领域中的适用性有待商榷。

②证据质量评价即偏倚风险(Risk of Bias),是对元分析潜在偏倚的评估——这里的偏倚是指研究结果或推论与事实的系统性偏差。ROBIS是用来评估证据质量的常用工具,主要通过研究设计、研究过程、解释研究结果三个阶段来评估系统化文献综述的证据质量,包括评估目标研究问题与拟研究问题的相关性、评估系统化文献综述过程中的偏倚风险情况、判断系统化文献综述的总偏倚风险[21]。当前,ROBIS主要用于医疗领域,而在其他领域的应用比较少。

3 教育技术领域已有研究述评

Tamim等[22]从元分析的概念明晰性、元分析过程与方法的全面性、元分析实施过程的严谨性三个维度的16个题项出发,对技术影响学习的25个元分析进行了方法学质量评价,结果发现:对于研究质量水平不同的元分析来说,效应量大小没有显著性差异;不足之处在于,该研究在评判研究质量高、中、低水平上仅仅给出了主观的结果。在此基础上,Bernard等[23]从界定问题、检索文献、从研究中收集资料、评估原始研究质量、分析研究结果、解释证据、编码者一致性七个维度出发,研究高等教育领域技术整合元分析研究的偏倚风险情况;不足之处在于,该研究没有关注文献筛选的过程和方法。

Plonsky等[24]从引言和文献综述、研究方法、结果与讨论三个维度的17个题项出发,对计算机支持的语言学习的10个元分析的方法学质量进行评估。不足之处在于,该研究缺少对文献编码过程、选择合成效应量模型、异质性检验以及灵敏度分析的关注;同时,该研究没有将研究结果、结论与讨论两部分区分开来。

Young[25]使用基于AMSTAR改编的R-AMSTAR量表,对技术支持的数学学习的19个元分析进行质量评估。与AMSTAR采用清单形式进行评估不同,R-AMSTAR采用的是量表形式。但R-AMSTAR缺少对文献筛选、效应量合成、调节变量分析等的关注。该研究发现,对研究质量水平不同的元分析来说,效应量大小存在显著性差异,其中质量高的元分析平均效应量最小。不足之处在于,该研究也未给出评判研究质量高、中、低水平的客观标准。

Tamim等[26]在修订和完善其团队前期研究工具的基础上,对教育技术领域的52个元分析进行方法学质量评估。该研究增加了文献筛选流程题项,减少了原始研究方法学质量的题项。但是,该研究关于文献检索与研究结果的报告内容过于简单,且该研究也没有评估异质性检验及其效应量的计算等。该研究发现,低质量的元分析可能过高估计了教育技术对学习的贡献,进而误导研究者和实践者;另外,早期发表的元分析研究质量得分远低于近年来发表的研究得分——也就是说,本领域发表的元分析研究质量呈好转趋势。该研究还指出,近年来有些元分析的质量仍处于中等水平,这需要引起本领域研究者、实践者及管理者的注意,以防被结果误导。

教育技术领域关于元分析质量的研究已有近十年的历史,所采用的研究工具虽尚未统一,但主要聚焦于方法学质量评价。另外,目前关于元分析研究质量高、中、低水平的判定未有客观标准,研究质量与效应量大小之间的关系也存在争议。考虑到元分析在国内教育技术领域的应用仍处于初级阶段,本研究首先整合已有研究中的元分析方法学质量评价工具,然后采用系统化文献综述方法,对国内教育技术领域已发表的元分析研究进行方法学质量评价,同时研究方法学质量与发表年份之间的关系,以及不同质量水平元分析的效应量大小是否有显著性差异。

二 研究设计

1 文献检索与筛选

本研究的纳入标准为:①发表于国内教育技术领域和远程教育领域的期刊;②报告了效应量的元分析研究;③被CSSCI期刊收录;④2021年之前正式发表。本研究使用与元分析相关的关键词,如元分析、文献综述、系统评价、荟萃分析、整合分析法等;期刊来源类别选择CSSCI,限定在《电化教育研究》《中国电化教育》《现代教育技术》《开放教育研究》《现代远程教育研究》《远程教育杂志》《中国远程教育》七本期刊。

本研究的文献检索时间为2021年4月4日,共计检索到文献215篇。随后,本研究团队通过浏览文献的标题和摘要,排除170篇非元分析研究的文献。之后,本研究团队通过浏览文献全文,继续排除6篇未报告效应量的研究。最终,本研究纳入的文献有39篇。

2 编码表的制定

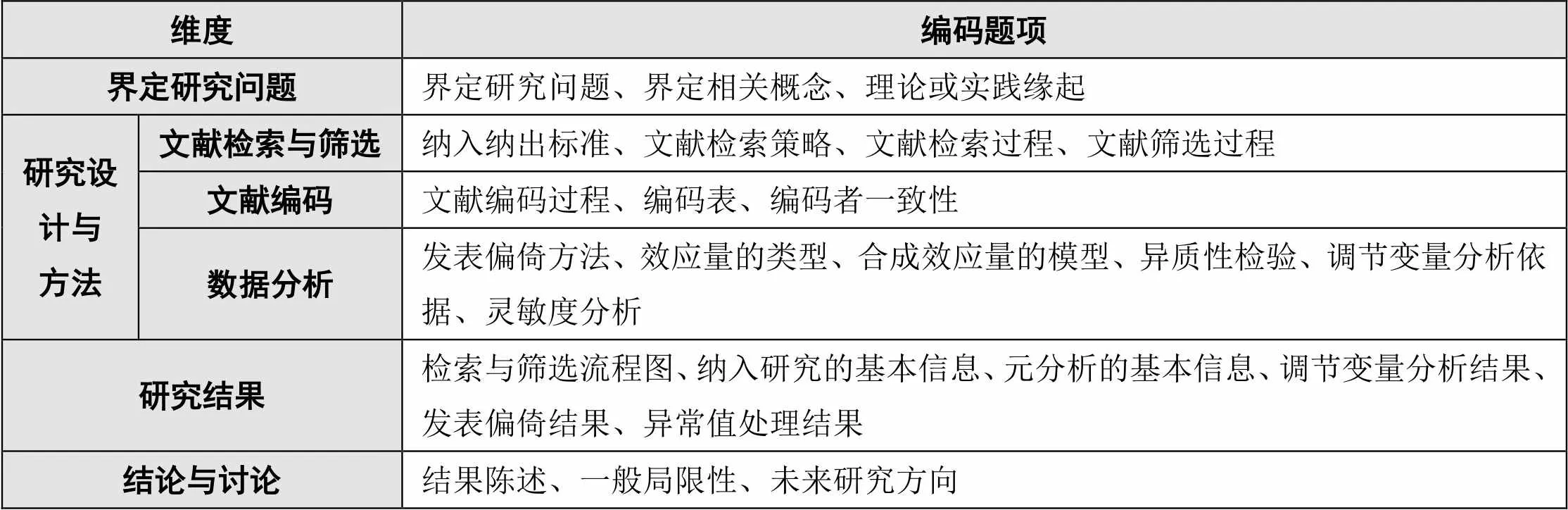

结合美国心理学协会(,)和教育领域的元分析报告质量研究相关成果[27][28][29][30],同时考虑国内教育技术元分析的应用情况,本研究主要从界定研究问题、研究设计与方法、研究结果、结论与讨论四个维度来评估本研究所纳入的39篇元分析,共设计评估题项25个,文献编码如表1所示。

表1 文献编码表

参考Tamim等[31]的评分方式,本研究采用三级定性描述每一题项的等级水平:第一级为没有报告相关信息,计分为0;第二级为部分报告相关信息,计分为1;第三级为清晰完整报告相关信息,计分为2;满分为50分。同时,本研究还对期刊名称、发表年份、关注的主题、关键词的使用、合成效应量的名称、合成效应量的类型、合成效应量的大小等进行编码,以对纳入文献的研究过程进行更为全面的分析。

3 文献编码及编码者一致性分析

本研究团队首先对纳入文献中的10篇文献进行预编码,编码完成后协商讨论,以达到对编码表的一致理解。之后,本研究团队中的两名成员采用“背对背”方式,分别对剩余的29篇文献进行正式编码。计算两名成员的编码者一致性采用组内相关系数()[32]。本研究的值在0.659~1之间。通常情况下,值大于0.75,为一致性高;值处于0.40~0.75之间,为一致性良好[33]。据此可知,本研究的评分者一致性满足统计学意义上的要求。对于不一致的编码结果,本研究团队的三名成员共同商议后确定最终的编码结果。

4 数据分析

本研究主要使用描述性统计分析报告纳入研究的基本特征,研究结果主要采用频数来描述每一题项在三种水平(即完整报告、部分报告、未报告)上的分布情况。同时,本研究对方法学质量25个题项的总得分进行排序后,将前27%记为高质量组、后27%标记为低质量组,剩余为中质量组[34],并采用方差分析验证这一分组的有效性。本研究还使用皮尔逊相关性检验分析发表年份与方法学质量总分的相关性。

三 研究结果

1 纳入研究的基本信息

在纳入的39篇文献中,发表在《电化教育研究》的有10篇,发表在《开放教育研究》《中国远程教育》的各有8篇,发表在《现代远程教育研究》的有4篇,发表在《中国电化教育》《现代教育技术》《远程教育杂志》的各有3篇;从发表年份上来看,主要集中在2017年以后;从研究主题上来说,涉及虚拟现实技术、翻转课堂、在线学习或网络学习、思维导图或知识可视化、教育机器人、移动学习等;从检索所用关键词和检索方式来看,近三分之二的元分析在检索时采用“教学干预+学习结果”的方式,其中“学习结果”所使用的词语通常为考试、测评、成绩、考察、学习成效、学习成果等之类。

从数据分析软件来说,有21篇文献使用Comprehensive Meta-Analysis(CMA)软件,有8篇文献使用Review Manager,有2篇文献使用Stata,有1篇文献使用R语言,其余7篇文献均未报告使用的数据分析软件;从使用的效应量类型来说,有14篇文献报告使用Cohen的值,13篇文献报告使用标准化均值差(),8篇文献报告使用Hedges的值,有2篇文献分别报告使用值、均值差(),还有2篇文献未报告使用的效应量类型。事实上,Cohen的值和Hedges的值都是标准化均值差,区别在于后者是对前者在样本量上进行校正后的无偏估计[35],但是不少研究者在使用时并未对其进行区分。

2 方法学质量分布

在纳入的39篇元分析文献中,方法学质量得分的最高值为44分、最低值为12分,均值为29.31分。在界定研究问题维度上,虽然绝大多数研究能够完整报告研究问题,但是缺乏对相关概念的界定以及对理论或实践缘起的阐述。在研究设计与方法维度上,文献编码过程、编码者一致性、异质性检验、调节变量分析依据、灵敏度分析等题项未报告的文献较多。在研究结果维度上,检索与筛选流程图、异常值处理结果等题项未报告的文献较多。在结论与讨论维度上,绝大多数研究完整报告了结果陈述部分和未来研究方向,同时绝大多数研究未完整报告一般局限性。25个题项在不同等级上的方法学质量评价结果如表2所示。

表2 方法学质量评价结果

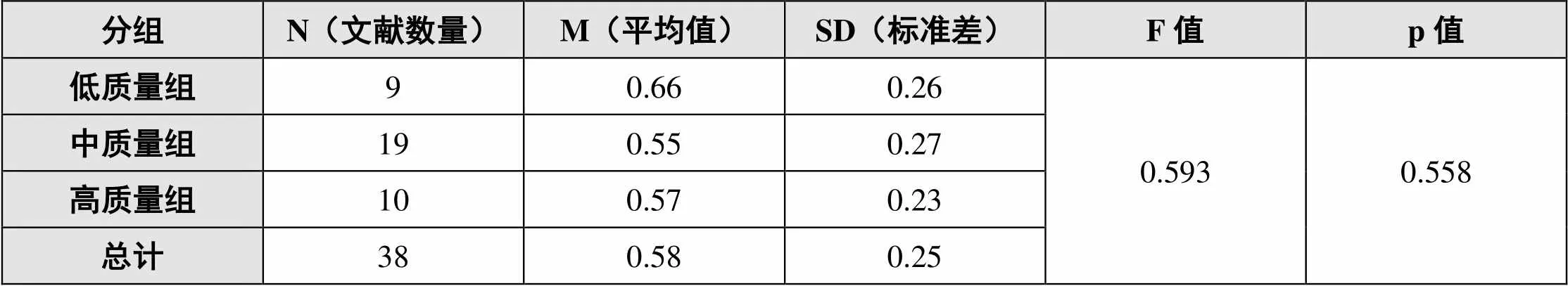

通过方差分析(ANOVA)发现,高、中、低分组在方法学质量上存在显著性差异(=61.336,=0.00<0.05),说明本研究采用的高、中、低分组方法是有效的。进一步分析发现,高、中、低三组在效应量大小方面不存在显著性差异(=0.593,=0.558>0.05),不同等级效应量大小方差分析结果如表3所示,这与Tamim等[36]的研究结果并不一致。

表3 不同等级效应量大小方差分析结果

注:其中有1篇文献未报告总效应量,所以本表文献数量总计38篇。

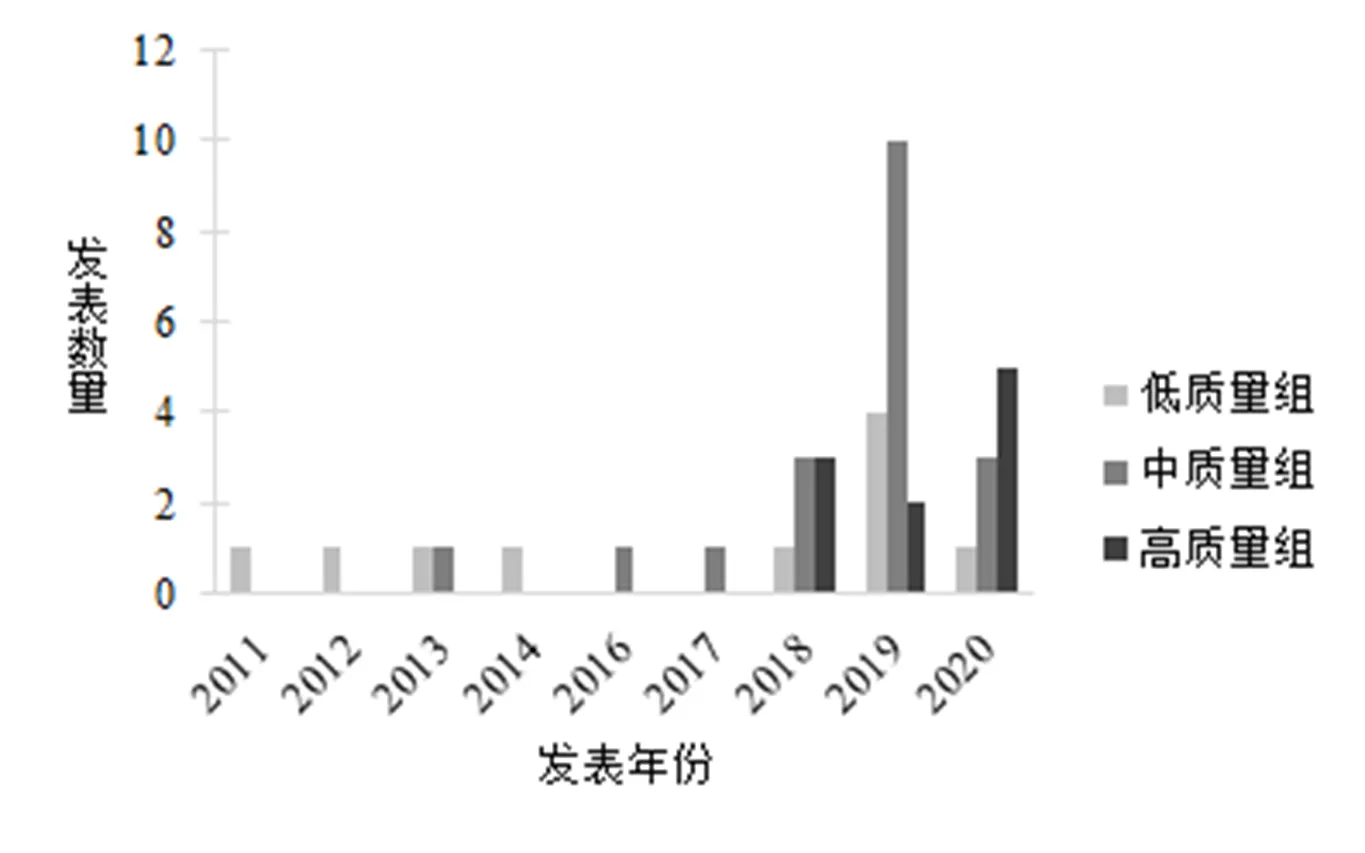

3 方法学质量与发表年份的关系

本研究发现纳入研究的文献的方法学质量与发表年份之间存在显著性正相关(=0.638,=0.000<0.01)。按照发表年份,本研究用条形统计图可视化呈现高、中、低三组方法学质量的发表数量和发表年份分布,如图1所示。可以看出,高质量文献主要集中在2017年以后。

图1 高、中、低三组方法学质量的发表年份和发表数量分布

四 讨论与展望

1 研究发现

本研究从国内教育技术领域七本CSSCI期刊发表的文献中筛选出39篇元分析,通过对其方法学质量的评估,发现虽然国内教育技术领域元分析研究文献的发表数量和研究质量整体呈上升趋势,但研究报告质量参差不齐,主要表现为:

①虽然多数文献报告了研究问题,但存在基本概念界定不清楚、概念泛化的问题;同时,在理论或实践缘起部分缺乏论证,多为泛泛之谈。

②在研究设计和方法部分,多数文献忽视了对文献编码过程的阐述和编码者一致性的分析,且缺少对异常值的检验,这是造成元分析研究结果偏倚的重要原因。

③在研究结果部分,多数文献没有报告文献筛选的过程和结果,仅报告最后纳入研究的数量;另外,多数研究仅使用漏斗图的方式判断发表偏倚情况,而很少采用定量的方式来评估研究的发表偏倚情况。

④在结论与讨论部分,多数文献缺少对研究结果普适性和局限性的解释与讨论,也缺少对未来研究提供参考性的建议或意见。

⑤对研究质量水平不同的元分析来说,其在效应量大小上不存在显著性差异;但是,低质量组元分析效应量的均值最高,也就是说低质量组可能会高估教育技术对学习的贡献。

2 研究讨论

针对目前元分析研究存在的问题,本研究认为造成这些问题的原因主要在于:

(1)概念泛化或是造成元分析研究质量不佳的首要因素

虽然元分析不是研究“苹果”或“橙子”,而是研究“水果”的问题,但这并不意味着核心概念的界定可以泛化。在界定研究问题的同时,概念性定义和操作性定义也需要清晰界定,否则会影响研究的透明度和可重复性。然而,在纳入的39篇元分析文献中,有不少研究文献出现了概念泛化的问题。而概念泛化会影响整个研究设计的质量和研究结果的解释力,继而会对教育实践产生误导。

从视觉教学到计算机辅助教学、多媒体学习,再到在线学习、人工智能教育,教育技术的发展似乎是各种技术在教育研究与实践中的“沉浮”,技术在教育中的应用方式和形态没有形成一个稳定的“分析变量和观察单位”,有关教育技术的核心概念界定模糊、难以区分,造成研究与实践之间的“无效”对话,甚至出现学术共同体内的“无效”争论[37]。因此,需要构建教育技术学的概念体系,形成技术应用于教与学的逻辑框架。

(2)文献检索不充分会影响元分析的透明度和可重复性

相较于叙述性文献综述来说,系统化文献综述和元分析的主要优势之一在于其能尽可能多地纳入相关研究,进而寻找一般性的结论。然而,虽然纳入的大多数文献报告了文献检索的策略和过程,但文献检索所选用的关键词选择不当、检索方式难以复现,都会使文献检索的充分性难以保障,进而导致元分析的优势变成劣势。

事实上,医学研究领域常用的检索原则在教育技术甚至教育领域中的适用性有待商榷。在教育技术领域开展系统化文献综述或元分析时,文献检索关键词的选用需要有经验的研究者来指导。未来研究可以关注教育技术领域已发表的系统化文献综述和元分析研究的文献检索存在的问题,规范文献检索方式和流程,制定文献检索指导规范,提高文献检索的充分性。

虽然报告质量并不完全代表研究质量,但遵循特定的研究报告标准可以提升研究报告本身的可读性,并提高研究的透明度和可重复性。目前来说,元分析的报告标准主要有系统化文献综述和元分析优先报告条目(Preferred Reporting Items for Systemtatic Reviews and Meta-Analyses,PRISMA)以及元分析报告标准(Meta-Analysis Reporting Standards,MARS)两种[38][39]。其中,PRISMA主要在医学领域使用,而MARS主要在心理学领域使用,两者在教育技术领域中的适用性有待商榷。此外,是否需要制定教育技术领域元分析的报告标准还有待进一步研究。

(3)关键研究过程缺失会造成元分析的偏倚风险

元分析使用“效应量”这一指标来衡量实验干预的强弱或变量间关系的强弱,其研究结果有很强的解释力,为缩短教育研究与实践的距离提供了方法上的支持。然而,元分析虽然是提供“最佳证据”的主要来源,其研究结果具有较高的可信度,但是这并不代表其研究结论就是可靠的,“粗制滥造”的研究反而更容易造成误导。

本研究所纳入的元分析存在关键研究过程缺失报告的问题,这会造成元分析的研究偏倚。例如,文献检索使用不当或错误的检索词、没有严格按照纳入纳出标准执行文献筛选、没有进行编码者一致性分析、缺少对异常值的检验等都会造成偏倚风险。为全面提升教育技术领域元分析的研究质量,未来还需要编制元分析的证据质量工具。

(4)研究结果的普遍性和局限性需要引起重视

元分析作为一种研究方法,其研究结果具有很强的解释力,元分析的讨论部分需要解释效应量的大小。而在解释效应量的大小时,研究者需要选择合适的评估效应量大小的标准。例如,Cohen[40]规定了大、中、小标准化均值差效应量的分界点分别为0.2、0.5、0.8。而在本研究所纳入的元分析中,大部分在解释效应量的大小时没有关注这一点。

另外,每一种研究方法或研究范式都存在各自的局限性。在解释研究结果时,研究者要从研究方法、研究实施条件等多个方面阐述其局限性。本研究所纳入的39篇元分析文献中,大多从文献检索的范围、纳入纳出标准等方面对研究的局限性泛泛而谈,而对元分析研究方法本身存在的局限性缺少探讨。

3 未来展望

本研究仅关注元分析研究的方法学质量,未来可以研究证据质量视角下的研究质量。此外,本研究仅选择国内七本与教育技术相关的CSSCI期刊进行文献检索,未来还可以将纳入研究的范围扩展到国外期刊论文、国内外学位论文和会议论文,以更全面地探究教育技术领域元分析的研究质量。事实上,国内学者所写的元分析研究文章还有一些发表在国际期刊或国际会议上,因此本研究的研究结果在一定程度上并不能完全反映国内教育技术领域元分析研究的质量。

作为一种研究方法,元分析有一套严格的研究流程。开展元分析研究需要全面、系统地掌握此种方法,若其质量不佳,很可能在于研究者对该方法掌握不足。此外,研究者还要对所需研究的主题具有丰富的研究经验,仅仅通过模仿很难产生高质量的研究。

[1]National Research Council. Scientific research in education[M]. Washington, D.C.: National Academies Press, 2002:44-49.

[2]Alsop G, Tompsett C. From effect to effectiveness: The missing research questions[J]. Journal of Educational Technology & Society, 2007,(1):28-39.

[3][4]Spector J, Johnson T, Young P. An editorial on replication studies and scaling up efforts[J]. Educational Technology Research and Development, 2015,(1):1-4.

[5]Glass G V. Primary, secondary, and meta-analysis of research[J]. Educational Researcher, 1976,(10):3-8.

[6]程薇,凡正成,陈桄,等.重溯技术与学习关系之争:整合元分析的发现[J].电化教育研究,2019,(6):35-42.

[7][28]Ahn S, Ames A J, Myers N D. A review of meta-analyses in education: Methodological strengths and weaknesses[J]. Review of Educational Research, 2012,(4):436-476.

[8]Polanin J R, Maynard B R, Dell N A. Overviews in education research: A systematic review and analysis[J]. Review of Educational Research, 2017,(1):172-203.

[9]张琦.遵循循证原则制订教育政策[J].中国教育学刊,2007,(7):11-15.

[10]毛良斌,郑全全.元分析的特点、方法及其应用的现状分析[J].应用心理学,2005,(4):354-359.

[11]郑昊敏,温忠麟,吴艳.心理学常用效应量的选用与分析[J].心理科学进展,2011,(12):1868-1878.

[12]Hattie J. Visible learning: A synthesis of over 800 meta-analyses relating to achievement[M]. London ; New York: Routledge, 2008:7-21.

[13]Wang M C, Haertel G D, Walberg H J. Toward a knowledge base for school learning[J]. Review of Educational Research, 1993,(3):249-294.

[14]杨文登,叶浩生.缩短教育理论与实践的距离:基于循证教育学的视野[J].教育研究与实验,2010,(3):11-17.

[15]Cooper H. Research synthesis and meta-analysis: A step-by-step approach[M]. Los Angeles: SAGE Publications, Inc, 2010:29-39.

[16]Becker L A, Oxman A D. Overviews of reviews[A] Cochrane Handbook for Systematic Reviews of Interventions[C]. Chichester, England: John Wiley & Sons, Ltd, 2008:607-630.

[17][19]Shea B J, Grimshaw J M, Wells G A, et al. Development of AMSTAR: A measurement tool to assess the methodological quality of systematic reviews[J]. BMC Medical Research Methodology, 2007,(1):1-7.

[18][20]Shea B J, Reeves B C, Wells G, et al. AMSTAR 2: A critical appraisal tool for systematic reviews that include randomised or non-randomised studies of healthcare interventions, or both[J]. BMJ, 2017,358:j4008.

[21]Whiting P, Savovic J, Higgins J P T, et al. ROBIS: A new tool to assess risk of bias in systematic reviews was developed[J]. Journal of Clinical Epidemiology, 2016,69:225-234.

[22]Tamim R M, Bernard R M, Borokhovski E, et al. What forty years of research says about the impact of technology on learning: A second-order meta-analysis and validation study[J]. Review of Educational Research, 2011,(1):4-28.

[23][29]Bernard R M, Borokhovski E, Schmid R F, et al. An exploration of bias in meta-analysis: The case of technology integration research in higher education[J]. Journal of Computing in Higher Education, 2014,(3):183-209.

[24]Plonsky L, Ziegler N. The CALL-SLA Interface: Insights from a second-order synthesis[J]. Language Learning & Technology, 2016,(2):17-37.

[25]Young J. Technology-enhanced mathematics instruction: A second-order meta-analysis of 30 years of research[J]. Educational Research Review, 2017,(22):19-33.

[26][30][31][36]Tamim R M, Borokhovski E, Bernard R M, et al. A study of meta-analyses reporting quality in the large and expanding literature of educational technology[J]. Australasian Journal of Educational Technology, 2021,(4):100-115.

[27][39]American Psychological Association. Publication manual of the American psychological association[M]. Washington, DC: American Psychological Association, 2013:251-252.

[32]Fleiss J L, Cohen J. The equivalence of weighted Kappa and the intraclass correlation coefficient as measures of reliability[J]. Educational and Psychological Measurement, 1973,(3):613-619.

[33]潘晓平,倪宗瓒.组内相关系数在信度评价中的应用[J].华西医科大学学报,1999,(1):62-63、67.

[34]戴海崎,张锋.心理与教育测量(第4版)[M].广州:暨南大学出版社,2018:80-82.

[35]Borenstein, M., Hedges, L. V., Higgins, J. P. T., Rothstein, H. R. Introduction to Meta-Analysis[M]. Chichester, UK:John Wiley & Sons,Ltd., 2009:21-30.

[37]郭文革.教育的“技术”发展史[J].北京大学教育评论,2011,(3):137-157、192.

[38]Page M J, Mckenzie J E, Bossuyt P M, et al. The PRISMA 2020 statement: an updated guideline for reporting systematic reviews[J]. BMJ, 2021,88:105906.

[40]Cohen J. Statistical power analysis for the behavioral sciences[M]. New York: Routledge, 1988:20-40.

Research on the the Quality of Meta-analyses Methodology in the Field of Domestic Educational Technology

CHENG Wei1FAN Zheng-cheng2YANG Shu-ting3

Meta-analysis is considered as the “best evidence” for guiding educational practice and formulate education policies. However, it does not mean that the research conclusion of the meta-analysis is necessarily reliable. Based on this, this paper attempted to analyze the research quality of meta-analyses published in domestic educational technology journals. Firstly, a total of 39 meta-analysis literature were included through literature search and screening. Then, a meta-analysis methodology quality evaluation tool containing 25 items was compiled. Subsequently, 39 pieces of literature were coded and data extracted. It was found that although the publication number and research quality of meta-analysis in the field of domestic educational technology showed an overall upward trend, the quality of research reports was uneven, and the meta-analysis literature included in the research generally had the problems of conceptual generalization, insufficient literature retrieval, and lack of key research processes, ignoring the generalizability and limitations of the research results. This paper was expected to provide reference for the application of normative meta-analysis in the field of educational technology through research.

educational technology; meta-analysis; methodology quality; report quality

G40-057

A

1009—8097(2022)06—0025—10

10.3969/j.issn.1009-8097.2022.06.003

本文为江苏省教育科学“十三五”规划青年专项课题“教育技术学领域元分析的方法学质量评价研究”(项目编号:C-b/2020/01/23)的阶段性研究成果,并受教育部人文社会科学研究项目“循证视域下技术有效应用于教与学的理论与实践研究”(项目编号:19YJC880013)资助。

程薇,讲师,博士,研究方向为技术促进学习、循证实践和智慧学习环境,邮箱为chengweiet@njupt.edu.cn。

2021年12月31日

编辑:小时