MSAM:针对视频问答的多阶段注意力模型

梁丽丽 刘昕雨 孙广路 朱素霞

摘要:视频问答(VideoQA)任务需要理解视频和问题中的语义信息生成答案。目前,基于注意力模型的VideoQA方法很难完全理解和准确定位与问题相关的视频信息。为解决上述问题,提出一种基于注意力机制的多阶段注意力模型网络(MSAMN)。该网络将视频、音频以及文本等多模态特征输入到多阶段注意力模型(MSAM)中,通过逐阶段的定位方式精准找到与回答问题相关的视频信息,用于答案生成。为了提高特征融合的有效性,提出一种三模态压缩级联双线性(TCCB)算法计算不同模态特征之间的相关性。MASMN在ZJL数据集上进行实验,平均准确率均为54.3%,比传统方法提高了近15%,比现有方法提高了近7%。

关键词:视频问答;多阶段注意力模型;多模态特征融合

DOI:10.15938/j.jhust.2022.04.014

中图分类号: TP391.3

文献标志码: A

文章编号: 1007-2683(2022)04-0107-11

MSAM:Video Question Answering Based

on Multi-Stage Attention Model

LIANG Li-li,LIU Xin-yu,SUN Guang-lu,ZHU Su-xia

(School of Computer Science and Technology, Harbin University of Science and Technology, Harbin 150080, China)

Abstract:The video question answering (VideoQA) task requires understanding of semantic information of both the video and question to generate the answer. At present, it is difficult for VideoQA methods that are based on attention model to fully understand and accurately locate video information related to the question. To solve this problem, a multi-stage attention model network (MSAMN) is proposed. This network extracts multi-modal features such as video, audio and text and feeds these features into the multi-stage attention model (MSAM), which is able to accurately locate the video information through a stage-by-stage localization method. In order to improve the effectiveness of feature fusion, a triple-modal compact concat bilinear (TCCB) algorithm is proposed to calculate the correlation between different modal features. This network is tested on the ZJL dataset. The average accuracy rate is 54.3%, which is nearly 15% higher than the traditional method and nearly 7% higher than the exist method.

Keywords:video question answering; multi-stage attention model; multi-modal feature fusion

0引言

近年來,由于视频问答任务具有较强的应用价值,现已成为计算机视觉、自然语言处理等领域的研究热点,该任务是对视频内容和问题进行理解,生成一个符合逻辑的答案[1]。现有视频问答方法分为以下4个类别[2]:编码器-解码器、注意力模型、记忆网络模型和其他方法。

现阶段大多数方法利用注意力机制思想来解决视频问答任务。注意力模型计算问题与视频之间的语义相似性,为与问题相关的视频分配更高的权重得分。但现有的基于注意力模型的视频问答方法存在两个方面的不足:①难以有效地理解复杂的视频信息。现有方法未能充分利用视频中丰富的模态信息,且未能选择有代表性的模态信息作进一步的分析和推理;②难以准确地定位与问题相关的视频信息。现有方法未能动态地理解问题和视频的语义信息,且未能精准定位到与问题相关的视频信息。

针对上述问题,本文提出了一种多阶段注意力模型(multi-stage attention model, MSAM)用来精准定位与问题相关的视频特征。MSAM共分为3个阶段且每个阶段所关注的对象有所侧重:第1阶段注意力模型是在视频序列中找到与问题相关的关键通道。第2阶段注意力模型是在第1个阶段的基础上,从关键通道中找到与问题相关的关键区域,实现进一步的精准定位。第3阶段注意力模型在第1阶段的基础上对融合的视频表示进行关注,通过多个特征协同合作来理解问题,从而得到与问题相关的视频表示。基于MSAM的提出,因此构建了多阶段注意力模型网络(multi-stage attention model network,MSAMN)来解决视频问答任务。实验表明本文提出的方法在视频问答任务中的分类准确率有明显提高,同时提出的MSAMN具有较好的泛化性能。

本文的主要贡献如下:①提出了一种多阶段注意力模型,该模型以逐阶段的定位方式精准地找到与问题相关的视频信息;

②提出了一种三模态压缩级联双线性模型,该模型充分利用多种模态特征之间的相关性来实现更有效的多模态特征融合;

③提出了一种基于高复用性的问题特征提取模型,该模型既考虑了细粒度的过滤停用词后的单词特征,又考虑了粗粒度的问题特征。

本文内容安排如下:第二章介绍了与MSAMN方法相关的研究工作;第三章描述了MSAMN的整体框架图;第四章详细介绍了视频的帧特征、剪辑特征和音频特征,以及问题的文本特征的特征提取方法,然后详细地阐述了多阶段注意力模型和三模态压缩级联双线性算法;第五章进行了大量的实验,并对实验结果进行了整理和分析。

1相关工作

目前国内外学者对视频问答任务已经进行了大量的研究,实验表明将注意力模型应用到视频问答任务中可以显著提高模型的准确率。文[3]提出了一种基于属性增强的注意力网络模型,该模型通过属性增强表示获得视频每一帧在时间维度上的权重得分,进而计算属性和视频之间的相似性。但这种模型只关注视频的静态特性,而忽略了视频的动态特性,随后研究学者意识到视频与图像的不同之处在于视频特征具有时序性以及大量的动态特性。因此文[4]提出了一种空间-时间推理模型,该模型利用3D 卷积网络提取视频的剪辑特征,再利用空间注意力模型和时间注意力模型分别关注视频区域和视频帧。文[5]提出了一种基于双层注意力模型(DLAN)的网络,它利用问题中的单词来对视频中的帧和片段进行关注以找出关键区域,根据生成问题-导向视频表示来生成答案。文[6]提出了一种基于运动外观的协同记忆网络,该网絡利用运动线索产生外观注意力并利用外观线索产生运动注意力,结合运动-外观协同记忆注意力用于生成答案。上述研究均利用C3D[7]来提取视频中的时序特征,但由于C3D对视频上下文剪辑片段的访问受限,只能对单个剪辑片段进行特征提取,因此对于行为、状态转换、计数等问题,模型生成的答案准确率不高。

此外,一些研究学者认为模型生成答案准确率不高的原因在于视频问答任务是多模态的深度学习任务[8],其中各个模态之间的表示、传译、对齐和融合的过程中可能会出现问题。因此文[9]提出了一种基于联合序列的融合模型(JSFusion),该模型能够测量多模态序列数据对之间的语义相似性,并通过引入注意力模型,采用一种自下而上的方法来递归地匹配序列数据。文[1]提出了一种多粒度关注网络(MGTA-Net),该网络利用时间协同关注模型可以得到多级视频表示,并将多级视频表示与问题特征相结合形成多粒度表示,用于答案生成。文[10]提出了一种基于树-结构的记忆网络(HTreeMN),该网络根据问题的词汇构建语义树,其中语义树具有层次结构,并且可以自然而然地将分层的注意力机制添加到树中,然后对叶子结点,非叶子结点和根结点分别进行注意力关注。但是上述方法仍存在对视频理解能力较差、与问题相关的视频信息定位不准确等问题,因此,本文提出一种基于多阶段注意力模型网络方法用于解决视频问答任务。

2模型整体框架

MSAMN框架图由多模态特征提取、MSAM和答案生成3个模块组成,MSAMN的具体流程如图1所示。多模态特征提取模块主要是从视频中提取帧特征、剪辑特征和音频特征,从问题中提取文本特征。在视频特征提取方面,本文利用残差神经网络ResNet[12]提取帧特征和音频特征,利用时域分段网络TSN[13]提取剪辑特征。在问题特征提取方面,首先利用NLTK对问题执行停用词的过滤操作,然后采用LSTM[14]对其进行编码,得到问题特征。MSAM模块主要分为以下3个阶段:第1阶段是对视频序列进行注意力关注,该阶段选择与问题匹配得分最高的关键通道(关键帧/关键剪辑/关键音频)来进行第2阶段关注。第2阶段是对第1阶段得到的关键通道进行多步迭代关注,以逐步精准定位与问题相关的关键区域。第3阶段在第1阶段的基础上对融合的视频表示进行关注,通过多个特征协同合作来理解问题,从而得到与问题相关的视频表示。答案生成模块融合多个阶段的有效信息,用于生成答案。

3方法

针对视频问答任务而言,理解视频内容的主要困难在于视频中包含大量视频且某些事件持续时间较长,比如计数问题:整段视频中总计出现的人数?那么视频问答模型回答此类问题时,首先需要在大量冗余信息中查找与问题相关的视频信息,然后再根据问题在相关视频信息中逐步精确地定位视频信息来回答问题,从而保证模型生成答案的准确性。

3.1多模态特征提取

3.2多阶段注意力模型

3.2.1第1阶段注意力模型

3.2.2第2阶段注意力模型

3.2.3第3阶段注意力模型

3.3答案生成

4实验与分析

4.1数据集介绍

4.2数据准备

4.3实验设置

4.4评价标准

4.5实验对比与实验结果分析

4.6消融研究

4.6.1评估各模态通道组合的有效性

4.6.2评估各阶段注意力模型的有效性

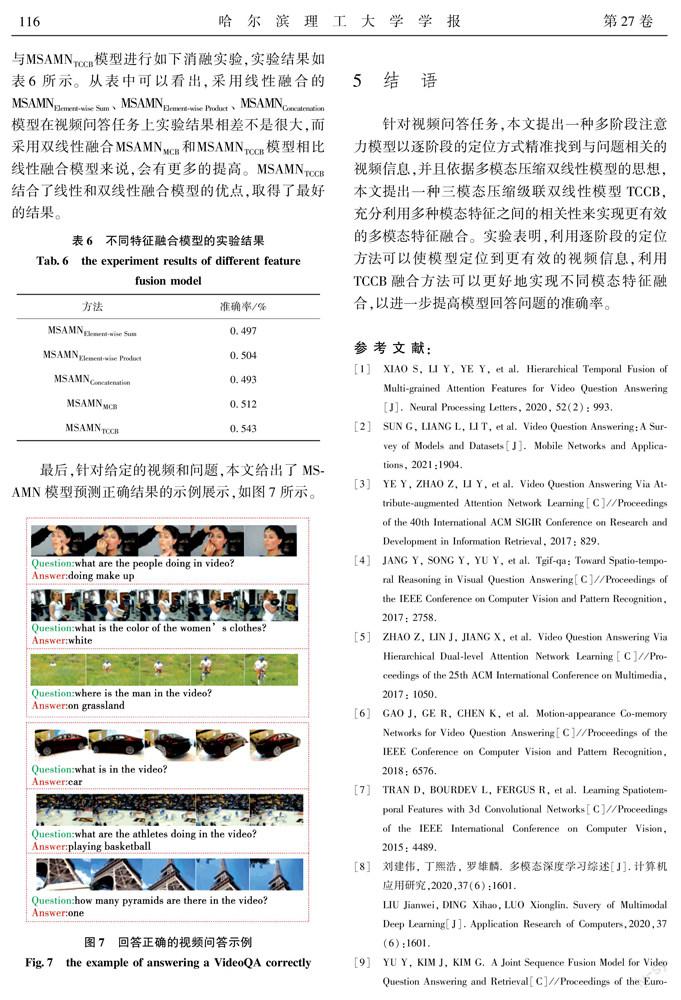

4.6.3评估TCCB融合模型的有效性

5结语

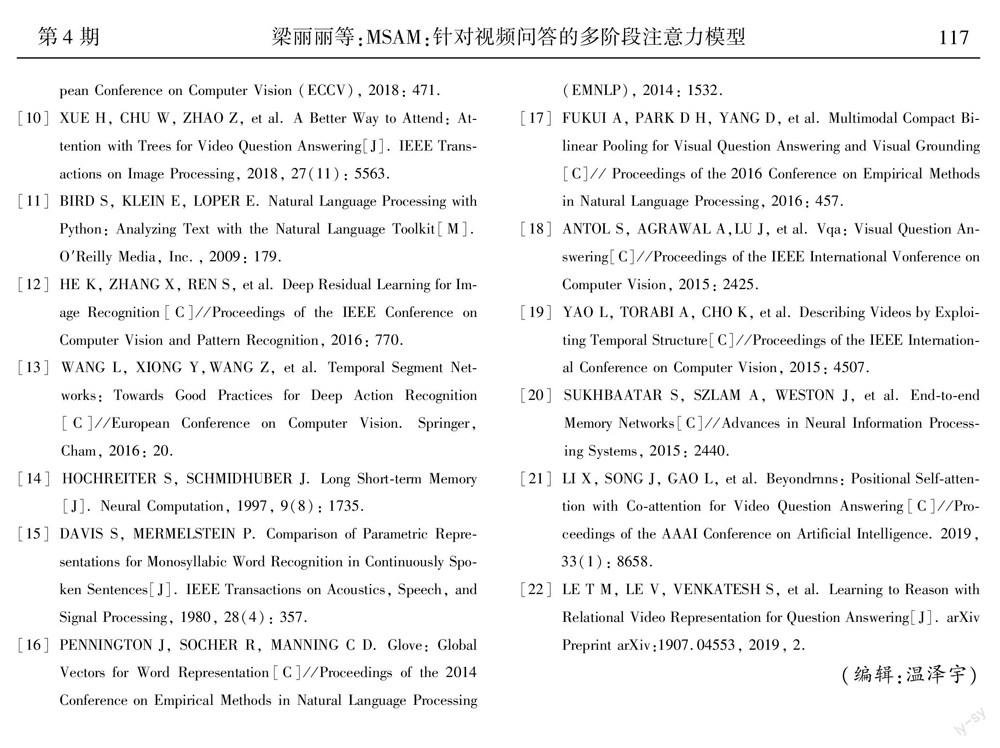

针对视频问答任务,本文提出一种多阶段注意力模型以逐阶段的定位方式精准找到与问题相关的视频信息,并且依据多模态压缩双线性模型的思想,本文提出一种三模态压缩级联双线性模型TCCB,充分利用多种模态特征之间的相关性来实现更有效的多模态特征融合。实验表明,利用逐阶段的定位方法可以使模型定位到更有效的视频信息,利用TCCB融合方法可以更好地实现不同模态特征融合,以进一步提高模型回答问题的准确率。

参 考 文 献:

[1]XIAO S, LI Y, YE Y, et al. Hierarchical Temporal Fusion of Multi-grained Attention Features for Video Question Answering[J]. Neural Processing Letters, 2020, 52(2): 993.

[2]SUN G, LIANG L, LI T, et al. Video Question Answering:A Survey of Models and Datasets[J]. Mobile Networks and Applications, 2021:1904.

[3]YE Y, ZHAO Z, LI Y, et al. Video Question Answering Via Attribute-augmented Attention Network Learning[C]//Proceedings of the 40th International ACM SIGIR Conference on Research and Development in Information Retrieval, 2017: 829.

[4]JANG Y, SONG Y, YU Y, et al. Tgif-qa: Toward Spatio-temporal Reasoning in Visual Question Answering[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 2758.

[5]ZHAO Z, LIN J, JIANG X, et al. Video Question Answering Via Hierarchical Dual-level Attention Network Learning[C]//Proceedings of the 25th ACM International Conference on Multimedia, 2017: 1050.

[6]GAO J, GE R, CHEN K, et al. Motion-appearance Co-memory Networks for Video Question Answering[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 6576.

[7]TRAN D, BOURDEV L, FERGUS R, et al. Learning Spatiotemporal Features with 3d Convolutional Networks[C]//Proceedings of the IEEE International Conference on Computer Vision, 2015: 4489.

[8]劉建伟, 丁熙浩, 罗雄麟. 多模态深度学习综述[J].计算机应用研究,2020,37(6):1601.

LIU Jianwei,DING Xihao,LUO Xionglin.Suvery of Multimodal Deep Learning[J].Application Research of Computers,2020,37(6):1601.

[9]YU Y, KIM J, KIM G. A Joint Sequence Fusion Model for Video Question Answering and Retrieval[C]//Proceedings of the European Conference on Computer Vision (ECCV), 2018: 471.

[10]XUE H, CHU W, ZHAO Z, et al. A Better Way to Attend: Attention with Trees for Video Question Answering[J]. IEEE Transactions on Image Processing, 2018, 27(11): 5563.

[11]BIRD S, KLEIN E, LOPER E. Natural Language Processing with Python: Analyzing Text with the Natural Language Toolkit[M]. O′Reilly Media, Inc., 2009: 179.

[12]HE K, ZHANG X, REN S, et al. Deep Residual Learning for Image Recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770.

[13]WANG L, XIONG Y,WANG Z, et al. Temporal Segment Networks: Towards Good Practices for Deep Action Recognition[C]//European Conference on Computer Vision. Springer, Cham, 2016: 20.

[14]HOCHREITER S, SCHMIDHUBER J. Long Short-term Memory[J]. Neural Computation, 1997, 9(8): 1735.

[15]DAVIS S, MERMELSTEIN P. Comparison of Parametric Representations for Monosyllabic Word Recognition in Continuously Spoken Sentences[J]. IEEE Transactions on Acoustics, Speech, and Signal Processing, 1980, 28(4): 357.

[16]PENNINGTON J, SOCHER R, MANNING C D. Glove: Global Vectors for Word Representation[C]//Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing(EMNLP), 2014: 1532.

[17]FUKUI A, PARK D H, YANG D, et al. Multimodal Compact Bilinear Pooling for Visual Question Answering and Visual Grounding[C]// Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing, 2016: 457.

[18]ANTOL S, AGRAWAL A,LU J, et al. Vqa: Visual Question Answering[C]//Proceedings of the IEEE International Vonference on Computer Vision, 2015: 2425.

[19]YAO L, TORABI A, CHO K, et al. Describing Videos by Exploiting Temporal Structure[C]//Proceedings of the IEEE International Conference on Computer Vision, 2015: 4507.

[20]SUKHBAATAR S, SZLAM A, WESTON J, et al. End-to-end Memory Networks[C]//Advances in Neural Information Processing Systems, 2015: 2440.

[21]LI X, SONG J, GAO L, et al. Beyondrnns: Positional Self-attention with Co-attention for Video Question Answering[C]//Proceedings of the AAAI Conference on Artificial Intelligence. 2019, 33(1): 8658.

[22]LE T M, LE V, VENKATESH S, et al. Learning to Reason with Relational Video Representation for Question Answering[J]. arXiv Preprint arXiv:1907.04553, 2019, 2.

(編辑:温泽宇)