融入主题特征的中越跨语言情感分类模型

施忆雪,余正涛,相 艳,张亚飞

(1.昆明理工大学 信息工程与自动化学院,云南 昆明 650500;2.昆明理工大学 云南省人工智能重点实验室,云南 昆明 650500)

0 引言

互联网的快速发展推动了中越两国交流,对越南语的网络评论进行情感极性分析有助于了解民众对特定事件的态度,是越南语事件观点分析的基础。越南语情感词典、标注数据等资源的稀缺阻碍了其情感分类研究,可通过跨语言情感分类(Cross-Lingual Sentiment Classification,CLSC)方法,利用中文作为源语言的情感资源,解决越南语作为目标语言的情感分类问题。目前常用的跨语言情感分类方法有三类: 一是基于双语对齐资源的方法,利用平行语料、情感词典等,将源语言中的情感资源直接迁移到目标语言中,弥补语言之间的语义鸿沟[1-4]。二是基于机器翻译技术,将两种语言翻译至同一语言,最终将跨语言情感分类转变为单语任务[5-8]。三是基于特征迁移[9-13],将源语言与目标语言的特定语言特征和语言无关特征映射到统一空间中,使得两种语言在语义空间下共享同一表示,以实现情感分类任务。

目前基于特征迁移的方法主要解决的是两种语言的语义表征对齐问题,而未关注文本所蕴含的主题对于情感分类的作用。实际上,无论是中文还是越南语,用户通常都会针对特定主题发表评论,主题信息将有助于推断情感状态[14]。以下将以图1和图2所示评论为例,分析主题在评论中的作用。

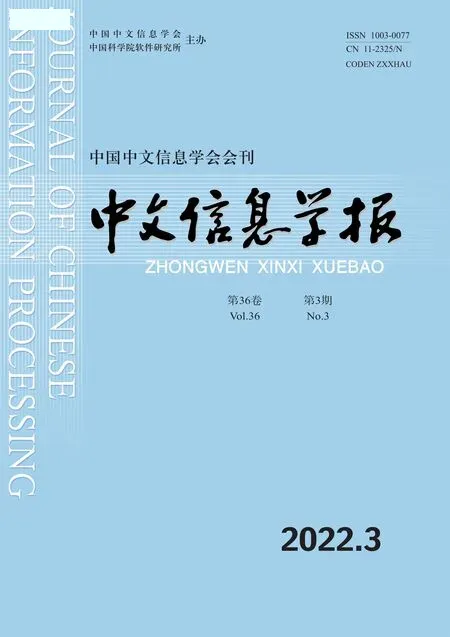

图1 中文评论句样例

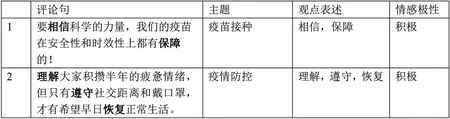

图2 越南语评论句样例

图1所示的中文新冠疫情数据集中,有关于“疫苗接种”和“疫情防控”两种不同主题的评论句。针对“疫苗接种”主题的评论句中,常用的观点词为“相信”,“最好的”,“保障”等,表示对接种疫苗的支持和鼓励;而针对“疫情防控”主题的评论句中,观点词常用“理解”,“遵守”,“控制”等,表达疫情防控的必要性。可以看出评论在针对某一主题表达观点时,所使用的观点词具有特定性,而不同主题的观点表述存在差异。这一特性也体现在图2所示的越南语新冠疫情数据集上。因此,不论是中文还是越南语,评论句所使用的观点词通常是与特定主题高度相关的,情感极性也会与主题信息相关联。

根据上述分析,本文认为在进行跨语言情感分类任务中,加入主题信息能够更准确地判断用户表达的情感状态,提高分类性能。因此,本文提出一种融入主题信息的对抗学习模型,实现对越南语评论的情感分类。本文贡献如下:

(1)提出将中文和越南语的主题词分布作为外部知识引入模型,利用主题信息更好地构建双语评论在同一特征空间下的对应关系。

(2)提出选择门控机制将主题表征与语义表征进行融合,并利用对抗学习使模型语言分布差异最小,从而可以利用中文情感极性标签,实现对越南语情感极性的判别。

(3)在所构建的中越评论数据集和公共的英中数据集上进行了实验,相比已有的基准模型,本文模型的性能都有较大提升。

1 相关工作

跨语言情感分析旨在利用源语言资源丰富的情感知识解决目标语言资源稀缺的问题,按策略可分为以下三类方法:

(1)基于双语对齐资源的方法利用双语情感词典等双语资源,实现词粒度信息的对齐,以此判断两种语言的文本是否包含相同情感极性。例如,Wan[1-2]提出协同训练的方法,应用双语资源来提升分类器的性能;Balamurali等人[3]将多语言知识库中对齐连接词的语义信息作为监督信号,训练情感分类器;Barnes等人[4]利用双语词典,将源语言和目标语言的语义相似度及情感信息映射到同一空间中,通过联合学习预测目标语言的情感极性。

(2)基于机器翻译的方法这是跨语言情感分类中常用的方法,该方法主要利用翻译引擎将两种语言翻译至同一语言,最终将跨语言情感分类任务转变为单语情感分类分析任务。例如,文献[5~8]利用机器翻译工具获得双语平行语料,建立跨语言文本间语义的对应关系;Meng等人[8]通过捕获跨语言的语义相似性构建平行句的共享表示;Li等人[6]利用机器翻译工具获取双语间的枢轴特征,并利用单词的分布式表示构建枢轴特征的一对多映射;Zhou等人[7]利用机器翻译获取目标语言的标签,并利用语义与情感的相关性完成同一嵌入空间下的双语信息映射。

(3)基于特征迁移的方法其主要思想是将双语中特定语言特征和语言无关特征映射到统一的特征空间中。Chandar等人[9]利用平行句对,提出了一种用于学习共享表示的预测性自动编码器;Hermann和Blunsom 等人[10]提出的方法能学习到一种组合的分布式语义;Zhou等人[11]则提出一种双语嵌入,用于跨语言情感分析。上述方法学习的特征难以解释,并且算法时间复杂度高。对此,Chen等人[12]提出基于特征编码器和语言判别器的对抗训练模型,利用源语言标签训练情感分类器,最后应用在目标语言上进行情感分类;Chen等人[13]将语言通用的表情符号作为跨语言知识迁移的“桥梁”,提出了基于表情符号的跨语言情感分析模型,提高了目标语言情感分析的性能。

与前期工作不同的是,本文不仅关注跨语言语义差距的问题,同时也关注不同主题下观点表达差异的问题。因此本文提出一种融入主题分布的特征编码器,通过选择门控机制进行特征融合,利用对抗学习实现两种语言特征在特征空间下的对齐。

2 模型介绍

融入主题特征的中越跨语言情感分类的任务定义如下: 给定中文评论句SS={s1,s2,…,sns},中文情感标签yS,以及越南语评论句St={s1,s2,…,snt},模型的目标是预测中文和越南语评论句的情感极性y∈{0,1},其中,si表示词序列中一个词,0表示消极,1表示积极。

2.1 模型整体结构

模型主要分为评论特征编码、对抗学习和情感分类三个部分,具体结构包括语义特征编码器F、主题特征编码器T、选择门控机制G、语言鉴别器Q、情感分类器P,如图3所示。

图3 融入主题信息的跨语言情感分类模型

首先,利用语义特征编码器F对评论文本进行语义表征,表示为hc,利用主题特征编码器T进行主题表征,表示为ht′,二者通过门控机制G进行融合,得到评论的综合表征hf;然后对语言鉴别器Q进行迭代的对抗训练,使双语评论综合表征在情感特征空间下得到对齐;最后,利用中文评论的情感极性标签训练情感分类器P,用来预测越南语评论的情感极性。

2.2 评论综合表征

2.2.1 语义表征

语义表征由语义特征编码器F获得,其具体操作为:

(1)对于给定的评论数据,使用双语词嵌入将其转换为序列嵌入。评论句表示为一个词序列S={s1,s2,…,sn},其中n表示输入文本对应的词数。单个词嵌入为si∈Rd,则输入序列嵌入为S∈Rd×n。

(2)采用三种不同宽度的核,其窗口大小为lk。通过卷积操作后得到向量fk∈Rl×(n-lk+1)。

(3)采用最大池化操作,获取每个卷积特征中的最大值,经过拼接和线性转换,得到卷积后的语义表征hc∈Rm,其中m为线性变换后的隐层维度。

2.2.2 主题表征

本文将主题词分布引入到跨语言情感分类任务中,利用主题特征编码器T进行主题表征,其具体操作为:

(1)使用LDA主题模型预训练源语言和目标语言数据集,得到每个评论在其最大主题概率下的前K个主题词。

(2)利用双语词嵌入,得到K个主题词的嵌入序列ht∈RK×d,其中d是嵌入维度。

(3)将评论的嵌入序列经过平均池化操作,并通过多层感知机MLP进行维度转换,得到其主题向量ht′∈Rm,m是变换后的维度。

ht′=MLP(avg_pooling(ht))

(1)

2.2.3 选择门控机制

在获取到语义表征hc和主题表征ht′后,由于两者的贡献程度并不相同,因此设计一种选择门控机制G,利用一个语义特征门和一个主题门对两个表征进行融合,得到综合表征。门控机制的计算如式(2)~式(4)所示。

其中,gt是主题门,gc是语义特征门,W(gt),U(gt)、b(gc)是可学习的参数,hc、ht′、hf维度均为Rm。门控机制允许网络自适应地学习语义表征和主题表征的重要性,组成评论的综合表征hf∈Rm。

2.2.4 对抗学习

使用对抗学习对两种语言融入主题信息后的特征进行空间下的对齐。对抗学习过程包括生成器和鉴别器两部分,其中生成器是由评论综合表征中的语义特征编码器F、主题特征编码器T和选择门控机制G融合构成的,语言鉴别器Q由多层感知机构成,输出近似为语言分布。本文采用Chen[13]等人提出的Wasserstein距离方法减小源语言和目标语言分布距离,能够用于更稳定的超参数选择。鉴别器Q的损失函数表示如式(5)所示。

(5)

其中,hf表示源语言的综合表征,hf′表示目标语言的综合表征,θq表示语言鉴别器的参数。

2.2.5 情感分类

(6)

其中,W(l)∈Re,b∈Re是最后一个线性层的待训练参数。

最终模型的整体目标函数由鉴别器损失和情感分类器损失构成如式(7)所示。

(7)

其中,λ是平衡情感分类器P和鉴别器Q的超参数,θf表示语义特征编码器F,主题特征编码器T和选择门控机制G的参数,由θf参数化的F、T和Q力求最小化鉴别器损失和情感分类器损失。

2.2.6 模型训练

之前的研究发现,对抗训练时生成器和鉴别器的训练可能不完全同步[15],因此训练时先对鉴别器进行迭代训练,用来协调生成器和鉴别器的训练效果。训练鉴别器时利用梯度反转层[16]将其与生成器相连接,在反向传播的过程中利用超参数λ平衡P和Q对F、G和T的影响,让整个网络使用标准的反向传播进行完整训练。因此首先训练鉴别器Q,再对F、T、G和P进行训练,训练的完整伪代码如算法1所示。

算法1 训练过程输入:有标注的源语言语料Χsrc;无标注的目标语言语语料Χtgt;超参数:设置平衡参数λ>0,设置鉴别器Q迭代次数k∈NN;输出:源语言评论句和目标语言评论句的情感倾向y^s;1:forepochinEpochdo2:鉴别器Q训练迭代过程:3:forqiter=1tokdo4: 采样无标注的源语言批次数据xsrc~Χsrc5: hsrcf=G(F(xsrc),T(xsrc))6: htgtf=G(F(xtgt),T(xtgt)),得到源语言和目标语言语数据的特征向量7: lossq=-Q(hsrcf)+Q(htgtf),通过更新Q的参数来减小lossq8:end9:采样有标注的源语言批次数据(xsrc,ys)~Χsrc10:采样无标注的目标语言语批次数据xtgt~Χtgt11:hsrcf=G(F(xsrc),T(xsrc))12:htgtf=G(F(xtgt),T(xtgt)),得到源语言和目标语言语数据的特征向量13:y^s=p(hsrcf),得到源语言的情感预测标签14:loss=Lp(y^s,ys)+λlossq,ys为源语言的真实情感标签。通过更新F、T、G和P的参数来减小loss15:end

3 实验设置

3.1 数据集

为了证明实验的有效性,本文在中越实验数据 集上进行实验,验证情感分类的结果,通过爬虫技术 在twitter(2)https://twitter.com/home和新浪微博(3)https://weibo.com上爬取新冠疫情相关评论 作为实验数据。本文对收集到的中文评论数据集进行划分,选取5 000条标注评论用于训练情感分类器,选取1 000条标注评论进行验证。对收集到的越南语评论数据集进行划分,选取4 600条评论用于训练,选取1 200条标注评论用于验证和测试,越南语的训练数据用于对抗学习,不需要进行标注。数据集的具体信息如表1所示。

表1 中越实验数据集

为了验证融入主题信息模型的泛化能力,本文 同时在英中公开数据集上进行了实验验证,该实验 以英文作为源语言,中文作为目标语言,其中英文数据集由 Datafiniti(4)https://datafiniti.co/products/business-data/1 000家酒店的列表以及评论,使用评论数据并将评论星级4、5映射为情感极性积极,将星级1、2映射为情感极性消极。中文数据集使用酒店评论[17]。将英文作为源语言,中文作为目标语言,在目标语言上选择相同规模的数据进行验证和测试,该数据集的具体信息如表2所示。

表2 英中实验数据集

3.2 评价指标

与其他情感分类任务类似,本文的实验评价标准使用测试数据集上准确度A(Accuracy)、精确度P(Precision)、召回率R(Recall)和F1值的宏平均值结果作为评价指标,从而衡量模型的性能,如式(8)~式(11)所示。

其中,TP表示正类被正确预测,FP表示负类被错误预测,FN表示正类被错误预测,TN表示负类被正确预测。

3.3 对比模型

本文选取了以下6种模型作为基准模型,所有基准模型的训练集、验证集和测试集划分均与本文提出的模型一致。

LR(Logistic Regression): 是监督学习中经典的分类方法,以线性回归为理论支持,通过Sigmoid()函数引入了非线性因素,解决分类任务。使用源语言中文训练的基线模型,并仅依靠双语词嵌入对目标进行分类。

CNN(Convolutional Neural Networks)[18]: 采用 textCNN模型,使用源语言中文训练的基准模型,并仅依靠双语词嵌入对目标进行分类。设置卷积核大小为{3,4,5}。

LR+MT: 使用机器翻译的方式,首先将目标语言文本翻译成源语言,再利用逻辑回归模型对目标语言进行情感分类。

CNN+MT: 同样使用机器翻译的方式,将目标语言文本翻译成源语言,再利用CNN对目标语言进行情感分类。设置卷积核大小为{3,4,5}。

mSDA[19]: 采用基于Auto Encoder的方法,通过非线性降维,使得源域和目标域的数据分布在同一个子空间里面。设置去噪自编码器层数为3。

ADAN(Adversarial Deep Averaging Networks)[13]: 使用CNN作为特征编码器,利用对抗学习来弥合源语言和目标语言的差异,设置特征编码中使用的卷积核大小为{3,4,5},平衡超参λ为0.1,对抗迭代次数k=5。

3.4 参数设置

利用Adam优化器对F、P和T、G进行联合优化,用相同学习率的Adam优化器训练Q。实验使用xlmr[20]预训练模型获得两种语言的跨语言词嵌入向量,向量维度为1 024,使用dropout防止过拟合。模型训练30个批次后,在验证集上选择最佳模型。具体信息如表3所示。

表3 参数设置

4 实验结果分析

4.1 基线模型实验结果

表4列出了本文模型与基准模型在中越数据集上的对比结果。

表4 中越跨语言情感分类方法性能对比 (单位: %)

从表4实验结果可以看出,本文模型与其他基准模型相比有较大优势,具体分析如下:

(1)将本文模型与LR和CNN进行对比,可以看出本文模型结果的macroF1提升了大约18%,原因在于只使用双语词嵌入的方法尚不具备将中文评论中所含有的情感知识转移到越南语评论中的能力。

(2)对比LR、CNN和LR+MT、CNN+MT时,也可以看出LR+MT的结果要优于LR,macroF1提高了5%,原因是通过机器翻译的方式能够减小语义鸿沟。而在对比本文模型与LR+MT,CNN+MT时,可以看出本文模型要优于基于机器翻译的方法,macroF1值提高了7%,原因可能是翻译过程中丢失特定语言包含的语义特征。本文采用的对抗学习策略可以在不丢失特定语义特征情况下,实现两种语言情感表征在同一特征空间下的对齐。

(3)mSDA的结果在所有对比实验中效果最差,macroF1仅为50.22%,推测原因是这种基于词袋特征的方式不适用于跨语言的任务,两种语言具有完全不同的词汇表,使语言间的差异过大。

(4)分析本文模型与ADAN的结果,本文模型的macroF1提高了3.1%。通过分析认为,利用对抗学习能够缩小两种语言之间的语义差距,而对于描述同一事件的两种不同语言评论,本文方法能更好地学习到二者的对应关系,从而可以使分类性能得以提升。

为了验证模型的泛化能力,本文还进行了英中跨语言情感分类实验,结果如表5所示。

表5 英中跨语言情感分析方法性能对比 (单位: %)

根据表5的实验结果,可以验证本文模型在英文和中文数据集上同样适用,这表明本文模型在英中跨语言情感分类上也有较好的表现。

4.2 不同组件对情感分类结果的影响

为了验证本文模型组成结构中主题特征、门控机制和对抗学习三种不同组件对模型最终性能的影响,针对这三个部分进行实验验证。实验结果如表6所示。其中,our_model表示本文提出的模型;-topic module表示没有融入主题特征的模型;-gate module表示模型融入主题特征后,没有利用选择门控机制作为融合策略,而是将语义特征和主题特征直接拼接;-adversarial module表示模型没有进行对抗训练,直接将所得特征用于训练情感分类器。

表6 不同组件对情感分类结果的影响 (单位: %)

实验结果表明,-adversarial module的性能效果在四个方法中最差,说明在本文提出的模型中对抗训练的重要性,对抗训练模块使双语评论表征在情感特征空间下得到对齐,利用中文情感极性标签,实现对越南语情感极性的判别;再对比融入对抗训练模块后的几组模型,-topic module的性能要低于-gate module的性能,说明主题特征融入的有效性,能够丰富双语评论的情感特征;-gate module模型性能要低于本文提出的模型,说明选择门控机制进行特征融合,能够学习到更好的评论综合表征,最终提高情感分类的结果。

4.3 主题特征对语言鉴别结果的影响

为了验证融入主题特征的有效性,本文针对主题特征部分做进一步的验证,实验结果如图4所示。其中,“-topic”、“+topic”分别表示不包含主题特征、包含主题分布特征。

图4 语言鉴别loss对比

语言鉴别器的作用是实现源语言和目标语言的特征在同一空间下的对齐。从“-topic”曲线可以看到,语言鉴别损失在前25个批次较大,到第30批次时才有所减小。从“+topic”曲线上可以看到,前25个批次语言鉴别损失比“-topic”小,并且在25到30批次时,语言鉴别损失再次减小并趋于零。因此可以得出以下结论: 融入主题特征信息,可以更快缩小两种语言评论在特征空间下的距离。

4.4 主题数对情感分类结果的影响

主题数的大小决定了主题划分的粒度。本文针对主题数进行实验,观察不同的主题数对模型在中越数据集上的分类效果影响,如图5所示。

图5 不同主题数目下的性能比较

对折线图进行分析可以看出,当主题数小于15时,模型的macroF1变化处于上升趋势,在主题数为15时macroF1值达到最高,而当主题数大于15后,模型的macroF1值变化趋于稳定。因此根据实验分析的结果可以看出,主题的融入可以使得分类效果得到提升,并且当主题数为15时,模型在中越数据集上的性能最高。

4.5 不同主题表征的性能比较

利用主题模型可以得到评论的主题概率分布和主题词分布两种不同的特征。将式(1)中所使用的主题词嵌入平均池化替换为主题概率分布ht1∈RN,其中,N表示主题数,然后通过多层感知机进行线性变换,得到另一种主题表征ht′∈Rm,其中,m为隐层维度,如式(12)所示。

ht′=MLP(ht1)

(12)

本文测试了两种不同的主题表征方式对于模型性能的影响,实验结果如图6所示。

图6 不同主题表征的模型性能比较

对实验结果分析可得,利用主题概率分布和主题词分布均可以提升模型性能。对比两种主题表征方式,主题词分布的性能在不同主题数目时均优于主题概率分布,表明主题词分布的表征方式能更好解释不同主题的观点表述差异。

5 结论

以往的跨语言情感分类工作更多地关注于解决不同语言语义差异的问题,而忽略主题信息对于跨语言表征的作用。针对这一问题,本文提出一种融入主题特征的跨语言情感分类模型,利用门控机制有效地将主题表征与语义表征进行融合,并通过对抗学习将不同语言更好地映射至同一空间。通过实验验证了所提模型在中越跨语言情感分类上的有效性,同时证明主题词作为融入信息能更快拟合出语言分布差异。未来工作中,我们将进一步研究如何利用双语评论之间的对应关系,如评论中的观点对象等辅助跨语言情感分类任务。