基于心灵知觉理论的AI服务用户接受机制及使用促进策略*

邓士昌 许 祺 张晶晶 李象千

·研究构想(Conceptual Framework)·

基于心灵知觉理论的AI服务用户接受机制及使用促进策略*

邓士昌1许 祺1张晶晶1李象千2

(1上海对外经贸大学工商管理学院, 上海 201620) (2上海体育学院心理学院, 上海 200438)

许多企业采用人工智能服务应答顾客需求, 然而多项研究指出用户并不总是对此感到满意。本研究围绕着用户对AI的心灵知觉的产生和影响, 探索了驱动用户对AI服务态度的关键因素及使用促进策略, 包括(1)机理分析层面:用户与AI早期接触的线索和体验因素如何使得人们产生了AI“擅长计算却缺乏感受”的心灵知觉?(2)调节作用层面:不同的用户内部状态和AI外部特征怎样调节了这种心灵知觉的形成和激活?(3)促进策略层面:将AI拟动物化和提供技术援助为何能借助心灵知觉使得用户在更广泛的场景中接受来自AI的服务?本研究试图在学理层面构建一个基于心灵知觉理论的新型AI服务接受模型, 为从理论上解释用户对AI服务的矛盾态度提供心理学参考; 同时试图在实践层面上借助心灵知觉理论提出两种促进用户接受AI服务的路径方法, 为企业在服务中提升AI的应用效能提供技术参考。

人工智能, 心灵知觉, 客户服务, 刻板印象, 热情

1 问题提出

人工智能并非“万能钥匙”。不少消费者表示, 相比冷冰冰的智能客服, 能和真人客服直接沟通让人更踏实放心。“实在不知道智能客服是为了方便消费者解惑, 还是为了方便商家偷懒?”……“现在拨打客服电话, 最烦的就是听到机器人的声音, 只想说一句‘转人工’……”

——《智能客服成“标配” 用户体验参差不齐》《经济参考报》(2019年10月29日)

一切坚固的东西都烟消云散了, 人工智能(artificial intelligence, AI)的出现和发展打破了许多传统上被认为是牢不可破的界限。过去几年, 大数据、机器学习、自然语言处理和计算机视觉等关键技术融合到了一起, 将AI推向了更广泛的应用市场。服务是AI技术的主要应用场景之一, 越来越多的企业正在采用AI驱动的虚拟客服替代人工服务(安永, 2018)。然而, 用户喜欢被AI服务吗?答案是矛盾的。一方面, 许多用户认为AI简化了操作程序, 提升了服务效率(Kaplan & Haenlein, 2019); 另一方面, 不少用户也反感在服务中遇到AI, 认为真人客服更能理解自己的需求(Arm Treasure Data, 2019)。为何有时候用户接受AI服务, 有时候却又反感?是AI技术不够“智能”, 还是用户对AI心存偏见?这是一个当前服务管理中日趋凸显、亟待回答的理论和实践问题。

不得不承认, 当前AI技术远未成熟, 这是用户不愿意在大部分服务中遇到AI的重要原因(林子筠等, 2021)。然而, 多项研究指出, 即使AI表现得和人类一样出色, 用户依然有可能不喜欢来自AI的服务。例如, Luo等人(2019)发现, 虽然在电话销售中, AI推销员的表现可以与熟练员工不相上下, 但当用户得知电话那头是机器人时, 销售成功率会大大降低。Castelo等人(2019)认为, 用户对AI的反感并不完全是由于AI的技术表现不佳, 而是一些心理上的感知造成了用户并不总是喜欢与AI互动。经济参考报(2019)的采访也发现: “我反感智能客服, 并不是抵触技术进步, 而是当面对着理性得一丝不苟的人工智能时, 用户的情绪互动需求显然是被压抑的”。所以, 哪些因素驱动了用户对AI服务的态度?这不仅是一个AI技术层面上的问题, 更是一个用户心理层面上的问题。以此为逻辑起点, 本研究将从心灵知觉理论(mind perception theory)切入, 构建一个基于用户心灵知觉的AI服务态度模型, 并在此基础上提出促进用户接受AI服务的方法路径, 为提升AI服务的应用效能提供参考。

2 文献回顾与评述

2.1 AI在服务领域中的应用

尽管近年来有关AI的讨论在大众媒体和学术期刊上比比皆是, 但要准确界定AI“是什么”和“不是什么”却并不容易(Kaplan & Haenlein, 2019)。本研究采纳了Russell和Norvig (2016)的观点, 他们从类比人类智能的角度出发, 认为AI的主要目的是理解智能的本质, 并在此基础上通过机器学习、自然语言处理、知识表示和推理、计算机视觉等技术使得机器或程序能够集成并执行智能任务。换句话说, AI的目标是发展出智能体(agent), 让机器或程序能够以与人类相类似的方式做出反应。

现在, AI已经越来越多地被应用于服务中, 并被企业和学界视为服务创新的主要来源(徐鹏, 徐向艺, 2020)。本研究总结, 应用于服务中的AI可以被分为三类:(1)能够自动化地提供服务的虚拟员工。AI程序可以在很少或没有人为干预的情况下自动执行特定任务, 这使得AI驱动的虚拟员工可以全天候地满足客户需求。例如, 聊天机器人(chatbot)正在为英国国家健康医疗体系(NHS)的用户提供医疗咨询和建议(O’Hear, 2017); 淘宝、京东和携程等企业也大规模地采用了AI服务来响应用户需求(科技日报, 2021)。(2)能够预测顾客个性化需求的智能程序。人工智能可以从海量的客户数据中获取洞察力, 帮助企业创造与顾客日常生活自然相融合的体验, 从而提高顾客的服务满意度。例如, AIda爱搭公司的AI程序可以根据客户需求进行智能分析, 为顾客推荐适合他们个人风格和购买预算的服装产品(科学中国, 2020)。(3)能够发掘潜在商业机会的优化算法。AI驱动的客户分析算法可以对更庞大、更复杂的数据集合(文本、语音、图像等)进行分析, 探寻促使客户购买的驱动因素和阻碍因素。例如, Kanetix公司通过AI驱动的算法在保险推销前对客户进行筛选, 从而对那些更有可能购买保险的潜在客户加大推广力度(Davenport et al., 2020)。可见, 应用于服务中的AI既可以有一个物理表示(如迎宾机器人), 也可以是完全虚拟的算法。

2.2 影响用户对AI服务态度的主要因素

理论上说, AI可以使得服务更有效率(Huang & Rust, 2018, 2021), 但是市场调查表明, 一方面, 许多用户对苹果“Siri”、华为“小艺”等虚拟助手爱不释手(安永, 2018); 另一方面, 在医疗、销售和争议解决等服务中, 仅有不到五分之一的用户愿意遇到AI服务(Arm Treasure Data, 2019)。学术研究也取得了类似结果, Chi等人(2020)和Vlačić等人(2021)详细回顾了用户对AI服务态度的研究, 发现在服务中, 用户经常会对AI表现出不信任、不满意和不接受。

可见, 让用户接受AI服务并不是天然的事情, 许多因素影响了用户对AI服务的态度。大量研究对此话题进行了探索。最初, 研究者们沿用经典的技术接受模型(technology acceptance model, TAM或unified theory of acceptance and use of technology, UTAUT)讨论用户对AI的态度, 认为感知有用性、感知易用性等对AI的绩效预期, 以及使用AI时的努力预期、社会影响等个体内外因素决定了用户在任务中使用AI的意愿; 同时, 性别、年龄、使用经验等特征在其间起了调节作用(e.g., Go et al., 2020; Venkatesh, 2021)。然而, 有研究者指出将经典的TAM或UTAUT不加修改地应用到AI领域是有问题的(e.g., Flandorfer, 2012), 因为这些经典模型都是在十多年前的技术背景下开发的, 它们所探讨的那些“新”技术(如即时通讯、远程办公等)在变革性上远不能和AI相比。AI的许多应用涉及了可以达到人类水平的认知和情感能力, 换句话说, AI不仅仅可以辅助人类的工作, 而且有可能替代人类的工作, 而TAM和UTAUT所涉及到的任何一种技术都不是这样。因此, 用户对AI的态度问题要比TAM和UTAUT描述的复杂得多。

同感于此, 许多研究者针对AI的特点, 提出了新的理论模型以归纳影响用户与AI互动的关键因素。例如, 张雁冰等人(2019)从AI与人的相似性入手, 提出了AI的外观设计、交互方式、智能水平和情感能力这4个因素影响了用户与AI的交互, 使得用户对AI产生快乐、信任或恐惧等感知, 进而导致用户对AI服务出现愿意使用、拒绝使用等行为。Xiao和Kumar (2021)从企业对机器人技术的采纳程度(degree of robotics adoption, DRA)入手, 提出员工对机器人的接受(employee acceptance of robots, EAR)和用户对机器人的接受(customer acceptance of robots, CAR)联合影响了DRA。其中EAR受到企业特征、员工特征和机器人特征的影响, 而CAR受到用户特征的影响。Chi等人(2021)回顾并归纳了以往研究中发现的、可能影响用户对AI态度的11种因素, 并将它们分类为三类:(1)人们对机器人的信任倾向、(2)值得信赖的机器人功能与设计、(3)值得信赖的服务任务和情景, 这三类因素共同影响了用户对社会服务机器人的互动信任(social service robot interaction trust, SSRIT)。

不难看出, 上面这些理论模型都有着百年前构造主义心理学派的影子, 它们都强调分析影响用户对AI服务态度的主要“因素”, 有着元素论的倾向。本研究认为, 虽然新近的AI服务用户接受模型研究几乎囊括了所有可能影响用户对AI态度的因素(e.g., Chi et al., 2021; Xiao & Kumar, 2021), 然而上面这些研究尚存在两个方面的不足。第一, Makridakis (2017)提出, 大多数用户在接受或拒绝AI时并不持坚定立场, 在任务中, 用户对AI的支持和反对因素可能同时存在并相互作用。上面这些模型仅仅解释了影响用户接纳AI的要素, 但缺乏对这些要素之间是如何互动的描述, 更没有提炼出一般理论以解释用户对AI态度的动态性变化。第二, 这些模型大多鼓励AI“更像人”, 认为机能上的不足是阻碍人们采纳AI的核心原因。虽然AI与人的相似性的确很重要, 然而, 恐怖谷效应(the uncanny valley)的存在表明一味地增加AI的类人机能恐怕不是促进用户接受AI的黄金法则(Mende et al., 2019)。因此, 有必要找出更加“直击心灵”的方法, 多管齐下地改善用户对服务型AI的态度。

2.3 一个潜在的一般性理论:心灵知觉与用户对AI的矛盾性态度

相对于强调提高AI的类人水平(e.g., 张雁冰等, 2019)和提高人类对AI的信任(e.g., Chi et al., 2021)。Waytz和Norton (2014)提出了一个观点:人们也许在心灵层面上就认为AI不配与人类相提并论。本研究认为, 这是使得用户对AI服务呈现矛盾化态度的关键心理原因。心灵(mind)是人们将人类与其他非人实体区分开来的关键要素。Gray等人(2007)和Waytz等人(2010)发展出了心灵知觉(mind perception)理论, 阐述了人们将“心灵”归因于两个维度:能动性(agency, 分析和推理的能力)和感受性(experience, 体验和共情的能力), 如果人们感受到认知对象缺失了其中任一维度, 尤其是感受性维度, 则人们就会否认对方具有人性, 从而拒绝与对方平等互动。Waytz和Norton (2014)将心灵知觉理论应用到了人类与AI关系的研究中, 他们发现人们更接受AI从事需要“能力”的工作, 而不愿意接受AI从事需要“感受”的工作。作者们由此指出, 人们也许容忍AI在能动性(智能)上超过人类, 但却会保留“感受”作为一种独特的人类特质。Stein和Ohler (2017)进一步发现, 在聊天互动中, 如果人们察觉到正在表现出共情能力的对象是由算法操控的(而不是由人操控的), 则人们会经历认知失调, 表现出恶心、厌恶和反感(即恐怖谷反应)。

其他经验研究也响应了这一观点。Wang和Krumhuber (2018)通过4个实验研究发现, 虽然赋予AI社会价值(告诉被试AI可以陪伴孤独者)比赋予AI经济价值(告诉被试AI可以作为收银员)能增加人们对AI的情感性知觉, 但从绝对值看, 人们对AI的情感性知觉仍然远远低于对AI的认知性知觉(原文的Table1和2)。Longoni等人(2019)通过9个实验研究发现, 由于担心AI会忽视自己的独特性需求, 消费者往往不接受AI单独给出的医疗建议, 而只接受AI作为人类医生决策时的助手。Castelo等人(2019)通过4个实验室研究和两个实地研究, 发现由于消费者会认为智能算法缺乏执行主观任务所需的能力, 因此对于那些看起来更加主观(相对于客观)的任务, 人们更加不愿意使用智能算法。Wirtz等人(2018)的理论研究指出, 虽然情感计算(affective computing)等技术使得AI可以感知和回应人类情感, 但是人们往往不会对AI表达的情绪做出反应(例如很少看见人们与机器吵架), 这是因为在内心深处, 用户会认为AI的情绪是“被操控的”, 而不是“自发的”。由于人们不认为AI能拥有真正的情感, 因此用户会拒绝AI在情感−社交类任务中的深度应用。可见, 虽然AI技术一日千里, 当前的情感计算技术已经能使得AI感知和回应人类情感, 然而人们依然更倾向于将AI与“能动性”而不是“感受性”联系起来, 认为AI不适宜从事更需要“共情”的任务(例如照顾病人, Waytz & Norton, 2014)。

本研究认为, 心灵知觉理论为分析用户对AI的矛盾性态度提供了一个有说服力的理论框架。与上一节回顾过的“影响因素”类模型结合起来, 心灵知觉理论可以串联起影响用户接受AI服务的各种因素, 解释用户在不同的场景中对AI的态度。然而, 目前有关心灵知觉与AI的用户接受的研究成果相对零星, 缺乏系统整理, 而且还有可能存在跨文化问题。因此, 有必要在以往研究的基础上, 继续考察用户对AI的心灵知觉与各种其他因素如何联合影响了用户对AI的接受程度。

2.4 未来研究发展趋势

AI虽然能帮助企业降低服务成本, 但却未必能提高用户的服务满意度(Huang & Rust, 2018, 2021)。从文献回顾中可以看出, 其原因可能是由于心灵知觉的影响, 用户认为AI缺乏“感受”, 所以不愿意在情感−社交类服务中面对AI。在以往研究的基础上, 本研究拟就如下问题进行拓展:

第一, 用户认为AI“擅长计算却缺乏感受”的心灵知觉是怎么产生的?其影响用户对AI态度的心理过程又是怎样的?目前有关AI与心灵知觉的研究大多对此语焉不详, 认为用户对AI的心灵知觉是自然发生的(e.g., Castelo et al., 2019; Longoni et al., 2019; Wang & Krumhuber, 2018; Waytz & Norton, 2014)。而且, 虽然当前研究初步地描述了“现象”, 但是对其背后心理过程的讨论却并不充分。为何当用户感觉到AI缺乏“感受”时, 人们就会反感AI出现在情感类或主观性任务中?这种影响是跨文化的吗?对于这些问题, 当前的研究缺乏进一步探讨, 造成了理论的不深入和概念的肤浅。

第二, 是否有其他关键因素调节了用户对AI心灵知觉的形成和激活?以往采用心灵知觉理论探讨人类和AI关系的研究都相对静态, 认为“AI擅长计算却缺乏感受”的心灵知觉是人类对机器的固有认知。然而, 心灵知觉对AI服务接受意愿的影响可能并不绝对, 邓士昌等人(2020)的前期访谈就发现了不少例外情况。对于在心灵知觉作用时起了主要调节作用的关键因素, 现有研究普遍缺乏深入探讨, 这造成了对驱动用户接受或反感AI服务的关键因素理解不充分, 妨碍了一个整体性框架的提出。

第三, 如何借助心灵知觉理论, 使得用户在更广泛的场景中接受来自AI的服务?目前, 相关研究集中于描述用户“为什么”不喜欢AI服务, 可是基于心灵知觉理论、提出了如何才能促进用户在更广泛的服务场景中接受AI的研究却并不多见。Castelo等人(2019)发现可以增加任务的感知客观性以促进用户在主观任务中接受AI, 然而类似的促进策略仍然偏少。这阻碍了进一步提升用户对AI服务的接受程度和AI服务的应用效能。

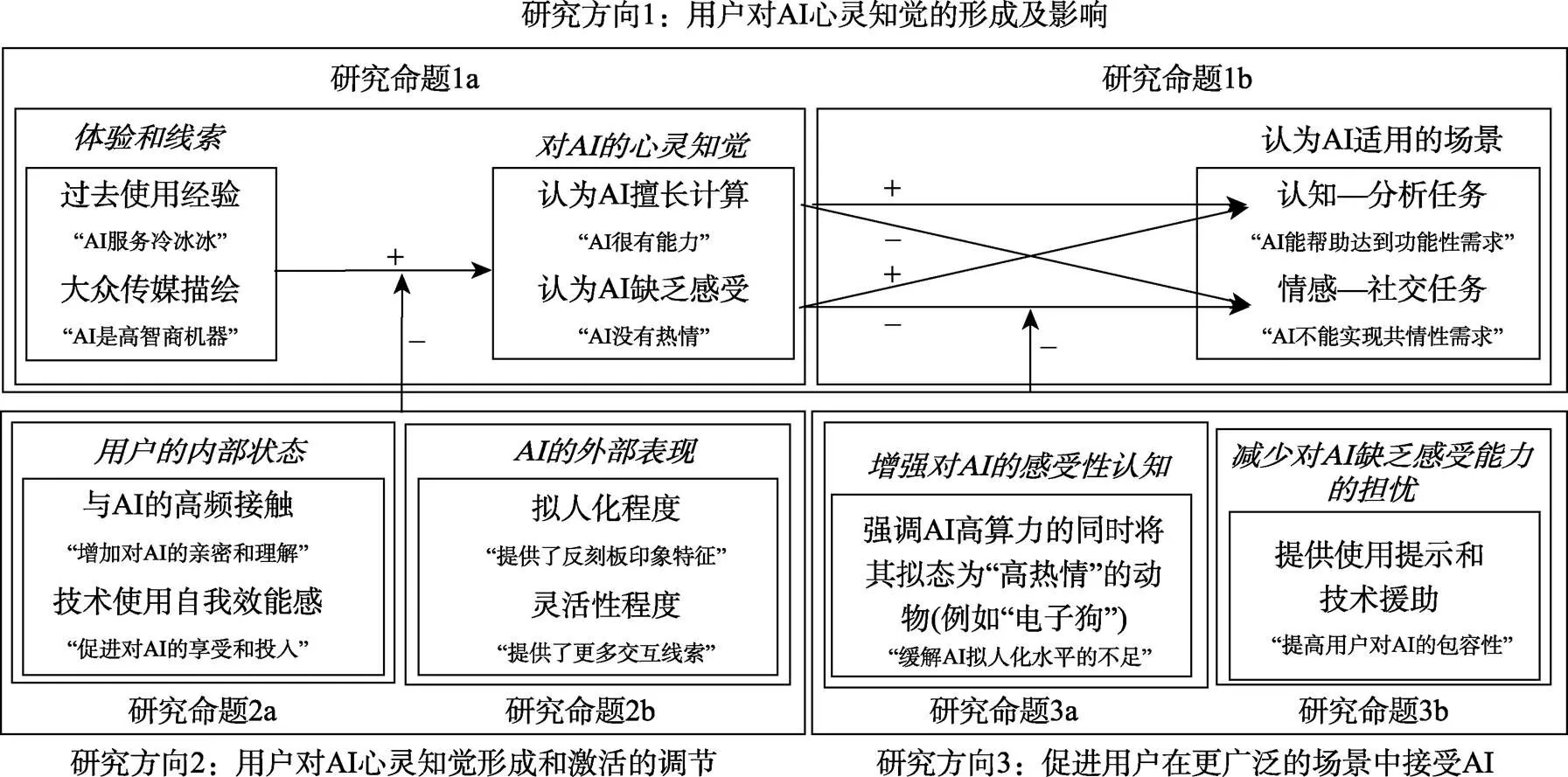

3 研究构想:用户对AI心灵知觉的形成、作用调节及使用意愿促进

如前所述, 从预订餐位到处理投诉, AI在服务上的功能日趋广泛, 然而用户却并不总是愿意接受来自AI的帮助。在此背景下, 本研究将关注点放在了用户接受AI服务的关键驱动因素及促进策略上。以心灵知觉理论为牵引, 本研究拟在三个逐渐递进的层面上展开探索:(1)机理分析层面:用户与AI早期接触的线索和体验因素如何使得人们产生了AI“擅长计算却缺乏感受”的心灵知觉?(2)调节作用层面:不同的用户内部状态和AI外部特征怎样调节了这种心灵知觉的形成和激活?(3)促进策略层面:将AI拟动物化和提供技术援助为何能借助心灵知觉使得用户在更广泛的场景中接受来自AI的服务?上面的研究构想可以总结为图1。

本研究采用了Wirtz等人(2018)的术语, 将服务场景分为认知−分析类(cognitive-analytical)和情感−社交类(emotional-social)。认知−分析类任务是客观的、常规且重复的、可预测的和与信息处理有关的, 例如在医疗诊断中分析复杂图像; 而情感−社交类任务是主观的、需要共情的、发散性的和要求创造性解决问题的, 例如安抚愤怒的顾客。这一分类被当前有关AI在服务领域中的应用的研究普遍采用。Waytz和Norton (2014), 以及Wang和Krumhuber (2018)将AI应用场景分为更强调能动和目的达成的认知类(cognition)和更强调共情和寻求温暖的情感类(emotion)。Huang和Rust (2018, 2021)按照AI技术发展的先后顺序, 将可应用于服务中的AI形态分为4类:机械的(mechanical)、分析的(analytical)、直觉的(intuitive)和共情的(empathetic)。其中, 前两类AI服务形态是涉及理性计算的、容易取代人类服务的; 而后两类AI服务形态是涉及情感共鸣的、较难取代人类服务的。Castelo等人(2019)将服务场景定义为客观(objective)和主观(subjective), 在他们的分类中, 客观任务涉及可量化和可测量的事实, 而主观任务涉及个人意见或直觉(gut instincts)。虽然Castelo等人(2019)的术语与Wirtz等人(2018)的术语在内涵上相差不远, 但Wirtz等人的术语更直白, 更契合心灵知觉理论中所描述的“能动性”和“感受性”二维度, 因此采用Wirtz等人的术语更易于理解。

图1 总体研究框架

3.1 研究方向1:用户对AI心灵知觉的形成及影响

如前所述, 诸多理论和实证研究都采用心灵知觉理论探讨了用户对AI服务的矛盾性态度, 认为由于人们更倾向于相信AI是算力强大的, 而不是富有情感的, 因此用户在更强调“认知−分析”的场景中会更接受AI, 而在更强调“情感−社交”的场景中更反感AI (e.g., Castelo et al., 2019; Wang & Krumhuber, 2018; Waytz & Norton, 2014; Wirtz et al., 2018)。可是, 目前很少有研究探索了人类对AI这种心灵知觉的来源。Shahid等人(2014)发现很多儿童会把AI当作“朋友”, 而且越年幼的孩子与AI互动越积极; Bylieva等人(2021)也发现儿童与AI语音助手的互动方式与成年人很不一样, 儿童会将AI当作真人, 采用礼貌口吻, 并询问一些私人问题。可见, 儿童在与AI互动时并没有表现出如成年人一般的对AI的心灵知觉。基于这些发现, 本研究将用户对AI的心灵知觉解释为一种刻板印象(stereotype), 并认为这种心灵知觉的出现最初只是无心之举, 但是随着用户与AI的不断互动而逐渐变得根深蒂固, 最终演化为认为AI擅长计算却不解人性的“人机之大防”。

3.1.1 研究方向1a:影响了用户形成对AI心灵知觉的体验和线索因素

Sundar (2008)提出, 在人与机器互动过程中, 各种各样的体验(experience)和线索(cues)促使了人们对机器刻板印象的形成。结合前期访谈(邓士昌等, 2020), 本研究提出两类最能影响用户对AI心灵知觉形成的体验和线索因素:(a)过去使用AI的经验(体验), 以及(b)大众媒体对AI的描绘(线索)。首先是“体验”因素。Wu和Wen (2021)的分析表明, 由于大多数用户并不熟悉AI的研发过程, 因此人们和AI的早期接触经验影响了他们对AI的态度。受到技术发展限制, AI在相当长一段时间内都只能在更需要“认知−分析”能力的场景中提供服务(例如提供自动订餐服务的语音助手), 而在需要“情感−社交”的服务中长期缺位。因此, 用户对于从事认知−分析任务的AI更为熟悉, 而对在情感−社交场景中提供服务的AI相对陌生。再加上早期AI服务的技术表现不佳, 经常出现答非所问的情况(中国青年报, 2019), 这自然使得用户产生了AI服务“冷冰冰、兜圈子”的刻板印象。

然后是“线索”因素。涵化理论(cultivation theory; Morgan et al., 2015)指出, 大众媒体创造的符号环境培养了最广泛的群体共同意识。无论中外, 许多文学、电影和游戏作品长期以来都将AI描述为高智能但缺乏情感的机器, 新闻媒体也往往将AI描述为力大无穷但不解人意的“铁疙瘩” (程林, 2020)。Sundar等人(2016)发现, 人们对AI服务的接受意愿很大程度上受到了大众媒体对AI形象描绘的影响。Banks (2020)也发现, 媒体中描绘的机器人形象促使了人们对AI形成一种“机器不通人情”的启发式态度。可见, 用户对AI“不能共情”的心灵知觉也在相当程度上受到了大众媒体对AI描绘的影响。

在Amiot和Bastian (2015)关于人与动物关系的心理学研究中, 作者认为人们会把自己(人类)的品质投射到非人实体上, 从而简化人们与动物的关系认知(例如绵羊是温顺的, 狐狸是狡黠的)。传统上, 只有动物在人们的认知中享有特权、获得人们更多的拟人化投射。但是, 随着AI拥有越来越多的人类智能, 人们也将这套社会感知工具迁移到了AI身上(Amershi, 2020)。本研究推测, 在过去使用AI的经验(体验)以及大众媒体对AI描绘(线索)的影响下, 用户对AI形成了一种“擅长计算却不能感知”的启发式思维捷径, 这反映了用户对AI表现的现有经验积累。基于上述推理, 本研究提出:

过去在情感−社交场景中使用AI受挫的经历和大众媒体对AI “高智商低情商”的描绘使得用户形成了AI擅长计算却缺乏感受的心灵知觉。

3.1.2 研究方向1b:对AI的心灵知觉影响了用户在不同场景中对AI的态度

研究命题1a推测, 用户对AI的心灵知觉实质上是一种受到体验和线索因素影响而形成的、对AI的刻板印象。著名的刻板印象内容模型(Stereotype Content Model; Fiske et al., 2002)定义了两种基本社会知觉, 即热情(warmth)和能力(competence)。热情知觉指感知到对方是友好、善良、真诚和温暖的, 而能力知觉指感知到对方是能干、胜任、自信和熟练的。在Gray等人(2007)和Waytz等人(2010)关于心灵知觉理论的阐述中, 作者们引用并承袭了刻板印象内容模型的观点, 认为对心灵或“人性”的能动性感知代表了社会知觉中的能力知觉, 而对心灵的感受性感知代表了热情知觉。可见, “用户认为AI擅长计算却缺乏感受”的心灵知觉, 可以理解为刻板印象内容模型中所描述的“高能力低热情”感知。

有关刻板印象内容模型的成熟研究指出, 对他人的“高能力低热情”感知会影响认知者对认知对象的态度。Cuddy等人(2011)指出, 对他人的热情感知与能力感知往往是不对称的, 热情感知代表了认知者是否认为他人怀有积极意图, 也即感知到他人是否是利他的、乐于助人的; 而能力感知代表了认知者是否认为他人有能力去实现这些意图。所以, 被置于“高能力低热情”感知的群体会受到认知者的模糊和矛盾判断。Oleszkiewicz和Lachowicz-Tabaczek (2016)的实证研究发现, 在工作场合中, 对同事的能力和热情感知影响了对他们的信任、喜爱和尊重。具体地, 对同事的信任会同时受到高能力和高热情感知的影响; 但是, 对同事的喜爱却是对他们高热情感知的结果, 而对同事的高能力感知仅仅影响了对他们的尊重。换言之, 人们只会对感知为“高能力高热情”的同事同时产生尊重和喜爱; 而对同事“高能力低热情”的感知会使得人们认为同事是值得尊重, 但不值得喜爱、以及在情感上不值得依赖的。Sevillano和Fiske (2016)关于人类对动物刻板印象的研究也指出, 虽然人类对感知到“高能力低热情”的那些动物(例如狮子、狼和熊)充满恐惧、尊崇和敬畏; 但从内心上, 人类更愿意与那些“高能力高热情”的动物(例如猫、狗和马)建立情感联系。Fiske (2018)的综述研究也发现, 人们通常对商人、官员、富人和专业技术人员持有“高能力低热情”感知, 其结果就是, 人们往往对这些群体持功利主义态度, 既希望能接近这些群体、利用这些群体的“高能力”; 同时也希望和这些群体保持情感距离、不愿意和他们保持共情。

可见, “用户认为AI擅长计算却缺乏感受”的心灵知觉使得人们认为AI是有能力的、可以被利用的; 但在情感上, 该心灵知觉使得人们并不认为AI是值得喜爱的、可以与之建立情感依赖关系的。Huang和Rust (2018, 2021)的理论研究指出, 在机械性的和分析性的服务中, 用户更看重服务提供者能否做到精确、连贯和有效率(例如准点接送的出租车司机); 但是在直觉性的和共情性的服务中, 用户更关注服务提供者能否理解自己的感受、体察自己的想法(例如同情患者的医生)。Wirtz等人(2018)也指出, 在“认知−分析”类服务场景中, 用户更关注功能性目标的达成, 但是在“情感−社交”类的服务场景, 用户会更关注共情性目标的达成(例如让服务人员理解自己的感受)。杨亚平等人(2019)发现, 在“高能力低热情”感知中, 如果一个群体的实际表现和大众对其持有的刻板印象一致(例如商人是有钱且贪婪的), 那该刻板印象的效应启动会更快、激活程度会更大。由于当前AI的共情技术尚不发达(Huang & Rust, 2021), 因此用户对AI“擅长计算却缺乏感受”的心灵知觉很容易被启动和放大。其结果就是, 由于用户对AI持高能力感知, 所以在主要寻求功能性价值的“认知−分析”类服务场景中, 用户可能会对AI有着更积极的态度, 认为AI的精确、连贯和有效率等机能更能帮助自己达到目的。但是, 由于用户对AI持低热情感知, 所以在主要寻求共情性价值的“情感−社交”类服务场景中, 用户往往会认为AI和自己“不是同类物种”, 从而主动和AI保持情感和社交距离, 不愿意与AI进行共情性的互动、情感交流和建立依赖关系。基于上述推理, 本研究提出:

AI擅长计算却缺乏感受的心灵知觉使得用户认为AI虽然有能力, 但并不值得在情感上被依赖和喜爱, 这使得用户只愿意在认知−分析类任务中使用AI达到功能性目的, 而不愿意在情感−社交类任务中与AI建立共情性联系。

3.2 研究方向2:调节了用户对AI心灵知觉形成和激活的关键因素

既然提出用户对AI“擅长计算却缺乏感受”的心灵知觉是一种刻板印象, 那就不得不考虑哪些因素调节了这种刻板印象的形成与激活, 也即刻板印象可塑性(stereotype malleability)问题。许多关于此问题的成熟综述研究(e.g., Blair, 2002; Bodenhausen & Macrae, 2013; Wheeler & Petty, 2001)都指出刻板印象的作用并非对所有人或在所有情况下都会自动发生, 它的形成与激活受到两大类因素的影响:认知者的内部状态(internal states)与认知对象的表现因素(external factors)。研究方向2将考察这两类因素对前述研究命题1a和1b的调节性影响。需要特别指出, 研究方向2并不能穷尽调节了用户对AI心灵知觉形成及激活的所有因素, 这样的列表将是无限长的。研究方向2的目的是在“刻板印象可塑性”的理论框架下重新考察过去研究中发现的、影响用户对AI态度的主要因素(e.g., Allan et al., 2021; Chi et al., 2021; Xiao & Kumar, 2021; 张雁冰等, 2019)。本研究拟将过去文献中发现的影响因素, 纳入到基于心灵知觉理论的AI服务用户接受模型中, 为今后进一步探明驱动用户接受AI服务的广泛因素提供来自心灵知觉理论的参考。

3.2.1 研究方向2a:与AI互动时的个体内部状态调节了对AI心灵知觉的形成

许多有关刻板印象可塑性的研究表明与个体长期或短期目标相冲突的刻板印象会在形成时会受到抑制, 例如, 致力于公平目标的个体有着较少的性别刻板印象(Moskowitz et al., 1999)。对比到本研究语境中, 本研究推测希望与AI建立“准友谊” (para-friendship)关系的个体可能更不容易形成AI“擅长计算却缺乏感受”的心灵知觉, 因为这种对AI的心灵知觉与这些个体的目标相悖。Ki等人(2020)使用“准友谊”这一术语来描述某些个体与AI语音助手的互动方式, 他们会和AI助手进行亲密交谈、分享自己内心的想法, 并且寻求AI助手的情感支持。虽然受到技术限制, 当前的AI助手并不能充分理解和准确回应这些人群的情感需求, 但对于惧怕与真人建立情感联系的“社恐”人群来说, AI为这些人提供了进行自我表露和寻求社会支持的绝佳对象, 因此与AI建立准友谊关系是一种理想的关系替代(Archer, 2021)。

Ki等人(2020)在研究中证实, 与AI互动时是否感觉到亲密(intimacy)、理解(understanding)、享受(enjoyability)和投入(involvement)是驱使个体是否愿意与AI建立准友谊关系的核心要素。本研究推测, 与AI接触频率更高的用户(high-frequency users)可能更容易在与AI互动时体验到亲密和理解, 从而更容易与AI形成准友谊关系, 进而更不容易形成AI“擅长计算却缺乏感受”的心灵知觉。Ramadan等人(2021)的研究表明, 在实际应用中, AI并不仅仅只是为用户提供了功利性好处, 还部分满足了用户的情感性需求, 其中, 更频繁的AI使用能促使用户对其产生特殊需求(例如请求Alexa语音助手为自己唱歌), 从而使得相当部分的高频AI用户希望AI能作为自己的朋友, 甚至是生活伴侣。Hermann (2021)的理论研究也指出, 如果消费者经常性、更密集、更频繁地与AI互动, 那AI就越有可能嵌入消费者的社会关系当中, 从而促使消费者与AI建立心灵和情感上的纽带; 而这种对AI的纽带和依恋反过来又使得消费者提高了使用AI的时间和互动频率, 导致消费者对AI出现友谊、依恋、甚至是爱。所以, 本研究假设, AI产品的高频用户更容易与AI建立准友谊关系, 而这种关系状态会降低用户认为AI“缺乏热情”的刻板印象, 进而影响他们对AI心灵知觉的形成。

本研究还推测, 技术使用自我效能感(technology use self-efficacy)较强的个体可能更容易在与AI的互动过程中体验到享受和投入, 从而增加这些个体与AI建立准友谊关系的可能性。大量研究表明较强的内部控制感会抑制刻板印象的形成(e.g., Gordijn et al., 2004), 而技术使用自我效能感可以引导这种与AI互动时的内部控制过程(Hatlevik et al., 2018)。技术使用自我效能感是一个人相信自己使用新技术的能力, 这种能力信念独立于其他自我效能感(Latikka et al., 2019)。Bandura (1997)认为较高的自我效能感提供了一种更强的内部控制感, 导致了对未来结果的积极感知。在此基础上, Xiao和Kumar (2021)提出, 由于技术使用自我效能感形成于对新技术的知识累积和积极经验, 因此这种自我效能感较高的个体通常认为自己更懂技术, 从而也就越愿意沉浸于探索和使用技术。Turja等人(2019)发现技术使用自我效能感较高的个体会对服务类AI会表现出更高的社会认可度, 这可能是因为这类个体在与AI互动时有着更强的控制感, 更能在与AI交互时体验到享受和投入。因此, 本研究认为较高的技术使用自我效能感能促进用户与AI建立准友谊关系, 从而削弱“AI不可感受”的心灵知觉的形成。基于上述推理, 本研究提出:

较高的AI使用频率和技术使用自我效能感使得个体更容易与AI建立准友谊关系, 这两个因素会抑制用户认为AI擅长计算却缺乏感受的心灵知觉的形成。

3.2.2 研究方向2b:AI的外部表现因素调节了用户对AI心灵知觉的激活

除了刻板印象的形成, 刻板印象可塑性研究同时也关注抑制了刻板印象发挥作用的认识对象外部表现因素。Blair (2002)的综述研究认为, 如果认知对象有着反刻板印象特征(counter-stereotypical features), 则认知者将出现更少的刻板印象反应。例如, Finnegan等人(2015)发现给被试呈现反性别刻板印象的图片(女性建筑工人或男性化妆师)能够抑制性别刻板印象的激活。基于这一逻辑, 本研究推测当人们接触“善解人意的AI”时, 他们以往受过去使用经验和大众传媒描绘而形成的、对AI的心灵知觉很有可能将受到抑制。这一构想可以用AI的拟人化(anthropomorphism)程度来阐述。拟人化是描述AI类人特征水平的术语, 这些类人特征不仅包括在外表上与人类相似, 还包括行为和情感上与人类相似(喻丰, 2020)。虽然恐怖谷效应使得AI拟人化与人类对AI态度颇有争议(喻丰, 许丽颖, 2020), 但总体而言, 许多研究支持人们更愿意与拟人化水平更高的AI接触。例如, 相比起拥有合成声音的社交机器人, 人们更信任拥有人类声音的社交机器人(Xu, 2019); 同时, 人们对拟人化水平更高的AI助手有着更近的心理距离(Li & Sung, 2021)。随着智能技术的发展, AI的拟人化水平越来越高, 因此本研究推测, 如果用户在与AI互动中接触到了更多的“反心灵知觉”的例子, 则他们“AI不能感知”的心灵知觉在激活时会受到抑制。

同时, 有关刻板印象可塑性的研究也认为改变认知对象的刺激线索配置(configuration of stimulus cues)能调节认知者的刻板印象激活。Macrae等人(1995)证明刺激线索的微小变化可以对人们的刻板印象激活产生很大影响。例如, 给被试呈现同一位中国女性, 但A组被试看到她在化妆, B组被试看到她在用筷子。虽然刺激对象都一样, 但是刺激线索的变化使得A组被试表现出了更多有关女性的刻板印象, 而B组被试表现出了更多有关中国人的刻板印象。对比到本研究语境中, AI在执行任务时的灵活性程度(flexibility)可能会使得用户对AI的感知线索发生转移。Wirtz等人(2018)的理论框架表明, 自助服务技术(self-service technology, SST)和AI服务的关键区别之一就是SST与用户的交互较少, 其要求用户必须按照特定流程操作, 否则将无法工作; 而AI在任务中可以与用户灵活互动, 可以引导用户完成任务流程, 容错率较高。Shin和Perdue (2019)的综述研究表明, 由于SST的灵活性较差, 因此用户往往把它视为工具, 对它采取居高临下态度, 在它出错时甚至会采取暴力行为(例如脚踢机器)。所以, 如果AI在执行任务时表现出了较多的SST特征, 则用户很有可能会将本应该具有高度灵活性的AI视为死板的SST, 从而激活“这玩意不通人性”的心灵知觉。基于上述推理, 本研究提出:

AI的拟人化程度和在任务中的灵活性程度影响了个体对AI的认知线索, 这两个因素会抑制用户认为AI擅长计算却缺乏感受的心灵知觉的激活。

3.3 研究方向3:借助心灵知觉促进用户在更广泛的服务场景中接受AI

就如同数年前的“扫码支付”一样, 本研究相信AI在服务中的广泛普及是不可逆转的未来趋势。然而, 上面的研究推理指出, 人们并不总是在所有场景中都接受AI服务。这一方面固然是由于当前的AI技术本身表现欠佳, 另一方面更是因为人们在心理层面上就对AI服务有所反感。研究方向1和研究方向2已经提出了一些改变用户“AI擅长计算但不解人意”的心灵知觉的途径, 但在现实中, 它们要么超出了企业的掌控范围(例如改变大众媒体对AI的描绘), 要么难以在短期内实现技术突破(例如增加AI的拟人化和灵活性水平)。因此, 有必要提出一些其他的、在当前环境中更具有操作性的认知策略, 以促进用户在更广泛的服务场景中接受AI。

本研究将用户对AI的心灵知觉解释为一种刻板印象, 它影响了用户与AI互动时对自己与AI关系的认知。因此, 在心灵知觉本身难以骤然改变的情况下, 可以从用户与AI的关系隐喻入手, 通过精巧地将AI“拟动物化”, 或是在用户使用AI时提供技术援助, 从而使得用户认为“缺乏感受”的AI也能在情感−社交类任务中发挥作用。

3.3.1 研究方向3a:将AI拟态为“高热情”的动物能增进用户对AI的感受性认知

Hoffman和Novak (2018)提出, 人们通常依照人类中心的拟人论(human-centric anthropomorphism)来理解自己与智能物品的关系。这是指人们从自己的角度出发, 将自己(人类)的品质推广到非人物品身上的过程。作者们与Kahneman的“快决策与慢决策”类比, 认为人类中心的拟人论是一种自动化的、经验性的、属于system 1的过程。Novak和Hoffman (2019)的理论框架表明, 人类中心的拟人论是用户与AI交互时的自然认知过程, 如果人们能将自己的一些“高热情”品质(如有亲和力)投射到智能物品上, 那将增强人们在与其互动时的延伸感, 从而改变认为“AI不能实现共情性需求”的固有认知。当前, 绝大多数AI研发和应用企业都致力于制造出尽可能像人类的AI。虽然这是AI技术的“圣杯” (Rubin, 2003), 但是目前的科技水平却很难达到, 只能创造出“似人非人”的AI。这使得人们在服务中与这类拟人AI互动时频频出现恐怖谷效应(Stein & Ohler, 2017)和补偿性反应(Mende et al., 2019)。因此, 在现有技术条件下, 让人类将自己的情感品质投射到AI上是很难实现的(Blut et al., 2021)。

本研究提出, 将AI拟态为具有高热情品质的动物, 可能会缓解当前AI “拟人化水平”不足的不利影响, 使得人们更自然地通过人类中心的拟人论将“高热情”品质投射在AI上。Sevillano和Fiske (2016)提出, 人类在与动物漫长的互动过程中建立了一套牢固的、跨文化的动物关系隐喻, 例如牛是耐劳的、狗是忠诚的。人类虽然认为动物低自己一等, 但并不妨碍人们将一些动物、特别是与人类亲近的动物视为“高热情”的。然而, 将服务中的AI拟态为具有高热情品质的动物存在着一个问题。Wirtz等人(2018)指出从事“情感−社交”任务并不意味着只需要高热情, 一定的认知−分析能力是从事情感−社交任务的前提。Huang和Rust (2018, 2021)也提出AI能提供的服务是按照机械的、分析的、直觉的和共情的顺序依次上升的, 也即“情感−社交”任务是一种更高级的服务类型。因此, 如果单纯地将AI拟态为动物, 未免会让人怀疑非人的动物是否具备解决“认知−分析”类任务的能力。

为了解决这一问题, 本研究推测, 将AI拟态为具有高热情品质的动物时需要辅以精巧的信息框架, 使得AI虽然在外表上被拟态为可亲近的动物, 但是其内核依然提醒用户正在面对的是“算力超群”的AI。这说起来复杂, 但并不难实现, “电子狗”就是一个简短而精巧的例子, 既强调了“电子”的强大分析能力, 又强调了“狗”的忠诚老实。Coghlan等人(2019)关于AI拟动物化的研究指出, 虽然受到技术限制, 当前不可能让机器人在外观上与真正的动物一模一样, 但是, 相较于“钢铁加电路”形态的传统机器人, 人们对拟态为动物的机器人仍然会有移情、怜悯、同情等情感反应。也就是说, 如果将AI拟态为动物, 虽然人们知道这是假的, 但是仍然会不由自主地对动物形态的AI产生部分移情。因此, 本研究提出, 借助人类对动物形态AI的这种部分移情, 可以引导用户认为当前在服务中出现的并不是蠢萌的动物本身, 而是有着动物般温情的高算力AI。于是要做到这一点, 就需要精心设计动物形态的AI在提供服务时的信息框架, 做到在将AI拟态为“高热情”动物的同时强调AI本身的高算力。在这方面, 网易云音乐的AI智能服务程序“西西”和“多多”就提供了一个生动的例子。在用户寻求帮助时, “西西”和“多多”会告诉用户:“我们是来自宇宙的驯鹿, 在人工智能的帮助下, 我们学会了人类的语言, 现在很高兴为您服务”。在这个例子中, 拟态为具有高热情品质动物的AI唤起了人们的温暖体验; 而在理性层面, “西西”和“多多”又告诉用户, 自己是认知−分析能力卓越的人工智能。如此, 借助人们对拟态为动物的AI的部分移情, 人们对AI的刻板印象得到了改变, 从而促进了用户在与AI互动时的感受性认知。基于上述推理, 本研究提出:

3a通过设计信息框架, 在展示AI强大算力的同时将其拟态为具有“高热情”品质的动物, 这样能调和“AI擅长计算但缺乏感受”的矛盾感, 促进用户对AI的感受性认知, 从而增进人们在情感−社交任务中使用AI的意愿。

3.3.2 研究方向3b:与AI互动时提供技术援助能减少用户对AI缺乏感受能力的担忧

当前, 绝大多数AI研发和应用企业都暗示“AI就是人类的化身, 它能做任何人类能做到的事情”。然而, Longoni等人(2019)发现, 由于消费者相信自己的状况具有特殊性, 而AI提供的服务是基于统计规律的、不能感知用户独特性的, 因此人们往往不愿意接受AI提供的医疗服务。这表明在很多时候, 人类并不把AI视为能独自决策的“人”。不过, Longoni等人(2019)也发现, 如果AI在医疗服务中不是独自决策, 而是仅仅为人类医生的决策提供支持, 则消费者对AI的抗拒将会减弱(Study 9)。这说明人们接受AI作为辅助人们决策的工具。因此, 本研究推测, 如果能引导用户从技术角度认识AI, 使得人们建立“AI是在辅助自己决策”的观念, 则有可能会增进用户对AI的包容性, 减少用户对AI缺乏感受性能力的担忧。

要做到这一点, 在用户与AI互动时提供相应的技术援助是必不可少的。许多研究表明, 在用户使用新技术时提供相应的便利条件(facilitating conditions)有诸多好处, 它可以减少用户与新技术互动时的认知成本, 并且让用户快速熟悉新技术的特性(e.g., Mahardika et al., 2019)。Weidemann和Rußwinkel (2021)的研究发现, 如果人机交互没有按人们预期进行, 则用户可能会出现挫折情绪, 拒绝与机器继续互动。然而, 如果能够在人机互动时提供相应的技术援助, 让人们在互动中的控制感提升, 则人们更有可能将自己视为人机互动中的主体, 增进对机器的包容性。据此, 本研究建议, 虽然与传统的自助式服务设备(如银行的ATM机)相比, AI具有高度灵活性, 但是企业也不应该骤然地将AI抛给用户、让用户自己探索, 而是需要提供一些技术援助, 帮助用户更有效率地与AI互动。例如, 可以在用户使用AI时提示“您面前的AI助手是由自然语言处理技术驱动的, 您可以正常地与它对话, 但请您语速慢些, 突出关键词”。如此, 用户就不会将AI视为“有完全决断能力的人”, 而是将AI视为能为自己决策提供支持的“助手”, 从而将自己视为互动中的主体, 降低对AI缺乏感受性能力的担忧。基于上述推理, 本研究提出:

在用户与AI互动时提供相应的使用提示与技术援助有助于构建AI与人类的联合互动模式, 减少用户对AI缺乏感受性能力的担忧, 增进人们在情感−社交任务中使用AI的意愿。

4 理论建构:用户对AI服务矛盾性态度的心理学探索

许多企业正在采用AI驱动的虚拟客服作为人工服务的补充, 它能帮助企业有效降低服务成本, 全天候地应对大量重复性问题。但从文献回顾中可以清楚看出, 用户并不总是对此持接受态度。采用新兴技术进行服务创新固然重要, 然而能否给顾客带来良好体验才是企业服务的核心竞争力。Becker和Jaakkola (2020)指出, 在服务中, 企业的最终目标应该是最大化地改善客户的服务体验, 而不仅仅是节省成本和优化流程。因此, 如何提高人们对AI服务的接受程度、提升AI服务的应用效能就成为了当前服务管理的迫切需求。本研究从用户对AI“能动性”和“感受性”两方面的知觉入手, 讨论了用户对AI心灵知觉的形成路径、影响这种心灵知觉激活的调节因素、以及促进用户在更广泛的场景中接受AI的策略。本研究希望在学理和实践两个层面建构理论, 从心理学角度解释用户对AI服务的矛盾性态度, 提升未来AI服务的应用效能。

4.1 学理层面:一个基于用户对AI心灵知觉的新型AI服务接受模型

本研究探讨了用户对AI心灵知觉的起源。虽然在客观上AI与人类互动的能力越来越强, 清华大学(清华大学新闻网, 2021)甚至迎来了第一位“AI虚拟学生”华智冰。然而, AI本身的技术表现是一回事, 用户的心理感受却是另一回事, 许多研究表明, 即使AI程序与人类的表现旗鼓相当, 人们在某些场景中还是更愿意被真人服务(e.g., Longoni et al., 2019; Luo et al., 2019; 张雁冰等, 2020)。过去一些研究认为用户这种“AI擅长计算但缺乏感受”的心灵知觉是自发形成的、是一种天然的“人性感知” (e.g., Castelo et al., 2019; Wang & Krumhuber, 2018; Waytz & Norton, 2014)。但是, 本研究推测用户对AI的心灵知觉是一种刻板印象, 它形成于用户与服务类AI的早期接触经验中; 甚至或许在用户接触AI之前, 人们就通过大众媒体对AI的描绘, 将AI理解成了“不通人情”的机器。这使得人们将AI视为一种完成任务的工具, 而不是陪伴身边的伙伴, 从而驱动人们在心理上并不希望与AI互动和交流, 阻碍了用户在情感−社交类型的服务场景中对AI持正面态度。

同时, 本研究探讨了哪些因素影响了用户对AI心灵知觉的形成和激活。近年来, 研究用户对AI服务接受意愿影响因素的文献快速增长, 研究者们发现的影响因素越来越多, Chi等人(2021)的文献甚至归纳11种之多的因素。无限地堆积影响因素显然是不可取的, 这样的列表将越来越长。本研究试图围绕着用户对AI心灵知觉的形成和激活, 重新审视影响用户对AI态度的关键因素。本研究借鉴了刻板印象可塑性的研究, 将过去研究中发现的、影响用户对AI态度的因素分为两类:用户的内部状态和AI的表现因素。参考有关刻板印象调节的理论, 本研究推测, 由于与AI的高频接触和技术使用效能感等内部状态促进了用户对AI产生准友谊关系, 而这与“AI不通人情”的刻板印象相冲突, 因此这些用户内部状态因素影响了对AI心灵知觉的形成。另一方面, 由于AI的拟人化和灵活性程度等外部表现提供了反刻板印象的样例, 因此这些AI外部表现因素影响了用户对AI心灵知觉的激活。

总体而言, 本研究试图通过心灵知觉理论建立起一个理论模型, 提供一个新的、归纳用户对AI服务态度的影响因素的动态框架, 避免今后类似研究的元素化倾向。

4.2 实践层面:两种促进用户在情感−社交场景中接受AI服务的方法路径

当前的AI技术正在变得更加成熟和先进, 部署费用也在逐渐降低, 因此在AI技术将给服务企业带来巨大优势的现实情境下, 越来越多的企业将在相当程度上采用AI服务替代人工服务。许多研究都认为使用AI技术辅助、甚至代替人力将是未来服务发展的必然趋势(王砚羽等, 2019)。可是, 对企业来说, 采用新技术进行服务创新固然重要, 然而能否给顾客带来良好体验才是服务的核心竞争力(Becker & Jaakkola, 2020)。在著名的SERVQUAL评价体系中, 共情性是衡量服务质量的重要维度, 然而当前的AI服务能否带来良好的共情体验?答案也许并不乐观。因此, 如何促进用户对AI服务的接受就成为了一个极具实践价值的问题。

本研究提出, 受到“AI擅长计算却缺乏感受”的心灵知觉的影响, 用户通常只愿意让AI服务“执行指令”, 却不愿意与AI服务“互动交流”, 这使得用户在情感−社交类服务场景中对AI的接受度很差。虽然目前不少企业认识到了需要改善AI “冷冰冰”的形象, 并试图通过情感计算技术使得AI程序更有“情商” (例如京东的AI客服“JIMI”)。然而机器人表达的问候和道歉并不是真正的问候和道歉, 实证研究表明, 当用户察觉到AI程序试图模仿人类反应时, 用户可能会对其更加反感(Stein & Ohler, 2017)。可见, 让“AI更像人”的拟人化方向也许存在问题。喻丰和许丽颖(2020)指出拟人化的概念是多元化的, 因此本研究推测将AI拟态为具有“高热情”品质的动物而非人类, 这也许是一种更好的AI拟人化方向。人类对动物建立的关系隐喻十分牢固且抽象(Amiot & Bastian, 2015; Sevillano & Fiske, 2016), 因此, 借助高热情的动物形象, 人们能更自然地建立与AI的关系隐喻(Coghlan et al., 2019), 增加对AI感受性能力的认知, 进而愿意在情感−社交场景中接受AI的服务。

将AI拟态为人类还有一个问题, 即企业默认既然AI是“人”, 那用户与AI交流就是一件自然的事情, AI可以替代人类做出决策。然而, 心灵知觉理论指出由于人们认为AI缺乏感受, 因此用户往往不将AI视为人, 从而在与AI的互动中感受到了约束。通过文献推理, 本研究认为, 企业需要在用户与AI的互动中提供技术支援, 从而促进用户从“助手”角度看待AI, 建立人类与AI的联合互动模式。即让用户成为与AI互动中的主体、让AI成为互动中的辅助者和选项提供者。这样做能顺应用户对AI的心灵知觉, 提高用户对AI的包容性, 减少用户对AI缺乏感受能力的担忧, 进而降低用户与AI互动时的约束感, 增进用户在情感−社交场景中接受AI服务的意愿。

总之, 本研究试图借助用户对AI的心灵知觉, 通过建议将AI拟态为高热情的动物而不是真人, 以实现更好的AI拟人化; 以及建议在用户使用AI时提供技术援助以提高用户对AI的包容性, 从而促进用户在更广泛的服务场景中接受AI。本研究希望为企业在服务中提高用户对AI的满意度、提升AI服务的应用效能提供具有实践性的路径参考。

安永. (2018).. https://assets.ey.com/content/ dam/ey-sites/ey-com/en_gl/topics/insurance/insurance-pdfs/ey-chatbot-pov.pdf

程林. (2020). 奴仆、镜像与它者: 西方早期类人机器人想象., (7), 107–112.

邓士昌, 田芊, 林晓祥. (2020). 客户服务中人工智能情感胜任力模型和测量指标构建.,(4), 100–110. https://doi.org/10.16060/j.cnki.issn2095- 8072.2020.04.009

经济参考报. (2019).. http://www.xinhuanet.com/money/2019-10/29/ c_1210331478.htm

科技日报. (2021). 人工智能:把根扎牢才能遍地开花. http://digitalpaper.stdaily.com/http_www.kjrb.com/kjrb/html/2021-03/05/content_463602.htm?div=-1

科学中国. (2020).. http://science.china.com.cn/2020-11/23/ content_41368614.htm

林子筠, 吴琼琳, 才凤艳. (2021). 营销领域人工智能研究综述.,(3), 89–106. https://doi.org/10. 16538/j.cnki.fem.20200805.301

清华大学新闻网. (2021). 清华大学迎来国内首个原创虚拟学生“华智冰.” https://www.tsinghua.edu.cn/info/1175/ 84993.htm

王砚羽, 苏欣, 谢伟. (2019). 商业模式采纳与融合:“人工智能+”赋能下的零售企业多案例研究.,(7), 186–198. https://doi.org/10.14120/j.cnki.cn11-5057/f.2019.07.020

徐鹏, 徐向艺. (2020). 人工智能时代企业管理变革的逻辑与分析框架.,(1), 122–129. https://doi.org/ 10.19744/j.cnki.11-1235/f.2020.0010

杨亚平, 徐强, 朱婷婷, 郑旭涛, 董晓晔, 陈庆伟. (2019). 不同热情-能力社会群体刻板印象激活效应的行为模式:基于刻板印象内容模型.,(10), 1143–1156. https://doi.org/10.3724/SP.J.1041.2019.01143

喻丰. (2020). 论人工智能与人之为人., (1), 30–36. https://doi.org/10.16619/j.cnki.rmltxsqy.2020. 01.003

喻丰, 许丽颖. (2020). 人工智能之拟人化.,(5), 52–60. https://doi.org/10.16783/j. cnki.nwnus.2020.05.007

张雁冰, 方雪, 吕巍. (2020). 人工智能语音助手智能程度对消费者使用意愿的影响研究.,(4), 11–15.

张雁冰, 吕巍, 张佳宇. (2019). AI营销研究的挑战和展望.,(5), 75–86.

中国青年报. (2019).http://www.xinhuanet.com/politics/2019-12/05/ c_1125310047.htm

Allan, D. D., Vonasch, A. J., & Bartneck, C. (2021). The doors of social robot perception: the influence of implicit self-theories.. https://doi.org/10.1007/s12369-021-00767-9

Amershi, B. (2020). Culture, the process of knowledge, perception of the world and emergence of AI.,(2), 417–430. https://doi.org/10.1007/s00146-019-00885-z

Amiot, C. E., & Bastian, B. (2015). Toward a psychology of human–animal relations.,(1), 6–47. https://doi.org/10.1037/a0038147

Archer, M. S. (2021). Friendship between human beings and ai robots? In J. von Braun, M. S. Archer, G. M. Reichberg, & M. S. Sorondo (Eds.),(pp. 177–189). Springer International Publishing. https://doi.org/ 10.1007/978-3-030-54173-6_15

Arm Treasure Data. (2019).. https:// www.treasuredata.com/resources/ai-vs-human-customer-service-consumer-preferences/

Bandura, A. (1997).. New York: W. H. Freeman. https://psycnet.apa.org/record/ 1997-08589-000

Banks, J. (2020). Optimus primed: Media cultivation of robot mental models and social judgments.,. https://doi.org/10.3389/frobt.2020.00062

Becker, L., & Jaakkola, E. (2020). Customer experience: fundamental premises and implications for research.,630– 648. https://doi.org/10.1007/s11747-019-00718-x

Blair, I. V. (2002). The malleability of automatic stereotypes and prejudice.,(3), 242–261. https://doi.org/10.1207/S15327957PSPR0603_8

Blut, M., Wang, C., Wünderlich, N. V., & Brock, C. (2021). Understanding anthropomorphism in service provision: a meta-analysis of physical robots, chatbots, and other AI., 632–658. https://doi.org/10.1007/s11747-020-00762-y

Bodenhausen, G. V, & Macrae, C. N. (2013). Stereotype activation and inhibition. In J. Wyer (Ed.),. Psychology Press. https://doi. org/10.4324/9780203763650

Bylieva, D., Bekirogullari, Z., Lobatyuk, V., & Nam, T. (2021). How virtual personal assistants influence children’scommunication. In D. Bylieva, A. Nordmann, O. Shipunova, & V. Volkova (Eds.),(pp. 112–124). Springer International Publishing. https://doi.org/10.1007/978-3-030-65857-1_12

Castelo, N., Bos, M. W., & Lehmann, D. R. (2019). Task-Dependent algorithm aversion.,(5), 809–825. https://doi.org/10.1177/0022243719851788

Chi, O. H., Denton, G., & Gursoy, D. (2020). Artificially intelligent device use in service delivery: A systematic review, synthesis, and research agenda.,(7), 757–786. https://doi.org/ 10.1080/19368623.2020.1721394

Chi, O. H., Jia, S., Li, Y., & Gursoy, D. (2021). Developing a formative scale to measure consumers’ trust toward interaction with artificially intelligent (AI) social robots in service delivery.,(May 2020), 106700. https://doi.org/10.1016/j.chb.2021.106700

Coghlan, S., Vetere, F., Waycott, J., & Barbosa Neves, B. (2019). Could social robots make us kinder or crueller to humans and animals?,(5), 741–751. https://doi.org/10.1007/s12369- 019-00583-2

Cuddy, A. J. C., Glick, P., & Beninger, A. (2011). The dynamics of warmth and competence judgments, and their outcomes in organizations.,, 73–98. https://doi.org/10.1016/j.riob.2011.10.004

Davenport, T., Guha, A., Grewal, D., & Bressgott, T. (2020). How artificial intelligence will change the future of marketing.,(1), 24–42. https://doi.org/10.1007/s11747-019-00696-0

Finnegan, E., Oakhill, J., & Garnham, A. (2015). Counter- stereotypical pictures as a strategy for overcoming spontaneous gender stereotypes.,. https://doi.org/10.3389/fpsyg.2015.01291

Fiske, S. T. (2018). Stereotype content: Warmth and competence endure.,(2), 67–73. https://doi.org/10.1177/0963721417738825

Fiske, S. T., Cuddy, A. J. C., Glick, P., & Xu, J. (2002). A model of (often mixed) stereotype content: Competence and warmth respectively follow from perceived status and competition.,(6), 878–902. https://doi.org/10.1037/0022-3514.82.6.878

Flandorfer, P. (2012). Population ageing and socially assistive robots for elderly persons: The importance of sociodemographic factors for user acceptance.,, 1–13. https://doi.org/10. 1155/2012/829835

Go, H., Kang, M., & Suh, S. C. (2020). Machine learning of robots in tourism and hospitality: interactive technology acceptance model (iTAM) – cutting edge.,(4), 625–636. https://doi.org/10.1108/TR-02-2019-0062

Gordijn, E. H., Hindriks, I., Koomen, W., Dijksterhuis, A., & van Knippenberg, A. (2004). Consequences of stereotype suppression and internal suppression motivation: A self- regulation approach.,(2), 212–224. https://doi.org/10.1177/014616720325 9935

Gray, H. M., Gray, K., & Wegner, D. M. (2007). Dimensions of mind perception.,(5812), 619–619. https:// doi.org/10.1126/science.1134475

Hatlevik, O. E., Throndsen, I., Loi, M., & Gudmundsdottir, G. B. (2018). Students’ ICT self-efficacy and computer and information literacy: Determinants and relationships.,, 107–119. https://doi.org/ 10.1016/j.compedu.2017.11.011

Hermann, E. (2021). Anthropomorphized artificial intelligence, attachment, and consumer behavior.. https://doi.org/10.1007/s11002-021-09587-3

Hoffman, D. L., & Novak, T. P. (2018). Consumer and object experience in the internet of things: An assemblage theory approach.,(6), 1178–1204. https://doi.org/10.1093/jcr/ucx105

Huang, M.-H., & Rust, R. T. (2018). Artificial intelligence in service.,(2), 155–172. https://doi.org/10.1177/1094670517752459

Huang, M.-H., & Rust, R. T. (2021). Engaged to a robot? The role of ai in service.,(1), 30–41. https://doi.org/10.1177/1094670520902266

Kaplan, A., & Haenlein, M. (2019). Siri, Siri, in my hand: Who’s the fairest in the land? On the interpretations, illustrations, and implications of artificial intelligence.,(1), 15–25. https://doi.org/10.1016/ j.bushor.2018.08.004

Ki, C.-W. (Chloe), Cho, E., & Lee, J.-E. (2020). Can an intelligent personal assistant (IPA) be your friend? Para- friendship development mechanism between IPAs and their users.,, 106412. https://doi.org/10.1016/j.chb.2020.106412

Latikka, R., Turja, T., & Oksanen, A. (2019). Self-efficacy and acceptance of robots.,, 157–163. https://doi.org/10.1016/j.chb.2018.12.017

Li, X., & Sung, Y. (2021). Anthropomorphism brings us closer: The mediating role of psychological distance in User–AI assistant interactions.,, 106680. https://doi.org/10.1016/j.chb.2021. 106680

Longoni, C., Bonezzi, A., & Morewedge, C. K. (2019). Resistance to medical artificial intelligence.,(4), 629–650. https://doi.org/10. 1093/jcr/ucz013

Luo, X., Tong, S., Fang, Z., & Qu, Z. (2019). Frontiers: Machines vs. humans: The impact of artificial intelligence chatbot disclosure on customer purchases.,(6), 937–947. https://doi.org/10.1287/mksc.2019.1192

Macrae, C. N., Bodenhausen, G. V., & Milne, A. B. (1995). The dissection of selection in person perception: Inhibitory processes in social stereotyping.,(3), 397–407. https://doi.org/10. 1037/0022-3514.69.3.397

Mahardika, H., Thomas, D., Ewing, M. T., & Japutra, A. (2019). Experience and facilitating conditions as impediments to consumers’ new technology adoption.,(1), 79–98. https://doi.org/10.1080/09593969.2018.1556181

Makridakis, S. (2017). The forthcoming artificial intelligence (AI) revolution: Its impact on society and firms.,, 46–60. https://doi.org/10.1016/j.futures.2017.03.006

Mende, M., Scott, M. L., van Doorn, J., Grewal, D., & Shanks, I. (2019). Service robots rising: how humanoid robots influence service experiences and elicit compensatory consumer responses.,(4), 535–556. https://doi.org/10.1177/0022243718822827

Morgan, M., Shanahan, J., & Signorielli, N. (2015). Yesterday’snew cultivation, tomorrow.,(5), 674–699. https://doi.org/10.1080/15205436.2015.1072725

Moskowitz, G. B., Gollwitzer, P. M., Wasel, W., & Schaal, B. (1999). Preconscious control of stereotype activation through chronic egalitarian goals.,(1), 167–184. https://doi.org/10. 1037/0022-3514.77.1.167

Novak, T. P., & Hoffman, D. L. (2019). Relationship journeys in the internet of things: a new framework for understanding interactions between consumers and smart objects.,(2), 216–237. https://doi.org/10.1007/s11747-018-0608-3

O’Hear, S. (2017).. TechCrunch.

Oleszkiewicz, A., & Lachowicz-Tabaczek, K. (2016). Perceived competence and warmth influence respect, liking and trust in work relations.,(4), 431–435. https://doi.org/10.1515/ppb-2016-0050

Ramadan, Z., Farah, M., & El Essrawi, L. (2021). From Amazon.com to Amazon.love: How Alexa is redefining companionship and interdependence for people with special needs.,(4), 596–609. https:// doi.org/10.1002/mar.21441

Rubin, C. T. (2003).. The New Atlantis. https://www.thenewatlantis.com/publications/ artificial-intelligence-and-human-nature

Russell, S., & Norvig, P. (2016).(3rd ed.). Pearson Education Limited.

Sevillano, V., & Fiske, S. T. (2016). Animals as social objects: groups, stereotypes, and intergroup threats.,(3), 206–217. https://doi.org/10.1027/1016- 9040/a000268

Shahid, S., Krahmer, E., & Swerts, M. (2014). Child–robot interaction across cultures: How does playing a game with a social robot compare to playing a game alone or with a friend?,, 86–100. https:// doi.org/10.1016/j.chb.2014.07.043

Shin, H., & Perdue, R. R. (2019). Self-service technology research: A bibliometric co-citation visualization analysis.,, 101–112. https://doi.org/10.1016/j.ijhm.2019.01.012

Stein, J.-P., & Ohler, P. (2017). Venturing into the uncanny valley of mind—The influence of mind attribution on the acceptance of human-like characters in a virtual reality setting.,, 43–50. https://doi.org/10.1016/j. cognition.2016.12.010

Sundar, S. (2008). The MAIN model: A heuristic approach to understanding technology effects on credibility. In M. J. Metzger & A. J. Flanagin (Eds.),(pp. 73–100). The MIT Press.

Sundar, S. S., Waddell, T. F., & Jung, E. H. (2016).. 2016 11th ACM/IEEE International Conference on Human- Robot Interaction (HRI) (pp.343–350). https://doi.org/ 10.1109/HRI.2016.7451771

Turja, T., Rantanen, T., & Oksanen, A. (2019). Robot use self-efficacy in healthcare work (RUSH): development and validation of a new measure.,(1), 137–143. https://doi.org/10.1007/s00146-017-0751-2

Venkatesh, V. (2021). Adoption and use of AI tools: a research agenda grounded in UTAUT.. https://doi.org/10.1007/s10479-020-03918-9

Vlačić, B., Corbo, L., Costa e Silva, S., & Dabić, M. (2021). The evolving role of artificial intelligence in marketing: A review and research agenda.,, 187–203. https://doi.org/10.1016/j.jbusres.2021.01.055

Wang, X., & Krumhuber, E. G. (2018). Mind perception of robots varies with their economic versus social function.,. https://doi.org/10.3389/fpsyg. 2018.01230

Waytz, A., Gray, K., Epley, N., & Wegner, D. M. (2010). Causes and consequences of mind perception.,(8), 383–388. https://doi.org/10. 1016/j.tics.2010.05.006

Waytz, A., & Norton, M. I. (2014). Botsourcing and outsourcing: Robot, British, Chinese, and German workers are for thinking- not feeling-jobs.,(2), 434–444. https://doi.org/ 10.1037/a0036054

Weidemann, A., & Rußwinkel, N. (2021). The role of frustration in human–robot interaction – what is needed for a successful collaboration?,. https://doi.org/10.3389/fpsyg.2021.640186

Wheeler, S. C., & Petty, R. E. (2001). The effects of stereotype activation on behavior: A review of possible mechanisms.,(6), 797–826. https://doi.org/ 10.1037/0033-2909.127.6.797

Wirtz, J., Patterson, P. G., Kunz, W. H., Gruber, T., Lu, V. N., Paluch, S., & Martins, A. (2018). Brave new world: service robots in the frontline.,(5), 907–931. https://doi.org/10.1108/ JOSM-04-2018-0119

Wu, L., & Wen, T. J. (2021). Understanding AI advertising from the consumer perspective.,, JAR-2021-004. https://doi.org/10.2501/ jar-2021-004

Xiao, L., & Kumar, V. (2021). Robotics for customer service: a useful complement or an ultimate substitute?,(1), 9–29. https://doi.org/10.1177/ 1094670519878881

Xu, K. (2019). First encounter with robot Alpha: How individual differences interact with vocal and kinetic cues in users’ social responses.,(11–12), 2522–2547. https://doi.org/10.1177/1461444819851479

User acceptance mechanism and usage promotion strategy of AI services based on mind perception theory

DENG Shichang1, XU Qi1, ZHANG Jingjing1, LI Xiangqian2

(1Management School, Shanghai University of International Business and Economics, Shanghai 201620, China)(2School of Psychology, Shanghai University of Sports, Shanghai 200438, China)

Many enterprises have adopted AI services to respond to customer needs, yet several studies indicate that users are not always satisfied with AI in service. This study explores the key factors that drive users᾽ attitudes toward AI services and usage promotion strategies based on the generation and influence of users᾽ mind perceptions of AI, which including (1) Mechanism analysis: How do the cues and experiential factors of users᾽ early contact with AI lead to the perception that AI is “good at computing but not feeling”? (2) Moderating effects: How do different internal user states and external AI features moderate the formation and activation of this mind perception toward AI? (3) Facilitation strategies: With the reverse utilization of mind perception, how can the mimicry of AI as warmth animals and the provision of technical assistance enable users to accept services from AI in a wider range of scenarios? This study attempts to construct a new model of AI service acceptance based on the theory of mind perception at the theoretical level and provide a psychological reference for theoretically explaining users᾽ ambivalent attitudes toward AI services. At the practical level, this study attempts to propose two pathways to facilitate users' acceptance of AI services with the help of mind perception theory and provide a technical reference for enterprises to enhance the effectiveness of AI applications in their service processes.

artificial intelligence, mind perception, customer service, stereotype, warmth

2021-02-02

*国家自然科学基金项目(72002123); 教育部人文社会科学研究项目(19YJC630027)资助。

李象千, E-mail: 2070164L@gmail.com

B849