全色/多光谱融合影像的MVG无参考质量评价

包科迪,孟祥超,邵枫,叶蒙梦,金康俊,彭振宇

宁波大学信息科学与工程学院,宁波 315211

1 引 言

受卫星传感器成像系统限制,获取影像在高空间分辨率和高光谱分辨率方面互相制约而不可兼得,如多数国内外卫星同时提供全色影像(高空间分辨率,单波段)和多光谱影像(低空间分辨率,多波段),全色/多光谱影像融合(Pansharpening)可“以软补硬”,集成全色影像和多光谱影像的空、谱互补优势,生成高空间分辨率的多光谱影像。目前已提出大量全色/多光谱融合算法(张良培和沈焕锋,2016),如成分替代类融合方法、基于多分辨率分析融合方法、基于模型优化融合方法、以及基于深度学习融合方法等。然而,由于无真实高空间分辨率多光谱影像,如何有效评价融合影像质量,以及各融合方法的性能具有一定的挑战(Vivone等,2018)。

目前,全色/多光谱融合影像的质量评价主要包括全参考评价(模拟数据)和无参考评价。其中,全参考评价基于Wald 准则(Wald 等,1997),首先,将原始全色和多光谱影像以其空间分辨率比率分别进行空间降采样,然后,对降采样后的全色、多光谱影像进行融合,最后,以原始多光谱影像为参考影像对融合影像进行质量评价。常用评价指标包括光谱角SAM(Spectral Angle Mapper)(Yuhas 等,1992)、全局相对误差ERGAS(Erreur Relative Globale Adimensionn elle de Synthèse)(Wald,2000)、通用影像质量指数UIQI(Universal Image Quality Index)(Wang 和Bovik,2002)、Q4(Alparone 等,2004)、以及Q4 在高维影像上的拓展指数Q2n(Garzelli 和Nencini,2009)、结构相似性指标SSIM(Structural Similarity)(Wang 等,2004)等。相比于全参考评价,无参考质量评价更符合实际情况,也更具有现实意义,并于近年来引起广泛关注。目前,全色/多光谱融合影像的无参考质量评价方法主要包括两种策略:(1)由于无真实高空间分辨率多光谱影像,在光谱保真度评价方面,将融合影像空间维降采样至原始多光谱影像空间维度大小,以原始多光谱影像为光谱参考;或将原始多光谱影像上采样至融合影像空间维度大小(韩鹏等,2008),以上采样多光谱影像为光谱参考,采用ERGAS、SAM 等全参考评价指标对融合影像进行光谱保真度的评价;在空间评价方面,以全色影像为参考,采用空间评价指标SPCC(Sales 等,2013)对融合影像进行空间质量评价,或采用信息熵、平均梯度等无参考评价指标进行空间质量评价。(2)发展无参考质量评价指标,目前,全色/多光谱融合影像的无参考质量评价指标提出较少,其中,Alparone 等(2008)提出了QNR(Quality with No Reference),其考虑了光谱和空间两方面的失真,通过比较融合前后影像与全色影像的空间相似性来预测空间畸变,计算多光谱影像和融合影像波段间的差异性来预测光谱畸变,并将二者结合得到最终的质量预测值。在QNR 的基础上,Kwan 等(2017)提出了GQNR(Generalized QNR),该方法针对Worldview-3卫星短波红外波段与全色波段波谱范围无重叠,导致QNR 的空间失真描述存在不准确性,提出采用NIQE(Natural Image Quality Evaluator)模型来描述空间失真,并结合QNR 中的光谱失真得到最终的质量预测。此外,Zhou 等(2019)提出了一种无参考评价方法,其将植被指数(NDVI)、水体指数(NDWI)、建筑物指数(RatioG)与原始多光谱波段叠加进行特征提取,并用多元高斯分布MVG (Multivariate Gaussian Distribution) 模型拟合,计算基准MVG 模型和测试MVG 模型之间的距离来预测融合影像的质量值。同样的,Yang 等(2017)基于MVG模型,创新性提出的高光谱影像的参考质量评价方法。

基于MVG模型的评价框架基于大量特征统计,通常具有较好的鲁棒性,在融合影像的评价中具有一定意义。然而,一方面,Zhou 等(2019)提出方法对融合影像的空间和光谱两方面失真考虑不足,另一方面,Zhou 等(2019)在模型训练中未充分考虑不同卫星类型和专题地物对评价模型的影响。针对上述问题,本文提出了一种基于MVG 模型的全色/多光谱融合影像无参考质量评价方法,提出方法充分考虑融合影像的空间和光谱失真,以纹理特征和边缘特征结合的方式来表示空间畸变,以融合影像与多光谱影像间的光谱差异表示光谱畸变,对融合影像进行有效定量评价。此外,本文基于Meng等(2021)提出的大型全色/多光谱影像融合数据库NBU_PansharpRSData,以及全色/多光谱融合影像质量评价数据库PRSIQD(Pansharpened Remote Sensing Image Quality Database)(Xiong 等,2020),构建不同卫星和典型专题地物类型影像的基准数据集、测试数据集(失真融合影像数据集)、以及验证数据集(主观评分数据集),用于提出MVG评价模型的设计、测试、以及验证。

2 提出方法

2.1 总体思路与框架

本文针对无真实参考影像情况下全色/多光谱融合影像的质量评价难题,提出了一种基于MVG的全色/多光谱融合影像无参考质量评价方法,充分考虑融合影像的空间和光谱失真,对融合影像进行有效定量评价。本文提出的方法基于MVG 模型框架,在NBU_PansharpRSData 和PRSIQD 大型数据集基础上构建了用于提出MVG 评价模型的基准数据集、测试数据集以及验证数据集。总体思路如图1所示,首先,基于构建的基准数据集,针对性提取反映融合影像质量的空间和光谱特征,对大量空、谱特征进行训练拟合,构建基准MVG评价模型;然后,基于测试数据集中的融合图像建立融合影像待评价MVG 模型,通过计算基准MVG 和测试MVG 模型间的相对距离预测测试影像的质量分数,实现对融合影像的有效定量评价;最后,通过验证数据集来验证提出模型。

图1 本文总体思路Fig.1 The general idea of this article

2.2 数据集

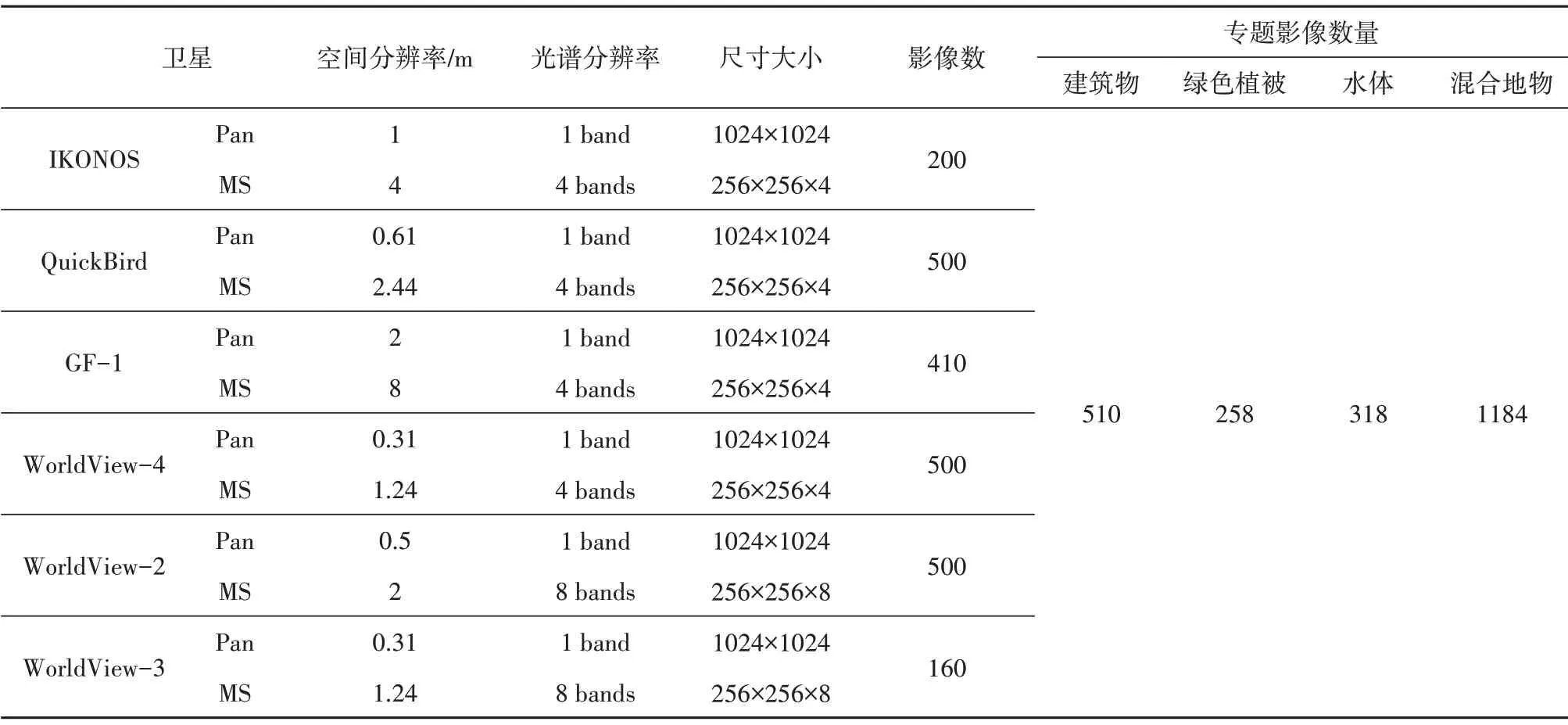

(1) NBU_PansharpRSData 数据集。 NBU_PansharpRSData数据集共2270对全色/多影像数据,包 括IKONOS、QuickBird、GF-1、WorldView-4、WorldView-2、WorldView-3 等6 种卫星类型数据集,以及水体、植被、建筑物、混合地物4种专题地物类型数据集,如表1所示。

表1 NBU_PansharpRSData数据库介绍Table 1 The introduction of NBU_PansharpRSData

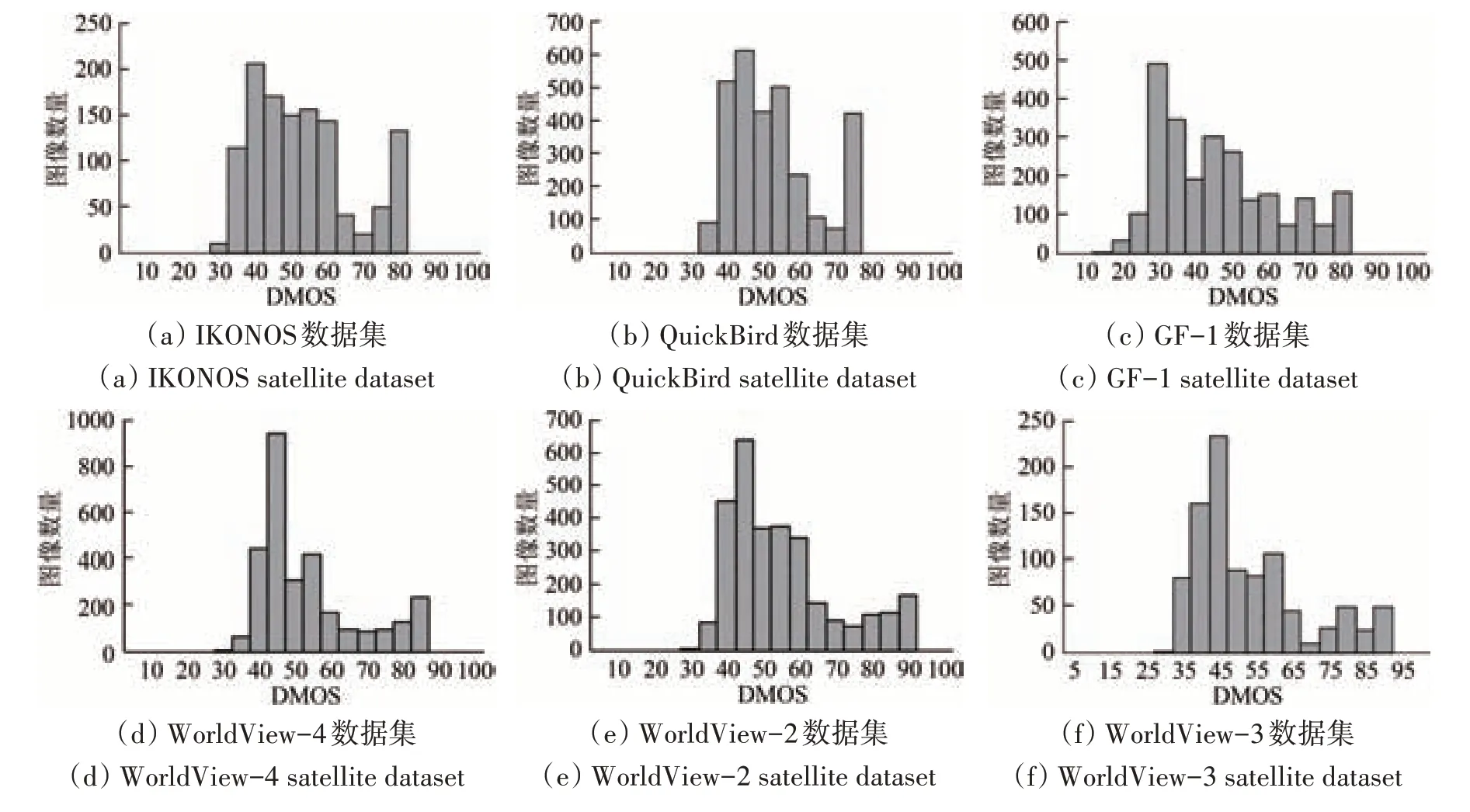

(2) PRSIQD 数据集。Xiong 等(2020) 在NBU_PansharpRSData 基础上,提出全色/多光谱融合影像评价数据集PRSIQD,该数据集采用6 种不同的Pansharpening 方法(张立福 等,2019;Meng 等,2019),包括4 种成分替代类(CS)方法和两种多分辨率分析(MRA) 方法对NBU_PansharpRSData 中的全色和多光谱影像进行融合,共有13620 幅不同空间和光谱失真程度的融合影像,在此基础上,邀请28 位(20 男性、8 女性)参与者进行主观打分,建立全色/多光谱融合影像主观评价数据库。图2 和图3 给出了DMOS(Difference Mean Opinion Scores)分布。

图2 光谱失真DMOS分布Fig.2 The distribution of DMOS for spectral distortion

图3 空间失真DMOS分布Fig.3 The distribution of DMOS for spatial distortion

(3)本文MVG 基准、测试、验证数据集。本文基于NBU_PansharpRSData 和PRS IQD 数据集构建用于提出MVG 评价模型的基准数据集、测试数据集和验证数据集,其中,基准数据集包括了4 种四波段原始多光谱卫星影像数据集,分别是IKONOS、QuickBird、GF-1 以及WorldView-4,还包括了水体、植被、建筑物、混合地物4 种原始多光谱专题地物类型影像数据集,基准数据集用于构建基准MVG 模型。测试数据集包括了6 种不同的Pansharpening 方法得到的融合影像。Pansharpening 方法中成分替代类为PCA (Principal Component Analysis)(Chavez 等,1991)、IHS(Intensity-Hue-Saturation)(Tu 等,2001)、BDSD(Band-Dependent Spatial-Detail with local parameter estimation)(Garzelli等,2008)、GS(Gram Schmidt)(Laben 和Brower,2000);多分辨率分析类为ATWT_M2(A Trous Wavelet Transform using the Model 2)(Ranchin 和Wald, 2000) 和MTF-GLP-CBD(MTF-GLP with context based decision) (Aiazzi 等,2002,2006)。验证数据集通过28位参与者进行主观打分建立,打分者从空间和光谱两方面综合考虑,最终给出一副融合影像的综合得分。主观打分与客观评分间的一致性可衡量客观评价方法的优劣。

2.3 提出评价模型

多光谱融合影像无参考质量评价模型,如图4 所示,对基准数据集影像进行分块,并有效提取分块后基准影像(原始高质量多光谱影像)的空间信息和光谱特征,在此基础上对提取的空、谱特征进行MVG 模型的学习训练,建立基准MVG 评价模型,此外,选择高方差子影像进行模型训练,以增强基准MVG评价模型的稳健性。在测试步骤,通过衡量融合影像的MVG 模型与基准MVG 模型之间的距离得到质量评价结果。接下来,将会详细介绍每一步的细节。

本文基于上述构建的大型数据集,提出全色/

(1)影像分块与特征提取。将原始高质量影像分割成大小为N×N的无重叠影像块,为了保证训练集影像具有的较好的纹理复杂度,更好的预测影像的质量,筛选每幅影像中方差大于90%的子影像块作为训练集。在此基础上,对分块子影像提取空间和光谱特征,为有效表征融合影像的空间和光谱畸变,提出采用纹理特征和边缘特征结合的方式表征空间特征,以融合影像与多光谱影像间的光谱差异表示光谱特征。

1)空间特征。高分辨率的遥感影像纹理较为复杂,并且容易受到噪声和模糊的影响。局部二值模式(LBP)是一种描述影像纹理特征的算子。在遥感影像处理中,容易产生由未配准或畸变造成的影像轻微旋转,这种旋转从主观目视上往往难以察觉,此外,同一遥感影像不同融合方法会产生不一样的光谱畸变,在灰度处理中会表现出不同灰度,这种单一旋转和灰度变化不应影响影像的空间纹理特征,而LBP 具有灰度不变性和旋转不变性等显著优点,并且在计算效率上优于其他纹理提取算法,基于此,本文用LBP 算子提取影像的纹理特征。本文使用的LBP 算子为改进的旋转不变Uniform 模式算子(Ojala 等,2002),定义如下:

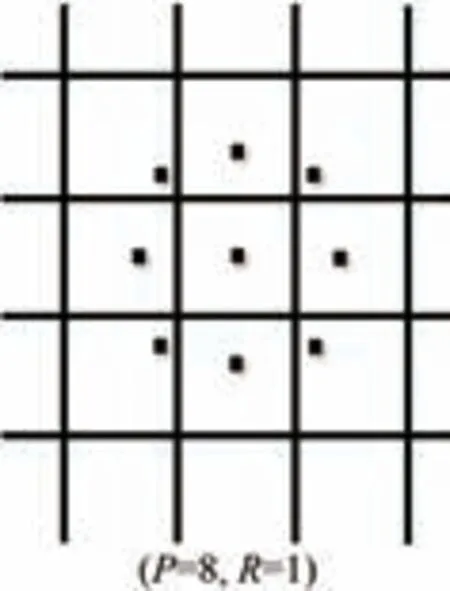

式中,P是采样点数,R圆形对称领域的半径。本文中设置P= 8,R= 1,如图5 所示。U(LBPP,R)定义如下:

图5 采样点为8、半径为1的LBP示意图Fig.5 LBP schematic with point 8 and radius 1

式中,gc和gp分别是中心像素点和领域像素点的灰度值,s(x)为

在旋转不变Uniform 模式下,针对8个采样点,LBP 有9 种输出,将输出进行归一化处理,得到代表纹理特征的特征向量。

在高空间质量的遥感影像中,目标对象的边缘是连续且清晰的。相反,在低质量的影像中,对象的边缘往往模糊且不连续。Canny 边缘检测算子(Canny,1986)是一种被广泛应用于计算机视觉系统的较为完善的边缘检测算子,其抗噪能力强,能有效的检测出图像的弱边缘,相较于其他边缘检测算子,Canny 算子在遥感图像边缘的提取上更具有优势(郑健等,2019)。其流程如下:首先对输入影像进行高斯平滑滤波处理,这里大小为(2k+ 1)(2k+ 1)的高斯内核可由式(4)得到:

式中,i,j表示像素点的位置。假设经过高斯滤波后的影像为I,则滤波影像的梯度近似可由式(5)得到:

式中,Gx代表水平梯度,Gy代表垂直梯度,表示为

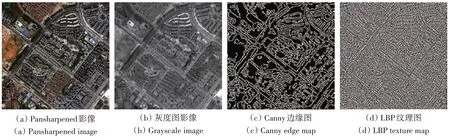

得到梯度图后,对其进行非极大值抑制处理,排除非边缘像素,仅保留细线条。最后通过双阈值检测,去掉一些由颜色和噪声变化引起的边缘像素,并最终得到边缘图,图6(c)所示。

图6 原始的多光谱图像和全色图像Fig.6 Pansharpened image and its feature image

2)光谱特征。以融合影像与多光谱影像间的光谱差异表示光谱畸变(Vivone 等,2015),针对性提取光谱特征,表示为

式中,i,j代表波段,M和F分别代表原多光谱影像和融合影像,P默认为1。式(8)中的di,j(M,F)定义如下:

式中,Q(I,J)表示为

这里,其中σIJ代表输入影像I,J之间的协方差,和σI,σJ分别代表I,J的均值和方差。

用来计算原始多光谱影像波段和融合影像波段之间的差异性。如对于R、G、B、NIR四波段影像,即输出六维光谱特征向量:

本文中将当做特征向量进行处理,在训练时计算的是两幅同一原始多光谱影像的光谱差异性,即= 0。

表2 给出了特征描述。如上所述,对筛选的n个影像块进行m维(m= 17)特征提取,表示为f=[f1,f2,⋅⋅⋅f17]。

表2 特征描述Table 2 Description of features

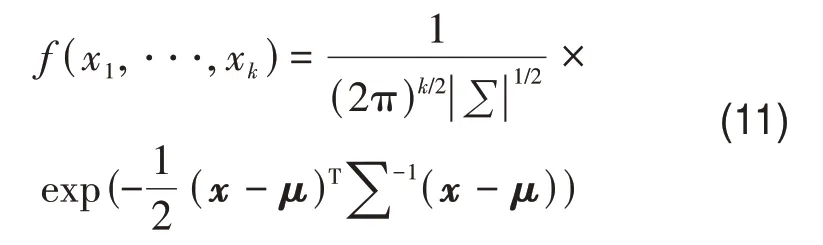

(2)MVG 拟合。基于上述提取的空间和光谱特征,构建特征矩阵,获得一个n×m的特征矩阵,对这个特征矩阵求均值向量μ和协方差矩阵∑。得到均值向量μ和协方差矩阵∑后,原始的基准MVG模型可拟合如下:

式中,x=[x1,x2,…,xk],为k维随机变量,μ和∑分别是x的均值向量和协方差矩阵,由极大似然估计法(Bishop,2006)给出估计量。

(3)评价输出。得到原始MVG 模型后,将测试影像同样分割成大小N×N 的无重叠影像块,这里不做块筛选操作。按照训练中的特征提取流程,得到每个子影像块的均值向量μi和协方差矩阵∑i,用修正后的Bhattacharyya 距离(Fukunaga,1972)来预测子影像块的质量分数:

则最后影像的质量值为所有qi值的平均。

3 实验结果与分析

3.1 评价指标

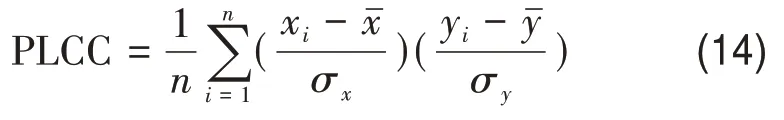

为了验证评价实验,本文用了4 个常用指标(Sheikh等,2006):皮尔逊线性相关系数(PLCC)、斯皮尔曼秩阶相关系数(SRCC)、肯德尔秩阶相关系数(KRCC)、均方误差(RMSE)。

式中,xi表示主观评分,yi代表客观预测质量值。RMSE反映了客观预测的准确性。

式中,和分别代表xi和yi的均值,σx和σy是其标准差。PLCC 反映了客观评分与主观打分之间的相关性,同样是衡量客观预测的准确性。

式中,rxi和ryi分别为xi和yi在各自数据序列中的排序位置。SRCC用来衡量客观评分的单调性。

两个数据序列中任意一对数据(xi,yi) 和(xj,yj),若满足xi>yi且xj>yj或者xi

更符合主观评分应该有更高的PLCC、SRCC、KRCC以及更低的RMSE。

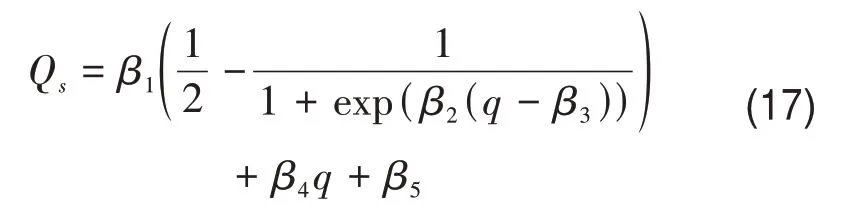

由于主观评分与客观结果之间存在非线性关系,本文使用了五参数逻辑回归函数来减少这种非线性关系:

式中,β1、β2、β3、β4、β5通过拟合得到。逻辑回归只会影响RMSE和PLCC。

本文用了4种全参考评价方法作为比较:SSIM、SAM、ERGAS、Q2n。

3.2 实验参数设置

根据前文所述,将影像分块成42×42大小块筛选方差>90%时具有较好的表现。这里,对块大小以及方差阈值的设置对结果的影响做了实验,如图7所示,PLCC以及SRCC作为比较的指标。可以看出,块大小42×42 与块大小24×24 相差不大,考虑到运行效率问题,本文选择了将块分成42×42大小。此外,影像中方差的大小可以反映影像的纹理复杂度,故筛选方差较大的子影像块作为训练集有着更好的表现。

图7 SRCC和PLCC在不同块大小和方差阈值上的表现Fig.7 SRCC and PLCC performance on different block sizes and variance thresholds

3.3 结果与分析

针对每个库,随机选定影像库中的80%的MS影像作为原始高质量影像进行训练,剩下的20%的融合影像(包括了6 种失真类型)作为测试集。这里的融合影像是先将多光谱影像和全色影像降采样后再融合得到,因此为充分验证提出方法的有效性,以原始高质量多光谱影像为参考影像,采用Q4、ERGAS、SAM、SSIM 全参考质量评价方法对融合影像进行评价,并与提出方法进行对比分析。

(1)卫星库实验结果。表3—表6 给出了4 个卫星影像库上本文方法以及对比方法的实验结果。其中表现最好的结果加粗表示,次优结果以下划线表示。

表3 IKONOS影像集实验结果Table 3 Experimental results of IKONOS images

表4 Quickbird影像集实验结果Table 4 Experimental results of Quickbird images

表5 GF-1影像集实验结果Table 5 Experimental results of GF-1 images

从表3—表6 上的结果可以发现:不同的卫星库上,每种评价方法的效果都有明显的变化。其中Q4,SSIM 以及本文提出的评价方法在大多数卫星库上拥有较好的表现,相反,ERGAS 以及SAM总体表现相对较差,与主观评分不完全相符。值得注意的是,由于卫星传感器的不同,每种评价方法都有其相应的优缺点,例如:SSIM 方法在IKONOS 卫星库和GF-1 卫星库上表现较好,而在QuickBird 卫星库和WorldView-4 卫星库上表现不如Q4。

表6 WorldView-4影像集实验结果Table 6 Experimental results of WorldView-4 images

基于MVG的评价方法因为通过学习的方式预测质量值,因此在整个影像库上具有较好的鲁棒性,并且在IKONOS卫星库和QuickBird卫星库上表现最佳,虽然在Gaofen-1卫星库和WorldView-4卫星库上并不是所有指标最佳,但是仍保持着优越性。

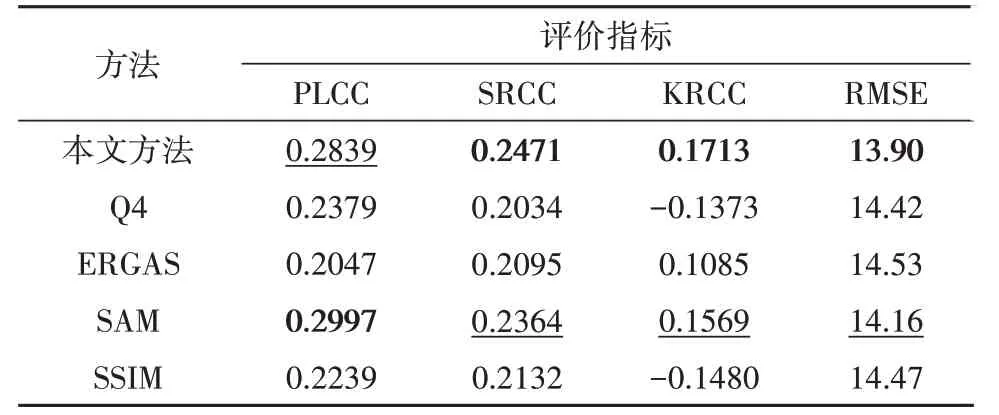

(2)主题库实验结果。表7—表10 给出了4 个卫星影像库上本文方法以及对比方法的实验结果。其中表现最好的结果加粗表示,次优结果以下划线表示。

表7 建筑物影像集实验结果Table 7 Experimental results of building images

表8 植被影像集实验结果Table 8 Experimental results of vegetation images

表9 水体影像集实验结果Table 9 Experimental results of water images

表10 混合地物影像集实验结果Table 10 Experimental results of mixed ground images

从表7—表10上的结果可以看出:在建筑物主题库上,Q4 和本文提出的方法具有较好的表现,而SAM因其只考虑光谱一方面的失真,导致表现较差。在植被专题库上,基于MVG 的方法有着最佳的表现,原因在于植被影像光谱失真比较明显,而将原始多光谱影像作为光谱参照,能较好的描述光谱失真。与建筑物主题库不同的是,SSIM评价方法在植被库表现不佳,因为SSIM 评价方法主要以评价空间结构为主,而ERGAS和SAM依旧表现较差。在水体专题库上的实验结果与植被专题库比较相似,因为二者影像的失真类型主要为光谱失真。值得注意的是,在混合地物主题库上,Q4 评价方法表现最佳,基于MVG 的评价方法不如在水体库、建筑物库和植被库的表现,其原因在于MVG 模型通过学习的方式预测质量,建筑物库这种专题库的影像之间有着更为紧密的联系,通过训练学习的方式能更好的表现融合影像的失真,而混合地物库的不同影像包含了不同的地物,因此在随机训练和测试的过程中,不能很好的建立一一对应关系,导致了整体表现不佳。总体来说,不同评价方法在不同主题地物库上表现不同,主要原因在于不同地物有着不同程度的光谱失真和空间失真,例如建筑物库上空间失真为主要失真类型,而在植被库和水体库上有着更多的光谱失真。

4 结 论

本文提出了一种基于MVG 的全色/多光谱融合影像无参考质量评价方法,该方法为全色/多光谱融合影像的无参考质量评价提供了一种新的思路。

提出方法基于大型全色/多光谱影像融合数据库NBU_PansharpRSData 、PRSIQD,进一步选用并建立了适用于本文MVG 模型设计、测试、验证的基准数据集、测试数据集、以及验证数据集。这些数据集可为全色/多光谱融合影像的质量评价研究提供帮助。本文提出方法充分考虑融合影像的空间畸变和光谱保真,针对性提取影像的空间和光谱特征,通过大量特征的拟合,建立了稳健MVG 评价模型,实验结果表明了本文提出的方法相较于传统全色/多光谱融合影像质量评价方法具有一定优越性,本文依据不同卫星、不同主题地物数据库训练的基准模型,可相应的供他人借鉴使用。

本文提出方法是在全色/多光谱融合影像的降分辨率尺寸下进行的。目前发现本文方法不能很好的推广至全分辨率尺寸进行评价,并且十分依赖数据库学习,不能实时在线的进行评价。在接下来的研究工作中,期望能将本文工作进行推广,设计出一种全色/多光谱融合影像全分辨率评价方法,并且该方法不再依赖数据库训练,能够实时在线评价。