一种基于卷积神经网络的人群密度识别算法

杨博涵

摘要:近年来,人群密度的识别成为模式识别领域的热点问题,基于这个问题,该文提出一种基于卷积神经网络的算法,首先将数据集中的Ground-Truth数据转化为人群密度图,然后将生成的密度图送入神经网络中进行训练,得到人群密度数据。该文创新点在于采用多尺度卷积神经网络,使用多种尺度的卷积核来适应不同尺度的人头大小。通过利用具有不同尺寸接收领域的过滤器,从而可以识别各种分辨率的人群图像和数据。

关键词:人工智能;卷积神经网络;人群密度识别

中图分类号:TP3 文献标识码:A

文章编号:1009-3044(2022)02-0082-02

1 概述

近年来,随着城市化程度的加深,人群聚集的程度越来越高。一方面,随着大型商超、地铁站等人群聚集场所的增多,发生人群踩踏的概率越来越高;另一方面,在疫情的影响下,有必要对一些封闭场所的人群密度进行控制,防止出现大规模聚集性疫情。在人力资源日渐紧张的当下,依托于城市天网工程,利用摄像头对人群密度进行监测是最好的选择。

根据之前的成果,最广泛使用的人群统计方法是基于特征的回归[1],这种方法的主要步骤是(1)分割前景;(2)从前景提取各种特征,例如人群遮罩的区域、边缘计数或纹理特征;(3)利用回归函数来估计人群计数。线性或分段线性函数是相对简单的模型,性能良好。其他更先进/有效的方法有岭回归[2](RR)、高斯过程回归(GPR)、神经网络(NN)[3]。

在目标检测中使用较多的神经网络是卷积神经网络,卷积神经网络采用一个固定尺寸的卷积核来遍历图片,对整张图片进行卷积操作后可以自动化地提取图片中不同尺寸的特征,之后可以利用多次池化、卷积等操作,对图片中的特征进行自动归纳,从而检测图片的特征。卷积神经网络具有原理简单,相关资源成熟的特点,故本文基于密度图和卷积神经网络提出了一种具有多尺度检测功能的卷积神经网络。在多尺度卷积神经网络中,用滤波器大小为1 × 1的卷积层来代替全连通层。因此,模型的输入图像可以是任意大小以避免失真。网络的直接输出是对人群密度的估计,从中得出总人数。

2 用于人群计数的多尺度神经网络

2.1 用于人群计数的密度图的生成

人群计数有两种途径,第一种途径是直接输入人群图像和标签数据,然后对人群数进行预测;第二种途径是输入人群的密度图,之后积分得到人头数量。生成密度图是较好的办法,因为密度图可以保留更多的信息,如图像的空间分布,如果一个小区域的密度比其他区域高得多,这可能表明那里发生了异常情况。

2.2 通过高斯核生成密度图

如果在[xi]位置存在一个人头,可以用[δ]函数来表示为[δx-xi],而一个包含[N]个头像的图像可以表示为:

[Hx=i=1Nδx-xi]

为了将这个图像转化为一个连续的函数,可以将这个函数与高 斯核[ Gσ]进行卷积[4],得到密度函数。

[Fx=Hx*Gσ]

此外还有一个问题,在使用二维高斯核时,需要设定高斯核大小用以表示估计的人头大小。然而,在实践中,由于许多情况下的遮挡,几乎不可能准确地获得头部的大小,并且也很难找到头部大小和密度图之间的潜在关系。有趣的是,在拥挤的场景中头部的大小通常与两个相邻人的中心之间的距离有关。作为折衷,对于那些拥挤场景的密度图,建议根据每个人到其邻居的平均距离,数据自适应地确定每个人的扩散参数。即对于一个人头的最近的[k]个人头的距离记作[{di1,di2,...,dik}],且有:

[di=1kj=1kdij]

高斯核的选择应该取决于[di],即:

[Fx=Hx*Gσi,σi=βdi]

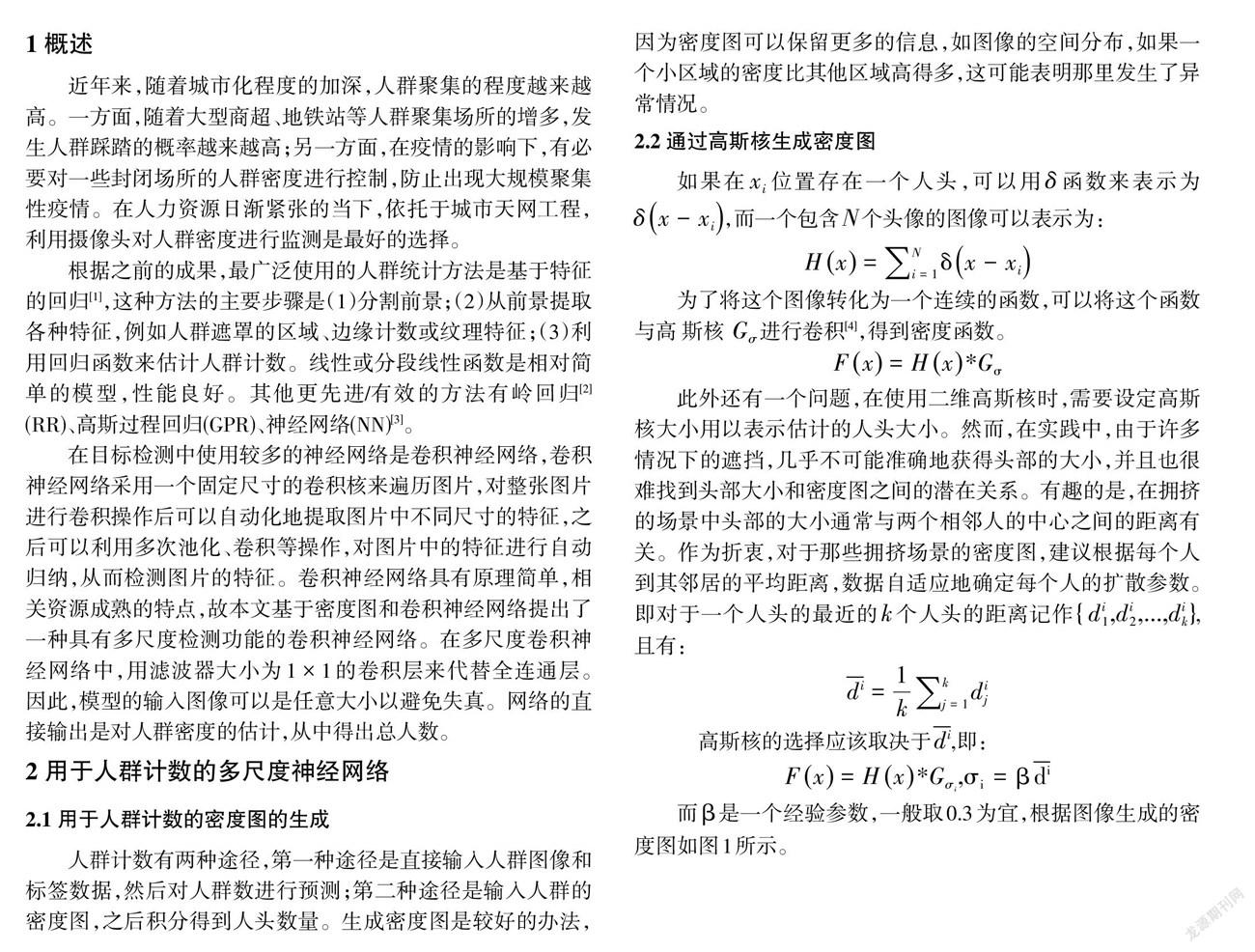

而[β]是一个经验参数,一般取0.3为宜,根据图像生成的密度图如图1所示。

2.3 使用密度图的多尺度卷积神经网络

由于透视失真,图像通常包含大小非常不同的头部,因此具有相同大小感受野的过滤器不太可能捕捉不同尺度下的人群密度特征。因此,更自然的是使用具有不同大小的局部感受野的滤波器来学习从原始像素到密度图的映射。在MCNN中,對于每一列使用不同大小的过滤器来模拟对应于不同比例的头部的密度图。例如,具有较大感受野的过滤器对于模拟对应于较大头部的密度图更有用。

这种用于密度估计的MCNN模型的一个优点是,滤波器被学习来对不同尺寸的头部的密度图进行建模。因此,如果模型是在包含非常不同尺寸的头部的大数据集上训练的,那么模型可以容易地适应(或转移)到另一个人群头部具有一些特定尺寸的数据集。如果目标域只包含几个训练样本,可以简单地在MCNN中的每一列中固定前几个层,并且只微调最后几个卷积层。在这种情况下,微调最后几层有两个优点。首先,通过固定前几层,可以保留在源域中学习的知识,并且通过微调最后几层,可以使模型适应目标域。因此,源域和目标域的知识可以整合,有助于提高准确性。其次,与微调整个网络相比,微调最后几层大大降低了计算复杂度。

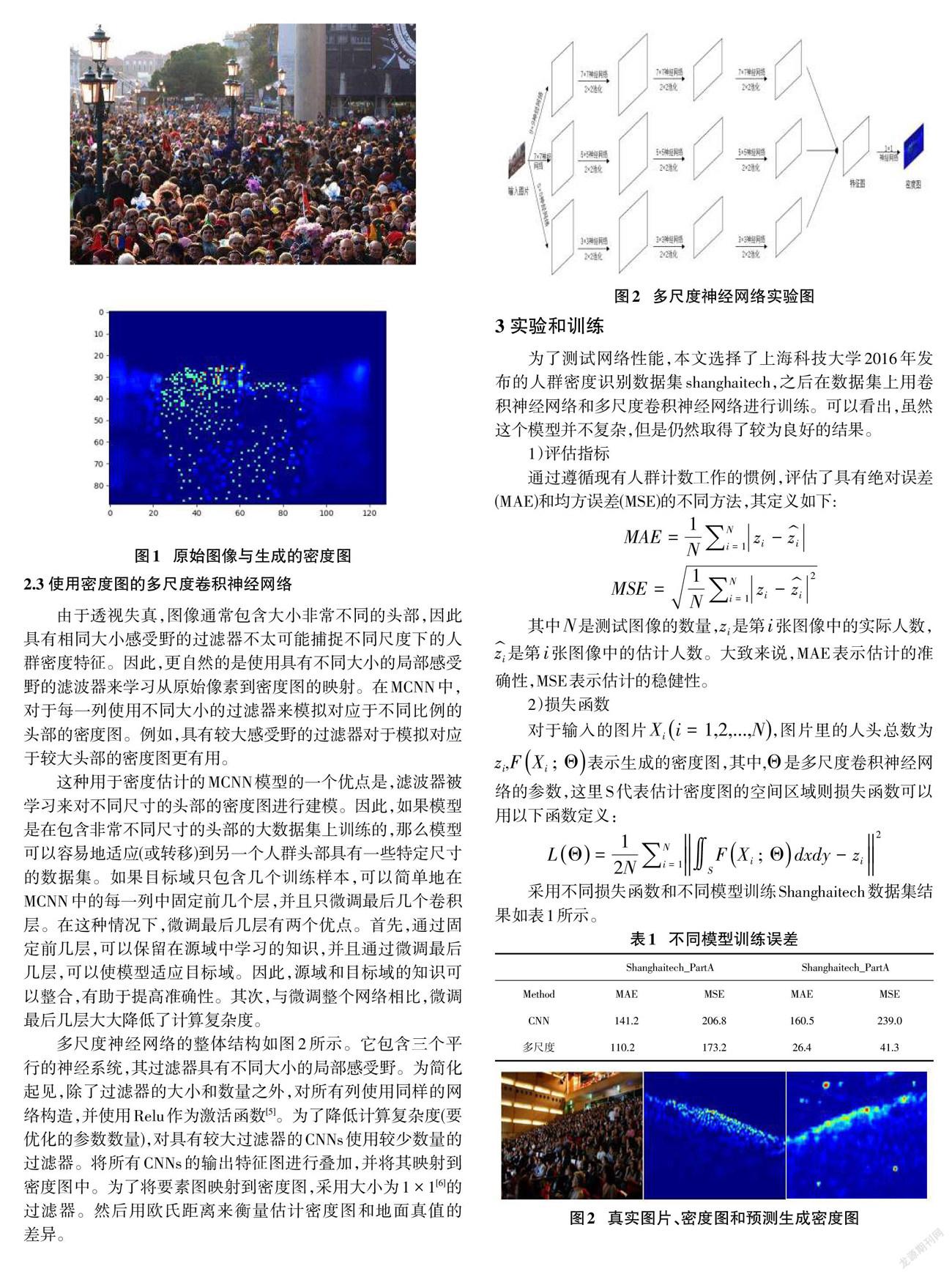

多尺度神经网络的整体结构如图2所示。它包含三个平行的神经系统,其过滤器具有不同大小的局部感受野。为简化起见,除了过滤器的大小和数量之外,对所有列使用同样的网络构造,并使用Relu作为激活函数[5]。为了降低计算复杂度(要优化的参数数量),对具有较大过滤器的CNNs使用较少数量的过滤器。将所有CNNs的输出特征图进行叠加,并将其映射到密度图中。为了将要素图映射到密度图,采用大小为1 × 1[6]的过滤器。然后用欧氏距离来衡量估计密度图和地面真值的差异。

3 实验和训练

为了测试网络性能,本文选择了上海科技大学2016年发布的人群密度识别数据集shanghaitech,之后在数据集上用卷积神经网络和多尺度卷积神经网络进行训练。可以看出,虽然这个模型并不复杂,但是仍然取得了较为良好的结果。

1)评估指标

通过遵循现有人群计数工作的惯例,评估了具有绝对误差(MAE)和均方误差(MSE)的不同方法,其定义如下:

[MAE=1Ni=1Nzi-zi]

[MSE=1Ni=1Nzi-zi2]

其中[N]是测试图像的数量,[zi]是第[i]张图像中的实际人数,[zi]是第[i]张图像中的估计人数。大致来说,MAE表示估计的准确性,MSE表示估计的稳健性。

2)损失函数

对于输入的图片[Xii=1,2,...,N],图片里的人头总数为[zi],[FXi;Θ]表示生成的密度图,其中,[Θ]是多尺度卷积神经网络的参数,这里S代表估计密度图的空间区域则损失函数可以用以下函数定义:

[LΘ=12Ni=1NSFXi;Θdxdy-zi2]

采用不同损失函数和不同模型训练Shanghaitech数据集结果如表1所示。

4 结论

本文提出了一种新的卷积神经网络模型,利用人群密度图提供的信息和由多个不同大小的卷积核形成的多尺度神经网络对密集人群进行预测,它可以从几乎任何角度准确地估计单个图像中的人群数量。此外,在源域上训练的模型可以通过只微调训练模型的最后几层而容易地转移到目标域,这证明了所提出的模型的良好的可推广性。

但本文结果也有不足,由于时间和能力所限,没有尝试和其他的如Local Binary Pattern(LBP)、Ridge Regression(RR)等基于回归的传统方法进行比较,在数据集上,密度识别领域还有类似UCF_CC_50数据集,UCSD数据集等,并未将模型在这些数据集上进行训练,不能直接比较模型和其他已有模型的优劣,可以在后面进行改进。

参考文献:

[1] Chan A B,Liang Z S John,Vasconcelos N.Privacy preserving crowd monitoring:Counting people without people models or tracking[C]//2008 IEEE Conference on Computer Vision and Pattern Recognition.June 23-28,2008,Anchorage,AK,USA.IEEE,2008:1-7.

[2] Chen K,Loy C C,Gong S G,et al.Feature mining for localised crowd counting[C]//Procedings of the British Machine Vision Conference 2012.Surrey.British Machine Vision Association,2012.

[3] Marana A N,Costa L F,Lotufo R A,et al.On the efficacy of texture analysis for crowd monitoring[C]//Proceedings SIBGRAPI'98.International Symposium on Computer Graphics,Image Processing,and Vision (Cat.No.98EX237).October 20-23,1998,Rio de Janeiro,Brazil.IEEE,1998:354-361.

[4] Lempitsky V, Zisserman A. Learning to count objects in images[J].Advance in Neural Information Processing Systems, 2010:1324–1332.

[5] Zeiler M D, Ranzato M, Monga R, et al. On rectified linear units for speech processing[J].ICASSP, IEEE, 2013: 3517–3521 .

[6] Long J,Shelhamer E,Darrell T.Fully convolutional networks for semantic segmentation[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).June 7-12,2015,Boston,MA,USA.IEEE,2015:3431-3440.

【通聯编辑:代影】

2390501705261