基于深度强化学习的农田节点数据无人机采集方法

胡 洁,张亚莉,王 团,望梦成,兰玉彬,张植勋

·农业航空工程·

基于深度强化学习的农田节点数据无人机采集方法

胡 洁1,3,张亚莉2,3※,王 团1,望梦成1,兰玉彬1,3,张植勋2

(1. 华南农业大学电子工程学院,广州 510642;2. 华南农业大学工程学院,广州 510642;3. 国家精准农业航空施药技术国际联合研究中心,广州 510642)

利用无人机采集农田传感器节点数据,可避免网络节点间多次转发数据造成节点电量耗尽,近网关节点过早死亡及网络生命周期缩短等问题。由于相邻传感器数据可能存在冗余、无人机可同时覆盖多个节点进行采集等特点,该研究针对冗余覆盖下部分节点数据采集和全节点数据采集,对无人机数据采集的路线及方案进行优化,以减轻无人机能耗,缩短任务完成时间。在冗余覆盖下部分节点数据采集场景中,通过竞争双重深度Q网络算法(Dueling Double Deep Q Network,DDDQN)优化无人机节点选择及采集顺序,使采集的数据满足覆盖率要求的同时无人机能效最优。仿真结果表明,该算法在满足相同感知覆盖率要求下,较深度Q网络(Deep Q Network,DQN)算法的飞行距离缩短了1.21 km,能耗减少27.9%。在全节点数据采集场景中,采用两级深度强化学习联合(Double Deep Reinforcement Learning,DDRL)方法对无人机的悬停位置和顺序进行优化,使无人机完成数据采集任务时的总能耗最小。仿真结果表明,单节点数据量在160 kB以下时,在不同节点个数及无人机飞行速度下,该方法比经典基于粒子群优化的旅行商问题(Particle Swarm Optimization-Traveling Salesman Problem,PSO-TSP)算法和最小化能量飞行控制(Minimized Energy Flight Control,MEFC)算法的总能耗最少节约6.3%。田间试验结果表明,相比PSO-TSP算法,基于DDRL的数据采集方法的无人机总能耗降低11.5%。研究结构可为无人机大田无线传感器节点数据采集提供参考。

无人机;数据采集;深度强化学习;节点感知冗余;DQN;DRL

0 引 言

各种农业传感器在农业生产中起着监测作物生长环境、协助精准灌溉和施肥及病虫害防治等作用[1-2]。在网络基础设施缺乏的部分边远地区,农田无线传感器节点的数据采集存在困难[3-4]。因此,利用各种移动设备采集田间无线传感器节点数据成为一种解决措施[5-6]。相比地面移动设备,无人机具有不受限于地面环境、不破坏地面作物、信号传输所受阻挡小等优势,是采集传感器节点数据的有利途径[7]。目前农业无人机普遍采用牛耕法的方式进行喷药、撒播等作业,然而当采集随机布置的传感器节点数据时,相邻节点间的数据可能存在冗余[8-9],且无人机在一个悬停点可能覆盖多个节点[10],因此需要对无人机数据采集的路线及方案进行优化,以减小无人机能耗、缩短任务完成时间。

针对无人机采集传感器节点数据的方法,国内外学者开展了相关研究,大部分优化方案主要集中在降低能耗[11-12]、任务完成时间最短[13]、轨迹距离最小[14-17]等。Luo等[11]提出了一种智慧农场的数据采集方案,根据传感器节点的接收信号强度(Received Signal Strength Indication,RSSI)确定簇和簇头,采用改进的Dijkstra和遗传算法(Genetic algorithm,GA)寻求最佳轨迹。Ben等[12]提出了一种使用无人机从无线传感器网络节点采集数据的解决方案,可以同时减小通信与无人机飞行能耗。Just等[14]针对无人机采集大面积节点数据,使用时隙概念结合飞行禁止列表,将无人机路径与每个节点的激活周期进行同步,大大缩短了飞行距离和飞行时间。Zhang等[15]提出了一种基于分层深度强化学习(Hierarchical Deep Reinforcement Learning,HDRL)算法解决可充电多无人机数据采集场景的路径规划问题,最大限度地缩短无人机的总飞行时间。蒋宝庆等[16]提出了一种基于Q学习的无人机辅助采集小规模无线传感器节点数据,减少了无人机的任务完成时间和有效数据量,提高了无人机能效。Yi等[17]研究了一种基于深度强化学习(Deep Reinforcement Learning,DRL)的无人机辅助物联网采集最优信息年龄(Age of Information,AoI)数据,得到最优的无人机飞行轨迹和传感器节点的传输调度方案。文献[15-18]采用强化学习算法研究无人机数据采集问题,无人机通过与环境进行交互得到反馈,通过自主学习获得最优数据采集策略。上述研究大多针对无人机的飞行距离进行优化,忽略了节点数据量大小和通信范围等因素。

作者在无人机果树喷药的研究中发现,悬停能耗对无人机整体能耗的影响更大,需综合考虑悬停时间和飞行时间。因此,针对能量受限的农业无人机不同数据采集场景,本文基于深度强化学习算法,在考虑传感器节点冗余覆盖的情况下,研究如何对无人机进行调度,有选择地采集部分节点数据及规划采集顺序,使数据采集在满足覆盖率要求的同时达到无人机能效最优,在需要采集全部传感器节点数据的情况下优化无人机的悬停位置和采集顺序,使无人机能耗最小。

1 作业场景及相关模型

1.1 冗余覆盖下部分节点数据采集场景

在布设传感器时,为了对整个作业区域进行全面覆盖,传感器之间往往存在感知范围交叉重叠的情况,这种情况在随机布设传感器的环境中尤其明显。无人机受限于自身能量和续航时间,在采集传感器数据时需要对传感器进行甄选,对飞行路径进行优化,以求在感知覆盖率要求和无人机能耗之间获得最佳平衡。

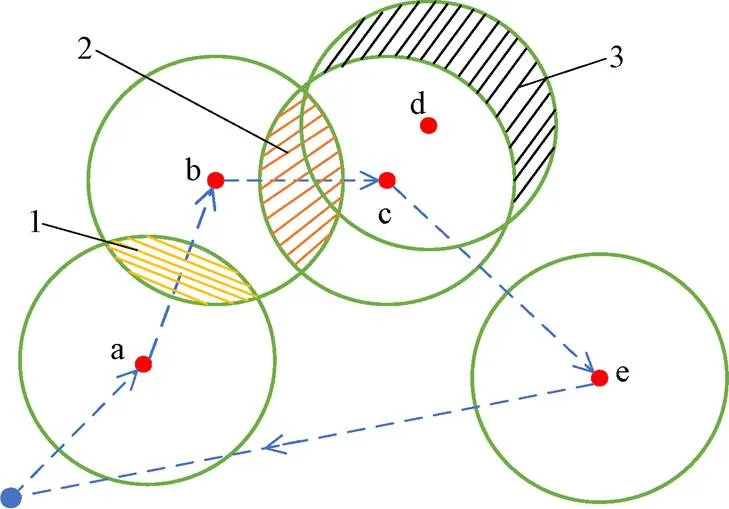

假定农田随机分布的传感器节点总数为,每个节点的感知范围是以节点为中心的圆(本文假设所有节点的感知半径相同),如图1所示。在采集数据过程中无人机悬停在节点的正上方,在一个悬停位置只采集一个节点的数据,传感器节点在收到无人机的信标信息后被唤醒并向无人机发送数据,无人机采集完该节点数据后飞向下一个被选择的节点。数据采集过程中,假设无人机可以获知各节点的位置及当前自身能量。无人机以固定高度飞行,为简便表示,后续统一采用平面二维坐标表示无人机的悬停位置。

图1 冗余覆盖下部分节点数据采集场景

1.2 全节点数据采集场景

农业生产中,有些情况下需要采集田间所有传感器节点的数据,若每采集一个节点数据都要悬停,悬停点过多,无人机会有巨大的能量消耗。由于无人机的通信区域是以悬停点在地面投影为中心的圆,在这个范围内的节点都可以与无人机进行数据传输,通过合理选择无人机的悬停点位置和采集顺序,让无人机在每个悬停点时采集其通信范围内的传感器节点数据,达到减少无人机悬停次数及能耗的目标,最终完成所有传感器节点的数据采集。

如图2所示,假设田间有个无线传感器节点,每个节点都有准确定位(配备GPS或北斗天线),每个传感器都具有相同的通信范围和数据缓冲区大小。无人机在飞行高度固定为的情况下,在某个悬停点可正常通信的是图2中圆形区域内的传感器节点,设该区域的半径为(通过信道传输模型计算得出),区域中的传感器节点以单跳方式与无人机进行通信。假设无人机匀速飞行,飞行高度固定,通过对悬停位置选择及飞行路径规划,使无人机在采集完所有传感器节点数据时总能耗最小。为简便表示,后续统一用平面二维坐标表示无人机的悬停位置。

注:H为无人机飞行高度,m;R为无人机在某个悬停点可与传感器正常通信的区域半径,m。

1.3 信道传输模型

无人机悬停采集田间节点数据,其悬停时间与数据传输速率相关,而数据传输速率受信道损耗和衰落的影响。

假设在通信过程中传感器节点的发射功率为,根据香农定理可得位置的无人机与节点间的数据传输速率R,i(bit/s)为

从式(2)可以看出,在其他参数不变的情况下,无人机与节点的距离越远,数据传输速率越慢,则无人机悬停时间越长。

1.4 无人机能耗模型

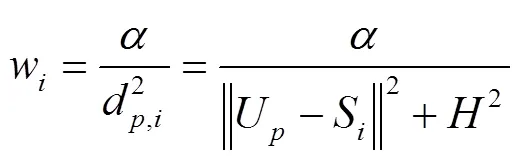

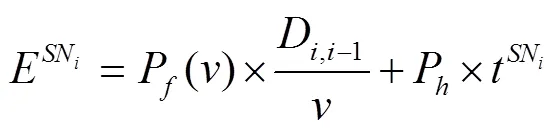

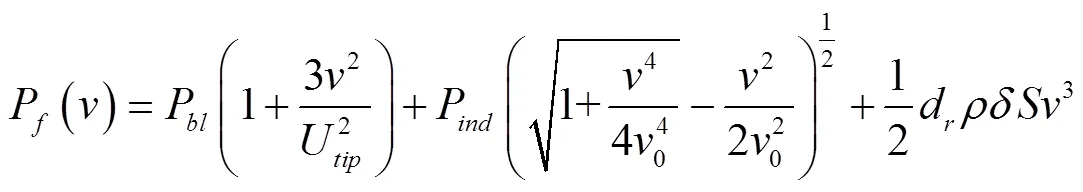

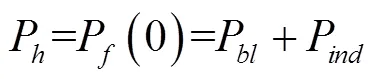

本文采用Zeng等[19]的旋翼无人机功率模型:

由式(3)~(4)、式(6)~(7)可知,在冗余覆盖下部分节点数据采集场景中,无人机从SN-1起飞到结束SN的数据采集所消耗的能量(kJ)为

同理,在全节点数据采集场景中,从SN-1起飞到结束SN的数据采集所消耗的能量(kJ)为

最终,无人机完成个悬停位置的数据采集任务所需要的总能耗E(kJ)为

2 基于DRL的节点数据采集方法

2.1 深度强化学习DRL

强化学习是一类特定的机器学习方法,可解决关于序列决策的相关问题[20]。深度强化学习(Deep Reinforcement Learning,DRL)将深度学习的感知能力和强化学习的决策能力相结合[21-22],通过深度学习对环境状态信息进行特征提取,传递给智能体进行决策并执行动作,执行动作后得到由环境反馈的奖惩信号以及环境状态的改变,促进智能体进行下一步的动作。智能体通过与环境迭代交互选取一系列动作以最大化累积奖励,即在有限反馈中实现序列决策的优化[23]。田间节点数据采集本质上是在多种影响因素变化情况下对无人机悬停位置的选择和采集时序的安排;每采集一个节点数据,或会带来相邻节点数据的效用变化,或会带来去往其余节点的距离成本变化,这可以转化为序列决策问题。本文基于DRL方法,针对前述2个场景设计了竞争双重深度Q网络(Dueling Double Deep Q Network,DDDQN)及两级深度强化学习(Double Deep Reinforcement Learning,DDRL)算法。

2.2 冗余覆盖下基于DDDQN的部分节点数据采集方法

2.2.1 任务环境

设农田为一个矩形区域,如图3所示,无人机按照虚线所示的路线采集节点数据。采集节点a数据时,无人机获取的数据覆盖范围增量是以a为中心的整个圆范围;采集节点b数据时,数据覆盖范围增量是以b为中心、去掉阴影区域1的剩余圆;采集节点c数据时,数据覆盖范围增量是以c为中心、去掉阴影区域2的剩余圆;而采集节点d的数据覆盖率增量只有阴影区域3的范围,节点d与已采集的节点间数据冗余比例高,无人机根据奖励函数(公式(12))确定当前动作,可能会将节点d舍弃。

注:a~e为传感器节点;1为节点a与节点b的冗余覆盖部分;2为节点b与节点c的冗余覆盖部分;3为节点d带来的数据覆盖率增量。

2.2.2 DDDQN算法

DDDQN算法将双重深度Q网络(Double DQN)[24]与竞争深度Q网络(Dueling DQN)[25]相融合。图4为DDDQN算法框架[26]。该算法结合了2种算法的优势,将DQN算法存在的网络值估计过高的问题与网络的结构同时进行优化。

注:s为无人机当前状态;V(s)为在状态s下通过神经网络得到的状态值;A(s,a)为在状态为s下执行动作a时通过神经网络得到的优势值;Q(s,a)为在状态值V(s)和优势值A(s,a)的总和。

在冗余覆盖场景中,无人机强化学习模型中的状态-动作-奖励框架如下:

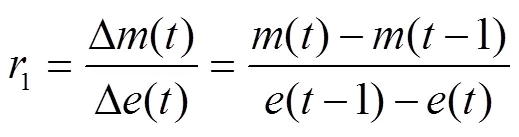

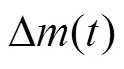

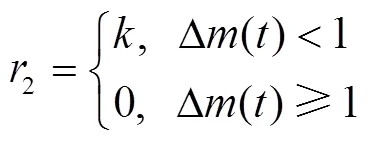

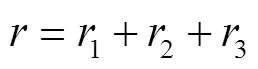

3)奖励函数:考虑到无人机续航能力有限,需要尽可能快地从分散的传感器节点采集数据,避免花费大量时间和能耗采集冗余覆盖部分数据。因此,在建立奖励函数时需要兼顾正向和负向奖励,定义如下:

2.3 基于DDRL的全节点数据采集方法

2.3.1 任务环境

全节点数据采集与部分节点数据采集的区别是:(1)要求采集所有节点的数据;(2)悬停位置不局限在节点的正上方;(3)在一个悬停位置可以采集多个在通信范围内的节点数据。

全节点数据采集示意图如图5所示,设农田为矩形区域,为定位无人机的悬停位置,将农田区域离散为×个小栅格,每个小栅格中心是无人机可选的悬停点。栅格越小,对悬停位置的优化程度越高,但算法复杂度越高。图中三角形代表某个飞行策略确定的悬停采集点,虚线代表飞行路径。无人机在悬停点2采集传感器b和c的数据,在悬停点3采集传感器d和e的数据。

针对全节点数据采集场景,若直接采用DQN算法对系统进行建模,会导致系统状态空间维数爆炸、模型训练困难,无人机甚至难以完成数据采集任务。本文提出一种基于两级深度强化学习(DDRL)的数据采集策略,将该问题分解为2个子问题进行研究,以简化模型,避免出现直接采用DQN算法产生的问题。分解后的2个子问题为:1)选择无人机最优采集区域,采用深度Q网络(Deep Q Network,DQN)算法;2)在得到的最优采集区域内,采用n步深度Q网络(Option n-step Deep Q Network,OnDQN)算法选择悬停位置以及确定遍历顺序。

注:n0为矩形区域长度;k为小栅格长度;f为传感器节点;1~4为无人机悬停采集点。

2.3.2 基于DQN的最优采集区域选取

3)奖励函数:奖励函数由3个部分组成,其中能量效率表示当前动作执行后采集的传感器节点数增量与当前动作执行所消耗的能量之比,如式(13)所示。

注:1~7是根据传感器节点通信范围交叠情况划分的子区域。

Note:1-7is a sub-region divided by overlapping communication ranges of the sensor nodes.

图6 数据采集子区域的划分示意图

Fig.6 Schematic diagram of data collection subarea division

式中为负常数。

另外,为避免无人机耗尽电量,在数据采集过程中,若无人机出现电量不足的情况也给出惩罚:

式中为负常数。

2.3.3 基于OnDQN的最优航迹规划

无人机悬停点距离传感器位置越远,数据传输速率越低,悬停时间就越长。选定无人机的最优采集子区域后,需对子区域的采集顺序和悬停位置进行决策,以平衡无人机的飞行距离与悬停时间,从而最大限度地减少无人机能耗。在该问题中,无人机动作空间包括飞向某一子区域、悬停在子区域某个位置、数据采集3个动作,本文采用基于选项(option)的分层强化学习思想来解决该问题[15,27],将状态空间、动作空间、奖励函数以及option建模如下:

当奖励函数为稀疏奖励时,可能会导致算法学习效率低,甚至难以收敛[28]。本文采用n-step回报代替1-step回报来加快算法迭代速度[29]。定义n-step回报函数为

需要说明的是,本文的研究基于一些假设前提:假定无人机匀速飞行,没有考虑从悬停到起飞以及飞行到悬停的速度变化过程的能量消耗变化;假定无人机从一个位置到另一个位置是直线飞行,实际应用中还需考虑无人机的转向问题。

3 仿真分析

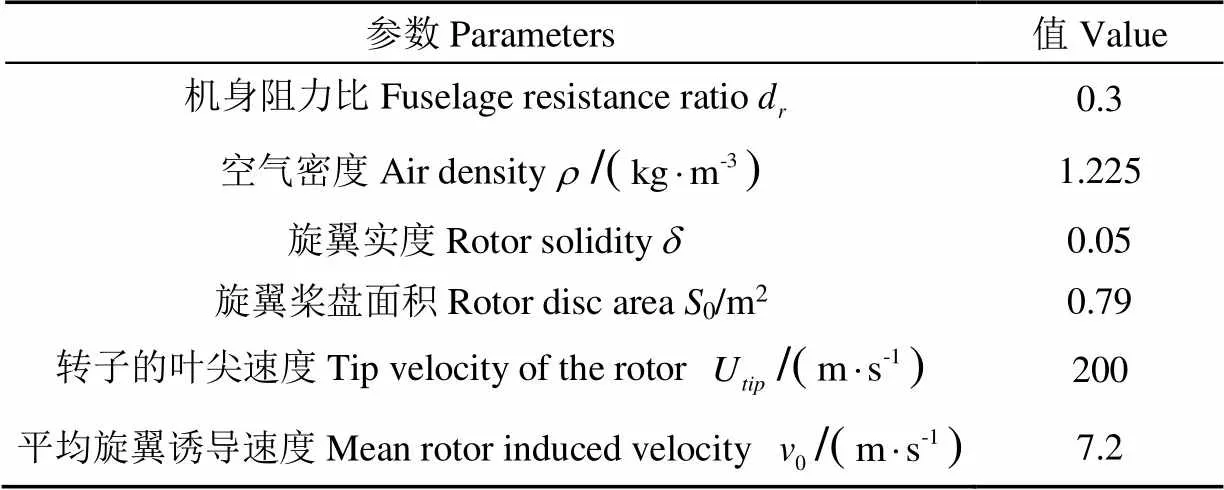

为验证节点数据采集算法的有效性,分别在冗余覆盖下部分节点数据采集场景和全节点数据采集场景进行仿真试验,试验在windows10系统下进行,处理器为AMD Ryzen 5 2500U,频率为2.0 GHz。网络架构使用谷歌的开源Tensorflow模块构建,利用Python搭建深度强化学习仿真环境。表1为旋翼无人机的功率模型参数。

表1 旋翼无人机参数

3.1 冗余覆盖下部分节点数据采集场景的仿真分析

仿真假设在640 m×640 m的农田随机均匀部署20个无线传感器节点,每个节点的感知覆盖半径均为80 m,无人机飞行速度为5 m/s,飞行高度为10 m,每个传感器存储的数据为160 kB。经平衡运算复杂度和优化结果,将农田离散为40 m×40 m的网格,共计256个网格单元。以覆盖率和有效覆盖平均能耗评估算法性能,定义如下:

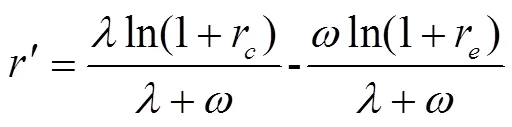

根据式(12)设置奖励函数,在实际训练过程中发现,负向奖励的取值范围远大于正向奖励,导致正向激励几乎不起作用。为此使用对数函数变换对原始奖励计算结果进行归一化处理:

图8为以最佳配置4作为奖励函数调节因子时,DDDQN算法与DQN算法的学习差异。DDDQN的学习过程比DQN更稳定,在学习结束时获得更高的周期奖励。在调节因子配置4下DDDQN算法每个episode可获得12的累积奖励,而DQN最多只能获得9的累积奖励。

表2 调节因子配置

注:,为奖励函数的调节因子,2为调节因子配置组编号。

图7 不同调节因子配置下的覆盖率与有效覆盖平均能耗

图8 DDQN和DQN算法的训练奖励值对比

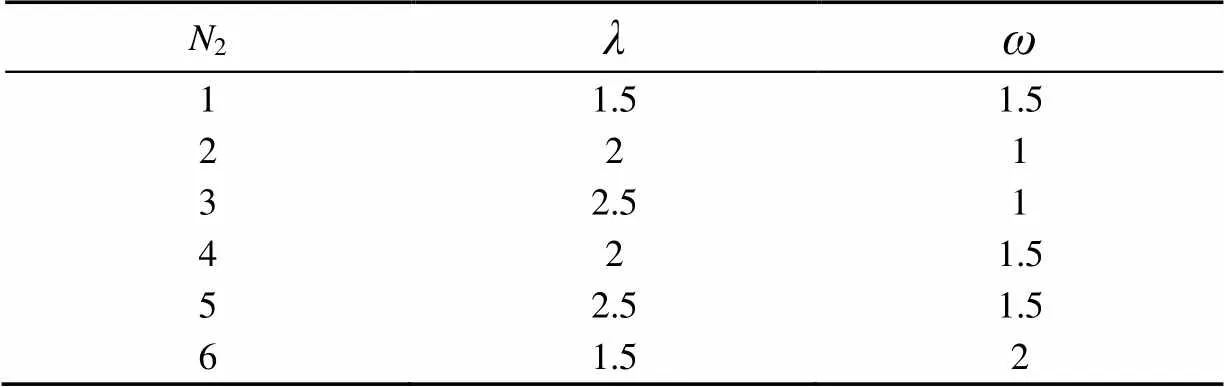

图9为采集节点覆盖率超过80%时DDDQN和DQN算法的无人机数据采集方案。经计算,DDDQN算法的飞行距离为3.13 km,相比DQN算法的4.34 km,无人机能耗减少了27.9%,飞行距离缩短1.21 km。根据式(19)~(20)计算可得,DDDQN相比DQN的有效覆盖平均能耗降低了26.3%。

图9 DDDQN和DQN算法的数据采集方案

3.2 全节点数据采集场景的仿真与结果分析

在仿真中,假设无线传感器节点随机分布在600 m×600 m的矩形区域内,将该矩形区域划分为15 m×15 m的网格。设置矩形区域左下角为无人机的飞行起点,飞行高度为10 m;无人机与传感器节点间单位距离(1 m)的信噪比=34 dB;通信带宽=10 kHz。

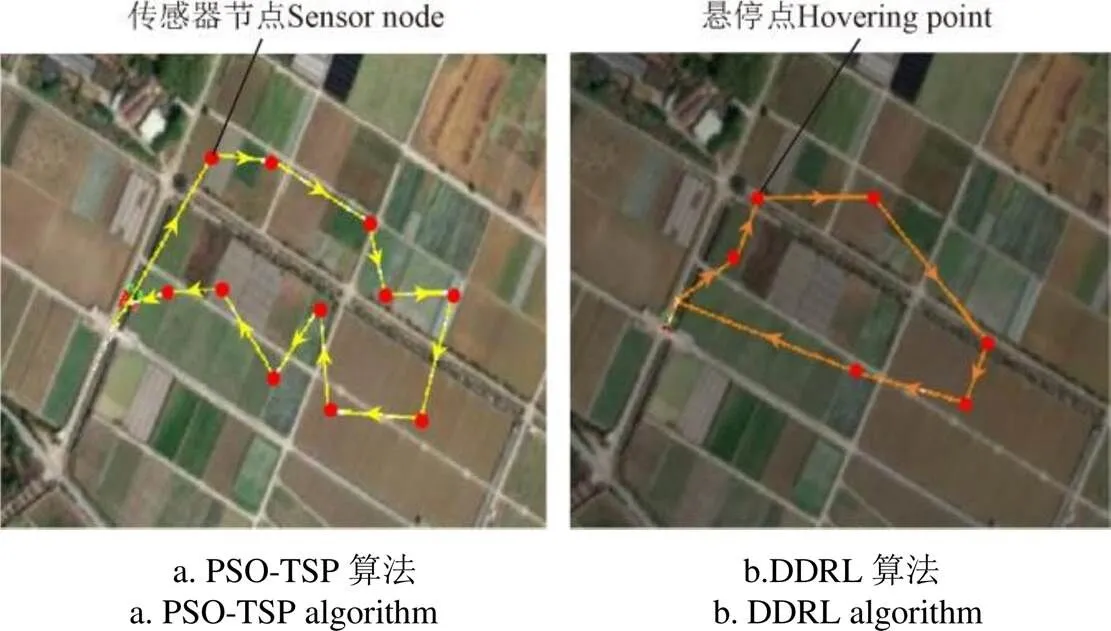

图10是不同条件下本文DDRL算法与经典PSO-TSP算法的结果对比。PSO-TSP算法是在Chen[30]等提出的IGA方法的基础上提出来的。PSO-TSP算法要求无人机遍历每个节点,在每个节点正上方悬停采集数据。

图10a是无人机的飞行速度对总能耗和总工作时间的影响。在仿真中设置20个传感器,每个传感器储存的数据为160 kB,通信半径为80 m。对于2种算法来说,飞行速度的增加都会减小无人机的总能耗和工作时间。在相同速度下,DDRL算法比PSO-TSP算法的能耗更低,当速度较低时DDRL算法优势更明显,无人机飞行速度为5 m/s时,相比PSO-TSP,采用DDRL算法的无人机总能耗减少7.8%,工作时间减少9.2%。

图10b为节点数据负载量对无人机能耗的影响。仿真中传感器节点数设置为20个,传感器的通信半径分别设为60 和80 m。从图10b中可以看出,本文DDRL算法在节点数据量较少(少于160 kB)的情况下比PSO-TSP算法的能耗低;通信半径60 m时DDRL算法的优势较80 m更明显。节点数据量变大后,相比PSO-TSP算法在节点正上方采集数据(距离近采集时间短),DDRL算法在每个悬停点采集多个节点数据,由于有些节点的距离远导致采集时间延长,导致悬停时间和能耗加大,总能耗超过PSO-TSP算法,通信范围大时更加明显。随着节点数据量增加,无人机飞行能耗占比减少,这是因为无人机悬停能耗增加。同等数据量前提下,DDRL算法的飞行能耗占比比PSO-TSP算法低,节点通信距离80 m时的飞行能耗占比比60 m时低,即悬停能耗占比高。

图10c是飞行速度对无人机悬停采集时间的影响。设置节点的水平通信距离为80 m,节点数据量为160 kB。由于PSO-TSP算法中无人机悬停在每个传感器正上方采集数据,数据传输距离近,故其悬停采集时间最低且不受飞行速度影响。而在DDRL算法中,悬停采集时间随着飞行速度的增加而减少,这是因为DDRL算法通过悬停点选择和采集顺序决策来优化总能耗,飞行速度增加,飞行能耗变小,此时悬停能耗成为影响总能耗的主要因素。

图10d为水平通信距离60 m、节点数据量160 kB时传感器节点个数对总能耗的影响。将本文DDRL算法与PSO-TSP及MEFC(Minimized Energy Flight Control)算法[31对比可知,MEFC算法考虑了无人机的飞行速度与转弯角度对能耗的影响,找到最优飞行速度并优化了飞行轨迹,将悬停点规划在传感器传输范围边缘,使无人机以低能耗完成数据采集。从图10d中可以看出,PSO-TSP的无人机总能耗最大,这是因为无人机需要飞到每个传感器节点正上方采集数据,由于飞行路径增加使其飞行能耗大大增加。MEFC算法规划的悬停点均在传感器传输范围边缘,且未考虑传输范围重叠的情况,虽然减少了飞行距离和飞行能耗,但增加了悬停点的数据传输时间,即增加了悬停时间和悬停能耗。随着节点数量的增加,3种算法的总能耗都增加。因此在数据量不大的情况下,本文DDRL算法的总能耗较另两种算法更具优势。

DDRL: Double Deep Reinforcement Learning; PSO-TSP: Particle Swarm Optimization-Traveling Salesman Problem; MEFC: Minimized Energy Flight Control; 60,80: Horizontal communication distance, m.

4 全节点数据采集算法的田间试验与结果分析

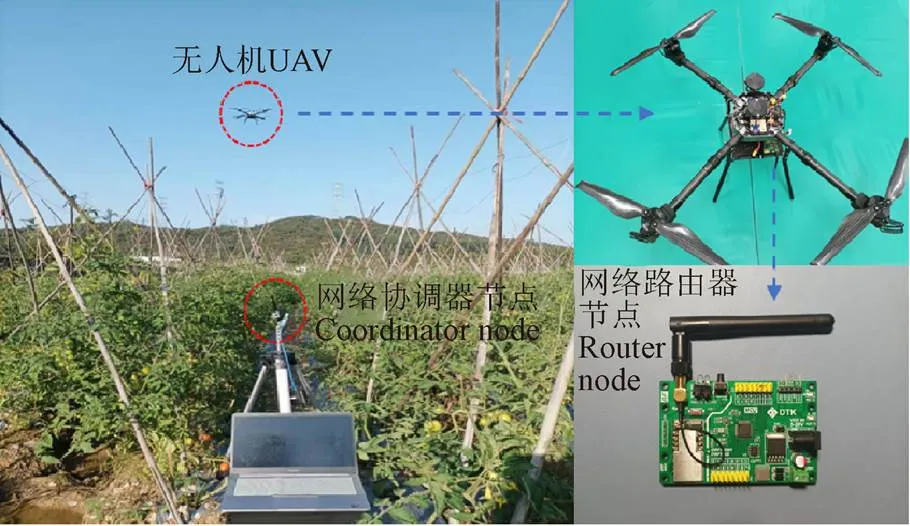

针对全节点数据采集场景,本研究通过田间试验对所提方法进行评估并验证其可行性。试验在广州华南农业大学增城教研基地开展,采用自制的四旋翼无人机在210 m×400 m的平坦农田中进行测试,无人机飞行高度为5 m。为了验证无人机接收数据的丢包率,同时对田间的通信路径损耗进行估测,以更精确地计算无人机悬停时间,利用2个DRF1609H型Zigbee模块测试无人机接收模块与地面数据发送模块之间的丢包情况和接收信号强度值,其中地面数据发送模块由Zigbee通信模块与单片机STM32组成,DRF1609H型Zigbee模块的发送功率为22 dbm。

如图11所示,无人机从地面节点正上方开始,每隔10 m水平距离,到与节点水平距离120m为止,当地面节点接收到无人机的数据请求后,发送200个数据包,每个数据包的长度为0.5 kB,丢包率测试结果如表3所示。接收信号强度值取每个位置采集10次数据的接收信号强度平均值。

图11 田间试验

从表3中可以看出,在水平通信距离80 m以外,随着测试距离的增加,丢包率增加,80 m以内范围满足数据传输稳定性要求。

表3 水平通信距离对丢包率的影响

采用MATLAB中的曲线拟合方法对路径损耗模型进行评估,确定水平通信距离与接收信号强度值之间的关系。如图12所示,经过多次试验发现,指数函数的拟合效果最佳,田间ZigBee传输的接收信号强度值RSSI与水平通信距离的关系为

为了进一步评估所提算法对无人机能耗优化的效果,在无人机上配备电流计模块获取瞬时电流并计算无人机能耗。首先测试无人机的飞行功率和悬停功率,测试方案如下:无人机以5 m/s速度和5 m高度进行匀速直线飞行100 m,利用每隔0.1 s获取的瞬时电流和电压计算无人机的飞行功率。同理,计算单位时间内无人机的悬停能耗。经过实际测试,本试验所采用的四旋翼无人机的平均飞行功率为746.38 W,平均悬停功率为771.86 W,无人机电池的最大容量为22 000 mAh。

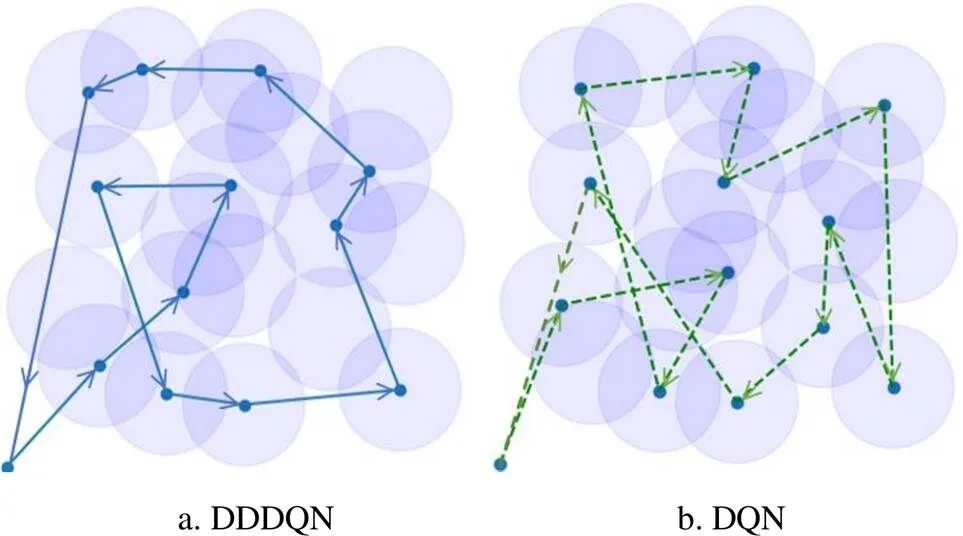

最后,在田间随机布置11个Zigbee模块模拟节点,结合田间路径损耗模型,运行算法得到DDRL算法及PSO-TSP算法规划的悬停点、悬停时间及采集顺序,然后令无人机按照规划方案进行数据采集试验。设置节点数据量为160 kB,数据包长度为0.5 kB,无人机飞行高度5 m,飞行速度5 m/s。图13a为PSO-TSP算法的飞行路径;图 13b为本文算法DDRL优化的悬停点和飞行路径。最终的试验结果表明,DDRL算法的无人机总能耗为354.56 kJ,飞行距离为1 189.23 m,丢包率为0.28%;PSO-TSP算法的总能耗为400.83 kJ,飞行距离为1 556.21 m,丢包率为0.15%。相比PSO-TSP,DDRL算法的总能耗减少了11.5%,飞行路径减少了366.98 m;DDRL算法的丢包率略高于PSO-TSP算法,这是因为DDRL算法的规划方案中无人机悬停采集点不在节点正上方,且在一个悬停点采集多个节点数据,而PSO-TSP算法的规划方案中无人机悬停在节点正上方采集数据,丢包概率降低。

图13 PSO-TSP和DDRL算法无人机悬停点及数据采集顺序示意图

5 结 论

利用无人机采集田间无线传感器节点数据,能克服农田无网络基础设施及节点多跳转发数据耗电快、网络生命周期短的问题。本研究将节点采集的情况分为感知冗余覆盖下部分节点数据采集及全节点数据采集两个场景,基于深度强化学习规划无人机的节点选择、悬停位置及采集顺序,以节省无人机能耗缩短任务完成时间。感知冗余覆盖下部分节点数据采集方案适用于节点间冗余覆盖面积比例比较高,无人机能量无法完成所有节点的数据采集任务,以及对数据的完整性要求不高的应用场景;全节点数据采集方案适用于对数据有完整性要求的应用场景。通过对研究结果的分析,得到以下结论:

1)在考虑感知冗余覆盖下部分节点数据采集场景中,采用竞争双重深度Q网络(DDDQN)算法选择采集节点及规划采集顺序,提高了无人机的能效和减少了冗余数据的采集。仿真验证了在相同配置下,DDDQN算法比DQN算法的覆盖率和平均能耗更优,算法性能更加稳定;在相同的覆盖率要求下,DDDQN算法比DQN算法的飞行距离缩短了1.21 km,能耗减少了27.9%。

2)在全节点数据采集场景中,提出了两级深度强化学习(DDRL)算法对无人机的悬停位置及采集顺序进行优化,减少了无人机完成任务时的总能耗。本文从传感器不同数据负载量、无人机飞行速度、传感器节点数量对DDRL与PSO-TSP及MEFC算法的总能耗、总时间、飞行能耗占比、悬停采集时间进行仿真对比,结果证明无人机采用DDRL算法采集数据的总能耗最低。最后,通过田间试验测试了四旋翼无人机的飞行功率与悬停功率,并对DDRL算法及经典PSO-TSP算法的采集方案进行了实际田间飞行试验。结果表明,DDRL算法能同时考虑飞行距离与数据传输时间两个因素,在采集相同的数据情况下较PSO-TSP算法能耗降低了11.5%。

[1] García L, Parra L, Jimenez J M, et al. DronAway: A proposal on the use of remote sensing drones as mobile gateway for WSN in precision agriculture[J]. Applied Sciences, 2020, 10(19): 6668.

[2] 宋成宝,柳平增,刘兴华,等. 基于HSIC的日光温室温度传感器优化配置策略[J]. 农业工程学报,2022, 38(8):200-207.

Song Chengbao, Liu Pingzeng, Liu Xinghua, et al. Optimal configuration strategy for temperature sensors in solar greenhouse based on HSIC[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(8): 200-207. (in Chinese with English abstract)

[3] Bandur D, Jaksic B, Bandur M, et al. An analysis of energy efficiency in Wireless Sensor Networks (WSNs) applied in smart agriculture[J]. Computers and Electronics in Agriculture, 2019, 156: 500-507.

[4] Polo J, Hornero G, Duijneveld C, et al. Design of a low-cost wireless sensor network with UAV mobile node for agricultural applications[J]. Computers and Electronics in Agriculture, 2015, 119: 19-32.

[5] Zhang B T, Meng L Y. Energy efficiency analysis of wireless sensor networks in precision agriculture economy[J]. Scientific Programming, 2021, 2021: 8346708.

[6] Huang S C, Chang H Y. A farmland multimedia data collection method using mobile sink for wireless sensor networks[J]. Multimedia Tools and Applications, 2017, 76(19): 19463-19478.

[7] Singh P K, Sharma A. An intelligent WSN-UAV-based IoT framework for precision agriculture application[J]. Computers and Electrical Engineering, 2022, 100: 107912.

[8] Yemeni Z, Wang H, Ismael W M, et al. Reliable spatial and temporal data redundancy reduction approach for WSN[J]. Computer Networks, 2021, 185: 107701.

[9] Kumar S, Chaurasiya V K. A strategy for elimination of data redundancy in internet of things (IoT) based wireless sensor network(WSN)[J]. IEEE Systems Journal, 2018, 13(2): 1650-1657.

[10] Rezende J D V, da Silva R I, Souza M J F. Gathering big data in wireless sensor networks by drone(dagger)[J]. Sensors, 2020, 20(23): 6954.

[11] Luo C W, Chen W P, Li D Y, et al. Optimizing flight trajectory of UAV for efficient data collection in wireless sensor networks[J]. Theoretical Computer Science, 2021, 853: 25-42.

[12] Ben Ghorbel M, Rodríguez-Duarte D, Ghazzai H, et al. Joint position and travel path optimization for energy efficient wireless data gathering using unmanned aerial vehicles[J]. IEEE Transactions on Vehicular Technology, 2019, 68(3): 2165-2175.

[13] Gong J, Chang T H, Shen C, et al. Flight time minimization of UAV for data collection over wireless sensor networks[J]. IEEE Journal on Selected Areas in Communications, 2018, 36(9): 1942-1954.

[14] Just G E, Pellenz M E, Lima L A D, et al. UAV path optimization for precision agriculture wireless sensor networks[J]. Sensors, 2020, 20(21): 6098.

[15] Zhang Y, Mou Z Y, Gao F F, et al. Hierarchical deep reinforcement learning for backscattering data collection with multiple UAVs[J]. IEEE Internet of Things Journal, 2021, 8(5): 3786-3800.

[16] 蒋宝庆,陈宏滨. 基于Q学习的无人机辅助WSN数据采集轨迹规划[J]. 计算机工程,2021,47(4):127-134.

Jiang Baoqin, Chen Hongbin. Trajectory planning for unmanned aerial vehicle assisted WSN data collection based on Q-Learning[J]. Computer Engineering, 2021, 47(4): 127-134. (in Chinese with English abstract)

[17] Yi M J, Wang X J, Liu J, et al. Deep reinforcement learning for fresh data collection in UAV-assisted IoT networks[C]//IEEE INFOCOM 2020-IEEE Conference on Computer Communications Workshops (INFOCOM WKSHPS). Toronto, ON, Canada: IEEE, 2020: 716-721.

[18] 付澍,杨祥月,张海君,等. 物联网数据收集中无人机路径智能规划[J]. 通信学报,2021,42(2):124-133.

Fu Shu, Yang Xiangyue, Zhang Haijun, et al. UAV path intelligent planning in IoT data collection[J]. Journal on Communications, 2021, 42(2): 124-133. (in Chinese with English abstract)

[19] Zeng Y, Xu J, Zhang R. Energy minimization for wireless communication with Rotary-Wing UAV[J]. IEEE Transactions on Wireless Communications, 2019, 18(4): 2329-2345.

[20] Padakandla S. A survey of reinforcement learning algorithms for dynamically varying environments[J]. ACM Computing Surveys, 2021, 54(6): 127.

[21] 陈佳盼,郑敏华. 基于深度强化学习的机器人操作行为研究综述[J]. 机器人,2022,44(2):236-256.

Chen Jiapan, Zheng Minhua. A survey of robot manipulation behavior research based on deep reinforcement learning[J]. Robet, 2022, 44(2): 236-256. (in Chinese with English abstract)

[22] Fenjiro Y, Benbrahim H. Deep reinforcement learning overview of the state of the art[J]. Journal of Automation, Mobile Robotics and Intelligent Systems, 2018, 12: 20-39.

[23] 张自东,邱才明,张东霞,等. 基于深度强化学习的微电网复合储能协调控制方法[J]. 电网技术,2019,43(6):1914-1921.

Zhang Zidong, Qiu Caiming, Zhang Dongxia, et al. A coordinated control method for hybrid energy storage system in microgrid based on deep reinforcement learning[J]. Power System Technology, 2019, 43(6): 1914-1921. (in Chinese with English abstract)

[24] Zhang W Y, Gai J Y, Zhang Z G, et al. Double-DQN based path smoothing and tracking control method for robotic vehicle navigation[J]. Computers and Electronics in Agriculture, 2019, 166: 104985.

[25] Wang Z Y, Schaul T, Hessel M, et al. Dueling network architectures for deep reinforcement learning[C]. //In Proceedings of the 33rd International Conference on International Conference on Machine Learning. New York, NY, USA: ICML, 2016: 1995-2003.

[26] Kumar H, Mammen P M, Ramamritham K. Explainable AI: deep reinforcement learning agents for residential demand side cost savings in smart grids[J]. arXiv e-prints, 2019: 1910. 08719.

[27] 赵铭慧,张雪波,郭宪,等. 基于分层强化学习的通用装配序列规划算法[J]. 控制与决策,2022,37(4):861-870.

Zhao Minghui, Zhang Xuebo, Guo Xian, et al. A general assembly sequence planning algorithm based on hierarchical reinforcement learning[J], Control and Decision, 2022, 37(4): 861-870. (in Chinese with English abstract)

[28] 杨惟轶,白辰甲,蔡超,等. 深度强化学习中稀疏奖励问题研究综述[J]. 计算机科学,2020,47(3):182-191.

Yang Weiyi, Bai Chenjia, Cai Chao, et al. Survey on sparse reward in deep reinforcement learning[J]. Computer Science. 2020, 47(3): 182-191. (in Chinese with English abstract)

[29] Hernandez-Garcia J F, Sutton R S. Understanding multi-step deep reinforcement learning: A systematic study of the DQN target[J]. arXiv e-prints, 2019:1901. 07510.

[30] Chen J, Ye F, Li Y B. Travelling salesman problem for UAV path planning with two parallel optimization algorithms[C]//2017 Progress in Electromagnetics Research Symposium-Fall(PIERS-FALL). Singapore, 2017: 832-837.

[31] 吴媚. 工业物联网环境下面向能耗优化的无人机飞行规划系统设计与实现[D]. 南京:东南大学,2019.

Wu Mei. Energy Efficient UAV Flight Planning System for the Industrial IoT Environment[D]. Nanjing:Southeast University, 2019. (in Chinese with English abstract)

UAV collection methods for the farmland nodes data based on deep reinforcement learning

Hu Jie1,3, Zhang Yali2,3※, Wang Tuan1, Wang Mengcheng1, Lan Yubin1,3, Zhang Zhixun2

(1.,,510642,; 2.,,510642,; 3.,510642,)

Unmanned Aerial Vehicle (UAV) has been widely used to collect data from the wireless sensor node in fields. Some problems can be solved in this case, such as no network infrastructure in farmland, fast power consumption of multi-hop data forwarding, premature death of nodes near the gateway, and shortened network life cycle. However, the multiple nodes overlapping can often occur during UAVs collection at the same time, due to the possible redundancy of adjacent sensor data. In this study, a UAV data collection method was proposed to plan the node selection, hovering position, and collecting order using improved deep reinforcement learning. The UAV data collection from the sensor nodes was then divided into two scenarios: data collection from the partial nodes under perceptual redundancy coverage, and data collection from all nodes. The optimization was made to save the UAV energy consumption in less mission completion time. The data collection of partial nodes under perceived redundancy coverage was suitable for the relatively high proportion of redundant coverage area among nodes. The UAV energy also failed to complete the data collection tasks of all nodes, indicating the low requirements of data integrity. By contrast, the all-node data collection fully met the high requirement of data integrity. In the scenario of partial node data collection with perceived redundant coverage, the Dueling Double Deep Q Network (DDDQN) was used to select the collection nodes and then plan the collecting order, indicating the high energy efficiency of the UAV with the less redundant data. Simulation results show that the DDDQN presented greater data coverage and lower effective coverage average energy consumption than the Deep Q Network (DQN) under the same configuration. The training process of DDDQN was more stable than that of DQN, particularly for the higher returns at the end of learning. More importantly, the flight distance and energy consumption of the DDDQN were reduced by 1.21 km, and 27.9%, respectively, compared with the DQN. In the scenario of all-node data collection, a Double Deep Reinforcement Learning (DDRL) was proposed to optimize the hovering position and UAV collection sequence, in order to minimize the total energy consumption of the UAV during data collection. A comparison was made on the DDRL with the classical PSO-TSP and MEFC. A systematic evaluation was made to clarify the impact of the UAV flight speed on the total energy consumption and total working time, the impact of different node data loads on the UAV energy consumption, the impact of different flight speeds on the UAV hover collection time, and the impact of the number of sensor nodes on the total energy consumption. The simulation results show that the total energy consumption of the improved model was at least 6.3% less than that of the classical PSO-based Travel Salesman Problem (PSO-TSP), and the Minimized Energy Flight Control (MEFC) under different node numbers and UAV flight speeds, especially at the data load of a single node less than 160 kB. Finally, the flight and hover powers of the quadrotor UAV were tested to determine the packet loss rate and received signal strength of the UAV in the field experiments. The actual field flight experiments were carried out on the DDRL and the data collection of the classical PSO-TSP. Field experiment results show that the DDRL-based data collection was reduced by 11.5% for the total energy consumption of UAV, compared with the PSO-TSP. The DDDQN and DDRL approaches can be expected to provide the optimal energy consumption for the UAVs' data collection of wireless sensor nodes in the field.

UAV; deep reinforcement learning; node data collection; perceptual redundancy; DQN; DRL

10.11975/j.issn.1002-6819.2022.22.005

S126;S-3

A

1002-6819(2022)-22-0041-11

胡洁,张亚莉,王团,等. 基于深度强化学习的农田节点数据无人机采集方法[J]. 农业工程学报,2022,38(22):41-51.doi:10.11975/j.issn.1002-6819.2022.22.005 http://www.tcsae.org

Hu Jie, Zhang Yali, Wang Tuan, et al. UAV collection methods for the farmland nodes data based on deep reinforcement learning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(22): 41-51. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2022.22.005 http://www.tcsae.org

2022-07-21

2022-10-27

高等学校学科创新引智计划项目(D18019);国家自然科学基金项目(32271997);广东省重点领域研发计划项目(2019B020221001);广东省科技计划项目(2018A050506073)

胡洁,博士,副教授,研究方向为农业人工智能,农业物联网。Email:hjgz79@scau.edu.cn

张亚莉,博士,副教授,研究方向为农业航空传感器技术与农产品产地环境监测。Email:ylzhang@scau.edu.cn