基于集成策略的接触网区域鸟窝智能识别方法

刘 鹏

0 引言

接触网是沿铁路线路架设的向电力机车供电的输电线路,主要由基础与支柱、支持装置、接触悬挂装置、定位装置等部分组成[1]。因为接触网的结构特点,每年3~5月,鸟类经常在接触网隔离开关底座、硬横梁、钢柱等处修筑鸟巢,而鸟类筑巢的树枝、金属线等材料极易造成线路短路、电气控制部件损坏、跳闸、机械补偿装置失灵等安全隐患,严重影响了行车安全[2]。目前,对接触网区域鸟窝的检测、识别主要依靠人工分析视频监控图像并判断和标记,这种由人工进行的图像甄别工作量大、效率低,而且可靠性和准确率也很难保证。 为了解决这一问题,文献[3~6]提出通过分析接触网沿线的车载视频,再根据一定的先验知识建立特征模型来完成接触网区域巡检中鸟窝的非接触式识别检测。近年来,基于深度卷积网络的人工智能技术能够在大量视频图像中快速确定含有特 定目标的图像,然后对该图像中目标区域进行定位、识别。文献[7]利用SSD网络及迁移学习技术完成对鸟窝的识别。文献[8]运用Faster R-CNN模型对鸟窝进行自动识别。文献[9]首先基于LSD直线段检测算法获取鸟巢可能出现的区域,然后运用YOLO v3网络对可能区域进行鸟窝自动识别。虽然上述方法针对接触网区域中的鸟窝识别取得了一定的效果,但针对成像条件复杂情况下的接触网区域鸟窝识别的效果有限,难以同时兼顾正常成像、成像质量不佳、有雾天气、图像部分曝光、部分鸟窝被器件遮挡等不同成像状态下的接触网区域鸟窝智能识别任务。为了解决这一问题,本文提出一种基于YOLO-v5检测模型与Inception v4识别模型多模型融合的接触网区域鸟窝智能识别方法。

1 接触网区域鸟窝样本图像集构建

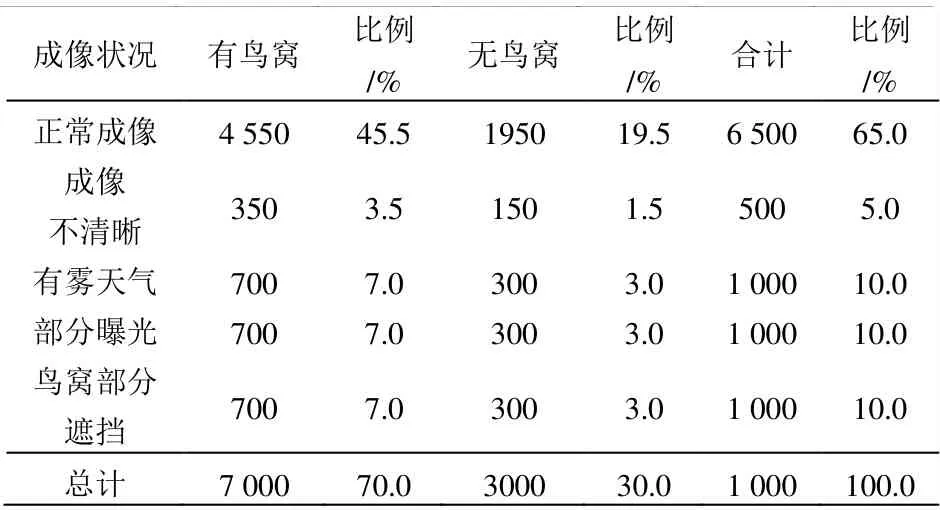

构建接触网区域鸟窝样本图像集是通过深度学习技术实现鸟窝智能识别的基础。由于接触网线路巡检图像中存在正常成像、成像质量不佳、有雾天气、部分曝光、鸟窝被部分遮挡等多种不同成像情况,因此,在收集样本构建接触网区域鸟窝样本图像集时必须考虑上述因素。选取接触网悬挂状态监测系统不同场景下的鸟窝拍摄图像构建鸟窝样本图像集。样本集包含10000幅接触网巡检图像,其中,包含鸟窝的图像7000幅,不包含鸟窝的图像3000幅,鸟窝样本图像集的像素均为2448×2050,其成像状况分布如表1所示。

表1 鸟窝样本图像统计

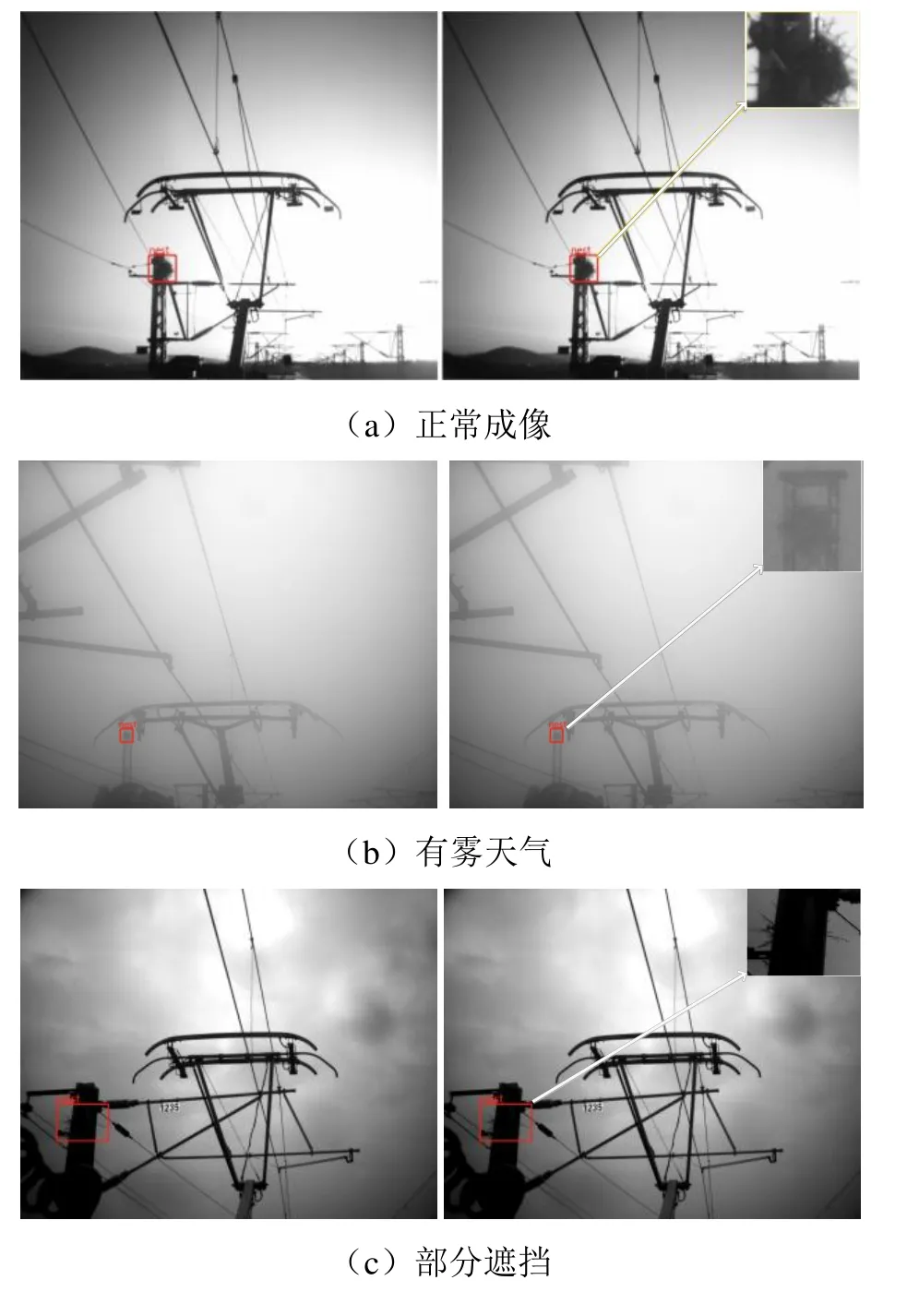

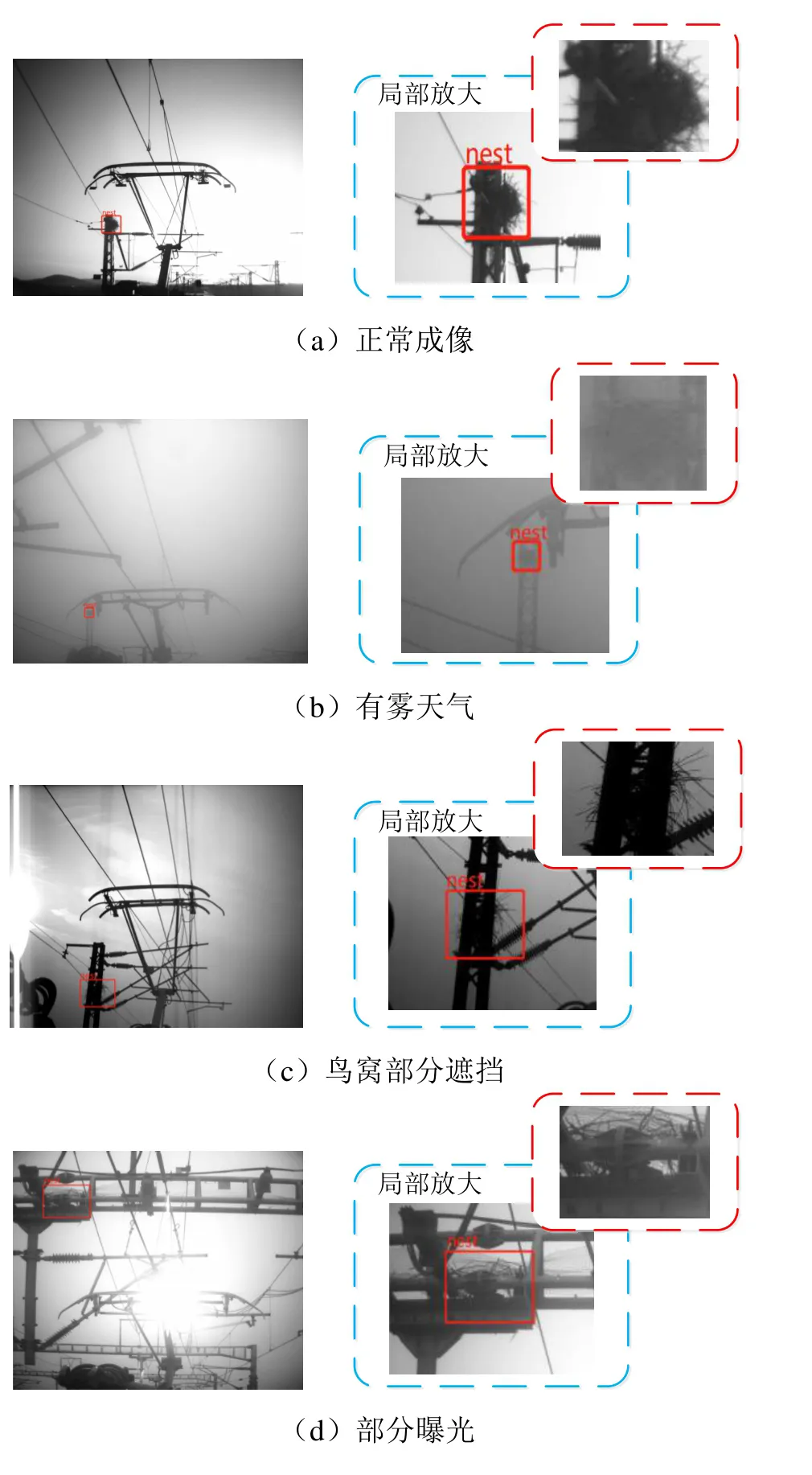

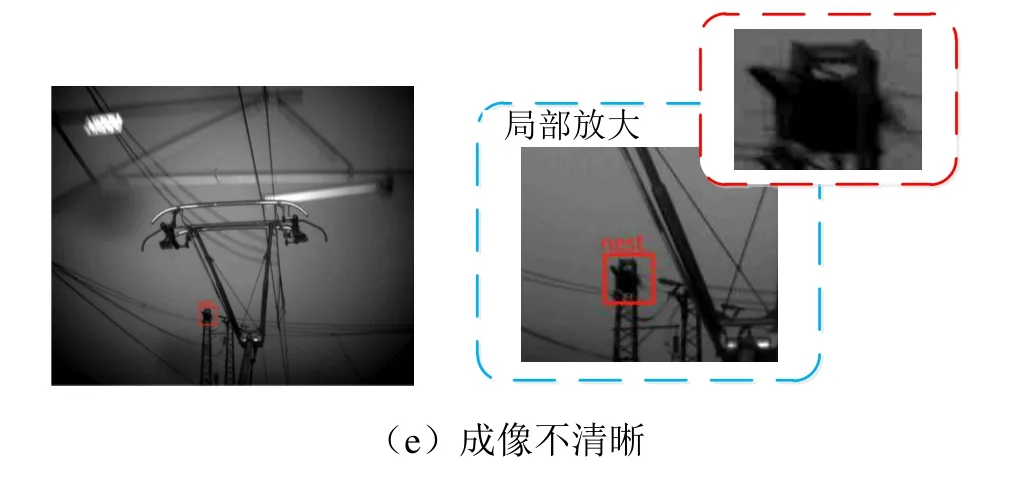

对样本集中的图像进行标注时,首先由专业巡检人员对接触网区域中是否存在鸟窝进行判断。若存在鸟窝,则利用标注工具在鸟窝出现处绘制矩形标记框,并标记nest类型。部分样本图像标注示例如图1所示,包含了正常成像、有雾天气、部分遮挡、部分曝光、成像不清晰等不同成像状况。

图1 典型样本图像及其标注示例

2 接触网区域鸟窝智能识别方法

2.1 识别流程

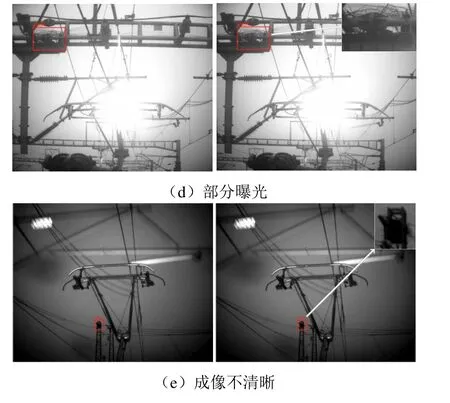

本文所述接触网区域鸟窝智能检测识别流程如图2所示。首先将前端采集的接触网图像经过预处理,缩放至长宽均为640像素,再分别由YOLO- v5的深层、浅层模型进行鸟窝初步检测;然后将两个模型检测结果通过IOU指标进行融合;最后将融合结果经Inception v4模型进行精确识别,从而完成接触网区域鸟窝的智能识别。

图2 接触网区域鸟窝智能识别流程

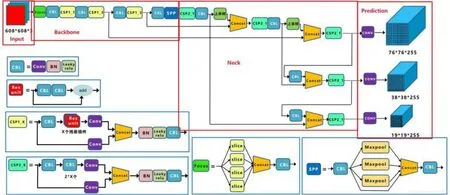

2.2 YOLO-v5深层模型与浅层模型

YOLO-v5[10]模型融合了CSP Darknet53[11]、PANET(路径聚合网络)[12]和SPP(空间金字塔池化)[13]等结构,不仅在对象检测方面表现出色,而且YOLO-v5s的模型推理速度更是达到了140 F/s。目前,该系列有4个模型(YOLO-v5s、YOLO-v5m、YOLO-v51、YOLO-v5x),YOLO-v5s模型网络在YOLO-v5系列中深度最小、特征图宽度最小。针对真实数据,考虑到鸟窝的多样性,选择了网络最小、速度最快的YOLO-v5s模型作为鸟窝初步检测的浅层模型,模型结构如图3所示,其中有4个由红色框标记的结构区域,从左到右分别是Input、Backbone、Neck、Prediction区域。

图3 YOLO-v5s模型架构

模型输入端包含Mosaic数据增强、自适应锚框计算两部分。前者通过随机缩放、裁剪、排布对图像进行拼接,增加样本库中小目标样本,提升检测性能,自适应锚框计算。针对不同数据集,模型将设定一个初始长宽的锚框,在网络训练中,网络在初始锚框的基础上输出预测框,进而与真实框Groundtruth进行比对,计算两者差距,再反向更新,自适应计算不同训练集中的最佳锚框值。Backbone包含Focus结构和CSP结构,Focus结构提供切片操作,CSP结构将梯度变化完整地集成到特征图中,减少模型参数量和Flops数值,既保证推理速度、准确率,又减小了模型尺寸。Neck用于生成特征金字塔,增强了模型对于不同缩放尺度对象的检测。Prediction用于最终检测,在特征图上应用锚定框,并生成带有类概率、对象得分和包围框的最终输出向量。

深层模型选择YOLO-v5l模型,其与YOLO- v5s最大的不同在于网络结构中CSP1和CSP2 block深度的不同。

2.3 检测模型集成策略

为提升接触网区域鸟窝的检出率,使两个检测模型实现检测结果互补,本文采用IOU将两种模型检测的结果进行融合,IOU参数的计算式为

式中:Boxs表示浅层模型的检测框,Boxl表示深层模型的检测框。当IOU大于设定阈值(本文取0.5)时,将融合两检测框后再输出,否则将两个独立检测框均作为输出。

2.4 融合结果精确识别

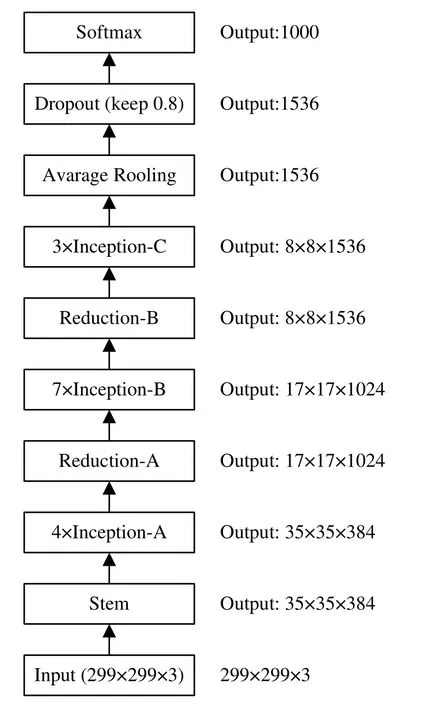

为得到更准确的识别结果,将融合后检测框尺寸统一缩放为长、宽均为128像素的图像块(超过128则进行缩小,不足128则用灰度值为0的像素补齐),然后利用Inception v4模型[14]进行精确识别。

Inception v4模型架构如图4所示。其中,Stem部分运用多次卷积和2次池化来防止瓶颈问题,之后共使用3种14个Inception模块,3种Inception模块间的Reduction模块起到池化作用,同时使用了Inception v4模块的并行结构来防止瓶颈问题的发生。

图4 Inception v4模型架构

3 实验及分析

3.1 实验设置

采用本文表1所示样本图像数据集进行了相关实验,并将数据样本图像统一缩放到640×640。

3.2 模型训练

分别利用本文第1节构建的样本图像数据集进行YOLO-v5s和YOLO-v5l模型训练与测试。首先将数据样本按8∶2的比例随机分成训练集、测试集,并对训练集进行水平镜像。模型训练时优化器选择Adam,batch size设置为64,训练轮数epochs设置为200,学习率设置为0.001。两个检测网络均载入COCO数据集的预训练权重,并保留在训练集上获得的最优模型。Inception v4模型[15]载入ImageNet数据集上的预训练权重,然后进行鸟窝、非鸟窝二分类训练,训练集、测试集样本均来自检测模型融合结果中的真实鸟窝、非鸟窝检测框,并按照8∶2比例划分训练集、测试集。对训练集图像进行水平镜像,训练时batch size设为32,训练轮数epochs设置为100,学习率设为0.001。

3.3 实验结果及分析

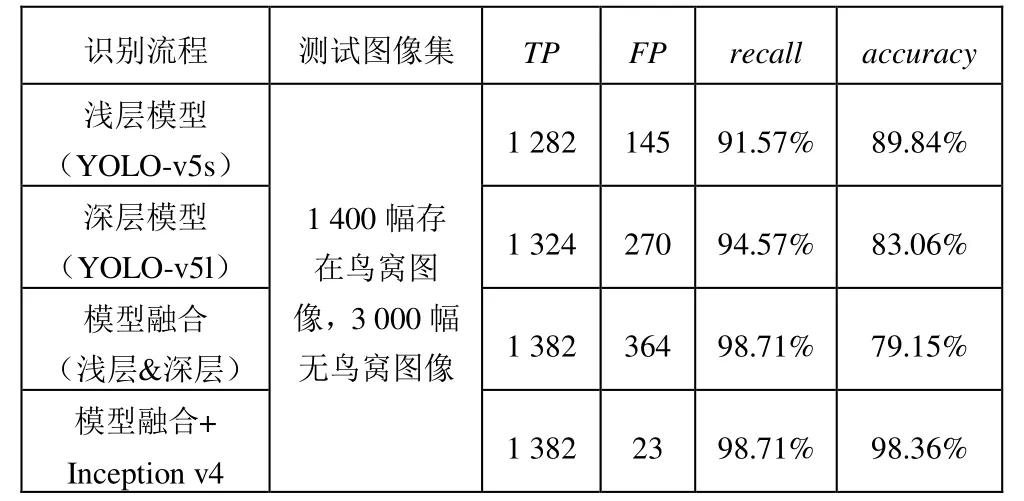

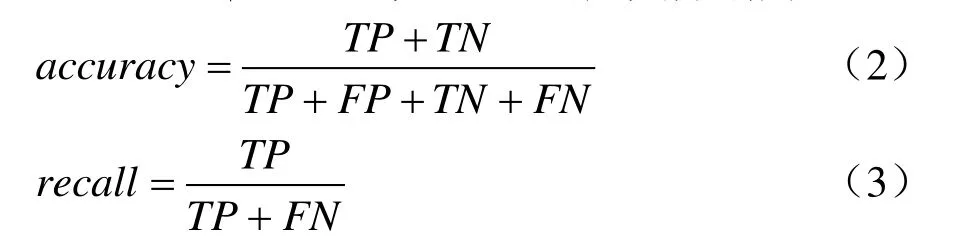

该实验流程包括YOLO-v5s(浅层)网络检测、YOLO-v5l(深层)网络检测、深层与浅层网络检测结果融合、检测结果融合后再通过Inception v4模型精确识别。实验测试结果如表2所示,其中,准确率accuracy、召回率recall的定义分别为

表2 接触网区域鸟窝智能识别性能对比

式中:TP为鸟窝图像正确检测的数量,TN为正常图像中正确检测的数量,FN为鸟窝图像检测错误的数量,FP为正常图像被检测错误的数量。

由表2可以发现,不同识别流程的召回率recall、准确率accuracy差别较大。其中,深层网络(YOLO-v5l)针对鸟窝识别的召回率为94.57%优于浅层网络(YOLO-v5s),但深层网络(YOLO-v5l)的误报FP较多,导致其准确率低于浅层网络(YOLO-v5s)。进行模型融合(浅层&深层)后,召回率上升到98.71%,但随之而来的误报FP也大幅上升到364,导致该流程的准确率accuracy下降到79.15%。模型融合+Inception v4则表现出了最佳检测性能,针对鸟窝检测的召回率recall为98.71%,准确率为98.36%,均获取了最佳性能。根据上述分析可知,将深层、浅层检测模型的融合结果进一步由Inception v4模型进行精确识别,可以在保证较高召回率的情况下,大幅降低误报(FP取值由364降低到23),从而大幅提升接触网区域鸟窝智能识别方法的性能,能够同时获得最佳的召回率、准确率。表2所示最优检测流程(将深层、浅层检测模型检测结果融合后再利用Inception v4进行精确识别)的部分典型识别结果如图5所示。

图5 接触网区域鸟窝智能识别结果的典型示例

4 结论

针对接触网区域中鸟窝的智能识别问题,本文提出了将YOLO v5s浅层网络与YOLO v5l深层网络的检测结果进行融合来实现接触网区域鸟窝初步检测,再使用Inception v4模型对初步检测结果进行精确识别的方法。同时,为了满足深度学习技术对样本图像数据量的要求,构建了接触网区域鸟窝样本图像数据集,并由专业巡检人员对鸟窝进行判读、标注。实验表明,所述方法能够有效实现正常成像、有雾天气、部分遮挡、部分曝光、成像不清晰等各种成像状态下的接触网区域鸟窝精确检测、识别任务,对进一步研发接触网区域鸟窝智能识别系统具有重要意义。