面向算力网络的航天智慧云服务架构与场景分析

白 宁,范利波

(中国西昌卫星发射中心,四川 西昌 615000)

0 引言

随着大数据和人工智能技术的快速发展,各个行业领域在不断地建设智能应用系统的同时,也将多种应用系统放置到了云中心。有资料显示,预计到2025年,全球85%以上的企业将应用系统放置在云端[1]。同时人工智能、5G技术迅速发展,其大带宽和低时延的特征需要数据就近处理,驱动计算从云端下移到数据源附近,边缘计算、移动边缘计算技术得到快速发展。未来航天科研活动中,面对海量大数据的实时业务计算需求,网络需具备计算、存储、传输融合的新模式。边缘计算(Edge Computing)在靠近数据源一侧就近提供计算处理服务,降低对云数据中心的计算、存储和网络带宽需求,提高应用的实时处理能力[2-3]。同时智慧云服务系统需要调度边缘计算和云计算中心资源分配,实现整体资源利用最优化,更好满足用户业务需求。

因此,建设航天智慧云服务系统,需要覆盖航天各子系统应用终端的大数据采集、传输和处理的网络系统架构。本文提出了基于算力网络的航天智慧云服务架构,并分析了未来典型应用场景下满足用户业务需求日趋多样化、算力资源分散化、网络服务智能化的发展趋势。

1 研究背景

1.1 算力网络概念

算力网络,又叫算力感知网络(Computing Awareness Network),为了满足人工智能时代社会对信息处理的巨大计算处理需求,需要将大量边缘节点的算力进行综合调度,通过核心网络的路由策略将分布在云中心、边缘云和终端的各类算力资源进行有效整合,形成池化算力资源,将应用提出的算力需求通过计算度量后,分解成多个原子算力服务节点,减轻了云中心的算力压力,同时减少了网络拥塞产生的时延,提升了算力资源利用率[3]。

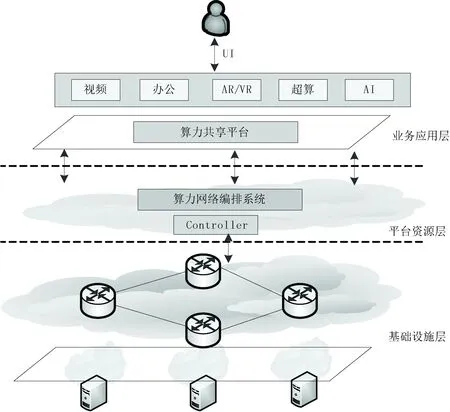

如图1所示,算力网络整体系统架构从下向上,划分为基础设施层、平台资源层和业务应用层。基础设施层将计算资源、存储资源和网络基础设施统一为整体,以虚拟机或容器(Controller)的形式为平台资源层提供接口,通过编排器调度边缘节点资源提供给用户;平台资源层在对下层资源进行管理和调度的同时,以组件的方式为上层应用提供接口服务;业务应用层通过对下层资源的调用,为用户提供最终应用服务,实现其业务功能。

1.2 算网融合发展现状及趋势

目前,分布式的海量航天科研数据,只能通过互联网络进行传输至云中心处理,导致相关应用服务对网络性能参数,如传输速率、时延和抖动等有较高的要求。基于人工智能应用服务需要深度学习训练,大量的数据需要进行计算处理,如果能够在靠近数据源边缘云就对数据进行处理,则大大缩短计算时间。现代的通信网络不仅需要高速的数据传输速率,还需要从根本上产生新的网络协议才能满足大数据的传输。而TCP协议无法适应这样的海量数据传输,比如在40 Gbps带宽环境下拥塞窗口恢复时间长达46小时[4]。此外,随着人工智能应用的发展,用户终端在网络边缘云交换的数据量就已经达到ZB级;而AR/VR、智能机器人、机器视觉等应用,对时延抖动、丢包率和数据安全性等提出了较高要求[5]。

图1 算力网络整体架构

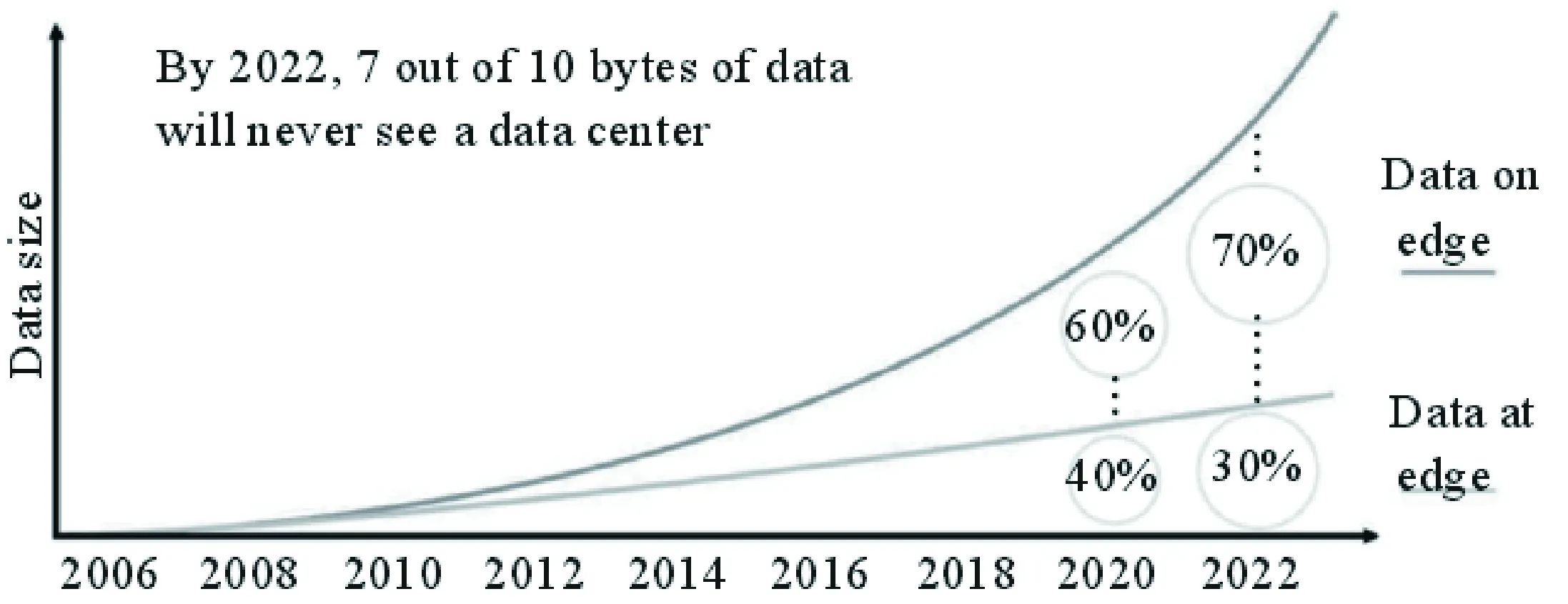

图2 边缘计算流量预测

边缘计算在靠近用户网络边缘提供轻量级的云计算、存储和安全服务,用户原本需要上传至云中心的数据得以就近计算处理,避免了传输时延大影响服务质量,同时也优化了网络路由策略。此外思科及IDC分别估计,未来将有超过70%~75%的数据在网络边缘就可处理[6](见图2)。这将对未来的云数据中心运行模式、网络流量模型产生重大改变。到2025年,麦肯锡预计边缘计算的价值将会增加至1 750亿~2 150亿美元[7]。

因此,从上面事例可以看到,边缘计算与算力网络的融合,是未来发展新型航天智慧云架构的发展趋势。

2 航天智慧云对算力网络的需求

航天智慧云服务目前采用“云计算中心+有线专网接入”模式,面向当前阶段多种类型用户需求,能提供性能很好的计算存储服务和高速的网络接入条件。但是,随着大数据、人工智能应用的发展,连接的智能设备终端类型与数量增多,需处理的数据量剧增、对实时性要求会更高,如远程控制、无人测试、AR/VR 等新型测试手段也将不断涌现,必然对现有智慧云服务的计算存储、网络传输性能、低时延抖动等能力提出更高要求。未来应用服务将对算力网络从以下几个方面提出新需求。

(1)计算存储能力。对于用户处理业务应用,只需要应用以低成本高效率完成数据处理,并不在意数据处理的地点。若智慧云服务架构采用云数据中心的模式,数据处理效率低,主要受限于网络传输质量和云中心的处理能力;采用算力网络的架构,计算任务可分配到多个资源空闲的边缘云来处理,传输带宽减少了拥塞,数据处理效率将大为提升。同时,存储能力在数据处理过程中也很重要,在很大程度上会影响计算机的处理速率。

(2) 网络传输性能。网络性能是提升实时性业务服务质量(QoS)方面的重要指标。传统云服务模式下,无法对不同业务流数据均按最优先计算处理。在算力网络中,针对不同种类的业务流,可以采用NFV的模式,在边缘节点上增加传输优化模块,采用专有协议、优化路由策略,灵活调度网络资源以满足不同业务对时延和抖动的需求。

(3) 网络接入方式增加。未来航天科研活动使用的移动终端会增加,导致对无线接入方式需求会增多。随着物联网的发展,海量传感器需要传输处理数据。算力网络中融入5G技术,利用5G技术有低时延、大带宽的特点,将5G接入作为航天智慧云服务的重要补充,增加了智能终端接入云的类型。

(4)业务体验服务能力。集中式的云服务模式下,各种应用(如文件存储、自动办公、视频会议等)都部署在云中心,当有用户距离云中心较远时,则存在因为网络时延大,丢包数增加等因素导致用户体验较差。在算力网络中,除了计算存储能力和网络性能,编解码能力、每秒传输帧数(FPS)、吞吐量也是决定业务体验的联合能力。因此,利用机器学习的算法,将用户常访问的数据预先判断后缓存至边缘云存储,这样提升了用户的访问速度,也降低了整个网络带宽流量。

3 基于算力网络的航天智慧云服务架构

3.1 算力网络集中式系统架构

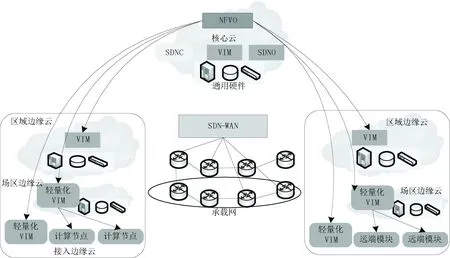

航天智慧云服务集中式算力网络架构下,根据技术中心、实验装置、测试场区、保障场区等不同科研试验场景的应用需求,将网络能力与应用服务能力下移到应用边缘。端、边、云的算力和网络资源及节点信息由集中式编排器NFVO (Network Function Virtualization Orchestrator) 统一管理,集中式编排器调度全网算力资源和网络状态,按照应用需求,编排最优的算力服务转发路径,并下发至原子算力节点,提升数据传输处理效率,为用户提供现场级、智能化的计算服务能力,如图3所示。

图3 算力网络集中式的航天智慧云架构

算力资源分别部署于网络基础设施上,如边缘计算节点、数据中心等,算力资源节点与NFVO进行垂直交互。应用从边缘节点接入,集中编排器在感知应用的算力和网络需求,进行路由策略控制,针对典型应用NFVO可预配置后下发至算力节点,边缘节点对预配置生成路由信息后,转发应用流量。集中式算力网络架构对现网设备和协议的改动最小,部署周期短。针对非典型应用,需要算力网络入口节点通过指令接口向集中编排器通告,增加了应用请求响应的延迟。

此外,由于接入智慧云节点增多,传统集中编排器无法下沉到边缘,通过轻量级虚拟化VIM(Virtual Infrastructure Manager)部署边缘编排器,减少边缘节点直接与智慧云的集中编排器交互,边缘云数据中心的VIM针对本地可执行路由策略编排的应用场景,直接下发编排策略,提升了本地应用请求响应速度和执行效率,起到层次化分担流量。

3.2 算力网络混合式系统架构

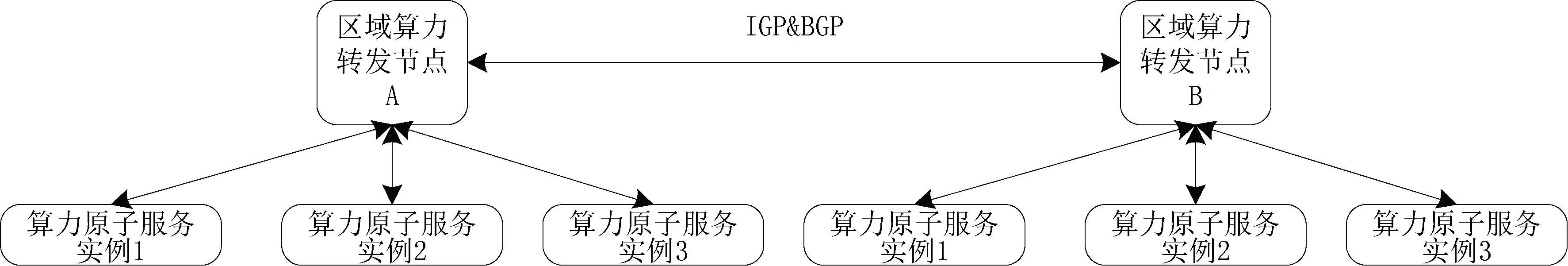

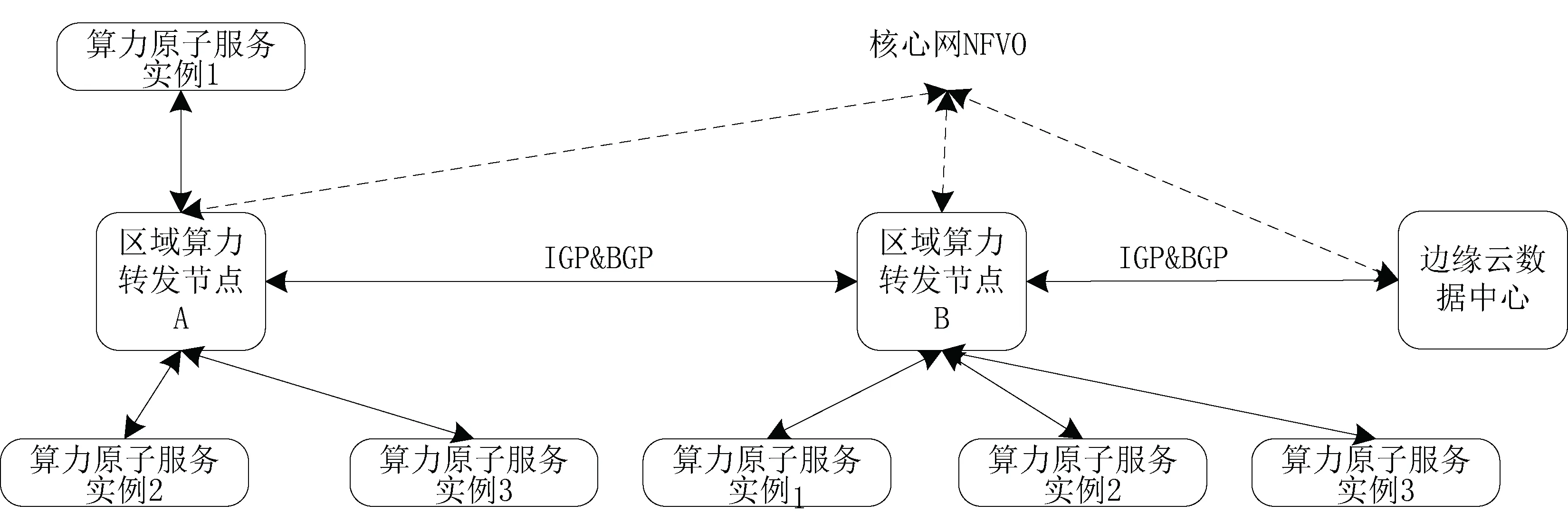

在实际网络部署中,算力资源节点向邻近算力网络节点上报(更新、删除)算力资源信息、节点标识、算力原子服务实例标识等。算力网络节点通过IGP&BGP路由协议将本节点的算力资源状态信息洪泛通告至邻居节点,达到全网算力节点形成统一的算力资源状态信息数据库。

算力网络分布式架构如图4所示。对于支持同样算力原子服务的实例或节点可能分布在多个算力网络转发节点管理域内,转发和路由设备根据网络和算力资源状态进行全局路由决策,选择最优的算力节点进行应用流转发。由于每个转发路由设备均包含全网统一的算力资源状态信息数据库,因此可以掌握全网的算力资源信息来指导应用流量转发,不需要NFVO参与,算力服务响应速度更快。分布式算力网络架构的优点是收敛快,特别适合时延敏感应用,缺点是对现网设备和协议调整范围大,改动的周期长。

本文采用一种既有集中式交互机制又有分布式交互机制的混合式架构,平衡部署代价、收敛速度各方面的需求。在不超过20个左右的网络节点的中小规模边缘算力网,算力节点创建本地算力资源信息数据库,算力资源通告和同步通过分布式协议IGP&BGP实现。更大范围的全局算力网络资源同步,则由局域网中的代理节点向中央集中编排器交互,发挥集中式架构调度全网资源信息的优势,重要的算力节点比如测试场区、实验装置场区等,则选择两种资源同步方式共存,如图5所示。

图4 算力网络分布式系统架构

图5 算力网络混合式架构

4 典型应用场景与服务能力

4.1 虚拟组网与优化传输

针对重大联合项目组、新型实验装置等需要专用网络保障的科研应用,在局域网出口处,部署SDN交换机及边缘云节点,加载虚拟智能边缘网关(vCPE),支持WiFi、光纤、以太网接入并可扩展支持5G、eMTC、NB-IoT及LoRa等接入方式,实现对各种物联网传感器的接入,对流量进行统一管理,控制应用流量引入加速虚拟专网,并通过云服务的形式实现用户自主管理,如图6所示。

图6 基于算力网络的虚拟组网

4.2 5G融合接入

现有场区局域网出于数据安全性的考虑,与运营商移动网络物理隔离,这样场区中移动用户终端产生的4G流量就不会进入场区局域网,但是也导致科研试验部分应用无法直接使用移动网络。在5G技术中,通过联通场区5G基站与边缘云之间的接口,可以将场区内产生的特定5G流量分流到本地边缘云,实现流量的“内网化”。通过边5G流量本地分流的方式,将5G应用到未来的智慧云中,解决现有网络在部分移动应用场景中的网络性能不足问题。

4.3 航天智慧云应用服务

现有科研云平台上有大量功能各异的云服务,用户通过区域内网进行访问,特别是在长途链路环境下,网络带宽、时延、抖动等因素有可能会导致服务质量不稳定。算力网络将计算存储资源下沉到靠近用户侧的边缘网络,用户根据应用算力需求可以就近处理信息或者通过NFVO路由决策到最优路径上。同时,在边缘侧,融合5G的移动接入方式,用户可以通过各类移动终端,随时随地高效访问智慧云服务,开展科研试验工作。可以提供以下几种典型的智慧云应用服务,如图7所示。

图7 航天智慧云应用服务

(1)AR/VR:移动AR/VR业务是一种云、端相结合的方式,其本质是一种交互式在线视频[8]。在云侧超算平台完成海量数据处理,在边缘算力点完成图像渲染和交互,再通过网络传输给用户输入设备(手机、PC、PAD、虚拟键盘、手柄等),对业务进行实时操作。

(2)无线办公:利用边缘云实现智能设备管理(如云打印、云投影等),开展无线办公。

(3)智慧靶场:根据5G和人工智能应用特点,算力网络需同时具备极低传输时延和超强算力。智能驾驶、机械臂、无人加注等是智慧靶场重要组成部分,可通过海量数据的训练完成深度学习,在特殊环境下实现远程无人化的操控。

(4)视频会议:利用算力网络实现虚拟化视频会议MCU功能,配合视频传输优化服务,实现高质量、可动态扩展的云化视频会议服务。在算力网络的支撑下,视频培训、远程故障诊断、视频客户服务、在线直播等一系列新兴视频应用迅速普及[9]。

(5)存储同步:根据用户访问趋势,自主地将智慧云存储中的高频访问数据缓存在网络边缘并自动同步更新,提升用户数据访问速度。

5 结语

算力网络在大数据、人工智能背景应用下,能够有效解决云中心与边缘节点之间算力调度,适应多种业务网络性能需求,用户业务体验得到极大提升,是未来航天智慧云服务处理大数据、连接多种智能终端的发展趋势。本文分析了大数据、人工智能应用的普及给网络与计算带来的挑战,以及航天智慧云服务对算力网络的需求,结合现网基础现状,提出并阐述了两种算力网络应用下的航天智慧云服务架构和特点,并给出其适用的典型应用场景与服务能力。后续仍需要根据智慧云服务运行模式的发展和用户应用需求变化来不断完善,以适应未来多样化业务场景。