快速精准识别棚内草莓的改进YOLOv4-Tiny模型

孙 俊,陈义德,周 鑫,沈继锋,武小红

快速精准识别棚内草莓的改进YOLOv4-Tiny模型

孙 俊,陈义德,周 鑫,沈继锋,武小红

(江苏大学电气信息工程学院,镇江 212013)

为了实现棚内草莓果实的快速精准识别,该研究提出一种基于改进YOLOv4-Tiny的草莓检测模型。首先,为了大幅度减少模型计算量,采用轻量型网络GhostNet作为特征提取网络,并在GhostBottleneck结构中嵌入卷积注意力模块以加强网络的特征提取能力;其次,在颈部网络中添加空间金字塔池化模块和特征金字塔网络结构,融合多尺度特征提升小目标草莓的检测效果;最后,采用高效交并比损失作为边界框回归损失函数,加速网络收敛并提高模型的检测准确率。结果表明,改进YOLOv4-Tiny模型权重大小仅为4.68 MB,平均每幅图片的检测时间为5.63 ms,在测试集上的平均精度均值达到92.62%,相较于原YOLOv4-Tiny模型提升了5.77个百分点。与主流的目标检测模型SSD、CenterNet、YOLOv3、YOLOv4和YOLOv5s相比,改进YOLOv4-Tiny模型平均精度均值分别高出9.11、4.80、2.26、1.22、1.91个百分点,并且模型权重大小和检测速度方面均具有绝对优势,该研究可为后续果实智能化采摘提供技术支撑。

机器视觉;图像处理;果实识别;YOLOv4-Tiny;注意力机制;小目标

0 引 言

草莓果实鲜美、色泽鲜艳并且具有丰富的营养,被誉为“浆果皇后”[1]。中国自20世纪初开始正式生产和栽培草莓,随着经济实力的增强以及社会生活水平的提高,已成为全世界草莓种植面积、产量最大的国家,目前国内草莓的栽培面积已达10万hm2,总产量达188万t,草莓的采摘收获主要依靠人工,存在劳动强度较大,成本高等问题[2],据统计,草莓采摘所花费的人力成本占草莓生产总成本的50%~70%。因此研究草莓果实的快速准确智能化识别方法极为重要。

近年来,国内外的果实精确识别、果实成熟度分类等研究已取得了显著的成果。最早的工作是针对颜色分明的水果,采用颜色滤波的方法分割果实和背景。Zhao等[3]通过阈值分割、边缘检测、区域增长、灰度共生矩阵等一系列图像预处理操作,从不同的颜色空间中提取水果的外观特征。张铁中等[4]采用LRCD(Luminance and Red Color Difference)方法分割草莓图像,提取分割后草莓图像的几何特征,从而确定草莓的重心位置和采摘点。Ouyang等[5]利用中值滤波去噪,OTSU算法,均值漂移聚类和形态学操作处理草莓图像以获得最具鉴别性的草莓形状特征,但对多个草莓目标的识别效果较差。谢志勇等[6]提出一种基于Hough变换的成熟草莓识别方法,但实际草莓果实形态各异,仅用圆形拟合成熟草莓果实误差较大。Feng[7]等根据色调和饱和度颜色直方图对果实进行区分,并通过双目视觉系统确定采摘点,但该方法识别仅对分布稀疏的果实有不错的识别效果,且检测速度较慢,单个草莓采摘需耗费31.3 s。侯贵洋等[8]结合颜色识别和特征识别,得到草莓质心坐标,并利用卷积神经网络辅助级联分类器判别未成熟和成熟的目标草莓,但在重叠密集的情况下误差较大,导致定位框不能与果实完全吻合。虽然上述研究都能够成功识别出草莓目标,但多数识别方法仅针对草莓的单一特征展开研究,当图像中出现多个果实目标时,上述方法检测效果不佳,难以满足实际棚内复杂情景下的草莓识别需求。

随着农业4.0的出现,信息系统和互联网技术可以用来收集、分析和处理大量农业数据[9]。深度卷积神经网络能够充分提取目标高维特征信息,结合深度学习的目标检测算法逐渐被广泛应用于农业果实识别、病害分类[10-11]和麦穗计数等研究。Sun等[12]提出了一种改进的Faster-RCNN番茄识别方法,采用ResNet50替换VGG16作为特征提取网络,并使用K-means聚类算法自动调整锚尺寸,将番茄的识别精度提升至90.7%,单张图片检测时间为73 ms。李就好等[13]针对苦瓜叶部的小尺寸病害,增加Faster-RCNN区域建议框的尺寸个数,并在ResNet50骨干网络的基础上融入特征金字塔网络,显著提升了各病害的识别能力,平均精度均值达到86.39%,单幅图像的检测时间为322 ms。闫建伟等[14]采用了一种基于感兴趣区域校准(ROI Align)的区域特征聚集方法。该方法将整个特征聚集过程转化为一个连续的操作,解决了Faster-RCNN中区域不匹配的问题,提高了识别准确率和召回率,对刺梨的平均识别精度达到92.01%,平均每幅图检测时间为0.2 s。这类以Faster-RCNN为代表,基于候选框建议的二阶段算法,虽然检测精度高,但是检测速度慢。而以SSD[15]、YOLO[16-19]为代表的单阶段算法,能够经过卷积神经网络处理图像,直接预测出目标的分类结果与位置坐标,在检测速度上相比二阶段算法占据优势。赵德安等[20]提出了一种改进的YOLOv3算法,对预设锚框尺寸进行调整,实现了苹果快速精准的定位,但该方法检测密集果实时,1得分下降明显。彭红星等[21]设计了一种基于多重特征增强与特征融合的SSD算法,通过使用感受野模块和高效空间金字塔模块,改进路径聚合网络,并在浅层网络添加通道注意力机制,提高了荔枝识别精度,但模块的累加降低了检测速度。张兆国等[22]采用轻量级网络MobileNetv3作为YOLOv4的特征提取网络,并在残差模块中添加轻型注意力机制,对马铃薯的检测速度有所提升,然而该方法降低了部分检测精度。Chen等[23]提出了一种改进的YOLOv4算法,通过修剪不重要的通道或网络层,微调剪枝后的训练参数,减少了模型的参数量,但剪枝后的模型对每幅图像的检测耗时仍需60 ms。

综上所述,多数研究仅针对模型的某一性能指标进行改进,并未在模型精度、速度以及权重大小之间达到很好的平衡。在真实果园内存在很多小目标果实,若不进行针对性的识别研究,实际识别过程中会出现漏检现象。因此,本研究以实际棚内草莓为研究对象,改进YOLOv4-Tiny模型的特征提取方式来减少模型的参数量,引入多尺度的特征融合机制,加强对小目标草莓的识别能力。

1 材料与方法

1.1 试验数据采集

试验草莓数据采集于江苏省东台市梁垛镇某草莓种植园,品种为章姬。草莓的种植方式为大棚地垄式,同一茎上生长的草莓形状类似,大多呈现为尖卵形,草莓的大小不一,且相互遮挡重叠。在自然光照条件下,采用手持拍摄设备(1 200万像素)搭配伸缩杆对草莓进行近距离(30 cm以内)拍摄,采集的原始图片保存为JPEG格式,分辨率为4 032×3 024(像素),共计841张。棚内草莓果实图像如图1所示。

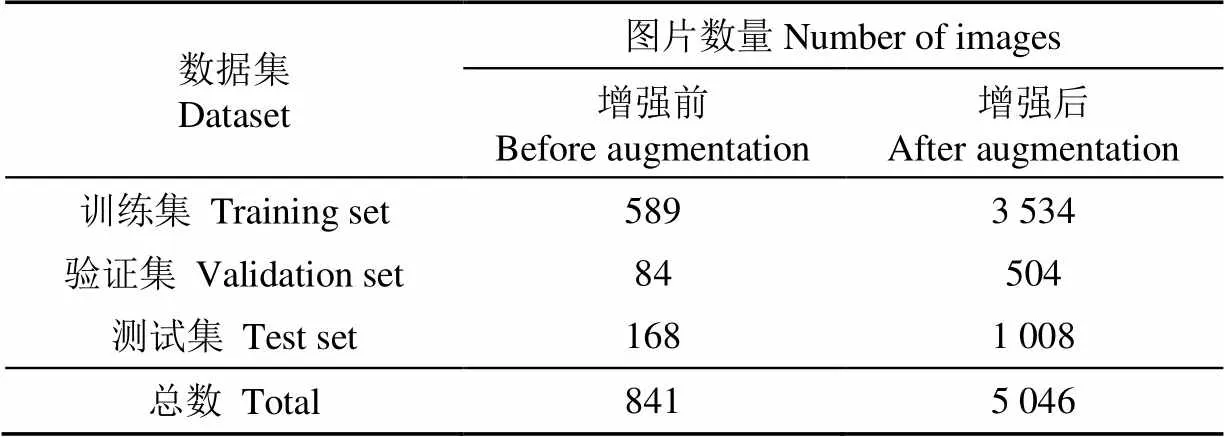

1.2 数据集构建

本试验采用LabelImg工具软件对原始图片各个目标所在区域进行矩形框标注。设定成熟草莓标签为Ripe,未成熟草莓标签为Unripe,生成XML类型的标注文件。标注后的数据集按照 7∶1∶2 比例随机分为训练集(589幅)、验证集(84幅)、测试集(168幅)。为防止训练数据量过少发生过拟合现象,增强模型的抗干扰能力,使用Python脚本对数据集图像进行数据增强处理[24],包括随机翻转、随机裁剪、随机亮度,增加高斯噪声,每张原始图像都生成6张新图像,最终草莓训练集图像数量达到3 534张,验证集数量达到504张,测试集数量达到1 008张。数据集分布如表1所示。

图1 棚内草莓果实图像

表1 草莓数据集分布

2 草莓检测模型搭建

2.1 YOLOv4-Tiny模型

YOLOv4-Tiny模型主要由3部分组成:骨干网络、颈部网络和头部网络。骨干网络使用CSPDarkNet53-Tiny进行特征提取,颈部网络使用2层的特征金字塔结构进行特征融合,头部网络则对目标进行分类回归。YOLOv4-Tiny模型的结构简单,虽有2层的特征金字塔结构,但对小目标的特征提取不充分,会丢失许多小目标的位置信息和细节信息,导致检测精度偏低。

2.2 YOLOv4-Tiny网络模型改进

2.2.1 GhostNet特征提取网络结构

CSPDarkNet53-Tiny虽相比于CSPDarkNet53网络参数量大大减少,但由于其卷积层使用过多,网络占用内存仍较大,所以本研究决定使用轻量级网络GhostNet[25]作为新的特征提取网络。该网络核心是采用Ghost模块取代标准卷积操作来减少网络计算量。图2展示了Ghost模块运算过程。

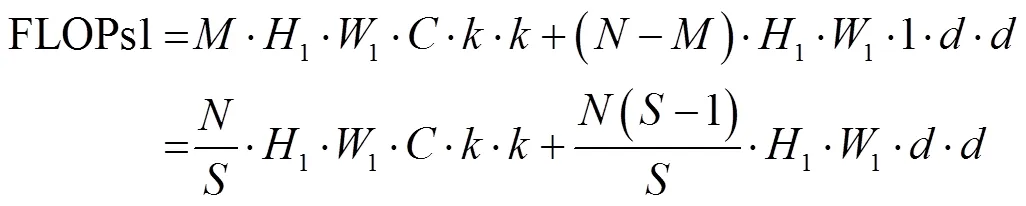

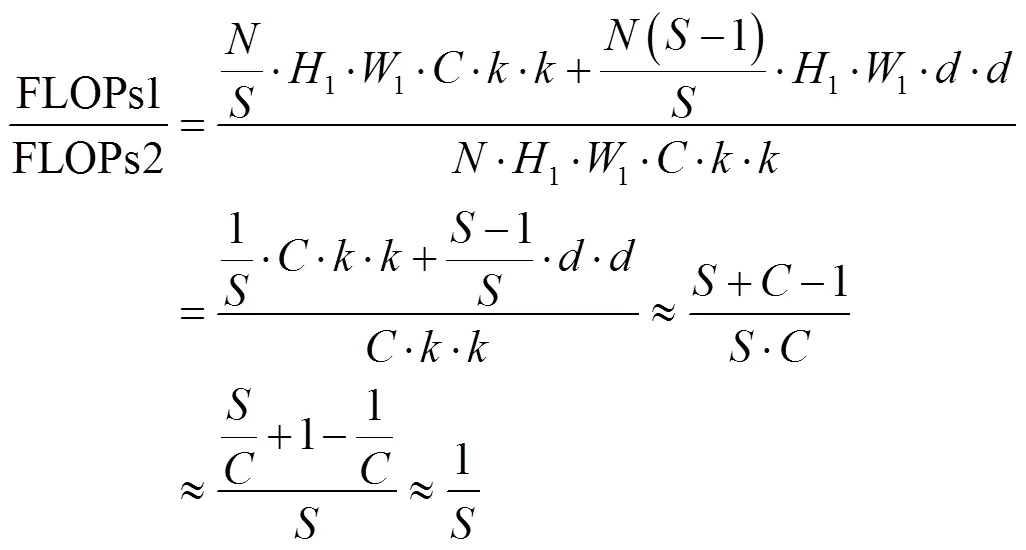

Ghost模块运算分为2步,首先利用少量的标准卷积对输入图片进行卷积运算,生成本征特征图,接着对本征特征图的每个通道单独进行线性变换操作,即使用逐层卷积生成特征浓缩后的特征图,最终将2部分生成的特征图合并输出(图2)。整体模块的浮点计算量FLOPs1为

式中、、分别为输入特征图的高、宽和通道数;1、1、分别为输出特征图的高、宽和通道数;为线性变换次数;为本征特征图输出通道数;、分别为标准卷积核大小和逐层卷积核大小。

与标准卷积浮点计算量相比,化简如下:

式中标准卷积核和逐层卷积核属于同一数量级,大小取近似值,即约等于,输入特征图通道数一般较大,而线性变换次数要远小于。由化简结果可知,Ghost模块的浮点计算量大约是标准卷积的1。

注:Conv和分别表示标准卷积和其卷积核尺寸;DWConv和分别表示逐层卷积和其卷积核尺寸;表示本征特征图通道数;表示线性变换的次数;、表示输入特征图高、宽和通道数;1、1表示输出特征图高、宽和通道数。

Note: Conv andrepresent the standard convolution and its convolution kernel size; DWConv andrepresent depthwise convolution and its convolution kernel size;represents the number of channels of the Intrinsic feature map;is the number of linear transformations;,andrepresent the height, width and number of channels of the input feature map;1,1andrepresent the height, width and number of channels of the output feature map.

图2 Ghost模块运算过程

Fig.2 Ghost module calculation process

GhostBottleneck是由Ghost模块组成的瓶颈结构,如图3a所示。图3a展示了步长为1的GhostBottleneck结构,主要由2个堆积的Ghost模块构成。第1个Ghost模块作用是扩展特征图的通道数,为后面的操作做扩展处理;第2个Ghost模块用来降维,将通道数降至与右分支的短接路径相匹配。该结构可以加深网络的深度,且不会对特征图宽高进行压缩。图3b为步长为2的GhostBottleneck结构,左分支2个Ghost模块之间添加步长为2的逐层卷积,作用是对特征层的宽高进行压缩,使其大小降为输入尺寸的1/2,在右分支添加一个步长为2的逐层卷积和1×1的标准卷积,确保与左分支生成的特征图尺寸相同,能够完成尺度相加操作。

注:BN为批量归一化,ReLU为激活函数,Add为相加操作。

2.2.2 卷积注意力机制模块

在骨干网络中引入卷积注意力模块能够有效避免模型对冗余信息的关注,更加关注图像中起决定作用的像素区域,提升网络的特征提取能力。改进后的特征提取网络结构组成如表2所示。

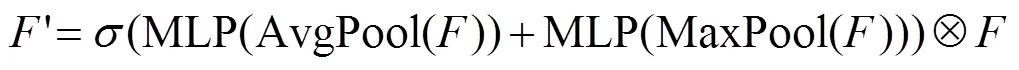

注:F为输入特征映射;Fʹ为经过通道注意力模块细化的特征映射;Fʹʹ表示经卷积注意力模块细化的特征映射。

表2 骨干GhostNet网络结构

注:CBAM代表卷积注意力模块;“-”表示当前的网络层未使用该结构或策略;1表示当前网络层使用该结构或策略。

Note: CBAM represents convolution block attention module; “-”represents that the current network layer does not use the structure or policy; 1 represents that the current network layer uses the structure or policy.

2.2.3 空间金字塔池化以及特征金字塔结构

试验数据集中存在体型较小的草莓目标,为提高小目标草莓的检测精度,本试验在新的Ghost骨干网络之后引入空间金字塔池化(Spatial Pyramid Pooling,SPP)[28]模块,如图5所示。SPP模块对输入的特征图进行3个并行的最大池化操作,池化核大小分别为5×5、9×9和13×13,将3个池化后的特征图与输入特征图按通道进行合并操作,得到输出的融合特征图。这种多重池化的融合有效地结合了草莓的全局和局部特征,增强了网络对小目标的识别能力。

为加强特征的传递和重用,本试验在颈部网络中引入特征金字塔网络(Feature Pyramid Network,FPN)结构[29],如图6所示。对输入至颈部网络的特征图,首先进行1×1卷积降维操作,得到分辨率为13×13(像素)的输出特征并对其进行上采样,将上采样得到的特征图与GhostBottleneck9输出的特征通道融合,得到分辨率为26×26(像素)的输出特征;接着将融合后的特征图进行上采样,并将上采样的特征图与GhostBottleneck6输出的特征通道融合,得到分辨率为52×52(像素)的输出特征;最后将13×13、26×26、52×52(像素)的特征图输出至头部预测网络。这种多尺度融合的特征金字塔结构能够进一步提升对小目标果实的检测性能。

图5 SPP模块

2.3 高效交并比回归损失函数

传统的交并比(Intersection over Union,IoU)回归损失函数只考虑了真实框和预测框的重叠面积,当2个框不相交时,不能反映2个框距离的远近,也无法提供可传递的梯度。本研究采用高效交并比损失(Efficient Intersection over Union Loss,EIoU Loss)[30]作为边界框回归损失函数reg,包含重叠面积损失IoU,中心点距离损失dis和高宽真实差损失asp,计算式如下:

注:GB表示GhostBottleneckn;取1~11;CBL表示卷积+批量归一化+LeakyReLU激活函数。

Note: GBrepresents GhostBottleneckn;takes 1-11; CBL represents Convolution + BatchNorm + LeakyReLU activation function.

图6 改进的YOLOv4-Tiny整体结构

Fig.6 Improved YOLOv4-Tiny overall structure

由公式(5)可知,EIoU回归损失函数不仅考虑了预测框与真实框的重叠面积,还将预测框与真实框的中心距离和宽高作为惩罚项,当预测框与真实框不相交时也能回传梯度,使网络收敛更快,回归精度更高。

3 模型训练

3.1 试验平台

本研究所有试验均在工作室单计算机搭建的深度学习环境中实现,计算机配置为PC Inter Core(TM)i7-10700K CPU @ 3.80 GHz、内存为32 GB,1 TB固态硬盘;搭载10 GB显存的Nvidia GeForce RTX 2080Ti,安装有CUDA 11.4版本的并行计算框架和CUDNN 8.2.2版本的深度学习加速库,在Ubuntu18.04 Linux操作系统上搭配编程语言Python 3.9以及Pytorch 1.11.0的深度学习框架。

训练参数设置:模型的网络输入尺寸为 416×416,每批量样本数为16,多线性进程为8,动量因子为0.937,初始学习率为0.01,权值衰减为0.000 5。训练方法采用随机梯度下降法(Stochastic Gradient Descent,SGD),并在每训练完一次所有样本时保存一次模型的权重文件,共训练200轮。

3.2 评价指标

为了准确评估模型的性能,本研究采用了4个常用的目标检测算法性能评估指标:1得分、平均精度均值(Mean Average Precision,mAP)、检测时间、权重大小。其中,mAP与准确率(Precision,)、召回率(Recall,)有关,具体计算公式如下:

式中TP表示被模型预测为正类的正样本;FP表示被模型预测为正类的负样本;FN表示被模型预测为负类的正样本;AP()表示每类别的识别平均精度值;mAP表示所有类别的识别平均精度均值,表示所有类别总数;1得分表示准确率与召回率的加权平均。此外,模型的检测时间指标以平均识别一张图片所消耗的时间为标准,权重大小以mAP值最优的权重文件大小为标准。

4 结果与分析

4.1 消融试验结果

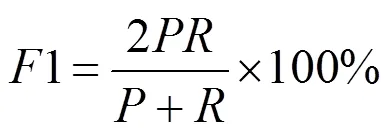

本研究在YOLOv4-Tiny算法基础上,使用轻量型骨干网络GhostNet减少模型参数量,添加CBAM注意力机制模块,加强对特征图重点区域的关注。在骨干网络之后引入SPP模块和FPN结构进行更加充分的特征信息融合,增强对小目标的识别能力。在预测层使用EIoU回归损失函数,加速网络的收敛。为验证本试验各种改进策略对模型结果产生的有效性,对测试集图片分别进行了6组消融试验,以平均精度均值为评价指标,试验结果如表3所示。

表3 YOLOv4-Tiny不同改进方法的消融试验结果

注: GhostNet代表GhostNet骨干网络;FPN代表特征金字塔网络结构;EIoU代表高效交并比回归损失;mAP代表平均精度均值指标。

Note: GhostNet represents GhostNet backbone network; FPN represents the feature pyramid network structure; EIoU represents the regression loss of efficient intersection over union; mAP represents the mean average precision.

表3中试验1采用原YOLOv4-Tiny模型,该模型对草莓识别的mAP为86.85%;试验2在初始模型上的基础上将CSPDarkNet53-Tiny更换为轻量型骨干网络GhostNet,mAP 为 86.97%,较试验1提升了0.12个百分点;试验3在试验2的基础上引入了CBAM注意力机制模块,相比于第2组试验,mAP提升了0.46个百分点;试验4在试验3的基础上增加了SPP模块,比第3组试验模型mAP提高了1.93个百分点;试验5在试验4基础上使用FPN结构,mAP相比于试验4提高了1.73个百分点;试验6在第5组试验的基础上引入了EIoU Loss,比第5组试验的mAP提升了1.53个百分点。通过消融试验发现,本研究提出的改进策略均对网络精度的提升起到了促进作用。

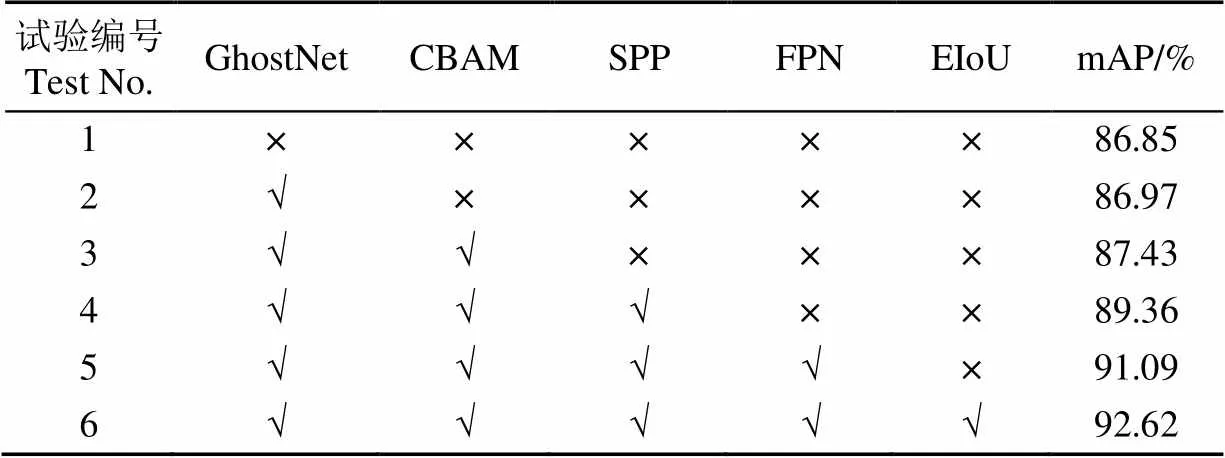

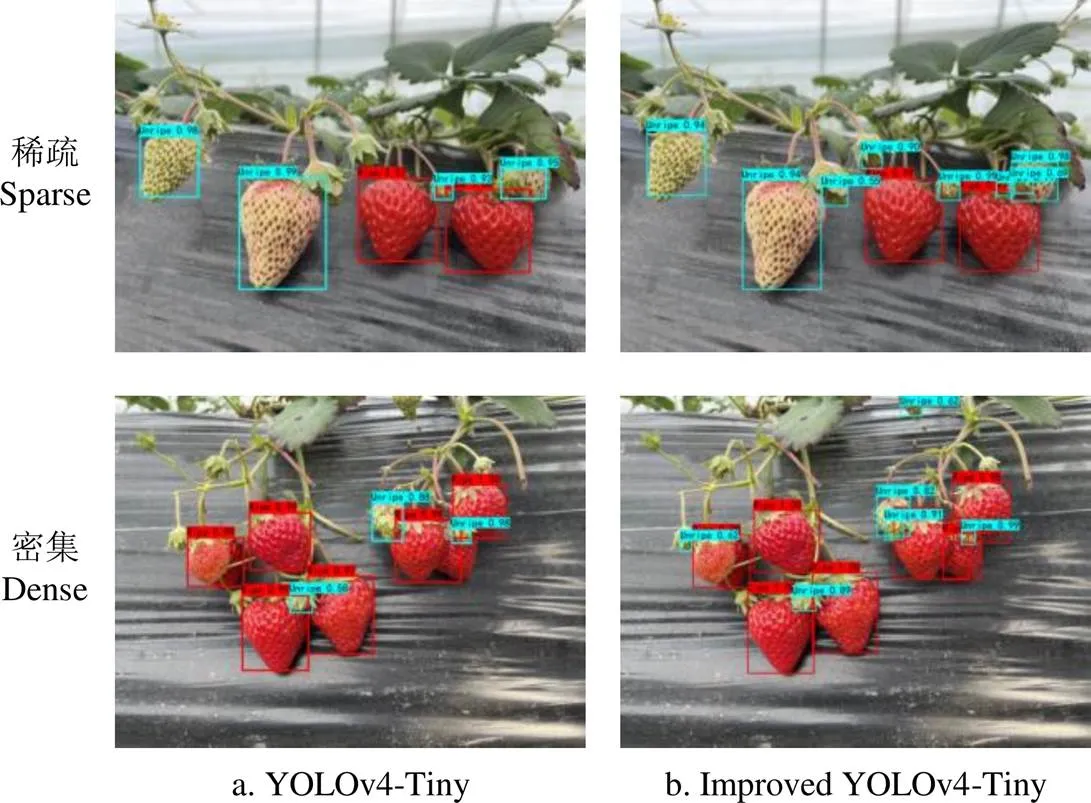

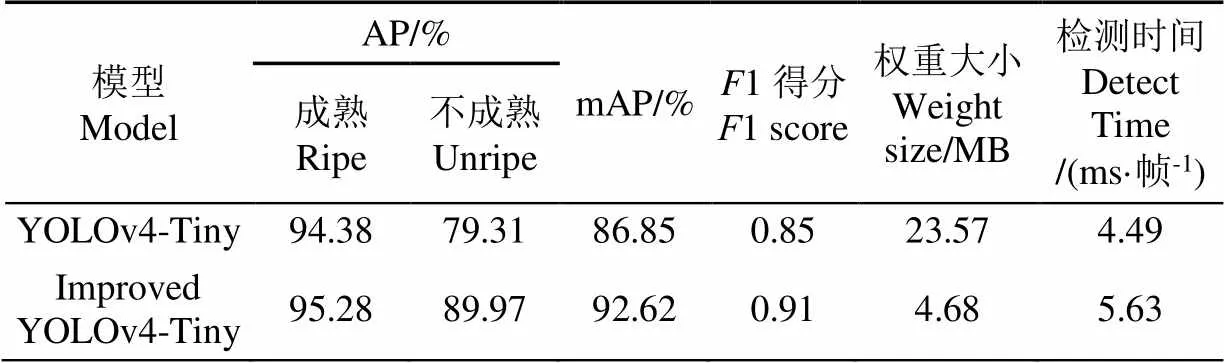

4.2 YOLOv4-Tiny改进前后试验结果

图7展示了原YOLOv4-Tiny和改进的YOLO4-Tiny 模型对草莓的识别效果。通过图7可以发现,对于稀疏和密集环境下的大目标草莓识别,YOLOv4-Tiny和改进的YOLOv4-Tiny均有较好的检测效果,而对于小目标果实的识别,YOLOv4-Tiny则存在严重的漏检现象,改进的YOLOv4-Tiny模型漏检数量很少。

注:图中红色检测框代表检测到的成熟草莓果实,蓝色检测框代表检测到的未成熟草莓果实。下同。

改进前后模型对草莓识别的平均精度、平均精度均值、1得分、权重大小以及检测时间如表4所示。由表 4可知,相比于初始YOLOv4-Tiny模型,改进的YOLOv4-Tiny对成熟和未成熟的草莓检测平均精度分别提升了0.90和10.66个百分点,平均精度均值提升了5.77个百分点,1得分提升了0.06。改进的YOLOv4-Tiny模型以轻量型GhostNet为特征提取网络,模型参数量大幅度缩少,训练生成的权重大小仅为4.68 MB,大约是初始模型的1/6。尽管改进的模型检测时间相比于原YOLOv4-Tiny增加了1.14 ms,但5.63 ms/帧的平均检测时间仍然完全满足实际果园的检测需求[31]。

表4 改进前后模型的试验结果

注:AP为平均精度。

Note: AP is average precision.

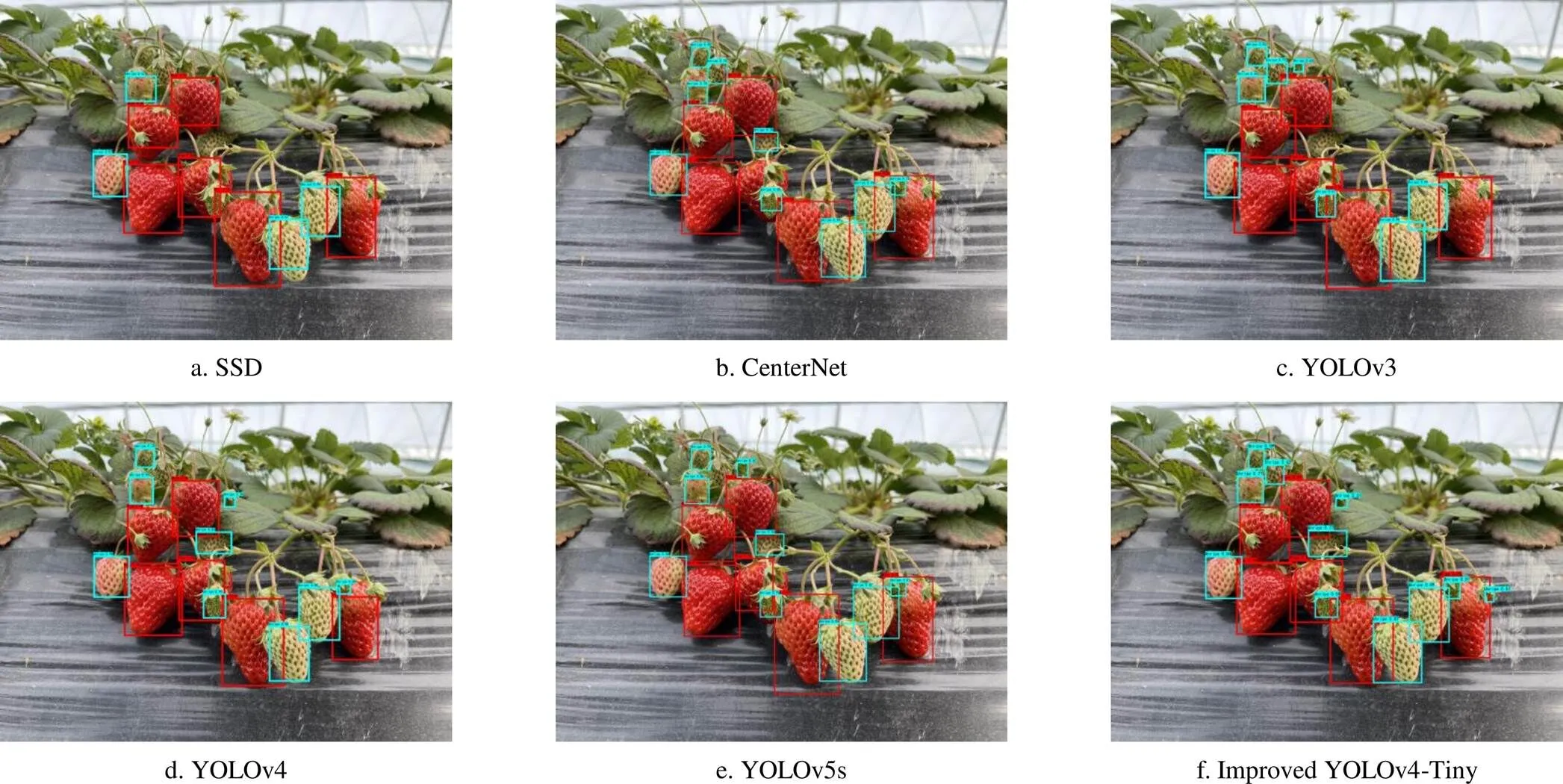

4.3 不同算法的对比试验结果

为进一步验证改进的模型性能,本研究将改进的YOLOv4-Tiny模型与SSD、CenterNet、YOLOv3、YOLOv4、YOLOv5s共5种常用的目标检测算法进行对比试验,分别训练5种算法至收敛并对比识别效果,如图8所示。由图8可知,SSD、CenterNet、YOLOv3存在严重的漏检现象,而YOLOv4、YOLOv5s对部分未遮挡或遮挡的小目标果实识别效果并不佳,而所改进的模型对于小目标未成熟的果实拥有很高的识别能力,漏检误检的果实很少,在实际棚内复杂环境下拥有更优异的检测效果。

图8 不同算法实际检测效果对比

表5展示了不同目标检测算法的草莓在测试集上的试验结果。由表5可知,本研究改进的YOLOv4-Tiny算法平均精度均值为92.62%,与常见的目标检测模型SSD、CenterNet、YOLOv3、YOLOv4、YOLOv5s相比,分别高出9.11、4.80、2.26、1.22、1.91个百分点,1得分达到0.91,分别高出上述5种模型0.08、0.05、0.03、0.01、0.03,在模型大小方面,改进的模型具有绝对的优势,模型大小仅为4.68 MB,在检测速度方面,平均每张图检测速度仅需5.63 ms,相比于上述5种模型分别减少了5.57、7.14、9.20、15.99、2.16 ms。综上所述,本研究提出的改进YOLOv4-Tiny模型在检测的精度、速度、网络结构大小方面都具有更大的优势,能够满足对棚内草莓果实的高效检测任务。

表5 不同算法在测试集试验结果

5 结 论

本文提出基于改进 YOLOv4-Tiny的棚内果园场景的草莓检测方法,以便后续采摘机器人实现对果实成熟度分类,定位识别和采摘。首先,对YOLOv4-Tiny的特征提取网络进行改进,使用更轻量化的GhostNet作为骨干网络,减少模型计算量以及优化多层特征信息的传递;其次,使用CBAM(Convolution Block Attention Module)注意力机制替换原SE(Squeeze and Excitation)模块,对空间和通道信息充分提取,提升网络检测精度。其次,使用SPP(Spatial Pyramid Pooling)模块和FPN(Feature Pyramid Network)结构,提高了模型对小目标草莓的识别能力。最后,在边界框回归损失函数中使用EIoU Loss (Efficient Intersection over Union Loss),加速模型收敛。

试验结果表明,所提出的改进YOLOv4-Tiny算法平均精度均值可以达到92.62%,1得分为0.91,平均每幅草莓图像的检测时间仅需5.63 ms,模型大小为4.68 MB,相比于原YOLOv4-Tiny,检测精度大幅度提升,模型更加轻量化,与SSD、CenterNet、YOLOv3、YOLOv4、YOLOv5s算法相比,本文算法识别精度最高,模型最小,平均检测速度也最快。综合所述,本研究改进的模型具有更好的鲁棒性,可为后续果实智能化采摘提供技术支撑。

[1] Morries J, Else M A, Chami D E, et al. Essential irrigation and the economics of strawberries in a temperate climate[J]. Agricultural Water Management, 2017, 194: 90-99.

[2] 王粮局. 基于动态识别定位的多机械手草莓收获机器人的研究[D]. 北京:中国农业大学,2016.

Wang Liangju. Research on Multi-Arm Strawberry Harvesting Robot Based on Dynamic Recognition and Localization[D]. Beijing: China Agricultural University, 2016. (in Chinese with English abstract)

[3] Zhao Y, Gong L, Huang Y, Liu C. A review of key techniques of vision-based control for harvesting robot[J]. Computers and Electronics in Agriculture, 2016, 127: 311-323.

[4] 张铁中,陈利兵,宋健. 草莓采摘机器人的研究:Ⅱ. 基于图像的草莓重心位置和采摘点的确定[J]. 中国农业大学学报,2005,10(1):48-51.

Zhang Tiezhong, Chen Libing, Song Jian. Study on strawberry harvesting robot: Ⅱ. Images based identifications of strawberry barycenter and plucking position[J]. Journal of China Agricultural University, 2005, 10(1): 48-51. (in Chinese with English abstract)

[5] Ouyang C Q, Li D L, Wang J L, et al. The research of the strawberry disease identification based on image processing and pattern pecognition[C]//Computer and Computing Technologies in Agriculture (CCTA). Berlin, Germany: Springer, 2012:86-94.

[6] 谢志勇,张铁中,赵金英. 基于Hough变换的成熟草莓识别技术[J]. 农业机械学报,2007,38(3):106-109.

Xie Zhiyong, Zhang Tiezhong, Zhao Jinying. Ripened strawberry recognition based on Hough transform[J]. Transactions of the Chinese Society for Agricultural Machinery, 2007, 38(3): 106-109. (in Chinese with English abstract)

[7] Feng Q C, Zheng W G, Qiu Q, et al. Study on strawberry robotic harvesting system[C]// IEEE International Conference on Computer Science and Automation Engineering (CSAE). Zhangjiajie, China: IEEE, 2012:347-351.

[8] 侯贵洋,赵桂杰,王璐瑶. 草莓采摘机器人图像识别系统研究[J]. 软件,2018,39(6):184-188.

Hou Guiyang, Zhao Guijie, Wang Luyao. Research on image recognition system of strawberry picking robot[J]. Software, 2018, 39(6): 184-188. (in Chinese with English abstract)

[9] Zhai Z, Martínez J F, Beltran V, et al. Decision support systems for agriculture 4. 0: Survey and challenges[J]. Computers and Electronics in Agriculture, 2020, 170: 105256.

[10] 孙俊,朱伟栋,罗元秋,等. 基于改进 MobileNet-V2 的田间农作物叶片病害识别[J]. 农业工程学报,2021,37(22):161-169.

Sun Jun, Zhu Weidong, Luo Yuanqiu, et al. Recognizing the diseases of crop leaves in fields using improved Mobilenet-V2[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(22): 161-169. (in Chinese with English abstract)

[11] 孙俊,何小飞,谭文军,等. 空洞卷积结合全局池化的卷积神经网络识别作物幼苗与杂草[J]. 农业工程学报,2018,34(11):159-165.

Sun Jun, He Xiaofei, Tan Wenjun, et al. Recognition of crop seedling and weed recognition based on dilated convolution and global pooling in CNN[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(11): 159-165. (in Chinese with English abstract)

[12] Sun J, He X F, Ge X, et al. Detection of key organs in tomato based on deep migration learning in a complex background[J]. Agriculture-Basel, 2018, 8(12): 196.

[13] 李就好,林乐坚,田凯,等. 改进 Faster R-CNN 的田间苦瓜叶部病害检测[J]. 农业工程学报,2020,36(12):179-185.

Li Jiuhao, Lin Lejian, Tian Kai, et al. Detection of leaf diseases of balsam pear in the field based on improved Faster R-CNN[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(12): 179-185. (in Chinese with English abstract)

[14] 闫建伟,赵源,张乐伟,等. 改进 Faster-RCNN 自然环境下识别刺梨果实[J]. 农业工程学报,2019,35(18):143-150.

Yan Jianwei, Zhao Yuan, Zhang Lewei, et al. Recognition of Rosa roxbunghii in natural environment based on improved Faster RCNN[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(18): 143-150. (in Chinese with English abstract)

[15] Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector[C]//European Conference on Computer Vision (ECCV). Berlin, Germany: Springer, 2016: 21-37.

[16] Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, USA: IEEE, 2016: 779-788.

[17] Redmon J, Farhadi A. YOLO9000: Better, Faster, Stronger[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, USA: IEEE, 2017: 7263-7271.

[18] Redmon J, Farhadi A. YOLOv3: An incremental improvement[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Salt Lake, USA: IEEE, 2018.

[19] Bochkovskiy A, Wang C, Hong Y. YOLOv4: Optimal speed and accuracy of object detection[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Seattle, USA: IEEE, 2020.

[20] 赵德安,吴任迪,刘晓洋,等. 基于 YOLO 深度卷积神经网络的复杂背景下机器人采摘苹果定位[J]. 农业工程学报,2019,35(3):164-173.

Zhao Dean, Wu Rendi, Liu Xiaoyang, et al. Apple positioning based on YOLO deep convolutional neural network for picking robot in complex background[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(3): 164-173. (in Chinese with English abstract)

[21] 彭红星,李荆,徐慧明,等. 基于多重特征增强与特征融合SSD的荔枝检测[J]. 农业工程学报,2022,38(4):169-177.

Peng Hongxing, Li Jing, Xu Huiming, et al. Litchi detection based on multiple feature enhancement and feature fusion SSD[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(4): 169-177. (in Chinese with English abstract)

[22] 张兆国,张振东,李加念,等. 采用改进 YoloV4 模型检测复杂环境下马铃薯[J]. 农业工程学报,2021,37(22):170-178.

Zhang Zhaoguo, Zhang Zhendong, Li Jianian, et al. Potato detection in complex environment based on improved YoloV4 model[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(22): 170-178. (in Chinese with English abstract)

[23] Chen W K, Lu S L, Liu B H. Detecting citrus in orchard environment by using improved YOLOv4.[J/OL]. Scientific Programming, (2020), [2022-07-05]. https://doi.org/ 10.1155/2020/8859237.

[24] 高友文,周本君,胡晓飞. 基于数据增强的卷积神经网络图像识别研究[J]. 计算机技术与发展,2018,28(8):62-65.

Gao Youwen, Zhou Benjun, Hu Xiaofei. Research on image recognition of convolution neural network based on data enhancement[J]. Computer Technology and Development, 2018, 28(8): 62-65. (in Chinese with English abstract)

[25] Han K, Wang Y H, Tian Q, et al. GhostNet: More features from cheap operations[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Seattle: IEEE, 2020: 1580-1589.

[26] Hu J, Shen L, Albanie S, et al. Squeeze-and-excitation networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(8): 2011-2023.

[27] Woo S, Park J, Lee J Y, et al. CBAM: Convolutional block attention module[C]//European Conference on Computer Vision (ECCV). Munich, Germany: Springer, 2018: 3-19.

[28] He K, Zhang X, Ren S, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015, 37(9): 1904-1916.

[29] Lin T Y, Dollár P, Girshick R, et al. Feature pyramid networks for object detection[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, USA: IEEE, 2017: 936-944.

[30] Zhang Y F, Ren W, Zhang Z, et al. Focal and efficient IOU loss for accurate bounding box regression[J]. Neurocomputing, 2022, 506: 146-157.

[31] Rui S, Gao F F, Zhou Z X, et al. Improved multi-classes kiwifruit detection in orchard to avoid collisions during robotic picking[J]. Computers and Electronics in Agriculture, 2021, 182: 106052.

Fast and accurate recognition of the strawberries in greenhouse based on improved YOLOv4-Tiny model

Sun Jun, Chen Yide, Zhou Xin, Shen Jifeng, Wu Xiaohong

(,,212013,)

Detection of fruit images has been one of the most important steps for automatic picking robots. There are many factors that make strawberry detection difficult in an orchard, such as the complex background, fruit occlusion, and small target fruit. In this study, an improved detection model with the YOLOv4-Tiny was proposed to rapidly and accurately recognize the strawberries in the greenhouse for the high detection accuracy of small targets in an orchard. Firstly, the GhostNet lightweight network was adopted to replace the backbone CSPDarkNet53-tiny for the feature extraction, which significantly reduced the parameters and computation of the model. Convolution Block Attention Module (CBAM) with the spatial information was embedded into the Ghost Bottleneck module instead of the original Squeeze and Excitation (SE) attention, in order to improve the feature extraction capability. Secondly, the Spatial Pyramid Pooling (SPP) module was introduced in the neck network structure, and then to carry out the maximum pooling operation with three pooling kernels (5×5, 9×9, 13×13). Feature Pyramid Network (FPN) structure was adopted to improve the detection accuracy of small target strawberries. Finally, the Efficient Intersection over Union Loss (EIoU Loss) was used to separate the influence factors of aspect ratio, and then calculate the length and width of the target frame and anchor box. As such, the convergence speed was faster with higher regression accuracy than before. The original data set was collected, consisting of 841 strawberry images with a complex background in the greenhouse. Data enhancement was carried out for the training, the verification, and the test set, in order to improve the generalization ability of the model. The experimental results showed that the average accuracy of the improved YOLOv4-Tiny model in the test set was 92.62%, which was 5.77 percentage points higher than the original one. The average detection time of each image was 5.63ms, and the final model size was only 4.68MB. The average accuracies of the improved model were 9.11, 4.80, 2.26, 1.22, and 1.91 percentage points higher, while the1 scores were 0.08, 0.05, 0.03, 0.01, and 0.03 higher than those of the SSD, CenterNet, YOLOv3, YOLOv4, and YOLOv5s target detection networks. The improved YOLOv4-Tiny model was much smaller than the SSD, CenterNet, YOLOv3, YOLOv4, where the network structure size was only 1/3 of YOLOv5s. The average detection speed of each image was only 5.63 ms, which was reduced by 5.57, 7.14, 9.20, 15.99, and 2.16 ms, respectively. Therefore, the improved YOLOv4-Tiny model can fully meet the requirements of high precision and real-time detection of strawberry fruits under the background of the orchard in the greenhouse. The finding can provide an effective way for the accurate detection of strawberry fruits in a complex environment using picking robots.

machine vision; image processing; fruit identification; YOLOv4-Tiny; attention mechanism; small target

10.11975/j.issn.1002-6819.2022.18.021

S126

A

1002-6819(2022)-18-0195-09

孙俊,陈义德,周鑫,等. 快速精准识别棚内草莓的改进YOLOv4-Tiny模型[J]. 农业工程学报,2022,38(18):195-203.doi:10.11975/j.issn.1002-6819.2022.18.021 http://www.tcsae.org

Sun Jun, Chen Yide, Zhou Xin, et al. Fast and accurate recognition of the strawberries in greenhouse based on improved YOLOv4-Tiny model[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(18): 195-203. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2022.18.021 http://www.tcsae.org

2022-07-05

2022-09-02

江苏大学农业装备学部项目(NZXB20210210),江苏高校优势学科建设工程(三期)资助项目(PAPD-2018-87)

孙俊,博士,教授,博士生导师,研究方向为计算机技术在农业工程中的应用。Email:sun2000jun@ujs.edu.cn

中国农业工程学会会员:孙俊(E041200652S)