孪生网络特征融合与自适应加权的目标跟踪算法*

徐淑萍,万亚娟

(西安工业大学 计算机科学与工程学院,西安 710021)

近年来,随着科技的不断发展,目标跟踪在无人驾驶、智能交通、人机交互等多个领域得到了广泛的应用,具有良好的发展前景[1-3]。然而,在实际跟踪场景中,往往会遇到背景杂乱、遮挡、形变等干扰因素,所以构建一种准确、鲁棒的目标跟踪算法仍然是一个极具挑战性的问题[4]。

近年来,基于孪生网络的目标跟踪算法因为其优异的跟踪性能和较好的实时性而得到了广泛的关注[5-6]。文献[7]提出的全卷积孪生网络(Fully-Convolutional Siamese Networks,SiamFC)目标跟踪算法将跟踪问题看做是模板匹配问题,无需更新模板,速度快且准确率高,但因尺度问题导致鲁棒性不强。文献[8]提出的孪生区域建议网络( Siamese Region Proposal Network,SiamRPN)目标跟踪算法将跟踪任务看做是单样本检测,在SiamFC的基础上加入了区域建议网络[9](Region Proposal Network,RPN),可得到目标边界框的位置和形状,有效的减少了尺度变化的影响,但模型的泛化能力较弱,目标丢失时仍能有较大响应1。为进一步提升孪生网络的跟踪性能,文献[10]提出了深层网络的孪生区域建议(Siamese Region Proposal Network with Very Deep Network,SiamRPN++)跟踪算法,在互相关部分引入了一个逐层特征聚合结构,设计了三层级联RPN并使用深度互相关机制,增强了算法的鲁棒性;文献[11]提出的浅中深特征融合孪生网络(Shallow-Middle-Deep Feature Fusion Siamese Network,SiamSMDFF)跟踪算法,将浅中深层特征相融合以获得互补特征映射,对目标进行准确定位。随着注意力机制的发展,将注意力机制嵌入到孪生网络中成为了研究的热点。文献[12]提出孪生注意力网络(Siamese Attention Network,SiamAttN),将注意力机制引入RPN网络,通过加权融合分类分支和注意力分支的得分来区分正负样本;文献[13]提出孪生目标感知网络(Siamese Object-Aware Network,SiamOAN),在主干网络部分引入通道注意力,自适应的识别目标的重要特征,一定程度上减少了背景干扰。以上跟踪算法虽然取得了一定的成果,但在实际复杂场景中仍有一些局限性。算法只使用从最后一层卷积层提取到的语义特征而忽略了有助于区分目标和背景的细节特征;算法很少使用注意力机制或只使用通道注意力机制,只关注各个不同通道的重要程度,而忽略了目标的空间信息。在相似物干扰和遮挡因素干扰下,很容易出现目标丢失与错误跟踪,降低跟踪精度。

综合上述分析,文中基于SiamRPN跟踪算法,并结合多层特征融合算法,引入自适应加权网络,设计一种基于孪生网络特征融合与自适应加权的跟踪算法,减少实际跟踪过程中因遮挡和环境干扰对结果的影响,提升跟踪的精度和稳定性。

1 MFAW-SiamRPN跟踪算法

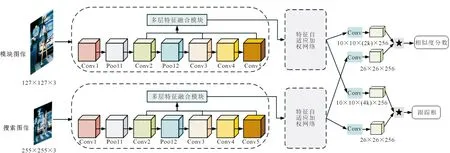

多层特征融合与自适应加权的孪生区域建议(Multi-Layer Feature Fusion and Adaptive Weighting Siamese Region Proposal Network,MFFAW-SiamRPN)跟踪算法在SiamRPN算法的基础上融入了特征融合模块和自适应加权网络,算法框架如图1所示。

图1 MFAW-SiamRPN算法框架图Fig.1 The framework of MFAW-SiamRPN algorithm

在特征提取网络部分嵌入特征融合模块,融合网络的深层和浅层信息,丰富目标的特征表示能力;在特征提取网络末端嵌入特征自适应加权网络,关注各个通道和区域位置上的重要特征,提高网络的适应性和辨别能力;将上述数据输入到RPN网络进行相似度计算,输出目标当前帧的预测边界框位置。

1.1 多层特征融合

SiamRPN跟踪算法只采用主干网络最后一层卷积层的特征来描述被跟踪目标,文中为避免因特征提取不充分而导致无法辨别目标和相似干扰物的问题,提出多层特征融合模块,具体如图2所示。

图2 多层特征融合模块图Fig.2 Multi-layer feature fusion module

在图2中,C={C1,C2,C3,C4,C5}表示在主干网络的每个阶段获得的特征映射,其中C5是最后一层卷积层的特征图,将其作为skipASPP模块的输入。与传统卷积相比,空洞卷积可以在不增加核参数数量的情况下获得更大的感受野,在skipASPP模块,使用膨胀率大小分别是1,2,5的空洞卷积进行跳跃连接,以增强每个卷积块的输入和输出的交互功能,skipASPP模块的工作原理为

(1)

式中:Si为每个空洞卷积的操作;⊕为两个特征图按元素相加;outi为每个空洞卷积块输出的结果。skipASPP模块最后的输出为

out=S1(C5)⊕S2(out1)⊕S3(out2)。

(2)

将skipASPP模块的输出与C5进行add运算,得到M5,对M5进行连续上采样,并与主干网络经过横向连接输出的特征图相结合,输出不同尺寸大小的特征图M4-M1。为了减少多次上采样产生的混叠失真效应的影响,通过调整并平均M1,M2,M4,M5到与M3相同尺寸大小来获得更充分的图像上下文和感受野信息,最终得到特征图M。

1.2 特征自适应加权网络

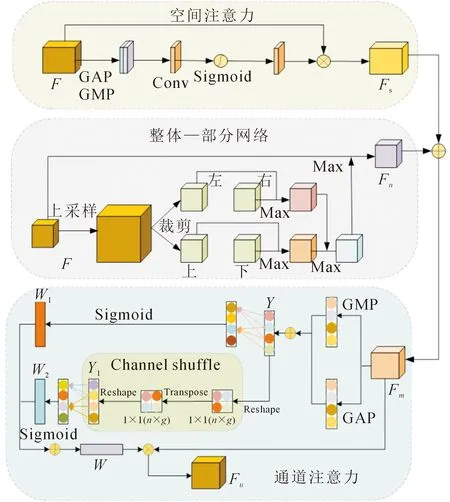

虽然在孪生网络特征提取部分加入了多层特征融合模块使提取到的特征包含丰富的深层语义特征和浅层细节特征,但是在遮挡、运动模糊、光照变化等干扰因素的影响下,网络的鲁棒性依然很差。主要是因为不同通道、不同区域的特征图对整个跟踪过程的贡献是有差异的,将特征图的不同通道或区域同等对待取相同的权重是不合理的,所以引入特征自适应加权网络对不同通道、不同区域进行自适应权重计算,详细的网络结构如图3所示。从图中可以看出,该网络由通道注意力、整体-部分网络、空间注意力三部分组成,每部分的详细介绍如下。

图3 特征自适应加权网络Fig.3 Feature adaptive weighted network

1.2.1 空间注意力

空间注意力更注重对目标位置特征的描述[14],也是对通道注意力的一种补充,利用不同通道中各个位置之间的关系来构建空间注意力,对目标特征信息中最丰富的区域予以更多的关注[15]。空间注意力模块将孪生网络特征提取部分输出的特征图作为输入,沿通道方向分别对特征图上的各个位置做全局平均池化(GAP)和全局最大池化(GMP),获得2个大小是w×h的单通道特征图像,将其沿通道方向进行特征拼接后变成大小是w×h的双通道特征图;之后利用隐藏层对得到的特征图进行卷积,将其映射到同一特征空间;卷积结果经过Sigmoid激活函数激活之后可以生成一个二维的空间注意力图Fs,公式为

Fs=σ(Conv(Concat(GAP(F),GMP(F)))),

(3)

式中:GAP,GMP分别为全局平均池化、全局最大池化;Concat为特征拼接;Conv为卷积操作;σ为Sigmoid激活函数。

1.2.2 整体-部分网络

为了改善特征位置的空间不变性,描述全局特征和局部特征之间的语义关系[16-17],提出一种整体-部分网络,主要过程是:将一个完整的特征图划分成多个小区域;在学习被拆解的部分之间的强的语义依赖的时候,把这几个部分的模型整合到一起;结合全部外观模型和局部外观模型的特征图,用于之后的目标分类和回归。具体操作如图3所示,使用因子为2的双线性插值法将经过多层特征融合模块后得到的特征图F上采样得到新的特征图F′,使用裁剪操作将其切分成上下左右四个部分,使用max函数融合部分特征映射和整体特征映射得到一个新的同样大小的特征映射Fn,其定义为

(4)

其中p,q分别为上下左右的每一部分、两部分组合后的部分(左-右或者上-下)或者四部分的融合。将经过空间注意力处理后得到的特征映射与经过整体-部分网络处理后的特征映射相加,得到的新的特征映射Fm作为通道注意力部分的输入。

1.2.3 通道注意力

通过卷积层可以提取到多通道的特征图,每个通道的特征图代表的是颜色、边缘、纹理等不同种类的信息[18]。在实际的跟踪场景中,不同通道的特征图的贡献是不一样的[19],有些通道包含的信息可能很关键很有意义而有的通道可能不包含信息或者包含一些无用的信息,所以可以通过通道注意力给不同的通道分配不同的权重,有选择的提取目标的特征,提高模型的判别力。

单独使用GAP或GMP可能会忽略掉通道内的部分特征信息,所以为了获得更全面的特征信息,文中的通道注意力融合全局平均池化和全局最大池化;同时在不降低通道维数的情况下采用快速一维卷积实现跨通道信息交互,但这种方法只捕获了每个通道与其相邻k个通道之间的局部跨通道交互,可能会失去与其他通道之间的交互,为了解决这个问题,在融合后的特征图上增加一个新的分支,通过通道混洗后该通道再与其相邻的k个通道进行局部跨通道交互以捕获不同的信息。

文中提出的通道注意力网络如图3所示,输入的特征Fm∈RC×H×W,其中C,H,W分别为特征图的通道数、高、宽。对输入的特征图分别进行全局平均池化和全局最大池化,将得到的结果进行逐点相加,公式为

y=GAP(Fm)⊕GMP(Fm)。

(5)

在新分支上对y进行通道混洗操作,假设特征图y被分成g组,每组有n个通道,将特征图y的通道尺寸重塑为g×n,转置,将其展平得到y1。

接下来使用快速一维卷积来捕获局部跨通道信道交互,公式为

w1=σ(C1DK(y)),

(6)

w2=σ(C1DK(y1)),

(7)

其中卷积核k的大小可以通过自适应计算得到,具体计算公式为

(8)

使用特征相加的方式将两个分支的特征向量进行融合,将得到的权值矩阵与特征图Fm相乘得到最终的特征图Fu。

1.3 分类和回归

MFAW-SiamRPN使用区域建议网络(RPN)实现目标的分类和回归,其中分类主要是用来鉴别前景和背景,回归主要是为了生成候选区域,从而获取边界框的正确位置,其框架结构如图1所示。将通过特征提取网络、特征自适应加权网络后得到的模板特征图φ(z)和搜索特征图φ(x)作为输入;使用两个3×3的卷积层将φ(z)的通道数提升到2k和4k,得到的两个卷积层中[Φ(z)]cls用于分类,[Φ(z)]reg用于回归,其中k代表锚框的数量,使用两个大小为3×3通道数不变的卷积层将φ(x)变成大小为20×20×256的卷积层;在模板分支和搜索分支上计算φ(z)和φ(x)的相关性。为了训练文中提出的MFAWSiamRPN算法,分类分支采用交叉熵损失函数,而回归分支采用smoothL1损失函数。用Ax,Ay,Aw,Ah为锚框的中心点坐标和尺寸,用Tx,Ty,Tw,Th为真实框的中心点坐标和尺寸大小,对坐标偏移量进行标准化处理,公式为

(9)

通过smoothL1来计算回归分支的损失,公式为

(10)

所以网络整体的损失函数计算公式为

loss=Lcls+λLreg,

(11)

式中:λ为平衡分类和回归两部分的超参数;Lreg为smoothL1损失;Lcls为交叉熵损失;其计算公式为

(12)

2 实验验证与分析

2.1 实验准备

用Pytorch深度学习框架在PC机上实现,GPU为GetForce RTX 2080Ti,内存大小是64 G。算法基于Python语言编写,使用标准差为0.01、均值为0的高斯分布初始化主干网络。算法所使用的到的数据集有GOT10k,OTB2015,VOT2018,使用动量为0.9,权重衰减为0.000 5的随机梯度下降算法(SGD)对网络进行训练,共进行50轮迭代,其中前五轮主要用来预热,学习率从0.001线性增加到0.005,在剩下的45轮训练中,学习率从0.005呈指数衰减到0.000 01,每轮训练的批尺寸大小为16。

2.2 定量分析

在OTB2015、VOT2018数据集上将MFAW-SiamRPN算法与其他已有的先进的跟踪器进行比较,文中所提算法取得了较为优异的结果。

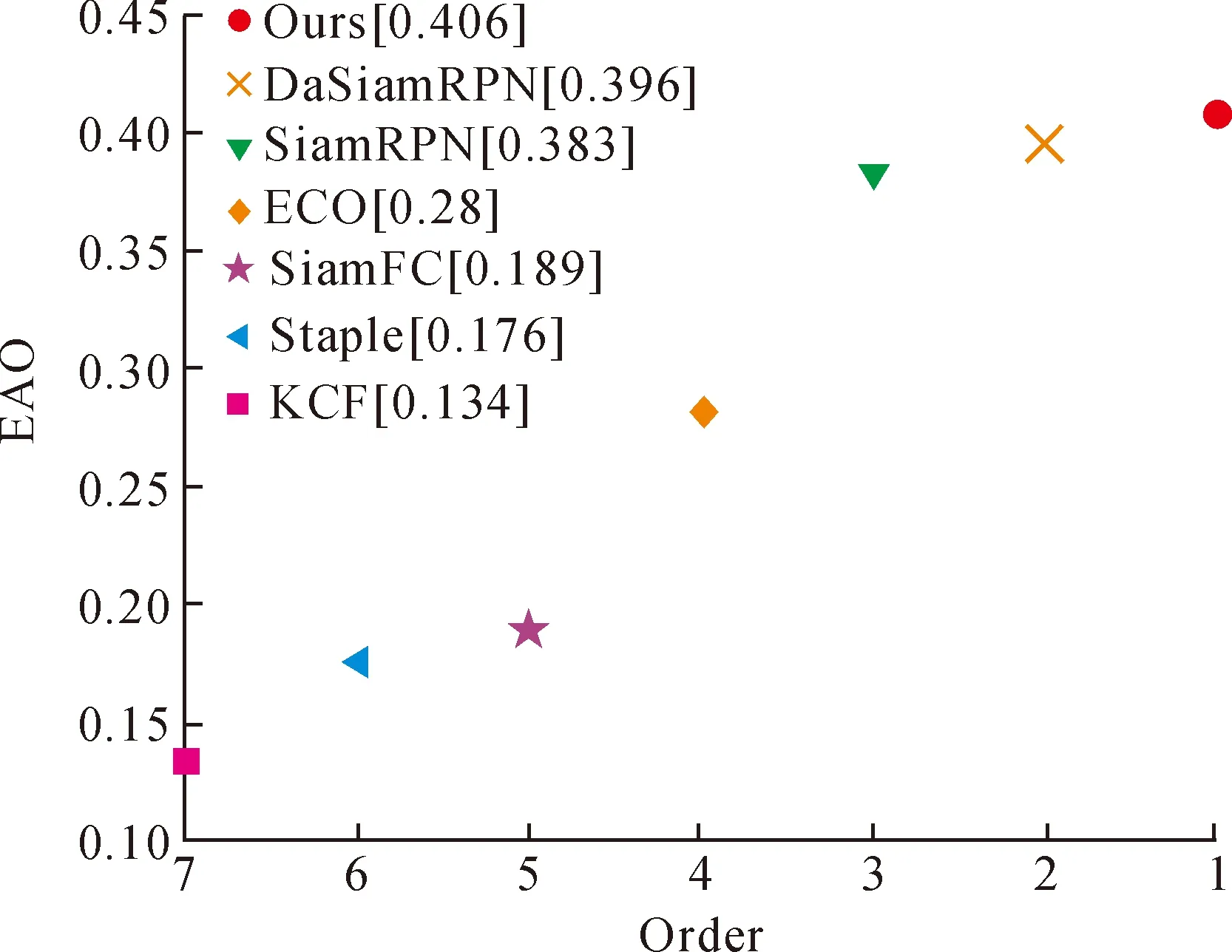

2.2.1 VOT2018结果分析

VOT2018数据集包括60个视频序列,具有遮挡、形变等不同的挑战属性,评价指标包括准确率、期望平均重叠率等。其中准确率代表预测的目标的中心位置和目标实际的中心位置之间的平均欧氏距离小于给定阈值的帧数与总视频帧数之间的比率,用百分比的形式表示;期望平均重叠率(Expected Average Overlap,EAO)是将不同长度序列求得的准确率的平均值再取平均,所求结果是一个百分数;鲁棒性用来评价跟踪器是否稳定,数值越大,稳定性越差。目标预测框和真实框之间的交并比为0时代表跟踪失败,鲁棒性的计算公式为跟踪失败次数与总的跟踪次数之间的比率,用一个百分数来表示。将MFAW-SiamRPN算法与Staple[20],KCF[21],SiamFC,SiamRPN,DaSiamRPN[22],ECO[23]六种主流的跟踪算法进行比较,实验结果见表1。

表1 VOT2018测试结果Tab.1 VOT2018 test results

可以看出,文中提出的跟踪器取得了比较好的效果,虽然准确率略低于DaSiamRPN,但在EAO值和鲁棒性上均优于其他算法。图4为不同算法的EAO排序图,横坐标为排名,纵坐标为EAO值。

图4 VOT2018数据集期望平均重叠率图Fig.4 VOT2018 dataset expected average overlap rate

从图4可以看出,文中提出的跟踪器的EAO值达到了0.406,相比于基准跟踪器SiamRPN提高了2.3%。综合表明,MFAW-SiamRPN跟踪算法整体性能不错,可以达到比较好的跟踪效果。

2.2.2 OTB2015结果分析

OTB2015由100个视频序列组成,拥有遮挡、形变等11种挑战属性,评价指标为准确率、成功率。成功率代表目标的预测框和真实框之间的交并比(IOU)大于设定的阈值的帧数占总视频帧数的比率,其中准确率、成功率越高,跟踪器的性能就越好。

将MFAW-SiamRPN算法与其他六种现有的跟踪算法Staple,KCF,CFNet,SiamFC,SiamRPN,DASiamRPN进行对比,在OTB2015上的实验结果如图5所示。其中图5(a)中,纵轴代表成功率,横轴代表预测框与真实框之间的重叠率,以百分比的形式表示;图5(b)中,纵轴代表准确率,横轴是设置的不同的像素值范围;从图中可以看出,MFAW-SiamRPN算法的准确率为0.872,成功率为0.664,相比于基准跟踪器SiamRPN,准确率增加了2.5%,成功率增加了2.8%。结果表明,MFAW-SiamRPN算法能提取到更丰富的特征,网络具有更强的适应性,跟踪效果较好。

图5 OTB2015实验结果图Fig.5 OTB2015 experimental results

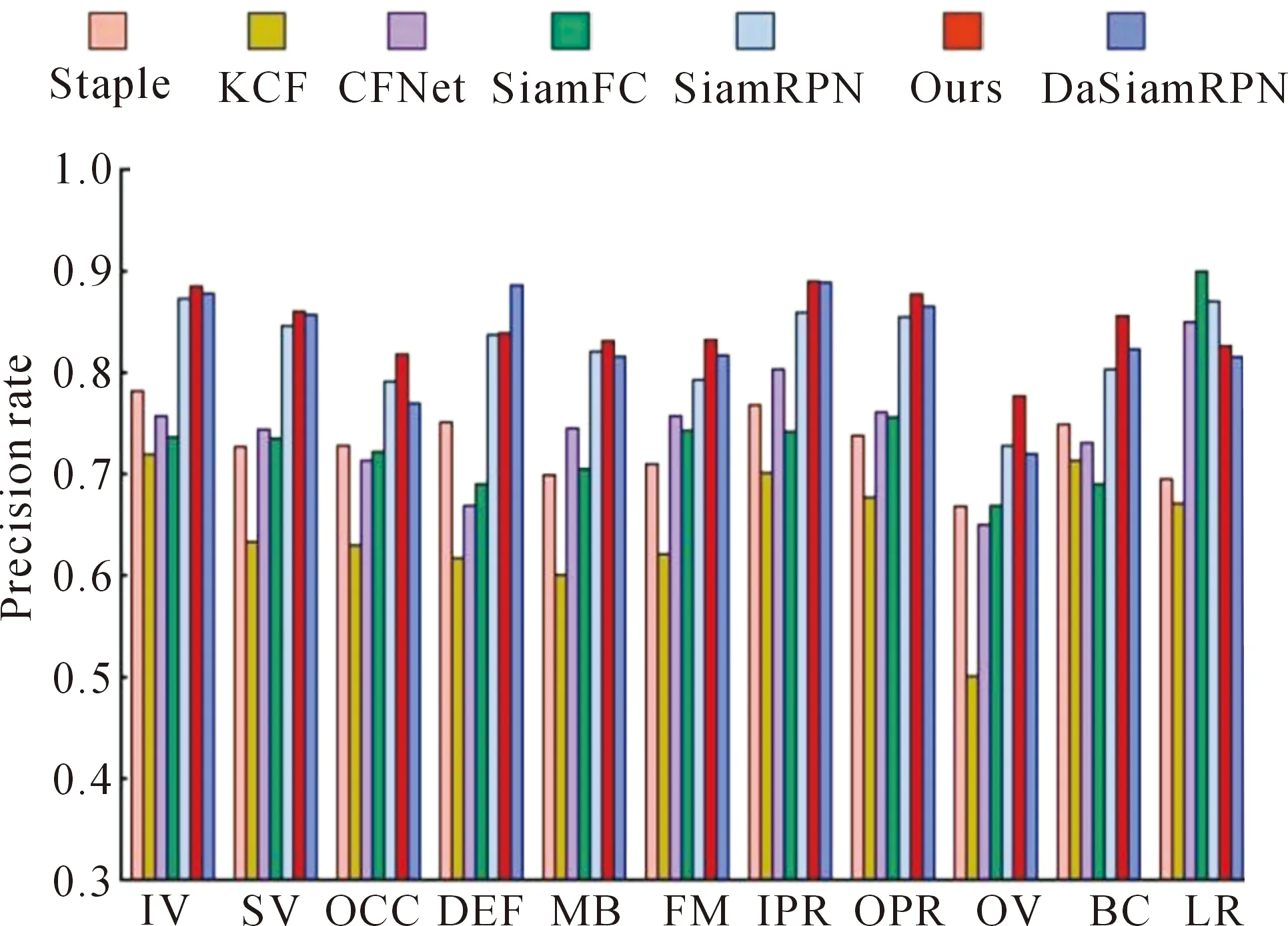

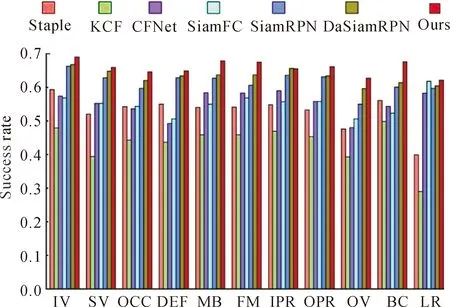

为了全面评估MFAW-SiamRPN跟踪算法在各种挑战属性上的性能,将MFAW-SiamRPN算法与其他已有的跟踪算法在含有11种不同挑战属性的图像序列上进行对比实验,结果如图6~7所示。

图6 OTB2015的11种挑战属性上的准确率Fig.6 Accuracy on 11 challenge attributes of OTB2015

图7 OTB2015的11种挑战属性上的成功率Fig.7 Success rate on 11 challenge attributes of OTB2015

实验表明,MFAW-SiamRPN算法能够很好地应对复杂环境中的各种挑战,该跟踪器在11个挑战属性上均优于基准跟踪器SiamRPN。同时,与其他跟踪器相比,文中跟踪器在大多数情况下表现良好。以上分析表明,MFAW-SiamRPN算法在处理各种挑战场景方面是有效的,尤其是在遮挡、背景杂乱方面。

2.3 定性分析

为了更加直观的观察MFAW-SiamRPN算法的跟踪性能,从OTB2015数据集中选取具有代表性的5段视频图像序列对跟踪结果进行分析,并与其他6种跟踪器进行比较。图8展示了7种不同的跟踪器在遮挡、背景杂乱、形变、出视野等挑战因素[24]干扰下的跟踪结果。

图8 七个不同的跟踪器在6段视频序列上的跟踪结果Fig.8 Tracking results of seven different trackers on six video sequences

1) 遮挡。在目标跟踪任务中,遮挡分为部分遮挡和全部遮挡,如图8当中的Human3、Jogging图像序列。在Human3图像序列中,目标男性在走向马路对面的过程中先后经过了一个女孩和一个交通指示杆从而经历了遮挡和遮挡后重现的过程。在第30和第45帧中,目标男性被部分遮挡,所有跟踪器都能够准确的跟踪到目标,但当他在第72帧中完全重新出现后,除了KCF,Staple外,其他跟踪器都能够跟踪到该目标男性。在Jogging序列中,慢跑的目标女孩在73帧中被信号灯遮挡,在96帧重新出现,只有文中提出的跟踪器仍精准的跟着目标女性。

2) 背景杂乱。在图像序列Bolt2,Subway中,被跟踪目标与周围人的外形、衣服十分相似,容易对跟踪过程造成一定的干扰。在Bolt2图像序列中,被跟踪目标与其他运动员的相似穿着和场景的不断切换导致背景十分杂乱,在第80帧,Staple,KCF,CFNet开始跟错目标,在第143帧,SiamFC,SiaRPN,DaSiamRPN也开始跟丢目标,只有文中算法在整个视频序列中可以持续稳定的跟踪目标。在Subway序列中,目标在第47帧碰到一个衣着相似的人,由于相似物的干扰导致最后只有文中算法跟着目标人物。

3) 形变。在序列Walking2中,目标女性在远离镜头走动的过程中尺寸逐渐变小,只有文中算法在整个序列中表现良好。主要是因为文中跟踪器在特征提取网络部分集成了多层特征融合模块,提取到了更丰富的空间信息和语义信息。

4) 出视野。在图像序列Human6中,目标男性在过马路的过程中出现了身体的一部分在镜头之外的情况,在第545帧,目标的脚不在图像内,在第549帧中,身体的一半都已经离开了视野之内,导致提取到的信息不充分不完全,使得其他算法预测的跟踪框不准确,位置产生了偏移,而文中提出的算法由于集成了多层特征融合和特征自适应加权网络,提取到了更多、更有用的信息,从而能够更为准确的表示目标、框选目标。

2.4 消融实验

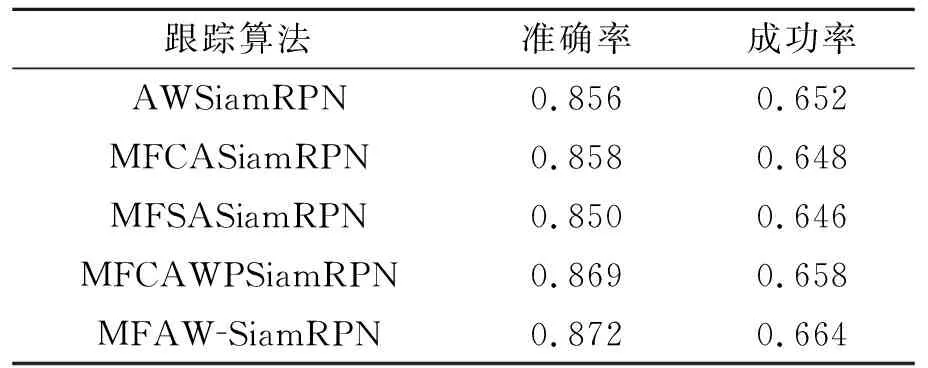

MFAW-SiamRPN主要由四个部分组成,即多层特征融合、空间注意力、通道注意力、整体-部分网络。为了更充分的理解每个部分在跟踪算法中的贡献,在OTB2015数据集上分析对比MFAWSiamRPN算法的四种变体,分别是仅使用自适应加权网络,不使用多层特征融合模块,构建AWSiamRPN算法;使用多层特征融合模块和通道注意力构建MFCASiamRPN算法;使用多层特征融合模块和空间注意力构建MFSASiamRPN算法;使用多层特征融合模块、通道注意力、整体-部分网络构建MFCAWPSiamRPN算法。对比跟踪算法共有五种,其消融实验结果见表2。从表中可以看出,相比于MFAW-SiamRPN,AWSiamRPN在准确率和成功率上分别降低了1.6%、1.2%,主要是因为提取到的浅层细节信息和深层语义信息增加了模型的外观表征能力,从而提升了跟踪的精度。同时,MFCAWPSiamRPN算法相比于MFCASiamRPN算法准确率提高了1.1%,成功率提高了1%。以上分析表明,跟踪器的每个部分都有助于提升跟踪器的整体性能效果,多层特征融合模块使得模型能够提取到更丰富的特征,自适应加权网络使得模型能够根据各部分的重要程度对不同区域和通道分配不同的权重,重点关注有价值的区域。

表2 消融实验结果Tab.2 Ablation experimental results

3 结 论

MFAW-SiamRPN算法在孪生区域建议网路SiamRPN的基础上,集成多层特征融合模块、自适应加权网络,提出了一种基于多层特征融合和自适应加权的孪生网络目标跟踪算法MFAW-Siam-RPN。多层特征融合模块采用具有不同扩张率的空洞卷积来充分利用上下文信息,用跳跃连接实现足够的特征融合,使模型具有更好的适应性和判别力。由空间注意力、整体-部分网络、通道注意力组成的自适应加权网络给不同的区域和通道分配不同的权重,使网络能够学习到更鲁棒的特征表示,进一步增强了网络的特征识别能力。在OTB2015和VOT2018数据集上的实验结果表明所提跟踪算法与其他几种先进的跟踪算法相比具有良好的跟踪性能,可以在高帧率下有效的处理遮挡、背景杂乱、形变等问题。相比较基准跟踪器SiamRPN,文中算法在OTB2015数据集上的准确率提升了2.5%,成功率提升了2.8%,在VOT2018数据集上的EAO值提升了约2.3%。