基于VR 的建筑行人交通行为数据采集与评价*

王 朔,徐 建,李闽平,黄 玲

1 研究背景

近年来,大型公共建筑中的密集行人交通及疏散等问题受到越来越广泛的研究及关注[1]。行人交通特性研究一般包括单个行人和群体行人两个方面,二者的侧重点不同。对于单个行人,其主要的交通特性指标包括步行速度、步幅、占用空间等,对于群体行人主要包括行人交通量、行人密度、平均速度等。建筑环境内行人交通行为还包括行人的其他活动特征,如寻路、对空间设施的反应、标识系统的引导、空间物理环境(如建筑室内的声环境、光环境)等相关影响等。

目前行人交通研究手段主要集中在以下几个方面:

(1)基于实验的研究,包括通过现场观测、演习及有控实验等多种方法[2]。

(2)行人交通仿真模型,采用计算机模拟手段研究特定场景下行人交通问题,包括基于元胞自动机[3]、格子气[4]、社会力[5]、多智能体等[6-8]各类行人交通计算机仿真模型。

(3)行人交通行为数据采集,采用人工或仪器的方法对行人交通行为数据进行采集、统计、分析[9,10]。

尽管计算机模拟手段取得了很大的进步,基于实验或现场观测的行人数据采集仍然是行人交通特性分析、仿真模型建立、仿真模型标定、验证等工作的基础。

传统的行人数据采集包括人工观测、仪器自动检测及问卷调查等。连续的人工观测耗时长,准确率低,调查内容也受到局限,因此人工监测一般用于短期的交通调查或计数统计等。基于现场有控实验的行人数据采集主要缺点是对于特殊情况,如火灾、爆炸、大客流等紧急情况下的行人交通实验存在安全隐患及难于组织实施。

近年来,VR 技术获得了广泛的发展及应用。VR 技术提供的实时三维空间表现能力、人机交互式的操作环境以及给人带来的身临其境感受为建筑设计、城市规划设计、建筑环境评价模拟等提供了良好的技术手段[11]。

VR 技术应用于建筑环境行为设计到多方面的问题,既包括多通道虚拟环境实现技术、人机交互技术等具体实现技术,也包括虚拟环境模拟因素控制与主观评价等实验技术。Rudolph Darken 和Barry Peterson 对VR 环境中的移动、导航及寻路行为进行了研究及总结,包括空间信息的获取,空间信息的表示,空间环境导航模型,虚拟环境中的导航设计,虚拟空间中展示过程中的视频效果对人的环境识别任务执行的影响等[12]。孙澄宇等对虚拟漫游控制中的步行姿态控制及校准方法进行了研究[13];申申等对基于显示器及头盔两种模式的空间场所认知模式及场景感知进行了研究[14]。总的来说,目前的研究较多的关注虚拟环境中的特定要素的影响因素进行研究,或是使用简化的交互手段模拟环境行为,而创建一个高度仿真及人机交互沉浸感,对环境行为进行细粒度的记录的环境行为实验平台对实验的有效性及准确性至关重要,本文的研究综合应用了虚拟现实技术及人机交互技术的最新成果,搭建虚拟环境交互及环境行为数据获取平台,并进行了寻路空间行为模拟及初步的环境行为数据采集与分析,对实时采集数据的类型、结构及数据的可分析性进行研究。

2 基于VR 技术的行人行为模拟与数据采集分析平台

本研究借助VR 技术建立对应的空间虚拟环境,通过人机接口技术,让测试者在虚拟环境中完成特定的目标,通过记录测试者在时间序列中的位置、动作等数据,进行相应的数据分析。为了实现在虚拟环境中实现行人交通行为的模块及数据采集、分析,笔者搭建了针对建筑空间场景模拟及行人数据采集系统。基于VR 的行人模拟与数据采集平台主要实现了以下几个关键问题:

(1)环境模拟,包括环境的逼真程度,标识系统创建等;

(2)环境效果及事件效果模拟,包括建筑环境中灯光效果、环境声效的变化,以及燃烧、爆炸、烟气扩散等环境事件模拟;

(3)大客流模拟,通过集成第三方模拟软件的模拟结果在VR环境中重建大客流;

(4)行为模拟及数据采集(模拟真实的走路、躲避障碍物及人群、上楼梯,乘扶梯);

(5)多人联机协作场景交互。

图1 为应用平台的基本实现框架,其核心是基于Unreal[15]虚拟引擎的仿真平台,该部分主要实现了虚拟场景的渲染,与程序及外部设备交互,场景特效渲染等功能,大客流动态人物展现等核心功能。针对个体交通行为的模拟,本研究采用了Omni 万向跑步机及HTC Vive 头盔作为用户主要人机交互设备。Omni 万向跑步机支持用户在该设备上模拟走路、转方向、跑步等多种动作,系统可以采集到测试者当前的方向,双脚动作的状态等来标定测试者的行为状态。HTC Vive 除提供三维全景的图像显示功能,也可以同时捕捉用户视线的方向,视线的仰角/俯角等信息,从而记录用户在场景中行走时的路径,在不同时刻的场景中的关注点、兴趣点等相关行为信息。

本文扩展了Omni 与HTC Vive 应用接口,增加用户行为动作与现实场景行为动作匹配与校准的功能,并开发模拟使用楼梯、乘用自动扶梯等对应的模拟功能。通过模拟测试与校准功能,将虚拟人机交互动作与实际行为动作的反应速度、行走速度等相匹配,从而获取正确的模拟数据。这部分结合多人测试实验及评价完成。行为数据采集模块则记录整个测试过程中测试者在虚拟场景中的行为信息,包括时间序列的时间戳、位置坐标、视线方向(水平角度,仰角/俯角)等作为环境行为研究数据。

针对虚拟环境中的大客流,本文应用Anylogic[16]进行大客流仿真,通过AnyLogic 软件导出标识的行人位置,方向信息,行人在场景中的动作则在模拟平台中根据行人动作的上下文重建相关的动作,如行走,转身、跑步等。

3 案例研究

本研究结合广州地铁燕塘地铁站为例进行了相关的行人交通数据采集的初步试验。在以往的研究中以此站点为例进行了相关的应急预案场景模拟,相关的工作作为本文的试验基础[17]。

燕塘站属于典型的地铁换乘站,3 号线及6 号线在此站换乘。整个车站分为4 层,由上至下分别为站厅层、6 号线站台层、3/6 号线转换层及3 号线站台层。各层之间主要靠自动扶梯及单跑楼梯连接,由图2 可以看出,通过不同的楼梯可能会组合出不同的路径,且形成的路径距离有一定差异。

模型创建充分考虑到三维视觉及标识系统等因素的影响,对于站内的标识系统进行了精细的建模。以便测试者能够根据场景信息及标识信息决定下一步行动的方向、动作等行为。

本案例实验的目的是利用虚拟现实技术对燕塘地铁站进行完整的模型创建,并利用虚拟行为采集系统对乘客在车站内的寻路行为进行模拟,获取客观寻路行为数据,如寻路运动轨迹、步行速度、寻路时间、错误率等。同时通过实验采集数据进行寻路行为分析,借此验证本实验平台的可行性。

实验步骤如下:

1)告知被试实验目的和方法;

2)每个测试者正式实验前适应几分钟虚拟现实环境;

3)临时告知被试目的地。被试者随机选择从六号线或三号线站台出发走到A、B、C 出口,每个测试者做两次目标试验,第一次试验完成后才告知第二次测试目标。

实验共23 人参加,其中3 名女性测试者,每个人随机被分配相关的任务,从地铁3 号线或6 号线的某个位置走到指定的出口(地铁A、B 和C 出口),实验每隔0.2 秒记录了测试者的X、Y、Z 坐标及视线角度。

4 数据分析

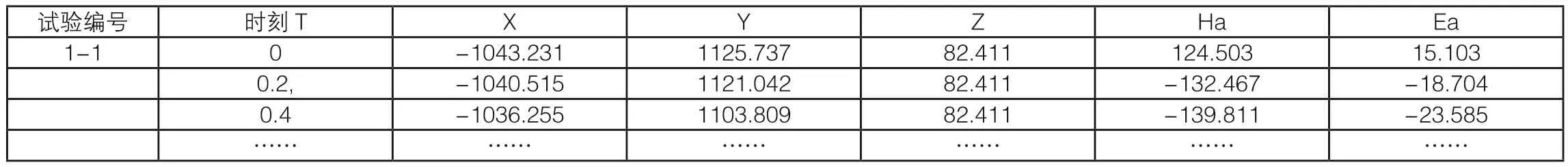

对23 名测试者测试过程进行了相关的记录,表1 详细记录了每个测试者在0.2 秒时间间隔下详细的位置及方向数据。其中,时刻T 为采样时间,X、Y、Z 数据记录了在具体的时刻测试者在空间中的位置坐标,Ha 为测试者在采样时刻视线方向的水平投影角度,Ea 为视线方向的垂直角度。表2 是根据表1 相关数据整理得到的46 组实验分析所需数据,包括每个整个测试过程用时及行走路线总的长度及平均速度等。其次,根据每个人的行走路径采集数据,在空间中绘制了每个测试者的行走路径以及测试者在每个位置的视觉方向矢量。

表1 单个测试者测试数据记录(片段)

表2 46 组测试数据统计资料(片段)

4.1 路径数据分析

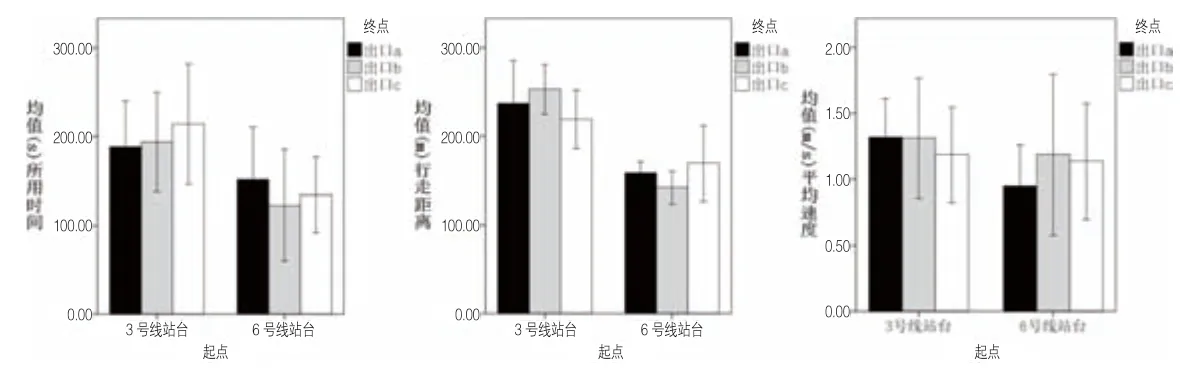

通过单因素ANOVA 分析,显示不同类型的路径在所用时间、行走距离和平均速度上的差异均无统计学意义(图3),但是部分路径的特征较为明显。以3C 路线(起点为3 号线站台,终点为C出口)为例,其路径距离最短,但是消耗时间最长,其中一部分原因是步行速度变慢导致的。而类似的还有6A 路线,说明这些路线相比于其它路线有很明显的影响步行速度的相关因素,找出这些因素对提高站内的通行效率有一定的帮助。

图3 不同测试路线时间(左)、距离(中)、及平均速度分布(右)

不同性别间的步行速度差异较明显(F(1,44)=4.92,P<0.05),且男性的步行速度要高于女性,分析其原因是男性对实验设备的操作熟练度要高于女性,并且男性的体力要好于女性。不同年龄的步行速度差异并不明显,其原因是本次实验受试者的年龄差距并不是很大,多集中在18~22 岁这一同龄层次之间。

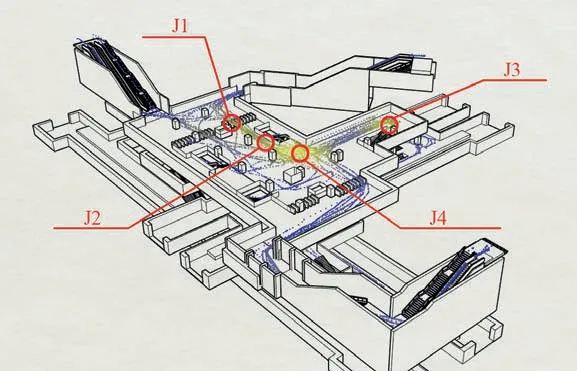

将46 组数据中每个位置的采样点在空间中进行标识,可以得到整个测试过程的运动轨迹(图4)。实验结果表明:路径重叠密集区较为集中(图中黄色区域),主要集中在闸机(J1)、狭窄通道(J2)、上下行楼梯转弯口(J3)、站厅与通道的转点(J4)等区域。说明这些区域是行人密度较高及易拥堵区域,需做好引导措施保证站内通行的顺畅。

图4 测试人员运动轨迹及空间位置密度分布

4.2 行为数据分析

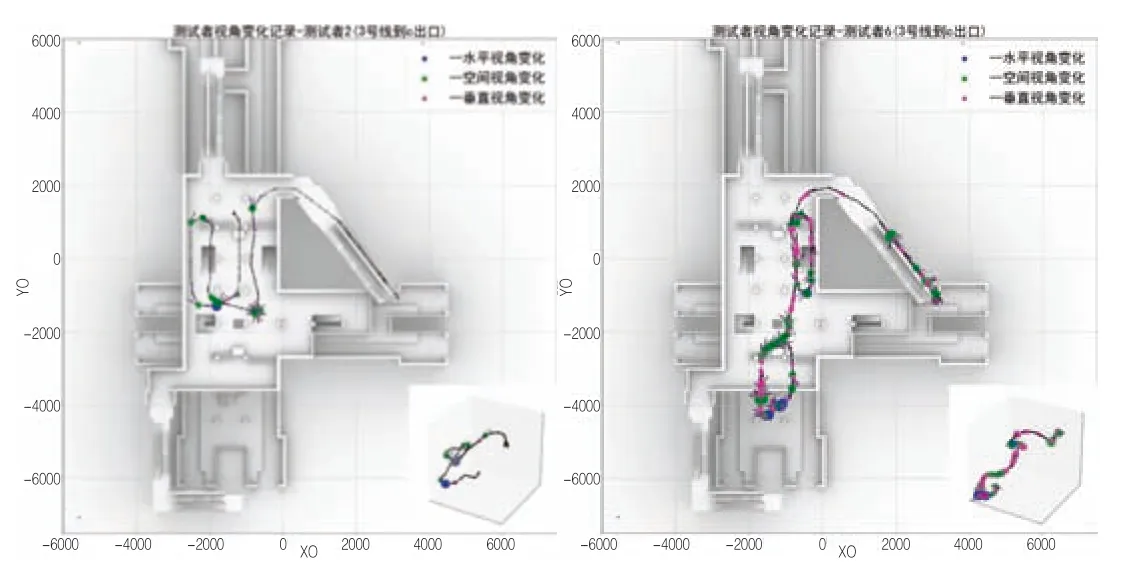

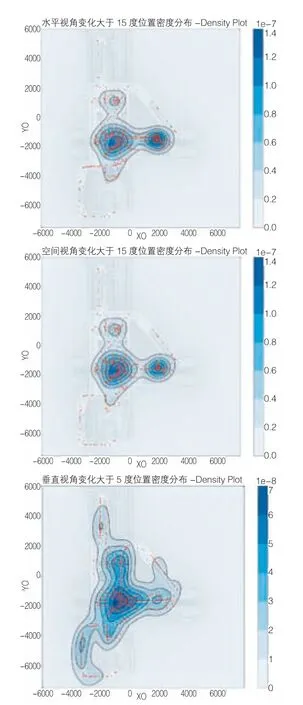

通过记录数据可以计算测试人员视角变化幅度较大的时间及空间位置。对于视角变化幅度,分别计算及标记了在一定时间间隔内水平方向角度,垂直方向,空间视角(两视线空间夹角)的变化,并将水平角度大于15 度,空间角度大于15 度及垂直方向角度变化大于5 度的位置点密度以半径的形式在空间位置中标记出来(图5)。由于部分数据违反方差分析要求(方差不齐),因此视线分析采用K-W 非参数检验。分析结果表明:不同路线间的视角变化差异没有统计学意义(水平角度:X2=6.35,df=5,p=0.27;垂直角度:X2=4.65,df=5,p=0.46;空间角度:X2=9.31,df=5,p<0.97),能够初步说明整个地铁站的寻路条件较好,整体环境信息较易理解,没有造成太大的视觉上的压力。在个人属性方面,不同性别在3 种视角变化上差异显著(水平角度:X2=6.40,df=1,p<0.05;垂直角度:X2=4.85,df=1,p<0.05;空间角度:X2=7.69,df=1,p<0.05),且均显示出男性转头次数要明显大于女性,但年龄方面没有发现显著差异。因此,可以认为性别因素在地铁站的寻路过程中对视线变化差异的影响较大。这一发现和其它相关研究者的研究结果相似[18],其主要原因是和男女性使用了不同的空间策略有关。

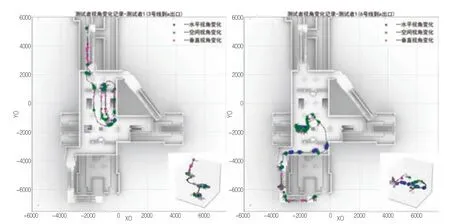

图5 测试者在环境中视角变化记录(图左为测试者1,图右为测试者2)

从视角变化位置统计中可以观察到测试者在行走及寻路过程中容易发生迟疑,速度减慢,停留及转动视角方向观察场景的具体位置区域。以测试者3 和测试者12 为例(图6),在同类型路径下,前者的视角变化明显要少于后者,说明不同类型测试者的空间探索模式有较大的差异。对采样点的总数,水平方向,空间方向转动次数大于15 度及垂直角度方向变化大于5 度的位置及次数进行了统计。结果表明,水平角度变化及空间位置变化的次数非常接近(ρ=0.95,P <0.01),相关系数(皮尔逊相关)略大于垂直角度变化动作的次数(r=0.79,P <0.01),表明行人主要依靠水平方向转动来辨别方向及观察场景。另外垂直角度变化角度的区域在自动扶梯及楼梯位置聚集明显(图7),这也是符合常规的行人行为特征的。

图6 测试者3(图左)和测试者12(图右)的视角变化空间分布图

图7 水平、空间、垂直视角变化的分布密度图示

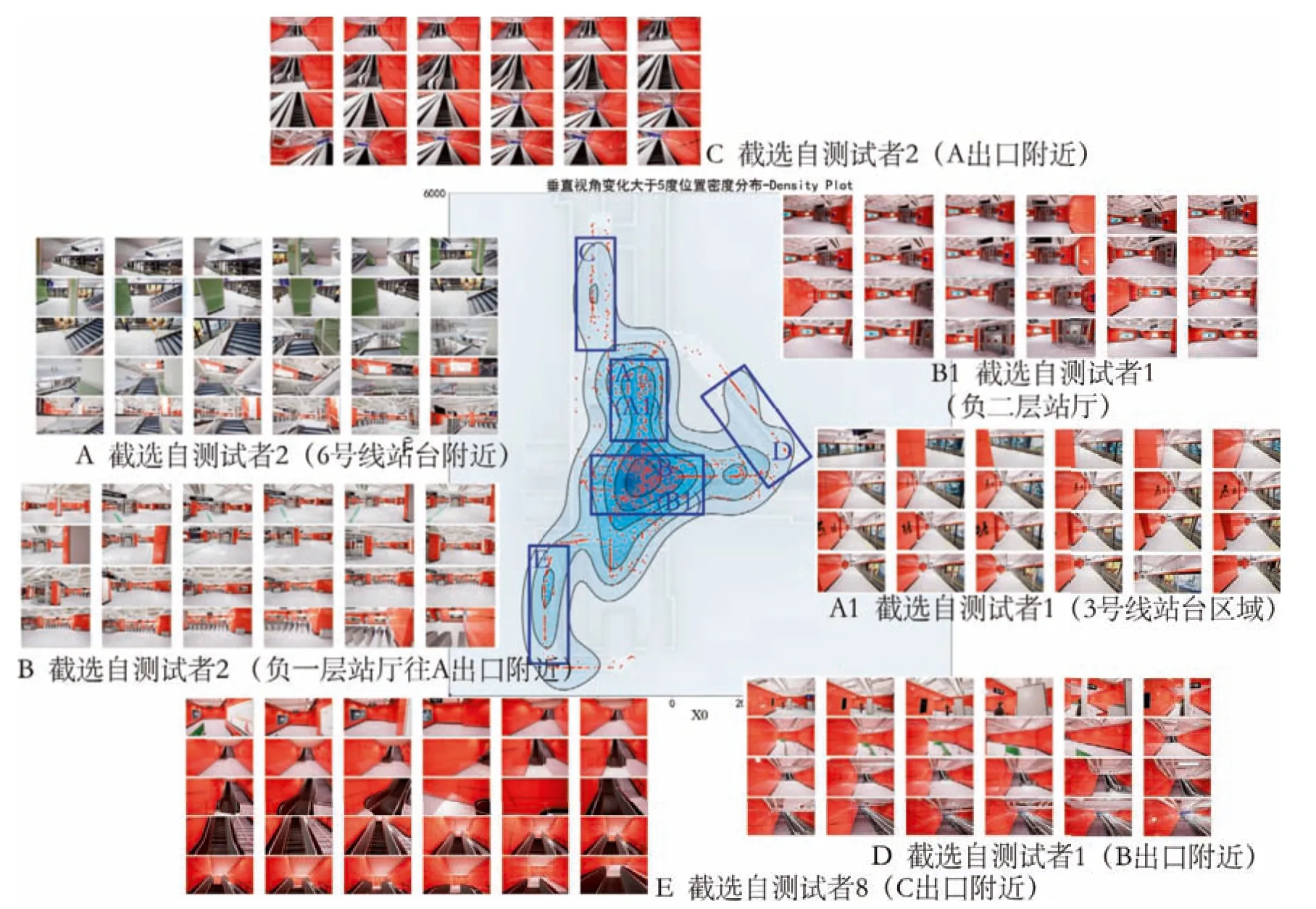

软件平台开发了测试过程回放的功能,可根据测试者的路径记录信息生成测试过程的序列帧图像,可以针对序列帧图像对测试者空间行为做进一步的分析。通过观察测试者行为过程眼睛关注的序列帧图像,可以看出测试者视线转动频率较高的区域相对于视线转动频率较低的区域,其空间特征在空间复杂度以及路线选择可能性等方面的特征更为为明显。图8 显示了根据不同测试者测试路线中所截取的代表性区域的分时图像,其中A(A1)为站台的区域,B(B1)为站厅的区域,C、D、E 分别为从站厅已接近出口楼梯及自动扶梯的区域,从序列帧可以明显的看到测试者行走过程寻找楼梯,出口等明显交通特征的行为,一旦明确了路线特征,其视线的转动频率明显减少,另外,在站台出发的位置需要寻找往上一层站厅的楼梯,其选择性较单一,难度比在站厅层选择路线任务要容易,视线转动统计频率明显低于站厅内(图8)。

图8 典型测试者测试过程的序列帧图像

4.3 其它类型数据分析

通过记录数据文件,还可以进行多方面的数据分析,包括:

(1)相同目标不同测试者所经过的路线分布情况。通过收集的整个路径可以看出,从3 号线站台到目标为A 出口的不同测试者的行为路径(3A)的差异,可以分析测试者在场景中哪个位置会选择趋于一致的路线以及哪个位置会开始路线分化。进一步的分析还可以结合场景的空间特征及场景中的各类要素设计(柱子、墙、家具、提示牌等)等因素分析测试者路线选择的影响因素;

(2)多人行走过程中,整个路径的长度,瓶颈速度,方差等相关统计;

(3)行为观察。针对每个测试者,可以通过时刻、坐标位置及方向等信息,对测试者在场景路线中的行为动作做进一步的分析,如速度变化,或在某个特殊位置出现加速、逗留等情况。还可进一步根据该位置、方向等信息得到该位置的视觉观察图像等,做进一步的视觉因素分析。

结论

(1)实验验证了基于VR 系统的行人仿真及交通数据采集平台的可行性。通过问卷调查,23 测试者,95%以上测试人员认为场景的仿真度和真实性较高,但部分标识字体只有在较接近目标的时候才比较清楚。1 人认为走路较真实情况快,5 人测试后感觉有些头晕,23 人均顺利完成了测试。

分析调查问卷,对其中的问题分析如下:

目前3D 展示使用的HTC Vive 两块显示屏幕采用的1K 分辨率图像对于场景的总体还原度及真实度可以满足要求,但对于细节层次及标识牌等在距离用户较远的情况下由于分辨率的影响还有待进一步的采取技术手段解决。下一步的研究可以对测试者的视力及观测目标的距离及观测结果进行相关的实验及标定。

(2)通过该平台,可以方便的设置不同的场景情景,人流情况等,进行不同类型的行人交通行为仿真,获得详细的任意时间间隔的行人数据,进而进行不同类型的分析。对于单个行人,也可以在测试的时间和空间范围内,对个体在某个节点迟疑,停止,观察等动过进行精细的记录、分析,从而进行个体行人交通行为的调查、分析。本文尝试构建了基于Omni 万向跑步机和HTC Vive 头盔等交互设备创建虚拟测试环境,让参与者以自然行走及全景观察的模式进行测试,并通过记录行人的活动、视觉轨迹等数据进行分析与定量研究,为公共建筑行人交通行为实验提供了新的平台及方法。

通过对测试者视角变化(水平、空间、垂直角度)的记录,可以反映出测试者在寻路过程中的部分行为规律。在寻路过程中,视线以水平方向的变化为主,在空间中,水平与空间变化较大的区域是一致的,主要发生在楼梯口及通道转折处,和水平方向视角变化的区域基本一致,只是在自动扶梯上下楼位置垂直视角变化有明显的增加,这与人在实际环境中的行为也是一致的。行人空间交通行为中,通过对行人视角变化记录数据的分析,可以对行人的交通行为进行一定的判断,并作为进一步环境行为研究的基础。

(3)本平台实现了对环境的物理因素(视觉环境、声环境等)以及大客流等情景以及特殊类事件(火灾、爆炸、烟气扩散等)进行模拟,以及结合第三方模拟软件数据集成方式的大客流模拟,实验总体上对平台及实验的可行性进行了相关的测试及验证,目前只针对给定目标的寻路行为进行了相关的模拟及行为采集,更复杂的场景设置环境下的实验行为测试实验还有待进一步的设计及研究。

图、表来源

文中图、表均由作者绘制。