学习情感分析方法研究综述

田元 周晓蕾 周幂 陈迪

摘 要:文章从学习情感数据库、单模态学习情感分析方法和多模态学习情感分析方法三个方面进行综述,以期讓广大研究者对学习情感分析有一个较为清晰全面的了解和认识,进一步推动学习情感分析研究的发展。研究结果表明:现有的情感数据库中的情感标签不完全符合学习过程中的情感状态,而专门针对学习情感分析的数据库资源相比之下较为匮乏;虽然多模态数据在情感识别中更可靠,但存在大规模数据的维数灾难、不同模态间的不同步、算法的实时性等亟待解决的问题;目前关于学习情感分析的系统及其理论研究相对比较匮乏。

关键词:学习情感数据库;单模态学习情感分析;多模态学习情感分析

中图分类号:TP391 文献标志码:A 文章编号:1673-8454(2021)22-0001-06

一、引言

随着互联网技术和移动计算技术的快速发展,以多媒体学习资源、网络技术平台以及网上学习社区所形成的在线学习、移动学习等,成为未来不可缺少的学习方式。这些方式相较于传统面对面的课堂教学,虽不再受时间、地点、空间的限制,却阻碍了师生直接的情感交流,教师无法实时感知学生的学习情感状态,及时给予反馈,同时在人机交互中难以自适应地对学习活动进行调整和优化。学习过程中情感的缺失会影响学习效果和教学质量,并且不利于学习者的心理健康以及健全人格的形成。学习情感的计算和识别是解决以上问题的关键,也是提供智能的学习支持服务,从而构建个性化、自动化、过程化的智慧学习环境的重要一环。

近年来,研究者结合情感理论、学习理论及情感计算研究,对情感、学习及技术三个领域的前沿内容进行了整合研究,其最新的论述中强调将情感、认知和动机应用到教育和学习环境中,建立对情感敏感的智能教学系统是以上领域融合的研究焦点。实现学习情感的精准描述将进一步优化数字化教育功能,加速学习方式的变革和发展。同时,研究者对网络远程教育、现代信息化课堂、移动学习等数字化学习环境下学习者所呈现的情感、兴趣及行为给予了越来越多的关注和研究。

学习情感分析领域涉及的方法手段多样,相关研究包括:面部表情识别、语音情感识别、文本情感分析、生理信号分析等。鉴于目前国内外对学习情感分析的综述性文献较少,本文在大量相关文献研究的基础上,对支撑学习情感研究的主要技术方法及具体算法进行了分类和讨论,对学习情感分析领域工作的进展与难题进行了总结,以期让广大研究者对该领域有一个较为清晰全面的了解和认识,进一步推动学习情感分析研究的进展。

二、学习情感数据库

著名的国际心理学家Ekman提出,人的基本情感可以分为喜悦、悲伤、害怕、愤怒、惊讶和厌恶这六种,以此为基础可混合衍生出丰富多样的情感类型,并根据脸部肌肉运动单元与不同表情的对应关系,创建了面部动作编码系统(Facial Action Coding System,FACS)来实现自动面部图像分析及人类表情的分类,以上六种情感类型的划分奠定了离散型情感表示模型的基础。

随着情感分类理论和情感状态表示模型以及情感计算方法的不断成熟,不同需求和规模的情感数据库相继被建成或完善。学习情感是在特定场所下发生,与一般情感存在一定差异且以面部表情体现为主。学习者在学习过程中较难产生愤怒、恐惧、悲伤等情感,除非观看补充学习的相关视频材料,而感兴趣、困惑等情感在学习过程中十分常见。因此部分学者针对学习的特殊性,建立了学习情感数据库。

北京师范大学建立的学习情感数据库(Beijing Normal University Learning Affect Database,BNU LAD)[1],其中包括了144位被试学习者的数据,实现了包括愉快、好奇、困惑、厌烦、专注、走神及疲惫这七种主要学习情感的多标签、多强度标注。

Ramón等[2]采集了25名实验对象的人脸图像和脑电信号数据,实验对象包括年龄在18—47岁区间的18名男性,7名女性,均为大学生。实验将学生分为AB两组。A组由18名学生组成,他们执行与Java语言编程相关的活动,目的是诱导学生表现出不同的以学习为中心的情绪,如兴趣、参与、兴奋和专注。B组由7名学生组成,观看不同主题的视频(如野生动物、自然、短片),引导学生表现无聊、放松等情感。

中国海洋大学创建的在线自发学习情感数据库(Online Learning Spontaneous Facial Expression Database,OL-SFED)[3],被采集对象为82名年龄在17到26岁的学生,通过观看不同类型的视频,触发被采集对象愉悦、困惑、疲劳、分心以及中性这五种有意义的学习情感并加以标记收集。

山东师范大学的孔玺自主建设的学习者人脸表情数据库[4],通过大量文献阅读,将学习表情分为常态、高兴、愤怒、悲伤、恐惧、专注、走神这七种,并以山东某高校数字媒体专业70人作为实验对象,让实验对象观看不同类型的数字学习画面,完成在智慧学习环境下基于面部表情的人为学习情感数据的构建。

学习情感是学习者在学习活动过程中所产生的与学业相关的特定情感的集合, 目前数据量较为充分的学习情感库较少,情感数据库的建设需要遵循真实性、交互性、连续性、丰富性四个原则。

三、单模态学习情感分析方法

在学习活动中,学习者的情感发生变化时很大程度上会通过外部行为(如面部表情、声音、肢体动作以及文本信息)和生理信号(如脑电波、皮肤电导)等表现出来,这些主观的反应更加能感知学习者真实的情感变化。根据情感表达形式的不同以及数据采集和处理方式的不同,本文将单模态的学习情感分析方法归纳为以下四种:基于面部表情识别的方法、基于语音情感识别的方法、基于文本情感识别的方法和基于生理信号分析的方法。

1.基于面部表情识别的学习情感分析方法

大量心理学文献和著作都表明,面部能够传达丰富的情感信息,是最有效的表情器官,并将面部表情作为情感计算领域中最重要也是最客观的指标之一。面部表情识别的一般步骤包括:面部检测与定位、图像预处理、表情特征提取和表情分类识别。本文根据面部表情图像状态的不同,将面部表情的识别研究分为:基于静态图像的面部表情识别方法和基于动态图像序列的面部表情识别方法。

基于静态图像的分析方法在面部表情识别研究中有着至关重要的作用。早期的研究都是针对静态图像进行特征提取和分类识别,其呈现的是单幅图像时刻的表情状态,能够简单直观、快速地提取特征且具有很好的识别率,目前关于静态图像基本表情的识别技术已经比较成熟并取得了广泛的应用。按照特征提取的方法进行分类,主要有主成分分析法[5]、局部二值模式法[6]、Gabor小波法[7]。

随着深度学习在图像分类领域的发展,其在面部表情识别领域也越加成熟,其中以卷积神经网络(Convolutional Neural Network,CNN)最具有代表性。高宇豆[8]在基本情感分析方法的基础上,采用微调深度CNN的方法进行基于图像的学习情感分析,并进一步分析基于视频的学习情感。除此之外,还使用中文简化版PAD(Pleasure-displeasure,Arousal-nonarousal,Dominance-submissiveness)情绪量表量化学习情感,建立学习情感与学习状态相关性模型,从而更好地借助学习情感分析学习者的学习状态。张璟[9]提出一种特征金字塔的多尺度特征融合的卷积神经网络人脸检测算法,以解决后排学生人脸微小难以检测的问题。邓豪[10]搭建了基于表情识别的学习兴趣检测系统,該系统能够实现图像获取、人脸检测、学习表情识别分类、学习情感识别结果等功能,并采用小尺寸卷积核连续卷积层的方式以及在每个卷积层后添加批规范化层,以提高表情识别准确率。

面部表情牵扯肌肉的运动,产生了一个动态变化过程,动态序列中连续变更的图像能够更好地反应表情变化的实质,其同时包含空间维度上和时间维度上的信息,具有很高的研究意义和广泛的实用价值。近年来,基于动态序列图像的动态面部表情识别成为新的研究热点,主要有光流法[11]、特征点跟踪法[12]、模型法[13]、差分法[14]和深度学习法,其中深度学习方法是近年来比较流行的方法。

针对动态图像序列的面部表情识别,需要提取单帧图像的空域特征以及各图像帧之间的时域特征。对于提取序列时域特征的代表性算法则是循环神经网络(Recurrent Neural Network,RNN)。Zhang等[15]从表情图像序列中选择具有代表性帧图像,融合利用CNN提取代表帧的空域特征,以及RNN提取所有表情序列帧的面部特征点的时域特征进行面部表情识别。长短期记忆网络(Long Short-Term Memory,LSTM)因其具有保证在计算成本较低的前提下处理可变长的序列数据,而被研究者广泛使用。Donahue等[16]人提出了一个深度时空模型,该模型将CNN的输出作为LSTM的输入,LSTM的输出作为最终网络的输出,从而完成一系列涉及时变输入和输出的视觉任务。

2.基于语音识别的学习情感分析方法

语音是语言的一种声学表现形式,作为人类交流、传递信息的基础媒介,其声学特征包含了大量的说话人情感信息。在学习情感分析领域,学生说话时间少,因此语音情感识别通常作为一种辅助手段。

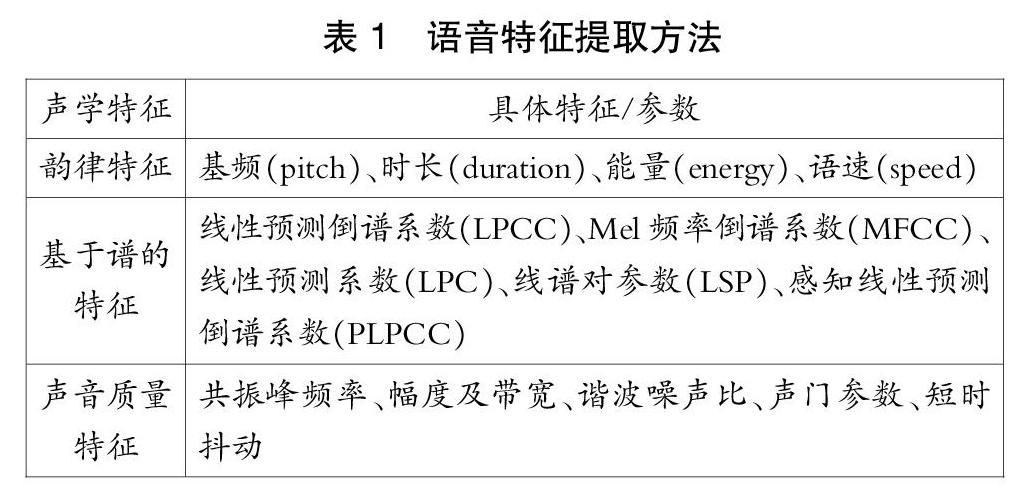

语音情感识别的一般步骤包括:信号预处理、情感特征提取、特征降维和情感分类。其中,信号预处理将采集的原始语音片段通过预加重、分帧加窗、降噪等操作转化为计算机可识别的语音数据;情感特征提取就是从语音数据中提取出呈现情感状态和变化的声学特征;然后对提取的特征降维,选择出适用的特征,消除无关或冗余信息,减轻对分类器性能的要求;最后根据特征的表示设计分类器,给不同情感类型赋予类别标记。情感特征提取是语音情感识别最为关键的一步,声学特征的类型参数丰富多样,如表1所示,大致可以分为韵律特征、基于谱的特征和声音质量特征三类作为分类器的输入层。

声音质量特征:声音质量描述的是声门激励的性质,其声学表现为“叹息声”“嘶哑声”“颤抖哽咽”等。声门脉冲的形状决定了说话人的声音质量,人的情绪会影响音质,通过对音质的评估,可以分析出说话人的相关的情感特征。体现声音质量的特征主要有共振峰频率、幅度及带宽、谐波噪声比、声门参数、短时抖动等。Gharsellaoui等[17]选取音质和韵律参数与MFCC进行优化组合,基于此提出了一种新的声学特征框架,情感识别准确率高达94%。

与传统特征相比,深度学习特征具有更多内在信息,基于深度学习的语音情感识别具有更强泛化能力。Rajak等[18]讨论了情感的不同维度,通过将特定的情感放在各自的象限,即二维的效价轴和唤醒轴中,使用两种不同的CNN架构来进行象限的预测。该方法在RAVDESS语音情感数据库上的准确率达到76.2%,而使用普通的离散模型,其准确率仅在50%~55%。Mekruksavanich等[19]使用四个开放的语音情感数据库识别一种深度学习分类器,研究了人类语音数据中涉及负面情感分析的复杂任务,利用泰国语语音数据库对性能最好的分类器进行了测试。实验表明,一维卷积神经网络在泰语负面情感识别分析任务中表现最为突出,准确率达到96.60%。

3.基于文本信息分析的学习情感分析方法

自然语言是人类表达信息的主要途径之一,随着在线学习平台的日渐兴起,以自然语言表述的文本信息存在于教学活动的各个环节之中。目前,文本情感分析方法大致分为基于情感词典与规则的方法、基于机器学习的方法以及基于深度学习的方法。

基于情感词典的方法首先利用情感词典获取文本中情感词的情感值,再通过加权计算确定文本的情感倾向。该方法不考虑词语间的联系,因此也不会受到上下文的影响并且能够在没有训练数据的情况下进行情感分析[20]。情感词典是情感分析的基础知识库,为了提高分类准确率,需要根据特定领域建立相应的情感词典。

与情感词典的方法相比,机器学习方法相对来说更简单,在特定场景下对情感分析更为精准、扩展性与可重复性更好,但机器学习的分类精确度依赖于高质量的标注训练集,而训练数据通过人为主观标注,会在一定程度上影响分类效果。

Moreno-Marcos等[21]针对MOOC平台中某一课程论坛评论,对比了情感词典方法和机器学习方法的学习情感分析效果。本研究中选取了两种基础词典,分别是WordNet和SentiWordNet,均与表情符号和否定词结合使用。两种情感词典方法尽管都是通过循环迭代文本信息中单词的正负性计算与消息的极性相关的变量,且SentiWordNet算法更为复杂、适用范围更广,但在学习情感分析上效果更差。接着,Moreno-Marcos分析了逻辑回归、SVM、决策树、随机森林和朴素贝叶斯等五种机器学习方法,并与情感词典方法对比发现,随机森林和WordNet算法最为推荐。李慧[22]所构建的情感词典以“中文情感词汇本体库”为基础,由“HowNet词典”“清华大学李军中文褒贬义词典”和“BosonNLP词典”融合而成,然后从情感词特征和句子构成特征等多个维度进行特征选择,并使用SVM算法对学习情感进行分类。

深度学习方法有着比情感词典和机器学习更强的表达能力和模型泛化能力,但除了存在依赖大量数据的问题外,梯度消失与爆炸、参数的设置以及模型复杂度等问题同样亟需解决。

Li等[23]对BERT模型进行了改进,由于浅层的BERT可以提取更一般的信息,因此尝试将浅层BERT词向量与卷积神经网络相结合,并在卷积操作后、池化操作前引入自注意力模块,以此作为MOOC平台的评论分类器。实验发现:浅层BERT-CNN模型能够在降低模型规模和减少性能损耗的基础上,达到与基础BERT 模型相同的分类效果。

4.基于生理信号的学习情感分析方法

人的情感主要受神经系统控制,在以上三种情感分析方法中,被测试者可以通过个人主观的意识支配大脑去掩饰或隐藏真实的情感,导致计算出的情感信息不够准确,而生理信号是由自主神经和内分泌系统所控制的,不受个体主观控制,能够较为客观地反映被试者的情感,获得的情感信息真实性更高且细微的情感变化也能表现出来。

用于情感识别的生理信号多样,主要有脑电信号(EEG)、心电信号(ECG)、皮电信号(SC)、容量搏动(BVP)、肌电信号(EMG)、皮肤温度(SKT)、光电脉搏(PPG)、呼吸信号(RSP)、血压、心率等,常用的特征包含时域、频域、时频域和能量域。

Wang等[24]使用HeartMath研发的一款情绪状态压力检测仪emWave系统评估各类多媒体课程对情绪学习和表现的影响,此系统主要用于检测人类的神经状态,它能够感应HRV(心率变异性)和情绪识别算法分析神经状态下的情绪状态,通过测量和记录人类情绪变化,得出不同类型的多媒体材料对学生的学习表现和学习情绪有显著影响,但学习情绪与学习绩效之间的相关性较低的结论。Kuo等[25]使用皮电反应(Galvanic skin response,GSR)和四象限螺旋学习模型对学习者在学习英语过程中产生的情感进行识别,并设计一款学习系统,该系统能够根据学习者的情绪调整学习水平并给予适当的帮助,使学习者有更好的学习表现。张乐凯[26]通过研究生理信号与用户情感之间的内在联系,采集皮肤电、皮肤温度、脉搏、呼吸、瞳孔直径等生理信号进行特征提取、选择、降维,通过多种机器学习算法对建立的最优特征集进行识别,并成功应用到产品设计和用户体验中。

四、多模态学习情感分析方法

情感的产生或变化,往往同时伴随着多个模态的反应,如高兴时会面露笑容、音调高、语速快,还可能手舞足蹈、心率起伏较大。基于单模态的情感识别信息量不够充分,且一旦受到外界的影响,如通过面部表情进行情感识别时受到大面积的遮挡,其影响将可能是彻底的。而不同模态之间的情感信息相互支持补充,能够有效提高情感识别率和鲁棒性,进一步扩展应用环境。D'mello等[27]对90个多模态情感识别系统进行了定量评估和元分析,其分析结果显示,多模态情感识别系统比对应的单模态情感识别系统更为准确,平均改进率达9.83%,这更加肯定了多模态信息融合的有效性及其对于情感识别的重要现实意义。当前研究热点也正在从单模态转向多模态。

前文提到的常用的单模态特征提取方法都可以作为多模态情感识别过程中提取特征的参考,而对于多模态情感识别,其关键在于多种信息的融合。当前常见的融合方法可大致分为特征层融合、决策层融合和模型层融合三类。

D'mello的元数据分析中对这三类融合方法进行了分类统计,指出目前特征层融合和决策层融合的方法应用更多。Yang等[28]通过摄像头/视频设备采集身体运动的数据信息,通过录音设备采集声音信息,通过文本跟踪采集文字信息,通过眼动仪采集眼动信息,通过可穿戴设备采集生理信号信息,对在线协同学习中情感交互进行分析,提出了一种结合逻辑功能的多模态情感计算模型,并验证了原型系统的可行性和有效性。

薛耀锋等[29]在已有情感交互研究的基础上,提出了在线学习的多模态情感计算模型,该模型包括:在线学习者数据采集模块、情感识别模块、情感数据可视化模块和辅助学习反馈/干预模块。情感识别模块中采用了多模态的情感分析方法,基于文本、语音及人脸表情情感识别结果,分析学习者学习情感。该模型能够准确有效地识别学习者情感,为学习者提供个性化学习服务。郑茜元[30]针对传统方法无法检测到学习者正视屏幕且视线落点也在屏幕上时出现分心状态的问题,提出了一种基于眼动分析的注意力检测方法,结合面部表情识别,提高学习者学习状态检测准确率。吴慧婷[31]利用人脸关键点定位、表情识别、人眼状态识別和脸部姿态估计等算法,对采集的学生表情、眼睛睁闭合状态、脸部朝向屏幕偏角进行处理,并加入课后答题数据综合分析,进行学生在线学习投入度研究,帮助教师更有针对性地进行网络教学。目前,多模态学习情感分析方法文献与单模态相比较为匮乏,以面部表情识别与语音情感分析的结合运用最为常见。

五、存在的问题与展望

本文介绍了近年来国内外学者在学习情感分析领域取得的研究成果及支撑情感识别的几类技术手段,并具体分析了这些技术的研究进展。尽管学习情感分析已得到一定程度的发展与应用,但从研究现状来看,还存在如下一些问题:

1.学习情感数据库较匮乏

学习情感数据库与一般的情感数据库相比相对匮乏,虽然一般情感数据库支撑着情感识别技术的研究,但与学习情感的研究不完全匹配,其中包含的情感标签不完全符合学习过程中的情感状态,如学习者常出现的困惑、感兴趣等。学习情感数据库的相对稀缺,导致学习情感识别的进度受到一定影响,因此建立高质量的学习情感数据库刻不容缓。

在建设学习情感数据库时,需充分明确情感的类型及其特征描述、恰当定义情感标签,从而跟一般的情感库进行区分。此外,模态的选取、数据采集场景的搭建、情感信息的采集及处理方式、情感诱导素材的设计以及被试对象的选择,都是构建符合学习者情感特点的数据库的关键,也是学习情感识别系统的重要保证。

2.学习情感分析方法需改进

单模态学习情感识别存在信息不够全面、容易受噪声、遮挡、异常信息干扰等问题,这导致了单模态的情感识别系统对于实际应用的环境及场景要求很苛刻,难以保证情感识别的稳定性。多模态学习情感识别利用多个信息源相互印证补充,有效保证了系统的鲁棒性和精确性,但多模态情感识别也面临着许多其它的挑战,如多个模态信息融合使得不同特征之间的相关性变得复杂,大规模数据可能引起维数灾难,以及不同模态之间时间不同步,融合算法的实时性受损等都是多模态情感识别亟待解决的问题。此外,不论是单模态识别还是多模态识别,在应用到学习活动中时,都需要结合实际的学习方式和场景,选择适合的数据源和识别方法,以准确、高效、稳定地捕捉学习者的情感状态和变化。

3.学习情感分析相关研究亟待完善

目前关于学习情感分析的系统及其理论研究相对比较匮乏,主要集中于以面部表情识别为主的单模态学习情感研究。在数字化教育迅速发展的时代,对于学习情感自动检测和分析的研究是非常有意义的,设计符合学生心理和认知的情感教学策略模型,通过学习情感的检测识别,对学习者的学习情况进行分析,进一步给予学习反馈和干预,实现个性化、智能化、全方位的学习服务是未来教育的新趋势。

参考文献:

[1]刘永娜,孙波,陈玖冰,等. BNU学习情感数据库的设计与实现[J].现代教育技术,2015,25(10):99-105.

[2]Ramón Z C,Lucia B E M,Daniel L H,et al.Creation of a Facial Expression Corpus from EEG Signals for Learning Centered Emotions[C]∥2017 IEEE 17th International Conference on Advanced Learning Technologies (ICALT).Los Angeles:IEEE Computer Society,2017:387-390.

[3]Bian C L,Zhang Y,Yang F,et al.A Spontaneous Facial Expression Database for Academic Emotion Inference in Online Learning[J].IET Computer Vision,2018,13(3):329-337.

[4]孔玺.智慧学习环境下数字学习画面的情感研究[D].济南:山东师范大学,2020.

[5]Jia J,Xu Y,Zhang S,et al.The facial expression recognition method of random forest based on improved PCA extracting feature[C]∥2016 IEEE International Conference on Signal Processing, Communications and Computing(ICSPCC).Los Angeles: IEEE Computer Society,2016:12-16.

[6]周宇旋,吴秦,梁久祯,等.判别性完全局部二值模式人脸表情识别[J].计算机工程与应用,2017,53(4): 163-169+194.

[7]Xu X,Quan C,Ren F.Facial expression recognition based on Gabor Wavelet transform and Histogram of Oriented Gradients[C]∥2015 IEEE International Conference on Mechatronics and Automation(ICMA).Los Angeles: IEEE Computer Society,2015:2117-2122.

[8]高宇豆.自然場景下的学习者表情识别与情感分析[D].北京:华北电力大学,2019.

[9]张璟.基于表情识别的课堂专注度分析的研究[D].太原:山西大学,2020.

[10]邓豪.基于人脸表情的学习兴趣评测方法研究[D].北京:北方工业大学,2019.

[11]Liu M,Shan S,Wang R,et al.Learning expressionlets on spatio-temporal manifold for dynamic facial expression recognition[C]∥Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Los Angeles: IEEE Computer Society,2014:1749-1756.

[12]Yao S,He N,Zhang H,et al.Micro-expression recognition by feature points tracking[C]∥Proceedings of the 10th International Conference on Communications.Los Angeles: IEEE Computer Society,2014:1-4.

[13]许良凤,王家勇,崔婧楠,等.基于动态时间规整和主动外观模型的动态表情识别[J].电子与信息学报, 2018,40(2):338-345.

[14]黄秀,符冉迪,金炜,等.基于图像差分与卷积深度置信网络的表情识别[J].光电子·激光,2018,29(11):1228-1236.

[15]Zhang K,Huang Y,Du Y,et al.Facial Expression Recognition Based on Deep Evolutional Spatial -Temporal Networks[J].IEEE Transactions on Image Processing,2017,26(9):4193-4203.

[16]Donahue J,Hendricks L A,Guadarrama S,et al.Long-Term Recurrent Convolutional Networks for Visual Recognition and Description[J].IEEE transactions on pattern analysis and machine intelligence,2017,39(4):677-691.

[17]Gharsellaoui S,Selouani S A,Dahmane A O.Automatic emotion recognition using auditory and prosodic indicative features[C]∥Proceedings of the 28th Canadian conference on electrical and computer engineering.Los Angeles: IEEE Computer Society,2015:1265-1270.

[18]Rajak R,Mall R.Emotion recognition from audio, dimensional and discrete categorization using CNNs[C]∥TENCON 2019-2019 IEEE Region 10 Conference (TENCON).Los Angeles: IEEE Computer Society, 2019:301-305.

[19]Mekruksavanich S,Jitpattanakul A,Hnoohom N.Negative Emotion Recognition using Deep Learning for Thai Language[C]∥2020 Joint International Conference on Digital Arts, Media and Technology with ECTI Northern Section Conference on Electrical, Electronics, Computer and Telecommunications Engineering(ECTI DAMT & NCON).Los Angeles: IEEE Computer Society,2020:71-74.

[20]鐘佳娃,刘巍,王思丽,等.文本情感分析方法及应用综述[J].数据分析与知识发现,2021,5(6): 1-13.

[21]Moreno-Marcos P M,Alario-Hoyos C,Munoz-Merino P J,et al.Sentiment analysis in MOOCs: A case study[C]∥2018 IEEE Global Engineering Education Conference (EDUCON).Los Angeles:IEEE Computer Society,2018:1489-1496.

[22]李慧.面向学习体验文本的学习者情感分析模型研究[J].远程教育杂志,2021,39(1):94-103.

[23]Li X,Zhang H,Ouyang Y,et al.A Shallow BERT-CNN Model for Sentiment Analysis on MOOCs Comments[C]∥2019 IEEE International Conference on Engineering,Technology and Education(TALE).Los Angeles: IEEE Computer Society,2019:1-6.

[24]Wang H P, Chen C M.Assessing the effects of various multimedia curriculums to learning emotion and performance based on emotion recognition technology[C]∥2010 International Symposium on Computer, Communication, Control and Automation (3CA). Los Angeles: IEEE Computer Society,2010:365-368.

[25]Kuo Y C,Tseng C C.Recognizing the emotion of learners by physiological sensors to improve english learning performance[C]∥2011 4th International Conference on Biomedical Engineering and Informatics(BMEI). Los Angeles: IEEE Computer Society,2011:2152-2156.

[26]张乐凯.基于生理信号数据的产品设计与用户体验研究[D].杭州:浙江大学,2018.

[27]D'mello S K,Kory J.A review and meta-analysis of multimodal affect detection systems[J].ACM Computing Surveys, 2015,47(3):1-36.

[28]Yang J,Xue Y,Zeng Z,et al.Research on multimodal affective computing oriented to online collaborative learning[C]∥2019 IEEE 19th International Conference on Advanced Learning Technologies(ICALT).Los Angeles: IEEE Computer Society,2011:137-139.

[29]薛耀锋,杨金朋,郭威,等.面向在线学习的多模态情感计算研究[J].中国电化教育,2018(2):46-50+83.

[30]郑茜元.基于面部特征的学习状态研究[D].长春:长春工业大学,2020.

[31]吴慧婷.基于多维度信息融合的学生在线学习投入度研究[D].武汉:华中师范大学,2020.

(编辑:李晓萍)