虚拟传感器与视觉传感器联合标定技术研究

贾鹏飞,张蕾,刘全周,李占旗

虚拟传感器与视觉传感器联合标定技术研究

贾鹏飞,张蕾,刘全周,李占旗

(中汽研(天津)汽车工程研究院有限公司,天津 300300)

为了在虚拟场景下实现对ADAS控制器的测试,文章对相机的测距模型进行了研究,在虚拟场景下完成了相机的标定,对相机捕获的图像进行了畸变校正,设计了4层BP神经网络对虚拟传感器与相机进行联合标定,得到了虚拟传感器与视觉传感器的转换关系,并设计了实验进行验证,通过测试最终的数据误差为0.37%。

ADAS;BP神经网络;联合标定

前言

在汽车驾驶辅助系统(ADAS)测试中,虚拟场景测试平台可方便灵活地对辅助驾驶系统的控制策略进行测试,具有节约劳动成本,提升测试效率的优点。虚拟场景平台传感器的标定作为测试工作中的重要组成部分,其标定的精度直接影响最终的测试精度,因此标定技术已经成为各个高校和企业研究的热点[1-3]。

目前,ADAS主要通过实际场景和虚拟场景两种方式进行测试,在实际场景中的测试由于驾驶环境复杂,很多情况并不能完全模拟,因此存在很多局限性。而虚拟场景测试是通过在虚拟场景中模拟各种对象、路况、环境以及行为等,不仅能够缩短测试时间,还能对ADAS系统做出全面考核,使考核指标不仅仅局限在里程数。为了提升传感器的标定精度,实现ADAS的精确预警,国内外学者做了大量工作。

牛萍娟等人通过神经网络的非线性映射能力直接建立了毫米波雷达坐标系和视觉图像坐标系之间的映射关系,减少了传感器标定的时间。韩正勇等对相机内外参数的求解问题做了研究,利用采集的几帧图像得到标定的转换矩阵,并求解出矩阵参数。俞德崎等用ArUco标签确定标定板与相机坐标系间的关系,通过随机采样一致性算法提取纸板角点以建立对应关系,采用Kabsh 算法求解最有配准参数。Jaroslav Moravec提出基于多项式划分的摄像机标定修正模型,提升了模型的计算速度。

针对提升虚拟场景平台下ADAS测试精度,本文提出虚拟场景平台传感器与视觉传感器联合标定的方法,通过使用BP神经网络的非线性拟合出两者之间的转换关系,并实现虚拟场景传感器与视觉传感器之间的联合标定。

1 相机测距模型

视觉传感器标定主要涉及三个坐标系之间的相互转换:图像坐标系、摄像机坐标系和世界坐标系。图像坐标系一般值相机捕捉到图像画面后,目标在图像中的坐标位置点,图像为*行矩阵的数据,每个矩阵点代表图像坐标,如图1所示。

图1 图像坐标系

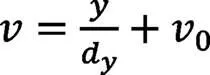

图1中,(、)为图像的像素坐标,在进行坐标转换时,会将图像坐标转换为相机坐标,即以相机的中心为原点,得到图像坐标与相机中心原点的位置关系,两者的转换关系为:

齐次坐标和矩阵形式:

由相机坐标系到世界坐标的转换示意图如图2所示,Oc为世界坐标原点,OZ为相机的光束中心,P(x,y)图像的坐标点,通过小孔成像的原理计算得到点Oc与Xc、Yc、Zc的距离关系。

从世界坐标系到相机坐标系的变换:可以由一个旋转矩阵和一个平移向量来描述:

化为齐次坐标:

相机坐标系到图像物理坐标系:

其中是焦距。化成齐次坐标为:

通过图像坐标系、摄像机坐标系和世界坐标系之间的相互关系可以得到从世界坐标系到图像坐标系的转换:

其中1、2分别为相机的内外参数矩阵。视觉传感器通过标定之后,可得到相机的内外参数,从而确定图像坐标到空间距离的转换关系,实现物体的测距。

2 虚拟场景中的联合标定

2.1 BP神经网络算法

BP神经网络在进行学习时,是以输入数据和期望数据对内部权值进行计算得到合适的神经节点阈值与权重。输入数据经过BP神经网络内外神经元节点的非线性计算得到输出值,会同期望输出进行比较,计算两者的偏差,由偏差量反过来更新BP网络内部的神经元节点的权重与阈值,使误差沿梯度方向下降,经过不断学习,确定合适的神经元节点参数,并保证误差最小。训练完成后,输入与输出之间会确定非线性的关系式,当有新的数据变量输入时,会根据此关系式计算出输出变量,图3为典型多层神经网络示意图[4-6]。

图3 神经网络结构示意图

令输入向量为:

输出向量为:

第l隐含层各神经元的输出为:

其中,为第层神经元的个数。

设()为从1层第个神经元与层第个神经元之间的权重值,()为第l层第个神经元的偏置:

()= f (()) (10)

t为节点的期望输出值;0为节点计算输出值。

在训练学习过程中,网络层节点之间的权重矩阵w的设定和误差会进行不断的修正,修正的模型为:

为学习因子;φ为输出节点的计算误差;0为输出节点的计算输出;为动量因子。

2.2 联合标定算法设计

本文中训练数据是通过虚拟场景下测量的前车距离与视觉传感器测量的目标在图像中的坐标进行联合标定。虚拟场景下的数据可以通过设置前方目标与主车之间的距离获得,视觉传感器数据则是通过消除畸变后的视觉传感器检测虚拟场景中目标所在图像中的坐标获取,算法流程如图4所示。

图4 联合标定流程图

虚拟场景平台传感器与视觉传感器联合标定就是通过BP神经网络的非线性功能拟合出虚拟场景平台传感器与视觉传感器之间的关系,在预测阶段即可通过计算得到的非线性关系预测出相应的目标位置。实验中使用300组输入输出数据,从中随机选择200组作为训练集数据用于训练,100组作为测试集数据用于测试网络的拟合性能。

3 试验与验证

3.1 数据获取

在实验数据获取中主要为虚拟场景平台传感器数据的获取和视觉传感器数据获取。虚拟平台传感器数据获取是通过despace软件中虚拟传感器获取前方目标的坐标,前方目标距离不同时所在的坐标位置也不同,因此在本实验中以此数据作为输入参数,即有两个输入参数。视觉传感器获取数据是在暗箱中安装摄像头,通过摄像头所拍摄的图像中目标的坐标作为BP神经网络的输出参数,数据采集如图5所示,图6所示:

图5 虚拟传感器目标信息获取

图6 摄像头目标数据获取

3.2 联合标定

实验中视觉传感器的标定是通过摄像头拍摄暗箱中虚拟场景下的标定板图像,经过计算摄像头内外参数消除畸变[7-10]。如图所示,摄像头拍摄的虚拟场景下标定板图像,通过计算所得到的摄像头内外参数矫正图像畸变后得到的虚拟场景下标定板图像如图7所示。

图7 虚拟场景中图像校正

通过测试集95组数据测试,其结果如图8所示,图中红色代表预测输出,蓝色代表期望输出(真实输出),经过对比发现,除个别数据存在较小误差外,其他预测数据基本接近期望输出。预测误差百分比如图9所示。

图8 BP神经网络数据预测曲线

图9 数据误差图

通过虚拟场景平台传感器与视觉传感器联合标定技术能够准确地获取虚拟场景下目标的坐标位置,且平均误差小于0.37%。

4 结论

本文对ADAS摄像头的测距模型进行了推到,得到了图像坐标到空间坐标的转换关系,利用虚拟场景的标定板图片实现了摄像头图像的畸变校正,借助于BP神经网络算法实现了虚拟传感器和摄像头数据的联合标定,通过实验室验证平均的标定误差为小于0.37%,可实现辅助驾驶系统在虚拟场景下的测试。

[1] 刘庆华,邱修林,谢礼猛,等.基于行驶车速的车辆防撞时间预警算法[J].农业工程学报,2017,33(12):99-106.

[2] 方建超,周兴林,毛雪松.利用多普勒激光雷达实现距离和速度同步测量[J].光电工程,2016,43(12):212-218.

[3] 王忠立.基于立体视觉的空间球体快速定位方法[J].北京理工大学学报,2006(11):974-977.

[4] 余厚云,张为公.基于单目视觉传感器的车距测量与误差分析[J].传感器与微系统,2012,31(9):10-13.

[5] 许宇能,朱西产,马志雄,等.基于单目摄像头的车辆前方道路三维重建[J].汽车技术,2014(2):48-52.

[6] Tuohy S, O’Cualain D, Jones E, et al. Distance determination for an automobile environment using inverse perspective mapping in OpenCV[C].Signals and Systems Conference. IET,2010:100-105.

[7] Nakamura K,Ishigaki K, Ogata T, et al. Real-time monocular ranging by Bayesian triangulation[C].Intelligent Vehicles Symposium. IEEE, 2013:1368-1373.

[8] Han J,Heo O,Park M,et al.Vehicle distance estimation using a mono- camera for FCW/AEB systems[J].International Journal of Automo- tive Technology, 2016,17(3):483-491.

[9] Bao D,Wang P.Vehicle distance detection based on monocular vision [C].International Conference on Progress in Informatics and Com- puting. IEEE,2017:187-191.

[10] 王永杰,裴明涛,贾云得.多信息融合的快速车牌定位[J].中国图像图形学报,2014,19(03):471-475.

Research on Joint Calibration Technology of Virtual Sensor and Visual Sensor

JIA Pengfei, ZHANG Lei, LIU Quanzhou, LI Zhanqi

(CATARC (Tianjin) Automotive Engineering Research Institute Co., Ltd., Tianjin 300300)

In order to test the ADAS controller in the virtual scene, the ranging model of the camera was studied in this paper. The camera calibration was completed in the virtual scene and the distortion of the image captured by the camera was corrected. A 4-layer BP neural network was designed to calibrate the virtual sensor and the camera. The conversion relationship between the virtual sensor and the visual sensor was obtained.The experiment is designed, and the data error is 0.37%.

ADAS;BP neural network; Joint calibration

10.16638/j.cnki.1671-7988.2021.021.009

U495

B

1671-7988(2021)21-36-04

U495

B

1671-7988(2021)21-36-04

贾鹏飞,硕士、工程师,就职于中汽研(天津)汽车工程研究院有限公司,研究方向汽车辅助驾驶系统。

天津市科技计划项目(编号:17YDLJGX00020)。