基于拟合决策边界表达式的对抗攻击方法

◆赵永泉

基于拟合决策边界表达式的对抗攻击方法

◆赵永泉

(云南电网有限责任公司西双版纳供电局 云南 666100)

基于深度学习的图像分类器已经被广泛使用,由于模型鲁棒性问题导致其不能正确分类,进而增加微小扰动的样本,称之为对抗攻击。现有黑盒攻击算法难以在较低的访问次数下获得准确决策边界信息,本文提出基于拟合决策边界表达式的对抗攻击方法。该方法定义根据目标函数以及决策边界的定义,推导出决策边界表达式,并利用投影操作寻找决策边界附近的对抗样本。试验结果标明,该方法相比现有的黑盒攻击方法具有更高的攻击成功率。

对抗攻击;计算机视觉;深度学习

对抗攻击指的是在原始样本中加入扰动,以获得一个可以欺骗目标深度学习分类器的样本。文献[1]首次发现深度学习模型易受攻击的特点,进而提出框约束L-BFGS算法进行迭代对抗攻击。L-BFGS算法针对特定的原始图像随机添加扰动生成对抗样本。文献[2]提出的生成方法基于隐空间聚类。文献[3]提出了一种基于快速边界攻击的有目标攻击样本生成方法,将搜索拆分为面上和线上两部分,并通过二分法减少搜索规模。文献[4]提出了基于AE-WGAN的定向对抗样本生成方法,通过高质量映射转换和隐层编码迁移算法生成指定标签的对抗样本。文献[5]提出的ZOO方法通过目标模型的输出来拟合模型梯度,其在攻击成功率和扰动大小两个指标上都很优秀。本文通过转换模型拟合目标函数构建决策边界近似表达式,根据决策边界近似的表达式,利用投影操作进行对抗样本生成,提升攻击成功率。

1 对抗样本定义

在对抗攻击的过程中,根据攻击目标的不同,可以分为有目标攻击和无目标攻击,其形式化定义如公式(1)所示:

其中,C代表可以对样本进行分类的深度学习模型(目标模型),是模型参数。y为目标模型对x的分类结果,是原始样本的正确类别。在有目标攻击中,目标模型将x分类到攻击者指定的类别。在无目标攻击中,目标模型将对抗样本分类到样本正确类别外的其他类别(不指定误分类的类别)。

2 基于决策边界的图像对抗攻击算法

Croce等人[6]尝试寻找目标模型的决策边界,通过使用目标模型的梯度信息、模型的结构与模型的参数,精确地将样本投影在目标模型决策边界附近,从而获得性能良好的对抗样本。

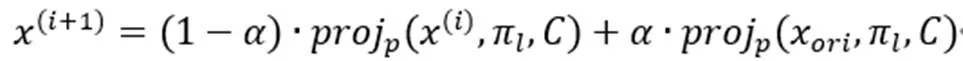

在获得决策边界近似的表达式后,Croce等人根据决策边界的平面表达式,计算样本到决策边界的距离,如式(3)所示:

3 基于拟合决策边界表达式的对抗攻击方法

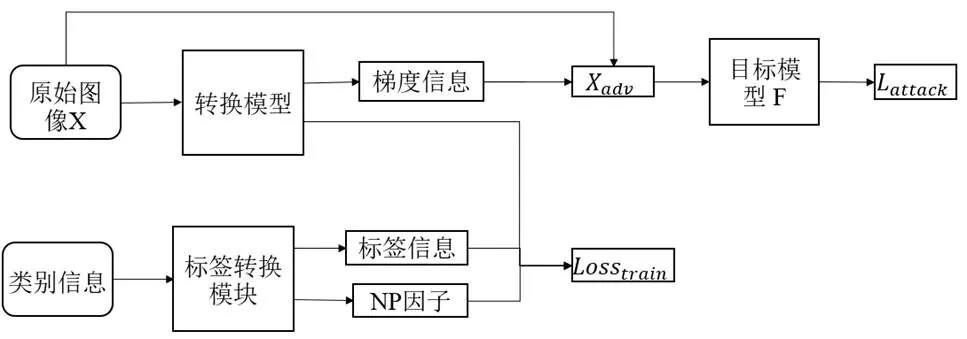

受到Croce等人[6]在白盒攻击中利用模型的决策边界信息进行对抗攻击(FAB算法)的启发,本文提出一种在黑盒场景下,基于拟合决策边界的对抗攻击方法,结构如图1所示。

图1 算法框架

在黑盒场景中进行对抗攻击,攻击者不能获得目标模型的结构以及参数信息,即模型的内部信息,本文通过定义含有决策边界的目标函数,并利用转换模型拟合目标函数,求解决策边界表达式,在黑盒场景中利用决策边界信息进行对抗攻击。此方法与已有的基于替代模型的攻击方法相似,但基于替代模型的攻击方法在拟合替代模型时,考虑训练样本与所有类别之间的关联,根据目标模型关于所有类别预测概率对替代模型进行拟合,目的是使替代模型学习到目标模型对样本每个类别的预测概率,并拟合目标模型中所有类别之间的决策边界,使替代模型分类的性能接近目标模型,之后通过对替代模型进行白盒攻击获得对抗样本,最终利用得到的对抗样本对目标模型进行攻击。与替代模型相比,本文提出的基于拟合决策边界的攻击方法,方法框架如图2所示,首先根据对抗攻击的目的,构建相应的模型。在模型拟合的过程中,本方法只针对与攻击相关的两个类别的信息进行拟合,在迭代过程中忽略与攻击目标无关的类别,相比于替代模型方法,能够更有针对性的拟合在攻击过程中所需的目标模型的内部信息。在进行对抗攻击时,本方法利用拟合模型的信息生成对抗样本进行攻击,并且在对抗样本生成过程的同时,利用目标模型对对抗样本的分类概率指导转换模型的拟合。此外,在利用模型的分类概率拟合替代模型时,替代模型方法希望拟合每一个类别的输出概率,而本方法只需要拟合两个类别概率之间的差值,并且在两个类别的预测概率不同的情况下,预测概率之间的差值也可能相同,因此本方法需要拟合的目标模型信息少于替代模型方法,在相同的访问次数情况下,本方法拟合的信息更接近对抗攻击所需的目标模型的内部信息,使得其在进行对抗攻击时,可获得比替代模型方法更好的效果。

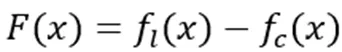

3.1 决策边界函数

(5)

3.2 拟合转换模型

图2 转换模型构建框架

拟合构建的转换模型由标签映射模块以及转换模型的训练模块组合。由于在白盒场景中,攻击者可以获得目标模型的内部信息,因此可以分别计算关于两个类别的梯度信息获取决策边界表达式中需要的梯度信息。但是在黑盒场景中,只能获取到目标模型的输出结果,构建的目标函数拟合的信息为两个类别分类概率之间的差值,所以决策边界表达式中的导数求解过程由分别计算两个输出概率的梯度信息,并将它们转换为利用转换模型的一个位置的输出信息计算目标函数的梯度信息。因此,在进行目标函数拟合过程前,本方法需要对原始样本的初始类别以及攻击的目标类别进行标签映射,将两个类别的标签映射为转换模型的一个类别,使获取的目标模型的输出结果对转换模型的训练有指导意义,从而拟合转换模型,标签转换过程如图3所示。

在标签转换过程中,根据原始类别的标签以及目标类别的标签的组合进行映射,将每两个类别的组合映射到新标签中的一个位置,获得图中所示的映射矩阵,对应位置的值的计算如式(9)所示:

根据标签转换矩阵每个位置值的计算方式,本方法获得的映射矩阵是关于主对角线反对称的矩阵,因此在计算标签映射过程只考虑映射矩阵对角线上半部分的映射,并通过构建因子(Negative-Positive Factor)表示主对角线下半部分的标签,因子计算公式如式(10)所示:

3.3 对抗样本生成

在完成迭代搜索后,对生成的对抗样本进行微调,进一步降低对抗样本的平均扰动,获得满足攻击条件的对抗样本。

4 实验

4.1 数据源

数据源采用的是图像识别领域经典的数据集, 包含十个类别的手写数字(0-9)的图像信息,每一张图片的大小为28x28,并且每一个像素点只由一个灰度值进行表示,图像的维度是784。

4.2 实验环境

硬件环境:处理器i9-9820X、显卡2080Ti、服务器内存64GB。

软件环境:Ubuntu 16.04 64位,编程语言Python3.5,框架tensorflow 1.13.1,CUDA版本:10.0.130。

4.3 实验方法

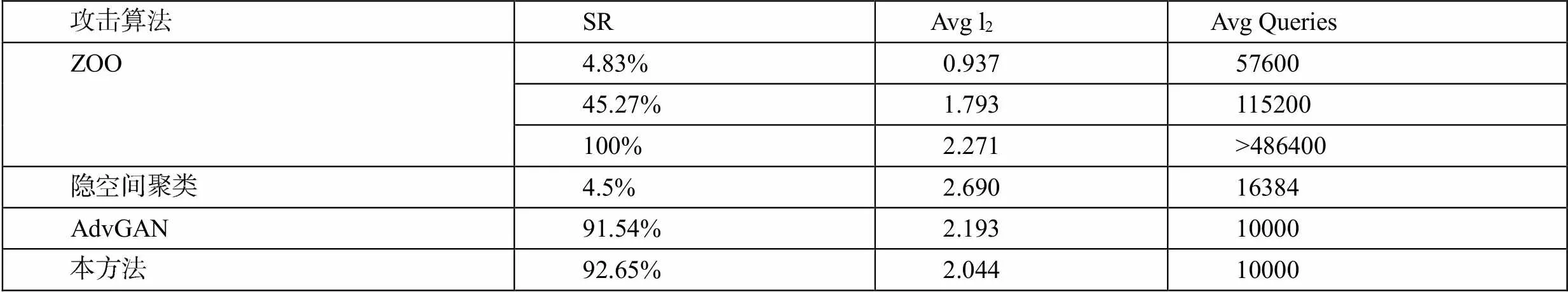

本文为研究决策边界信息在对抗攻击中的作用,提出了基于拟合决策边界表达式的攻击方法,使用MNIST数据集验证算法性能。同时根据黑盒攻击常用的攻击成功率、平均扰动以及平均访问次数三个评价指标[7],与ZOO算法、隐空间聚类方法以及AdvGAN算法[8]进行对比。平均访问次数影响了目标模型是否能觉察到攻击的存在,因此越低的访问次数对应着越好的攻击性能。实验结果如表1所示。

4.4 实验结果

表1 无目标攻击结果

表2 有目标攻击结果

通过实验结果可以看出,无论是有目标攻击还是无目标攻击,本方法在对目标模型查询次数不高于其他方法的条件下,本方法在攻击成功率上要优于其他方法。此外,本方法生成的对抗样本的扰动大小无目标攻击下与其他方法大致相当,而在有目标攻击中优于其他方法。

5 结束语

为在黑盒场景中获得决策边界表达式,本文提出基于拟合决策边界信息的对抗攻击方法,构建与决策边界相关的目标函数,通过目标模型的输出信息,利用转换模型对目标函数进行拟合,根据拟合后的转换模型与构建的决策边界信息,对原始样本进行投影操作,进而生成对抗样本。并且在MNIST数据集上进行验证,利用决策边界的信息生成对抗样本,生成性能较好的对抗样本,减少对目标模型的访问次数。

[1]Szegedy C,Zaremba W,Sutskever I, et al. Intriguing Properties of Neural Networks[C]//International Conference on Learning Representations. 2014.

[2]周世杰,张准,刘启和,等. 一种基于隐空间聚类的黑盒对抗样本生成算法,CN111191717A[P],2020.

[3]郭书杰. 基于快速边界攻击的黑盒对抗样本生成方法[J].计算机系统应用,2020.

[4]张洁,张志昊. 基于AE-WGAN的定向对抗样本生成及利用[J].南京邮电大学学报(自然科学版),2020.

[5]Chen P-Y, Zhang H, Sharma Y, et al. Zoo: Zeroth Order Optimization based Black-box Attacks to Deep Neural Networks without Training Substitute Models[C]//Proceedings of the 10th ACM Workshop on Artificial Intelligence and Security. 2017.

[6]Croce F,Hein M. Minimally distorted Adversarial Examples with a Fast Adaptive Boundary Attack[C]//Proceedings of the International Conference on Machine Learning,2020.

[7]Papernot N,McDaniel P,Goodfellow I,et al. Practical Black-box Attacks against Machine Learning[C]//Proceedings of the ACM on Asia Conference on Computer and Communications Security,2017.

[8]Xiao C,Li B,Zhu J-Y,et al. Generating Adversarial Examples with Adversarial Networks[C]//International Conference on Learning Representations,2018.