基于深度学习的白喉乌头与牧草高精度分类研究

范宏 刘素红 陈吉军 沈江龙 乔雪丽 郑江华

摘要:采用无人机获取白喉乌头危害草原区的1 cm空间分辨率的无人机数字正射影像,分别在5×5、10×10、20×20、40×40、80×80像素5个尺度下选取白喉乌头和普通牧草2类训练样本,使用VGG16、VGG19、ResNet50等3种模型对图像切片的特征进行学习,以获取图像切片的深层特征,进而实现对2类地物的分类提取。对比5个分割尺度下3种模型得到的分类精度,发现不同的分割尺度对分类精度有明显影响,随着分割尺度的增加分类精度呈现出先升高再降低的趋势,在40×40像素尺度下3种方法都得到了最高的分类精度,分别为95.31%、96.88%、93.75%,白喉乌头的分类验证精度分别为86.52%、92.77%、93.81%。对分类结果进行分析发现,在40×40像素的尺度下对应的地面实际范围是40 cm×40 cm,与白喉乌头的单株长宽接近,能较好地提取白喉乌头整株的深層特征。

关键词:卷积神经网络;毒害草;无人机影像;图像识别;白喉乌头;牧草

中图分类号: TP391.41;S127文献标志码: A

文章编号:1002-1302(2021)12-0173-08

收稿日期:2020-11-06

基金项目:新疆维吾尔自治区高校科研计划(编号:XJEDU2019I010);2018年新疆治蝗灭鼠指挥办公室委托项目。

作者简介:范 宏(1994—),男,安徽阜阳人,硕士研究生,主要研究方向为遥感与草原灾害防治。E-mail:1025288556@qq.com。

通信作者:郑江华,博士,教授,博士生导师,主要研究方向为遥感与地理信息系统应用研究。E-mail:zheng_jianghua@126.com。

天然草原是发展畜牧业的基础,近年来过度放牧和不合理开发以及气候变化等因素,导致新疆伊犁河谷天然草地大面积退化,毒害草大量繁殖和蔓延,可食牧草生产力下降,加剧了草畜矛盾,严重影响了当地畜牧业生产和草原生态平衡,毒害草已成为新疆伊犁草原的隐形杀手[1]。目前我国草原毒害草灾害监测主要依靠人工实地调查、现场取样等方式,不仅耗时、费力,且存在代表性、时效性差和主观性强等弊端,难以对毒害草的危害程度进行准确判断和对其危害范围进行预估[2]。

草原毒害草的识别检测主要包括地面检测和遥感检测[3]。遥感技术在草原毒害草的识别上主要是依据植被的光谱特征,根据植物在红光波段、近红外波段、中红外波段以及远红外波段对光谱的吸收反射特征来区分不同的植被进而识别出所要检测的毒害草[4-5]。郭芬芬等使用2012年的HJ-IA卫星超光谱成像仪(HSI)的高光谱数据,在西藏申扎县根据多种类型草地的光谱特性进行了其分布范围的提取[6]。温阿敏等采用GF-1卫星WFV传感器获取的多光谱遥感影像结合其光谱特征对新疆伊宁县的白喉乌头进行识别,验证了WFV数据在草原毒害草白喉乌头监测中的可行性[2]。杜欣等在深圳市东部利用高分辨率Pléiades遥感卫星影像,结合光谱、地形及纹理信息,采用投影寻踪学习网络的方法,实现了植物分类[7]。

无人机技术的发展,也为毒害草的识别监测研究提供了高精度的数据支持[8]。其中,无人机可见光遥感影像只包含了RGB 3个通道,能够利用的光谱信息非常匮乏[9],因受限于传感器通道数,使得在利用其数据进行图像分类时有很大困难[10]。通过对比白喉乌头和普通牧草在可见光光谱范围内的光谱曲线发现,二者在可见光波段范围的光谱特征较为相似,加大了无人机遥感中白喉乌头的提取难度,采用传统的像素统计方法很难达到白喉乌头与普通牧草的分离,会造成大量像元混分[11]。

卷积神经网络(Convolutional Neural Network,简称CNN)是一种能够进行深度学习的人工神经网络系统[12]。和传统的图像分类方式相比,卷积神经网络能够通过控制卷积核大小对更大范围的图像信息进行提取,而无须对图像中单个像元进行信息提取,与人类的视觉神经系统能够对图像进行更深层次的抽象化处理类似,进而对原始图像进行分类得到分类结果。卷积神经网络方法相较于传统神经网络使用了局部感受野和空间采样技术以及权值共享,这样可减少大量参数,能够更好地进行特征提取,增强了其适用性,泛化能力也更强[13]。卷积神经网络的基本网络结构可以分为输入层、卷积层、全连接层和输出层4部分[14]。

无人机影像数据的空间分辨率相对较高,从图像识别角度考虑,利用深度学习对无人机影像进行特征提取和地物识别,得到了草原毒害草分布情况[15]。目标特征的提取来源于图像信息,包括目标的光谱信息、形状信息、纹理信息等,关键在于将图像信息与目标本身的特点结合。

研究区普通牧草成片分布,白喉乌头散布其中,其具有一定高度且存在阴影。但是白喉乌头光谱与牧草光谱在可见光范围内高度重合,易混淆面状地物目标。针对研究区内白喉乌头与牧草的类间边界模糊、光谱相似等问题,本研究提出了一种基于卷积神经网络自动提取图像切片特征对白喉乌头和普通牧草进行区分的方法,并对识别时切片尺度大小的选择进行了探讨。首先对无人机影像按不同的切分尺度进行规则分割,得到相应的图像切片[16],然后利用基于CNN的VGG16、VGG19、ResNet50模型[17]对图像切片的图像特征进行学习[18],从而实现对白喉乌头与普通牧草的分类,根据试验结果得到最佳的切分尺度。

1 研究区与数据

1.1 研究区概况

研究区为新疆那拉提草原,地处天山腹地,位于被誉为“塞外江南”的伊犁河谷东端,地理位置为85°17′~85°28′E、43°01′~43°15′N,总面积960 km2(图1)。属于大陆性半干旱气候,夏季炎热、冬天寒冷,春季气温升高快、秋季气温降低亦快,春季气温明显高于冬季。该地区平均海拔1 800 m,年降水量为880 mm,年平均气温在 20 ℃左右。主要土壤类型有高山草甸土、山地黑钙土、灰褐色森林土等。那拉提草原草地类型为山地高寒草甸,常见的植被有白喉乌头(Aconitum leucostomum)、草原老鹳草(Geranium pratense)、箭 头 唐 松 草(Thalictrum simplex)、鸭茅(Dactylis glomerata)、无芒雀麦(Bromus inermis)和巨序翦股颖(Agrostis gigantea)等[19]。

1.2 数据来源

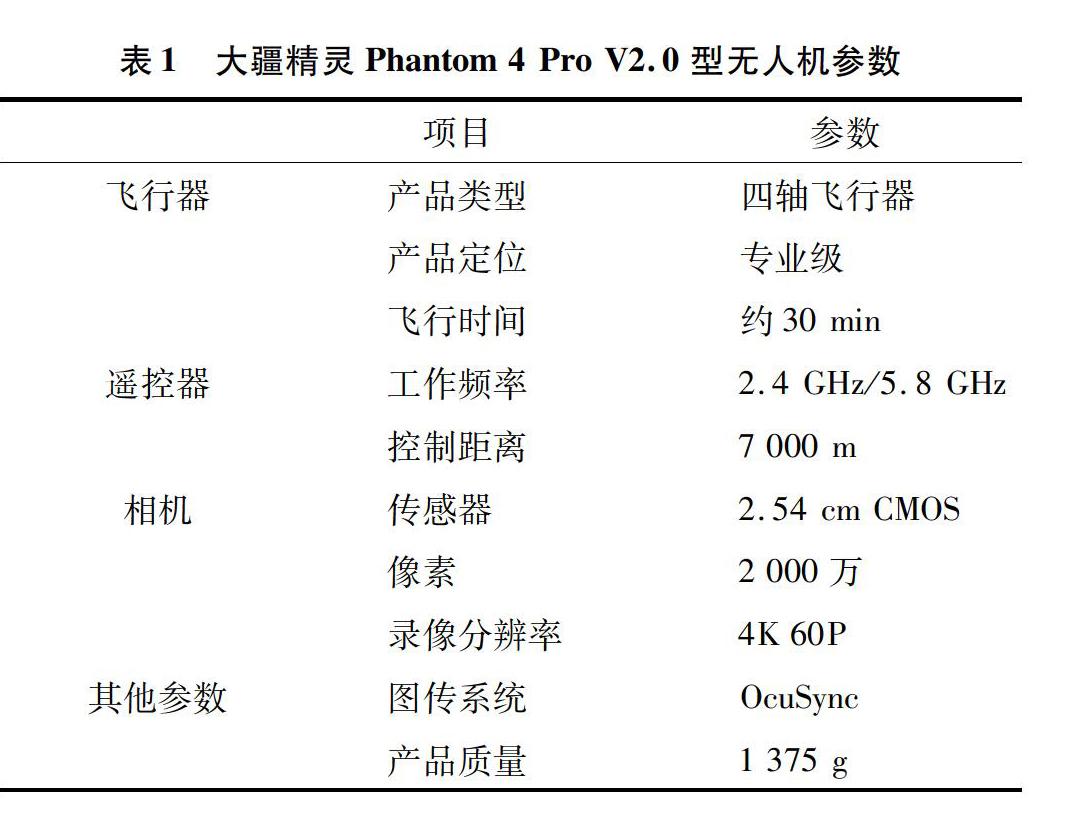

本研究所采用的数据为大疆精灵Phantom 4 Pro V2.0型四旋翼无人机影像数据,相机使用2.54 cm(CMOS)传感器,拍摄时间为2019年7月16日,地点为新疆那拉提草原南缘,研究区域植被类型为草原和林地,地势较为平坦。研究区无人机(UAV)影像分辨率为0.01 m,飞行高度为 30 m,共获取2 891幅无人机影像。无人机参数与相机参数如表1所示。

2 原理与方法

2.1 网络模型

本研究选用的CNN模型是在ImageNet数据集上预训练好的VGG16、VGG19、ResNet50模型。利用SGD和AdaGrad优化算法[20],对网络参数进行微调。VGGNet网络[21]是在AlexNet网络[22]的设计基础上进一步发展而来的,其主要贡献之一是将网络的深度增加到16~19层[17],并且网络设计使用了非常小的 3×3 的卷积核。其中VGG16模型包含3个全连接层和13个卷积层,共16层;VGG19与VGG16结构相似,有3个全连接层(Fully connected+ReLU)和16个卷积层(Convolution+ReLU),共19层(图2)。

ResNet是2015年何凯明提出的CNN结构模型,在ImageNet Large Scale Visual Recognition Challenge 2015(ILSVRC2015)会议中该方法以152层的网络模型将错误率降低到了3.75%,并且排名第一[23]。ResNet 50是一种更加容易被优化的模型,是基于已有训练深度网络提出的一种减轻了网络训练负担的残差学习框架,它可以在网络深度增加的同时让精度也得到增加[24]。ResNet模型利用层次更深的网络解决了训练误差随网络层数的增加而增加的问题[25]。相比于VGGNet网络,ResNet50包含了49个卷积层和1个全连接层,共50层,它的网络结构更为庞大(图3)。

2.2 研究方法

本研究通过对无人机影像进行多个尺度下的规则切分,获取多个尺度的图像切片,然后构建所需的数据集,包含训练样本集、测试样本集、验证数据集及白喉乌头、普通牧草2类目标样本(图4)。将制作完成的数据集使用VGGNet模型和ResNet模型进行训练,通过训练得到各尺度下图像切片的图像特征,以优化网络模型;本次研究的深度卷积网络选用VGG16、VGG19、ResNet50等3种深度学习模型。完成训练之后对验证数据集的图像进行分类,得到分类结果,最后利用抽样法对得到的分类结果进行精度验证, 同时与传统的2种分类方法

进行对比分析。

2.2.1 数据集构建

白喉乌头危害区内的无人机影像中主要包含牧草和白喉乌头2类地物。由于2类地物在可见光光谱范围内差异很小和类间边界模糊等特点,若采用传统的像元级监督分类会造成极大的混淆;采用面向对象的分类方法,很难正确地找到2类地物的边界,分类结果也很不理想。根据2类地物的空间分布特点,结合影像的空间分辨率与地物目标的大小采用不同的切割尺度对影像进行切分。首先对影像进行目视解译,分别选取2类地物的样本各240个,按照3 ∶1随机分为训练样本集和验证样本集;按照与训练样本集、测试样本集对应的切割尺度对影像进行规则切分,构成测试数据集。通过提取不同尺度下图像切片特征对测试数据集进行识别,然后为识别后的图像切片赋予不同的标签,以达到对影像的分类提取。

2.2.2 分类精度验证

通过试验得到分类结果,对分类后的图像采用抽样法来进行分类精度的验证。利用系统抽样的方法进行样本抽取[26],以保证被抽样的样点在图像上能够均匀分布。首先确定抽样的间隔,再随机确定1个样本在第1段内,然后按相等间隔选取后续样本。最后通过目视解译对比野外实地照片和无人机影像,来确定样本是否分类正确,再通过计算得到试验的分类精度。

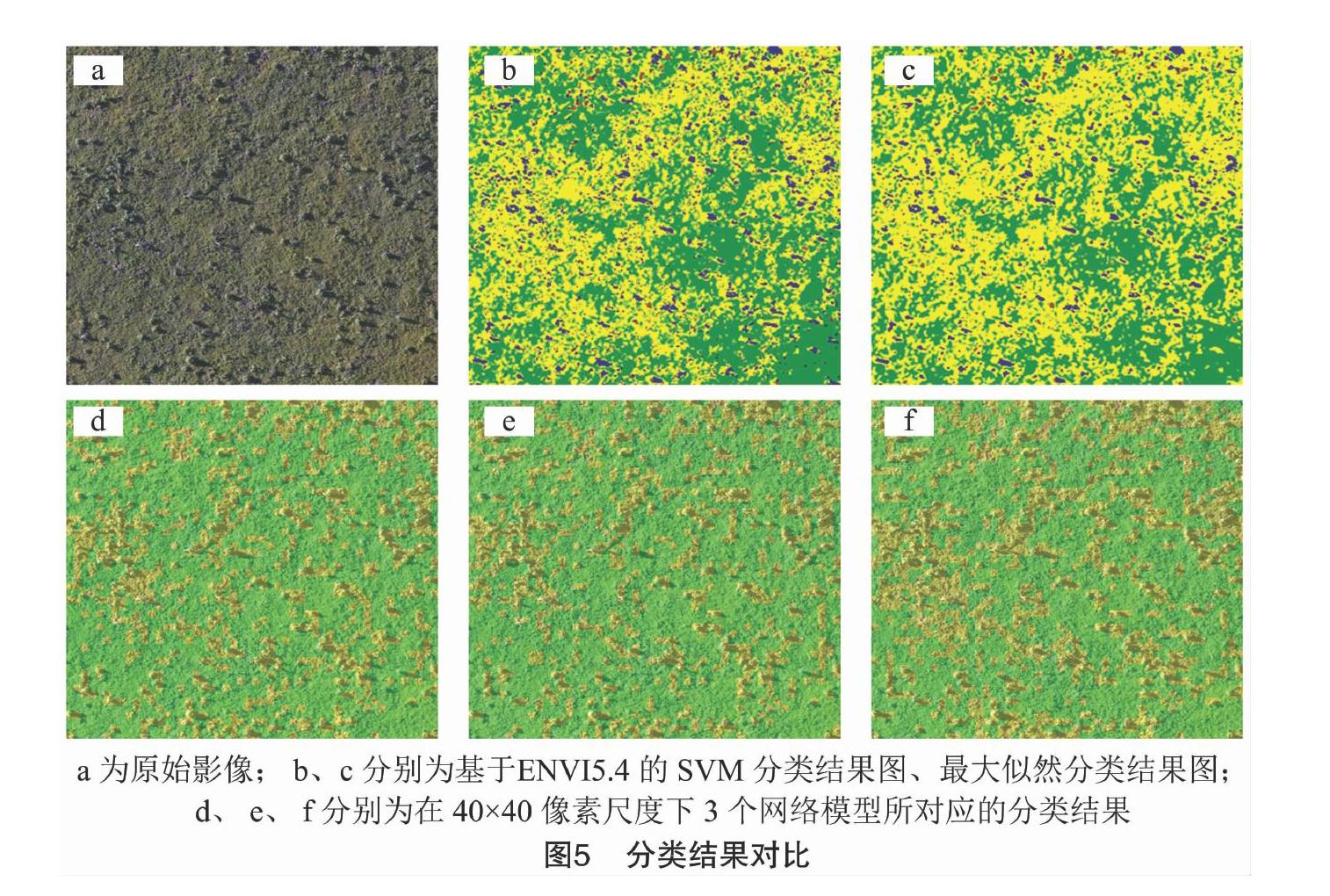

2.2.3 分类结果对比

将深度学习得到的分类结果与基于支持向量机(SVM)分类、最大似然分类2种方法的分类结果进行对比,通过人工目视解译来判断3种模型在5个尺度下的分类测试结果与2种监督分类方法的正确性,找到最佳的图像分割尺度和方法。

3 试验结果与分析

3.1 数据集与预处理

在综合考虑影像空间分辨率和目标地物大小的基础上,本研究选取了共5个尺度的数据集,分别是5×5、10×10、20×20、40×40、80×80像素。5个尺度下分别建立训练数据集、测试数据集、验证数据集。训练数据集和测试数据集的构建步骤如下:首先对影像进行人工目视解译,分别选取2类地物样本各240个;然后通过笔者所在研究团队研发的图像裁剪软件(Extract-Interface V1.0)按坐标文件进行规则裁剪;最终将得到的图像切片按照3 ∶1随机分为训练样本集和测试样本集。验证数据集的构建是选取1幅较大影像,通过图像裁剪软件按固定尺度进行规则裁剪。由于要避免数据量过大导致测试时间过长,故采用了不同大小的影像用来构建测试数据集。在5×5像素尺度下选取1幅500×500像素的影像,裁剪得到10 000幅图像切片;在10×10像素尺度下则选取1幅1 000×1 000像素的影像,裁剪得到10 000幅圖像切片;在20×20、40×40、80×80像素尺度下选取1幅2 000×2 000像素的影像,裁剪分别得到 10 000、2 500、625幅图像切片。本研究的主要目标是对不同尺度下的白喉乌头和普通牧草2类地物进行区分,选取的训练样本集展示如表2所示。

3.2 结果与分析

本次研究采用5种不同分割尺度的方案,结合基于CNN的VGGNet与ResNet模型将研究区内的白喉乌头与普通牧草进行区分。从分类的测试精度中可以看出,基于深度CNN的自动提取图像特征的几种方法在提取图像的深层信息方面具有一定优势,能够更好地综合图像的纹理、光谱、结构等信息,对图像的信息提取更加全面。如表3所示,随着分割尺度的增加,分类精度大体呈现先增加再减小的趋势。

将规则分割的5个尺度的验证数据集输入15个通过训练得到的优化后的网络模型,进行自动分类得到的分类结果见表4。

在40×40像素尺度下3种模型分类精度较高,VGG16、VGG19、ResNet50模型的分类精度分别为95.31%、96.88%、93.75%。分析发現,在40×40像素的尺度下对应的地面实际范围是40 cm×40 cm,与白喉乌头的单株长宽接近,在训练样本的选择中图像切片恰好覆盖整株白喉乌头,能较好地提取整株白喉乌头的深层特征。从表4也可以看普通牧草 白喉乌头出,在该尺度下3个网络模型提取的白喉乌头分布效果较好,基本覆盖所有的白喉乌头。在5×5像素尺度下,只能得到较少的白喉乌头和牧草的光谱特征,在信息提取时,2类地物光谱差异很小,故分类精度很低,分别只有66.97%、66.41%、62.50%;3个网络模型提取的白喉乌头分布均较为杂乱,不能很好地表示白喉乌头的空间分布(表4)。与5×5像素相比,在10×10像素尺度下的信息稍加丰富,在分类精度上有一定提升,分别为76.56%、72.66%、82.81%,但2类地物的相似性仍然很难区分,3个网络模型的提取结果依然不理想,大量的牧草被识别为了白喉乌头。在20×20像素尺度下,样本已经能覆盖正常白喉乌头的1/4和较小白喉乌头的一半甚至全部,2类地物在该尺度下已经可以明显区分,分类精度有了明显提升,分别为86.07%、86.07%、93.44%,其中ResNet50模型所得到的精度已经非常接近其在40×40像素尺度下的分类精度,ResNet50模型所分出的白喉乌头已经很接近真实的白喉乌头分布,另外2个模型较差。在80×80像素尺度下,其分类精度分别为95.31%、94.31%、82.93%。从训练样本可以看出,样本图像切片包含了白喉乌头和其周围牧草的信息,有一定的信息混杂,在分类精度上VGG16和VGG19模型与上一尺度的分类精度相比变化很小,在ResNet50模型中,其精度下降较为明显,从93.75%下降到82.93%。大部分白喉乌头都已被识别出,但由于切割尺度问题,有些较小而孤立的白喉乌头没有被区分出来,同时大量的牧草也被识别为白喉乌头。

综上所述,模型的分类精度与其训练样本尺度的选择之间可能具有较大的关联。对分类结果分析发现,当训练样本的尺度能恰好完整地包含目标地物时,可以更好地提取其深层特征,对光谱特征差异较小的地物识别,能够达到更好的分类精度。

3.2 分类精度验证

通过对不同尺度下分类精度的对比与分析,得到白喉乌头识别检测的最佳切分尺度为40×40像素,利用系统抽样法对分类结果进行精度验证。本研究将40×40像素的3个网络模型对应的结果图进行均匀采样,采样数均为625块。通过与实地照片和无人机影像的对此解译来确定样本分类是否正确,然后统计得到最终分类精度。

如表5所示,使用深度学习的方法进行图像分类可以取得很好的效果。测试阶段的表现更加明显,VGG16、VGG19、ResNet50的分类精度均达到了93%以上;在分类精度验证时,可以看出白喉乌头的分类精度分别为86.52%、92.77%、93.81%,分类效果较为理想,仅存在个别偏差;牧草的分类精度分别为78.92%、76.94%、67.61%,3种方法对牧草的分类大体正确,但在局部范围内存在一定偏差,原因是影像中颜色偏亮的枯黄牧草被错分为白喉乌头,导致牧草的分类精度偏低。由于在影像中牧草所占比例较大、白喉乌头所占面积较小,故整体精度受牧草精度影响较大,分别为78.92%、76.94%、67.61%。基于卷积神经网络的3种方法中,3个网络提取的白喉乌头分布一致性较高,与实际目视解译结果相比,三者基本能够将白喉乌头完全识别出来,基本没有遗漏。较易产生混淆的是牧草中光谱反射率较高的偏黄牧草与稀疏牧草,通过人工目视解译也有一定难度,因此验证数据中部分牧草会被识别为白喉乌头。由于本研究的目的是识别检测白喉乌头,从分类的验证结果看白喉乌头基本都被识别出来,分类效果较好,达到了对白喉乌头的识别检测目的。

4 讨论与结论

为了体现深度学习方法在草原毒害草识别上的优越性,将本研究分类结果与传统的2种监督分类方法进行了对比(图5)。

通过目视解译可以看出,基于像元统计的传统分类方法对于光谱差异很小的地物分类效果很差,大量的牧草被错分为白喉乌头。其原因是牧草与白喉乌头均为草本植物,颜色均呈绿色,目视解译也很难对其进行区分;在影像中白喉乌头的顶部较普通牧草偏亮,这是牧草与白喉乌头的区分标志,但部分牧草由于枯黄或被牛羊啃食过后较为稀疏,呈现亮度也偏大,因此在这些区域使用任一种分类方法进行分类都有很大难度。与传统的基于像元统计的分类方法相比,深度学习方法的分类精度明显提高,VGG16、VGG19和ResNet50的分类精度均达到了93%以上,白喉乌头的分类精度验证也分别为86.52%、92.77%、93.81%,整体精度受牧草精度影响分别为78.92%、76.94%、67.61%。从图5中可以看出白喉乌头基本全被识别出来,能够满足白喉乌头识别的精度要求。

在地物识别的图像切割尺度选择上,对试验结果分析可以得出,当图像切片恰好能完全覆盖目标地物时,能够最为全面地获取目标地物的深层特征,这样所达到的分类精度也就是最高的。但在验证分类模型的分类精度时发现,由于切割尺度设为与目标地物白喉乌头尺寸一样,在实际操作中对测试影像进行规则切割,其中会有一定量的白喉乌头被拦腰分在2个图像切片里,或者有1/4在1个切片里,出现同1个切片中有2类地物,导致二者无法得到很好的区分,即使是人工目视解译判读也很难给出明确的界定。这种情况下,增加1类混合地物切片,或许能够改善分类结果,以后的研究中会着重考虑。

总体来看,深度学习方法较传统方法有非常好的区分效果,错分现象大量减少,较好地解决了传统方法所不能完成的光谱相近地物的区分问题,实现了白喉乌头与牧草较高精度的自动分类。

本研究利用深度学习的代表性模型VGG16、VGG19和ResNet50对草原毒害草的识别问题进行研究,通过与SVM和最大似然2种传统图像分类方法的结果对比,说明深度学习网络可以更好地提取地物的深层特征,从而提升无人机影像分类的准确性,能够较好地解决白喉乌头与普通牧草在可见光范围内光谱相似、在传统基于像元统计方法中难以区分的问题。

本研究提出了基于CNN的分类方法,对无人机影像中白喉乌头和牧草进行分类,并讨论了切割尺度的选择问题,确定了最佳切分尺度。从试验结果看,3种模型的分类精度在不同的尺度下各有优劣,但都在40×40像素尺度下得到了最佳分类效果,分别为95.31%、96.88%、93.75%,总体趋势呈现随着切割尺度的增大分类精度先增加再减小的趋势。故最佳的切割尺度应该选择尽量接近被检测目标的实际大小,这样能够较完整地提取图像切片深层信息,达到较高的分类精度。

随着草原毒害草防治工作的迫切要求和无人机监测技术的发展,深度学习方法将在无人机草原毒害草监测识别中发挥重要作用。今后将继续深入开展相关研究,进一步提升草原毒害草的识别精度,为新疆草原毒害草防治提供技术支撑和相关参考。

参考文献:

[1]李 宏,陈卫民,陈 翔,等. 新疆伊犁草原毒害草种类及其发生与危害[J]. 草业科学,2010,27(11):171-173.

[2]温阿敏,郑江华,穆 晨,等. 基于GF-1WFV数据的草原毒草白喉乌头空间分布监测与分析[J]. 新疆农业科学,2015,52(10):1939-1946.

[3]Felinks B,Pilarski M,Wiegleb G. Vegetation survey in the former brown coal mining area of eastern Germany by integrating remote sensing and ground-based methods[J]. Applied Vegetation Science,1998,1(2):233-240.

[4]Jia X P,Richards J A. Segmented principal components transformation for efficient hyperspectral remote-sensing image display and classification[J]. IEEE Transactions on Geoscience and Remote Sensing,1999,37(1):538-542.

[5]Nagler P L,Daughtry C S T,Goward S N. Plant litter and soil reflectance[J]. Remote Sensing of Environment,2000,71(2):207-215.

[6]郭芬芬,范建容,汤旭光,等. 基于HJ-1A高光谱数据的藏北高原草地分类方法对比[J]. 遥感信息,2013,28(1):77-82,88.

[7]杜 欣,黄晓霞,李红旮,等. 基于投影寻踪学习网络算法的植物群落高分遥感分类研究[J]. 地球信息科学学报,2016,18(1):124-132.

[8]Chen J J,Yi S H,Qin Y,et al. Improving estimates of fractional vegetation cover based on UAV in alpine grassland on the Qinghai-Tibetan Plateau[J]. International Journal of Remote Sensing,2016,37(8):1922-1936.

[9]Walter V. Object-based classification of remote sensing data for change detection[J]. ISPRS Journal of Photogrammetry and Remote Sensing,2004,58(3/4):225-238.

[10]易超人,鄧燕妮. 多通道卷积神经网络图像识别方法[J]. 河南科技大学学报(自然科学版),2017,38(3):41-44.

[11]李云飞,符冉迪,金 炜,等. 多通道卷积的图像超分辨率方法[J]. 中国图象图形学报,2017,22(12):1690-1700.

[12]He K M,Zhang X Y,Ren S Q,et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(9):1904-1916.

[13]Sirinukunwattana K,Raza S E A,Tsang Y W,et al. Locality sensitive deep learning for detection and classification of nuclei in routine colon cancer histology images[J]. IEEE Transactions on Medical Imaging,2016,35(5):1196-1206.

[14]段 萌,王功鹏,牛常勇. 基于卷积神经网络的小样本图像识别方法[J]. 计算机工程与设计,2018,39(1):224-229.

[15]韩星烁,林 伟. 深度卷积神经网络在图像识别算法中的研究与实现[J]. 微型机与应用,2017,36(21):54-56.

[16]Helmy A K,EL-Taweel G S. Regular gridding and segmentation for microarray images[J]. Computers & Electrical Engineering,2013,39(7):2173-2182.

[17]Zefler M D,Fergus R. Visualizing and understanding convolutional networks[C]//Fleet D,Pajdla T,Schiele B,et al. Proceeding of Computer Vision—ECCV 2004. Zurich:Springs,2014:818-833.

[18]Zhou X,Sun Z P,Liu S H,et al. A method for extracting the leaf litter distribution area in forest using chip feature[J]. International Journal of Remote Sensing,2018,39(15/16):5310-5329.

[19]张鲜花,安沙舟,王显瑞,等. 白喉乌头种群空间分布格局初步研究[J]. 草地学报,2012,20(3):428-433.

[20]黄慧萍,吴炳方,李苗苗,等. 高分辨率影像城市綠地快速提取技术与应用[J]. 遥感学报,2004,8(1):68-74.

[21]Simonyon K,Zisserman A. Very deep convolutional networks for large-scale image recognition[J]. Computer Science,2014:1-14.

[22]Krizhevsky A,Sutskever I,Hinton G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM,2017,60(6):84-90.

[23]He K M,Zhang X Y,Ren S Q,et al. Deep residual learning for image recognition[C]//IEEE. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition,2016:770-778.

[24]王景中,杨 源,何云华. 基于多分类和ResNet的不良图片识别框架[J]. 计算机系统应用,2018,27(9):100-106.

[25]陈小娥,杨薇薇. 基于深度学习的车标识别算法的研究与实现[J]. 长春工程学院学报(自然科学版),2017,18(2):117-120.

[26]Gundersen H J G,Jensen E B. The efficiency of systematic sampling in stereology and its prediction[J]. Journal of Microscopy,1987,147(3):229-263.

——黔南扁穗雀麦