基于全局—局部特征联合的光学卫星遥感图像舰船目标细粒度识别

李孟洋 孙炜玮 张筱晗 姚立波*

基于全局—局部特征联合的光学卫星遥感图像舰船目标细粒度识别

李孟洋1,2孙炜玮1张筱晗3姚立波*1

(1 海军航空大学,烟台 264000)(294592部队,徐州 050003)(3 遥感信息研究所,北京 100096)

针对光学遥感图像舰船目标类间差异小,需要丰富舰船目标的特征表示能力提高其细粒度识别准确率的问题,文章提出了一种基于全局—局部特征联合的舰船目标细粒度识别方法,设计了双分支特征提取与融合模型。首先,全局特征提取分支通过卷积神经网络提取图像的全局特征;其次,局部特征增强分支将浅层特征图打乱并重构,加入对抗性损失函数,训练网络识别局部重点区域特征的能力,提取目标局部特征;最后,将全局特征和局部特征进行融合,利用全连接层对特征进行降维处理去除冗余信息,增加鲁棒性,并利用融合特征完成分类任务。实验表明,该方法可以兼顾全局特征和局部特征,在FGSC-23舰船目标数据集上准确率达到86.36%,优于其他方法。

舰船目标 细粒度识别 特征融合 遥感图像 遥感应用

0 引言

随着海洋资源的开发和利用,对海上舰船目标实现精准识别对于维护海洋安全具有重要意义。面对广阔的海洋,光学遥感卫星具有覆盖范围广、空间分辨率高、与人类视觉表征相符合等优势[1]。因此,利用高分辨率光学遥感图像可以更好的完成舰船目标细粒度识别任务[2-3]。然而,受光照、天气等因素影响,不同平台光学遥感器对同一舰船目标的成像差别较大,导致舰船目标类内差异大;同时,光学遥感图像通常只有俯视的平面影像,缺少其他角度信息,这都为舰船目标精细识别任务带来困难。

遥感图像舰船目标识别分为三个级别:元识别,判断有无舰船;粗粒度识别,判别民船、军舰、航母等;细粒度识别,判别舰船具体类别,如巡洋舰、护卫舰等。传统的遥感图像舰船目标识别方法主要分为特征提取[4-8]、特征选择[9-10]以及判别分类三个步骤,但对人工特征依赖较大,无法提取深层次信息,速度慢且识别率较低。近年来,发展迅速的深度学习技术被引入到遥感图像舰船目标识别任务中。文 献[3]提出了基于二维傅里叶变换的深度网络(2D-DFrFT based Deep Network,FDN),通过变换域丰富图像细节信息,在仅有四类舰船目标的BCCT-2000数据集上进行验证;文献[11]提出的基于卷积神经网络CNN(Convolutional Neural Network)的合成孔径雷达图像(Synthetic Aperture Radar,SAR)舰船识别算法,解决了数据分布不平衡的问题;文献[12]提出了一种基于CNN的多波段舰船目标融合识别方法,完成了六类舰船的分类。但仅通过CNN提取目标全局特征,缺少对目标局部重点区域特征的关注。此外,这些工作仅针对舰船目标粗粒度识别,不适合舰船目标细粒度识别任务。

在计算机视觉中,目标细粒度识别任务的重点在于找到其关键的判别性区域,随着深度学习的蓬勃发展,发展出基于关键位置的分类网络[13-17]和端到端特征编码[18-20]的两种框架。文献[21-22]等通过对层间特征交互处理,提高网络局部特征学习的能力;文献[23]通过破坏重建的方式加强网络对关键判别位置的响应;文献[24]训练得到一系列卷积核探测具有判别性的特征模块。以上方法均在细粒度自然图像识别任务中取得了不错的成绩。卷积网络[23-24]仅通过重点关注目标的局部特征就可以有效提高细粒度识别准确率,为遥感图像舰船目标细粒度识别任务提供了借鉴,但其主要基础是自然图像具有丰富的局部特征以及空间维多角度的成像。遥感数据与自然场景图像存在较大的域差异,受舰船刚体目标特性和光学遥感成像的限制,舰船目标不同类别之间可能存在相似的全局特征或局部特征,为细粒度识别任务带来困难。目前,利用光学遥感图像对舰船目标进行元识别和粗粒度识别已有所成果,但细粒度识别任务尚处于探索阶段。

针对高分辨率光学卫星遥感图像舰船目标细粒度识别问题,本文提出了一种基于全局—局部特征联合的双通道舰船目标识别方法。首先,通过全局增强单元学习舰船目标的全局特征;其次,通过局部增强单元训练卷积网络,使其关注重点集中在局部特征;第三,将全局特征和局部特征进行融合,增强不同特征之间的互补性,提高特征稳健性,完成识别任务;最后,基于FGSC-23数据集[3],对算法性能进行测试验证。

1 特征图重构算法

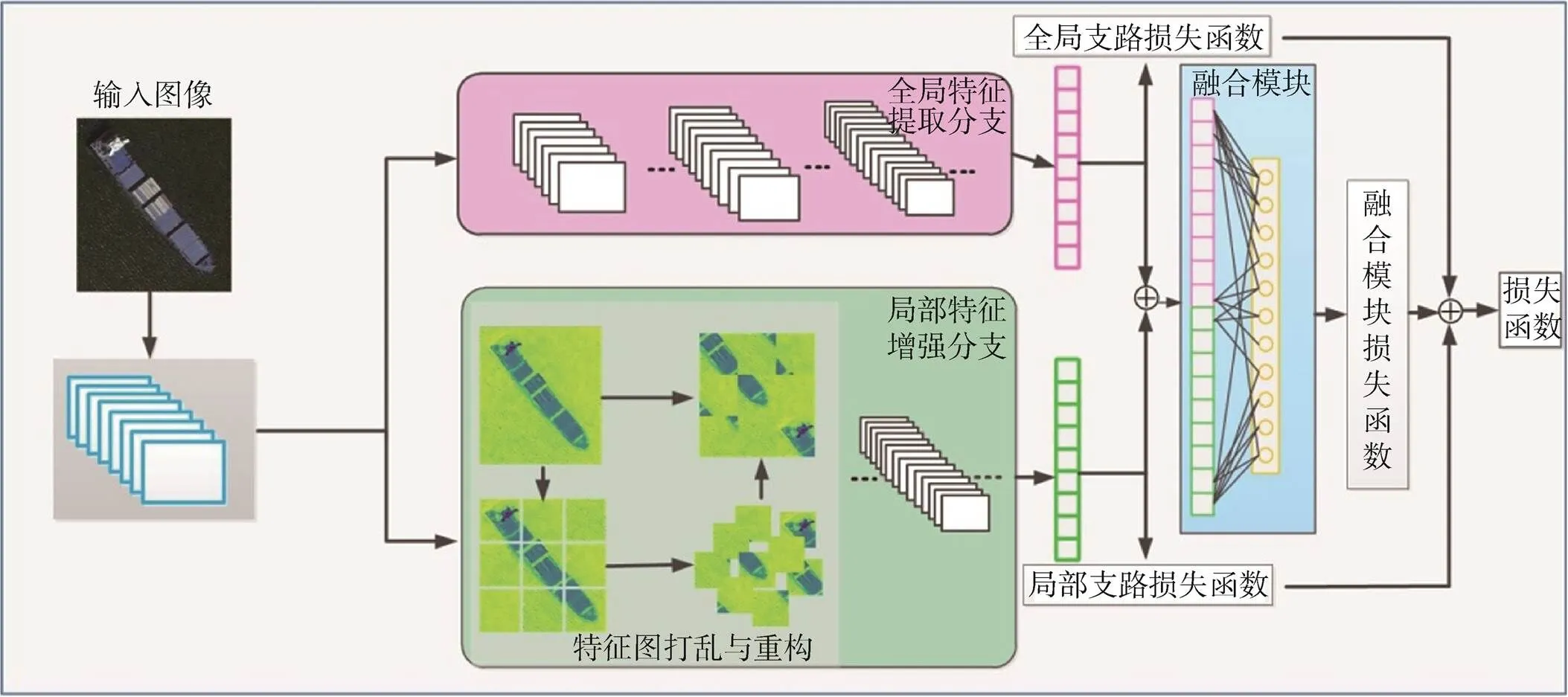

1.1 网络结构

本文设计的模型分三个模块,分别为全局特征提取分支、局部特征增强分支以及特征融合模块,算法结构如图1所示。全局特征提取分支中,选取Restnet50网络[25]作为目标全局特征提取网络,提取舰船目标深层语义特征,并经过全连接层得到舰船目标的全局特征。局部特征增强分支,设计了特征图重构算法,将提取的局部特征打乱重构作为网络输入,同时设计对抗性损失函数,通过训练,加强网络对目标局部特征的响应能力,提取舰船目标的局部特征。特征融合模块,将全局特征和增强的局部特征在特征维进行融合,设计融合方法并对融合特征进行降维处理,去除冗余信息,降低计算量,送入分类网络得到识别结果。针对数据集可能存在的样本不均衡问题,采用优化的交叉熵损失函数对网络进行训练。下面对模型中的局部特征增强分支、特征融合模块以及模型训练损失函数分别进行分析。

图1 双分支全局与局部特征提取和融合模型结构

1.2 局部特征增强分支

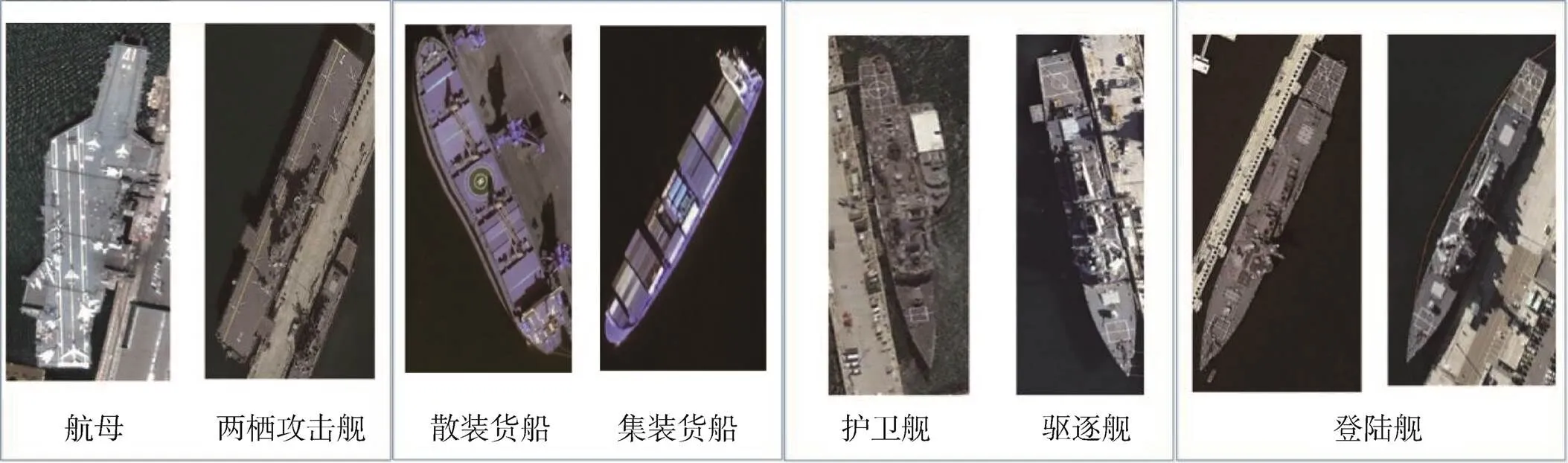

如图2所示,对于某些舰船,如散装货船和集装货船、驱逐舰和护卫舰具有相似的全局特征,即类间差异小;而受光照、涂层等因素影响,即使同种类别的舰船(如不同的登陆舰)在遥感图像中也会呈现出较大差异,即类内差异大。对舰船目标识别任务来说,考虑到舰船的刚体结构,具有固定的几何形状、尺度等全局特征,某些类间差异较大的舰船,如航母、两栖攻击舰,仅凭全局特征就可以完成类型识别。在类间差异小的情况下,重点局部特征将对舰船目标的细粒度识别起到关键作用。

图2 不同类型舰船光学遥感图像

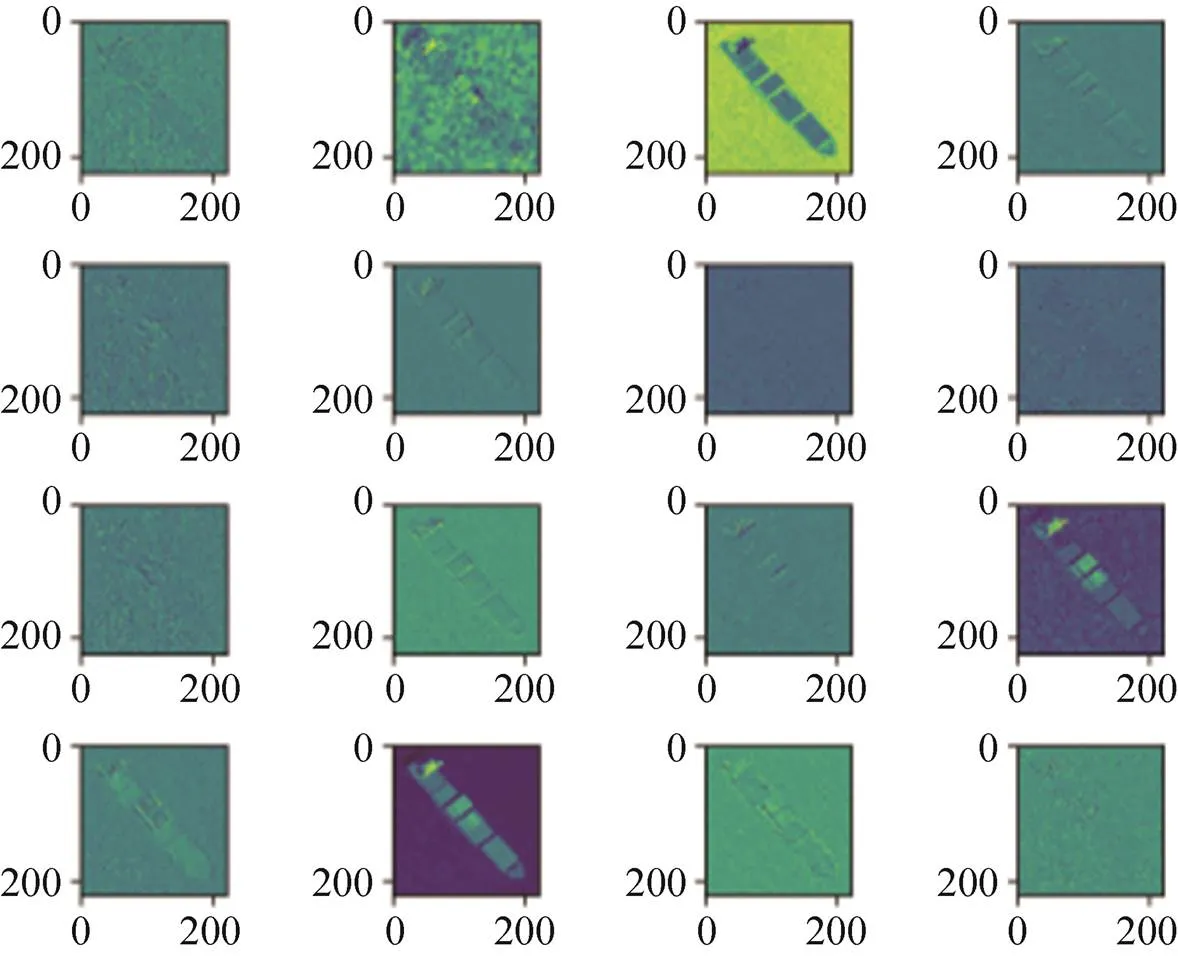

原始图像中包括舰船目标的边缘、纹理等细节特征,相比而言,CNN特征图经过卷积池化操作,得到更为抽象的语义特征,利于舰船目标识别。某散装货船图像切片经Resnet50网络第一层卷积得到的特征图前16维如图3所示,可以看出,不同通道的特征图包含有图像的不同信息,有的特征图中舰船目标部分区域得到锐化,有的特征则更抽象。如何让网络自适应从中提取目标重点局部特征是本文研究的重点。

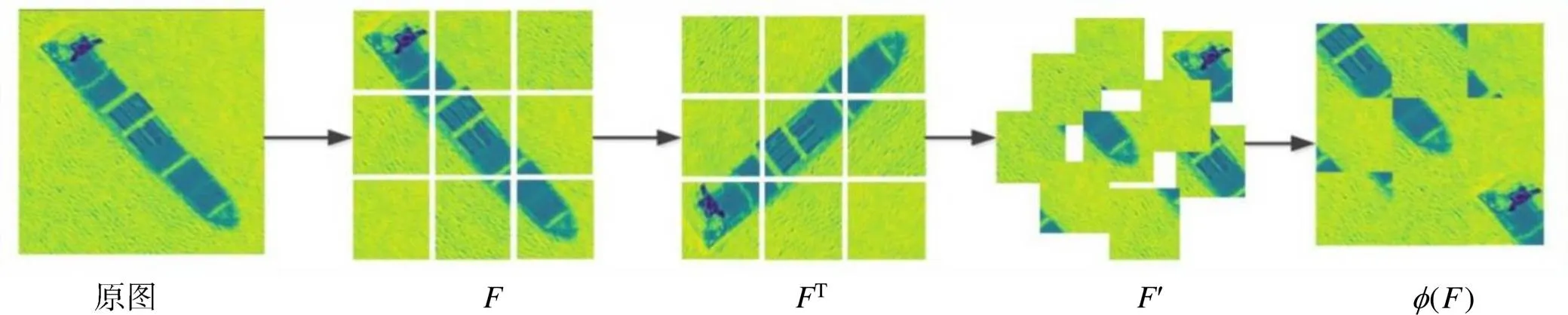

本文受破坏重构学习(Destruction and Construction Learning,DCL)[23]启发,对特征图进行打乱重构,得到重构特征图,将其和原特征图送入共享网络进行训练,若训练后,网络能够通过重构特征图准确地判别舰船目标类别,则证明该网络具备自适应提取目标重点局部特征的能力。为此,设计对抗性损失函数训练网络,引导网络仅通过局部特征来完成识别任务,使该分支向局部特征分配更多注意力,忽略其它位置,从而提取局部特征。

图3 特征图前16通道展示

图4 基于特征图的打乱与重构

1.3 特征融合

全局特征提取分支得到的特征主要集中在舰船目标轮廓、颜色等全局特征,可以完成某些类间差异大的舰船识别;局部特征增强分支得到的特征主要针对局部关键位置,可以完成某些类间差异小、类内差异大的舰船目标识别。全局特征和局部特征通过串联组成融合特征,从而实现舰船目标在不同级别下的特征信息融合,具有互补性和稳健性。本文模型利用全连接层、RELU激活层、DROPOUT层组合对融合特征进行类降维处理,加速收敛过程,提高泛化能力,去除冗余信息和噪声,提高网络识别的准确率。

1.4 模型训练与损失函数

为实现端到端训练,综合考虑各组成部分对网络的影响,更好的发挥全局特征与局部特征作用,同时减少数据不平衡的影响,设计损失函数。网络损失函数由全局支路损失函数g、局部支路损失函数p、融合模块损失函数c三部分构成

全局特征提取分支产生的损失函数为

局部特征增强分支产生的损失函数p为

局部特征增强分支产生的对抗性损失函数a

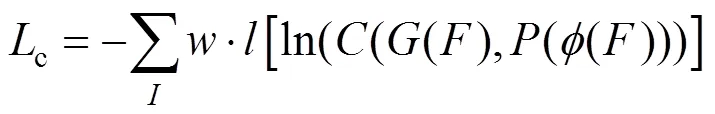

融合模块损失函数c为

2 实验

2.1 数据集与实验设置

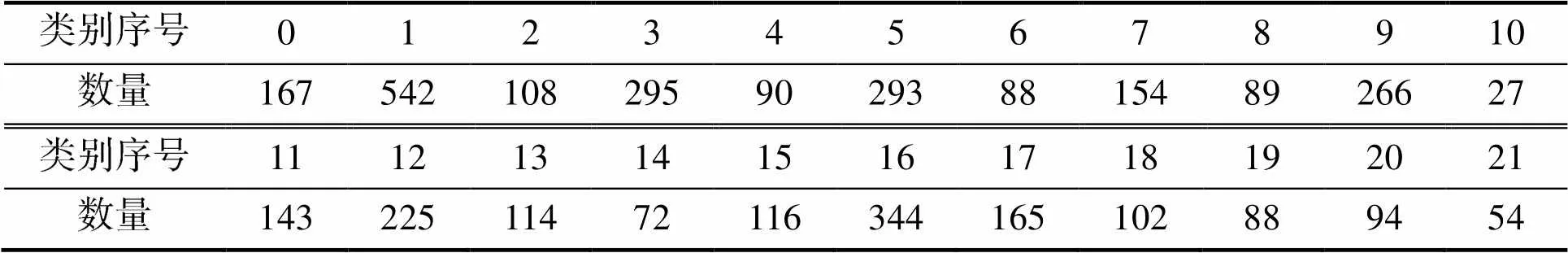

本节采用了公开的光学遥感图像舰船目标识别数据集FGSC-23对所提方法进行验证。数据集的图像分辨率介于0.4~2.0m,共包含22类、3 636个舰船目标,分别为航母、驱逐舰、登陆舰、护卫舰、两栖运输舰、巡洋舰、塔拉瓦级两栖攻击舰、两栖攻击舰、指挥舰、潜艇、医疗船、战斗艇、军辅船、集装箱船、汽车运输船、气垫船、散装货船、油船、渔船、客船、液化气体船以及驳船,依次对应类别序号0至21。实验按照4:1的比例划分训练集和测试集,各个类别样本数如表1所示。

表1 FGSC-23各类别样本数目表

Tab.1 The numbers of each category in FGSC-23

实验平台为搭载ubantu16.04系统的计算机,配置1080Ti显卡,采用Pytorch深度学习框架。实验采用了包括随机旋转、随机水平翻转在内的数据增强手段,并将图像统一映射为448像素×448像素矩形以适应模型结构的输入。以Resnet50作为特征提取网络的基本结构,采用在ImageNet数据集上训练的模型作为初始化权重,再利用实验数据集进行微调。经过多次试验调试,参数设置迭代次数300次,初始学习率0.001,每迭代60轮学习率下降为50%,采用随机梯度下降训练优化方法,动量取0.9。

2.2 评价指标

实验评价指标采用准确率和混淆矩阵。准确率为被识别正确的总数与目标总数之商。混淆矩阵的纵列代表样本标签,横行代表该样本经过分类被判别成的类别,故对角线元素代表各类别的准确率,其他位置代表被错误分类的概率。

2.3 实验结果与分析

2.3.1 不同参数的影响

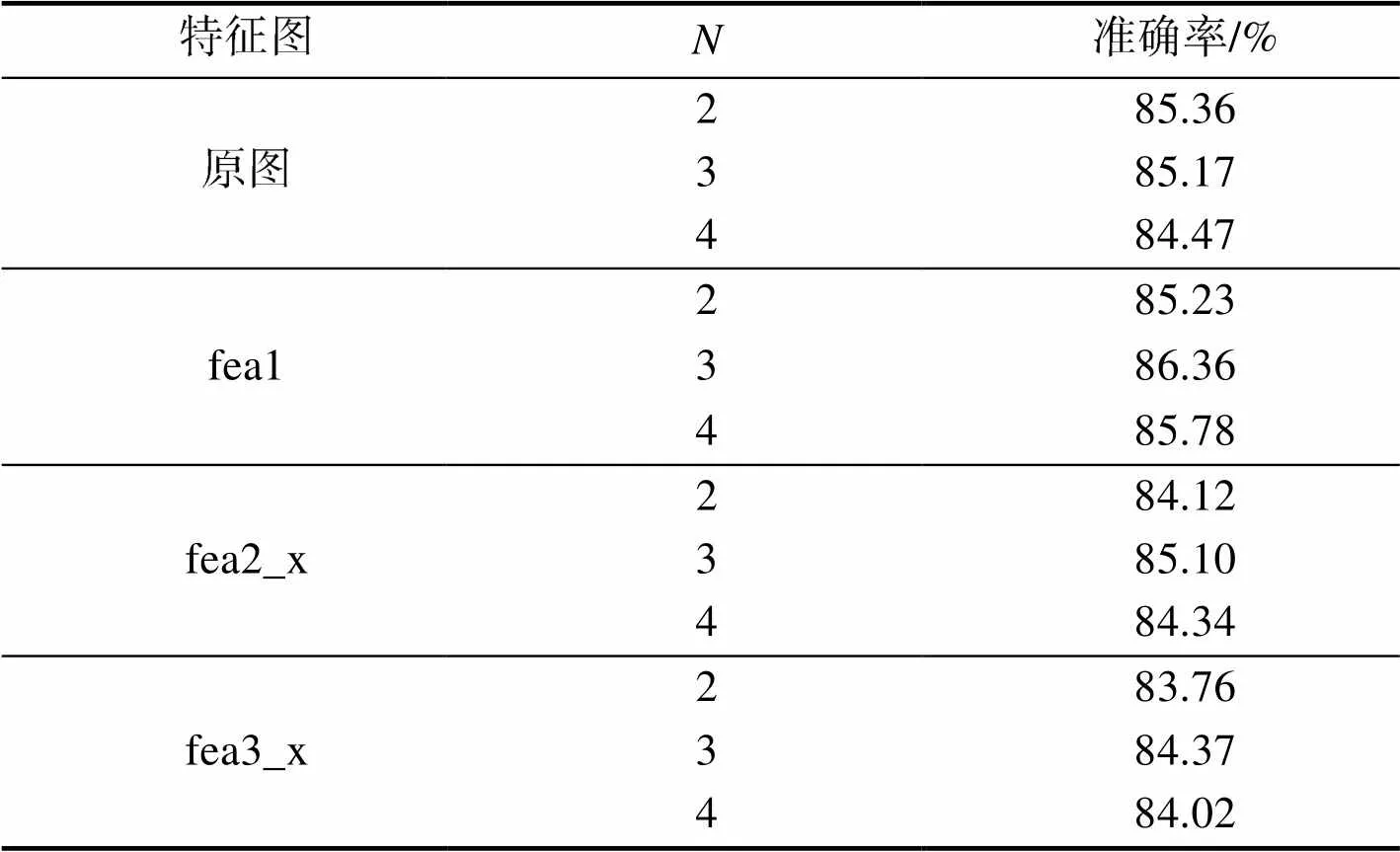

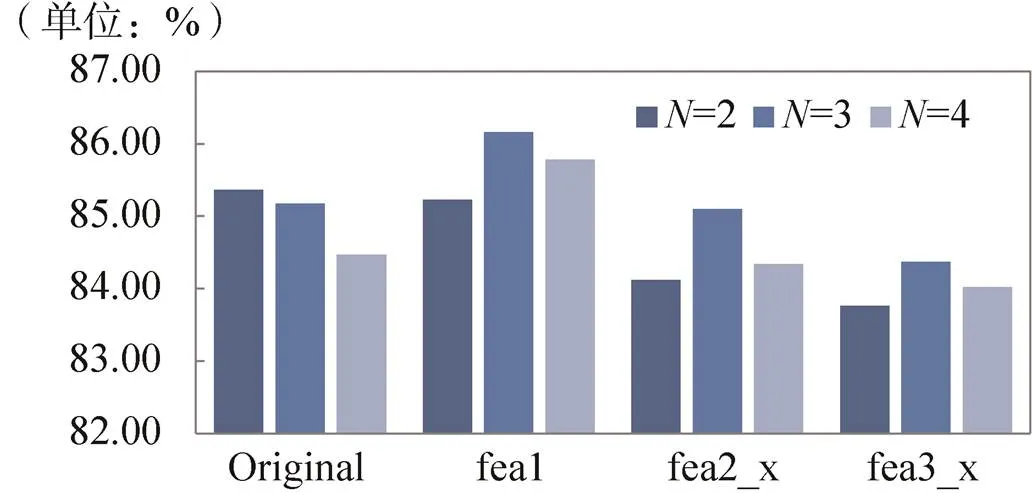

首先,验证不同网络参数对识别结果的影响。本文选取Resnet50作为基础网络进行实验。Resnet50的结构共5个模块,分别命名为conv1、conv2_x、conv3_x、conv4_x、conv5_x,输出特征图分别为fea1、fea2_x、fea3_x、fea4_x、fea5_x。为研究局部特征增强分支中打乱不同卷积层特征图以及不同的打乱参数对实验结果的影响,本文分别在原图、fea1、fea2_x、fea3_x上针对不同进行实验,结果如表2所示。

表2 不同参数的结果对比

Tab.2 Comparison with different parameters

实验结果表明,即使局部特征增强分支在原图上进行打乱重构,融合结果也要优于单分支模型,证明融合方法有效。同时,可以看到,局部支路选取基于fea1打乱的重构操作,效果要优于在原图基础上进行,在fea2_x、fea3_x特征图的打乱重构效果不明显。

由图5可以看出,在fea1特征图上,随着的增大,准确率经历了先上升后下降的阶段。当较小时,特征图分的块较大,局部支路的卷积核对关键位置的识别尚不敏感,随着的增大有所改善。但当>3时,准确率开始下降,这是因为船体的部分关键区域分块时被分开了,破坏了重点区域的整体性,网络的识别能力降低。故在后续实验中均取=3。

图5 不同参数结果对比柱状图

2.3.2 不同的特征融合方法

通过对特征融合以及结果融合两种方式下舰船目标细粒度识别结果来验证融合模块中不同融合方法对识别结果的影响。特征融合为在特征维上,对全局特征和局部特征进行串联,而后利用全连接层、ReLU激活函数、Dropout层对特征进行处理,加快收敛速度,提高泛化能力,减少冗余,达到降维效果;决策级融合是对不同支路的分类结果,采取一定的融合方式进行得到的最终分类结果。

利用决策级得到的融合结果为

经实验可得,特征级融合的准确率为86.36%,决策级融合的准确率为85.03%,说明特征级融合相对决策级融合效果较好。全局特征和局部特征融合得到的特征对舰船目标具有更全面的表征性,故识别效果优于决策级融合。

2.3.3 与其他方法的对比

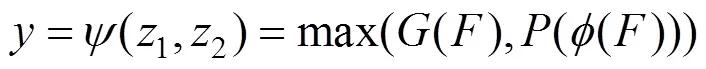

最后,为验证本文所提框架的有效性,分别采用经典的Resnet50、Vgg16,以及专门针对细粒度识别的RCNN[18]、DCL[23]方法以及本文方法在FGSC-23数据集上进行舰船目标细粒度识别实验。实验结果如表3所示。

表3 不同框架的识别结果

Tab.3 Results of different methods

从表中可以看出,在FGSC-23数据集上本文所提方法取得了86.36%的准确率,优于其他经典的深度学习方法。

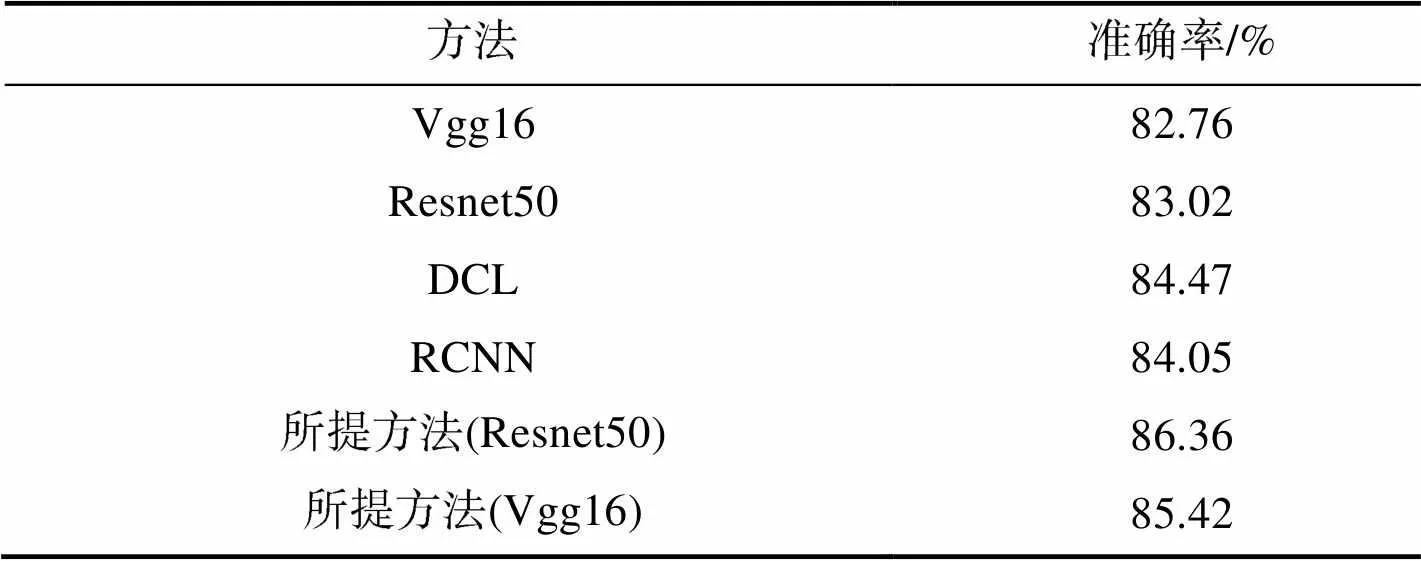

各方法的混淆矩阵如图6所示。横坐标是正确的标签,纵坐标是识别的标签,因此,对角线是正确识别的,其他位置为错误识别的。

通过混淆矩阵,可以看出,相比经典的识别方法,本文所提方法对于类间差异较小的类别,如散装货船和集装货船,具有更高的准确率,同时,相比细粒度识别方法,对于类间差异较大的类别,如航母和两栖攻击舰,识别更具包容性。简言之,本文所提方法可以兼顾全局特征和局部特征,以此实现对目标的分类,达到更好的识别效果。

图6 混淆矩阵

3 结束语

针对遥感图像舰船目标细粒度识别任务,本文提出了一种双分支全局与局部特征提取和融合模型。该模型融合了舰船目标的全局特征和局部特征,获得更丰富全面的特征表示,增强了特征的互补性和鲁棒性。局部支路通过对特征图进行打乱重构,构造对抗性损失函数,使网络获得识别判别性区域的能力。最后,基于FGSC-23数据集验证所提模型的细粒度识别能力,实验结果表明,该模型准确率达到了86.36%,优于DCL、RCNN等经典模型。本文模型受数据集限制,针对部分样本较少的类别,识别能力仍有待提高。未来将关注如何优化小样本舰船目标细粒度识别、增强特征表能力,进而提高识别精度。

[1] 王小勇. 空间光学技术发展与展望[J]. 航天返回与遥感, 2018, 39(4): 79-86.

WANG Xiaoyong. Development and Prospect of Space Optical Technology[J]. Space Recovery & Remote Sensing, 2018, 39(4): 79-86. (in Chinese)

[2] 王昌安. 遥感影像中的近岸舰船目标检测和细粒度识别方法研究[D]. 武汉: 华中科技大学, 2019.

WANG Chang'an. Detection and Fine-grained Recognition of Ship Targets in Remote Sensing Images[D]. Wuhan: Huazhong University of Science and Technology, 2019. (in Chinese)

[3] SHI Q, LI W, TAO R. 2D-DFrFT Based Deep Network for Ship Classification in Remote Sensing Imagery[C]//2018 10th IAPR Workshop on Pattern Recognition in Remote Sensing (PRRS), Augest 19-20, 2018, Beijing, China. IEEE, 2018.

[4] ZHANG X, LYU Y. A New Benchmark and an Attribute-guided Multi-level Feature Representation Network for Fine-grained Ship Classification[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2020, 13(1): 1271-1285.

[5] LOWE D. Distinctive Image Features from Scale-invariant Keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91-110.

[6] LESA J, BEAMER, STEPHEN F, et al. The BPI/LBP Family of Proteins: A Structural Analysis of Conserved Regions[J]. Protein Science, 2008, 7(4): 906-914.

[7] JORGE S, FLORENT P, THOMAS M, et al. Image Classification with the Fisher Vector: Theory and Practice[J]. Int J Comput Vis, 2013, 105(3): 222-245.

[8] WANG Y, CHOI J, MORARIU V, et al. Mining Discriminative Triplets of Patches for Fne-grained Classification[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. IEEE, 2016.

[9] 蒋定定, 许兆林, 李开端. 应用基本遗传算法进行水面舰船目标识别研究[J]. 中国工程科学, 2002, 6(8): 79-81.

JIANG Dingding, XU Zhaolin, LI Kaiduan. Application of Basic Genetic Algorithm to Target Recognition of Surface Ships[J]. Strategic Study of CAE, 2002, 6(8): 79-81. (in Chinese)

[10] 李娜, 刘方. 基于模糊聚类视区划分的SAR目标识别方法[J]. 电子学报, 2012, 40(2): 394-399.

LI Na, LIU Fang. SAR Target Recognition Method Based on Fuzzy Clustering Viewing Zone Division[J]. Acta Electronica Sinica, 2012, 40(2): 394-399. (in Chinese)

[11] HUANG L, LIU B, LI B, et al. Open SAR Ship: A Dataset Dedicated to Sentinel-1 Ship Interpretation[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(1): 195-208.

[12] 刘峰, 沈同圣, 马新星. 特征融合的卷积神经网络多波段舰船目标识别[J].光学学报, 2017, 37(10): 240-248.

LIU Feng, SHEN Tongsheng, MA Xinxing. Feature Fusion Convolutional Neural Network Multi-band Ship Target Recognition[J]. Acta Optics Sinica, 2017, 37(10): 240-248. (in Chinese)

[13] LI J W, QU C W, SHAO J Q, et al. Ship Classification for Unbalanced SAR Dataset Based on Convolutional Neural Network[J]. Applied Remote Sensing, 2018, 12(3): 10-35.

[14] HUANG S, XU Z, TAO D, et al. Part-stacked CNN for Fine-grained Visual Categorization[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June27-30, 2016, Las Vegas, NV, USA.IEEE, 2016.

[15] ZHANG H, XU T, ELHOSEINY M, et al. SPDA-CNN: Unifying Semantic Part Detection and Abstraction for fine-Grained Recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. IEEE, 2016.

[16] FU J, ZHENG H, MEI T. Look Closer to See Better: Recurrent Attention Convolutional Neural Network for Fine-grained Image Recognition[C]//2017 IEEE Conference on Computer Vision & Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. IEEE, 2017.

[17] ZHENG H, FU J, MEI T, et al. Learning Multi-attention Convolutional Neural Network for Fine-grained Image Recognition[C]//2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. IEEE, 2017.

[18] LIN T, ROYCHOWDHURY A, MAJI S. Bilinear Convolutional Neural Networks for Fine-grained Visual Recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(6): 1309-1322.

[19] XING W, ZHANG Y, GONG Y, et al. Grassmann Pooling as Compact Homogeneous Bilinear Pooling for Fine-grained Visual Classification[C]//15th European Conference on Computer Vision, September 8-14, 2018, Munich, Germany. ECCV, 2018: 365-380.

[20] KONG S, FOWLKES C. Low-rank Bilinear Pooling for Fne Grained Classification[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR), July 21-26, 2017, Honolulu, HI, USA. IEEE, 2017.

[21] ZHENG H, FU J, ZHA Z J, et al. Looking for the Devil in the Details: Learning Trilinear Attention Sampling Network for Fine-grained Image Recognition[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. IEEE, 2019.

[22] YU C, ZHAO X, ZHENG Q, et al. Hierarchical Bilinear Pooling for Fine-grained Visual Recognition[C]//Computer Vision — ECCV 2018: 11220. ECCV, 2018: 595-610.

[23] CHEN Y, BAI Y, ZHANG W, et al. Destruction and Construction Learning for Fine-grained Image Recognition[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. IEEE, 2019.

[24] WANG Y, MORARIU V I, DAVIS L S. Learning a Discriminative Filter Bank within a CNN for Fine-grained Recognition[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-22, 2018, Salt Lake City, UT, USA. IEEE, 2018: 4148-4157.

[25] HE K, ZHANG X, REN S, et al. Deep Residual Learning for Image Recognition[EB/OL]. [2020-07-11]. https://arxiv.org/pdf/1512.03385.pdf.

Fine-grained Recognition of Ship Targets in Optical Satellite Remote Sensing Images Based on Global-local Features

LI Mengyang1,2SUN Weiwei1ZHANG Xiaohan3YAO Libo*1

(1 Naval Aviation University, Yantai 264000, China)(2 Unit 94559 of the Chinese People's Liberation Army, Xuzhou 050003, China)(3 Institute of Remote Sensing Information, Beijing 100096, China)

In view of the small intra-class diversity in ship targets, the need to enrich the target's feature representation capability to improve the accuracy of fine-grained recognition is necessary, thus this paper propose a method for fine-grained recognition of ship targets based on combination of global-local features. The model consists two branches: firstly, the global feature extraction branch extracts the global features of the image through a convolutional neural network; secondly, the local feature enhancement branch shuffles and reconstructs the shallow feature map, then trains the network to extract the local feature of discriminative regions by an adversarial loss function; finally, the global feature and local feature are fused together to complete the classification task through the fully connected layer , which removes the redundant information as well as increases the robustness. Experiments show that this method can take both global and local features into account, and the accuracy rate on the FGSC-23 dataset is 86.36%, which is superior to others.

ship target; fine-grained recognition; feature fusion; remote sensing image; remote sensing application

TP75

A

1009-8518(2021)03-0138-10

10.3969/j.issn.1009-8518.2021.03.015

2020-07-20

国家自然科学基金重大研究计划重点项目(91538201);国家自然科学基金重大项目(61790554)

李孟洋, 孙炜玮, 张筱晗, 等. 基于全局—局部特征联合的光学卫星遥感图像舰船目标细粒度识别[J]. 航天返回与遥感, 2021, 42(3): 138-147. LI Mengyang, SUN Weiwei, ZHANG Xiaohan, et al. Fine-grained Recognition of Ship Targets in Optical Satellite Remote Sensing Images Based on Global-local Features[J]. Spacecraft Recovery & Remote Sensing, 2021, 42(3): 138-147. (in Chinese)

李孟洋,女,1993年生,2015年获军械工程学院雷达工程专业学士学位,2020年获海军航空大学信息与通信工程专业硕士学位,现任职于中国人民解放军94592部队。主要研究方向为深度学习、目标识别。E-mail:502295312@qq.com。

(编辑:庞冰)