深度学习算法在颈动脉超声图像斑块分割中的应用研究

沈冲冲 周小安 安相静 熊煜 吴涛

摘 要:近年来,随着计算机技术的进步和数据集的大规模化,越来越多的人把计算机视觉技术应用到超声医学图像中。但在超声图像方面却存在低准确度且不稳定产生的模糊、伪影等使现有算法对模糊、噪声图像误判较高。另外由于病例过多,人为的去检测和识别斑块过于繁琐。为了缓解这些问题,提出了采用inception的网络结构方法快速准确地获取高噪声的超声图像的关键特征,并通过数据增强和自适应中值滤波的方法确保了分割的稳定性。最后得到的颈动脉分割图像,更有利于医生去观察和判断病变体的严重程度,给医护人员带来了巨大的便利,实验结果表明,本文的方法具有实用意义。

关键词: 颈动脉超声图像;分割;inception;滤波

文章编号: 2095-2163(2021)01-0084-05 中图分类号:TP391 文献标志码:A

【Abstract】In recent years, with the advancement of computer technology and the large-scale data set, more and more people apply computer vision technology to ultrasound medical images. However, there are low accuracy and unstable blurs and artifacts in ultrasound images, which make existing algorithms misjudge blur and noise images higher. In addition, due to too many cases, it is too cumbersome to manually detect and identify plaques. In order to alleviate these problems, inception's network structure method is proposed to quickly and accurately obtain the key features of high-noise ultrasound images, and the stability of segmentation is ensured through data enhancement and adaptive median filtering. The final carotid artery segmentation image is more conducive to doctors to observe and judge the severity of the lesion, and it brings great convenience to medical staff. The experimental results show that the method in this paper has practical significance.

【Key words】carotid artery ultrasound image; segmentation; inception; filtering

1 概 述

事实上,颈部动脉斑块是颈部动脉粥样硬化的典型症状,一般会在颈部的动脉分叉处出现。目前医学界认为,其出现与缺血性脑卒中疾病密切相关。当颈动脉斑块或硬化出现时,血管内壁的内中膜结构增厚后,一开始会导致颈动脉管腔明显狭窄或闭塞。当内中膜厚度[1](Intima-Media Thickness,IMT)增大到一定程度,颈动脉内径变窄造成颅内流血消减,导致血管灌注区域内的压力减小血液流速变缓、血液的粘稠度增大,最后造成脑部区域供血量减少。随着斑块出现脱落,血液中形成的血小板和纤维素等成分会发生黏附、堆積现象,进而形成了血栓,造成远端动脉出现阻塞。这会使通往大脑的血液变少,从而引发大脑缺血、缺氧疾病,即血性脑卒中,也就是人们经常说的脑梗死[2]。因此对心脑血管疾病等高危险人群进行早期准备检测和跟踪可以对患者采取预防性(调整饮食作息习惯),治疗性(使用药物降脂治疗)等措施进行治疗。

研究表明,颈动脉的IMT可以作为心机梗死和脑卒中预测指标,斑块的总面积对斑块的变化也非常敏感,因此医生可以根据斑块的面积来检测斑块的变化。通常情况下,颈动脉斑块的分割都是由医学专家手动完成的,可是手动进行分割比较耗时,并且分割效果多会依赖操作者的临床经验。早期学者通过研究图像处理方法中图像分割等传统算法尝试去应用到医学斑块分割中,并提出了一些能够解决颈动脉斑块分割的有效方法,其中部分方法尽管不是完全自动的,但是开启了研究颈动脉斑块分割的热潮,使越来越多的人开始研究这个领域,并取得了相当不错的效果。例如文献[3-6]的研究中认为颈动脉超声图像是被图像采集噪声或半点噪声破坏的普通高频图像,并且可能具有波干扰,为了滤除采集噪声,一种解决方案是在分割之前对图像进行平滑处理。在这种情况下,文献[7]开发出了一种采用预处理的技术,通过采用中值滤波消除斑点噪声。为了衰减噪声信号并保留边缘信息,文献[8]采用了一种方法,结合了有效的主动轮廓分割来分割颈动脉超声图像,使用各向异性扩散滤镜对图像进行预处理以降低噪声。Golemati等人[9]提出了一种基于霍夫变换分割颈动脉超声图像。但是由于颈动脉弯曲特性,霍夫变换可能不适合分割颈动脉斑块。Loizou等人[10]提出了一种基于snake模型的颈动脉图像综合分割方案。但是该方法中涉及人工初始化snake,这可能导致错误的结果。Destrempes等人[11]使用3个Nakagami分布的组合来模拟颈动脉超声图像中目标区域的回声性,该图像包含斑块、血管腔和动脉壁外模,需要对图像的第一帧进行手动分割。Athanasiou等人[12]也提出一种基于K均值聚类的全自动分割方法。本文采用实例分割领域的Mask-RCNN[13]算法作为颈动脉斑块硬化自动化分割模型,该方法无需人工参与、实现了全自动的斑块分割,并在网络层中使用inception、resnet50网络进行对比,实验结果表明,采用inception具有较高的分割准确性,而且训练收

敛更快,有效避免了过拟合发生的风险。

2 相关工作

2.1 图像预处理

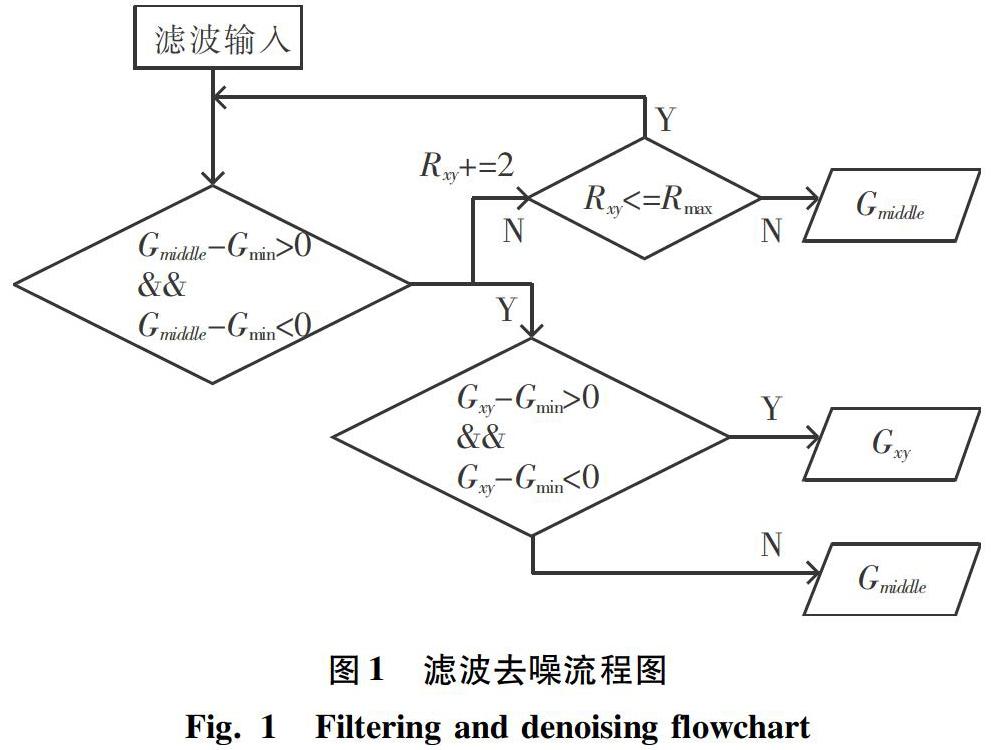

一般来说,输入的原始图像含有复杂的噪声,所以在进行图像分割之前需要进行去噪预处理。本文中用到的超声图像就包含了大量的噪声信息。因此,进行图像的预处理是必不可少的一步。采用自适应中值滤波进行去噪处理,流程如图1所示。其中,Rxy表示以(x,y)为中心的滤波器覆盖的范围,Gmin、Gmax、Gmiddle分别表示覆盖范围中的最小灰度值、最大灰度值和平均灰度值,Gxy表示(x,y)处像素点的灰度值,Rmax表示设定的最大滤波覆盖范围。

2.2 颈动脉超声图像采集

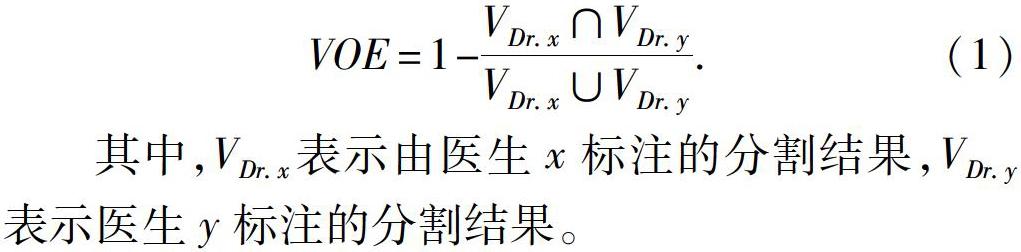

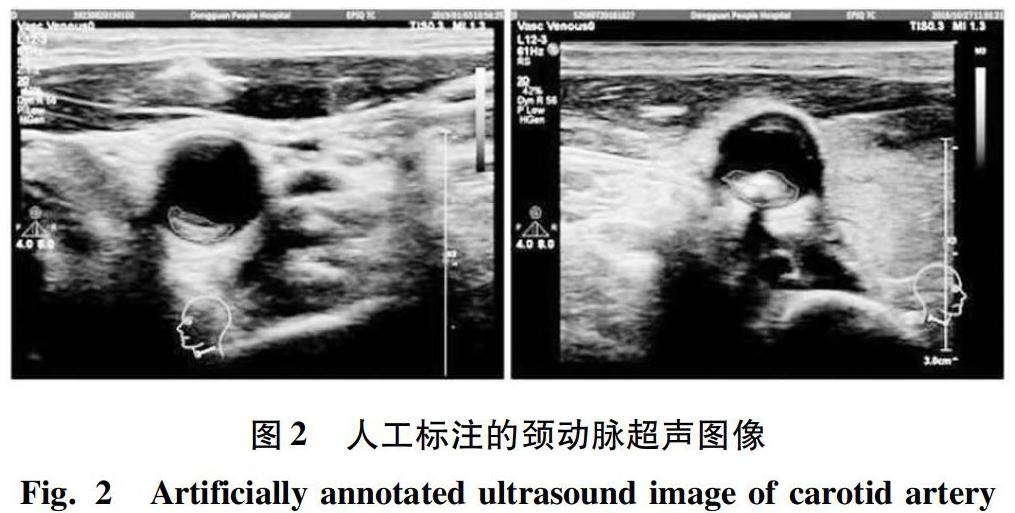

本实验使用的颈动脉超声图像主要来源于甲级医院放射科诊断室的患者。一共包含284位不同病人颈部的568张超声图像,其中每个人有2条颈动脉。图像分辨率大小为1024×768。图像标注由多位经验丰富的超声科医生完成。由于噪声等因素的存在导致部分图像手动去分割比较困难,所以通过筛选,最终留下了523张超声图像用于实验研究。经过标注的数据通过VOE(volumetric overlap error)系数的计算来选定可信度最高的那组数据作为实验金标准。VOE的公式如下:

其中,VDr.x表示由医生x标注的分割结果,VDr.y表示医生y标注的分割结果。

将每位医生的标注结果与其他几位医生的标注结果进行VOE系数运算,最后选用的是VOE均值最低的那组数据作为用于模型训练的标签。图像如图2所示。

2.3 颈动脉斑块的人工分割

对于深度学习分割算法来说,首先要确定用于训练和测试的标准,对自动分割的结果进行评价,必须以人工分割的结果为基准。因此,对这些分割结果的可靠性进行评价是很有必要的。数据交由2位专业的超声影像诊断医生助理将对568张颈动脉超声图像中的斑块进行手动分割,且两人均对彼此的分割结果并不可见。为了达到更为可靠的评估标准,后期还会随机抽取其中50张颈动脉超声图像并找其他2位有着多年工作经验的医师,再次进行手动分割,通过计算这些分割结果中斑块的差异并取平均,这些手工分割的结果就是本次研究中模型训练的标签。

2.4 数据增强

为了更好地降低训练误差和泛化误差,并优化目标使其达到最终想要的模型损失收敛到最佳位置,本次研究可以采用数据增强。而且,如果数据量少且参数多也极易导致欠拟合现象。常见的数据增强手段主要包括翻转、缩放、旋转、裁剪、变色、对比度增强等操作。

因为本实验的超声图像虽然是彩色的3通道图像,但由于实际图像3个通道颜色一样。另外,裁剪可能造成原图像目标丢失,所以在本实验中,只是采用旋转(旋转90°)、翻转、缩放(放大1.2倍)变换来增加训练数据的数量。经过数据增强后的新数据为4 184张超声图像。

3 实验方法

本实验基础网络采用resnet50、inception_v3并结合RPN,分别用于超声图像的特征提取,使用RELU作为激活函数。采用数据增强之后的数据集用于训练和预测,并对实验结果进行比较。

3.1 inception_3

inception块的网络实现的关键就是找到某些密集成分,来拟合网络的局部稀疏结构,为了做到这一点,网络去除了全连接层,并在整体上体现了聚类的思维,这样做增加了网络的宽度,同时增加了网络对多尺度的适应性。inception_v3网络结构又进行了改进,主要有2个方面:将一个较大的二维卷积拆分成2个较小的一维卷积,比如将7×7的网络拆分成1×7卷积和7×1卷积,将3×3卷积拆分成1×3卷积和3×1卷积,这可以节省大量参数,减小内存开销,出现网络过拟合的可能性也随之降低。同时也增加了一层非线性扩展模型的表达能力。另一方面,inception_v3优化了inception块的结构,但是这些inception块只在后部出现,前部还是普通的卷积层。并且inception_v3还在分支中使用了分支,可以说是网络中的网络(NiN)。

3.2 网络结构

将经过滤波去噪处理后的数据送入设定好的网络进行训练。网络结构示意图如图3所示。网络Backbone分别采用inception_v3。

3.3 损失函数

在训练期间,将每个采样的ROI上的多任务损失定义为:

掩码分支对于每个ROI具有km2维输出,其编码分辨率为m×m的k个二进制掩码,每个k类对应一个。为此,使用每像素sigmoid,并将Lmask定义为平均二元交叉熵损失。对于与真实类k相关联的ROI,Lmask仅在第k个掩码上定义,因此其他掩码输出不会导致损失。

3.4 评价指标

对于二分类问题,混沌矩阵是常用的评价指标模型。为了避免受到主观因素的影响,使评价结果更具真实性和可靠性,当对本文基于深度学习算法在颈动脉超声图像中效果进行评估时,也可以采用常规的评价指标,详见表1。其中,TP表示真正例样本的数量,FP表示假正例样本的数量,TN表示真反例样本的数量,FN表示假反例样本的数量。根据混淆矩阵可以得到目标的准确率、精确度、召回率等评价指标。参照表1则可计算得到目标的精确度和召回率,具体如下:

其中,Precision是在识别出来的图片中,True positives所占的比率,Recall是测试集的所有正样本中,被正确识别为正样本的比例。AP就是在一定阈值下Precision-recall曲线所包含的面积,可以估算为:

通常AP值越高,分类效果越好。对每个类别AP值的和求均值,就得到mAP值,Precision 和Recall 在 0-1 之间,故 mAP 的大小也在[0,1]区间内。本实驗采用AP和准确率作为模型评价工具。

4 實验结果分析

本实验使用inception_v3、resnet50作为模型,进行对比实验,将前面介绍的经过预处理和数据增强之后的超声图像用于网络模型的训练,研究中采用留出法对网络分别进行训练、验证和测试,其中,85%图像用于训练,5%用于验证,10%用于预测。模型训练的硬件环境为Intel Core i7搭载Tesla K40c显卡,在Ubuntu16.04LST系统中搭建Tensorflow的Python3.6环境进行训练,手动设置学习率为e-3,权重初始化为0,一共训练200 epoch。各部分的loss值随训练步骤的变化如图4所示。

inception_v3、resnet50的AP,准确率指标对比见表2。通过对比这两个指标,就可以得到本文提出的算法具有较好的自动分割能力,从测试集中随机挑选出4张图中与其对应的分割图如图5所示。

5 结束语

本文通过调整深度学习中的mask-rcnn网络使其应用在场景复杂的颈动脉超声医学图像病变体的自动化分割中,解决了已有文献提出方法现存的一些问题。提高了分割的准确性、不再需要人工标注,大幅度节省了医生的时间成本。在一定程度上为医生提供了便利,但本文的方法也有一定的局限性。首先,由于样本数量的限制,无法达到预期的效果,mask-rcnn算法虽然可以自动分割出颈动脉超声图像中的病变体,却不能给出病变体的严重程度,这也是下一步的工作目标。

参考文献

[1]LORENZ M W, MARKUS H S, BOTS M L, et al. Prediction of clinical cardiovascular events with carotid intima-media thickness: A systematic review and meta analysis-response[J]. Circulation, 2007,115: 459-467.

[2]GOLLEDGE J, GREENHALGH R M, DAVIES A H. The symptomatic carotid plaque[J]. Stroke:A Journal of Cerebral Circulation, 2000, 31(3):774-781.

[3]CHAUDHRY A, HASSAN M, KHAN A, et al. Automatic segmentation and decision making of Carotid Artery ultrasound images[M]//LEE S, CHO H, YOON K J, et al. Intelligent autonomous systems 12. Advances in Intelligent Systems and Computing. Berlin/ Heidelberg:Springer, 2012,194:185-196.

[4]HASSAN M, CHAUDHRY A, KHAN A, et al. Carotid artery image segmentation using modified spatial fuzzy c-means and ensemble clustering[J]. Computer Methods and Programs in Biomedicine, 2012,108 (3): 1261-1276.

[5]CHAUDHRY A, HASSAN M, KHAN A, et al. Image clustering using improved spatial fuzzy C-Means[C]//ICUMIC'12. Kuala Lumpur, Malaysia:ACM, 2012:1-7.

[6]HASSAN M, CHAUDHRY A, KHAN A, et al. Robust information gain based fuzzy c-means clustering and classification of carotid artery ultrasound images[J]. Computer Methods and Programs in Biomedicine, 2014,113 (2): 593-609.

[7]SANTHIYAKUMARI N, RAJENDRAN P, MADHESWARAN M. Medical decision-making system of ultrasound carotid artery intima–media thickness using neural networks[J]. Journal of Digital Imaging, 2011,224 :1112-1125.

[8]SANTHIYAKUMARI N, RAJENDRAN P, MADHESWARAN M, et al. Detection of the intima and media layer thickness of ultrasound common carotid artery image using efficient active contour segmentation technique[J]. Medical& Biological Engineering& Computing, 2011, 49 : 1299-1310.

[9]GOLEMATI S, STOITSIS J, SIFAKIS E, et al. Using the Hough transform to segment ultrasound images of longitudinal and transverse sections of the carotid artery[J]. Ultrasound in Medicine & Biology, 2007, 33 (12):1918-1932.

[10]LOIZOU C P, PATTICHIS C S, PANTZIARIS M, et al. An integrated system for the segmentation of atherosclerotic carotid plaque[J]. IEEE Transactions on Information Technology in Biomedicine, 2007,11 (6): 661-667.

[11]DESTREMPES F, MEUNIER J, GIROUX M F, et al . Segmentation of plaques in sequences of ultrasonic B-mode images of Carotid arteries based on motion estimation and a Bayesian model[J]. Proceedings of the IEEE Transactions on Biomedical Engineering, 2011, 58(8): 2202-2211.

[12]ATHANASIOU L, BOURANTAS C V, RIGAS G, et al. Methodology for fully automated segmentation and plaque characterization in intracoronary optical coherence tomography images[J]. Journal of Biomedical Optics,2014,19(2):26009.

[13]HE K, GKIOXARI G, DOLLR P, et al. Mask R-CNN [C]// Proceedings of the IEEE International Conference on Computer Vision. Venice:IEEE,2017: 2961-2969.