航空人工智能概念与应用发展综述

卢新来,杜子亮,许赟

航空工业发展研究中心,北京 100029

人工智能作为一类战略性的新兴技术在近年来取得了举世瞩目的成功。随着美军“阿尔法”空战格斗比赛、“融合计划2020”等一系列标志性的演示验证项目取得圆满成功,人工智能在军事领域的巨大应用潜力得到证实,围绕这一颠覆性技术主动权的争夺也在如火如荼地开展。

2019年2月,在美国总统签署行政令发布美国国家人工智能战略——《美国人工智能倡议》[1]的第2天,美国国防部就公布了其人工智能战略——《2018年国防部人工智能战略总结》[2],美国空军紧随其后也于2019年9月公布了其人工智能发展战略——《2019年空军人工智能战略》[3]。这一系列战略文件的发布,以及近年来密集的预算投入,标志着美军已正式将人工智能作为未来保持非对称军事优势的关键核心所在。公开资料显示,美国国防部的人工智能投资从2016财年的6 000万美元迅速提升至2021财年的25亿美元(包括在自主领域的投资),并且据国防部宣称其目前有超过600个人工智能项目正在进行当中[4]。

一种不可忽视的全球技术生态系统发展态势显示[5],以人工智能为代表的信息技术在数据、网络和计算能力等多个维度上呈现出指数级增长的态势,与此同时通信技术也迎来质变的发展机遇期。基于此,一种常见的观点认为相比军用系统物理属性上的提升幅度而言,信息和通信技术将为军用系统带来数量级上的增益。虽然这一观点还有待讨论和验证,但人工智能领域激烈的竞争和快速发展的态势给航空领域带来重大机遇的同时也带来了前所未有的挑战。为此,本文围绕人工智能定义、智能等级划分以及人工智能航空应用等方面的议题开展了一些基础性的研究工作,以期在人工智能赋能航空的初始阶段阐明一些基本概念和基本认识。

1 关于人工智能定义的讨论

1.1 不同视角下人工智能定义的讨论

众所周知,公认的人工智能(Artificial Intelligence, AI)概念最早于1956年的达特茅斯会议被正式提出,经过2个多月的研究,麦卡锡、明斯基、罗切斯特、香农等10人共同给出了对人工智能的预期目标:“制造一台机器,该机器可以模拟学习或者智能的所有方面,只要这些方面可以被精确地描述”[6]。这一预期目标在诞生之初就将复制人的才能,如创造性、自我改进和语言应用等,纳入人工智能的研究范畴,使其从根本上区别于控制论、运筹学等,从而成为一门独立的研究学科[7]。该预期目标在诞生之后,也曾被作为人工智能的定义使用,对该领域的发展起到了举足轻重的作用[8]。

经过60多年的发展,人工智能几经起落,已形成几千种不同的技术路线[9],其中的主流方法根据基本思想的不同大致可以划分为三大流派:符号主义、连接主义和行为主义。人工智能技术路线的多种多样部分造就了目前人工智能没有学界公认定义的现状[4],这也从一个侧面反映出如何实现60多年前达特茅斯会议上关于人工智能的预期目标依然是未知的。因此,不管具体内容如何,人工智能往往采用概括性术语(Umbrella Term)的范式来进行定义。

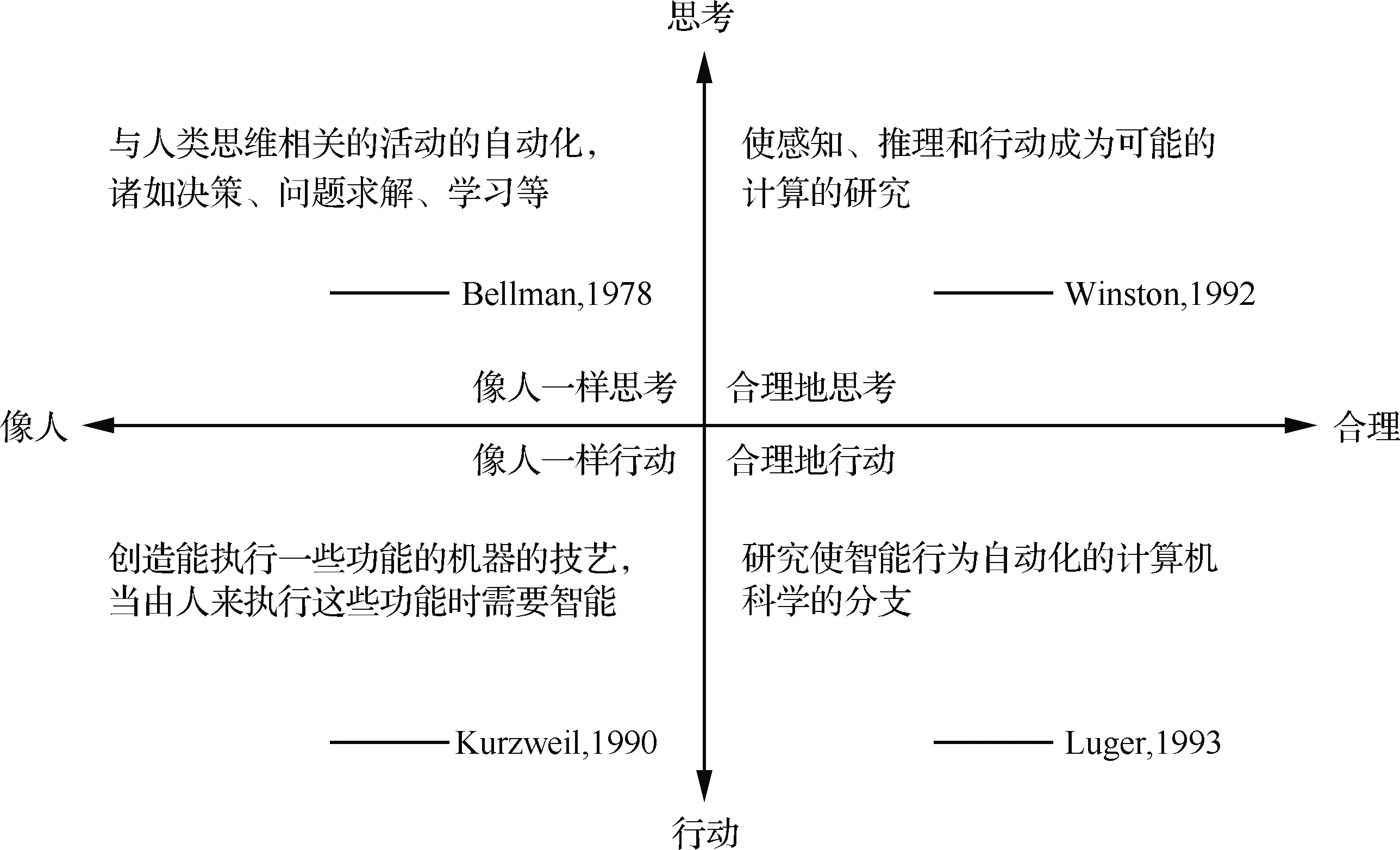

Russell和Norvig[7]按照2个维度将历史上一些具有代表性的人工智能定义进行分类,这一分类方法按照关注思维过程还是强调行为,关注与人类表现的逼真度还是强调合理性将人工智能的定义归纳为4类。这种分类方式的好处是可以高度概括和直观展示历史上学术界为实现人工智能而进行的4种不同途径的尝试。

与学术界不同,国防和工业部门作为人工智能技术的应用方,对人工智能的定义也有自己的理解。美国2019财政年度国防授权法案(NDAA)[10]第238章要求其国防部长在2019年8月13日以前给出人工智能的定义。在上述国防授权法案颁布之后,美国国防部在其《2018年国防部人工智能战略总结》[2]中对人工智能的内涵进行了描述:“无论以数字或自主物理系统内嵌智能软件的形式,机器具备执行通常需要人的智能才能执行的任务的能力,如识别模式、从经验中学习、下结论、做出预测、采取行动等”。从这一描述可以看出,美国国防部对人工智能实现途径的认知与图1中“合理地行动”这一途径更为贴合,理性论者的途径更多地涉及到基础研究与工程应用的结合,这也与美国国防部作为人工智能技术应用方的角色相匹配。

雷宏杰如姚呈康[11]针对人工智能在军用航空领域的应用特点,对军用航空人工智能的概念进行了描述:“军用航空人工智能是针对航空军事任务场景,面向作战需求,研究和制造在人类给定的具体目标下,能够通过感知、认知、决策、执行过程达成给定目标的航空装备及其相关产品的科学与工程”。这一定义在军用航空背景下对场景、需求和目标进行了限定,是对图1中“合理地行动”这一途径在特定领域应用背景下的细化。

图1 人工智能的4类定义Fig.1 Four types of artificial intelligence definitions

从美国国防部及国内航空领域专家对人工智能定义的认识上可以看出,作为技术的应用方,他们对人工智能实现的途径有着相同的认知倾向。这就像在莱特兄弟和其他人停止模仿鸟并开始使用风洞且开始了解空气动力学后,对“人工飞行”的探索才得以成功;航空科学与工程领域的教材也不会把其领域目标定义为制造“能完全像鸽子一样飞行的机器,以致它们可以骗过其他真鸽子”[7]。与这一思辨过程类似,黄铁军等[12]在论述从人类大脑出发研究更强的机器智能乃至通用人工智能时指出,理解意识现象和功能行为背后的内在发生机理是人类的终极性问题,而制造类似人脑的具有自我意识和智能功能的智能机器是工程技术领域的重大挑战。一种直观而常见的看法是“制造智能”的前提是“理解智能”,这实际上是把问题的解决建立在解决另一个更难问题的基础上,犯了本末倒置的错误[12]。

虽然美国国防部在人工智能战略中对人工智能的内涵进行了解释,但值得注意的是,目前仍然不存在美国政府正式的官方人工智能定义[4]。其中部分原因是这段描述中依然涉及到了2个未明确定义的概念,一个是“人”,一个是“智能”。如何定义“人”或者“智能”?到目前为止依然没有清晰公认的答案。实际上,维特根斯坦在1953年出版的《哲学研究》中明确指出,日常生活中使用的概念如人是没有经典概念定义的。

Nilson[13]给出了一种在人工智能定义中将未明确的概念减少到一个的答案:人工智能是关于知识的科学——也即怎样表示知识以及怎么获得知识并使用知识的科学。基于这一认识,人工智能希望发现可以不受领域限制、适用于任何领域的知识,包括知识表示、知识获取以及知识应用的一般规律、算法和实现方式等。这一定义在某种程度上揭示了人工智能具有普适性、迁移性和渗透性的原因。

为了使航空人工智能的研究范围和关注重点更加清晰聚焦,雷宏杰和姚呈康[11]从军用航空人工智能视角出发对航空人工智能技术的范畴进行了界定,即“主要面向作战,以军事应用为背景,基于人机混合智能系统的任务执行想定,通过不断提升机器的智能水平,使航空装备在强实时、高动态、不确定态势和不完备信息条件下,能够逐步实现对人的辅助、协同以及融合,不断提升人机混合智能系统的任务执行效能”。此外,还依据运行环境和层内承担的主要功能差异,将航空人工智能的运行分为体系层、平台层、平台子系统层和设备层4个层次。

1.2 关于不确定性与确定性的思辨

从1.1节关于人工智能定义的论述中可以看出,目前甚至是今后相当长的一段时间里人工智能依然难以存在公认的定义,这种不确定性给投资者、管理者和应用者带来了一定困扰,比如不同机构、组织和个人对人工智能项目的理解不同,容易带来对项目发展预期见解的差异;再比如将成本差异化较大的低端技术包装成高端应用或产品,使智能成为不可或缺的廉价广告词。

事实上,比起前沿基础研究的高风险和不确定性,比起工业或军事应用落地过程中可能面临的种种问题和困难,现有人工智能技术本身的确定性是最高的。一种认识是,本轮智能技术升级的窗口期只有10~15年,而一代新技术从诞生到成熟往往需要几十年,所以本轮智能技术升级所依靠的人工智能技术,将主要是现有人工智能技术的工程化落地,而不是等待下一代新技术的成熟[14]。

这就如设计一款飞机一样,当发动机的主要性能参数框定之后,飞机平台飞行性能指标的上限也就基本确定了。而得益于大数据可用性改善、计算机处理能力提高、机器学习方法改进这三要素融合汇聚的人工智能,其现有特性也决定了它在航空领域应用落地的方式、形态及能力边界。

2 关于智能等级划分的讨论

随着人工智能的快速发展和研究投入的持续提升,一种自然而然的想法是对智能系统的智能等级进行划分,从而引导关键技术发展,为战略规划和预算制定等工作提供必要的指导。这种想法在航空领域内反映为对航空装备进行智能等级划分的需求。然而,目前并没有专门性的权威研究成果公之于众。在一些关于人工智能分类的描述中,隐含着某种等级划分的意味。2016年Hintze[15]将人工智能分为单一反应型(Reactive Machines)、有限记忆型(Limited Memory)、具有心智型(Theory of Mind)和自我意识(Self-awareness)4类。2017年海牙战略研究中心在其《人工智能与未来防务》报告中认为人工智能分为弱人工智能(Artificial Narrow Intelligence,ANI)、强人工智能(Artificial General Intelligence,AGI)、超人工智能(Artificial Superintelligence,ASI)3个层级[16]。2018年中国国家标准化管理委员会在其发布的《人工智能标准化白皮书(2018版)》中将人工智能分为弱人工智能和强人工智能[17]。

在发展相对成熟的自动驾驶领域,国内外权威机构先后对自动驾驶汽车的自动化等级(Automation Levels)进行了划分。2013年,美国高速公路安全管理局(NHTSA)将驾驶自动化分为0~4级[18]。由于该划分对最高等级的驾驶自动化界定过于宽泛,无法满足正确引导和规范行业与技术发展的需要,美国机动车工程师协会(SAE)又于2016年提出了0~5级的驾驶自动化划分指导[19],将NHTSA分级中的等级4细化为等级4和等级5。2020年,中国工业和信息化部在其提出的《汽车驾驶自动化分级(报批稿)》国家标准中基于驾驶自动化系统能够执行动态驾驶任务的程度,根据在执行动态驾驶任务中的角色分配以及有无设计运行条件限制,将驾驶自动化功能分为0~5级。该标准将驾驶自动化(Driving Automation)定义为车辆以自动的方式持续地执行部分或全部动态驾驶任务的行为。值得注意的是,自动驾驶领域并没有基于人工智能的视角去评价自动驾驶汽车的能力,虽然有一些研究试图建立自动驾驶汽车智能等级划分的方法,但均未被广泛认可和接受。

与自动驾驶领域相似,航空领域也未见被广泛接受的智能等级划分方法。不过,一些研究试图建立无人机的智能等级划分方法或从航空人工智能技术体系构建的角度给出智能等级划分。虽然有关航空领域智能等级划分的研究较少,但关于自主性(Autonomy)和自主等级(Autonomous Levels)的研究却有着悠久的历史,对无人机系统自主等级划分的认知过程也是本文剖析航空领域智能等级划分的最佳切入点。

自1965年摩尔定律被提出以来,随着计算机处理能力在相当长的时间里稳定快速提升,无人系统尤其是无人机的能力也快速提升,随之而来的是针对无人系统的自主性和自主等级划分的热烈讨论。这些研究从无人系统本身、任务执行以及人机交互等不同角度出发,试图理解自主性及其等级划分,并随着人工智能的引入而带来全新的见解。值得注意的是,与第1节中“人工智能”的概念类似,自主性也没有公认的定义[20],人们对自主性和自主等级的认识随着无人系统的发展而不断演化。本文并不打算像第1节一样讨论自主性的概念,而是希望从自主等级划分的发展历程中寻找对论证智能等级划分的意义或方法有帮助的观点。

公认最早的关于自主等级的研究来自Sheridan[21],他基于人或机器谁来做决策以及如何执行决策将自主分为10个等级,刘树光等[22]将其译为自动装置等级。2000年,Parasuraman等[23]基于信息获取、信息分析、决策与行动选择以及行动执行这4类功能,在Sheridan工作的基础上提出了修改版的自主等级。上述自主等级划分方法基于人机交互视角,并不针对特定平台或系统。

随着无人系统尤其是无人机的机载处理能力的不断提升,无人系统迎来快速发展期,评估无人系统的自主等级也变得越来越重要。伴随着美国海军研究办公室(ONR)自主作战(Autonomous Operations,AO)未来海军能力倡议的提出以及美国空军研究实验室(AFRL)传感器飞机项目的进行,AFRL制定了一套具有1~10共10个等级划分的自主控制等级(Autonomous Control Level, ACL),作为用于衡量研究进展的标准。2001年,美国国防部公开发布的《无人机路线图2000-2025》中直接引用了上述ACL划分方法,并对当时美军一些无人机的自主等级和预期要达到的自主等级进行了评估[24]。2002年,AFRL借鉴了衡量人类效能的方法,结合OODA环的原理,对《无人机路线图2000-2025》中的ACL进行了较大修改,构建了0~10级共11个级别,分别针对OODA环中观察(Observe)、调整(Orient)、决策(Decide)和行动(Act)4个环节进行自主等级划分的ACL度量图(ACL Metrics Chart)[25]。Proud等[26]在充分参考Sheridan、Parasuraman和AFRL工作的基础上,也基于OODA环的概念,将自主分为8个等级,并分别对OODA环中4个环节进行了自主等级划分,并将这种方法应用于美国国家航空航天局(NASA)的航天器任务评估与重规划工具项目(SMART)。值得注意的是,在美国国防部接下来发布的《无人机路线图2002-2027》[27]和《无人机系统路线图2005-2030》[28]中,并没有采纳AFRL对ACL的改进,而是仍然沿用了第1版路线图中自主等级的划分方法。

随着美国陆军现代化的主要项目——未来作战系统(Future Combat Systems, FCS)的开展,国防部联合计划办公室(JPO)、陆军机动支援中心、美国国家标准与技术研究院(NIST)分别开展了描述机器人行为等级的研究。为了集成各领域的研究成果,达成一致的标准共识,NIST成立了无人系统自主等级(Autonomy Levels for Unmanned Systems, ALFUS)特别工作组,并于2004年首次公布用于描述无人系统自主等级的ALFUS框架[29-30]。该框架从任务复杂度、环境复杂性和人机交互强度3个维度切入来衡量无人系统的自主等级,随着任务复杂度不断提升、环境复杂性不断增强、人机交互强度不断降低,无人系统的沿着单驱动器/子功能—单一功能—单无人系统—编队的发展路径形成0~10级或1~10级(0~1级均为远程遥控)的自主等级划分。

随着无人机系统在伊拉克的军事行动中大放异彩,其使用也达到了前所未有的强度。截至2010年5月,美军在当年度就累计完成了100万飞行小时的无人机任务。伴随着任务量的激增和经费的削减,飞行员资源短缺成为美军面临的重要问题之一。于是,美军在其2011版的《无人系统综合路线图》中将无人系统的主要矛盾定位到任务中人的参与程度,按照人力资源需求的不同,将自主分为人操作(Human Operated)、人授权(Human Delegated)、人监督(Human Supervised)和完全自主(Fully Autonomous)4个等级[31]。

美国国防科学委员会在其2012年发布《自主性在国防部无人系统中的地位》报告中认为[32],国防部范围内对自主性的错误认知正在阻碍其发展:① 需要明确的是所有的自主系统都在某种程度上受到人类操作员监督;② 国防部资助的自主等级研究成果对自主系统设计过程无益,它们太多的关注无人系统/计算机本身,而对人机协同实现功能和完成任务关注不够;③ 无人系统离散的自主等级划分以及在整个任务过程的不同阶段只能属于单一自主等级的划分方式不符合认知科学以及实战经验。该报告建议国防部放弃定义自主等级的尝试,并提出了一套从认知梯次(Cognitive Echelon)、任务时间线(Mission Timelines)、人-机系统权衡空间(Human-machine System Trade Spaces)3个方面认识自主系统的认知框架。

美国空军在其2015年发布的《自主地平线》[33]系列报告第1卷中从人与自主系统编队的角度出发提出了灵活自主性(Flexible Autonomy)的概念,指出灵活自主性应提供飞行员与系统之间顺利、简单和无缝的功能交接,报告将自主系统的功能分为任务执行、监视与信息融合、选项生成和决策4种,并按照功能的不同,认为自主等级(Level of Autonomy, LOA)分别处于完全手动、执行辅助、态势感知支持、决策辅助、监督控制和完全自主这6种不同层次。从之后业界的反应来看,这种自主等级划分方法影响有限。2017年,海军分析中心(CNA)发布《人工智能、机器人和蜂群》报告[20],赞同了2012年《自主性在国防部无人系统中的地位》报告中对自主等级的看法,同时也指出截至报告发布之日,对自主等级依然不存在具有操作意义的概念架构。

随着美军战略重心转移到大国竞争,以及以人工智能为代表的信息科学进入快速发展赋能期,美军对自主以及自主等级的认知进入了全新时期。美国空军在其2019版《自主地平线》[34]中并没有试图去定义自主性或人工智能,也没有去定义自主等级或智能等级的想法。而是认为,在以任务为中心的环境中,在与相互依赖的伙伴和下级合作时,更需要让自主系统知道:① 做什么(WHAT to do),即在任务目的/目标以及总体任务背景下做什么;② 不做什么(WHAT NOT to do),即限定了作战约束或交战规则;③ 可能的一些原因(WHYs),即规定了上级的目标或指挥官的意图;④ 但不(NOT)要求提供关于如何执行任务的细节(HOW),比如执行任务的方法或如何处理意外情况。该报告认为用WHAT, WHAT NOT, WHY and NOT-HOW的模型描述自主系统的交互能力和工作预期更为清晰,并且给出了针对特定军事组织和任务,描述自主行为核心的3组属性——熟练属性、信任原则和灵活原则,如图2所示。

图2 自主行为的3组属性Fig.2 Three groups of attributes of autonomous behavior

从上述一系列研究中可以得到一些有趣的发现:① 与人工智能的认知过程相仿,美军对自主性的认知越来越具有基于特定组织或任务而“合理地行动”的倾向;② 经过20多年的研究,美军依然没有建立起具有实操意义的自主等级划分方法,对自主性、人工智能、自主等级等概念的认知依然处于不断深化的过程当中,或许这就是当前认知深度的真实写照;③ 当前数据驱动的人工智能,促使美军在认识自主行为时把信任提升到了前所未有的高度;④ 对于在特定背景下特定组织中,执行特定任务的自主/智能系统而言,往往使用自主等级评估其系统特性,本文认为对智能等级的划分在所处的情境下没有必要。

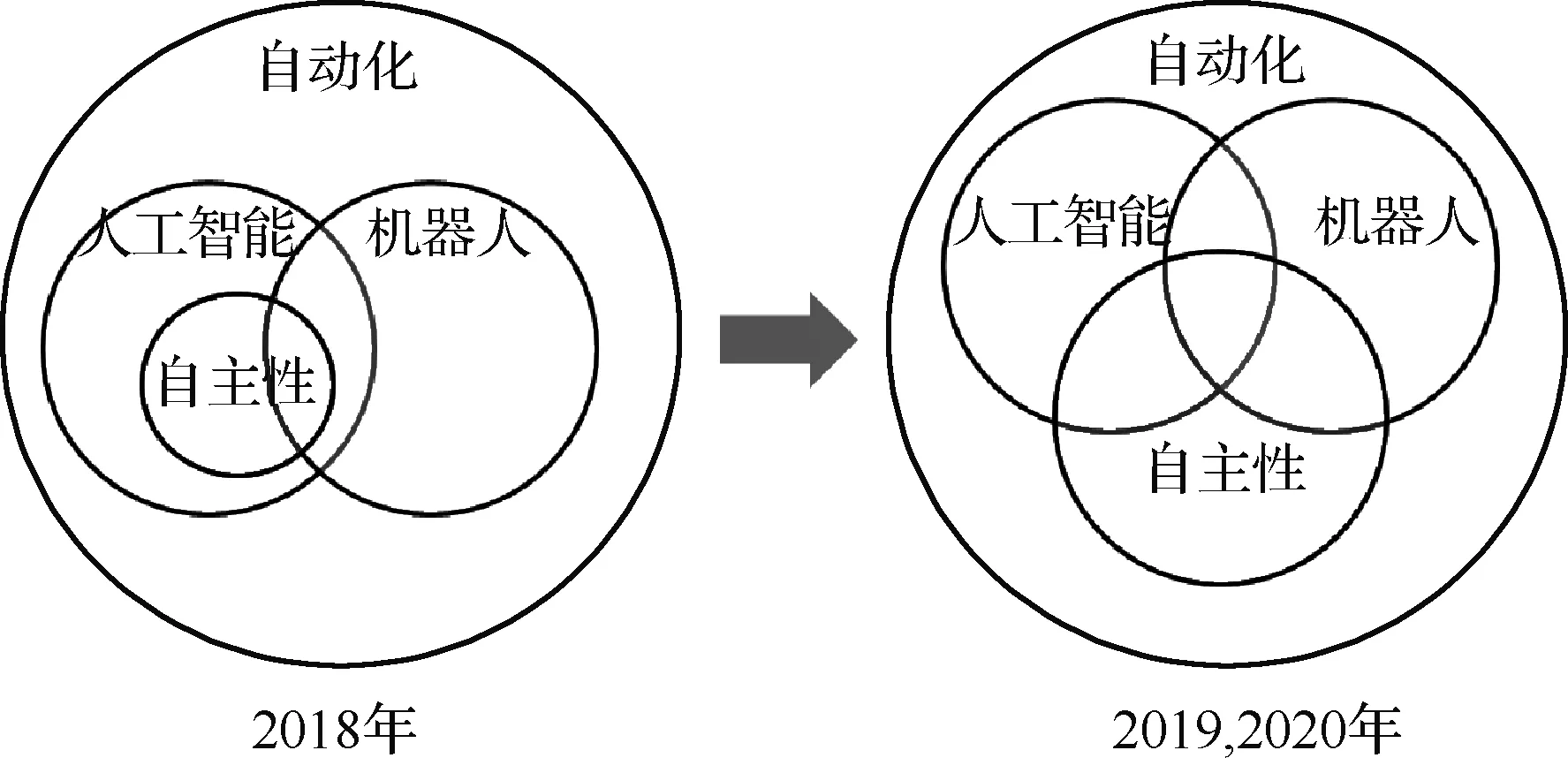

对于上述第4点认识,一些研究可以提供部分佐证。美国国防科学委员会在2016年的《自主性夏季研究》中指出,为特定目的而探索范围有限的自主能力已经可以为军事带来高价值的应用,因此不一定需要去解决那些通用人工智能所面临的长期问题[35]。Clough[25]在其提出ACL度量图的研究中指出,“我们想知道的是一架无人机完成任务的好坏,我们并不关心它有多智能,我们关心的是它完成了分配给它的任务。因此,对智能水平的衡量并不一定能告诉我们更多关于任务的情况”。美国国会研究服务局(CRS)在其3个版本的《人工智能与国家安全》[36-37,4]报告中对人工智能等相关概念的认识经历了如图3所示的变迁,不管是基于哪种认识,人工智能总会涵盖到为完成特定军事任务的而非必须具备内涵或特性。

图3 美国国会研究服务局对人工智能 相关概念认识的变迁Fig.3 Congressional Research Service’s perception of artificial intelligence and other related terms

3 航空人工智能应用

人工智能是关于知识的科学——也即怎样表示知识以及怎么获得知识并使用知识的科学。而航空科学与技术是以数学、物理学以及现代技术科学为基础,以飞行器设计、推进理论与工程、制造工程、人机与环境工程等专业为主干的高度综合的学科体系。人工智能与航空科学与技术2个体系庞杂、精妙无比的学科之间的交叉融合难免千丝万缕,纷繁复杂。本研究并不试图描绘航空人工智能应用的全貌或搭建航空人工智能的关键技术体系,而是从总体历史沿革、机载导弹、机载系统及可信4个方面分别围绕一些具有代表性的研究方向阐述航空人工智能应用的发展特点和态势。

3.1 总体历史沿革

在早期的人工智能研究投入中,政府和军方的投资占比较高,伴随着人工智能技术路线本身的发展演化,以技术制胜而著称的美国空军一直努力将最前沿的技术转化为战斗力。

20世纪80年代,随着计算机知识获取、推理能力的提升,第1个成功的商用专家系统R1[38]开始为其部署机构节省大量的运营成本。专家系统的发展热潮引起了DARPA的注意,并于1986年在其战略计算倡议(Strategic Computing Initiative)中发起了飞行员助手项目(Pilot’s Associate,PA)[39]。该项目旨在探索使用实时的、可协作的基于知识的智能系统来提升下一代战斗机的效能和生存能力,从而帮助单座战斗机飞行员在日益复杂的战场环境下驾驶性能更高的战斗机更好地完成任务。在该项目的设想中,智能系统包括态势评估系统、系统状态评估系统、战术规划系统、任务规划系统以及包括语音在内的人机交互系统共5个子系统。这一设想在当时的条件下对机载处理器的功耗、空间和实时计算能力等都提出了非凡的要求,并且当时对人机交互的研究也并不足够深入,不过在该项目的研究推动下,许多关键技术在以后的X-45无人机、美国陆军未来作战系统的人机接口设计等项目中得到了较好地继承和应用。

为解决未来攻击/侦查旋翼机飞行员面临的任务种类繁杂、信息负载过重的问题,美国陆军于1994年在借鉴飞行员助手等一系列项目研究成果的基础之上,启动了旋翼机飞行员助手项目(Rotorcraft Pilot’s Associate,RPA)[40],该项目还是当时世界上最大的智能用户界面项目(Intelligent User Interface,IUI)。RPA包括2个主要组成部分,第1部分基于先进任务装备组件(AMEP)提供包括先进传感器、通信系统和瞄准系统在内的复杂自动化系统,该部分在严格意义上并非是智能的;第2部分是包括数据融合、外部态势评估、内部状态评估、实时规划系统以及座舱信息管理系统5个模块在内的认知决策辅助系统(CDAS)。经过5年的研究和试验,该项目在红外和夜视图像增强的传感器集成方面以及路径规划方面取得成功,但在需求捕获、总体性能、意图推断等方面并不成功。

随着仿真和计算能力的不断增强,美国军方越来越多地在训练、分析和采办中使用仿真技术,为了在大型的、基于实体的仿真训练中提升个体的自主行为能力,Jones等[41]于1992年开始研发用于模仿固定翼飞行员在执行任务时的行为的软件系统,这一努力最后产生了基于规则的智能系统——TacAir-Soar。在1997年举行的战争综合演练场(STOW)仿真演习中,TacAir-Soar能够成功完成722种固定翼飞行任务中的95%。1998年,它还展示出了在仿真环境中与人类飞行员协作和对抗的能力。TacAir-Soar最大的创新在于为支持实时、复杂条件下的自主和智能行为集成了一系列能力,大大提升了美军大型仿真演练能力。

2016年,一个名为“阿尔法”(ALPHA)的模拟空战程序在模拟环境中以快于人类250倍的决策速度完胜美国空军退役上校基恩·李,这一标志性事件再次引起航空领域对人工智能的热切关注。ALPHA属于波音公司为AFRL开发的“仿真、集成和建模高级框架”(Advanced FrameworkforSimulation,Integrationand Modelling,AFSIM)项目的一部分,旨在于AFSIM环境中改善假想敌算法。ALPHA使用遗传模糊树的方法训练模糊推理系统[42],这种方法可以创建一系列有效的规则,并在复杂问题中产生确定性的控制指令。该程序只需在价值35美元的“树莓派”计算机上运行,对计算资源的要求并不高。

ALPHA的成功大大激发了美军的兴趣,伴随人工智能强劲的发展态势,DARPA于2019年启动“空战进化”(ACE)项目,旨在通过人工智能来处理视距内空中格斗问题,增强飞行员对战斗机自主性的信任,加速飞行员从平台操纵者向任务指挥官的转变。在2020年举办的“阿尔法”空战格斗比赛中,苍鹭系统公司的智能空战代理“隼”(Falco)凭借凌厉的攻势以5:0的成绩战胜了顶尖的F-16人类飞行员,标志着自主空战迎来深度强化学习时代。该方法在较短时间内,通过至少40亿次仿真训练,使Falco相当于拥有30年的F-16驾驶经验。接下来按照ACE项目计划,自主空战将由局部行为向全局行为演进,由仿真环境向全尺寸实体发展。图4为ACE项目的技术发展路线。

图4 ACE项目的技术发展路线Fig.4 Technology roadmap for Air Combat Evolution program

2020年,美空军第9侦察联队的一架U-2侦察机在试飞中对一种新型机载人工智能算法——ARTUμ进行了测试,在飞行过程中ARTUμ在使用U-2的机载雷达执行导弹搜索任务还是执行自卫任务的选择中做出了最终的决策,这在美军历史悠久的人工智能研发中尚属首次,在某种意义上标志着部分战术决策权让渡给人工智能成为现实可能。ARTUμ源自谷歌AlphaZero的升级版本MuZero,该成果于2019年11月才首次公开发表相关论文[43],对算法的开源工作可能更为滞后,美军对开源算法的改造和部署能力着实惊人。此外,得益于商业DevSecOps软件实践以及容器技术和容器云技术(如Kubernetes)的引入,ARTUμ的可移植性和部署能力得到极大提升,从在云端完成训练到实际任务部署只用了一个多月。

3.2 机载导弹

人工智能在航空领域的快速渗透融合,为机载导弹带来了新的发展契机。樊会涛和闫俊[44]指出,在机载导弹的第一次技术革命解决了精准攻击问题,第二次技术革命解决了“打远”问题之后,人工智能技术可能会通过极大增强机载导弹的自主能力而引发第三次技术革命。

在强博弈、高动态、强对抗的机载导弹领域,国内外在总体上正处于智能化的概念研究和单项技术攻关阶段[45]。一些综述研究[45-47]指出,未来机载导弹智能化发展的关键技术方向包括智能感知与识别技术、多源信息智能处理技术、智能自主规划与决策技术、多弹协同作战技术等,这些技术的应用将极大增强机载导弹的自主能力,从而影响未来的空战模式。一些更为聚焦的研究[48-49]将智能机载导弹的技术切入点定位到雷达导引头信息处理,并结合工程应用实际,识别出微弱特征目标智能检测技术、智能干扰对抗技术、智能杂波抑制技术等潜在应用突破方向。本节以强化学习为例,希望通过列举一些该技术在导弹领域的研究成果,展示该技术在航空领域较强的融合渗透能力。

Gaudet和Furfaro[50]于2012年首先提出一种在自动寻的阶段基于强化学习设计导弹制导律的方法,其研究表明该方法展现出了优于比例导航制导方法的性能。该研究旨在向导弹研究团体展示利用强化学习设计导弹导引控制器的可能性,Gaudet还指出强化学习也可以用于其他导弹问题,比如发射制导和高超声速再入阶段的控制等,强化学习的一个明显优势是控制器可以在虚拟环境下使用从高分辨率模拟器中学习得到的随机模型来进行优化。自Gaudet提出这种想法以来,利用强化学习设计导弹制导律的工作一直在不断的完善中[51-53]。

Lei等[54]基于行动者-评论家(Actor-Critic)深度强化学习方法就导弹智能突防开展研究,依托武器装备作战效能仿真系统WESS[55]搭建了导弹突防场景的训练环境,并且设计了一种多样本协同训练方法,从而构建了一套导弹智能突防训练系统框架。基于这套框架智能体未来能够根据多传感器数据判断战场态势并快速做出决策,辅助新战术的开发。

为克服飞行器气动设计费时费力,初始设计方案严重依赖专家领域知识,方案选型空间较小的不足,Yan等[56]设计了一种全新的方法首次将强化学习和迁移学习用于导弹的气动设计。在这种方法中,一种名为深度确定性策略梯度(DDPG)的算法被用来从半经验方法中在高精度连续空间中提炼设计规律,迁移学习则用来在CFD环境中加速学习过程。实验结果表明该方法在收敛速度和搜索能力上均展现出较好的性能从而为高效气动设计带来潜在价值。

3.3 机载系统

智能机载系统往往扮演着航空平台眼睛、耳朵和大脑的重要角色,随着人工智能、认知科学等的发展,越来越多的机载系统有望具备先验知识储备、学习、认知和自适应等能力,从而大大增强平台综合性能,降低飞行员任务负担,其中认知雷达就是一个很好的例子。

现代雷达系统不仅要面对电子干扰、低空/超低空突防、高速反辐射导弹、隐身飞机四大传统威胁,还要具有多工作模式、多目标处理、多任务执行的多功能特性[57]。快速动态变化的环境对现代雷达系统提出了高鲁棒性、高适应性和高性能的要求。基于这一现状,随着控制论、波形分集以及知识辅助的信号处理等方向的协同发展,在模仿和引入人类认知过程的机理后,认知雷达的概念逐渐形成,并在过去的十几年里快速发展。

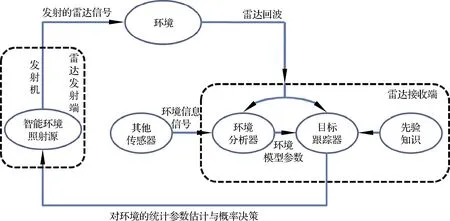

公认的认知雷达概念最早由加拿大学者Haykin[58]提出,他认为认知雷达包含3个基本要素:① 智能信号处理能力,这一能力通过雷达在与外界环境交互的过程中不断学习得来;② 从接收机到发射机的反馈,这是一个提升雷达自适应能力的促进过程;③ 对雷达回波信息的保留和记忆,不断更新雷达知识结构。金林将认知雷达的3个基本要素总结提炼为3个能力:① 雷达系统具备基于当前数据的自适应能力,即构建环境感知通道和处理反馈系统;② 雷达系统需要具备自适应调整能力,即具有可重构性;③ 雷达系统具备基于知识自适应能力,即实现信息分选、存储和更新[59]。图5为认知雷达的示意框图。

图5 认知雷达的示意框图Fig.5 Block diagram of cognitive radar

在Haykin提出认知雷达概念的论文中并没有出现“人工智能”一词,彼时Hinton刚刚在深度学习的基础理论方面获得突破[60],直到Krizhevsky等在2012年使用深度卷积神经网络在图像识别上得到质的飞跃后[61],人工智能才开始得到更多的关注,不过这并不影响认知雷达的研究投入和快速发展。

在过去十几年的研究工作中,该领域的研究人员重点围绕收发器体系架构与机理、雷达资源管理、目标探测、来波方位估计、目标跟踪、雷达网络和频谱共享等方面开展研究[62],广泛使用了贝叶斯决策理论、信息论、决策理论(包括模糊逻辑、基于规则的系统、元启发式算法和马尔科夫决策过程等)、动态规划、优化算法、博弈论等方法。

国外防务机构围绕认知雷达也开展了一系列研究项目。基于让雷达具备先验知识的认识,AFRL和DARPA先后启动了基于知识的雷达(KB-Radar)、知识辅助的传感器信号处理与专家推理(KASSPER)和知识辅助雷达(KA-Radar)项目。随着深度学习的大放异彩,DARPA又于2013年启动了雷达与通信共享频谱(SSPARC)和自适应雷达对抗(ARC)2个研究项目。其中ARC项目旨在开发短时间内对抗敌方新型、未知雷达威胁的能力,这是第一次将认知雷达的原理应用到了雷达电子战领域,标志着雷达电子战开始进入了认知雷达电子战时代。美国雷神公司于2019年在一篇题为《未来的智能化网络化雷达正在建造中》的官方新闻中宣称包括SPY-6在内的多型在研新一代雷达均采用了开放式架构和智能化技术,雷神公司认为“可以相互交谈、思考、学习和做出决策,更好地适应复杂世界需要”的智能化网络化多功能雷达将迅速发展。欧洲防务局于2020年宣布将启动“在复杂对抗电子战环境中应用的基于人工智能强化的雷达/通信系统”研究项目,旨在基于人工智能改善和提升复杂对抗环境中已列装的雷达和通信系统的性能。

尽管引入人类认知过程的方法为雷达能力提升带来了巨大前景,但完全实现这一设想仍然面临着一些重要挑战[62]。研发方面,认知雷达面临评估评价工具和试验测试方法相对不足的问题;采办方面,传统的采办流程中对非认知雷达性能的定义方法不再适用;知识方面,认知雷达仍需要评估和确认知识源可靠性的方法;法规方面,认知雷达的自适应特性仍受不可忽视的国家和国际法律约束。为了克服新技术的引入带来的全新问题,有必要以一种全新的视角来系统地看待人工智能航空应用需要解决的整体性问题——可信。

3.4 可信航空人工智能

在人工智能的应用潜力得到广泛认可的同时,大量研究也同时指出“可信”(Trustworthiness)是人工智能赋能行业应用的必要前提,其重要性和全新特质值得特别关注。而航空作为安全性要求极高的领域,可信的重要性尤为突出。

为解决人工智能在应用过程中存在的固有安全可信问题,DARPA在其下一代人工智能计划中启动了诸如可解释人工智能、确保人工智能对欺骗的鲁棒性、理解群体偏见、更少的标注数据学习等一系列基础研究项目。何积丰[63]指出,当前的人工智能主要基于机器学习理论,而非传统软件理论,人工智能的关键安全问题包括:第一,尽量避免人工智能的副作用;第二,避免奖励条件的错误解读;第三,分布转变的稳定性;第四,探索的安全性;第五,可拓展的监管。在2020年中国计算机学会召开的“第三代人工智能演进路径”论坛上,与会专家认为人工智能的可信需要解决边界性问题、可回溯问题和可验证问题等[64]。

随着航空领域人工智能应用探索的深入,可信也作为一个越来越重要的议题而得到关注。2015版《自主地平线》[33]指出具有学习能力的智能算法在自主系统中的使用将在可理解性(Understandability)、确认(Validation)和标准化(Standardization)等方面带来不同于以往的全新挑战。2016年美国国防科学委员会《自主性夏季研究》[35]报告将自主性面临的可信问题作为报告的第二章,指出人工智能应用技术的复兴在辅助解决诸多难题的同时也为可信问题带来了更多难点。2019版《自主地平线》[34]将熟练性属性、信任原则和灵活性原则作为自主系统的3个主要行为维度,指出设计自主系统时需要从一开始就考虑四方面的信任原则:① 认知一致性与透明;② 态势感知;③ 人 与多系统集成;④ 人与系统的协同与训练,这些信任原则对当前的人工智能方法提出了可解释、可回溯、透明等新要求。DARPA将其“空战进化”项目的主要目标之一定位在提升近距格斗的人机协同过程中飞行员对自主的信任。

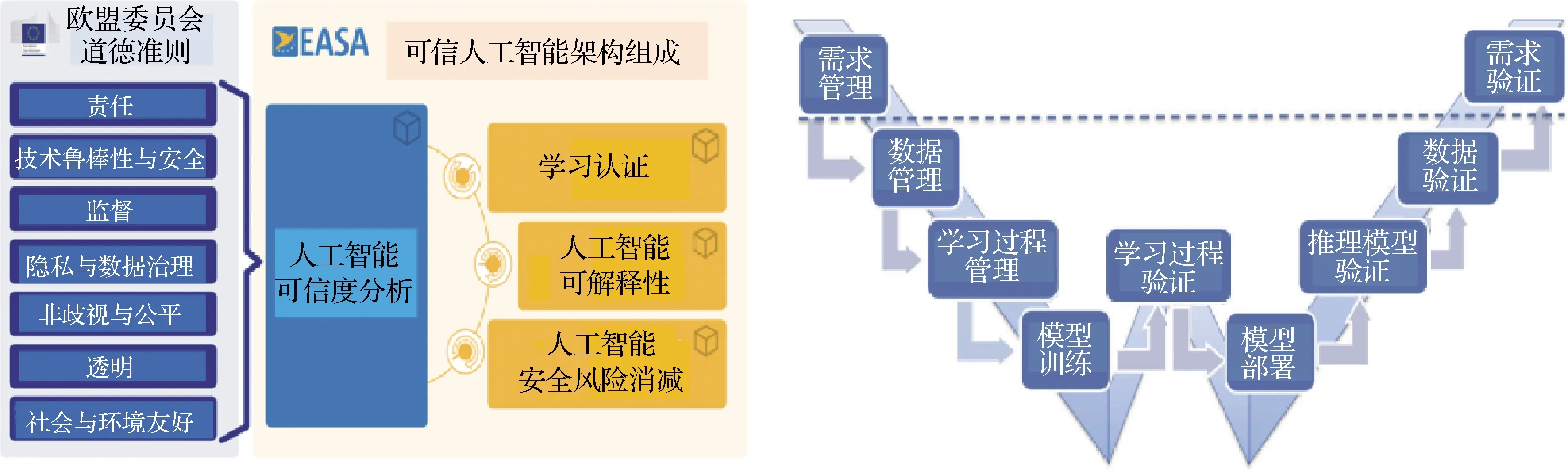

欧洲航空安全局(EASA)在其2020年发布的《人工智能路线图——以人为中心的航空人工智能方法》[65]中认为航空领域人工智能应用应优先重点解决安全可信问题,在欧盟委员会人工智能高级别专家小组(AI HLEG)制定的《人工智能道德准则》指导下[66],EASA根据人工智能的技术特点和航空领域的特色提出了由人工智能可信度分析(AI Trustworthiness Analysis)、学习认证(Learning Assurance)、可解释人工智能(AI Explainability)和人工智能安全风险消减(AI Safety Risk Mitigation)4部分组成的可信人工智能架构。随后,EASA又在其发布的《神经网络设计认证的概念(CoDANN)》[67]报告中提出了将神经网络用于安全攸关的航电系统设计时所必需考虑的安全准则,并针对新技术的引入带来的新问题提出了一种学习认证的W-型研发周期(W-shaped Development Cycle for Learning Assurance),用于作为传统研发认证框架的针对性改进。图6为EASA可信人工智能架构与W-型学习认证流程。

图6 EASA可信人工智能架构与W-型学习认证流程Fig.6 EASA trustworthy AI building-blocks and W-shaped learning assurance process

对于可信航空人工智能而言,其在总体上可能会面临的问题有:① 传统的研发认证框架不再适用于以机器学习为代表的人工智能技术;② 难以对预期的功能进行精确的综合描述;③ 对智能系统的行为难以做出预测和解释;④ 缺乏对鲁棒性的保证;⑤ 可能会出现非预期的结果或功能;⑥ 缺乏评估智能应用运行效能的标准化手段;⑦ 智能应用可能存在偏见和偏差;⑧ 框架和算法的复杂性;⑨ 自适应学习过程带来的复杂性;干扰、对抗带来的影响;小样本问题等。基于以上的叙述,建议将可信航空人工智能作为航空人工智能应用落地过程中一个重要的议题开展专门性研究。

4 结 论

本文围绕人工智能定义、智能等级划分以及人工智能航空应用等问题进行了初步探讨,得到一些见解:

1) 历史总是过高估计技术进步带来的短期效益,而严重低估其长期效益,工业界需辩证地看待人工智能的不确定性和确定性,做好预期管理,基于现有人工智能技术的特性,结合行业实践,探索现有技术应用落地的方式、形态和能力边界等。

2) 在针对特定任务的军事应用背景下,试图建立智能等级划分的努力很可能是不必要的。

3) 对人工智能和自主性的认知依然处于不断深化的进程当中,但它们都有着向“合理地行动”这一方向发展的态势。

4) 人工智能的爆发式发展从根本上得益于大数据可用性改善、计算机处理能力提高、机器学习方法改进这3个要素的融合汇聚,而人工智能赋能航空的速度和程度也在很大程度上受到航空领域内3个要素积累汇聚的制约,这在某种程度上为行业内顶层设计明确方向的同时,也表明人工智能赋能航空是一个渐进发展的过程,而非一蹴而就的技术应用。

5) 当前人工智能的技术特点决定了其特殊性,建议将可信航空人工智能作为一个重要的方向提前开展研究和攻关。