基于相似性融合的显著区域检测方法研究

蒋益锋 胡琳娜 刘冉冉

摘要:提出一种简单有效的基于相似性融合的显著区域检测方法:首先,通过最小方差量化降低颜色数,在将量化图像分割为超像素后,融合环绕性和边界连通性线索计算超像素的加权融合显著值,加权系数基于融合方法的显著相似性获得;同时,引入融合修正以增强前景区域;最后,通过显著性平滑和增强抑制图像背景,得到高亮且均匀的显著区域检测结果。为了验证所提出方法的有效性,在ASD、ECSSD、ImgSal三个公开数据集上与8个现有方法进行了性能比较,实验结果表明:所提出的融合机制可有效提升MaxF和S-measure等性能指标,并得到更为理想的检测结果。

关键词:显著性;显著区域检测;相似性;融合

中图分类号:TN911文献标识码:A文章编号:2095-7394(2021)06-0050-09

当人类在观察一个场景时,视觉系统可以在极短的时间内实现对场景内容的整体把握,并在某一时刻内快速理解场景中某一区域的细节信息。随着人眼在场景中的快速跳转,人类视觉系统将依据场景内容的重要程度从一个位置跳转到下一个位置,直到掌握整个场景的主要内容。在计算机视觉领域,显著性检测技术通常用于揭示场景内容的重要程度,其主要任务可分为人眼视点预测[1-4]和显著区域检测[5-7],从所采用的检测手段[6]来看,可分为快速的、自底向上的、数据驱动的显著性检测,以及慢速的、自顶向下的、任务驱动的显著性检测。目前,显著性检测技术已被广泛地应用于图像分割[8]、小目标检测[9]、目标跟踪[10]、视频压缩[11]以及视频摘要[12]等计算机视觉领域。

自底向上的检测方法采用图像的底层特征检测显著区域,此类方法一般利用中心-环绕的局部特征差异或特征的全局稀缺性来计算显著性。基于局部特征差异的方法通过从输入图像中抽取不同的视觉特征,并利用视觉特征的局部差异生成显著图;基于全局稀缺的方法通过在整个场景中抽取全局的稀缺特征,并利用这些稀缺特征作为显著区域的特征表示。除了通常所采用的颜色特征外,可用于显著性检测的图像特征还包括强度[13]、纹理[14]和频谱[1,3]等。

受早期感知视觉系统和选择性注意机制的启发,Itti等人[1]利用高斯差和中心-环绕对比预测人眼视点;Ma等人[15]采用模糊增长和局部对比分析计算显著性;Hou等人[2]提出了SR方法,该方法利用频域中的谱残差获得显著图;而Li等人[3]认为,SR方法只利用了相位信息,导致仅适用于特定场景,因此,采用低通高斯滤波核对图像的振幅谱进行卷积操作,实现显著性检测;Achanta等人[5]提出了FT方法,通过在Lab颜色空间中计算颜色特征距离获得显著区域。文献[4]提出了一种采用布尔图检测显著性的BMS方法,该方法认为,基于图像特征稀缺性的检测方法有时会忽略全局信息并将显著区域错误地定位到高对比的区域,因此基于格式塔心理学原理,采用环绕性线索检测显著性。由于在注意图的生成过程中,BMS方法去除了所有與图像边界连通的区域,因而会导致对贴边显著区域检测的失效。

本文同样关注快速的、自底向上的、数据驱动的显著区域检测方法。这里所提出的基于相似性融合的显著区域检测方法,在最小方差量化后对量化图像进行超像素分割;然后,在每个超像素上基于相似性对两种显著性结果进行融合并修正;最后,通过平滑和增强后处理得到显著区域检测结果。在三个数据集上的实验结果表明:所提出的方法具有较高的MaxF和S-measure指标,并能够得到高亮且均匀的显著区域检测结果。

1基于相似性融合的显著区域检测方法

1.1方法框架

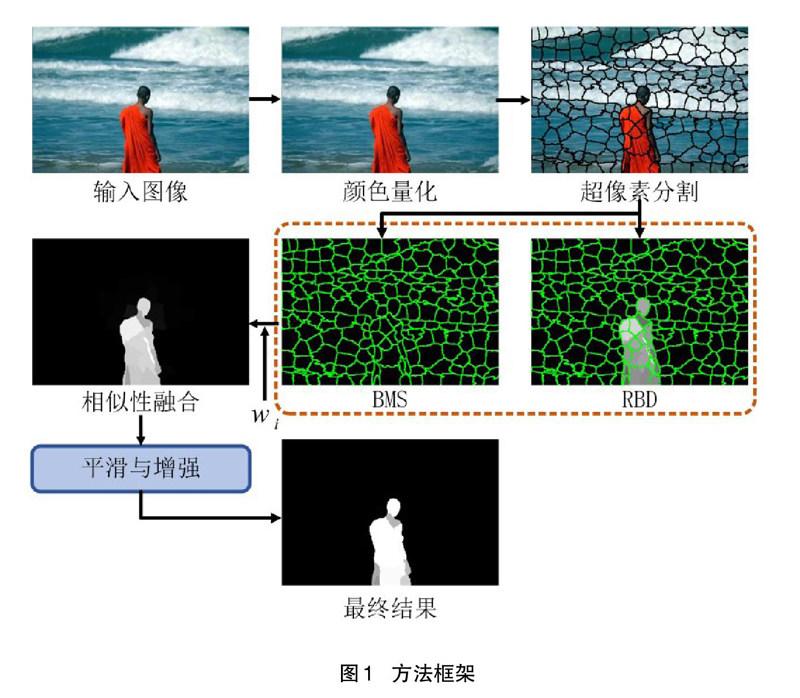

如图1所示为本文方法框架。首先,采用最小方差量化将输入图像包含的颜色数降为256 色,以得到较为紧致的超像素;然后,对量化图像进行超像素分割,并在每个超像素上引入加权系数,对基于BMS和RBD的显著相似性进行融合;在得到补偿修正后的超像素显著性后,进一步通过平滑和增强的两步后处理操作得到显著区域检测结果。

1.2颜色量化

为了降低颜色计算的复杂度并形成超像素的紧致性,本文首先将输入图像缩放到400像素宽度,并在RGB颜色空间中采用最小方差量化[16]将输入图像所包含的颜色数统一降低为256色;最小方差量化将RGB所属的立方体空间自适应地划分为不高于256个的大小不等的小立方体空间,其中分布较为稠密的颜色区域分配得到较大的立方体空间,分布较为稀疏的颜色区域分配得到较小的立方体空间;最后,将每个小立方体中包含的所有颜色统一映射为该立方体的中心颜色。虽然,颜色数的减少带来了一定的图像失真,但由于图像中的颜色分布在一定的局部区域内具有极高相似性,且人眼视觉很难感知到R、G、B通道上细微的值差异;因此,为合并图像中的颜色,并只保留少数颜色以表征图像整体分布带来可能。

如图2所示为最小方差量化图,图2(b)是对图2(a)采用最小方差量化得到的结果,图2(c)显示了量化前后的差异。其中,输入图像I包含了31 285种颜色。可以看到:虽然经过量化后颜色数只剩下256种,但人眼很难看出量化前后的显著差异,其差异图也仅在显著区域的轮廓处有较为明显的区别。如表1所示为平均绝对误差,将输入图像I和量化结果V归一化到[0,255]的整数区间,并在R、G、B三个颜色通道上计算得到两者的平均绝对误差(Mean Absolute Error,MAE):

其中:i∈{1,2,3}表示R、G、B三个颜色通道;W和H分别表示图像的宽度和高度;符号丨·丨表示绝对值计算。可以看到,最小方差量化前后得到的图像只具有较小的MAE。

1.3基于相似性的显著性融合

在得到经过量化的图像后,采用SLIC方法[17]对量化图像进行超像素分割,超像素个数的上限设置为200。考虑到BMS方法对与图像边界连通的显著区域检测的失效,本文采用基于边界连通性的RBD方法陷作为补充。在分别采用BMS和RBD方法计算得到显著图并归一化到[0,1]的浮点数区间后,对每个超像素进行逐像素的加权融合,第i个超像素内坐标(x,y)处像素的融合值为:

其中,符号丨·丨表示绝对值计算。

图3示例了上述融合过程:从第一行可以看到,对于相似的显著区域输出,融合结果可以对前景区域进一步增强;而第二行中,由于BMS导致的显著区域检测失效,得到了一幅近乎全黑的显著图,但经过补偿修正后的融合结果仍然有效保留并增强了实际的显著区域。

处理操作采用gamma值为2的非线性映射,将[0,0.5]区间统一映射到[0,1]区间,使得前景部分更趋向于1,而背景部分保持不变,以得到高亮的前景区域。如图4所示,为平滑与增强后处理图。图4(b)是对图3(a)进行两步后处理操作后得到的显著区域检测结果,两者的差异如图4(c)所示。可以看到:经过平滑和增强后处理,显著区域得到进一步的增强,同时,背景部分依然保持较低的显著值。最后,将后处理的结果缩放回原始图像大小并归一化,得到最终的显著区域检测结果。

2实验结果和分析

本节对文中提出方法与8个显著性检测方法在ASD[5,19]、ECSSD[7,20]和ImgSal[3,21]三个公开数据集上进行算法性能比较。检测方法为PCA[22]、GU[23]、GR[24]、GC[23]、COV[25]、BMS[4]、RPC[26]、TLLT[27],实验平台为1.80 GHz CPU、8 GB内存,算法采用MATLAB实现。

2.1评估数据集

ASD数据集也称为MSRA1000或MSRA1K数据集,是最为经典的显著区域检测评估数据集,共包含1 000张图像,并依据显著区域轮廓标注有二值真值图。其中,大部分图像只包含一个显著区域并位于图像的中心。ECSSD数据集增加了包括图像背景不平滑、显著区域与背景颜色接近、显著区域外轮廓模糊等更为复杂的图像结构,但其中大部分的显著区域依然聚集于图像中心。ImgSal数据集在构造时则更多地考虑了待检测图像本身的差异性,与ECSSD数据集相比,该数据集包括更多小尺寸的显著区域以及更为杂乱的背景;同时,显著区域要更为远离图像中心。

2.2评估方法

本文采用精确率-召回率(Precision-Recall,PR)和F度量(F-measure)来评估检测方法性能。当得到一幅输入图像的显著图S后,将其二值化为M,并通过比较M与人工标注图G,计算出精确率P和召回率R:

其中,符号丨·丨表示计算前景像素的数量。但无论是精确率或召回率都无法单独表征检测方法的性能,因此,采用两者的调和平均(即F度量)来评估性能,计算式为:

其中,参数β2参照文献[5]的建议设置为0.3。

本文采用一组[0,255]间的固定阈值对显著图进行序列化的二值分割,并对应计算256组精确率、召回率和F度量值。除了绘制PR曲线和F曲线来直观地展示各方法的檢测性能外,本文还计算了两个统计指标作为方法性能的定量评估。

(1)MaxF指标。序列化二值分割产生的256 组F度量的最大值,该指标表明了方法的最优检测性能。

(2)S-measure指标[28],即结构度量指标。该指标可以有效度量显著图与人工标注图之间面向区域和面向物体的结构相似性。

2.3评估结果和分析

如图5所示,是在三个数据集上的PR曲线比较。其中,黑色曲线代表本文所提出方法。可以看到:本文方法在大部分的召回率区间都具有较高的精确率,PR曲线有效覆盖了参与比较的其它方法。

如图6所示,是在三个数据集上的F曲线比较。其中,黑色曲线代表本文所提出方法。在F曲线图中,主要观测曲线的峰值即MaxF值,该值所在的x轴坐标即为最优分割阈值,而在最优分割阈值下得到的F度量值,表明了方法的最优检测性能。可以看到,在三个数据集上本文方法都具有最大MaxF峰值

表2和表3分别是在三个数据集上的MaxF和S-measure指标的统计比较。与参与比较的8个显著性检测方法相比,本文方法在三个数据集上都具有最高的指标值。从表2、表3的统计结果中可以看到:平均而言,三个数据集中,各检测方法在ImgSal数据集上均得到了较低的指标值,表明ImgSal相对于前两个数据集具有更大的检测难度;而在ASD数据集上,各检测方法普遍获得了最高的指标值,表明该数据集的检测难度较低。

如图7所示,为本文提出算法与8种检测方法得到的显著图的视觉比较。图7(a)是原始的输入图像,其中的上面三行、中间三行、下面三行图像,分别来自于ASD、ECSSD、ImgSal三个数据集;图7(b)是人工标注的真值图;图7(c)是本文算法的检测结果。可以看到:相较于其它8种方法,本文算法检测得到的显著图具有高亮且均匀的前景区域,同时,非显著区域的图像背景得到了有效抑制。

3结语

本文针对静态图像的显著区域检测问题,提出了一种基于显著相似性融合的检测方法:首先,采用最小方差量化降低颜色数,使得超像素分割得到的区域更为紧致;然后,针对基于环绕性线索对贴边显著区域的检测失效,引入基于边界连通性的方法进行加权融合,并在每个超像素上对融合结果进行修正,以增强前景区域;最后,通过显著性平滑和增强的后处理操作,得到高亮且均匀的显著区域并抑制了图像背景。在ASD、ECSSD、ImgSal三个数据集上的实验结果表明:所提出的方法在MaxF和S-measure两项指标上均优于流行的8种显著区域检测方法;同时,本文所提出的加权融合机制简单有效,也适用于对现有显著性方法的融合。下一步,将在更多数据集和现有检测方法上验证这一融合机制,并针对具有复杂背景以及背景与显著区域具有高度颜色相似等图像,进一步改进并提升该融合方法的正确性和有效性。

参考文献:

[1]张晴,李云.基于马尔科夫链和物体先验的显著物体检测[J].计算机工程与设计,2019,40(4):1038-1045.

[2]李楚为,张志龙,杨卫平.结合布尔图和灰度稀缺性的小目标显著性检测[J].中国图象图形学报,2020,25(2):267-281.

[3]LI J,LEVINE M D,AN X J,et al. Visual saliency based on scale-space analysis in the frequency domain[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2013,35(4):996-1010.

[4] ZHANG J,SCLAROFF S. Saliency detection:a boolean map approach[C]. Proceedings of the IEEE International Conference on Computer Vision,2013:153-160.

[5] ACHANTA R,HEMAMI S,EATRADA F. Frequency- tuned salient region detection[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2009:1597-1604.

[6]王豪聪,赵晓叶,彭力.基于前景增强与背景抑制的显著性物体检测[J].计算机工程与科学,2018,40(6):1119- 1124.

[7]YAN Q,XU L,SHI J,et al. Hierarchical saliency detection [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2013:1155-1162.

[8] QIN C C,ZHANG G P,ZHOU Y C,et al. Integration of the saliency-based seed extraction and random walks for image segmentation[J]. Neurocomputing,2014,129:378-391,.

[9] LOU J,ZHU W,WANG H,et al. Small target detection combining regional stability and saliency in a color image [J]. Multimedia Tools and Applications,2017,76(13):14781-14798.

[10] BORJI A,FRINTROPS,SIHITE D N,et al. Adaptive object tracking by learning background context[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2012:23-30.

[11] GUO C L,ZHANG L M. A novel multiresolution spatiotemporal saliency detection model and its applications in image and video compression[J]. IEEE Transactions on Image Processing,2010,19(1):185-198.

[12] LEE Y J,GHOSH J,GRAUMAN K. Discovering important people and objects for egocentric video summarization[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2012:1346-1353.

[13] ZHAI Y,SHAH M. Visual attention detection in video sequences using spatiotemporal cues[C].Proceedings of the ACM International Conference on Multimedia,2006:815- 824.

[14] SCHARFENBERGER C,WONG A,CLAUSI D A. Structure- guided statistical textural distinctiveness for salient region detection in natural images[J]. IEEE Transactions on Image Processing,2015,24(1):457-470.

[15]張绳富,董蓉,李勃.基于颜色先验的显著性物体检测[J].现代制造工程,2019(4):122-128.

[16] HECKBERT P. Color image quantization for frame buffer display[J]. Comput Graph,1982,16(3):297-307.

[17] ACHANTA R,SHAJI A,SMITH K,et al. SLIC superpixels compared to state- of- the- art superpixel methods[J]. IEEE Transactions on Pattern Analysis and Machine Intel- ligence,2012,34(11):2274-2282.

[18] ZHU W,LIANG S,WEI Y,et al. Saliency optimization from robust background detection[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recog- nition,2014:2814-2821.

[19] LIU T,SUN J,ZHENG N N,et al. Learning to detect a salient object[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2007:1-8.

[20] SHI J P,YAN Q,XU L,et al. Hierarchical image saliency detection on extended CSSD[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2016,38(4):717-729.

[21] LI J,LEVINE M D,AN X,et al. Saliency detection based on frequency and spatial domain analysis[C]. Proceedings of the British Machine Vision Conference ,2011:1-11.

[22] MARGOLIN R,TAL A,ZELNIK M. What makes a patch distinct?[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2013:1139-1146.

[23] CHENG M M,WARRELL J,LIN W Y,et al. Efficient salient region detection with soft image abstraction [C]. Proceedings of the IEEE International Conference on Computer Vision,2013:1529-1536.

[24] YANG C,ZHANG L,LU H. Graph- regularized saliency detection with convex- hull- based center prior[J].IEEE Signal Processing Letters,2013,20(7):637-640.

[25] ERDEM E,ERDEM A. Visual saliency estimation by non- linearly integrating features using region covariances [J] Journal of Vision ,2013,13(4):1-20.

[26] LOU J,REN M W,WANG H. Regional principal color based saliency detection[J]. PlosOne,2014,9(11):1-13.

[27] GONG C,TAO D,LIU W,et al. Saliency propagation from simple to difficult[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2015:2531- 2539.

[28] FAN D P,CHENG M M,LIU Y,et al. Structure-measure:a new way to evaluate foreground maps[C]. Proceedings of the IEEE International Conference on Computer Vision,2017:4548-4557.

Research on Significant Region Detection Based on Similarity Fusion

JIANG Yifeng1,HU Linna2,LIU Ranran3

(1. Information Center,Jiangsu University of Technology,Changzhou 213001,China;2. Zijin College,Nanjing University of Science & Technology,Nanjing 210046,China;3. School of Automotive and Transportation Engineering,Jiangsu University of Technology,Changzhou 213001,China)

Abstract:In this paper,a simple and effective salient region detection method based on the similarity fusion is presented. Firstly,the color number is reduced by minimum variance quantization. After the quantized image is segmented into superpixels,the weighted fusion saliency value of superpixels is calculated by fusing the surrounding and boundary connectivity clues,and the weighted coefficients are obtained based on the significant similarity of the fusion method. In addition,a fusion correction is introduced to enhance the foreground area. Finally,high- bright and uniform detection results of salient regions are obtained by smoothing and enhancing the image background. In order to verify the effectiveness of the proposed method,eight existing methods are compared on ASD,ECSSD and ImgSal public datasets. The experimental results show that the proposed fusion mechanism can effectively improve MaxF and S-measure performance indicators,and obtain more ideal detection results.

Key words:saliency;salient region detection;similarity;fusion