边缘计算下的联邦学习应用研究

翟孟冬 陈宇 林榕健 李军

摘要:随着移动设备自身存储和计算能力的提升,越来越多移动设备在本地进行数据处理,如传感器,智能穿戴设备和车载应用等。当前机器学习技术在计算机视觉,自然语言处理,模式识别等领域取得了巨大成功,然而当前机器学习方法是中心化的,数据中心或者云服务器能够对数据进行访问。联邦学习作为新型的分布式机器学习范式,借助设备本身的存储和计算能力,能够在数据不出本地的情况下进行机器学习中的模型共建,从而保护数据隐私,从而有效解决数据孤岛问题。邊缘计算能够在靠近设备端提供计算,存储和网络资源,为高带宽低时延的应用提供基础。在联邦学习训练中,设备数量增加,设备网络情况复杂多变等均为联邦学习中的联合训练上带来了巨大挑战,如设备选择,网络通信开销大等状况。本文首先介绍了边缘计算的基础,以及联邦学习的联合训练流程,通过对联邦学习和边缘计算的融合应用进行分析研究,进一步我们对基于边缘计算的联邦学习做了分析,最后我们对当前的主要挑战以及未来的研究方向做了总结。

关键词:边缘计算;联邦学习;数据隐私

中图分类号:G424 文献标识码:A

文章编号:1009-3044(2021)07-0001-04

1背景介绍

1.1 边缘计算概述

目前世界上有70亿物联网设备[1],设备收集的数据在云数据中心之外[2]。边缘计算在靠近数据源的一侧,可以为设备的数据处理其自身的网络、计算和储资源[3],在多个设备联合进行机器学习训练时可以将模型靠近数据端[4],在智能家居、智能医疗和智慧城市等领域具有广阔的应用前景[5-6]。典型的边缘计算应用包括端设备,边缘节点,云数据中心[7]。由于数据不必上传至数据中心,对主干网络依赖程度降低,边缘计算具有高带宽低时延的特点[8]。

1.2 联邦学习概述

传统的以云端为中心的机器学习方法中,从移动设备收集到的数据,比如文本、音频、视频等数据资源需要全部上传到云端,由云端的数据中心对数据进行训练。为了保证数据拥有方的隐私问题,联邦学习应运而生[9]。联邦学习允许移动设备在本地利用本地数据对模型进行训练,训练结束后,移动设备不需要发送给云端发送涉及设备隐私的敏感数据,而只需上传更新后的模型,比如模型中参数,联邦学习的中心服务器再对收集到的模型数据进行聚合,这个过程持续直到联合训练模型达到预期的准确率。因此联邦学习可以和边缘计算充分结合。联邦学习包括横向联邦学习和纵向联邦学习,本文关注模型的联合训练[10]。

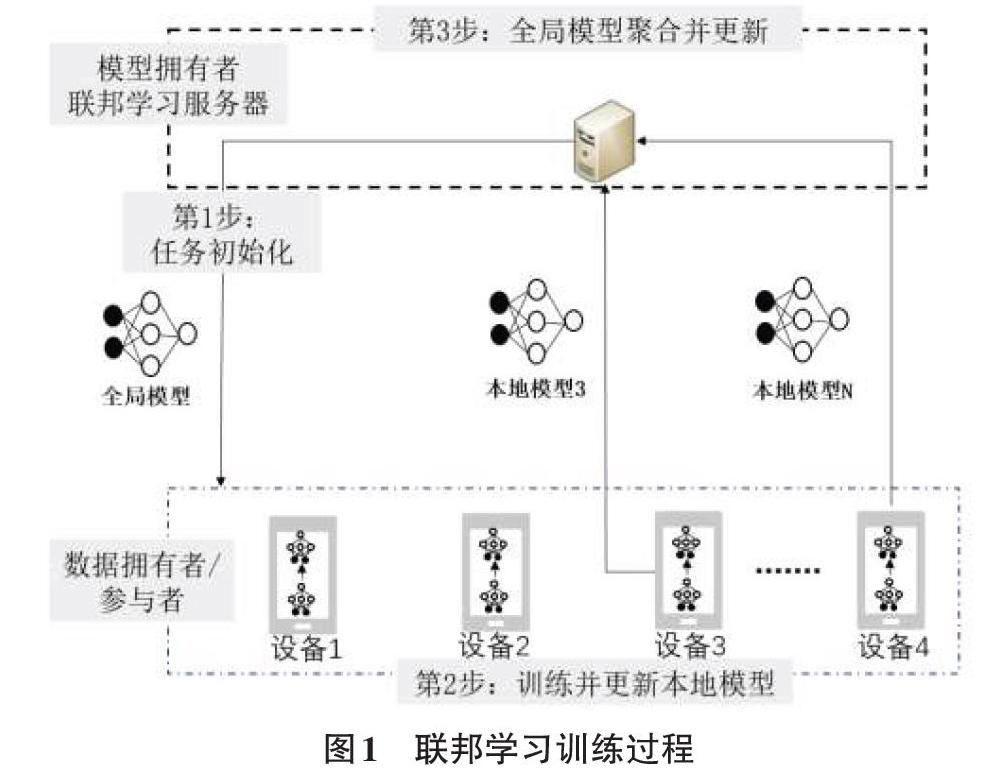

总体来说,联邦学习训练过程包括三步。如图1所示:

第一步,任务初始化。中心服务器选择训练任务,目标应用和数据要求。中心服务器指定全局模型和训练过程的超参数,如学习率,然后将初始全局模型[w0G]广播给参与方。

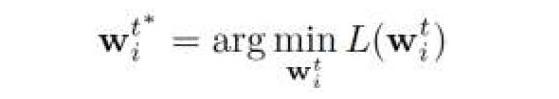

第二步,本地模型训练并更新参数。基于全局模型[wtG],t指当前迭代次数,每个参与方各自使用本地数据在本地进行训练,并更新本地参数[wti]。第i个参与方在第t次迭代的主要目标是找到更优的参数[wti]来最小化损失函数[L(wti)],即:

更新的本地模型随后发至中心服务器。

第三步,全局模型聚合和更新。中心服务器聚合来自所有参与方的模型参数,然后将更新的全局模型参数[wt+1G]发送至数据拥有者(参与方)。

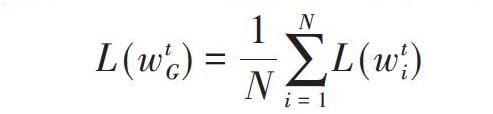

中心服务器的目标是最小化全局损失函数,即:

重复第二步和第三步直到全局损失函数收敛或准确率达到要求。联邦学习的训练过程可以处理不同的机器学习任务如支持向量机[11],神经网络,线性回归[12]等。

1.3 研究现状总结

当前大部分关于边缘计算和联邦学习的研究过于独立,如在边缘计算中讨论优化缓存和计算卸载策略优化时未能考虑数据隐私问题[3,13-17]。在联邦学习的研究中,针对多个参与方数据分布差异考虑了不同的联邦学习架构[18],针对无线通信和蜂窝网络的架构亦有研究[19-20],但都未能在联邦学习中考虑到边缘计算网络。本文针对基于边缘计算的联邦学习的联合研究,并讨论了联邦学习在边缘计算环境下协同训练的挑战和问题,能够进一步利用边缘计算的架构对联邦学习进行优化。

2 基于边缘计算的联邦学习研究

根据联邦学习训练过程,在联邦学习中有多个挑战,如多个参与方的数据分布不同,主要是非独立同分布的数据造成训练准确度的降低[21]-[23],分布式训练的收敛性等[21][24][25],此外,相比于分布式机器学习,还有以下特征:1)缓慢且不稳定的通信链接;2)异构的设备(参与方);3)隐私和安全问题,针对这三个特征,分别从三个方面展开研究:1)通信开销;2)资源选择;3)隐私和安全。本小节针对以上问题对相关研究进行调研并讨论解决方案。

2.1 通信成本

联邦学习中,在系统达到目标的准确率之前,移动设备和联邦学习服务器之间需要进行许多轮的通信,也就是移动设备需要将每一轮训练好的模型上传到云端。对于一些复杂的深度学习模型,比如卷积神经网络,每一个模型可能都包含几百万个参数[26],如果频繁地进行通信,会造成较大的通信开销并成为模型训练的瓶颈。因此,如何减小联邦学习的通信成本成为一个至关重要的问题。常见的减小通信成本的方法有:(1)增加边缘侧的计算量。边缘侧频繁地对模型进行上传是造成网络通信成本高的主要原因,因此需要减小边缘设备上传模型的次数,考虑到移动设备的处理器越来越强大且训练模型的数据集相对较小,因此可以在移动设备本地对模型进行更多的训练,之后再将训练好的模型上传到联邦学习服务器。由于经过更多计算之后的模型效果更好,因此边缘设备需要迭代的次数也就更少,通过减小上传频率减少了通信成本,这种方法的代价就是边缘侧的移动设备需要进行更多的计算[27-29];(2)压缩模型。分布式机器学习中经常采用压缩模型的方法来减小通信成本。通过稀疏化、量子化和二次抽样等方法可以将模型压缩为一个更紧凑的模型,从而减小了上传到云端的模型的大小。由于压缩模型可能会引入噪声,因此使用这种方法需要注意在减小模型大小的同时保证模型训练的质量[30-32];(3)基于重要性的更新。为了减少上传模型的大小,除了压缩模型,还可以对上传模型的参数进行过滤,可以有选择性地只上传部分较为重要的参数,这种方法可以大大减小每一轮的通信开销。实际上进行有选择性的模型上传获得的全局模型要比上传全部模型参数获得的全局模型的性能更佳[28,33,34]。

2.2 资源分配

联邦学习中,含有很多不同的设备,这些设备含有不同质量的数据集、电量、参与计算意愿程度。对于给定的不同设备和资源约束,比如设备电量和通信带宽,需要优化资源分配以达到最高的训练效率。对于联邦学习中的资源分配,主要考虑以下几个问题。

选择参与者。选择参与者指的是选择在一轮训练过程中对于参与设备的选择。通常,在一轮联邦学习训练过程中,联邦学习服务器会随机选择一些参与者进行训练,这些被选中的设备训练结束后再将各自的模型参数上传到云端,云端的联邦学习服务器再对模型参数进行加权聚合[27]。这种模式下每轮训练的时间就受到训练时间最长的设备的影响[35],因此亟需研究新的选择参与者的协议,来解决联邦学习训练时的瓶颈问题。

适应性聚合。联邦学习需要移动设备上传模型参数到联邦学习服务器进行聚合。传统的全局聚合的方法是同步的,即在一个固定的时间间隔内所有的设备都在本地进行一定轮数的训练,之后再聚合。对于给定的资源限制,需要研究如何通过调整聚合为适应性聚合,即能够根据资源限制和训练效率动态调整聚合时间来最大化训练效率[35]。

激励机制。在实际的联邦学习过程中,由于本地训练比较消耗计算和网络资源等原因,许多的设备不愿意参与模型训练。因此,联邦学习服务器和参与者之间就形成了信息不对称,因为参与者更了解它们的计算资源和数据质量。因此,需要研究出一套对于参与者的激励机制来激励参与者进行训练并减小由于信息不对称带来的潜在不良影响,研究者试图通过定制价格机制来促进设备参与训练[36],也有研究人員将模型拥有方和数据拥有方建模成Stackberg博弈模型[37]。

2.3 隐私和安全问题

联邦学习的重要的出发点就是要保护参与方的隐私,即参与方只需要分享训练模型必需的参数而不是分享设备的数据。然而,有研究显示如果联邦学习中存在恶意的参与者或者服务器,会引起很大的隐私和安全问题[38]。甚至可能因为存在恶意的参与者或服务器而导致最终获得的全局模型被破坏[39-40],也可能使得参与联邦学习的设备的隐私泄漏。

对于隐私泄漏问题,尽管联邦学习不要求参与协同训练的移动设备上传除了模型参数以外的数据,一个恶意的参与者还是可以从其他参与者分享的模型中推断出来一些敏感信息,比如性别、职业、位置等。研究者[38,41]展示了在FaceScrub数据集上训练一个二元的性别分类器任务时,仅仅通过分析其他参与者分享的模型就可以推断出其他参与者的输入数据信息,准确率高达90%。

对于安全问题,在联邦学习中,为了提高模型预测的准确率,参与者在本地进行训练并分享训练后的模型参数,然而,这个过程可能遭受多种攻击。比如数据污染[42]和模型污染[43][44],即一个恶意的参与者可以向云端的联邦学习服务器故意发送错误的参数来破坏模型参数的全局聚合过程。这样得到的全局模型无法进行正常的更新,整个学习系统就被破坏了。研究者通过多种方式来保护数据或模型,如基于区块链的联邦学习架构BlockFL[45]。

3 基于边缘计算的联邦学习挑战与趋势

联邦学习作为一种新技术,由于多用户参与,联邦学习本身的分布式和本地计算特征,在大规模部署联邦学习方面仍存在新的研究方向挑战。

3.1 用户离线

现有的一些为解决训练瓶颈和资源异构性提出的算法,例如合理选择参与者[46],资源分配算法[47],都是建立在假设参与用户始终在线可用。然而,在实际的训练过程中,参与训练的用户可能会正常运行执行训练任务,也有可能因为网络原因,电量不足等各种各样的情况,从联邦学习系统中登出。参与训练的用户的离线,会显著的降低现有联邦学习系统的性能,例如准确率和收敛速度。为了解决这潜在的用户离线情况,未来的联邦学习算法需要对网络中参与的用户丢失具有鲁棒性,并且可以解决只有少数用户参与训练的时候模型的准确性。一种可能的解决方案是,联邦学习的发起者为参与的用户提供免费的专用链接,例如可以使用蜂窝链接,以此来避免参与者退出。

3.2 隐私问题

尽管模型的训练是在本地进行,本地设备与联邦学习服务器进行交换的只有模型的训练参数,但是一些论文中发现,在训练的过程中的模型参数仍可能向对方或者第三方提供一些敏感性消息[48-49]。针对该问题,现有提出一些类似差分隐私、协作训练的安全解决方案,但在另外保护隐私的情况下,会牺牲联邦学习系统的性能,影响模型训练结果的准确性。在联邦学习系统设计时,合理的进行隐私保证和系统性能保证之间的权衡是一个关键问题。

3.3 无标签数据

现有的一些联邦学习训练的方法都是针对监督学习任务提出的,即假设联邦网络中所有的数据都已经被标记。然而在实际的训练过程中,网络中生成的数据很可能没有标签或者具有错误标签[50]。对于这些数据如果不进行特殊处理,将对服务器寻找合适数据进行模型训练带来巨大挑战。对于系统中未进行标记或标记错误的数据的情形,主要考验联邦学习系统的可伸缩性和异构性。一种可行的解决方案是使移动设备能够相互学习“标记数据”来构造标记数据。同时,还可以使用半监督学习技术克服标签数据不足的问题。

3.4 移动设备之间干扰

现有的资源分配方法,是根据参与联邦学习用户设备的资源状态来进行用户选择[51-52]。实际训练过程中,这些参与训练的用户设备在地理上可能是彼此靠近的,例如,可能参与训练的两个用户在同一个小区。在这种情况下,当用户设备进行参数更新提供给联邦学习服务器时,会产生干扰问题。对于干扰问题,可以通过将信道分配策略与资源分配方法结合在一起进行解决。现有的一些研究提出了多路访问方案和无线计算,但是对于该方法的扩展性还需要进一步深入研究。另外对于该方法是否能够支持多个用户训练的联合也需要进一步研究。

3.5 異步联邦学习

现有的联邦学习系统,大多是同步联邦学习,每轮训练的收敛速度由运行最慢的设备所决定。在一些论文中提出了异步联邦学习的方法来解决训练速度与最慢设备的依赖[53-54]。异步联邦学习同时还可以允许参与训练的用户中途退出,或者在训练过程中允许新用户加入,这更符合现实环境下的联邦学习,参与联邦学习训练的用户可能会因为网络问题或者电量问题中途退出或加入。而异步联邦学习的提出可以更好地解决联邦学习伸缩性问题。由于要保证收敛性,同步联邦学习仍是现在最常用的方法,鉴于异步联邦学习的众多优点,未来还应探索和设计异步联邦学习算法。

3.6 通信安全

由于联邦学习参与用户地理上的分布性,采用无线介质进行信息传输,由于无线介质的暴露特性,联邦学习很容易受到通信安全方面的影响,例如会存在干扰攻击和分布式拒绝服务攻击[55]。对于干扰攻击,攻击者可以发射高功率的射频干扰信号,破坏或干扰移动设备与服务器之间的通信。这种干扰会使模型上传或下载模型参数出错,从而降低联邦学习系统的性能,例如准确性。针对这种干扰攻击,可以采用Anti-jamming之类的抗干扰方案,例如,在不同频率发送一份模型更新参数的副本。

4 结束语

本文对对边缘计算和联邦学习进行了简单介绍,并且对联邦学习在边缘计算的环境下的研究做了综合的探讨,当前研究存在的问题以及相应的解决方案进行了简述和总结,并进一步探讨了边缘环境下联邦学习的挑战和研究趋势。

参考文献:

[1] K. L. Lueth.State of the iot 2018: Number of iot devices now at 7b - market accelerating, IOT Analytics, 2018.

[2] Cisco.Cisco global cloud index: Forecast and methodology, 2016-2021 white paper.

[3] Mao Y Y,You C S,Zhang J,etal.A survey on mobile edge computing:the communication perspective[J].IEEE Communications Surveys & Tutorials,2017,19(4):2322-2358.

[4] Shi W S,Cao J,Zhang Q,etal.Edge computing:vision and challenges[J].IEEE Internet of Things Journal,2016,3(5):637-646.

[5] 赵明.边缘计算技术及应用综述[J].计算机科学,2020,47(S1),47:268-272,282.

[6] 陆洋,李平,周庆华.智慧城市的基本单元:边缘服务器的功能定位及其深度应用[J].科技导报,2020,38(09),38:55-61.

[7] Wang X F,Han Y W,Leung V C M,et al.Convergence of edge computing and deep learning:a comprehensive survey[J].IEEE Communications Surveys & Tutorials,2020,22(2):869-904.

[8] CaproluM,Di Pietro R,Lombardi F,etal.Edge computing perspectives:architectures,technologies,and open security issues[C]//2019 IEEE International Conference on Edge Computing (EDGE).July8-13,2019,Milan,Italy.IEEE,2019:116-123.

[9] McMahan H B,Moore E,Ramage D,et al.Communication-efficient learning of deep networks from decentralized data[EB/OL].2016:arXiv:1602.05629[cs.LG].https://arxiv.org/abs/1602.05629

[10] Yang Q,Liu Y,Chen T J,et al.Federated machine learning[J].ACM Transactions on Intelligent Systems and Technology,2019,10(2):1-19.

[11] Burges C J C.A tutorial on support vector machines for pattern recognition[J].Data Mining and Knowledge Discovery,1998,2(2):121-167.

[12] ZiegelER,Myers R.Classical and modern regression with applications[J].Technometrics,1991,33(2):248.

[13] Mach P,Becvar Z.Mobile edge computing:a survey on architecture and computation offloading[J].IEEE Communications Surveys & Tutorials,2017,19(3):1628-1656.

[14] Kumar K,Liu J B,Lu Y H,et al.A survey of computation offloading for mobile systems[J].Mobile Networks and Applications,2013,18(1):129-140.

[15] Abbas N,Zhang Y,TaherkordiA,etal.Mobile edge computing:asurvey[J].IEEE Internet of Things Journal,2018,5(1):450-465.

[16] Wang S,Zhang X,Zhang Y,et al.A survey on mobile edge networks:convergence of computing,caching and communications[J].IEEE Access,2017,5:6757-6779.

[17] Yao J J,Han T,Ansari N.On mobile edge caching[J].IEEE Communications Surveys & Tutorials,2019,21(3):2525-2553.

[18] Yang Q,Liu Y,Chen T J,et al.Federated machine learning:concept and applications[EB/OL].2019:arXiv:1902.04885[cs.AI].https://arxiv.org/abs/1902.04885

[19] Niknam S,Dhillon H S,Reed J H.Federated learning for wireless communications:motivation,opportunities,and challenges[J].IEEE Communications Magazine,2020,58(6):46-51.

[20] Li T,Sahu A K,Talwalkar A,et al.Federated learning:challenges,methods,and future directions[J].IEEE Signal Processing Magazine,2020,37(3):50-60.

[21] Zhao Y,Li M,Lai L Z,et al.Federated learning with non-IID data[EB/OL].2018

[22] Krizhevsky A, Hinton G. Learning multiple layers of features from tiny images[J]. 2009.

[23] Rubner Y,Tomasi C,Guibas L J.The earth mover's distance as a metric for image retrieval[J].International Journal of Computer Vision,2000,40(2):99-121.

[24] Li X, Huang K, Yang W, et al. On the convergence of fedavg on non-iid data[J]. arXiv preprint arXiv:1907.02189, 2019.

[25] Huang L,Yin Y F,Fu Z,et al.LoAdaBoost:loss-based AdaBoost federated machine learning on medical data[EB/OL].2018

[26] He K M,Zhang X Y,Ren S Q,et al.Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).June27-30,2016,LasVegas,NV,USA.IEEE,2016:770-778.

[27] McMahan H B,Moore E,Ramage D,et al.Communication-efficient learning of deep networks from decentralized data[EB/OL].2016:arXiv:1602.05629[cs.LG].https://arxiv.org/abs/1602.05629

[28] Liu Y,Kang Y,Zhang X W,et al.A communication efficient vertical federated learning framework[EB/OL].2019

[29] Yao X,Huang C F,Sun L F.Two-stream federated learning:reduce the communication costs[C]//2018 IEEE Visual Communications and Image Processing (VCIP).December9-12,2018,Taichung,Taiwan,China.IEEE,2018:1-4.

[30] Kone?n? J,McMahan H B,Yu F X,et al.Federated learning:strategies for improving communication efficiency[EB/OL].2016

[31] Caldas S,Kone?ny J,McMahan H B,et al.Expanding the reach of federated learning by reducing client resource requirements[EB/OL].2018

[32] Hochreiter S,Schmidhuber J.Long short-term memory[J].Neural Computation,1997,9(8):1735-1780.

[33] Tao Z, Li Q. esgd: Communication efficient distributed deep learning on the edge[C]//{USENIX} Workshop on Hot Topics in Edge Computing (HotEdge 18),2018.

[34] Strom N. Scalable distributed DNN training using commodity GPU cloud computing[C]//Sixteenth Annual Conference of the International Speech Communication Association, 2015.

[35] Sprague M R,Jalalirad A,Scavuzzo M,et al.Asynchronous federated learning for geospatial applications[M]//CommunicationsinComputer and InformationScience.Cham:Springer InternationalPublishing,2019:21-28.

[36] Feng S H,Niyato D,Wang P,et al.Joint service pricing and cooperative relay communication for federated learning[C]//2019 International Conference on Internet of Things (iThings) and IEEE Green Computing and Communications (GreenCom) and IEEE Cyber,Physical and Social Computing (CPSCom) and IEEE Smart Data (SmartData).July14-17,2019,Atlanta,GA,USA.IEEE,2019:815-820.

[37] Osborne M J. An introduction to game theory[M]. New York: Oxford university press, 2004.

[38] Melis L,Song C Z,De Cristofaro E,et al.Exploiting unintended feature leakage in collaborative learning[C]//2019 IEEE Symposium on Security and Privacy (SP).May19-23,2019,SanFrancisco,CA,USA.IEEE,2019:691-706.

[39] Shokri R,Stronati M,Song C Z,et al.Membership inference attacks against machine learning models[C]//2017 IEEE Symposium on Security and Privacy (SP).May22-26,2017,SanJose,CA,USA.IEEE,2017:3-18.

[40] Papernot N,McDaniel P,Goodfellow I.Transferability in machine learning:from phenomena to black-box attacks using adversarial samples[EB/OL].2016

[41] Ng H W,Winkler S.A data-driven approach to cleaning large face datasets[C]//2014 IEEE International Conference on Image Processing (ICIP).October27-30,2014,Paris,France.IEEE,2014:343-347.

[42] Fung C,Yoon C J M,Beschastnikh I.Mitigating sybils in federated learning poisoning[EB/OL].2018

[43] Bhagoji A N,Chakraborty S,Mittal P,et al.Analyzing federated learning through an adversarial lens[EB/OL].2018

[44] Bagdasaryan E, Veit A, Hua Y, et al. How to backdoor federated learning[C]//International Conference on Artificial Intelligence and Statistics. PMLR, 2020: 2938-2948.

[45] Kim H,Park J,Bennis M,et al.On-device federated learning via blockchain and its latency analysis[EB/OL].2018

[46] Nishio T,Yonetani R.Client selection for federated learning with heterogeneous resources in mobile edge[C]//ICC 2019 - 2019 IEEE International Conference on Communications (ICC).May20-24,2019,Shanghai,China.IEEE,2019:1-7.

[47] Yoshida N,Nishio T,Morikura M,et al.Hybrid-FL for wireless networks:cooperative learning mechanism using non-IID data[EB/OL].2019:arXiv:1905.07210[cs.LG].https://arxiv.org/abs/1905.07210

[48] Ateniese G,Mancini L V,Spognardi A,et al.Hacking smart machines with smarter ones:How to extract meaningful data from machine learning classifiers[J].International Journal of Security and Networks,2015,10(3):137.

[49] Fredrikson M, Jha S, Ristenpart T. Model inversion attacks that exploit confidence information and basic countermeasures[C]//Proceedings of the 22nd ACM SIGSAC Conference on Computer and Communications Security. 2015: 1322-1333.

[50] Gu Z S,Jamjoom H,Su D,et al.Reaching data confidentiality and model accountability on the CalTrain[C]//2019 49th Annual IEEE/IFIP International Conference on Dependable Systems and Networks (DSN).June24-27,2019,Portland,OR,USA.IEEE,2019:336-348.

[51] Nishio T,Yonetani R.Client selection for federated learning with heterogeneous resources in mobile edge[C]//ICC 2019 - 2019 IEEE International Conference on Communications (ICC).May20-24,2019,Shanghai,China.IEEE,2019:1-7.

[52] Anh T T,Luong N C,Niyato D,et al.Efficient training management for mobile crowd-machine learning:a deep reinforcement learning approach[J].IEEE Wireless Communications Letters,2019,8(5):1345-1348.

[53] Sprague M R,Jalalirad A, Scavuzzo M, et al. Asynchronous federated learning for geospatial applications[C]//Joint European Conference on Machine Learning and Knowledge Discovery in Databases. Springer, Cham, 2018: 21-28.

[54] Xie C,Koyejo S,Gupta I.Asynchronous federated optimization[EB/OL].2019

[55] Lau F,Rubin S H,Smith M H,et al.Distributed denial of service attacks[C]//Smc 2000 conference proceedings.2000 ieee international conference on systems,man and cybernetics.'cybernetics evolving to systems,humans,organizations,and their complex interactions' (cat.no.0.October8-11,2000,Nashville,TN,USA.IEEE,2000:2275-2280.

【通聯编辑:唐一东】