光流估计补偿结合生成对抗网络提高视频超分辨率感知质量

祝 轩,柳 欣,兰志翔,孙逸霏,金玉莹,陈培榕

(1.西北大学 信息科学与技术学院,陕西 西安 710127;2.西北大学 数学学院,陕西 西安 710127)

超分辨率(super-resolution,SR)技术是从低分辨率(low-resolution,LR)图像或视频中恢复出高分辨率(high-resolution,HR)图像或视频[1]。随着高清显示技术的发展,SR技术在提高监控视频[2]、医学图像[3]以及遥感图像[4]等质量方面的应用越来越广泛。目前,SR方法分为单幅图像超分辨率(single image super-resolution,SISR)方法和视频超分辨率(video super-resolution,VSR)方法。相较于SISR方法,VSR方法可以利用帧内的空间信息和帧间的短时连续性和内容相似恢复出包含更多高频细节的视频[5-6]。

近年来,基于深度学习的卷积神经网络(convolutional neural network,CNN)以其在图像特征提取和模拟复杂映射关系上的优势被广泛应用于VSR。大部分基于CNN的VSR方法[7-9]利用像素损失(均方误差)训练网络,促使SR帧的平均像素值接近HR帧的平均像素值,其结果往往导致重建的SR帧缺乏高频细节、边缘不清晰、纹理平滑、视觉效果较差。目前,基于感知损失训练的生成对抗网络(generative adversarial networks,GAN)在SISR任务中生成了清晰的边缘、丰富的纹理和真实的颜色[10-11],但基于GAN的VSR方法尚不多见[12],且重建出的视频SR结果的感知质量有待提高。

本文提出了一个光流估计补偿结合多特征鉴别GAN的端到端视频超分辨率网络框架MC-PETGAN,该框架由光流估计补偿网络串联多特征鉴别GAN组成。光流估计补偿网络利用相邻视频帧之间具有的短时连续性和内容相似性特点补偿相邻视频帧;多特征鉴别GAN基于多特征鉴别器在像素、边缘和纹理3个方面的对抗训练促使生成器生成的SR帧与HR帧分别在像素、边缘和纹理3个方面的数据分布趋于一致,提高SR帧的感知质量。

1 相关工作

1.1 单幅图像超分辨率

单幅图像超分辨率是从单幅LR图像中恢复出具有高频信息的SR图像。Dong等人将CNN应用于SISR,设计了一个包含3个卷积层的轻量级网络SRCNN[13],其性能和速度均优于传统方法。Kim等人使用全局残差策略设计了一个20层的残差网络VDSR[14],该网络通过学习HR图像与LR图像之间的高频残差加快模型收敛速度。Sajjadi等人提出的EnhanceNet网络利用纹理匹配损失增强SR结果的真实感[10]。Ledig等人提出的SRGAN[11]网络联合内容损失和对抗损失训练网络,以便生成真实的结构和纹理。

1.2 视频超分辨率

1.3 视频感知质量评价

全参考图像质量评价指标(如峰值信噪比(PSNR)、根均方误差(RMSE))度量的是SR图像和HR图像像素点之间的差异,其往往用于评价图像或视频的失真度。2018 PIRM-SR(PIRM challenge on perceptual image super-resolution)[18]提出的感知分数(PI)指标用于评价SR视频的感知质量。PI能够表征图像或视频在像素、结构、纹理和色彩等方面的视觉质量。有研究指出,PSNR值所反映的具有良好视觉质量的SR结果与人类观察者的主观评价往往不一致,甚至相反[11,18-19]。

感知指标PI的定义如下:

(1)

其中:I表示待评价图像;Ma(·)表示一种无参考图像质量评价方法[20];NIQE(·)是基于自然图像统计特征的无参考图像质量评价方法[21]。

大量文献表明PI和NIQE跟人类主观评分结果高度相关,越低的PI和NIQE表示越好的感知质量[18-19]。

2 方法

2.1 MC-PETGAN网络框架

MC-PETGAN网络框架如图1所示,MC-PETGAN由光流估计补偿网络和多特征鉴别GAN构成,多特征鉴别器包括像素鉴别器Dp、边缘鉴别器DE和纹理鉴别器DT。

图1 MC-PETGAN网络框架Fig.1 The architecture of MC-PETGAN

2.2 光流估计补偿网络

(2)

(3)

其中:FNet(·)表示光流估计函数;h和w分别表示LR视频帧的高度和宽度。

补偿帧为

(4)

(5)

(6)

2.3 多特征鉴别GAN

2.3.1 多特征鉴别器训练 多特征鉴别器Dp、DE和DT分别用于鉴别SR帧和HR帧的像素值、边缘和纹理的一致性。多特征鉴别器的网络结构如表1~3所示,Conv(n,k,s)为卷积层,其中,参数n,k,s分别表示卷积核数量、大小和步长。

1)像素鉴别器Dp:Dp的输入是初始SR帧和HR帧。训练Dp的损失函数LDp为

(7)

2)边缘鉴别器DE:边缘反映了图像局部特性的不连续性(如灰度突变、颜色突变、纹理突变等),人类视觉对边缘十分敏感,边缘质量与图像质量紧密相关。DE用于鉴别SR帧和HR帧的边缘。训练DE的损失函数LDE为

(8)

其中,Edge(·)表示边缘提取检测算子。本文采用canny算子提取边缘。

3)纹理鉴别器DT:不包含色彩信息的灰度图像能够更加突出图像的纹理。DT用于鉴别灰度化的SR帧和HR帧。训练DT的损失函数LDT为

(9)

其中,Gray(·)表示灰度化操作。

表1 像素鉴别器网络结构Tab.1 The architectures of pixel discriminators

表2 边缘鉴别器网络结构Tab.2 The architectures of edge discriminators

表3 纹理鉴别器网络结构Tab.3 The architectures of texture discriminators

(10)

(11)

(12)

(13)

(14)

(15)

(16)

其中,φ4,4表示从VGG19网络中第4个MaxPooling层之前的第4个卷积层获得的特征图。

感知损失Lperceptual为

(17)

图2 生成器网络结构Fig.2 The architecture of generator

3 实验

3.1 数据集

从互联网上下载110段包括自然风景、人、动物和建筑等的1080P HD(1 080×1 920)视频,这些视频涵盖了复杂的场景转换和多样的运动形式。从每段视频中提取连续的32帧,总共3 520帧构成训练样本。利用Matlab的imresize函数对原始视频帧进行两倍下采样获得HR视频帧(540×960),将HR视频帧4倍下采样得到相应的LR视频帧(135×240),成对的HR/LR视频帧构成训练集。从Ultra Video Group Database(ultravideo.cs.tut.fi)中选取10段视频作为验证集,用于超参数的选择和模型性能的验证。分别使用公共基准集Vid4、SPMC8(从SPMC数据集[23]中选取的8段视频)、以及从互联网上下载的低质量监控视频作为测试集。

3.2 实验设置

从每一个LR序列视频帧中随机提取连续的3帧,在每帧中随机裁剪出一个64×64的块并将它们在深度维度上堆叠作为LR输入。从与LR帧对应的HR帧中裁剪出256×256的HR块,并对LR块和 HR块进行旋转和翻转等数据增强操作,将增强后的LR块集合和HR块集合分别作为LR和HR训练集样本。MC-PETGAN网络的训练过程包含预训练阶段和交替训练阶段,预训练阶段分别用光流损失Lflow和MSE损失LMSE训练光流估计补偿网络和生成器,提供初始化参数。交替训练阶段用感知损失Lperceptual和鉴别器损失LDp、LDE、LDT分别交替训练生成器与鉴别器,并将鉴别器权重参数截断到[-0.01,0.01]之间。

在tensorflow上实现MC-PETGAN网络框架,优化器为RMSprop,batchsize设置为15。预训练阶段的学习率为10-4,训练次数为103,交替训练阶段的学习率为10-4,训练次数为400。实验环境为Nvidia GTX 1080 Ti GPU,16GB内存。

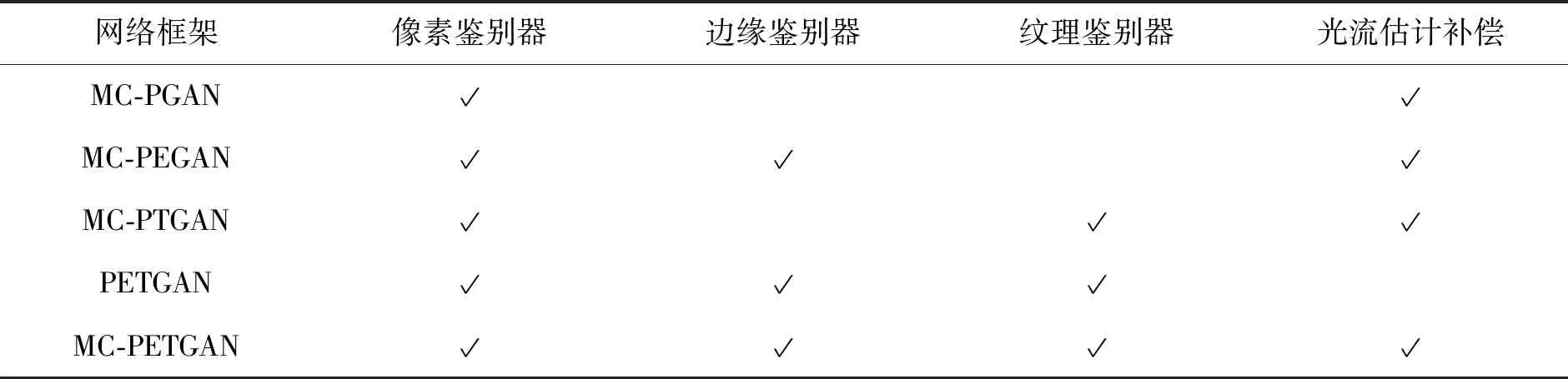

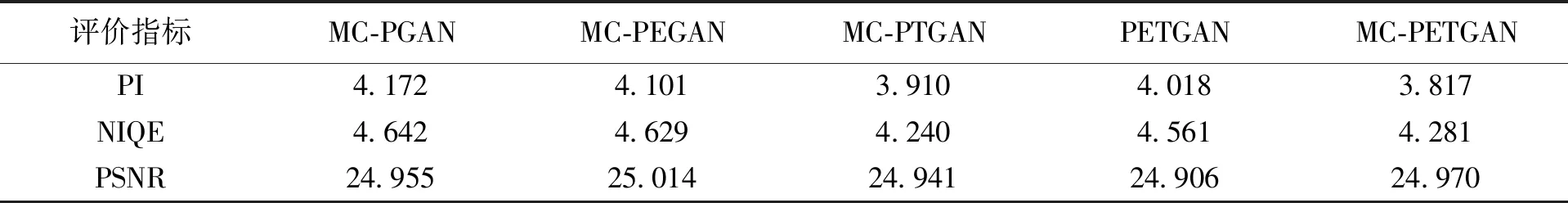

3.3 消融学习

消融学习实验方案设置如表4,消融实验的结果能充分反映光流估计补偿和多特征鉴别器对网络性能的影响。

表4 消融学习实验方案设置Tab.4 The experimental schemes of ablation study

表5是表4中5种消融学习实验方案在公共基准集Vid4上4倍SR重建的PSNR、PI和NIQE值。PI和NIQE值越低表示视觉感知质量越好,PSNR值越高表示失真度越低。由表5可以得到以下结论:①光流估计补偿可以获得更有竞争力的PI和PSNR值,相比于PETGAN方案,MC-PETGAN方案具有更低的PI和NIQE值以及更高的PSNR值;②多特征鉴别器可以有效降低PI和NIQE值,相比于MC-PGAN、MC-PEGAN和MC-PTGAN方案,MC-PETGAN方案具有更低的PI和NIQE值,PSNR只比MC-PEGAN略微减小。

表5 Vid4数据集上消融学习实验结果Tab.5 The ablation study results on Vid4 dataset

3.4 对比实验

本文选取VSRnet、VESPCN、TDVSR、SOF-VSR、EnhanceNet和SRGAN作为对比方法,其中VSRnet、VESPCN、TDVSR和SOF-VSR是利用像素损失训练的VSR网络,EnhanceNet和SRGAN是利用感知损失训练仅包含像素鉴别器的SISR网络。VSRnet、VESPCN和TDVSR的实验结果来自于作者官方主页;EnhanceNet和SOF-VSR的实验结果根据官方源码和模型参数获得;SRGAN的实验结果是通过第三方复现模型获得。所有评价结果均基于将Vid4的序列SR帧的每帧边缘裁掉8个像素,并按亮度通道计算。

3.4.1 定性验证 图3和图5是本文方法和对比方法分别对SPMC8和Vid4数据集中的数据4倍SR重建结果,为了更清楚地显示不同方法的区别,在图4和图6分别展示了图3和图5中红框区域的局部放大结果。由于VESPCN和TDVSR方法没有图3测试数据相应的源码,因此,图3和图4中只给出了EnhanceNet、SRGAN和SOF-VSR的实验结果,图5给出了所有对比方法的实验结果。观察图3~6可以看出,本文方法相比于对比方法能够重建出更多的高频细节,边缘和纹理完整清晰,色彩真实,视觉感知更加愉悦。

图3 “veni3_011”4倍SR重建结果Fig.3 The SR results of "veni3_011" under the upscaling factor of 4

图4 图3的局部放大区域结果Fig.4 The enlarged local region results of Fig.3

图5 “walk”4倍SR重建结果Fig.5 The SR results of "walk" under the upscaling factor of 4

图6 图5的局部放大区域结果Fig.6 The enlarged local region results of Fig.5

图7是本文方法对低质量监控视频2倍及4倍SR重建结果,结果显然本文方法可以恢复出低质量监控视频中的更多信息,如椭圆区域中的小车尾部“教练”字样、高速公路上悬挂监控设备的人以及交通警示标志。

3.4.2 定量验证 表6和表7分别列出了本文方法以及对比方法在Vid4和SPMC8数据集上4倍SR重建的PI、NIQE和PSNR值。由表6和表7可知,本文方法与VSR方法(VSRnet,VESPCN,TDVSR,SOF-VSR)相比,具有低的PI值。本文方法与SISR方法(EnhanceNet,SRGAN)相比,具有高的PSNR值。结合表6、表7和图3、图5可知,本文方法相比于VSR方法感知指标更好;相比于SISR方法失真指标更好。此外,本文方法生成的SR结果相比于VSR方法,结构和纹理更加清晰;相比于SISR方法,在保证结构和纹理清晰的基础上能够有效克服伪影。

图7 低质量监控视频2倍和4倍SR重建结果Fig.7 The SR results of low-quality surveillance videos under the upscaling factor of 2 and 4

表6 Vid4数据集4倍SR重建定量比较结果Tab.6 Quantitative comparative SR results on Vid4 dataset under the upscaling factor of 4

4 结语

本文提出了一个新的端到端的视频超分辨率重建框架MC-PETGAN,其充分利用了视频具有的帧间短时连续和空间相似性特性。MC-PETGAN框架包括光流估计补偿网络和多特征鉴别GAN,光流估计补偿网络引入帧间短时连续和内容相似信息,为多特征鉴别GAN提供有效丰富的信息。生成器与多特征鉴别器之间对抗训练促使SR结果与HR帧具有相似的像素、边缘和纹理分布,提高VSR结果的感知质量。实验结果表明,本文方法在保证视频SR结果像素精度的基础上,还可以较好地恢复出清晰的边缘和纹理,而且视觉感受愉快。