视觉与惯性传感器融合的SLAM技术综述

杨观赐 王霄远 蒋亚汶 李杨

摘 要:同时定位与建图(SLAM)是指当机器人在未知的环境中运行时能够自动绘制环境地图,同时确定自身在地图中的位置。融合视觉和惯性传感器获取的数据来实现实时的高精度和鲁棒的SLAM,是当前智能机器人领域的研究热点。为了全面深入地认识VI-SLAM系统,首先,分析了4种典型的VI-SLAM系统;其次,综述了视觉惯性里程计、定位和建图技术方面的最新成果;再次,比较分析了VI-SLAM研究平台;最后,总结展望了未来的发展趋势。

关键词:SLAM;视觉惯性里程计;定位;建图;移动机器人

中图分类号:TP181

文献标识码: A

同时定位和建图(simultaneous localization and mapping, SLAM)[1-2]是指将移动机器人置于未知环境中的未知位置时,移动机器人自动逐步构建与环境一致的地图,并同时使用该地图确定其自身在地图中的位置。SLAM系统由前端和后端组成,前端主要负责执行数据关联,后端主要负责状态推断。在确保计算效率的同时,如何确保地图和位姿估计的全局一致性和高精度,如何解决非线性、数据关联和界标特性等问题引起了众多学者的关注。

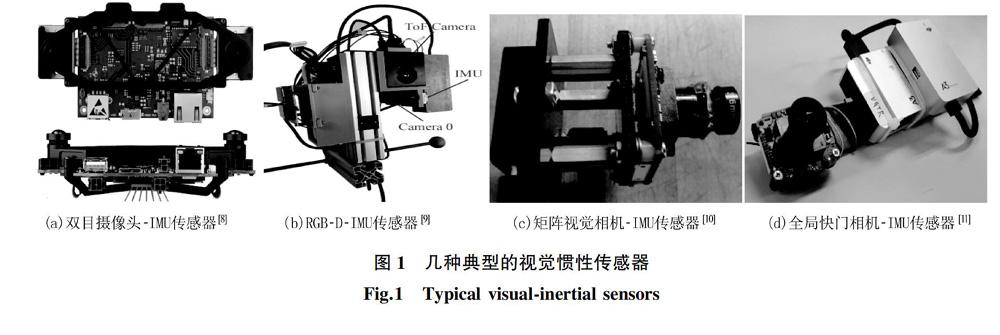

典型SLAM解决方案[3]主要利用视觉传感器,虽然取得了不错的效果,但是当移动机器人处于低纹理、光照变化和图像模糊、以及高速运动时表现欠佳。视觉传感器低速运行时能够有较精确地环境特征跟踪表现,但是随着速度的增大,特征跟踪的准确性迅速降低;惯性传感器(inertial measurement unit,IMU)能够跟随运动速度变化,不受运动场景和运动速度的限制而准确测量出角速度和线性加速度,但是当其长时间运行时,IMU因其自身偏置而产生估计累计漂移[3-4]。融合使用视觉和惯性传感器可以提供丰富的运动和环境结构信息。为了发挥视觉传感器和IMU的优势,规避它们的劣势,人们研制了视觉传感器和IMU融合的SLAM(visual-inertial SLAM, VI-SLAM)系统(见图1)[5],采用基于优化或基于滤波的技术采集物理量,然后运用特定的方法估算这些物理量,从而获得对自身运动和场景结构的可靠估计[6-7]。

a)双目摄像头-IMU传感器[31] b)RGB-D-IMU传感器[95] c)矩阵视觉相机-IMU传感器[40] d)全局快門相机-IMU传感器[93]

当前,VI-SLAM已广泛应用于机器人导航[5,12-18],无人机[19-27],增强现实[28-32],虚拟现实[33]以及无人驾驶[34]等领域,而传感器的校准、系统的初始化、数据的处理和融合方法、闭环检测的精度和效率等因素都会对VI-SLAM系统产生影响[8]。

为了更好地把握VI-SLAM领域取得的成果,本文从VI-SLAM系统、视觉惯性里程计、定位和建图技术以及VI-SLAM的研究平台方面进行了综述,并展望了发展趋势。

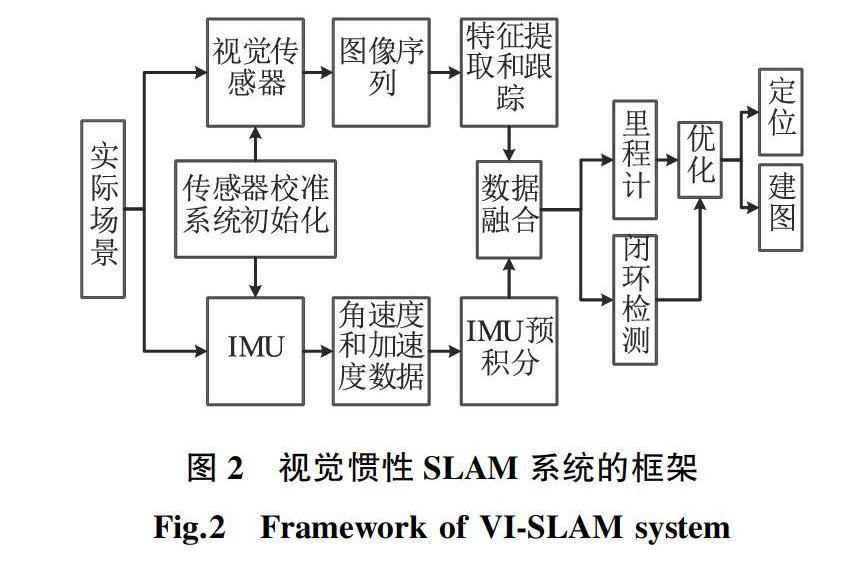

1 视觉惯性SLAM系统技术分类

图2是VI-SLAM系统的框架结构图。系统启动时,首先校准传感器;系统运行过程中,不同传感器分别采集环境结构信息和机器人运动信息;在预处理所采集的数据后,使用不同的融合策略进行数据融合;最后利用融合的数据实现定位和建图。接下来,将综述基于关键帧的VI-SLAM系统、稠密VI-SLAM系统、紧密耦合的VI-SLAM系统和协作式的VI-SLAM系统的技术特点。

1.1 基于关键帧的VI-SLAM系统

对于传感器数据的融合,基于过滤的融合策略与非线性优化方法相比,后者在鲁棒性、精度和计算复杂度上更具优势。文献[35]将惯性测量数据集成到基于关键帧的视觉SLAM中,将IMU误差项以全概率的方式与界标重投影误差集成在一起进行联合优化非线性成本函数,并利用“关键帧”概念边缘化过去状态部分来维持有限大小的优化窗口,从而确保实时性操作。文献[36]提出了基于关键帧的视觉惯性协作式同时定位和建图框架,在建图和定位高效协作方面具有优势。文献[37]提出的基于关键帧的单目和双目相机视觉惯性融合的SLAM系统,能够获得更好的局部一致轨迹和地图估计,并通过局部跟踪、位姿图优化和闭环检测实现VI-SLAM的定位准确性和全局一致性。此外,它能够根据先前构建的地图进行重新定位并继续执行SLAM。文献[38]提出的实时单目VI-SLAM系统在消除漂移方面性能良好,它通过融合单目视觉惯性里程计特征实现重定位,然后执行4-DOF位姿图优化校正漂移。此系统可以通过重用地图和重新定位相机获得机器人在已有地图中的绝对位姿,通过全局位姿图优化将当前地图与先前地图合并。

1.2 稠密VI-SLAM系统

文献[39]提出的稠密VI-SLAM系统,可以同时优化相机的位姿、速度、IMU偏置和重力方向,构建稠密的环境3D场景地图。文献[40]构建了一种基于动态网格与双目摄像头的稠密视觉惯性SLAM系统。该系统将空间划分为网格,在线重建场景的完全稠密地图。文献[41]研究了具有结构约束的稠密平面惯性SLAM框架。它使用手持式RGB-D传感器和IMU重建大型室内环境的稠密3D模型,通过结构约束减少输出建图中的漂移和失真。文献[42]提出的方法能够从摄像头的运动情况和稀疏深度推断稠密深度信息,从极稀疏的点云中恢复场景几何形状。文献[10]使用直接法同时优化IMU测量和视觉数据,形成了基于直接法的VI-SLAM,可以用于实时的场景稠密地图在线重建和跟踪。而为了平衡精度和计算效率,文献[43]提出了基于半直接法的VI-SLAM,它集成了特征法的准确性和直接法的快速性,在估计机器人的运动和稀疏场景的结构方面具有优势。

1.3 紧密耦合的VI-SLAM系统

移动机器人具有实时定位和地建图功能才能真正自主地运行。其路径规划和决策依赖于机器人对周围环境的及时准确建图和状态估计。对此,文献[44]提出了基于传感器时间同步校准的紧密耦合实时VI-SLAM框架,它能够在动态的环境中进行准确、实时的位姿估计和建图。文献[45]提出的多合一多传感器视觉惯性融合SLAM,通过同步和校准多传感器,实现紧密耦合的视觉惯性跟踪和并行建图。此方法能够与其他传感器模态松散耦合。由于视觉惯性系统具有非线性的特点,其性能在很大程度上取决于初始值的准确性,因此,文献[46]提出了提高初始状态估计准确性的方法。即:在已知重力大小的基础上,通过优化其切线空间上的二维误差状态细化估计的重力矢量,然后分别估计加速度计的偏置。此外,它还提出了确定何时初始化成功的自动终止条件,一旦初始状态估计收敛,就使用初始估计值启动非线性紧密耦合的VI-SLAM系统。

鉴于视觉惯性里程计(visual-inertial odometry, VIO)方法缺乏闭合回路的能力,并且即使传感器不断地重新访问同一位置,轨迹估计也会出现累积漂移,文献[47]提出了一种新颖的紧密耦合的VI-SLAM系统。该系统可以闭合回路并重用其地图,能在已建图的区域实现对传感器的零漂移定位;其局部建图线程在插入新的关键帧之后将执行局部BA(bundle adjustment),优化最后N个关键帧和由这些关键帧所观察到的所有点特征。为了获得鲁棒的SLAM,文献[48]提出了可以实时匹配全局最优结果的基于紧密耦合的非线性优化单目VI-SLAM。此系统采用多线程、异步自适应数值优化求解器,自适应地识别SLAM图的边界条件并进行同步和异步求解。为了实现移动机器人重启后快速的实时定位,文献[49]提出了基于地图元素与关键帧数据库的离线地图构建方法,并通过序列化方法进行保存与加载,之后,设计了基于离线地图的加载重定位方法,并形成了离线地图与建图轨迹的可视化方法。此系统能根据所得离线地图进行重定位和全局定位跟踪。

1.4 协作式VI-SLAM系统

近年来,协作式VI-SLAM系统研究也得到了快速的发展。针对多个单目摄像头,文献[50]研究了两个智能体间协作实现VIO的方法;文献[51]提出了基于交换的视觉惯性数据包的分散数据共享方法;文献[52]利用多摄像头采集的数据融合惯性测量数据进行在线校准初始化。围绕同时存在摄像头-IMU和双目摄像头的惯性里程计系统,文献[53]设计了可以在线估计初始值并同时校准传感器的方法;文献[54]通过融合事件相机和惯性测量数据,提供准确的状态估计。文献[55]将较大室内空间内多个用户在不同时刻使用移动设备收集的视觉和惯性测量数据进行融合,从而实现协作建图。协作式VI-SLAM系统能够最大限度地感知周围环境、提供丰富的传感数据供系统使用。虽然在环境退化的情况下,系统也能表现出高精度和鲁棒性,但是协作式VI-SLAM系统要求较大的计算能力。

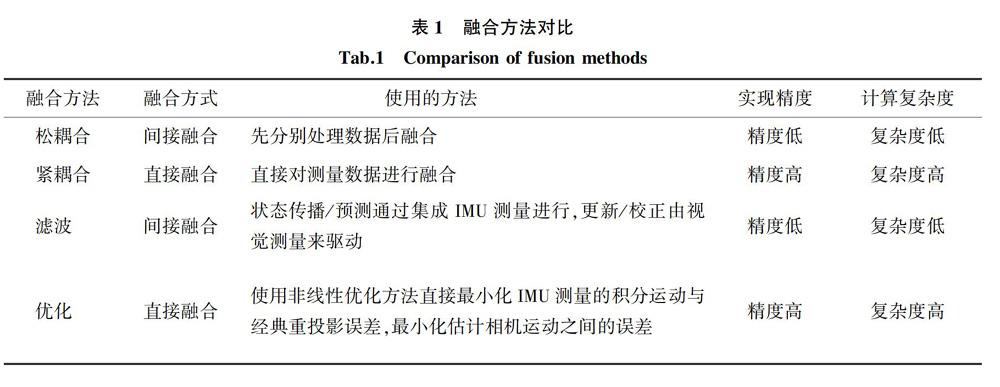

2 视觉惯性里程计

视觉惯性里程计使用相机与IMU采集的数据进行融合以估算机器人状态。VIO系统将来自视觉传感器和IMU的数据融合处理,获得对视觉传感器运动的更好测量。机器人高速运动时,相机帧之间可能无法进行特征匹配,IMU可以提供信息,使系统仍然保持较准确的位姿估计。同时,视觉图像信息可以弥补机器人低速运动时IMU存在的漂移问题[56]。在VIO和VI-SLAM系统中,视觉图像和IMU采集数据主要使用基于滤波方法或非线性优化方法进行数据融合。根据传感器融合测量方法不同,VIO系统分为松耦合和紧密耦合的方法。松耦合方法分别对图像和IMU数据进行预处理,然后进行融合;紧密耦合方法则直接融合相机和IMU的原始测量值找到最佳估计。表1是视觉惯性传感器数据融合方法的比较情况。与松耦合方法相比,紧密耦合方法更准确,更可靠[57]。

图3是视觉惯性里程计的结构图。VIO方法主要分为基于传统的方法和基于深度学习的方法。其中,传统的方法又细分为5类:基于扩展卡尔曼滤波器(extended Kalman filter,EKF)的VIO,基于点线特征的VIO,基于优化的VIO,基于直接方法的VIO和基于事件相机的VIO。值得注意的是,虽然当前基于事件相机的VIO方法较少,但是由于事件相机具有擅长捕捉亮度变化、在较暗和强光场景下也能输出有效数据的特点,基于事件相机的VIO方法值得期待,因此对此类方法进行了单独分析。基于深度学习的方法又细分为基于端到端学习的方法和基于监督学习的方法。

2.1 基于传统方法的VIO

2.1.1 基于EKF的VIO

为充分利用视觉和惯性传感器采集的信息,文献[58]提出基于扩展卡尔曼滤波器的半直接VIO方法,该方法几乎可以在原始传感器级别上紧密融合视觉传感器和惯性测量数据,同时结合了紧密耦合的视觉惯性扩展卡尔曼滤波器的优点以及直接光度法的鲁棒性和精度。文献[59]提出的基于全密集紧密耦合直接滤波的VIO方法同时估计所有像素的深度和机器人状态,通过向状态向量添加深度和强度信息,能够一步更新所有条目。文献[60]提出以机器人为中心的基于扩展卡尔曼滤波器的直接VIO框架。该方法以机器人为中心,结合光度误差的直接反馈,通过迭代扩展卡尔曼滤波器处理界标跟踪,可以实现多相机支持,对相机和IMU进行在线校准。文献[61]直接使用图像块的像素强度误差来实现精确的跟踪性能,具有良好的鲁棒性。

考虑到滤波器中计算雅可比的标准方法会导致准确性下降,文献[62]提出的多状态约束卡尔曼滤波器算法主要包括3个部分: EKF误差状态转换矩阵的封闭式计算、定向误差的参数化、在过滤器中选择线性化的点。在此基础上,文献[63]提出的基于滤波器的双目VIO方法,在计算效率和鲁棒性方面表现更优。与此同时,文献[64]基于文献[62]的框架,通过构建新的初始化方法设计了一种新的VIO算法,能够通过分析跟踪的特征自动检测静止场景,并根据静态IMU数据初始化滤波器状态。文献[65]提出了一种实时VIO算法。该算法通过确保其线性化系统模型的正确可读,对相机-IMU校准参数进行在线估算,从而确保实现一致性的估计。为了确保提供的测量信息足以在线校准相机的固有参数,文献[66]设计了视觉惯性系统的非线性可观测性分析方法,通过在线校准相机固有参数提高位姿估计的准确性。而文献[67]提出的基于RGB-D相机和IMU的VIO方法,不仅可以估算相机的运动轨迹,还可以在线校准重力场和相机与IMU之间的相对位姿以提高位姿估计准确性,并通过迭代优化减少线性误差。此外,文献[68]将IMU测量值与相机提供的视觉特征轨迹的观察结果相融合,实时生成高精度状态估计值。

2.1.2 基于点线特征的VIO

相比于点特征,线特征能够提供更多的环境几何结构信息,在无法可靠检测或跟踪点特征的低纹理环境或照明变化场景中,线特征可以有效提高系统的鲁棒性。为了同时使用点和线特征,文献[69]提出了基于滤波的紧密耦合双目视觉惯性里程计系统。此系统在滑动窗口上对点和线要素进行处理,并使用闭环技术减少累计漂移。为了解决相机轨迹估计的问题并构建基于惯性测量和视觉观察结构的3D地图,文献[57]提出了基于点线特征的紧密耦合VIO系统。系统主要包含两个模块:前端负责传播IMU主体状态,检测/匹配点线特征(见图4),后端用于估计和优化自身状态。文献[70]通过构建具有几何信息的环境特征图,合并IMU测量数据为视觉定位算法提供先验和比例信息。然后,基于稀疏图像对准的运动估计获得初始位姿估计,进一步执行特征对准以获得子像素级特征相关性。最后,通过最小化局部地图点和线的重投影误差,获得高精度的位姿和3D界标。文献[71]通过使用平行线的图像投影相交点消除角度漂移,从而提高了基于特征的VIO精度。文献[72]简化了基于融合点和线特征匹配的方法和VIO初始化策略。在VIO初始化过程中,将恒定速度約束应用于运动中的机器人,动态地加快了初始状态变量的获取;通过优化滑动窗口模型构造点特征和由线特征表征的稀疏图。

4 视觉惯性融合研究平台

这一节综述当前用于VI-SLAM研究的平台:Maplab、VINS-Mono、VINS-RGBD、VersaVINS和OpenVINS。表3是它们的简要比较统计表。

Maplab[94]是一个通用的视觉惯性建图和定位的开放框架。该框架提供多会话建图工具集合,支撑地图合并、视觉惯性批处理优化和回环闭合。其在线前端可以创建视觉惯性地图、跟踪本地化地图中的全局无漂移位姿。

VINS-Mono[11]是一种单目视觉惯性状态估计器。系统从测量数据预处理开始,初始化过程提供所有必要的值来引导基于非线性优化的VIO;带有重定位模块的VIO紧密集成了预集成的IMU测量值,特征观察和从闭环中重新检测到的特征;最后,位姿图模块执行4-DOF全局优化以消除漂移并实现重用目的,同时系统还可以通过有效的保存和加载地图来实现地图的重用。

VINS-RGBD[95]是基于VINS-Mono提出、用于机器人的轨迹估计和建图。它扩展了VINS-Mono系统,在初始化过程以及VIO阶段使用深度数据。系统集成了基于二次采样深度数据和八叉树滤波的建图系统以支持回环闭合在内的实时建图。

VersaVIS[9]是一种开放式多功能多相机视觉惯性传感器研究平台,支持各种相机和IMU的传感器融合,可支持移动机器人部署、集成和扩展应用程序。该平台支持IMU执行多台相机的时间同步,能够实现视觉惯性SLAM、多相机应用、多模式建图、重建和基于对象的建图。

OpenVINS[96]集成了块滑动窗口卡尔曼滤波器,支持相机参数在线校准和时间偏移校准;具有不同表示形式和一致性的第一雅可比估计的SLAM界标处理功能;提供状态管理的模块化系统、可扩展的视觉惯性系统模拟器以及用于算法评估的工具箱。

5 未来的发展趋势

在过去的十几年中,由于传感器技术、计算机计算性能和深度学习的快速发展,视觉惯性融合的SLAM技术领域取得了突破性进展。在工程实际中,由于机器人所处环境结构的复杂性、传感器自身的局限性、初始化精度和传感器校准以及数据融合的处理方式等问题,VI-SLAM仍然面临诸多挑战,以下几个方面可能是值得关注的方向。

(1)视觉-惯性传感器在线校准。相机-IMU的空间位置校准和校准参数在系统长时间的运行过程中经常会发生漂移,从而引起后续定位和建图累计误差。当前,虽然已经有很多学者研究了传感器的校准方法,但是往往仅针对有限的参数或者特定型号的传感器进行校准,且实时性表现仍然欠佳。因此,高效的视觉-惯性传感器在线校准方法是值得深入研究的方面。

(2)基于深度学习的状态估计。在实际的运行过程中,高精度可靠的状态估计是机器人实现自主功能的重要前提。近年来,深度学习方法得到了快速的发展,在图像特征提取和匹配方向出现了很多优秀的方法,提供了直接处理原始、高维数据的能力,而无需使用领域知识通过人工制作的特征提取器[80-81,85]。同时,基于深度学习的图像处理方法在应对视觉退化环境,如快速运动、运动模糊和光照变化等因素具有较强的适应性。因此,如何直接利用深度学习的方式,从传感器采集数据同本地或者更高级别的数据特征、知识图谱融合学习,形成智能高效的状态估计方法是一个有前景的方面。

(3)VI-SLAM系统化闭环检测。如果机器人能够进行精准的闭环检测,则可以在节省计算量的同时显著地减少轨迹估计的累计误差,从而提高定位精度和建图效率。虽然文献[43,97-98]中的方法可以实现闭环检测的功能,但也有许多需要提升的方面。突破视觉惯性闭环检测的新理论和新方法,对于提高机器人自主探索环境的能力,提高轨迹估计的精度和效率、定位和建图的能力具有重要意义。

(4)VI-SLAM系统自主环境感知。鲁棒的SLAM自主感知要求能够自主进行高级别的场景理解和自主无人执行高级别任务[99]。如何构建可用于指导完成高级别任务的丰富语义地图,如何提高VI-SLAM系统感知环境和数据并具备认知能力等是值得深入研究的方面。

6 结束语

视觉惯性传感器的互补融合使用极大地促进了SLAM技术的发展,尤其是在VIO方向;结合深度学习方法也取得了不错的效果。目前,视觉惯性传感器互补融合的研究中一部分成果已經得到了实际的应用。但是,VI-SLAM系统在实际运行时,机器人所处的环境是复杂的、外界干扰因素也是多样的,这让VI-SLAM的推广应用变得困难。在未来,随着智能机器人技术的发展,机器人所能实现的功能将会越来越复杂,因此在实现高精度、高效率的定位和建图方面依然有很多的研究工作要做。只有实现实时的、高精度、鲁棒的VI-SLAM系统,才能促进VI-SLAM技术向广泛实际应用转化。

参考文献:

[1]DURRANT-WHYTE H, BAILEYT. Simultaneous localization and mapping: part I[J]. IEEE Robotics & Automation Magazine, 2006, 13(2): 99-110.

[2]BAILEYT, DURRANT-WHYTE H. Simultaneous localization and mapping (SLAM): part II[J]. IEEE Robotics & Automation Magazine, 2006, 13(3): 108-117.

[3]CORKE P, LOBO J, DIAS J, et al. An introduction to inertial and visual sensing[J]. The International Journal of Robotics Research, 2007, 26(6): 519-535.

[4]KELLY J, SUKHATME G S. Visual-inertial sensor fusion: localization, mapping and sensor-to-sensor self-calibration[J]. The International Journal of Robotics Research, 2011, 30(1): 56-79.

[5]HUANG G Q. Visual-inertial navigation: a concise review[C]//IEEE International Conference on Robotics and Automation(ICRA). Montreal, QC, Canada: IEEE, 2019: 9572-9582.

[6]MARTINELLI A. Vision and IMU data fusion: closed-form solutions for attitude, speed, absolute scale, and bias determination[J]. IEEE Transactions on Robotics, 2012, 28(1): 44-60.

[7]DIAS J, VINZCE M, CORKE P, et al. Editorial: special issue: 2nd workshop on integration of vision and inertial sensors[J]. The International Journal of Robotics Research, 2007, 26(6): 515-517.

[8]LEUTENEGGER S, LYNEN S, BOSSE M, et al. Keyframe-based visual-inertial odometry using nonlinear optimization[J]. The International Journal of Robotics Research, 2015, 34(3): 314-334.

[9]TSCHOPP F, RINER M, FEHR M, et al. VersaVIS-an open versatile multi-camera visual-inertial sensor suite[J]. Sensors, 2020, 20(5): 1439.

[10]CONCHA A, LOIANNO G, KUMAR V, et al. Visual-inertial direct SLAM[C]//IEEE International Conference on Robotics and Automation (ICRA). Stockholm, Sweden: IEEE, 2016: 1331-1338.

[11]QIN T, LI P L, SHEN S J. Vins-mono: a robust and versatile monocular visual-inertial state estimator[J]. IEEE Transactions on Robotics, 2018, 34(4): 1004-1020.

[12]HEO S J, CHA J, PARK C G, et al. EKF-based visual inertial navigation using sliding window nonlinear optimization[J]. IEEE Transactions on Intelligent Transportation Systems, 2019, 20(7): 2470-2479.

[13]HUANG G Q, KAESS M, LEONARD J J, et al. Towards consistent visual-inertial navigation[C]//IEEE International Conference on Robotics and Automation (ICRA). Hong Kong, China: IEEE, 2014: 4926-4933.

[14]HESCH J A, KOTTAS D G, BOWMAN S L, et al. Consistency analysis and improvement of vision-aided inertial navigation[J]. IEEE Transactions on Robotics, 2014, 30(1): 158-176.

[15]OMARI S, BLOESCH M, GOHL P, et al. Dense visual-inertial navigation system for mobile robots[C]//IEEE International Conference on Robotics and Automation (ICRA). Seattle, WA, USA: IEEE, 2015: 2634-2640.

[16]KAISER J, MARTINELLI A, FONTANA F, et al. Simultaneous state initialization and gyroscope bias calibration in visual inertial aided navigation[J]. IEEE Robotics and Automation Letters (RA-L), 2017, 2(1): 18-25.

[28]SARTIPI K, DUTOIT R C, COBAR C B, et al. Decentralized visual-inertial localization and mapping on mobile devices for augmented reality[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Macau, China: IEEE, 2019: 2145-2152.

[29]PIAO J C, KIM S. Adaptive monocular visual-inertial SLAM for real-time augmented reality applications in mobile devices[J]. Sensors, 2017, 17(11): 2567.

[30]WILLIEM, IVAN A, SEOK H, et al. Visual-inertial RGB-D SLAM for mobile augmented reality[C]//Pacific Rim Conference on Multimedia (PRCM). Cham, Switzerland: Springer, 2017: 928-938.

[31]OSKIPER T, SAMARASEKERA S, KUMAR R, et al. CamSLAM: vision aided inertial tracking and mapping framework for large scale ar applications[C]//IEEE International Symposium on Mixed and Augmented Reality (ISMAR-Adjunct). Nantes, France: IEEE, 2017: 216-217.

[32]PIAO J, KIM S. Real-time visual-inertial SLAM based on adaptive keyframe selection for mobile AR applications[J]. IEEE Transactions on Multimedia, 2019, 21(11): 2827-2836.

[33]FANG W, ZHENG L Y, DENG H J, et al. Real-time motion tracking for mobile augmented/virtual reality using adaptive visual-inertial fusion[J]. Sensors, 2017, 17(5): 1-22.

[34]ZHENG F, LIU Y H. SE(2)-constrained visual inertial fusion for ground vehicles[J]. IEEE Sensors Journal, 2018, 18(23): 9699-9707.

[35]LEUTENEGGER S, FURGALE P, RABAUD V, et al. Keyframe-based visual-inertial SLAM using nonlinear optimization[C]//Robotics: Science and Systems(RSS). Berlin, Germany: IEEE, 2013.

[36]KARRER M, SCHMUCK P, CHLI M, et al. CVI-SLAM—collaborative visual-inertial SLAM[C]//IEEE International Conference on Robotics and Automation (ICRA). Brisbane, QLD, Australia: IEEE, 2018, 3(4): 2762-2769.

[37]KASYANOV A, ENGELMANN F, STUCKLER J, et al. Keyframe-based visual-inertial online SLAM with relocalization[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Vancouver, BC, Canada: IEEE, 2017: 6662-6669.

[38]QIN T, LI P, SHEN S, et al. Relocalization, global optimization and map merging for monocular visual-inertial SLAM[C]//IEEE International Conference on Robotics and Automation (ICRA). Brisbane, QLD, Australia: IEEE, 2018: 1197-1204.

[39]LAIDLOW T, BLOESCH M, LI W B, et al. Dense RGB-D-inertial SLAM with map deformations[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Vancouver, BC, Canada: IEEE, 2017: 6741-6748.

[40]MA L, FALQUEZ J M, MCGUIRE S, et al. Large scale dense visual inertial SLAM[C]//Field and Service Robotics (FSR). Cham, Switzerland: Springer, 2016: 141-155.

[41]HSIAO M, WESTMAN E, KAESS M, et al. Dense planar-inertial SLAM with structural constraints[C]//IEEE International Conference on Robotics and Automation (ICRA). Brisbane, QLD, Australia: IEEE, 2018: 6521-6528.

[42]WONG A, FEI X, TSUEI S, et al. Unsupervised depth completion from visual inertial odometry[J]. IEEE Robotics and Automation Letters(RA-L), 2020, 5(2): 1899-1906.

[43]LIU Q P, WANG Z J, WANG H, et al. SD-VIS: a fast and accurate semi-direct monocular visual-inertial simultaneous localization and mapping (SLAM)[J]. Sensors, 2020, 20(5): 1511.

[44]NIKOLIC J, REHDER J, BURRI M, et al. A synchronized visual-inertial sensor system with FPGA pre-processing for accurate real-time SLAM[C]//IEEE International Conference on Robotics and Automation (ICRA). Hong Kong, China: IEEE, 2014: 431-437.

[45]ZHANG Z, LIU S S, TSAI G, et al. PIRVS: an advanced visual-inertial SLAM system with flexible sensor fusion and hardware co-design[C]//IEEE International Conference on Robotics and Automation (ICRA). Brisbane, QLD, Australia: IEEE, 2018: 3826-3832.

[46]MU X F, CHEN J, ZHOU Z X, et al. Accurate initial state estimation in a monocular visual-inertial SLAM system[J]. Sensors, 2018, 18(2): 506.

[47]MURARTAL R, TARDOS J D. Visual-inertial monocular SLAM with map reuse[J]. IEEE Robotics and Automation Letters (RA-L), 2017, 2(2): 796-803.

[48]KEIVAN N, SIBLEY G. Asynchronous adaptive conditioning for visual-inertial SLAM[J]. The International Journal of Robotics Research, 2015, 34(13): 1573-1589.

[49]YANG G C, CHEN Z J, LI Y, et al. Rapid relocation method for mobile robot based on improved ORB-SLAM2 algorithm[J]. Remote Sensing, 2019, 11(2): 149.

[50]MARTINELLI A. Cooperative visual-inertial odometry: analysis of singularities, degeneracies and minimal cases[C]//IEEE International Conference on Robotics and Automation (ICRA). Paris, France: IEEE, 2020, 5(2): 668-675.

[51]DUBOIS R, EUDES A, FREMONT V, et al. On data sharing strategy for decentralized collaborative visual-inertial simultaneous localization and mapping[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Macau, China: IEEE, 2019: 2123-2130.

[52]LIU Y, WANG F, ZHANG W, et al. Online self-calibration initialization for multi-camera visual-inertial SLAM[C]//IEEE International Conference on Robotics and Biomimetics (ROBIO). Kuala Lumpur, Malaysia: IEEE, 2018: 192-199.

[53]HUANG W B, LIU H, WAN W W, et al. An online initialization and self-calibration method for stereo visual-inertial odometry[J]. IEEE Transactions on Robotics, 2020: 1-18.

[54]VIDAL A R, REBECQ H, HORSTSCHAEFER T, et al. Ultimate SLAM? combining events, images, and IMU for robust visual SLAM in HDR and high-speed scenarios[J]. IEEE Robotics and Automation Letters (RA-L), 2018, 3(2): 994-1001.

[55]GUO C X, SARTIPI K, DUTOIT R C, et al. Large-scale cooperative 3D visual-inertial mapping in a Manhattan world[C]//IEEE International Conference on Robotics and Automation (ICRA). Stockholm, Sweden: IEEE, 2016: 1071-1078.

[56]LIU T J, LIN H, LIN W, et al. InertialNet: toward robust SLAM via visual inertial measurement[C]//IEEE Intelligent Transportation Systems Conference (ITSC). Auckland, New Zealand: IEEE, 2019: 1311-1316.

[57]HE Y J, ZHAO J, GUO Y, et al. PL-VIO: Tightly-coupled monocular visual-inertial odometry using point and line features[J]. Sensors, 2018, 18(4): 1159.

[58]TANSKANEN P, NAEGELI T, POLLEFEYS M, et al. Semi-direct EKF-based monocular visual-inertial odometry C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Hamburg, Germany: IEEE, 2015: 6073-6078.

[59]HARDTSTREMAYR A, WEISS S. Towards fully dense direct filter-based monocular visual-inertial odometry[C]//IEEE International Conference on Robotics and Automation (ICRA). Montreal, QC, Canada: IEEE, 2019: 4710-4716.

[60]BLOESCH M, BURRI M, OMARI S, et al. Iterated extended Kalman filter based visual-inertial odometry using direct photometric feedback[J]. The International Journal of Robotics Research, 2017, 36(10): 1053-1072.

[61]BLOESCH M, OMARI S, HUTTER M, et al. Robust visual inertial odometry using a direct EKF-based approach[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Hamburg, Germany: IEEE, 2015: 298-304.

[62]LI M, MOURIKIS A I. Improving the accuracy of EKF-based visual-inertial odometry[C]//IEEE International Conference on Robotics and Automation (ICRA). Saint Paul, MN, USA: IEEE, 2012: 828-835.

[63]SUN K, MOHTA K, PFROMMER B, et al. Robust stereo visual inertial odometry for fast autonomous flight[J]. IEEE Robotics and Automation Letters (RA-L), 2018, 3(2): 965-972.

[64]QIU X C, ZHANG H, FU W X, et al. Monocular visual-inertial odometry with an unbiased linear system model and robust feature tracking front-end[J]. Sensors, 2019, 19(8): 1941.

[65]LI M, MOURIKIS AI. High-precision, consistent EKF-based visual-inertial odometry[J]. The International Journal of Robotics Research, 2013, 32(6): 690-711.

[66]TSAO S, JAN S. Observability analysis and performance evaluation of EKF-based visual-inertial odometry with online intrinsic camera parameter calibration[J]. IEEE Sensors Journal, 2019, 19(7): 2695-2703.

[67]CHU C B, YANG S D. Keyframe-based RGB-D visual-inertial odometry and camera extrinsic calibration using extended kalman filter[J]. IEEE Sensors Journal, 2020, 20(11): 6130-6138.

[68]LI M, KIM B H, MOURIKIS A I, et al. Real-time motion tracking on a cellphone using inertial sensing and a rolling-shutter camera[C]//IEEE International Conference on Robotics and Automation (ICRA). Karlsruhe, Germany: IEEE, 2013: 4712-4719.

[69]ZHENG F, TSAI G, ZHANG Z, et al. Trifo-VIO: robust and efficient stereo visual inertial odometry using points and lines[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Madrid, Spain: IEEE, 2018: 3686-3693.

[70]ZHANG N, ZHAO Y J. Fast and robust monocular visua-inertial odometry using points and lines[J]. Sensors, 2019, 19(20): 4545.

[71]CAMPOSECO F, POLLEFEYS M. Using vanishing points to improve visual-inertial odometry[C]//IEEE International Conference on Robotics and Automation (ICRA). Seattle, WA, USA: IEEE, 2015: 5219-5225.

[72]XIA L L, MENG Q Y, CHI D R, et al. An optimized tightly-coupled VIO design on the basis of the fused point and line features for patrol robot navigation[J]. Sensors, 2019, 19(9): 2004.

[73]FORSTER C, CARLONE L, DELLAERT F, et al. On-manifold preintegration for real-time visual-inertial odometry[J]. IEEE Transactions on Robotics, 2017, 33(1): 1-21.

[74]MA S J, BAI X H, WANG Y L, et al. Robust stereo visual-inertial odometry using nonlinear optimization[J]. Sensors, 2019, 19(17): 3747.

[75]USENKO V, ENGEL J, STUCKLERJ, et al. Direct visual-inertial odometry with stereo cameras[C]//IEEE International Conference on Robotics and Automation (ICRA). Stockholm, Sweden: IEEE, 2016: 1885-1892.

[76]VON STUMBERG L, USENKO V, CREMERS D, et al. Direct sparse visual-inertial odometry using dynamic marginalization[C]//IEEE International Conference on Robotics and Automation (ICRA). Brisbane, QLD, Australia: IEEE, 2018: 2510-2517.

[77]WEN S H, ZHAO Y F, ZHANG H, et al. Joint optimization based on direct sparse stereo visual-inertial odometry[J]. Autonomous Robots, 2020, 44(99): 791-809.

[78]ZHU A Z, ATANASOV N, DANIILIDIS K, et al. Event-based visual inertial odometry[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA: IEEE, 2017: 5816-5824.

[79]REBECQ H, HORSTSCHAEFER T, SCARAMUZZA D, et al. Real-time visual-inertial odometry for event cameras using keyframe-based nonlinear optimization[C]//British Machine Vision Conference (BMVC). London, UK: Springer, 2017: 1-8.

[80]LI C S, WASLANDER S L. Towards end-to-end learning of visual inertial odometry with an EKF[C]//IEEE 17th Conference on Computer and Robot Vision (CRV). Ottawa, Canada: IEEE, 2020: 190-197.

[81]CHEN C, ROSA S, MIAO Y, et al. Selective sensor fusion for neural visual-inertial odometry[C]//IEEE/CVF Computer Vision and Pattern Recognition (CVPR). Long Beach, CA, USA: IEEE, 2019: 10542-10551.

[82]CLARK R, WANG S, WEN H K, et al. VINet: visual inertial odometry as a sequence to sequence learning problem[C]//AAAI Proceedings of the Thirty-First AAAI Conference on Artificial Intelligence (AAAI). San Francisco, California, USA: AAAI, 2017: 3995-4001.

[83]LINDGREN K, LEUNG S, NOTHWANG W D, et al. BooM-VIO: bootstrapped monocular visual-inertial odometry with absolute trajectory estimation through unsupervised deep learning[C]//IEEE 19th International Conference on Advanced Robotics (ICAR). Belo Horizonte, Brazil: IEEE, 2019: 516-522.

[84]SHAMWELL E J, LEUNG S, NOTHWANG W D, et al. Vision-aided absolute trajectory estimation using an unsupervised deep network with online error correction[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Madrid, Spain: IEEE, 2018: 2524-2531.

[85]SHAMWELL E J, LINDGREN K, LEUNG S, et al. Unsupervised deep visual-inertial odometry with online error correction for RGB-D imagery[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(10): 2478-2493 .

[86]HAN L M, LIN Y M, DU G G, et al. DeepVIO: Self-supervised deep learning of monocular visual inertial odometry using 3D geometric constraints[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Macau, China: IEEE, 2019: 6906-6913.

[87]OLEYNIKOVA H, BURRI M, LYNEN S, et al. Real-time visual-inertial localization for aerial and ground robots[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Hamburg, Germany: IEEE, 2015: 3079-3085.

[88]BURRI M, OLEYNIKOVA H, ACHTELIK M, et al. Real-time visual-inertial mapping, re-localization and planning onboard MAVs in unknown environments[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Hamburg, Germany: IEEE, 2015: 1872-1878.

[89]LYNEN S, SATTLER T, BOSSE M, et al. Get out of my lab: large-scale, real-time visual-inertial localization[C]//Robotics: Science and Systems (RSS). Romo, Italy: IEEE, 2015: 37.

[90]HUAI Z, HUANG G Q. Robocentric visual-inertial odometry[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Madrid, Spain: IEEE, 2018: 6319-6326.

[91]USENKO V, DEMMEL N, SCHUBERT D, et al. Visual-inertial mapping with non-linear factor recovery[J]. IEEE Robotics and Automation Letters(RA-L), 2020, 5(2): 422-429.

[92]YANG Z F, GAO F, SHEN S J. Real-time monocular dense mapping on aerial robots using visual-inertial fusion[C]//IEEE International Conference on Robotics and Automation (ICRA). Singapore: IEEE, 2017: 4552-4559.

[93]SONG B W, CHEN W D, WANG J C, et al. Long-term visual inertial SLAM based on time series map prediction[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Macau, China: IEEE, 2019: 5364-5369.

[94]SCHNEIDER T, DYMCZYK M, FEHR M, et al. Maplab: an open framework for research in visual-inertial mapping and localization[J]. IEEE Robotics and Automation Letters (RA-L), 2018, 3(3): 1418-1425.

[95]SHAN Z Y, LI R J, SCHWERTFEGER S. RGBD-inertial trajectory estimation and mapping for ground robots[J]. Sensors, 2019, 19(10): 2251.

[96]GENEVA P, ECKENHOFF K, LEE W, et al. OpenVINS: A research platform for visual-inertial estimation[C]//IEEE International Conference on Robotics and Automation (ICRA). Paris, France: IEEE, 2020: 4666-4672.

[97]LI S P, ZHANG T, GAO X, et al. Semi-direct monocular visual and visual-inertial SLAM with loop closure detection[J]. Robotics and Autonomous Systems, 2019: 201-210.

[98]JONES E, SOATTO S. Visual-inertial navigation, mapping and localization: A scalable real-time causal approach[J]. The International Journal of Robotics Research, 2011, 30(4): 407-430.

[99]CADENA C, CARLONE L, CARRILLO H, et al. Past, present, and future of simultaneous localization and mapping: toward the robust-perception age[J]. IEEE Transactions on Robotics, 2016, 32(6): 1309-1332.

(責任编辑:曾 晶)