基于深度学习与超分辨率重建的遥感高时空融合方法*

张永梅,滑瑞敏,马健喆,胡 蕾

(1.北方工业大学信息学院,北京 100144;2.香港理工大学电子与信息工程系,香港 00852; 3.江西师范大学计算机信息工程学院,江西 南昌 330022)

1 引言

受限于卫星传感器的硬件条件与发射成本,在可获取的单一遥感数据中,其空间分辨率和时间分辨率成为一对矛盾体[1 - 3],若想要尽可能地提高遥感影像的空间分辨率,结果则可能引发“时间数据缺失”[4],反之难免又会牺牲影像的空间分辨率,制约了遥感影像的应用。在早期发射升空的卫星传感器所得到的数据中这种表现尤为明显[5],造成了对一直以来积累下来的庞大数据难以直接利用。

多源遥感图像融合是指将不同传感器获得的同一场景的图像或者同一传感器在不同时刻获得的同一场景图像,经过相应处理后,再运用某种融合技术得到一幅合成图像的过程[6],其为解决上述遥感影像时空矛盾问题提供了一条出路,即遥感影像的时空融合方法。

传统的时空融合模型包括基于变换的模型和基于像元重构的模型[4]。基于变换的模型是指对遥感影像进行数据变换(如小波分解等)后,对变换所得数据进行融合处理,最后再进行反变换从而得到想要的未知时刻高分辨率影像。如Malenovsk等[7]利用小波变换对MODIS(MODerate-resolution Imaging Spectroradiometer)影像的低频信息和Landsat影像的高频信息进行融合,验证了MODIS与Landsat影像融合的可能性,但其所得结果的分辨率只达到了240 m,且在有变化发生的区域效果较差;基于像元重构的模型主要是将低空间分辨率图像进行像元分解,计算出不同时相上遥感影像的变化关系,同时还需求出不同分辨率影像间的变化关系,再通过插值得到未知时刻的高空间分辨率图像。如在时空融合领域影响最为深远的时空自适应反射率融合模型STARFM(Spatial Temporal Adaptive Reflectance Fusion Model)[8]属于基于像元重构的模型,该模型在融合过程中不仅考虑了空间的差异性,而且还考虑了时间的差异性,是目前应用最广泛的时空融合模型之一,但在地物覆盖复杂、像元混合严重时往往精度较差。

随着机器学习的蓬勃发展,基于学习的遥感影像时空融合模型应运而生,如赵永光等[9]提出了一种利用稀疏表示对低空间分辨率图像进行超分辨率重建,再对数据进行高通滤波后融合的方法,取得了良好的融合效果。但是,通常基于学习的模型使用浅层学习较多,同时方法复杂度较高,运行效率低,较难实现大区域的融合,且在空间分辨率上不宜相差过大,一般只有4倍左右[2]。

为了实现融合质量的进一步提升,本文选择将学习能力更强、特征提取更有力的深度学习方式引入遥感时空融合中。在现有基于学习的遥感影像时空融合的基础上,通过对SRCNN (Super Resolution Convolutional Neural Network)网络进行二次学习的方法来重建低分辨率图像。SRCNN网络结构简单,可以相对缓解本文方法复杂度的提升,而二次学习的方式可以缓解融合时分辨率差距过大的影响。本文基于STARFM的基本思想,在融合过程中采用神经网络自动提取特征,学习映射关系,代替原本在滑动窗口内筛选相似像元与计算其权重的过程。实验表明,本文方法改善了遥感影像时空融合的质量。

2 基于改进STARFM的遥感高时空融合方法

2.1 基于深度学习的超分辨率重建方法

由于衍射现象的存在,通常成像系统所能达到的最高分辨率受限于成像光学器件本身,传统改善图像质量方法难以复原出系统在截止频率以外的信息[10],而超分辨率重建SR(Super resolution Restoration)技术采用信号处理方法,能够重建出成像系统截止频率之外的信息,从而得到高于成像系统分辨率的图像[11]。

传统的超分辨率重建技术分为基于重建的方法和基于浅层学习的方法[12]。基于重建的方法将多幅低分辨率图像进行亚像素精度对齐来求出不同分辨率图像之间的运动偏移量,从而构建出空间运动参数,再通过各种先验约束条件与最优解来重建出高分辨率图像[13]。基于浅层学习的方法旨在通过学习获得高低分辨率图像之间的映射关系来指导图像的重建,通常分为特征提取、学习和重建3个阶段,且各阶段相互独立[14],导致浅层学习特征提取与表达能力有限,有待进一步加强。

近年来,深度学习技术发展迅猛。在超分辨率重建问题中使用深度学习网络,在结构上仍需参考传统超分辨率重建方法的思想进行设计,使其作为预测器能够输出较为准确的预测值[15]。

香港中文大学Dong等人[16]于2016年首次将卷积神经网络CNN(Convolution Neural Network)应用于超分辨率重建中,提出了一种新的网络SRCNN。首先从深度学习与传统稀疏编码SC(Sparse Coding)之间的关系入手,将网络分为图像块提取、非线性映射和图像重建3个阶段,使其分别对应于深度卷积神经网络框架中的3个卷积层,统一于该神经网络之中,从而实现了由低分辨率图像到高分辨率图像的超分辨率重建。该网络直接学习低分辨率图像和高分辨率图像之间的端到端映射,除了优化之外,几乎不需要预处理和后处理。

在SRCNN中使用的3个卷积层卷积核大小分别为9×9,1×1和5×5,前2个输出的特征个数分别为64和32。SRCNN将稀疏编码的过程视为一种卷积运算,网络设计简单,并且重建效果相比作为浅层学习代表的SCSR(Sparse Coding based Super Resolution)[17]方法也有较大改善,是一种具有参考性的超分辨率重建方法。本文将通过二次学习方式,将其引入遥感影像时空融合中,从而提高低分辨率遥感图像重建效果。

本文采用SRCNN方法对低空间分辨率数据进行超分辨率重建,以代替STARFM方法中低空间分辨率图像的重采样过程,然而由于本文使用的MOD09Q1遥感影像只有250 m空间分辨率,像元混合现象严重,而Landsat8遥感影像具有30 m空间分辨率,二者之间的分辨率相差8~9倍,描述空间细节信息的能力差距较大;并且由于得到遥感影像的不同传感器之间存在着各种差异(几何误差),使得图像之间即使同一时刻同一位置的像素反射率也有较大差异,故将SRCNN直接引入至遥感影像的时空融合比较困难。

基于学习模型的融合方法中影像之间的空间分辨率差距不宜过大,一般在4倍左右,差距过大容易造成深度学习神经网络的训练困难,对低分辨率图像进行分辨率增强的效果欠佳,像元混合严重的现象较难缓解。

为解决上述问题,本文选择了一种进行二次学习的方法,先将低空间分辨率遥感影像从250 m分辨率经过学习重建至90 m分辨率,再重建至30 m分辨率,从而保证了2次学习过程中分辨率差距均在4倍之内。超分辨率重建方法流程如图1所示。

Figure 1 Flow chart of the super-resolution reconstruction method图1 本文超分辨率重建方法技术路线

首先将具有30 m空间分辨率的Landsat8遥感影像使用最近邻法降采样到90 m分辨率,同时将具有250 m空间分辨率的MOD09Q1遥感影像使用双三次插值法重采样到90 m分辨率。如图2所示,经过采样后的遥感影像虽然形式上具有了相同的分辨率,但在空间细节上差距仍较大。本文使用SRCNN对采样后的2组数据进行第1次学习,得到90 m分辨率的MOD09Q1重建图像。将得到的90 m分辨率重建图像重采样至30 m分辨率,与具有30 m分辨率的Landsat8原始数据一起利用SRCNN进行第2次学习,得到具有30 m分辨率的MOD09Q1重建图像,本文将该重建图像作为时空融合模型中的低分辨率输入数据。

Figure 2 Comparison of MOD09Q1 and Landsat8 both converted to 90-meter resolution in the study area (2018.10.29)图2 研究区域(2018.10.29)不同传感器 采样至90 m分辨率的遥感影像对比图

传统STARFM方法的输入只将MODIS数据通过插值法重采样到Landsat8数据的分辨率即可,本文在使用SRCNN网络进行超分辨率重建时,将Landsat8数据作为MOD09Q1数据的先验知识进行学习,一方面超分辨率重建的精度明显优于插值法重采样结果,提升了STARFM的输入质量;另一方面,在学习过程中,能够缓解由不同传感器所造成的各种误差,使重建得到的图像在风格与相似性上也与作为输入的高分辨率图像更加接近。故该方法能够尽可能还原出高低分辨率数据之间原本的差异信息,使得融合结果更加准确。

本文进行二次学习的2个SRCNN网络具有相同的结构,区别只在于输入和输出不同,而且输入和输出的不同之处只体现在分辨率上,SRCNN网络的训练过程通过图像切块进行,故二次学习的2个网络参数格式具有完全一致性,可以将训练好的用于第1次学习的网络参数迁移到用于第2次学习的网络中,提高运行效率,缓解深度学习所带来的时间复杂度的升高。

本文重建方法提高了高时间分辨率、低空间分辨率数据的空间分辨率,已得到了一定精度的高时空分辨率数据,再将其输入本文的改进STARFM方法中,相当于进行了双层时空融合,从而保证了较好的融合效果。

2.2 时空自适应反射率融合模型

Gao等[8]提出的STARFM方法是遥感影像时空融合领域应用最广泛的一种方法。该方法在忽略几何误差和大气校正误差的情况下,假设低空间分辨率(如MODIS)像元的反射率可以表示为高空间分辨率(如Landsat)对应像元反射率的线性组合。此时如果将低空间分辨率的遥感影像重采样到分辨率相同的高分辨率遥感影像,则低空间分辨率像元与高空间分辨率对应位置像元存在如下关系:

M(x,y,t)=L(x,y,t)+ε

(1)

其中,M(x,y,t)、L(x,y,t)分别表示在t时刻MODIS影像和Landsat影像在坐标为(x,y)处像元的反射率,ε表示不同分辨率图像由于传感器不同等所造成的系统误差。假设该ε不随时间变化,若已有t0和tk时刻的MODIS数据,以及t0时刻的Landsat数据,则未知的tk时刻的MODIS数据可由式(2)求得:

L(x,y,tk)=

L(x,y,t0)+M(x,y,tk)-M(x,y,t0)

(2)

STARFM方法为避免假设所带来的像元混合现象,通过滑动窗口技术引入了邻近像元信息,即:

(L(xi,yj,tk)+M(xi,yj,t0)-M(xi,yj,tk))

(3)

其中,w是滑动窗口大小,n表示不同时间点的摇感影像进行融合的数量,wi,j,k为相应位置处像元对应的权值大小。在STARFM方法中,还需对上述滑动窗口中的相似像元进行搜索,并排除劣质像元,只有筛选得到的像元才配置非零权重,而在对筛选后相似像元配置权重时,需要综合考虑像元间的光谱距离Si,j,k、时间距离Ti,j,k和空间距离Di,j,k等,其计算公式分别如下所示:

Si,j,k=|L(xi,yj,tk)-M(xi,yj,tk)|

(4)

Ti,j,k=|L(xi,yj,t0)-M(xi,yj,tk)|

(5)

(6)

Di,j,k=1.0+di,j,k/A

(7)

其中,A是一个常量,定义了Si,j,k、Ti,j,k与Di,j,k之间重要程度的比例。该相似像元的权重wi,j,k计算公式为:

wi,j,k=Si,j,k×Ti,j,k×Di,j,k

(8)

或

wi,j,k=ln(Si,j,k×B+1)×

ln(Ti,j,k×B+1)×Di,j,k

(9)

其中,B是取决于传感器分辨率间差距的比例因子。求出滑动窗口内所有筛选后相似像元权重wi,j,k后,再对其进行归一化处理,即可求得联合权重矩阵W,从而预测出未知时刻高分辨率遥感影像像素的分辨率。

由于MODIS影像和Landsat影像间分辨率差距过大,在重采样的过程中像元混合严重,制约了STARFM方法预测的准确率[9],本文将引入改进的SRCNN来克服这一现象,提高时空融合的质量。

另外,STARFM在引入滑动窗口技术时权重的计算取决于光谱距离、时间距离与空间距离的组合,可视为一种根据专家经验知识提取的手工特征。本文基于STARFM的基本思想,采用SRCNN作为基本框架,利用神经网络来自动计算该特征,充分利用深度学习强大的特征提取与表达能力,进一步提高时空融合的质量。

3 实验结果与分析

3.1 研究区域及数据源

本文选择在遥感时空融合领域中经典的MODIS和Landsat数据进行融合,充分利用二者分别在时间分辨率和空间分辨率上的优势。MODIS数据选择了空间分辨率为250 m、重访周期为1天的MOD09Q1(8天合成数据)的第1波段红色波段和第2波段近红外波段数据;Landsat数据选取了空间分辨率为30 m、重访周期为16天的Landsat8相应的第4、5波段[18],所举图例均以红色波段实验数据作为代表。本文的研究区域位于陕蒙交界一带,地理坐标38°47′59″N ~ 39°12′5″N,110°20′35″E ~ 110°49′6″E,实验截取的地理范围为45 km×45 km。

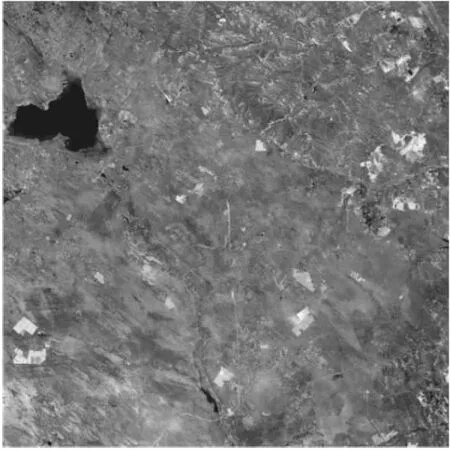

本文实验所用数据均来源于NASA官网USGS (https://earthexplorer.usgs.gov/),选取了2015年~2019年该研究区域内所有云量少于1%的数据。使用MCTK (MODIS Conversion Toolkit)工具将MODIS数据从HDF数据格式转换为TIF数据格式,并重投影到UTM-WGS84坐标系,所有数据均使用ENVI软件根据对应坐标裁剪到指定区域并进行配准。从图3可以看到,低分辨率的MOD09Q1影像在部分地区像元混合现象较严重。从图4可以看到该研究区域地物类型复杂,包括水体、山脉、沙地、林地、耕地、建筑物、道路等,且部分地物相间分布。该研究区域属于使用传统时空融合方法较难处理的类型。

Figure 3 Comparison of MOD09Q1 and Landsat8 in the study area (2018.10.29)图3 研究区域(2018.10.29)不同传感器遥感影像对比图

Figure 4 Landsat8 true color image in the study area (2019.04.23)图4 研究区域(2019.4.23)Landsat8真彩色遥感影像图

3.2 实验方法

3.2.1 超分辨率重建实验方法

传统SRCNN在处理自然图像时是一种单幅图像超分辨率重建技术,即样本和标签是基于同一幅图像变换所得,在训练之前先将样本图像进行降采样得到分辨率仅为原始图像1/3的低分辨率图像;再将该降采样图像使用双三次插值法放大至原样本图像尺寸,此时仍视其为低分辨率图像,并作为SRCNN的输入样本。在进行训练时,SRCNN将没有经过降采样处理的原样本图像作为高分辨率先验知识进行学习,再把训练得到的网络作用于相同类型的测试集图像上进行检测[16]。

本文在引入SRCNN时,进行了2种尝试。以上述第1次学习为例,方法1是直接使用高分辨率遥感影像进行单幅图像超分辨率重建,即使用上述传统的SRCNN只训练降采样后的90 m分辨率Landsat8图像这一组数据,再将所得到的网络作用于同一时刻同一地区的低分辨遥感影像,即经过重采样的90 m分辨率MOD09Q1数据,对比90 m分辨率的Landsat8数据检测实验结果;方法2是使用已有的高分辨率图像作为同一时刻同一地区的低分辨率图像的先验知识进行学习,本文采用经过采样后所得同为90 m分辨率的Landsat8图像和MOD09Q1图像2组数据来训练SRCNN,通过该网络可以得到重建后90 m分辨率的MOD09Q1图像,同样对比降采样的90 m分辨率Landsat8数据检测实验结果。

在测试集上得到的实验结果对比图如图5所示(像素数没对应是由于外围元素卷积运算时不填充),从中可以看到,同样以MOD09Q1数据信息作为基础,相比方法1,方法2所得图像在风格上与Landsat8数据更为接近。本文采用均方误差MSE(Mean Squared Error)作为损失函数来训练SRCNN。实验结果中方法1的MSE值为0.087 575 69,方法2的MSE值为0.042 040 63,方法2相比方法1的实验结果具有更丰富的空间细节信息。

Figure 5 Comparison of restructed images with 90-meter resolution by different methods in the study area (2015.7.1)图5 研究区域(2015.7.1)不同方法重建得到 90 m分辨率的实验结果对比图

本文使用方法2在第1次学习后得到了具有较高质量90 m分辨率的MOD09Q1重建图像,将该图像重采样至30 m分辨率后,再次利用SRCNN网络使用方法2进行第2次超分辨率重建。本次重建使用30 m分辨率的原始Landsat8遥感影像作为其先验知识,得到如图6c所示30 m分辨率的第2次超分辨率重建结果。对比相应的Landsat8数据,其MSE值为0.029 617 50。本文将该结果作为STARFM模型中低分辨率遥感影像的输入。

图6所示为本文通过二次学习进行超分辨率重建得到的实验结果与原始数据对比图,从中可以看到,图6a~图6d空间细节逐渐丰富。从整体角度来看,可以认为实验是以图6d作为图6a的先验知识训练神经网络的,中间先经过图6b最终得到图6c。图6d作为先验知识空间细节信息最为丰富,但时间分辨率为16天,而实验得到的图6c在空间细节上仅次于图6d,且时间分辨率只有1天,本文将其与图6d进行时空融合,可以得到时间分辨率为1天、空间细节信息更为丰富的合成影像,进一步提升了遥感影像时空融合的精度。

Figure 6 Comparison of original data and reconstructed results in the study area (2018.10.29)图6 研究区域(2018.10.29,红色波段) 实验数据与实验结果对比图

3.2.2 时空融合实验方法

STARFM作为应用最为广泛的时空融合模型,其基本原理经过众多实际应用的考验,证实了其正确性与优越性,并且在该过程中,其所存在的一些不足也被学者们加以改善。本文在3.2.1节通过二次学习使用SRCNN进行超分辨率重建的方法,改善了其在低空间分辨率数据重采样过程中像元混合严重所导致的精度不足现象。本文采用SRCNN作为基本框架,通过深度学习神经网络方法来提取图像特征,发现并学习高低分辨率数据之间的映射关系。

STARFM的基本思想就是利用已知时刻的高低空间分辨率数据和未知时刻的低空间分辨率数据来对未知时刻的高空间分辨率数据进行预测,如式(2)所示。STARFM在具体实现时为了减轻像元混合现象的影响,通过滑动窗口技术引入邻近像元信息来计算中心像元的反射率,根据特定规则筛选出相似像元,并排除劣质像元,根据图像对间的光谱距离、时间距离以及窗口内部的空间距离由特定的公式来计算出像元对应的权重,得到滑动窗口的权值矩阵[8]。

STARFM在实现过程中无论是在滑动窗口内筛选或排除像元时所用的规则,还是计算权重时所用的特定公式,都属于专家知识范畴,即手工提取的特征。本文采用神经网络进行深度学习来替代该过程,实现特征的自动提取。

基于STARFM的基本思想,在已知t0时刻高分辨率数据与tk时刻低分辨率数据时,通过式(2)计算所得到的数据可视为预测理论值,本文将其作为学习样本,并将对应时刻的高分辨率实际数据作为标签,输入SRCNN中进行训练,即可学习得到预测理论值与实际标签间所存在的映射关系。STARFM所使用的滑动窗口计算方法也是对该映射的一种直接计算方式。

图7a为STARFM方法融合所得预测结果,本文使用上述网络进行实验,得到的实验结果如图7b所示。

Figure 7 Comparison of fusion images by STARFM and the proposed method in the study area (2018.10.29)图7 研究区域(预测2018.10.29,红色波段) STARFM融合方法与本文改进融合方法对比图

从图7中可以明显看出,原先在MOD09Q1及其重建图像中只显示为图像斑块的地方(像元混合严重),融合结果具有了与Landsat8原始影像相同的空间细节信息,预测结果对比真实结果MSE值为0.008 333 66。实验中图7a与图7b都是基于同样的数据进行融合,即低分辨率图像均经过本文2.1节超分辨率重建处理。可以看到,使用手工特征的STARFM方法融合预测的结果虽然也明显呈现了更多的空间细节,图像风格也与Landsat8数据更加接近,但在部分区域图像斑块仍然较多,在细节上与本文的实验结果(图7b)仍有一定差距,其作为融合预测结果与真实数据相比的MSE值为0.017 497 47。故采用神经网络自动提取特征的方法相比利用滑动窗口手工提取特征的方法提升了融合质量。

3.2.3 实验结果与分析

本文已经从主观评价的角度对实验结果进行了分析。此外,本文采用峰值信噪比PSNR(Peak Signal-to-Noise Ratio)和结构相似性SSIM(Structural Similarity Index)作为客观评价指标来对实验结果进行进一步分析,其计算公式分别如下所示:

(10)

(11)

其中,MSE(f1,f2)表示2幅图像的均方误差,μ1、μ2、σ1、σ2分别表示2幅图像的均值和方差,σ12表示2幅图像间的协方差,C1、C2是用来维持稳定的常数。

PSNR是一种应用非常广泛的图像客观评价指标,PSNR越大表示图像的失真越小,然而其作为一种基于误差敏感的图像质量评价指标,并未考虑到人眼的视觉特性(人眼对空间频率较低的对比差异敏感度较高,对亮度对比差异的敏感度较色度高,对一个区域的感知结果会受到其周围邻近区域的影响等),因而经常出现评价结果与人的主观感觉不一致的情况。而SSIM分别从亮度、对比度和结构3方面来度量图像相似性,SSIM值越大表示图像相似性越高、失真越小,故本文采用PSNR和SSIM来衡量实验结果的优劣。

表1给出了本文的客观指标评价结果。对比第2~4行数据可知,在重建至中间分辨率时,使用的2种重建方法的PSNR差距不大,但在SSIM上方法2优势明显。通过对比第5行数据和第6行数据可知,本文采用的通过二次学习方式进行SRCNN重建方法相比STARFM所使用的简单重采样方法,PSNR和SSIM都高,尤其是在SSIM上提升效果显著。通过对比最后2行数据可知,本文采用SRCNN自动提取特征进行融合的方法相比STARFM使用滑动窗口技术人工提取特征进行融合的方法,PSNR和SSIM都高,融合效果更好。通过对比客观评价指标,表明本文改进方法提高了遥感数据时空融合的质量。

Table 1 Objective evaluation results表1 客观指标评价结果

4 结束语

本文对传统STARFM方法进行了2点改进,一方面基于学习的时空融合模型方法,对低空间分辨率数据进行超分辨率重建来代替原来的直接重采样方法。本文为了缓解分辨率差距过大的影响,通过二次学习方式,利用SRCNN网络实现了低空间分辨率数据的超分辨率重建,并且在重建过程中使用了不同传感器的高分辨率数据作为先验知识,丰富了低分辨率图像的细节信息。另一方面,本文基于STARFM的基本思想,以SRCNN作为框架,在融合过程中采用深度学习自动提取特征,相比原来利用滑动窗口手工提取特征的方法,明显改善了融合质量。

本文提出的基于深度学习和超分辨率重建的时空融合方法,虽然取得了良好的融合结果,但算法时间复杂度较高。在进行超分辨率重建时,本文选取了网络设计相对简单的SRCNN,避免了其它更为复杂的网络,在保证重建质量的前提下不再提升复杂度。本文下一步将深入研究SRCNN的并行化方法,尝试将2次超分辨率重建过程融入到深度学习中,并完善端到端的训练网络,以降低本文方法的时间复杂度。

本文在进行具体的时空融合时使用了神经网络自动提取特征,学习从预测理论值到对应标签间的映射关系,前期虽然需要付出较多的时间成本进行学习,但在学习到映射关系后即可快速得到需要进行融合预测的图像。相对而言,传统STARFM方法虽然不需要前期学习的时间成本,但每次进行融合预测时都需要复杂度较高的大量计算,理论上,如若需要融合预测大量的数据,本文方法在时间复杂度上相对而言具有优势。