基于图文融合的社交媒体反讽识别

林敏鸿 蒙祖强

摘要:文本与图片相结合的多模态内容在社交媒体上变得越来越常见。多模态数据包含了更为全面的信息,能更好地理解用户的真正想表达的意图。对多模态数据的反讽识别研究也受到了越来越多的关注。本文提出了一种基于深层语义融合的多模态反讽识别方法。通过实验证明了,本文的模型在各项指标上都要优于传统的单模态的反讽识别模型。

关键词:社交媒体;反讽识别;多模态融合

中图分类号:TP393 文献标识码:A

文章编号:1009-3044(2020)24-0185-02

1引言

在社交媒体上,人们喜欢采用多种多样的修辞方法来丰富自己的语言表达。反讽就是最常见的修辞方法之一。这种方式真正要表达的信息往往与字面理解的意涵的相反,通常需要更多的语境信息来辅助理解。反讽识别是一种隐式情感分析,对观点挖掘,舆情分析等任务中都有着重要的意义。反讽识别最初是针对文本数据的研究。而随着信息技术的发展,人们可以很方便地在社交媒体上运用图片、音频以及视频等多种多样的方式进行表达。文本与图片相结合的多模态内容在社交媒体上变得越来越常见。对多模态数据的反讽识别研究也受到了越来越多的关注。为了更好地對多模态数据进行反讽识别,本文提出了一种基于深层语义融合的多模态反讽识别方法(Multimodal irony recognition method based on deep semantic fusion, MIRM)。该方法构造了两个神经网络模型来提取图像特征和文本特征,然后采用双线性融合的方法来获取图像和文本的联合特征表示,并对其进行是否含有反讽表达的判断。最后实验表明,该方法在各项指标中都优于传统的对单一文本数据的反讽识别。

2基于图文融合的反讽识别

2.1特征表示

本文方法采用双向门控单元(Bi-directional Gated Recurrent Unit, BiGRU)网络来获取文本特征表示。在BiGRU网络中,t时刻的隐藏层输出状态为[ht],由前向隐藏层输出状态[ht,]和后向[ht]隐藏层状态输出拼接得来,将其作为第i个文本中第t个单词的向量表示。然后对每个词向量进行注意力加权计算来获取文本的特征表示。具体的计算过程如公式1和公式2所示。

最后,需要对模型进行文本情感分类的预训练,让参数[W1]和向量[b1]在训练过程中不断优化更新,得到有效的注意力权重参数和能够有效提取文本情感特征表示的文本特征提取网络。

另外,在本模型中,采取卷积网络提取图像特征表示。该网络的卷积部分的选择VGGNet16的预训练模型的卷积层。我们将第i个图像数据的最后一层的卷积输出经过了平均池化之后的特征图集合记为[Fi={F1i,F2i,…,FNi}]。每个[Fli]都是图像[Ii]的一个局部特征图,但每个特征图对当前网络的图像情感表征学习并不是同等重要的。因此,需要学习重要性度量来区别各个特征图的重要程度。在本章中,特征图的注意力的权重计算如下:

权重矩阵W与偏置b都是可随网络训练学习的参数。[tanh (?)]是一个非线性函数。[Fli]通过一个全连接层计算得到对应的注意力分数[sli]。[sli]经过归一化计算得到对应的注意力权重[αli]。然后对每个特征图进行加权计算得到加权特征图[Flai],经过一层全连接层后得到最终的图像特征表示[Vi]。与文本特征提取网络一样,没有经过训练的注意力模块是没有意义的,因此我们同样需要对网络进行图像情感分类的预训练以获得真正有效的图像情感特征提取模型。

2.2特征融合

本文将图像特征和文本特征采用双线性融合[2]策略来获取图像和文本的联合特征表达。第i个图片的特征表示为[Vi],第i个文本的特征向量为[Ti],则文本和图像的联合特征表示[Zi]为

2.3分类器

本文构建了一个包含了两层全连接网络和一个softmax层的分类器,以获取分类的概率分布。分类器的输入是联合特征向量[Zi],而输出是该图文数据类别的概率分布向量。向量的第0位表示该数据被判断为0类(无反讽表达)的概率,第1位表示被判断为1类(有反讽表达)的概率。

3实验与讨论

本文采用的实验数据集是一个公开的多模态反讽识别数据集,将其记作TwittersSarcasm数据集[1]。数据集中包含了10560个正例数据,14075个反例数据。另外还采用了图像情感分类数据集和文本情感分类数据集作为图像特征提取和文本特征提取网络的预训练数据集。一个是Twitter_img图像情感数据集。总共包含了8443张情绪积极的图片和2256张情绪消极的图片。另一个是Analytics Vidhya机构提供的Twitter文本情感分析数据集Twitter_text,其中包含了73221条情绪消极的文本与58659条情绪积极的文本。

本模型需要对特征提取网络进行预训练。在图像特征提取网络和文本特征提取网络之后各添加一个分类器,构成图像分类模型和文本分类模型。然后让该图像分类模型在Twitter_

img情感数据集上进行图像情感分类训练,以对网络中注意力计算层的参数进行微调,使得网络能自觉关注情感语义相关图像区域。同时,让文本分类模型在Twitter_text数据集上进行文本情感分类训练,使得网络能有效提取情感语义信息。由此得到图像特征提取网络和文本特征提取网络的预训练模型。

为了验证模型的有效性,本文构造了多个文本分类模型,同时对多模态图文反讽数据集TwittersSarcasm进行了实验。比较模型如下:

BiGRU模型是处理文本分类问题最常用的模型之一,在此用于对文本数据的反讽识别。

BiGRU-ATT模型是在BiGRU模型基础上增加注意力加权的文本反讽识别模型。

TextCNN模型是用卷积神经网络对文本进行分类的经典卷积结构。

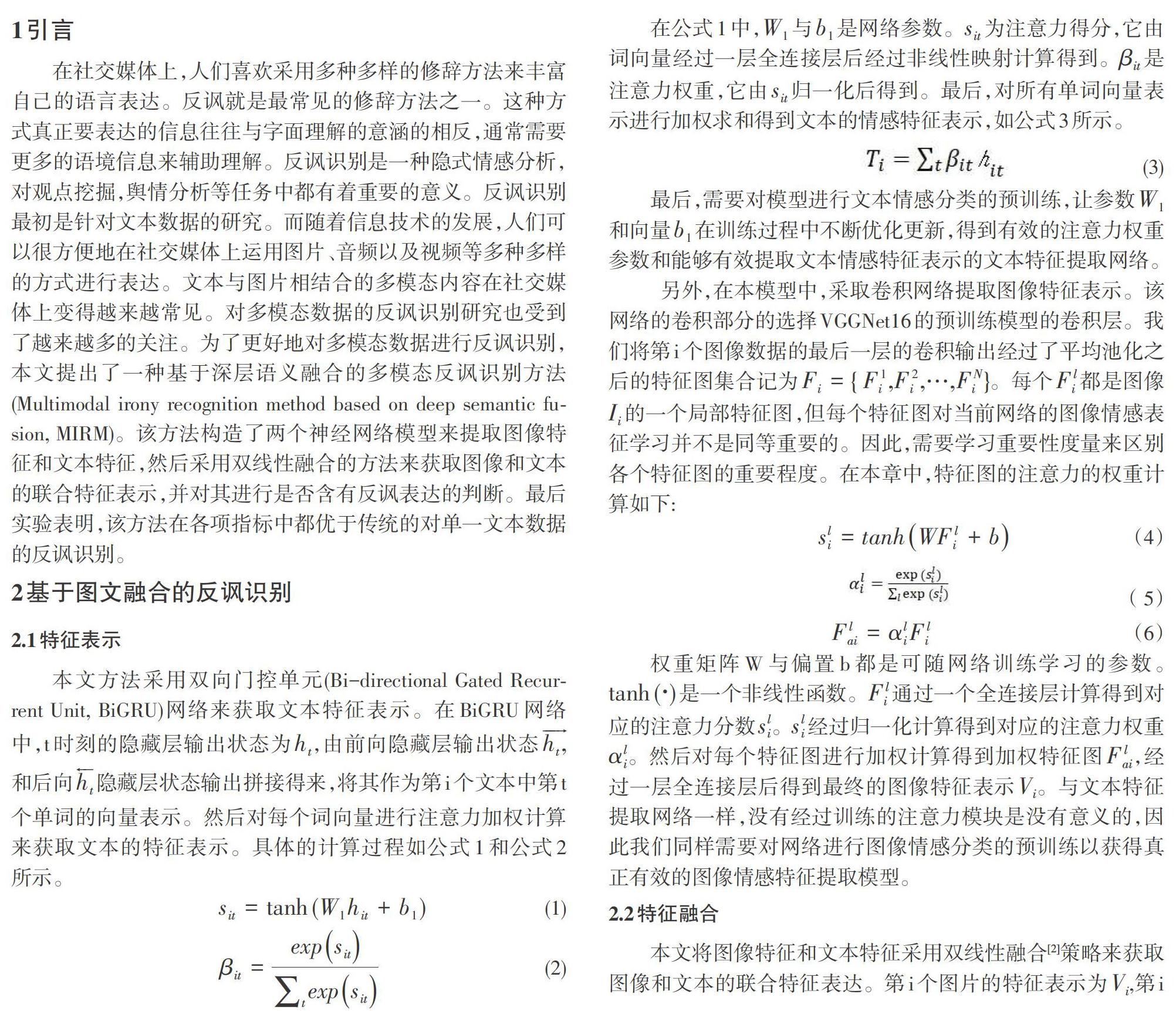

本文采用精确率(Precision)、召回率(Recall)、F1值(F1 score)和准确率(Accuracy)作为模型的评价标准。各模型在反讽数据集TwittersSarcasm的实验结果如表1所示。结合图文数据进行反讽识别的模型MIRM相较于仅对文本数据进行反讽识别的TextCNN模型、BiGRU模型和BiGRU-ATT模型效果都要好。本文所提出的模型相比于文本分类模型BiGRU和TextCNN,准确率提高了4%和3.5%。这也证实了相比单一的文本数据,结合图文信息能更好地理解反讽表达。

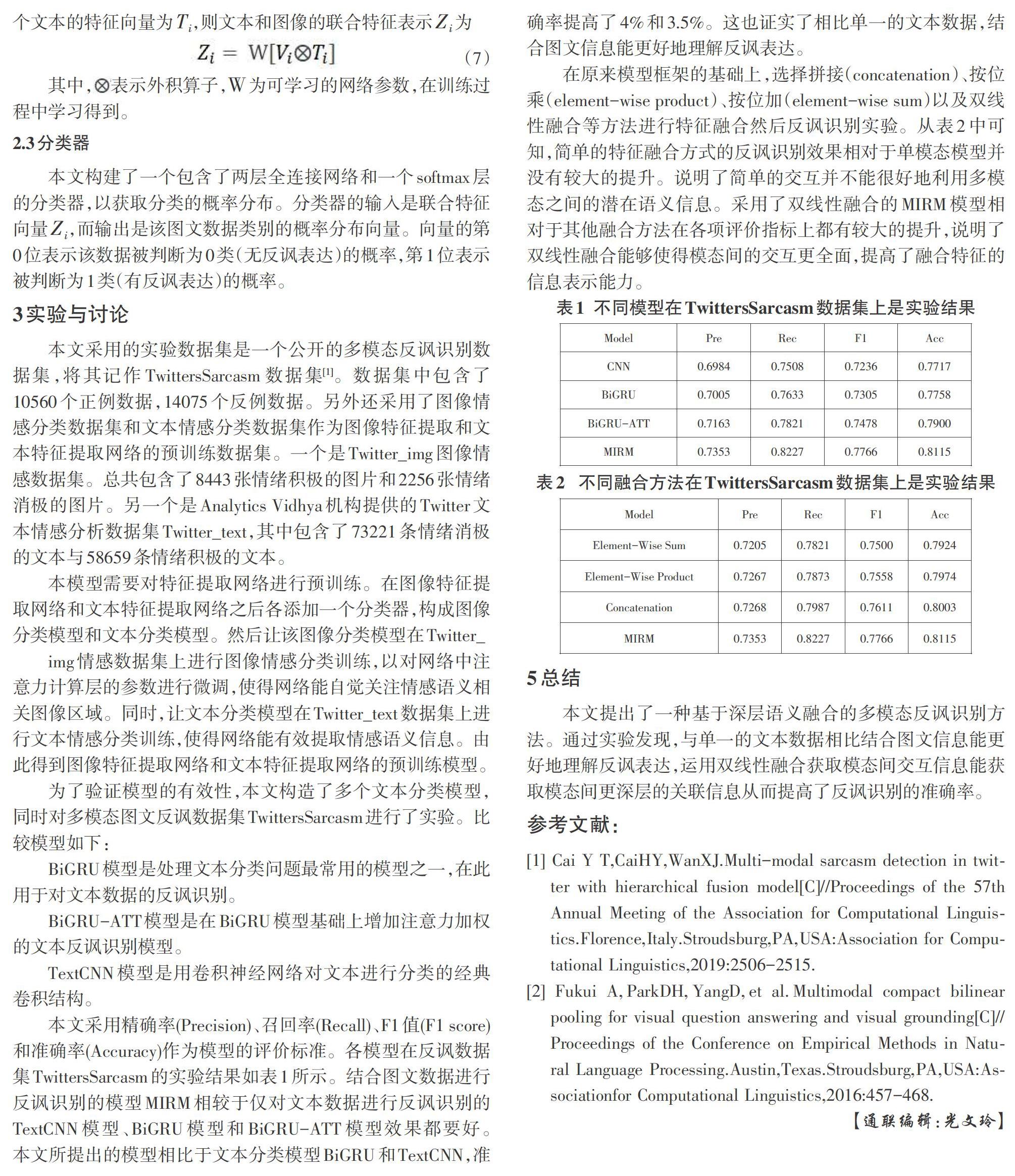

在原来模型框架的基础上,选择拼接(concatenation)、按位乘(element-wise product)、按位加(element-wise sum)以及双线性融合等方法进行特征融合然后反讽识别实验。从表2中可知,简单的特征融合方式的反讽识别效果相对于单模态模型并没有较大的提升。说明了简单的交互并不能很好地利用多模态之间的潜在语义信息。采用了双线性融合的MIRM模型相对于其他融合方法在各项评价指标上都有较大的提升,说明了双线性融合能够使得模态间的交互更全面,提高了融合特征的信息表示能力。

5总结

本文提出了一种基于深层语义融合的多模态反讽识别方法。通过实验发现,与单一的文本数据相比结合图文信息能更好地理解反讽表达,运用双线性融合获取模态间交互信息能获取模态间更深层的关联信息从而提高了反讽识别的准确率。

参考文献:

[1] Cai Y T,CaiHY,WanXJ.Multi-modal sarcasm detection in twitter with hierarchical fusion model[C]//Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics.Florence,Italy.Stroudsburg,PA,USA:Association for Computational Linguistics,2019:2506-2515.

[2] Fukui A,ParkDH,YangD,et al.Multimodal compact bilinear pooling for visual question answering and visual grounding[C]//Proceedings of the Conference on Empirical Methods in Natural Language Processing.Austin,Texas.Stroudsburg,PA,USA:Associationfor Computational Linguistics,2016:457-468.

【通聯编辑:光文玲】