德国FAKIN小型科研机构的科研数据管理方案

周 雷,杨 萍

随着科学研究第四范式的到来,科研数据已成为推动科技发展、社会进步的重要战略资源,这使得如何管理科研数据逐渐成为学术界的重要命题。近年已经产生大量研究成果:从应用场景看,主要为高校等大型科研机构;从操作视角看,主要以图书馆的科研数据管理服务为主;而面向中小型科研机构和以科研人员为视角的科研数据管理工作研究较少。德国FAKIN 小型科研机构科研数据管理方案(以下简称“FAKIN方案”)来自德国教研部(BMBF)最新科研数据管理项目16FDM007[1],以中小型机构科研人员日常数据管理为基础,将日常管理所用到的科研数据整理、元数据使用、数据清理、数据出版分享等具体方法集为一体,具有较强的实践性和应用性。本文以该项目成果为研究对象,旨在为机构科研数据管理服务提供参考。

1 文献综述

目前科研数据管理研究很多,主要分为3个方向。(1)以数据为主体视角的数据生命周期模型研究。数据生命周期模型是规划监护活动并抽象描述数据监护活动各个阶段的概念框架[2],如美国地质勘探局科研数据生命周期模型、英国牛津大学科研数据生命周期模型、数字监管中心监管生命周期模型[3]。各模型虽然在具体结构和细节上有所区别,但阶段划分较为类似,从机构应用角度也基本以这些成熟模型为基础[4]。(2)以图书馆为主体视角的科研数据管理服务研究。其中,以机构政策、数据权益为代表的科研数据管理理论机制研究、以调查比较为主的科研数据管理服务实践研究和以平台建设为主体的科研数据管理服务应用技术研究,是目前研究的重点。(3)以专业学科领域为主体视角的科研数据管理研究,主要以学科基础科研数据建设为主,如学科元数据标准[5]、基础数据建设规范[6]、学科科研数据汇交方案[7]。从科研数据管理具体工作来看,科研数据管理是一项沿数据生命周期并且在周期上每个结点都有具体工作流程、数据能反复溯源的一系列操作,具体包括数据采集、清洗、元数据使用、数据管理、数据质量控制、数据出版和引用等。但从以往研究看,科研数据管理往往侧重于图书馆等机构运营策略及服务的构建以及专业元数据标准的建立,而对于整体科研数据管理的具体工作方案却较为欠缺。

2 FAKIN方案的制定背景及原则

2.1 制定背景

德国最早的科研数据政策一般认为是德国研究联合会(DFG)1998年出台的《确保良好科学实践的建议》,科研数据管理最初目的是保证科学研究的严谨和规范[8]。随着科技发展和信息时代到来,在开放科学推进下,科研数据有了更多用途。2010年德国科学组织联盟(ADW)通过《科研数据处理原则》,明确科研数据不仅是良好科学实践的保障,更对未来科学研究具有较高价值[9]。此后,众多科研数据基础应用项目陆续展开。2014年底,德国高校校长联席会议(HRK)明确大学需要对科研数据进行管理[10],科研数据开始向机构层面实施推进。FAKIN科研数据管理方案也来自同期项目成果之一,制定的目的在于,科研数据管理不仅是一些大型科研机构、基础研究所必须,也是一些规模较小科研机构提升工作连贯性、加强科研质量的要求。这些科研机构的研究往往更加具体、集中,更容易进行数据汇交和关联,更容易体现科研数据管理对于数据价值的提升。

2.2 制定原则

FAKIN项目由柏林水技术中心有限公司(KWB)执行,始于2017年,历时2年。制定原则为:从机构性质角度看,小型科研机构是该项目的主要服务对象。这些机构通常没有独立的IT部门,一般也缺少专门致力于数据管理或相关领域的员工,数据处理一般根据个人技能进行。从内容角度看,FAKIN方案是基于项目最佳实践经验的总结,说明项目成果对不同机构具备可复制性。因为有益的实践可以在将来的项目中使用,甚至可以作为整个研究机构的标准,也符合当前科研数据管理自下而上制定的规律特征。从制定机构属性看,KWB 是非营利性的水技术研究中心,2018年有员工35人,承包合同32项,总额860万欧元,其中近40%来自德国各部委和欧盟基金项目,科研论文产出17篇[11],可见该机构具备小型科研机构的特点,主业以公共科研项目为主,实践经验具有普适性。

3 FAKIN方案主要内容及其结构功能特点

3.1 主要内容

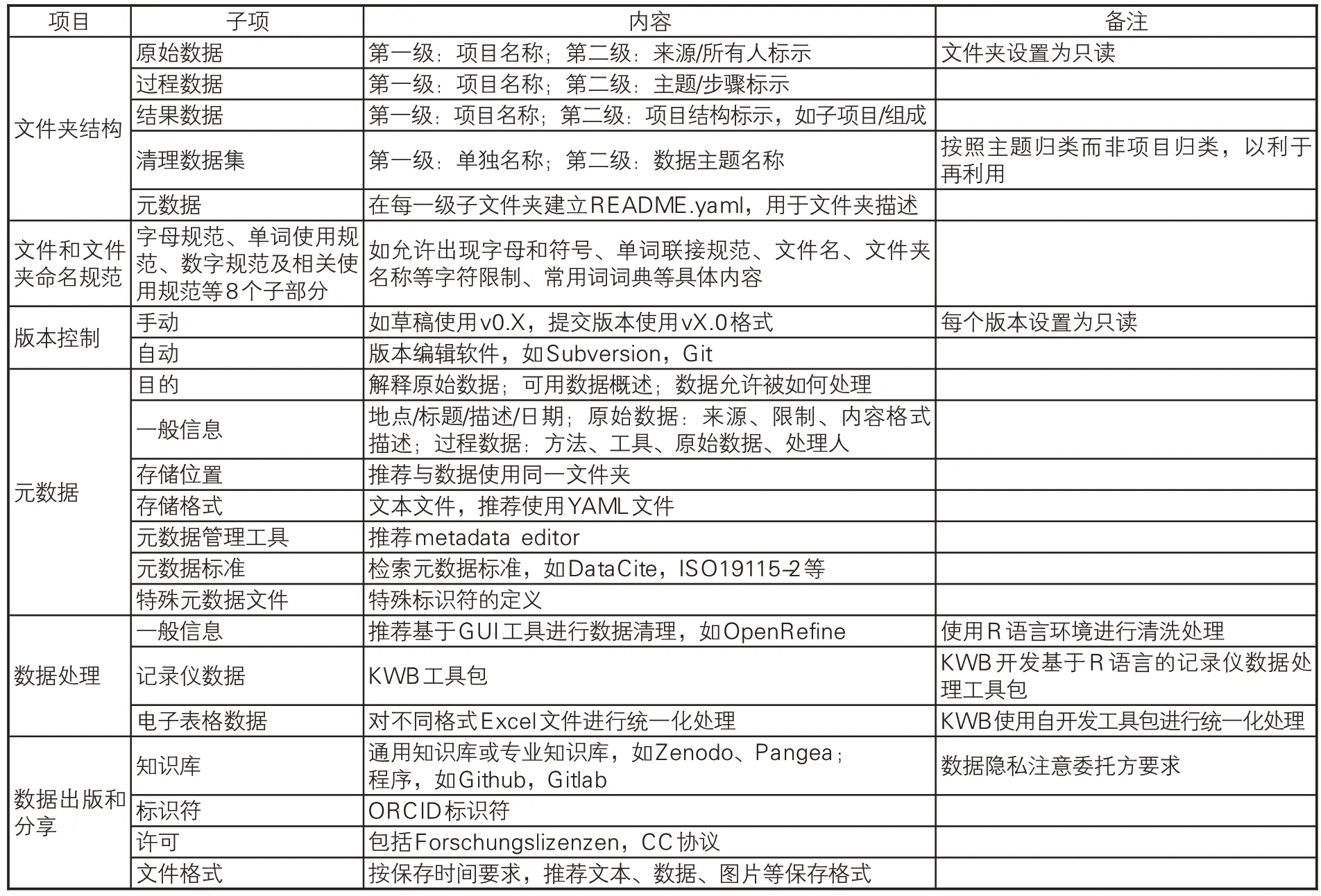

FAKIN方案分为6个部分:文件夹结构、文件和文件夹命名规范、版本控制、元数据、数据处理和数据出版与分享。每部分又针对具体细节再细分[12]。从总体数据结构看,FAKIN方案将数据分为3 部分:原始数据、过程数据和结果数据,符合一般科研项目流程。从涵盖内容看,FAKIN方案较细致和具体,如在文件命名、常用词典、元数据使用等方面都有较为详细的规范,易于操作,见表1。

表1 德国FAKIN方案主要内容

3.2 结构功能

科研数据管理方案的内容应该服务于方案的功能定位。首先,科研数据管理方案是科研数据管理具体工作/操作的集合,所以科研数据管理方案首先应具备全面性;其次,科研数据管理的目的是,以数据管理的形式,发现和利用数据,达到数据服务的增值、数据价值的升值,所以科研数据管理方案也应具备可溯源性和质量控制特性。

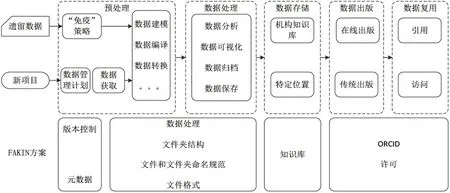

(1)全周期覆盖。科研数据管理方案应满足科研数据管理整个周期的工作。本文使用Wissik等提出的科研数据工作流程模型[13](以下简称“工作流程模型”)作为分析框架进行研究。该框架源自奥地利科研和经济部(BMWFW)资助的“go!digital”项目,工作流程模型认为科研数据管理主要包括5 个部分,即数据预处理、数据处理、存储、出版和复用,如图1上半部分所示。该流程在开始阶段增加两个场景即新项目和遗留数据(项目结束后的数据,原有设计不足可能会导致这些数据丢失或无法再利用)。在FAKIN 方案中,“版本控制”为遗留数据的“免疫”提供了具体方法,“元数据”中“目的”和“一般信息”则为原始数据提供数据源、类型等静态信息,以及允许何种操作、如何处理等动态信息,保证遗留数据在未来加工的可能性;而对于“新项目”场景——数据管理计划,“元数据”中的“目的”“一般信息”,以及“存储位置”“存储格式”部分基本可以涵盖数据管理计划所涉及的相关信息,如项目数据如何管理、描述、分析和存储等。此后,“预处理”阶段还包括数据的获取、建模、转换、数字化等科研数据基本操作过程。对于这些操作过程,“文件夹结构”和“文件和文件夹命名规范”给出了科研数据结构层次和命名规则,而“数据处理”明确了数据转换和数字化的具体办法,“数据出版和分享”中的“文件格式”则明确了数字化文件格式。工作流程的下一阶段是数据处理,包括数据分析、可视化等。其中,数据的分析、可视化,推荐使用OpenRefine,并给出了数据清洗的示例代码,同时也推荐了其它选择如Data Munging等。工作流程的后续步骤包括数据的存储、出版和复用。这些部分具有较强的关联性,而“数据出版和分享”中的“知识库”也提供了“标识符”“许可”等一体化服务。整个流程如图1所示。综上可以看出,FAKIN方案涵盖科研数据管理工作流程的主要内容,具有高度一致性。

图1 FAKIN方案与科研数据管理工作流程的映射关系

(2)便于溯源[14]。溯源过程的通用表达模型起源于国际溯源和标注组织(IPAW)的OPM 模型,之后W3C(万维网联盟)针对OPM 的不当之处进行修改,开发PORV-DM模型,通过3个基本类以及7 种类间关系较好地描述了数据的流转过程,但模型过于复杂。陈希等在其基础上创建ProVOC模型[15],该模型较为轻量化,可以按照应用进行扩展。本研究使用该模型对FAKIN方案的溯源性进行分析。ProVOC模型有3个类:执行实体、活动和数据。“执行实体”又分为“人类执行实体”“非人类执行实体”;“活动”是由执行实体发起或受执行实体控制、影响的一个或一系列动作;“数据”包括参数和数据集,其中“参数”一般指时间、空间和条件,“数据集”指按特定应用领域进一步分解出的若干子类(特定数据集)。FAKIN方案具备ProVOC中相应的构件元素,其中“人类执行实体”为处理人,“非人类执行实体”为数据来源,“活动”则为数据处理过程。“活动”的处理限制为“控制/影响”因素,“参数”为数据的产生时间、地点等,“特定数据集”为方案中不同项目、不同阶段中各子数据集。模型的交互关系共有8种,如“处理人”在“时间”/“地点”对“数据集”进行了“活动”,而对于FAKIN方案中的元素,也可以表达出该关系:“处理人”对于“数据”在“受控条件”和“参数”下进行了“活动”。

(3)多维度质量控制。数据质量被公认为是一个多维概念[16],以往研究主要涉及数据的准确性、连续性、完整性、可靠性等。张静蓓等[17]发现数据质量控制主要涉及4个方面的内容:文件整体质量、文档说明质量、科研数据本身质量以及源代码质量;屈文建等[18]利用krantz 理论,构建出一套科研数据质量控制标准,并从准确性、完整性、一致性等给出了具体指标。二者虽然在构建的出发点上有所区别,前者主要从数据的组成,后者从数据的特性进行构建,但按照各自给出的具体指标,二者又较为类似。本研究将其归并为科研数据构成(整体—文档—数据—代码)—特性(准确性—完整性—一致性)指标,如表2 所示。具体来看,文件整体和说明文档主要通过“文件和文件夹命名规范”“版本控制”来保证拼写、符号等基础元素的准确性、一致性;通过“元数据”中的“一般信息”来保证数据处理过程、方法的完整性、准确性;科研数据及其附属代码的质量控制,主要通过开源的处理软件进行保证,由于其开源特性,处理结果的偏差和代码本身的问题都可以通过大量反复使用而不断更正优化。

3.3 主要特点

在方案结构方面,FAKIN方案使用IPO模型(输入—处理过程—输出)制定文件夹结构策略。首先,IPO模型是IBM公司最早提出并用于描述过程的工具,其应用核心是描述数据处理的工作流程,与科研数据的收集—处理—输出流程类似,可以防止文件被意外覆盖,特别是在数据自动处理中最大程度地降低原始数据被删除的风险;其次,IPO过程可以分为多个子过程,向下分解、向上聚集方便,有利于保持文件和文件夹的清晰组织,避免深层文件夹结构的混乱。

表2 FAKIN方案质量控制特性

在软件工具方面,FAKIN方案使用大量开源软件和开放科学资源,如Figshare、Pangea。在数据处理过程中,所利用的程序软件,如R语言、OpenRefine、Github 都为开放、开源,既有利于数据的共享和再利用,又符合成果针对小型科研机构在设计中充分利用现有网络资源的特点。同时,工具的开源特性不仅减少软硬件投入,也便于不同类型科研人员、不同规模科研机构参与科研数据管理。

在应用操作方面,FAKIN方案为科研数据管理提供了现成的数据处理工具包,提高数据处理的便捷性。数据的收集整理是科研数据管理中最为耗时的部分,Borgman 发现数据收集处理中的工作量是数据共享的重要影响因素之一[19]。FAKIN方案提供基于R语言环境的数据收集工具包,普遍兼容常规数据采集器,同时,对于不同应用场景又可以实现二次开发,提升了收集处理数据的效率。

3.4 应用案例

FAKIN 方案的设计经验源自项目的最佳实践,KWB在开发过程中已经通过机构中试工厂的科研项目反复优化。在公共科研项目领域,FAKIN 方案也有了成熟的应用。例如,KWB 执行的 Flusshygiene 项目[20]和 AquaNES 项目[21]分属德国联邦教研部“可持续发展研究框架计划”和欧盟“地平线2020”,是全联邦或欧盟成员国共同参与的重大科研计划项目,对科研数据管理有严格规定。特别是AquaNES 项目涉及实验、文献等不同类型数据,而实验数据平行采集于4个实验工厂,具有采集频率和数据量不等(在50万~1,000万条/月)、采集装置和应用系统也不同的特点。在该项目中,除按照FAKIN方案进行一般性数据管理外,由于IPO模型的建立原则是处理过程,实验室数据一般来自数据记录仪,与其他数据具有不同的处理方法,所以依照IPO模式在相应的raw data和process目录中也分别构建相应子文件夹,并利用方案数据收集工具同时采集4处工厂的数据,效果良好。而对于科研过程中数据文件普遍过大的问题,如在利用监测数据进行废水处理装置生命周期评估[22]分析过程中,单个文件数据条目往往超过100万,使用FAKIN方案中数据处理工作包也可较为轻松地进行拆分整合。这种利用IPO 模型的文件结构简单有效,而工具包既具备较好的兼容性、二次开发特性,又能充分考虑实际应用的需要。从以上实际案例看,FAKIN方案主要应用于小型机构,其项目较为独立,领域也偏向工程技术,基本属于“监测数据+处理计算”的模式,具有数据来源类型相对单一,格式和结构也相对规整的特点。所以,随着不同类型数据来源增多或是大型异构数据集出现带来的命名冲突、结构冲突问题,可能还需要相对完善的命名规制和人工介入。

4 启示

纵观我国科研数据管理研究,主要从服务的范畴和任务(如内容、参与者)、治理(如机构科研数据政策)、执行(图书馆在科研数据管理服务中的作用)和实践(科研数据管理服务平台建设)等方面开展,并取得了大量研究成果,但具体方案却鲜有研究。所以,以科研工作者视角开发基于良好实践的德国FAKIN方案,不仅对我国图书馆/信息机构开展相关服务,而且对相关机构制定数据管理方案、保障科研质量都具有重要参考价值。

4.1 加强科研数据管理方案的制定

关于科研数据管理的文献众多,科研数据管理在设施建设、服务流程、服务项目上已经有了较为清晰的全景图。从调查结果看,科研数据管理的大部分基础设施已经可以满足项目及政策的基本要求,如何应用、实施路径已经成为科研数据管理研究的重点。而科研数据管理方案既是科研人员进行数据管理的具体工具,贯穿于整个数据生命周期,又是科研质量的保障和数据资源价值的前提。所以,图书馆和信息服务机构科研数据管理方案的建设与制定,既是服务的基础,又是提升服务质量的有力工具。目前,数据管理计划是科研数据管理服务的第一步。由于科研数据管理的后续步骤都包含在数据管理计划之中,因此良好的数据管理计划是增强数据质量、提升数据共享的基础保障,也是后续数据存储、组织等工作的落脚点和指南[23]。现阶段,作为参与数据管理的重要工具,几乎所有开展科研数据管理服务的图书馆都提供数据管理计划服务[24]。所以,参考数据管理计划进行科研数据管理方案的制定,既可以提升服务质量,又可以加深参与程度。

4.2 科研数据管理方案应注重全面性和可操作性

科研数据管理是贯穿整个数据生命周期的活动,作为活动指导的方案又需要在反复使用中不断优化,因此全面性和可操作性是科研数据管理方案的基础。科研数据管理的全面性包括流程和内容的完整。流程的完整要求方案涵盖整个科研过程,内容的完整则要求方案针对过程中所有可能涉及的问题。而可操作性则是要求在全面性的基础上,方案所给出的方式方法能被执行。FAKIN方案中,其设计来自科研流程,天然满足了完整的科研数据管理工作流程;而从内容看,以DCC主题模板为例[25],方案涵盖除由于其自身定位而较少涉及的政策和预算外的数据格式、数据收集、元数据、知识库、道德隐私、知识产权、存储安全等所有主题领域,给出的相关方法又详细具体。而在质量控制和溯源性等方面,则通过相对简单的结构方式来实现,易于操作实施。

4.3 科研数据管理方案应注重便捷性

简便易行是科研人员使用科研数据管理方案的必要条件,也是提升科研数据共享程度的基础。在科研数据管理中,文件命名的一致性、描述性质量以及文件夹目录结构清晰程度,是避免造成文件丢失、混乱以及提升可溯源性的关键;而数据收集和清洗既是科研过程中最为较耗时费力的步骤,又由于存在数据格式转换或是消除错误项、重复项等容易导致操作失误的阶段,也是阻碍数据分享的制约因素之一。所以,方案的制定还应着力体现在其便捷性上。在FAKIN方案采纳IPO模型,文件夹管理结构清晰,且从命名规范、元数据、源代码等方面考虑了数据的质量控制,可以有效避免产生无意义信息、错误描述、歧义性描述、版本混乱等常见错误[18]。而数据处理工具包又能在数据收集、整合阶段,较好地接收采集不同数据源的数据。在清洗阶段,既有常用软件的推荐和示例,又有自开发的扩展工具。这样,一方面降低科研人员数据处理的工作量,另一方面提高科研数据服务人员的工作效率,从而成为方案推广和普及的另一推手。

4.4 科研数据管理方案的制定与实施应具普遍性

随着开放科学的到来,机构数据知识库等IT基础设施建设成为必须的保障平台,在re3data.org 注册的机构数据知识库就有 2,542 个[26]。同时,机构数据知识库的存储服务能力、IT支撑能力已经成为机构科研数据管理服务评价的重要指标[27]。但从FAKIN 方案看,其立足项目组成员,利用公共资源,同样也可以建立机构内部、部门内部的科研数据管理规范。据德国同期项目调研[28],将近一半科研项目的数据量本身就在10G以内,特别是在社科领域,1G数据量内的项目约占30%,数据量规模自主可控。所以,对不同规模、不同类型的科研机构,都应建立符合自身硬件条件和学科特点的科研数据管理方案,提高科研质量,增强科研的可重复性。