应对新型冠状病毒肺炎疫情的AR 远程指导系统设计

陈 诚,鲁媛媛,何昆仑*,吴博轩,张 浩,肖若秀*,王志良

(1.北京科技大学计算机与通信工程学院,北京100083;2.解放军总医院,北京100853)

0 引言

2020 年3 月12 日,世界卫生组织(World Health Organization,WHO)宣布,新型冠状病毒肺炎(COVID-19)成为全球大流行疾病[1]。迄今为止,COVID-19 已蔓延到世界上大多数国家,已经有数百万确诊病例和数十万死亡病例[2]。尽管我国已经基本控制了疫情,但仍然有持续增长的输入性病例,尤其是近期部分地区由低风险区逐渐转变为中风险区,甚至是高风险区[3-4],抗疫仍是当前面临的重要问题。疫情期间,中国医疗队不断前往国内外疫区,为当地的抗疫工作做出了宝贵贡献,但是全世界的医疗资源仍然十分紧张。同时,由于COVID-19 传播性和感染性极强,做好卫生防范以防止交叉感染是一项重要的课题[5-7]。基于上述背景,如何减少直接接触、提供有效的救援指导已成为当前最为迫切的需求[8-9]。

远程指导作为非接触式诊疗方式,成为疫情期间广泛应用的救援手段。然而现有的系统主要以远程视频的方式进行指导[10],无法满足交互式和沉浸式的需求。增强现实(augmented reality,AR)技术是一种将虚拟环境信息与真实环境信息相互融合的创新技术,其利用计算机生成的虚拟文字、图像等虚拟环境信息和真实环境信息相互融合,实现虚拟环境与真实环境的信息资源互补。AR 技术因其可以有效实现各种超现实的视觉感官体验,如今被越来越广泛地应用于临床医学研究领域[11-12]。例如,Dixon 等[13]建立了一套LIVE-IGS 颅底手术导航系统,结合实时跟踪消融、关键结构接近警报、三维图像渲染技术,能够将颅内信息准确、直观地反馈给医生;Robu等[14]将术前三维虚拟图像与畸变校正后的腔镜真实图像匹配、融合并渲染,使腔镜图像与三维虚拟图像二者实时、同步地显示于腔镜显示器上。为应对COVID-19 疫情,本研究设计了一套AR 远程指导系统,可以实现医学专家对临床操作的远程参与和实时指导。不同于传统的局限于远程视频的指导系统,AR 远程指导系统可以为那些缺乏医学专家和专科医师的一线救援现场提供一种新型的远程会诊诊疗模式,有效实现医学专家对临床操作的远程直接参与和实时指导,在一定程度上提升了临床救治的工作效率。

1 系统设计

AR 远程指导系统包含服务器端和客户端2 个部分,基本架构如图1 所示。其中,服务器端采用云服务器,主要负责控制信息的管理和视频流数据的传输;客户端分为指导端和被指导端。信息管理的内容包括会议信息的存储和管理,例如会议名称、会议密码、会议内部的网络流地址等;视频流数据的传输用于对接指导端和被指导端传输的视频流,使客户端可以通过网络流地址接收视频数据。指导端主要由医学专家使用,通过摄像端口采集视频数据并将其分流成两部分,一部分数据直接被推流到云流媒体服务器,另一部分数据用于图像处理,优化指导端的视频效果,使被指导端得到实时的指导端视频信息。被指导端主要由抗疫前线的临床医生使用,通过摄像端口采集场景或者直接调用本地视频流,并将视频数据分流为两部分,一部分用于数据推流,另一部分用于本地的图像处理。

图1 AR 远程指导系统架构

2 系统实现

AR 远程指导系统主要由3 个技术模块构成,分别是图像分割模块、图像融合模块和视频传输模块。为减少服务器端的计算压力、避免对处理后的数据重新编码和处理数据时帧率不稳定的情况,三大技术模块均部署在指导端和被指导端中。

2.1 图像分割模块

图像分割模块用于分割指导医生的标记信息。AR 远程指导系统采用基于K-means 色彩聚类的改进型算法作为图像分割算法,图像分割流程如图2 所示。

图2 图像分割流程

基于K-means 色彩聚类的改进型算法对图像进行分割的基本思路是对视频帧进行静态处理。首先提取色彩聚类信息,通过读取一个视频帧,判断这个视频帧是否为第一帧。当视频帧为第一帧时,判断是否存在色彩聚类词典。若没有色彩聚类词典,则利用K-means 色彩聚类的改进型算法聚类生成新的色彩聚类词典。色彩聚类词典保存了一个视频帧的基本色彩信息,主要包括聚类中心像素和整体比例。根据经验原则,图像主要包含黑色的笔和字、淡黄色的手、白色的背景以及灰色的阴影。不同K值对应的图像分割效果如图3所示。实验显示:当K<4 时,目标对象会有色彩缺失,导致最终图像分割时会丢失目标对象的信息;当K>4 时,色彩聚类过多,会造成图像分割时产生过多背景信息,降低分割精度,同时会加大计算负担,造成系统更多的延迟。故AR 远程指导系统设定K=4,基于K-means 色彩聚类的改进型算法计算色彩聚类中心[15],最大循环迭代次数设为1 000,初始质心随机选取。

图3 不同K 值对应的图像分割效果示意图

若色彩聚类词典已经存在或生成了新的色彩聚类词典,则分析色彩词典的4 个聚类中心,对图像进行分割处理,并开始接受下一帧的视频数据。色彩聚类词典的信息提取方法如下:为提高图像分割精度,通常会在指导端使用白色背景演示,并占用图像信息较大的比例,因此提取接近白色RGB 像素值的聚类中心,标记为背景1,作为白色背景标注。对于阴影区域,通常情况包含2 种情况。第一种是靠近手或笔的边缘,主要呈现黑色,提取接近黑色RGB 像素值的聚类中心即可分离。第二种是远离手或笔的部分,通常呈现灰白色,在RGB 像素值上比较接近于白色,其分离策略如下:将色彩聚类词典中的另外3 个聚类中心像素值与背景1 的基准像素值(即白色聚类中心)进行求差,差值最小的即是灰白色色彩聚类中心,标记为背景2,作为灰白色背景标注。通过对图像的真实像素值与色彩聚类中的4 个色彩聚类中心像素值进行求差,将靠近白色聚类中心和灰白色聚类中心的像素分别标记为1 和2,作为背景信息,同时像素值赋为0。靠近其他聚类中心的像素点分别标记为3 和4,作为手、笔和笔迹等前景目标,实现前景与背景区域的图像分割。

由于视频影像的色彩亮度分布分散,处理后通常会留下部分阴影,无法靠近背景1 和背景2 的聚类中心。为提高分割精度,利用直方图均衡处理来降低噪声干扰,使阴影的灰度分布更加平均,如图4 所示。

图4 直方图均衡处理前后效果对比

另一方面,考虑到像素值和聚类中心的计算主要采用RGB 三通道的平均值,可能会带来颜色误判,例如在处理某一帧图像时,手指部分某处的RGB 像素值是(205,181,155),此时与4 个色彩基准值的色差绝对值分别为112、425、54 和190,与背景2 的色差绝对值最小,因此在未进行像素差值处理前手指被误判为背景2,造成在实际图像分割中部分手指区域被分割到背景2,如图5 所示。因此,在背景区域赋值前,需判断像素值是否接近纯色,否则,即使其像素值与背景基准像素值接近也不会被赋值。

通常情况下,处理后的图像会因为影像的噪声带来部分孔洞,因此需要进行形态学闭运算,即依次对图像进行膨胀操作和腐蚀操作,最终得到分离后的图像。为了提取前景区域,建立提取目标区域的掩膜图像,通过矩阵运算,得到前景的分割图像并应用于被指导端的图像融合。

基于K-means 色彩聚类的改进型图像分割算法克服了传统K-means 算法计算速度慢、无法处理运动模糊等问题,实现了前景信息提取准确、去阴影、抗光线变化的鲁棒性,运算速度较快,适用于视频播放。

图5 像素差值处理前后效果对比

2.2 图像融合模块

在AR 远程指导系统中,图像融合的目标是把指导端的手部指导信息和笔迹标注信息叠加在被指导端的界面上,实现AR 的功能。因此,为了得到全面的指导信息,不需要考虑连接区域的像素连续性,重点确保目标对象位置信息的完整性。本系统中图像融合的基本思路是利用掩膜图像进行图像算术运算,图像融合流程如图6 所示。

图6 图像融合流程图

具体如下:利用目标区域掩膜图像对指导端图像进行逻辑与运算,从而实现前景分割。同时,反向变更掩膜图像的二值信息得到反向掩膜图像,与被指导端图像进行逻辑与运算,得到图像背景。最后将指导端的前景图像和被指导端的背景图像进行算术相加,指导端图像的前景信息会补全被指导端的图像信息,从而实现图像融合。

2.3 图像传输模块

图像传输由FFmpeg 多媒体处理程序和EasyDSS流媒体服务器实现。基本思路:将采集好的视频图像进行编码和封装,同时进行数据推流,将封装好的视频图像推流到云服务器上运行的EasyDSS 流媒体服务器并进行视频的转发,最后指导端和被指导端通过数据拉流完成图像解码。

图7 显示了视频流从摄像口采集通过流媒体服务器转发,最终重新变成视频帧到达指定客户端的全过程。视频传输模块主要采用FFmpeg 多媒体处理技术和管道技术。具体如下:(1)利用OpenCV 逐帧读取摄像头采集的视频数据,并写入到管道中。(2)采用FFmpeg 读取管道数据并进行H.264 编码,减少数据量和传输时占用的带宽。(3)将数据封装成实时消息传输协议(real time messaging protocol,RTMP)数据包,并进行传输。(4)EasyDSS 流媒体服务器提供一个随机生成的RTMP 地址,FFmpeg 多媒体处理程序通过这个RTMP 地址将数据包准确地传输到流媒体服务器上。

图7 图像传输流程图

常用的传输协议有RTMP、HLS(HTTP live streaming)协议和HTTP-FLV 协议。由于RTMP 是基于传输控制协议(transmission control protocol,TCP)的协议,会占用非公共端口,在部分设备上可能会被防火墙拦截。且实验证明OpenCV 接收RTMP 数据包的性能不佳[16],因此,在数据拉流时不使用RTMP。HLS协议通过HTTP 80 端口传输,一般情况下能有效地穿过防火墙,但是HLS 协议的延迟太高,不适合AR远程指导系统这样的实时交互性系统。综上所述,数据拉流选用HTTP-FLV 协议,既可以降低延迟,又可以避免防火墙的拦截。

图像在传输过程中,图像处理模块每处理一个视频帧需要0.06 s 左右,数据拉流程序每接收一个视频帧需要0.03 s 左右,这就造成了视频帧的接收速度远大于视频帧的图像处理速度。接收的视频帧会在客户端数据拉流程序中一直累积,造成延迟越来越高。为解决这个问题,本系统采用帧缓存算法,接收的视频帧不会直接用于图像处理,而是存储在视频帧缓存区。当图像处理程序需要读取图像时,就从帧缓存区中读取最新的图像。帧缓存区会定期清除缓存的数据,保证视频帧不会一直累积。这样既可以解决视频帧接收速度与处理速度不匹配的问题,又能显著缩短实时视频的延迟时间。

3 系统功能测试

AR 远程指导系统主要功能包括:(1)音视频信息实时交互。支持交互双方使用可视化终端进行声音与图像的实时交流。(2)音视频呼叫。可视化终端可以发起音视频通话,根据权限呼叫其他终端,后者做出应答后开始音视频通话。(3)视频融合。使用可视化终端可以将2 个不同场景的视频叠加播放。(4)病情/医疗信息的AR 显示。在视频实时交互过程中,可视化终端可将患者生命体征、医疗数据、疫情数据等信息以文字、数字、表格、图像等形式叠加显示。(5)医疗指令的AR 量化传达。支持在视频实时交互过程中上级部门或专家的动态手势、文字、图画等叠加于视频中,对视频内的画面、动作等进行实时精确指导,实现医疗指令的量化传达。为确保AR 远程指导系统满足临床要求,对影像指导和交互指导进行功能测试。

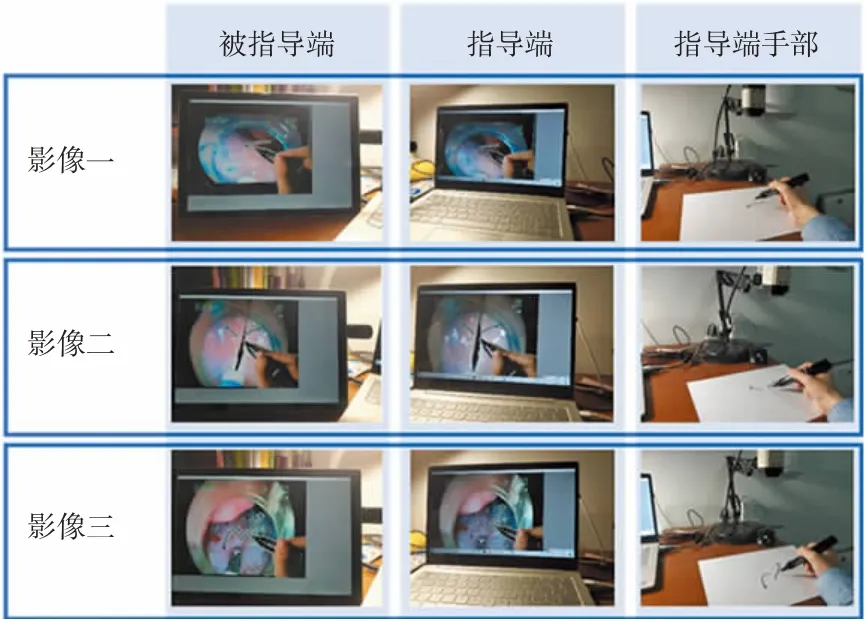

3.1 模拟影像指导

3.1.1 本地影像指导

对影像指导功能进行本地实验,实验环境为室内。采用真实的影像模拟被指导端摄像头采集的数据,指导端与被指导端结果如图8 所示。

图8 本地影像指导场景

实验表明,被指导端的影像场景可以清晰地传递给指导端,指导端通过采集手部及指导信息,可融合显示在屏幕上传达给被指导端。3.1.2 异地影像指导

为验证AR 远程指导系统的异地远程指导功能,进行异地实验,结果如图9 所示。其中,指导端位于河南省新乡市,被指导端位于河南省郑州市,2 个实验地点直线距离约40 km。

图9 异地影像指导场景

异地实验表明,本系统具有良好的异地远程指导能力以及较好的流畅度和较高的实时性。

3.2 交互指导(本地)

利用被指导端的后置摄像头采集数据模拟真实的场景,使用一个足球和一个地球仪模拟救援现场的人体部位。本地交互指导场景如图10 所示。

图10 本地交互指导场景

实验中所有的视频数据均通过互联网进行传输。经测试,指导视频帧率稳定在16 帧/s 左右,延迟小于2 s,表明AR 远程指导系统具有较好的流畅度和较高的实时性。

4 性能测试

AR 远程指导系统中服务器使用的是百度云服务器,其性能和负载能力可以根据实际情况调整;流媒体服务器使用的是成熟的商业化服务器EasyDSS,其性能可满足大多数视频数据传输场景。由于服务器端都是成熟的商业化产品,故只对客户端进行测试。

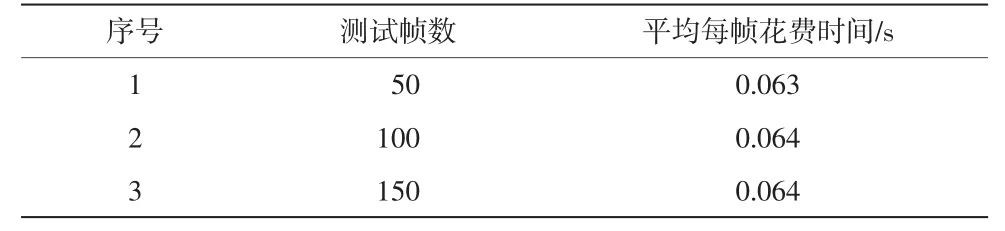

一方面,视频的帧率会直接影响用户体验,因此需要进行帧率测试。测试计算机CPU I5 7200U,内存8 GB,计算机系统Windows 10,测试环境带宽56.32 Mbit/s。测试方法:利用Python 内置时间函数,测量一帧图像从输入到输出消耗的时间(包含中间的图像处理过程),重复多次,求得每帧图像花费的平均时间。帧率测试结果详见表1。

表1 AR 远程指导系统帧率测试结果

另一方面,AR 远程指导系统需要较高的实时性,故对系统延迟进行测试。延迟测试所用计算机和帧率测试一致,测试环境为室内。虽然指导端与被指导端的设备空间距离较近,但视频数据在互联网上传输。测试方法:指导端和被指导端同时发送数据,当发送端停止传送数据时,利用Python 立刻生成一个精确到毫秒的时间戳,由于存在系统延迟,接收端要等待一定时间才能检测到发送端停止传送数据;当接收端接收完最后一帧数据时,同样利用Python内置函数生成一个时间戳。对比发送端和接收端时间戳的差值,就可以计算出延迟时间。延迟测试结果详见表2。

表2 AR 远程指导系统延迟测试结果

测试结果表明,AR 远程指导系统基本满足疫情期间远程指导的临床需求。

5 应用效果

本系统已经应用于抗疫前线,对解决医疗资源短缺、避免交叉感染起到了十分重要的作用。应用时,AR 远程指导系统的被指导端部署在污染区,由一线值班医护人员持有;指导端在清洁区或由专家随身携带。两端通过互联网或局域网络连接云服务器,通过音视频和AR 动态视频融合技术,实现了双方就同一动态视野或场景进行高效、直观、精确的交互。一方面,专家/设备工程师可以随时判断并处理重症病房或发热门诊留观患者的病情变化/医疗设备情况(如呼吸机参数、设备报警等),不仅可以有效降低交叉感染概率,减少防护物资损耗,还避免了因反复穿戴防护衣物消耗大量时间而降低诊疗效率,甚至耽误最佳治疗时机的问题。另一方面,多学科专家们也可以随时随地通过音视频了解患者病情,参与危重患者治疗方案的讨论、制订并指导现场工作的实施。

同时,AR 远程指导系统对使用环境没有特殊要求,互联网下开机即可使用,无需疫情病房施工部署,操作简便、直观。且云服务器可根据需求做私有云部署,数据信息安全、可控。除了应用于当前的疫情,本系统还可以投入到远程手术指导中,即在手术过程中,远程专家将指导意见实时、精准地叠加至手术医生的术野内,实现更为便捷的医疗指导和资源共享。

6 结语

本文设计了一套基于AR 技术的远程指导系统,通过图像分割技术、图像融合技术和视频传输技术实现了预期功能。系统通过基于K-means 色彩聚类的改进型算法解决了处理视频图像时运算时间长、受光线影响大、运动模糊的问题;通过帧缓存算法解决了视频帧接收速率与处理速率不匹配的高延迟问题和数据复用问题。

虽然AR 远程指导系统的应用取得了良好效果,但也存在一定的局限性。由于图像处理算法在客户端运行且使用Python 语言开发,导致其跨平台能力较差,目前只能在Windows 系统运行且需要配置Python 环境;同时疫情暴发突然,为了尽快完成研发并投入使用,AR 远程指导系统的前端工作开展程度较低,缺少远程指导系统常用的暂停、数据保存等功能。后期将对系统进一步优化、升级,提供更加有效的指导,实现可跨平台、更优的图像处理以及多功能应用,从而提升用户体验,扩大应用广泛性。