基于卷积神经网络的毫米波图像目标检测

程秋菊, 陈国平, 王 璐, 管 春

(重庆邮电大学光电工程学院,重庆 400065)

近年来,机场和车站等重要公共场所的安全问题变得越来越重要。传统的检测手段存在许多的缺点,比如金属探测器虽然能够探测金属目标的存在,但是不能区分该金属物品的名称;X射线成像系统虽然可以穿透衣物检测到隐藏的图像物品,但是它们的辐射非常高,对人体有害。然而,毫米波成像技术既可以穿透衣物来有效检测人体身上的隐匿物品,又不会对人体产生健康危害[1-4]。因此,毫米波成像系统是目前应用最广泛、安全的安检手段。由于毫米波图像因其特殊的成像效果,通常包含了光线暗淡、噪声干扰大、分辨率低等检测问题,所以针对毫米波图像的目标检测研究具有极其重要的现实意义。

传统的目标检测方法[5-9]一般通过人工提取特征之后使用特征分类器来实现图像的目标检测。该类目标检测方法的步骤一般可归纳为如下三步:①在图像中利用尺度大小不同的滑动窗口进行遍历,通过匹配度的计算后,根据阈值判断来选取粗略的目标候选区域;②利用经典的特征提取器从目标候选区域中提取特征,例如,方向梯度直方图(histogram of oriented gradient, HOG)、局部二值模式(local binary patterns,LBP)、尺度不变特征变换(scale-invariant feature transform,SIFT)等;③将得到的特征输入训练好的特征分类器中,例如支持向量机(support vector machine,SVM),从而识别目标的类别。然而,传统的目标检测方法存在着非常大的局限性,具有较差的泛化能力。因为当图像的背景较为复杂时,该类目标检测方法的检测效率会明显降低,导致检测性能变得非常差。为了应对这个问题,深度学习技术不断发展起来,出现了卷积神经网络[10],该网络不仅能替代人工设计提取特征,而且具有较好的特征表达能力和鲁棒性,实现即使在复杂的环境条件下也能准确地识别不同的目标物体。在图像目标检测领域,通过对深度学习[11]的深入学习,基于区域的卷积神经网络的从R-CNN[12]诞生开始,逐步发展,得到了fast R-CNN[13]和Faster R-CNN[14]神经网络模型。目前,Faster R-CNN深度学习网络在图像的目标检测技术中表现十分突出,该网络成功打破了传统的目标检测方法的瓶颈,将区域建议网络(region proposal network, RPN)与深度卷积神经网络相结合,实现了端到端的训练,提升了速度和准确度,成为了目标检测领域的主流框架之一。随后,通过借鉴faster R-CNN深度学习网络,衍生出YOLO[15]、SSD[16]和R-FCN[17]等图像的目标检测方法。

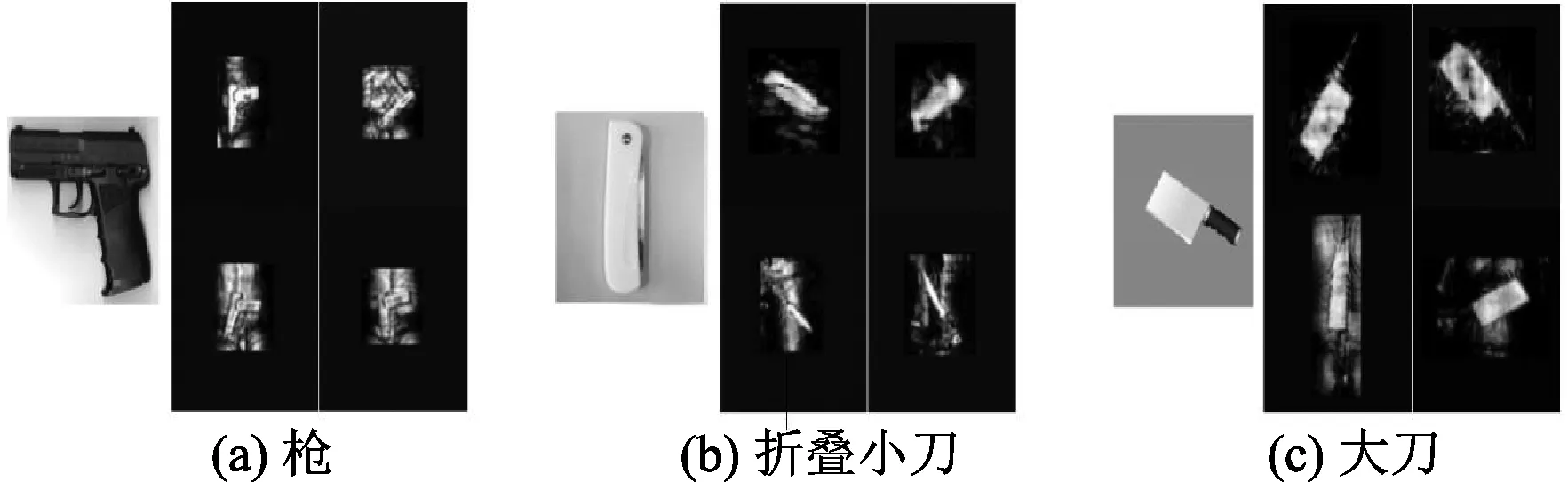

上述提到的方法都是针对在自然光场景下的光学图像而设计的,其图像都比较清晰,质量也都较高,例PASCALVOC 2007[18]、MS COCO[19]等。然而,毫米波图像与这些光学图像不同,主要原因在于它们的成像机制不同。毫米波图像主要反映了物体的电磁特性,这些特征随着目标结构、观察角度和材料因素而发生变化。但是,毫米波图像与光学图像也存在着相似的地方,主要因为毫米波成像系统有着非常接近光谱的高工作频率,所以毫米波图像具有许多与光学图像相似的几何特征。如图1(a)中左侧为枪的光学图像,右侧表示枪从不同角度成像的四个毫米波图像,但是它们都显示了手枪的直角结构。如图1(b)中左侧为折叠小刀的光学图像,右侧为四种不同类型的毫米波小刀图像,而图1(c)中左侧为大刀的光学图像,右侧为不同类型的毫米波大刀图像,可见刀具金属材料都表示为一系列常规亮块,特别是大刀具和相应背景的轮廓差异非常明显。所以鉴于光学图像与毫米波人体图像之间的结构相似性,本文主要研究将基于深度学习的检测方法应用于毫米波图像,旨在实现毫米波图像中隐藏物品的快速、高精度检测。

图1 光学图像与毫米波图像的对比

采用VGG16卷积神经网络和Faster R-CNN深度学习网络相结合,并利用了在线难例挖掘[20](online hard example mining,OHEM)优化训练网络模型的方法,对毫米波图像危险物品的检测进行研究。实验包括了3种典型的危险物品,它们分别是枪、折叠小刀和大刀,并且在大小为800×600的数千张毫米波图像的数据集上,采用Caffe深度学习框架在GPU上进行验证,最后分别与R-CNN结合VGG16、Fast R-CNN结合VGG16网络进行对比。以期能够实现毫米波图像中目标的快速、高精度检测。

1 Faster R-CNN网络模型

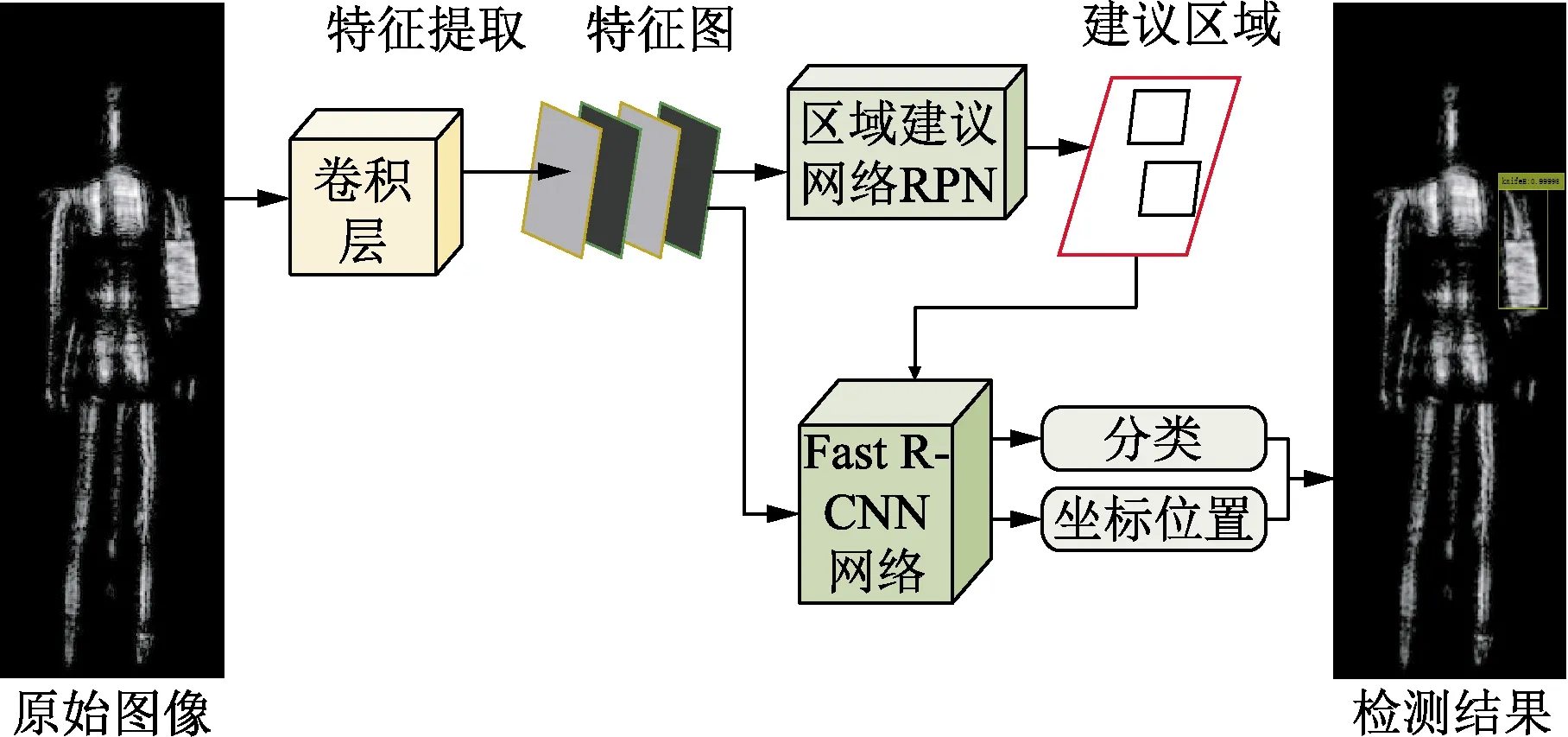

Faster R-CNN作为目前主流的深度学习网络之一,它非常明显的优势在于用区域建议网络代替了选择搜索算法(selective search,SS),大大提高了检测速度的同时,还极大地提升了目标检测的准确度[21]。Faster R-CNN包含了两个部分,分别是RPN和 Fast R-CNN,并且这两个部分共享卷积神经网络提取的特征。RPN主要负责提取建议区域,而Fast R-CNN主要负责对建议区域进行分类和定位。如图2所示,表示毫米波图像目标检测的Faster R-CNN深度网络模型。

图2 Faster R-CNN深度网络的结构

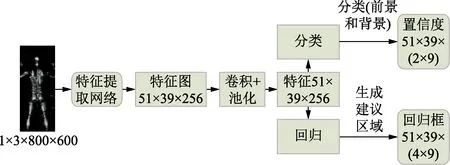

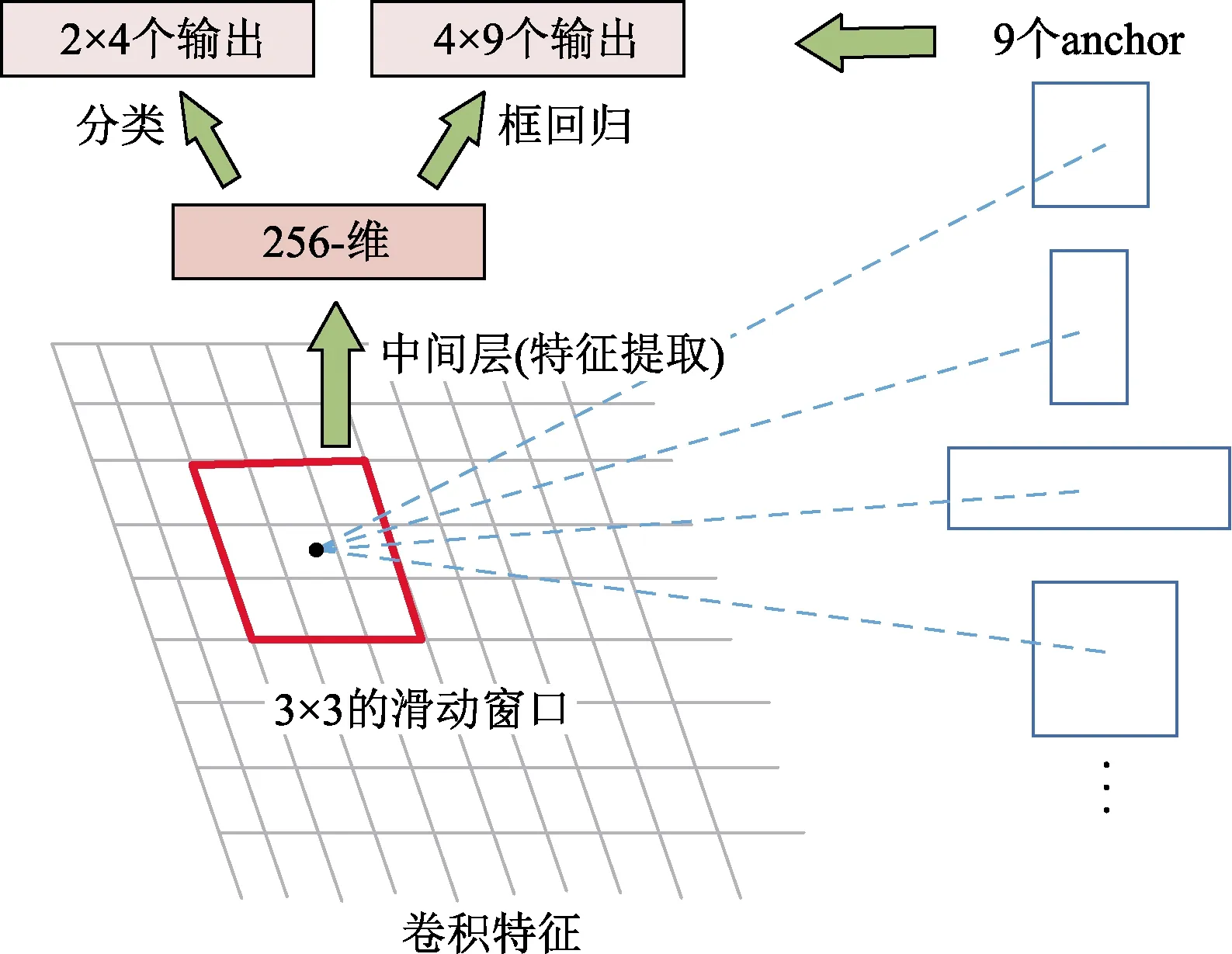

区域建议网络RPN是目前表现最突出的区域建议提取算法,它主要利用3×3的滑动窗口在输入的特征图上通过卷积实现建议区域的提取,既可以减少时间的消耗,又能够高效地预测出目标候选区域。如图3所示,为RPN的网络结构。实验以VGG16为例,所提取的特征图的大小为51×39×256,表示高、宽和通道数分别为51、39和256。对该卷积特征再次进行卷积计算,高、宽和通道数仍然保持不变,又会得到一个51×39×256的特征,对于该卷积特征有51×39个建议区域,每一个建议区域都在原图中对应着3种长宽比分别为2:1、1:2、1:1,以及3种尺度分别为1282、2562、5122共9种不同尺寸的检测框,即anchor。因此共有51×39×9 个anchor,检测的目标是对每个anchor是否包含物体进行判断。

图3 RPN网络结构

图4表明了接下来面对51×39个建议区域和51×39×9个anchor相关的计算步骤。首先,通过一个3×3的滑动窗口将每一个建议区域转换为固定的256维的特征,该特征对应了两个输出。一个输出的长度为2×9,表示该建议区域的anchor为物体的概率。另外一个输出的长度为4×9,表示该建议区域的框回归,每个anchor对应4个框回归参数。在图像训练中,通常使用多任务损失函数来减少目标函数,公式为

(1)

(2)

(3)

式中:x、y、w和h表示框的中心坐标及其宽度和高度。变量x、xa和x*分别用于预测框、anchor框和标签框。

图4 anchor与网络输出的对应关系

2 优化措施

2.1 训练网络模型

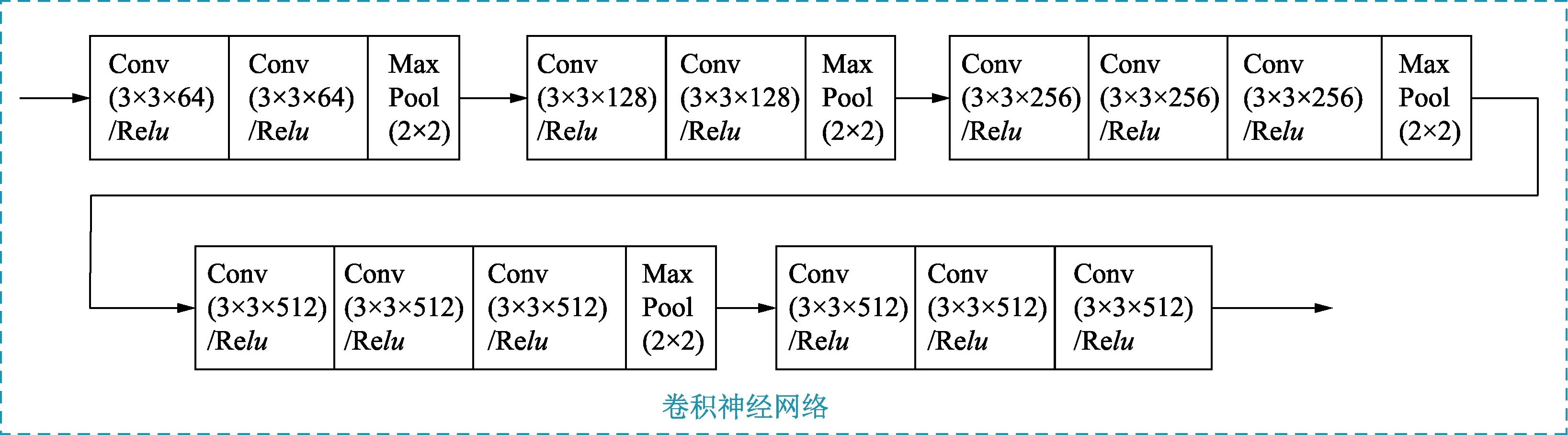

使用VGG16作为Faster R-CNN的特征提取网络,采用的是端到端的训练方式对VGG16卷积神经网络模型进行训练。原因在于该网络模型对比小型的训练网络模型而言,其深度更深,能更好地进行特征提取,从而得到更优的检测效果。如图5所示为VGG16卷积神经网络的结构。显而易见,VGG16网络通过具有relu激活函数的13个卷积层,以及4个池化层提取特征映射。为了能够适应毫米波图像的目标检测,本实验对VGG16的参数进行了调整。输入大小为800×600的图像,每个卷积层的卷积核大小为3×3,步长设置为1,每个池化层的池化核大小为2×2,步长为2。虽然该网络的图像的大小不会因为卷积层和relu层发生改变,但是图像输出长和宽会因为池化层变为原来的1/2。所以经过4个池化层后,最后一个卷积层输出的是512个大小为51×39的特征图,该特征图能够被RPN和Fast R-CNN共享。

2.2 在线难挖掘优化训练

图5 VGG16卷积神经网络的结构

图6 在线难例挖掘优化训练的结构

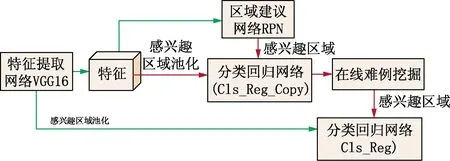

在线难例挖掘(online hard example mining,OHEM)技术能高效的解决训练过程中出现的正负样本不均衡的问题。OHEM会先将所有的建议区域实行前向传递,接着根据损失的大小进行排序,选取最大的损失值对应的若干个建议区域为难例,进行反向传播,从而更新分类回归网络。同时,为了避免建议区域的冗余问题,会在OHEM之前对建议区域实施非极大值抑制的方法来进行筛选,选取损失值最大的感兴趣区域,并且抑制预测框和标签框的重叠率(IOU)大于0.7的区域,因此达到了在网络训练的每一步中嵌入难例挖掘的目的,从而实现了在线难例挖掘优化训练。图6为在线难例挖掘技术优化的网络训练过程结构图,绿色箭头表示前向传递,红色箭头表示既能前向传递又能反向传递。分类回归网Cls_Reg和分类网络Cls_Reg_Copy的结构相同,但是分类回归网络Cls_Reg_Copy只能进行前向传递,实现在线难例挖掘并将结果送入分类回归网络Cls_Reg中进行反向传播,从而更新网络的参数。

3 实验结果与分析

3.1 训练集和测试集

实验主要测试了在人体身上的不同位置藏匿枪、折叠小刀、大刀这三类典型的危险物品,将收集的毫米波图像以JPEG格式保存,每幅图像的大小为800×600像素。实验使用了6 000张样本构成训练集(枪、折叠小刀、大刀各2 000张),3 000张样本构成测试集(枪、小刀、大刀各1 000张)。

3.2 实验结果

实验在Intel(R)Core(TM)i7-7820X CPU和NVIDIA 1080TI GPU的实验环境下进行,采用Caffe深度学习框架完成的。

单类目标的平均精度(average precision,AP)是一种有效的检测措施,它结合了每个对象的分类精度和位置精度。如表1所示,Faster R-CNN与VGG16相结合的深度网络的各类目标检测精度明显高于R-CNN与VGG16相结合的深度网络和Fast R-CNN与VGG16相结合的深度网络,且检测结果较好。然而Faster R-CNN与VGG16相结合并通过OHEM优化训练后的深度网络的各类危险物品的AP精度百分比明显高于Faster R-CNN与VGG16相结合的深度网络,由此可知该优化训练后的网络的AP检测效果更好。此外,从表1所示的检测结果同样可以看出,它们的共同点是枪这一类型有较高的检测精度,大刀次之,而小刀的检测精度最低。通过分析,原因在于与小刀相比,枪和大刀的种类都较为单一,面积区域较宽,形变较小;而小刀种类较多,面积区域也很小,并且收集样本的数量过小等问题导致小刀的检测效果明显较差。

表1 AP的检测结果比较

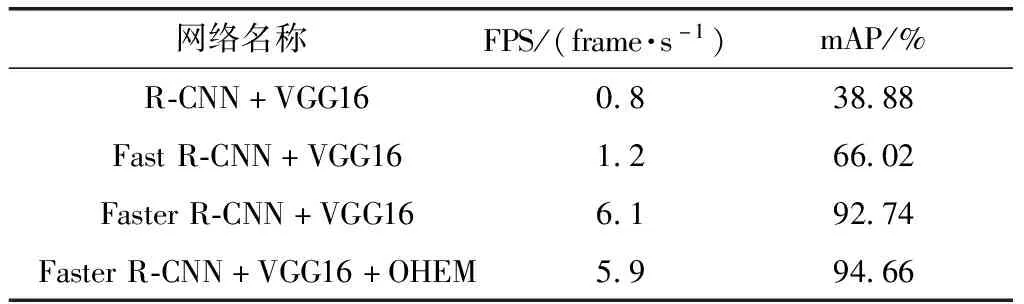

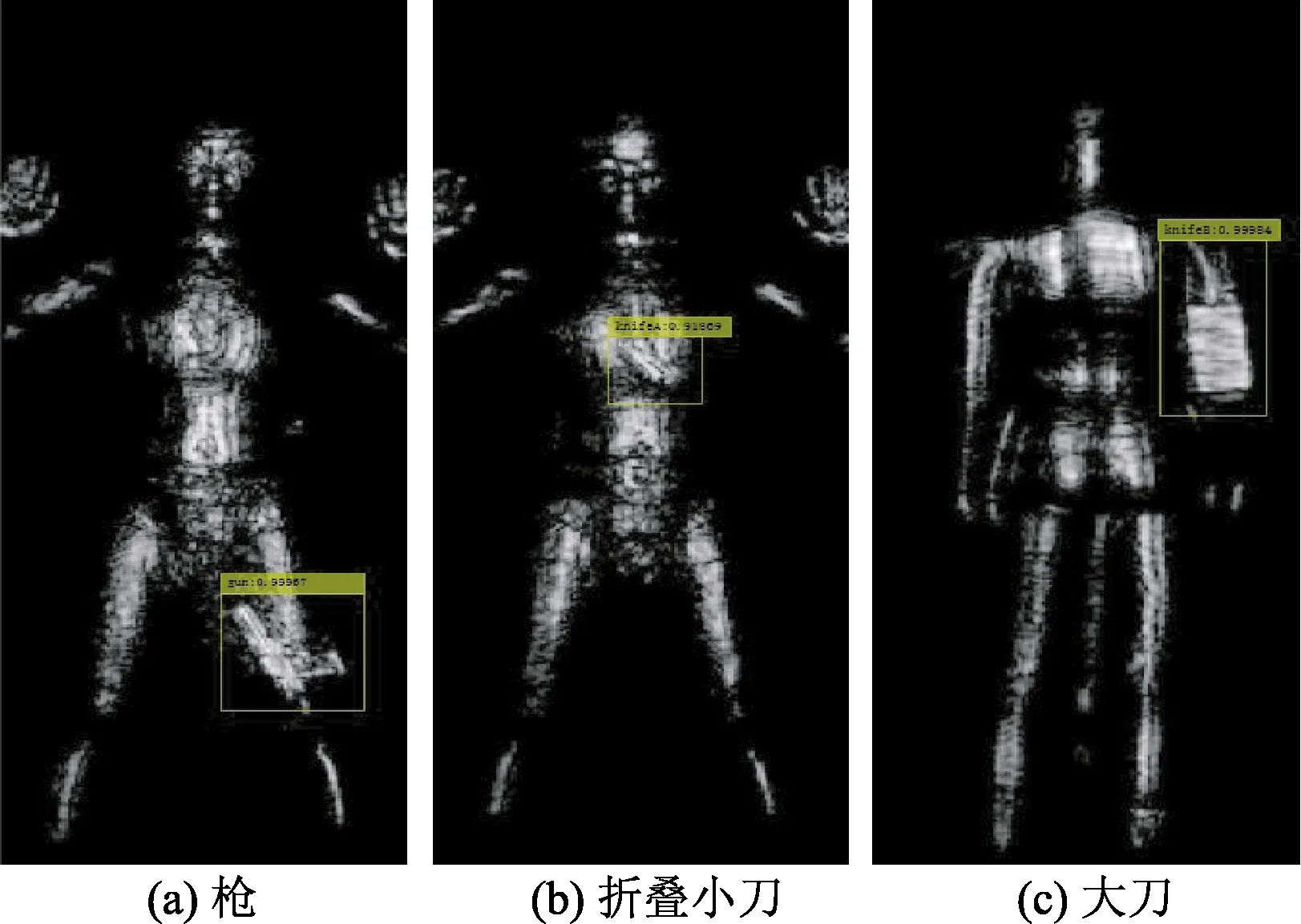

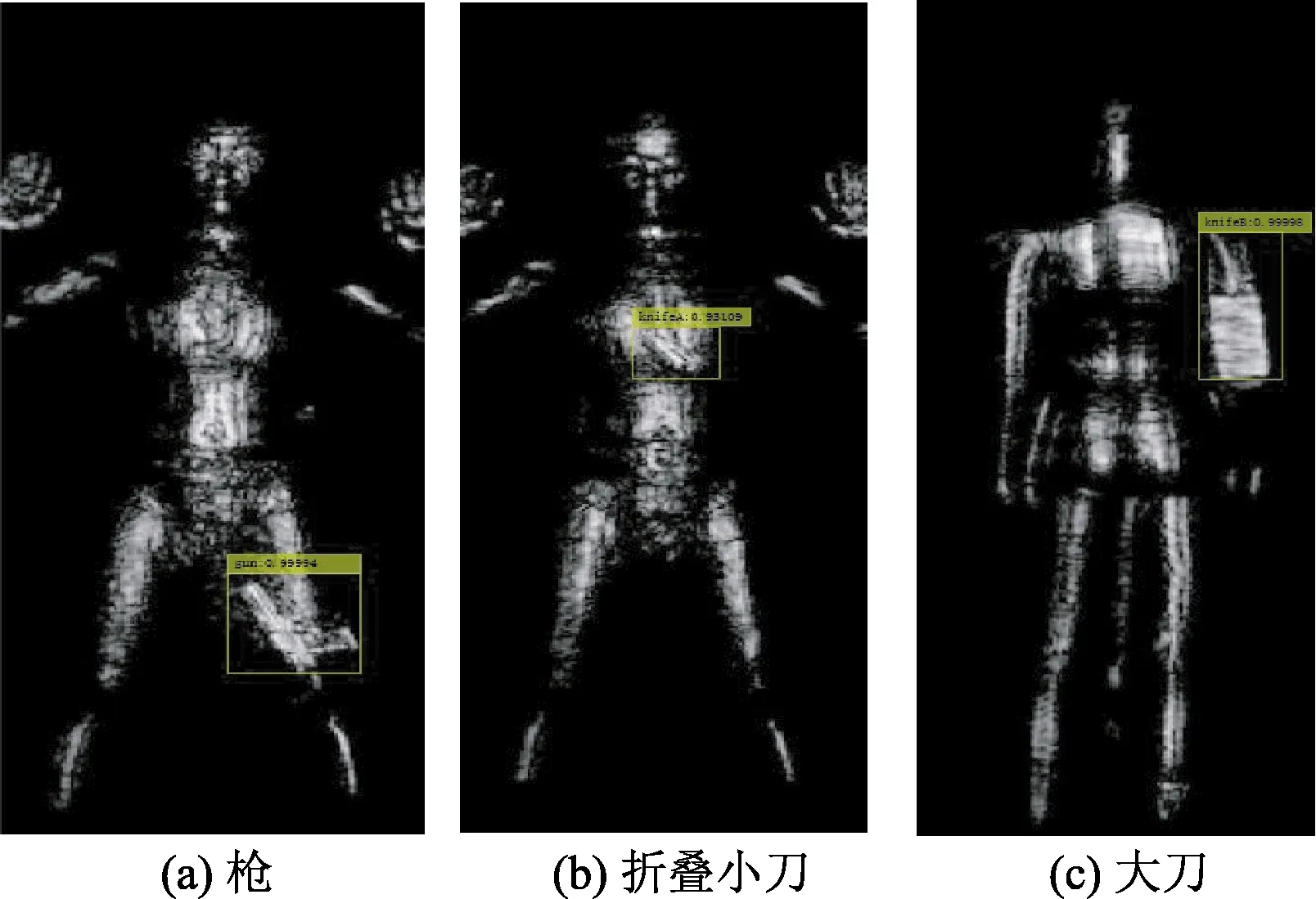

所有目标的平均精度(mean average precision,mAP)表示在同种目标检测网络下,求AP的平均值,同时观察毫米波图像处理的速度FPS也是一种有效的检测措施。如表2所示,在图像大小和检测数量都相同的情况下,与R-CNN结合VGG16和Fast R-CNN结合VGG16相比,Faster R-CNN结合VGG16的深度卷积网络的检测性能更优,其mAP达到近乎94%,并且每秒处理6张毫米波图像。然而,经过OHEM优化训练后的Faster R-CNN结合VGG16的深度网络效果更佳,其mAP达到94.66%,每秒处理近乎6张毫米波图像,也就是说,该优化训练后的网络能保持速度差异较小的情况下,检测准确度能得到提升。如图7所示为未经OHEM优化训练的毫米波图像目标检测的测试效果。如图8所示为经过OHEM优化训练后的毫米波图像目标检测的测试效果。由此可见,实验不仅证明了毫米波图像和光学图像中的对象特征是属于相似的分布,采用深度学习的卷积神经网络用于光学图像的目标检测方法同样适用于毫米波图像的危险物品检测,而且还证明了经过OHEM优化后的网络对毫米波图像的目标检测精度更高,说明了该方法是有效的。

表2 mAP和FPS的检测结果

图7 Faster R-CNN+VGG16的测试效果展示

图8 OHEM优化后的测试效果展示

4 结论

采用VGG16卷积神经网络与RPN相结合,并利用OHEM优化训练该网络,构建了一个基于Faster R-CNN深度卷积神经网络的新方法对毫米波图像进行目标检测,并与RCNN结合VGG16、Fast R-CNN结合VGG16、OHEM优化前的Faster R-CNN结合VGG16的深度网络进行了对比。实验结果表明,OHEM优化后的Faster R-CNN结合VGG16的深度网络深度学习网络的检测性能最优,并且能够保证稳定速度的同时进一步提高目标检测的精度。然而,根据深度卷积神经网络学习的特点,如何在保证稳定精度的同时进一步提高检测的速度是一个值得考虑的问题。因此,下一步考虑用多个GPU进行并行训练深度网络,提高开发效率。