基于具有空间注意力机制的MaskR-CNN的口腔白斑分割

谢飞 穆昱 管子玉 沈雪敏 许鹏飞 王和旭

摘要:口腔白斑(OLK)是一种癌前病变,由于其与口腔内健康组织有视觉相似性,导致难以准确区分,目前,对OLK 的诊断主要来自专业医生的经验,但这种方式效率低,诊断受主观影响大。该文提出具有空间注意力机制 (spatial attention) 的Mask R-CNN方法(Mask R-CNN-S)用于口腔白斑分割。Mask R-CNN特征提取能力受限于多任务的设计,在口腔白斑上分割效果并不理想。而Mask R-CNN-S 是基于Mask R-CNN网络,并引入了卷积块状注意力模块(CBAM)中的空间注意力模块,考虑了空间上的重要性信息,帮助Mask R-CNN关注更重要的区域。此外,受限于数据量较少,该文利用在其他相关大数据集里训练出来的预训练模型,同时采用冻结浅层参数,更新深层参数的策略。试验结果表明,该文所提方法实现了相比于传统Mask R-CNN更好的性能。

关 键 词:口腔白斑; Mask R-CNN;注意力机制;迁移学习

中图分类号:TP391.41

DOI:10.16152/j.cnki.xdxbzr.2020-01-002开放科学(资源服务)标识码(OSID):

Oral leukoplakia (OLK) segmentation baesd on Mask R-CNNwith spatial attention mechanism

XIE Fei1,2, MU Yu3, GUAN Ziyu3, SHEN Xuemin4, XU Pengfei3, WANG Hexu5

(1.School of Computer Science, Northwestern Polytechnical University, Xi′an 710129, China;

2.School of Computer Science, Xianyang Normal University, Xianyang 712000, China;

3.School of Information Science and Technology, Northwest University, Xi′an 710127, China;

4.Shanghai Ninth People′s Hospital, School of Medicine, Shanghai Jiao Tong University, Shanghai 200011, China;

5.Xijing University, Xi ′an 710123, China)

Abstract: Oral leukoplakia (OLK) is a precancerous lesion. Because of its visual similarity to healthy tissues in the oral cavity, it is difficult to be distinguished accurately. The current diagnosis of OLK is mainly based on the knowledge of experienced doctors. However, this is inefficient, and the diagnosis is greatly affected by subjectivity.The Mask R-CNN with spatial attention mechanism (Mask R-CNN-S) for OLK segmentation is proposed. Because Mask R-CNN feature extraction capability is limited by the multi-task design, the segmentation effect on OLK is not ideal. The Mask R-CNN-S is based on the Mask R-CNN network. And the spatial attention module in convolutional block attention module (CBAM) is added. It considers the spatial importance information and helps Mask R-CNN focus on more important areas. In addition, due to the lack of data, the pre-trained models trained with other related large datasets are used, and meanwhile the trick "freezing shallow layers′ parameters and updating deep layers′ parameters" is adopted. The experimental results show that the method in this paper achieves better performance than Mask R-CNN.

Key words: oral leukoplakia; Mask R-CNN; attention mechanism; transfer learning

口腔白斑(OLK)是癌前病變,医生通常是通过观察病人是否有口腔白斑来评估他们的病情。在口腔白斑的诊断过程中,医生根据病变的大小和组织病理学特征对口腔白斑进行分级[1]。为了充分利用这些实际经验,我们使用经过专业医生标注的图像数据,利用计算机视觉领域中的深度学习方法分割病灶区域,以辅助医生诊断。随着计算机性能的急剧提高,在计算机视觉领域中,卷积神经网络(CNN)已广泛应用于图像分类、分割和目标检测,并取得显著成效。 从AlexNet[2],VGG16[3],到 ResNet[4],网络模型性能越来越好。这些分类网络不仅适用于图像分类任务,同时也成为其他计算机视觉任务的主干网络。与此同时,网络设计逐渐地模块化和多样化。以Faster R-CNN[5] 为例,其使用VGG网络作为主干网,同时辅以区域建议网络(region proposal network,RPN)和ROI 池化模块,在兼顾分类和物体定位的目标检测任务中取得了良好的效果。就图像分割而言,自Long提出了FCN[6]以来,后续基于FCN类的方法主要是对不同尺度的特征图进行融合,然后采用上采样操作输出分割结果。多尺度融合成为分割网络的核心概念,几乎所有的分割网络都采用特征金字塔结构。在众多网络结构中,Mask R-CNN[7]和U-Net[8]在医学图像分割中得到了广泛的应用。与U-Net相比,Mask R-CNN网络结构更为复杂,能够提取更丰富的特征,因此,在自然图像分割中具有更好的性能。 目前,尚未有针对口腔白斑分割的研究,本文借鉴其他疾病辅助诊断的解决方案(如皮肤损害),利用基于Mask R-CNN的网络进行口腔白斑的分割。但是,口腔白斑分割的难点在于病损区域与健康口腔组织相似,白斑区域边界不清楚,病灶区域难以从口腔图像中准确分割。 为了解决这一问题,本文将CBAM[9]中的空间注意力模块引入到MASK R-CNN网络中,以增强特征提取能力,从而获得更好的分割效果。CBAM模块将归一化因子分配给每个特征图,以增强有效信息或抑制无效信息,反映出不同位置的重要性。由于我们训练样本量相对较少,本文借助于在其他数据集训练好的模型进行迁移学习,并冻结浅层参数,更新深层参数,以准确分割口腔白斑,采用3种策略找出最优的模型。

1 相关工作

通常,医生根据自己的经验和实践来诊断口腔白斑。口腔白斑诊断的难点在于它的颜色和形状特征与口腔健康组织相似而被漏诊。口腔白斑的特征是复杂多样的,如图1所示,其形状不规则,质地不均匀,边界不清,有白色凝胶状、片状、鳞状。出现在舌、牙龈、嘴角及其他口腔部位。口腔白斑很难区分,但准确的区域分割对于医疗诊断是非常重要的。我们的任务是实现对口腔医疗图像中口腔白斑病变区域的精准分割。

在2017年,He等人提出了Mask R-CNN实例分割网络,添加Mask分支到Faster R-CNN,将ROI池改为ROI对齐,将对象检测结果应用于分割任务,使网络具有良好的分割性能。在2018年的ISIC竞赛中,即使是未添加任何独立的设计,使用基于Mask R-CNN的模型,效果都要好于ISIC 2017年最好的基于U-Net的模型。最好的分割方案也是基于Mask R-CNN,这明显表明了Mask R-CNN在医学图像分割中的潜力。

注意力机制最早使用于自然语言处理中, 使得重要的信息能被聚焦, 增强了信息的结构化解析, 重要信息的提取在网络训练中逐步得到增强, 不重要信息的提取逐渐受到抑制。 注意力机制最早应用于Encoder-Decoder式自然语言处理模型当中, 但很快便被传播到计算机视觉领域, 因为计算机视觉天然需要注意力机制, 我们需要获取视觉观察中的有效信息, 并忽略其他无效信息。 Oktay提出了Attention-Unet[10], 设计Attention-Gate模块用来增强相关区域, 抑制不相关区域, Woo设计了CBAM模块, 借鉴了Hu等人提出的SE[11]模块的设计思想, 不仅增强空间注意力信息, 而且增强通道注意力信息。 模块化的设计使得CBAM能够很好地移植到不同的基础网络中, 并在分类和目标检测任务中取得了良好的效果。

ImageNet[12] 是一个计算机视觉系统识别项目, 是目前世界上图像识别最大的数据库,是美国斯坦福的计算机科学家模拟人类的识别系统建立的,能够从图片识别物体。使用这些数据训练出来的模型分类效果较好,得益于其出色的特征提取能力。使用ImageNet训练得到的模型被广泛地迁移到其他任务中,取得了更好的效果。

COCO[13]数据集由微软赞助,其对于图像的标注信息不仅有类别、位置信息,还有对图像的语义文本描述,COCO数据集的开源使得近两三年来图像分割语义理解取得了巨大的进展,也几乎成为了图像语义理解算法性能评价的标准数据集。而Mask R-CNN在COCO数据集上取得了良好的分割效果。

以上研究是本文工作的重要基礎,通过改变Mask R-CNN的网络结构,加入空间注意力模块,提高网络的分割性能,减少误差。通过迁移学习,采取冻结浅层参数,更新深层参数的策略,利用大量数据集模型的特征提取优势,弥补白斑数据较少的劣势,使得网络的分割效果得到提升。

2 口腔白斑分割

2.1 融合空间注意力的Mask R-CNN-S

本文在Mask R-CNN中加入了CBAM中的空间注意力模块,以提高分割性能。首先介绍利用传统Mask R-CNN进行口腔白斑分割的整体架构,如图2所示。

在特征提取阶段,Mask R-CNN可以使用多种基本网络模型来提取视觉特征,如ResNet,ResNeXt[14]常用的是ResNet 50和ResNet 101。以ResNet50为例,去掉其原始模型中的Top部分,仅保留特征提取部分,接收输入的图片,进行卷积和池化操作,取其不同深度输出的特征图,记作C1,C2,C3,C4,C5,由于C1层次太浅故舍弃。

在特征融合阶段,深层特征C5进行1×1卷积操作,形成特征P5,进行上采样操作。C4进行卷积操作,生成的特征图与P5求和,生成P4,以此类推,生成P3,P2。为防止抖动,再加入一次3×3的卷积操作,生成新的P2,P3,P4,P5,最后,对P5进行下采样,生成P6(P6只作用于RPN),这些就是特征融合网络的输出,如图3所示。

RPN(region proposal network)利用对特征图的学习来计算物体在图像中位置的候选框。对于P2,P3,P4,P5,P6中的每个点按照不同宽高比预设候选框,根据RPN网络回归修正每个候选框的位置和大小,以及每一个候选框前后景置信度。利用非极大值抑制(NMS),保留置信度较大的候选框。

ROI Align的作用在于将特征融合网络的输出和RPN的输出进行整合,利用双线性插值进行池化操作,使得特征图目标物体区域的精确信息被获取,用来进行分类回归。

分类与检测的结果对proposal优化更新,ROI Align再作用于Mask分支(14,14,256)。在Mask分支,特征图经过卷积、上采样(反卷积)、卷积,和Simoid激活层获得一定大小的Mask坐标预测集合,最后,这些Mask形成与原图等大的二值图,用白色区域代表病灶区域,黑色部分为其他区域。

空间注意力模块如图4所示,用来赋予特征图不同位置的重要性,增强重要区域,抑制不重要区域。将输入的特征先后进行最大池化和平均池化,再进行7×7的卷积操作,最后进行Sigmoid激活处理,生成1×H×W大小的矩阵,H和W分别为特征图的高和宽。

M(F)=[AvgPool(F);MaxPool(F)],(1)

Ms(F)=σ(f 7×7(M(F)))。(2)

其中:F为特征图;AvgPool为平均池化;MaxPool为最大池化;f 7×7是卷积操作;滤波器尺寸为7×7;σ为Sigmoid激活函数处理;Ms(F)是一个空间注意力参数矩阵。

在特征融合的过程中引入空间注意力模块,借鉴Attention-Gate的思路,本文方法仅在1×1卷积之后加入空间注意力模块。

Pi=CiMi(Ci)f 2×2upsamping (Pi-1)。(3)

其中:Ci代表特征提取第i阶段输出的特征图,P代表对应的特征融合部分的特征图, 表示对应元素相加, 表示对应位元素相乘; f 2×2upsamping 表示一个2×2的上采样。空间注意力机制如图5所示。

2.2 迁移学习

本文使用两种预训练模型,分别是COCO数据集的Mask R-CNN预训练模型[22]和ImageNet數据集的ResNet 50 no-top分类网络训练模型[21]。在迁移学习的过程中,模型调优策略是放开预训练模型不同阶段的参数以使其更新。主要依据在于预训练模型的前几个阶段提取的特征泛化能力更强,而后几个阶段提取的特征与物体类别相关性更强。因此,本文选择冻结或更新不同的特征提取阶段,使得预训练模型的能力得到最大程度的保留。

3 实验与分析

通过对口腔白斑原始数据分析,并利用这些数据对现有的分割模型以及本文提出的分割模型进行训练和测试。

3.1 实验细节

在TensorFlow[15]和Keras的基础上,将空间注意力模块按照第二节的阐述加入到Mask R-CNN架构中。主干网络是ResNet 50,输入图像尺寸为768×768,RPN的锚框尺寸为32,64,128,256,512,掩码形状为28×28,学习速率为0.001,学习动量为0.9,权重衰减为0.000 1,优化器为SGD,训练30个轮次。

3.2 数据集

我们从医院获取口腔白斑的医学图像数据90例,其中,78例作为训练集,12例作为测试集。专业医生使用VIA注释工具(VGG图像注解器)对每个图像上的疾病区域进行标注。生成一个JSON格式的注释文件,其中包含每幅图像上目标区域对应的坐标信息。在数据处理阶段,JSON注释文件将被转换为对应于每个分割区域的一系列二进制掩码图像。沿着长边将图像按比例缩小,并在短边填充黑色以适应网络训练,以相同的方式处理掩模图像。该图像使用imgaug图像增强工具库,包括水平和垂直翻转,90°,180°,270°旋转和(0.0,5.0)的高斯模糊。

3.3 评估标准

Jaccard指数[16]是评价模型效果的标准,它直观地表达了一个预测的Mask和真实标注的交并比,

J(A,B)=A∩BA∪B,0≤J(A,B)≤1。(4)

式(4)中A和B集合的像素坐标相应地表示一个真实标注和一个预测掩膜。

使用测试集中所有图像预测值的平均值Jaccard指数和作为模型性能的度量。

R=∑Ni=1J(Mg(i),Mp(i))N (5)

其中:R代表最终的结果;Mg(i)代表第i个图像的真实标注;Mp(i) 代表第i个图像的预测结果;N是数据的总量。

3.4 对照组设置

特征提取主干网络包含5个阶段,我们设置3档调节:①更新所有阶段的参数,记作All;②冻结前两个阶段的参数,放开第3个阶段及后续阶段的参数更新,记作3+;③不更新所有阶段的参数,记作Heads。

S代表引入注意力模块(Spatial Attention), I代表使用ImageNet预训练模型, C代表使用COCO预训练模型。我们的对比试验设置了12组,如表1所示,表中的“”表示被选择。例如S-C-3+代表引入空间注意力模块,使用COCO数据集在Mask R-CNN上的预训练模型,从主干网络的第3阶段开始进行参数更新。

3.5 实验结果与分析

表2为实验结果,其中,I-All表示原始Mask R-CNN模型,使用ImageNet预训练模型,而C-All表示利用COCO数据集预训练模型的结果,可以看出,COCO预训练模型明显优于ImageNet。

使用不同的预训练策略,在其他条件保持不变的情况下,COCO预训练模型训练的效果仍然好于ImageNet预训练模型,其中C-3+最好。

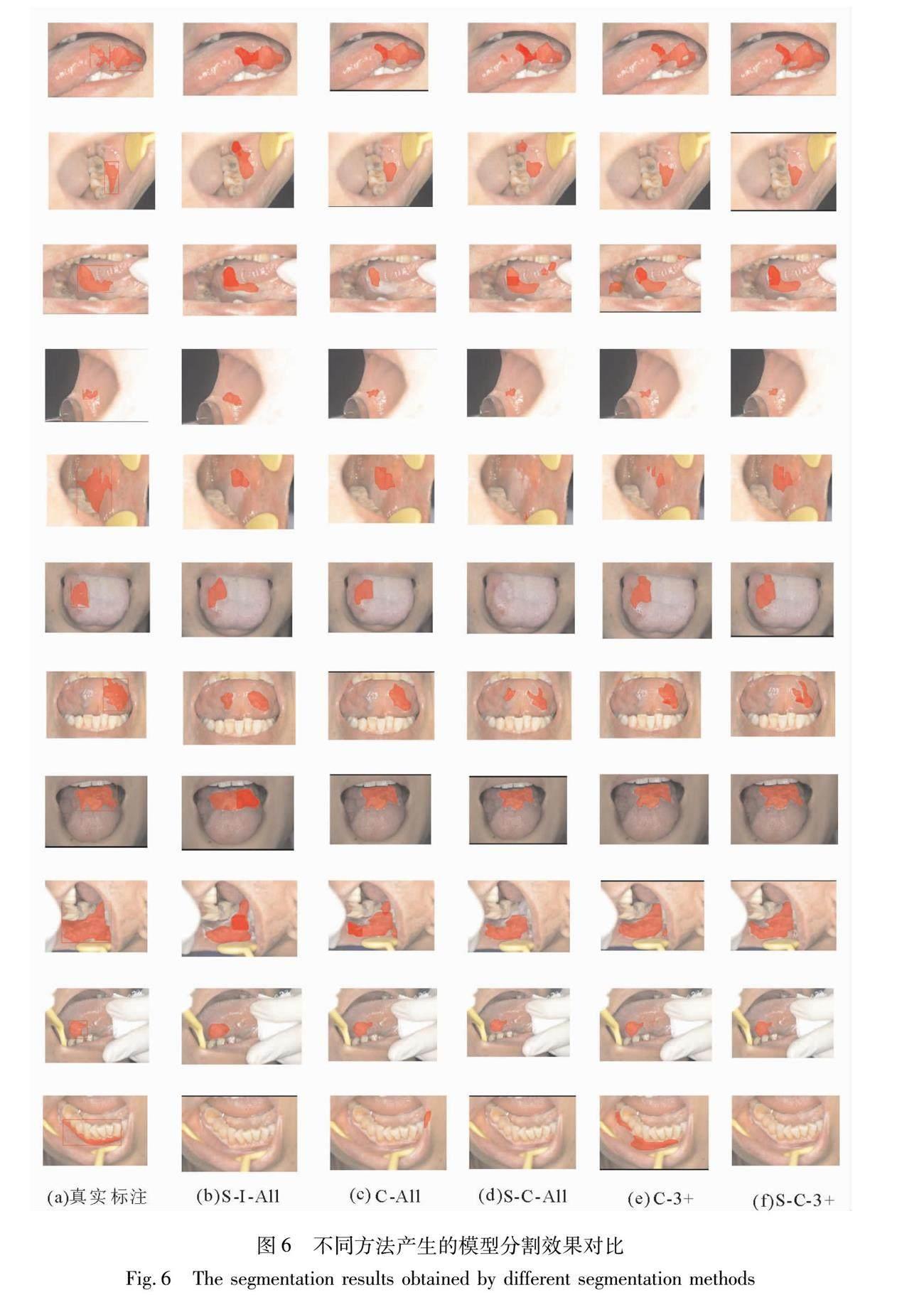

在加入了空间注意力模块之后,S-I-All成为使用ImageNet预训练模型中效果最好的,S-C-3+是使用COCO预训练模型中最好的。其原因在于,随着参数更新的阶段增多,ImageNet预训练模型更加适应分割任务,而空间注意力增强了模型的特征提取能力,使得模型分割性能提升。对于S-I-3+和S-I-Heads,空间注意力对其特征提取能力增强后,容易造成误识别的特征被抑制,分割性能降低。COCO预训练模型在放开所有阶段参数更新后,由于口腔白斑数据量较少,前两个阶段的特征提取能力被减弱,所以,加入空间注意力后分割效果变差,图6中的分割效果图也印证了本文的分析。

S-C-3+模型分割效果最好,平均Jaccard指数R达到了0.631 1,比C-3+有了较大提升,可以从图6中观察到,很多和白斑相似区域的特征被抑制,而白斑区域的特征被增强。因此,分割更加的合理。最后一组中S-C-3+的分割效果比C-3+差的原因是训练集中相似图片较少,随着数据集的增多,这种情况会逐渐改善。

4 结 论

Mask R-CNN是一种多任务处理网络,实现了分类、检测和分割的功能。通过利用目标检测结果优化分割,使网络具有更好的性能和平滑的分割效果。使用COCO预训练模型能够在少量的实验数据上获得良好的分割性能。利用冻结浅层阶段的参数更新深层阶段参数的迁移学习策略,充分挖掘预训练模型特征提取能力。此外,空间注意力模块提高了目标物体的分割准确度。所以,基于Mask R-CNN的S-C-3+方法产生的模型在口腔白斑分割任务中效果最好。在后续的工作中,我们将更关注于探索不同的迁移学习策略,同时改进Mask R-CNN,以获得更高的分割性能。

参考文献:

[1] 孙正, 宫芸芸, 黄洁. 白斑癌变危险因素与口腔白斑病分期体系的关系[J].中华口腔医学杂志,2001,36(5):47-49.

SUN Z, GONG Y Y, HUANG J. Analysis of relationship between risk factors of malignant transformation of oral leukoplakia and the LSCP system[J].Chinese Journal of Stomatology, 2001, 36(5):47-49.

[2] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[J].Communications of the ACM,2017,60(6):84-90.

[3] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[J].arXiv:Computer Vision and Pattern Recognition,2014.

[4] HE K M, ZHANG X Y, REN S Q, et al.Deep residual learning for image recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.IEEE,Las Vegas,2016:770-778.

[5] REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN:Towards real-time object detection with region proposal networks[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149.

[6] LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition.IEEE,Boston,2015: 3431-3440.

[7] HE K, GKIOXARI G, DOLLR P, et al. Mask r-cnn[C]∥Proceedings of the IEEE International Conference on Computer Vision.IEEE,2017: 2961-2969.

[8] RONNEBERGER O, FISCHER P, BROX T. U-net: Convolutional networks for biomedical image segmentation[C]∥International Conference on Medical image Computing and Computer-Assisted Intervention. Springer, Cham, 2015: 234-241.

[9] WOO S, PARK J, LEE J Y, et al. Cbam: Convolutional block attention module[C]∥Proceedings of the European Conference on Computer Vision (ECCV).Springer International Publishing, 2018:3-19.

[10]OKTAY O, SCHLEMPER J, FOLGOC L L, et al. Attention U-net:Learning where to look for the pancreas[J].arXiv Preprint arXiv:1804.03999, 2018.

[11]HU J, SHEN L, SUN G. Squeeze and excitation networks [C]∥2018 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, Salt Lake City, 2018: 7132-7141.

[12]DENG J, DONG W, SOCHER R, et al. ImageNet: A large-scale hierarchical image database[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition. IEEE,Miami, 2009:248-255.

[13]LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft COCO:Common objects in context[C]∥European Conference on Computer Vision. Springer, Cham, 2014: 740-755.

[14]XIE S N, GIRSHICK R, DOLLR P, et al. Aggregated residual transformations for deep neural networks[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition.IEEE,Honolulu,2017:1492-1500.

[15]ABADI M, BARHAM P, CHEN J, et al. Tensorflow: A system for large-scale machine learning[C]∥12th {USENIX} Symposium on Operating Systems Design and Implementation ({OSDI} 16). 2016: 265-283.

[16]JACCARD P. The distribution of the flora in the alpine zone.1[J]. New Phytologist, 1912,11(2):37-50.

(編 辑 李 静)