机器学习在SDN路由优化中的应用研究综述

王桂芝 吕光宏 贾吾财 贾创辉 张建申

1(四川大学计算机学院 成都 610065) 2(7584部队 广西桂林 541001)

随着网络规模的增大和新型网络应用的不断出现,网络流量呈指数级增长,给网络带来了负载不均衡、带宽消耗严重等一系列问题.单纯的扩容提速,不仅成本高,而且由于缺少系统性的流量管理机制,网络资源利用率低.此外,许多应用程序不仅需要带宽,还需要保证服务质量(quality of service, QoS),如端到端时延、抖动、丢包率等.因此根据网络的状态和需求找到一种实时的自适应的可定制路由是提高网络资源和服务质量的关键性因素.

在传统网络中,控制和转发紧耦合的网络架构与“尽力而为”的服务模式,需要在每个节点上执行特定的路由协议和算法以此来找到源到目的地的最佳路径.正是因为这个分布式体系,使得每个节点只有部分视图,导致很多全局性策略难以实施[1],所以很难进行智能路由.而软件定义网络作为一种新的网络体系架构,通过将控制平面与数据平面分离,提供了灵活高效的网络控制,简化了网络管理过程,使管理员可以通过网络编程的方法定义和控制网络,降低了为数据流提供路由优化服务的难度[2].

近年来,随着人工智能的迅速发展,机器学习在数据处理、分类、智能决策等方面皆取得非常不错的进展,受到了学术界的广泛关注[3].许多研究者开始尝试通过使用机器学习算法来解决路由优化问题.一方面,机器学习可以通过训练快速地计算出接近最优解的路由解决方案;另一方面,机器学习算法不需要精确的底层网络数学模型[4].目前用于解决路由优化问题的机器学习算法主要分为2类:监督学习和强化学习.

现如今,云计算大数据迅速发展,数据中心业务流量极速上升,具有规模大、种类多、速度快和价值密度低等特征的大数据推动了数据驱动的发展,同时也给网络带来巨大的传输压力[5].数据是广泛可用的,它不仅是需要分析和处理的内容,也是一种基础资源.我们需要根据需求从数据中提取有用的知识,使网络节点具有认知能力,可以感知当前环境,并对感知内容进行分析,自动化作出路由决策,实现数据驱动认知路由的功能.

就当前高中生传统文化素养现状来说,存在诸多问题,这些问题既包括教材、教学方面的客观因素,也包括学生自身的很多主观因素。

1 SDN相关介绍

软件定义网络(software defined networking, SDN)是由美国斯坦福大学Cleanslate研究组提出的一种新型网络架构[6],其基本思想就是将报文转发所涉及到的复杂逻辑控制从交换机/路由器等设备中分离出来,用软件编程的方式实现对网络的控制管理,从而达到自由操控流量的目的.而OpenFlow技术实现了控制平面与转发平面功能的解耦,由集中控制器向交换设备下发转发规则,使得控制器与交换设备可以相互分离独立发展[6].

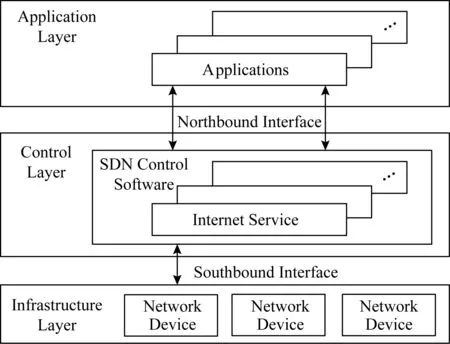

典型的SDN架构从上到下包含3层,分别是应用层、控制层、基础设施层,如图1所示.应用层包含流量工程、网络监测、故障恢复、网络虚拟化等网络应用程序,用户可以通过北向接口从控制平面获取全局网络视图,然后根据该信息编写网络策略对网络事件进行处理;控制层指逻辑集中的控制器,负责维护全网视图,通过南向接口对数据平面的设备进行集中控制,完成网络流量的分配;基础设施层由交换机等网络设备组成,提供数据转发的能力[7].

Fig. 1 SDN framework图1 SDN架构

SDN的架构决定了SDN的三大特性:控制平面与数据平面分离、集中控制、可编程性.传统的网络体系结构不够灵活,无法获得网络拓扑信息,且需要不同的协议来满足不同的场景需求.随着网络的发展,网络中的协议也越来越多,配置管理也变得越来越复杂[8].而SDN通过控制器就可以获取到网络拓扑的全局信息,实现了对网络的集中控制,降低了网络节点获取相邻网络节点信息的通信开销以及对网络资源的占用率.同时SDN的可编程性,使得网络通过软件编程的方法,实现对网络的灵活控制,确保资源的优化分配.可以说SDN的出现给传统的网络路由算法带来了新的机遇和挑战.

多路径路由是根据网络流量分布和业务流量需求,选择满足约束条件的多条候选路径,并在这些路径中均衡通信流量,从而提高网络的可靠性和吞吐量,降低网络拥塞,减少传输时延[9,11].QoS技术的出现旨在解决网络拥塞问题,保证网络可以根据业务的不同需求合理地分配和调度资源,为不同的数据流提供不同的服务质量.文献[12]提出了一种基于SDN的多路径路由系统HiQoS.通过修改Dijkstra算法,控制器计算出满足QoS约束的多条路径,并使用Hash表来保存,然后定时更新这些路径的链路状态.当需要为业务流选择路径时,控制器根据带宽使用情况和队列状态等为其选择一条最优路径.孔祥彬等人[13]提出一种基于Dijkstra算法的QoS路由算法,为业务流选择满足带宽约束的路由.这些研究大多是基于Dijkstra算法或对其进行改进,目的是计算出从源节点到目的节点的最短路径,计算效率低,不适合大型网络环境.文献[14]提出了一种基于SDN负载均衡的多路径路由算法.控制器收集每一条链路的流量负载信息,当新流到达时,控制器计算所有可以转发该流的路径,通过比较路径的链路负载选出一条最小负载的路径.该算法需要考虑该流的所有转发路径,在拓扑复杂的网络中,计算量过于庞大.

2 SDN路由机制

传统的路由技术可看作是一种P2P架构,通过建立一张路由表,在路由器与路由器之间运行路由协议,相互交换路由信息从而达到路由共享.而在SDN中,只需要在控制器与交换机之间直接运行南向协议,由控制器统一计算转发规则再下发给交换机.下发有主动和被动2种模式,主动模式是指数据包到达交换机之前就进行流表设置,而被动模式指当新流到达时,发现没有与之匹配的流表项,便将其送至控制器处理,可看作是一种C/S模式.根据是否是多路径路由将SDN路由机制分为2类[9]:

(2)实验剂量设置:参考《中药药理研究方法学》中剂量换算方法“体表面积比”换算动物临床等效剂量,分别以复方α-酮酸片0.68 g/kg(临床日用量为7.56 g)、培哚普利片6 mg/kg(参考《NKF- KDOQI慢性肾病诊断、分类与分层指南》[15])、尿毒清2.25 g/kg(临床日用量为25 g)、JYP工艺A组药粉1.93 g/kg、JYP工艺B组药粉1.50 g/kg、JYP工艺C组药粉1.70 g/kg,作为大鼠药效学实验剂量。实验时以蒸馏水按剂量配制成所需浓度。

1) 最短路径路由

同时,2015年7月起,专责小组开始派遣一部分人员进入门诊一线,一对一驻点观察记录门诊医师的诊疗习惯、叫号规律、劳动纪律行为、患者就诊分布规律、患者看诊需时等内容。他们另外从医院信息系统提取所有门诊医生接诊患者的时间点数据,个性化分析每位医生的看诊行为。

目前主流的SDN控制器如POX,Ryu等皆提供了完整的数据转发模块,采用的基本都是最短路径Dijkstra算法.Dijkstra算法每次都会找出一条源到目的节点的最短路径,然而所有数据包的转发如果只依赖于最短路径,虽然方法简单,但是数据流很容易因为具有相同目的地址而选择同一转发路径,这将会降低链路利用率,容易导致网络拥塞,且不能很好地满足带宽、时延、抖动和可靠性等方面的要求[10].

2) 多路径路由

因而,中央企业的党建工作也应与央企履行社会责任的相关工作配套结合,促使央企更好地承担社会责任,促进企业与社会、环境的全面协调可持续发展。首先,加强企业内各级党组织对企业社会责任工作的领导,充分发挥出企业党组织的政治核心作用。其次,央企党建必须树立并弘扬企业社会责任意识,将履行社会责任作为企业党务活动的一个要点,创新企业价值观念。最后,建立履行社会责任工作体系,党组织与企业行政部门互相合作,完善企业社会责任的组织管理,推动企业承担社会公益责任。

如果将SDN路由视为一项决策任务,那么在网络中找到最理想的控制策略是最关键的问题.今天大多数采用白盒方法来解决这个问题[15].随着网络规模的扩大和网络应用数量的快速增长,当前的网络已经变得高度动态、复杂、分散和定制化.在应用这些传统的白盒算法时,也面临着一些挑战.具体来说,白盒方法通常需要对底层网络进行假设和简化,然而,这种理想化的模型在处理真实复杂的网络环境时往往会遇到困难.此外,白盒方法在不同的场景和应用程序下具有较差的可伸缩性[16].

Fig. 2 KDN framework图2 知识定义网络架构

低蛋白饮食通过减少饮食氮、酸、磷的摄入,减轻肾脏排泄代谢废物的负荷,可以延缓CKD 3~ 5期患者的肾功能进展、改善并发症,但易发生蛋白质营养不良。医用低蛋白主食是以普通米/面为生产原料,通过蛋白酶解技术析出蛋白质,留下米/面的其他原有成分,可在不影响进食体验的情况下,减少植物蛋白的摄入,同时保证CKD患者能量摄入和高生物效价蛋白的比例,既协助延缓肾功能进展又能避免营养不良的发生,在CKD 3~5期患者的治疗中具有很好的应用前景。

3 基于监督学习的SDN路由优化

监督学习[20]是一种标签学习技术,通过给定数据及标签建立系统模型,找到输入输出的映射关系,训练完成后,当输入新的数据后,得到预期结果.监督学习通常被用来做分类和回归任务,常见的算法有K-最近邻算法、决策树、随机森林、神经网络、支持向量机(support vector machine, SVM)等.

监督学习通过学习解决各种网络应用问题,如资源分配、Web服务、路由选择等.Valadarsky等人[21]提出了利用监督学习模型预测未来的流量需求,然后为该需求计算最佳路由策略.此外,也有利用监督学习模型直接学习路径的研究[22].在文献[22]中,作者提出了一种采用GPU驱动的软件定义路由器(SDRs)来执行深度学习技术,通过使用监督的深度信念架构(DBA)[23],以边缘路由器的流量模式作为输入,网络中的每个节点都会针对其发送流量的每个可能目的地训练不同的模型,以此来估计下一跳.研究表明:该架构在网络吞吐量和平均时延方面都优于传统的开放式最短路径优先(open shortest path first, OSPF).

生姜蛋白酶(酶活力≥800 U/mg)和猕猴桃蛋白酶(酶活力≥500 U/mg),购自上海鼓臣生物技术有限公司。

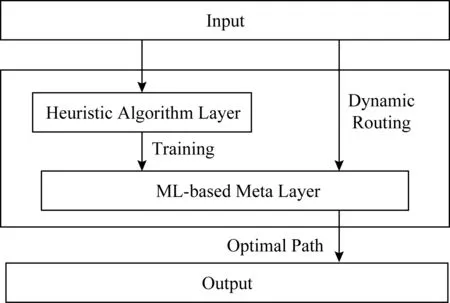

启发式算法,包括蚁群优化算法、模拟退火算法、遗传算法等可以有效管理流量,是解决动态路由优化问题的常用方法.这些算法可以有效减少端对端时延,减轻网络负载以及防止数据的丢失,但这是要建立在牺牲带宽为前提下且计算复杂度较高、计算时间开销大,导致其不能实时计算出最优路径[24].目前很多研究将监督学习算法和启发式算法相结合,以网络状态、流量矩阵作为输入,通过启发式算法计算出的相应路由策略作为输出进行训练神经网络,得到一个训练模型.当新流到达时,通过训练模型输出合适的路由路径.

强化学习(reinforcement learning, RL)[30]是目前人工智能最流行的一种学习方法.在一定环境状态下,通过代理与环境的交互,采取行动来获得最大的累积奖励,从而不断强化自己的决策能力.图4展示了常见的强化学习机制.首先环境给代理一个观测值及状态state,代理接收到状态后做出一个动作action,环境接收到动作后给予代理一定奖励并给出一个新的状态.其目的是从自己的经验中学习以使自己的奖励最大化.典型的强化学习算法有Q-Learning[31],它是通过对Q值的学习来更新存储状态、动作、奖励的表.

Fig. 3 Dynamic routing framework based on machine learning图3 基于机器学习的动态路由框架

Azzouni等人提出[25]基于深度神经网络的软件定义网络的NeuRoute动态路由框架同样也运用了启发式算法.该框架主要由流量矩阵估计器(TME)、流量矩阵预测(TMP)、流量路由单元(TRU)组成.首先TME通过OpenMeasure框架[26]使用连续的在线学习技术自适应推理和测量流量矩阵,然后TMP使用长短期记忆递归神经网络(LSTM-RNN)对TME产生的流量矩阵进行训练来预测未来网络流量矩阵,最后TRU将预测的流量矩阵和当前的网络状态作为输入,通过启发式计算出来的相应路径作为输出,训练前馈神经网络模型.在新流到达前,该训练模型计算出最优路由路径,然后TRU将选择的路径发送给控制器,控制器安装流表项.当新流到达时,转发规则已安装,交换机直接转发数据包,大大减少了网络时延.

研究表明:将启发式算法和监督学习算法结合对SDN路由优化具有一定优势,其运行时间远小于启发式算法,而网络时延、抖动等性能与利用启发式路由的结果相似.可见,利用监督学习进行路由优化是一种有效的方案.但是启发式算法被定义为NP问题,在利用启发式算法获取标签的过程具有较高的复杂度,且在网络管理过程中不能灵活地调整运维策略.文献[23]提出了一种基于监督学习的路由框架,该框架允许使用深度学习模型替换启发式方法,将流特征和当前的网络状态作为深度神经网络的输入,为每条链路输出一个值,最后再将其转换成路径.实验证明该方法实现了最大链路利用率.

在表2中,我们对基于强化学习的SDN路由优化方法进行了小结,可以看出强化学习作为一门自学习技术,特别是深度强化学习,在SDN路由决策方面发挥着巨大的作用.但在强化学习智能体训练收敛之前,训练开销较大.随着网络规模的增大,网络中的服务和应用将变得越来越多,每当出现新的服务时,需要重新训练收敛,这将限制了智能体优化路由的灵活性和可扩展性[44].

2.3 党参总皂苷纳米乳粒径 粒径测定结果见图3,党参总皂苷纳米乳粒径为60.67 nm,多分散指数PDI为0.347,粒径介于10~100 nm,达到纳米乳要求。

表1对基于监督学习的SDN路由优化方法进行了总结,可以看出监督学习作为一种标签学习技术,特别是神经网络,在SDN路由优化方面发挥着巨大的作用.但它的缺点也是不容忽视的.无论是使用启发式算法的输入输出作为训练集还是对流量进行提前的感知预测分类,在训练过程中都需要获取大量的标签数据进行训练,这将导致一个很高的计算复杂度.所以,我们的研究重心应该是让流量具有自我感知特性,尽量不使用标签,让网络通过对历史数据的自主学习实现智能路由.

安长英(1986-),女,汉族,籍贯:山东临沂,硕士研究生,注册会计师、税务师、会计师,主要从事国企财务工作等。

Table 1 SDN Routing Optimization Method Based on Supervised Learning表1 基于监督学习的SDN路由优化方法

4 基于强化学习的SDN路由优化

Fig. 4 Reinforcement learning mechanism图4 强化学习机制

文献[24]将启发式算法融入到监督学习中,提出了一种基于监督学习的动态路由框架,目的是获取满足QoS要求的最优路径.该框架如图3主要包含启发式算法层和机器学习层,将启发式算法层的输入(全局网络状态)和输出(最优路径)作为机器学习的数据集,然后在动态路由过程中,机器学习模型可以根据输入的网络状态快速计算出最优路径.实验表明:该方法计算效率高,且具有更好的网络性能.

将SDN路由优化看成一个决策问题,运用强化学习方法进行路由优化.网络即为学习环境,将网络拓扑、流量矩阵等视为状态,改变链路权重视为动作,运维策略如QoS服务质量等作为奖励,不断训练,得到一个模型.当新流到达时,可以快速计算出合适的路由路径,使网络性能最优.

教学从形态角度看,来自于人们的实践活动——交往。所谓教育,即交往的双方通过传递经验,影响人身心发展,形成教育。教学是教育的核心,传道授业离不开交往。教学中交往的主体离不开师生,缺失其中的一方将导致教学目的的落空,但双方在教学中的地位并不平等。后现代主义课程论者多尔认为:“教师是内在情境的领导者,而不是外在的专制者。”教师因在学科领域的知识积累,成为课程教学的主导者,学生则是主动学习的参与者,教学即特殊的交往。

由于机器学习在机器人控制、自动驾驶汽车等相关应用的成功,Mestres等人[17]提出了一种基于机器学习(machine learning, ML)的网络控制方法,这种新的范式被称为知识定义网络(knowledge defined networking, KDN).该范式将SDN、网络分析(network analytics, NA)和人工智能(artificial intelligence, AI)结合起来,促进了人工智能在计算机网络中的操作和管理[18].其框架如图2所示,知识平面通过控制和管理平面收集丰富的网络视图,然后利用机器学习将其转化成知识,并根据这些知识进行自动化决策.在路由优化决策中,我们的目标是利用这些知识赋予每个节点感知、询问、学习、推理和反馈等认知行为,使他们可以实时、在线地做出自适应路由决策,以达到最优网络性能[19].

Lin等人[32]在Kandoo[33]和Xbar[34]架构基础上,提出了一种符合OpenFlow协议的多层分布式控制架构.如图5所示,该架构主要由超控制器、主控制器、从控制器和OpenFlow交换机4个部分组成.交换机负责数据的收集和转发,从控制器将交换机收集的网络状态发送给主控制器,主控制器负责对每个传入的流进行路径计算,唯一的超控制器控制全局网络状态.在此架构基础上提出了基于强化学习的QoS动态路由算法(QoSaware adaptive routing, QAR),该算法将softmax作为动作选择策略,状态-行动-回馈-状态-行动(state-action-reward-state-action, SARSA)作为Q值更新函数:

Qt+1(st,at)Qt(st,at)+

α[Rt+γQt(st+1,at+1)-Qt(st,at)],

其中,α∈[0,1]表示学习效率,决定有多少误差需要被学习;γ∈[0,1]表示对未来奖励的衰减值;Rt表示在时刻t的QoS感知奖励.根据采取行动的成本、传输时延、排队时延和可用带宽计算出一种实时的自适应QoS路由决策,实现了控制负载的共享,减少了信令时延.实验表明QAR相比于Q-Learning方法,性能更优且具有较快的收敛性.

Fig. 5 Distributed hierarchy construction图5 分布式层次结构

因为SDN网络是一个复杂的连续时间系统,对数据流的细粒度进行管控,所以维护网络状态、动作、奖励信息的Q表会占用大量的存储空间,并随着Q表的不断增大,查表问题将是一个不容忽视的问题.为了解决这个问题,Sendra等人[35]提出了以神经网络代替Q表的学习过程,采用深度Q网络(deep Q network, DQN)的方法来进行智能路由,根据最佳网络状态和运维管理策略选择最佳数据传输路径.该方法降低了损失率和时延,提供了一个更好的QoS.然而DQN不能实时收敛,因为对SDN网络的操控是一个连续控制的问题,而DQN只适用于低维离散空间的控制和优化[36].

B超引导下肝组织活检术在临床上越来越普遍开展,该术创伤小。安全性高,并发症少,为肝病患者及早明确诊断和合理治疗提供了科学依据,值得大力宣传普及和推广。但该术还是一有创术,还存在一定风险性,必须根据循证护理方法,对患者施以正确的术前术后护理干预、教育评估和指导,以提高穿刺术的安全性。

传统的强化学习基于表的方法记录状态、动作的奖励,对最优行为策略的收敛率低,且不能解决高维状态和动作空间的问题.而深度强化学习(deep reinforcement learning, DRL)[37]将深度神经网络和强化学习结合,利用深度神经网络逼近值函数,使用强化学习的方法进行更新,自动从高维数据中提取低维特征,有效地压缩网络状态空间,从而使RL能够解决以前在处理高维度状态和运动空间时难以解决的大规模网络决策问题[16].

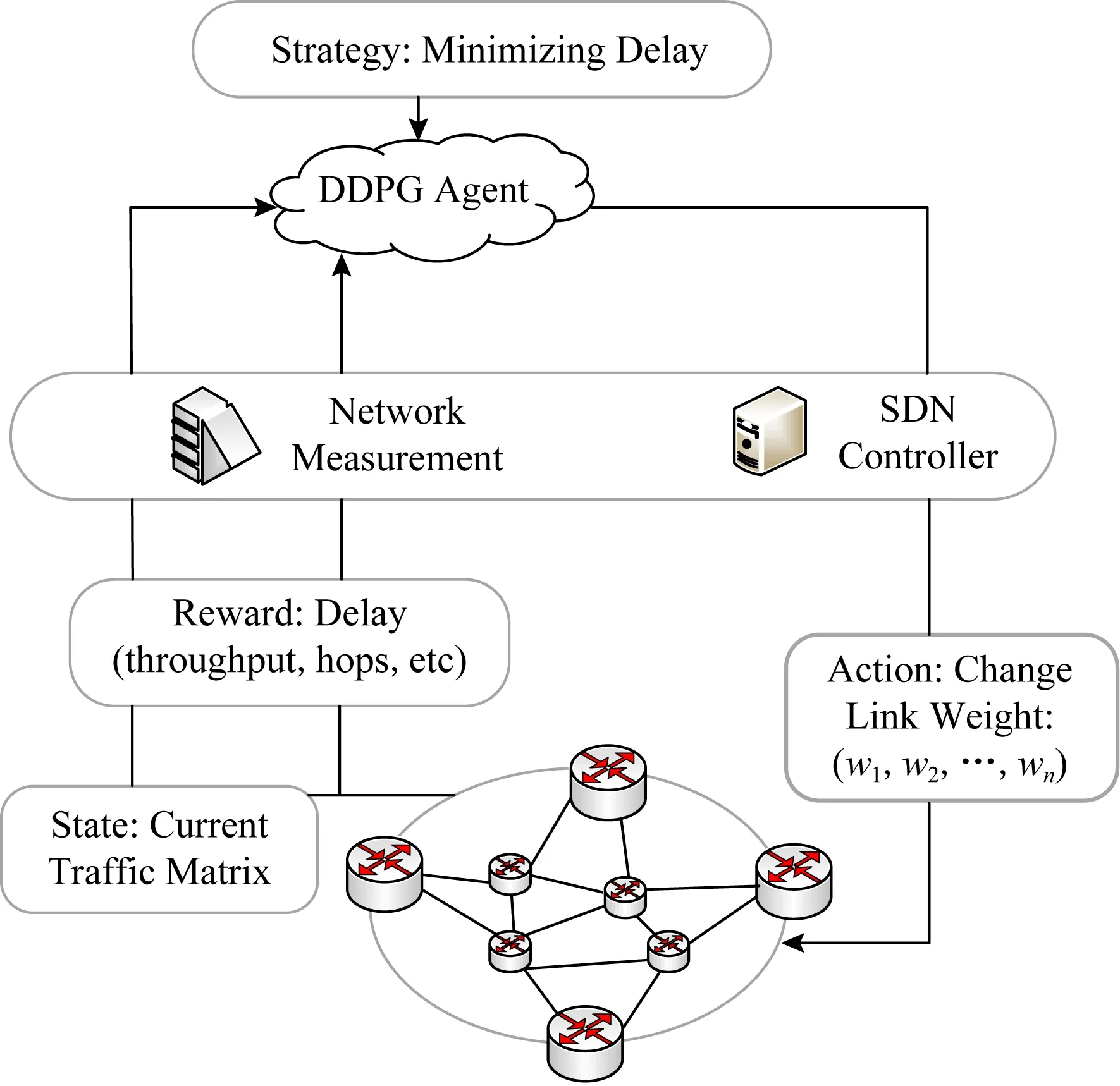

文献[38]首次提出了用自动化DRL代理提供路由配置.该研究可以自适应网络流量状况,通过DRL代理在单个步骤中提出最优的路由决策,实现了对网络的实时控制,克服了优化和启发过程中迭代步骤的繁琐.其中DRL代理是一种确定性策略梯度算法,通过状态、动作和奖励的更新与环境进行交互,状态即为流量矩阵,动作为改变链路权重,奖励为网络时延,其目的就是通过状态S到动作A的映射得到最优行为策略,从而最大化奖励,即最小化时延.

我认认真真地分析了抛光市场的未来行情。一旦金融风暴来了,必定有许多的小抛光厂湮没或转向,景花厂只要顽强地撑下去,撑到金融危机这片乌云过去了,抛光市场就会出现粥多僧少的现状,那时,景花厂便如鱼得水,如龙得云了,订单如雪花似的飞来,景花厂必将繁花似锦,一片辉煌。

Fig. 6 DROM framework图6 DROM框架

和文献[38]类似,Yu等人[39]提出了一种基于机器学习的SDN网络框架,该框架主要用一种深度强化学习算法——深度确定性策略梯度(deep deterministic policy gradient, DDPG)[40]来优化SDN网络路由,在此基础上提出了一种路由优化机制DROM,其架构如图6所示.DROM通过SDN控制器对网络进行分析和测量来获取全局网络状态,并确定一个最优行为,即一组链路权重,通过最大化奖励,不断更新链路权重集,SDN控制器也不断生成新的规则来建立新的路径.以此类推,不断迭代优化,直到获得最优解.其中奖励可以是单个参数如时延、吞吐量,也可以是包含多个参数的综合策略:

Ri→j=R(i→j|st,at)=

-h(at)+αdelayij+βBWij+γlossij+θTPij.

该式表示在状态st、动作at下的奖励,包含成本、时延、带宽、损失率、吞吐量等性能,其中h表示执行操作的成本,α,β,γ,θ∈[0,1]为可调参数,由运维策略决定.实验表明:DROM实现了在连续时间内对网络进行全局、实时、自定义的智能控制和管理,具有良好的收敛性和有效性.

由于流量具有周期性和相关性等特征,文献[41]提出将循环神经网络(recurrent neural network, RNN)作为输入神经网络,将之前所学状态描述联系起来一起学习,以得到一种更准确的结论.在RNN的基础上,结合DDPG,自动生成用于流量工程的策略.与最短路径相比,减少了网络的平均传输时延,但强化学习代理无法达到稳定,会引起流量的抖动,且不能迅速收敛.

此外,当前的研究大多使用模拟仿真的方法来评估网络性能,并未部署到实际的SDN网络中,未涉及如主机、交换机流表、SDN控制器等特定元素.近期,Witanto等研究者[42]从SDN本身的系统架构及流处理过程出发,提出了利用DDPG实现流量监控和路由的SDN应用方案.该方案主要由流量监控和路由2个模块构成,流量监控模块定期监控流量,统计并保存每个端口接收和发送的字节信息,用于训练神经网络生成流表项;路由模块通过深度强化学习代理根据交换机的端口利用率,生成图的边缘区权值,最大化奖励以使丢包率达到最小.然后控制器通过计算交换机之间最短路径,生成流表项发送给相关交换机,更新流表项.该研究只提供了一个思路,目的是实现一个管理系统,既可以检测设备之间的连接丢失情况,又可以路由网络流量使数据包丢包数最少.

将深度学习和强化学习结合来解决SDN路由问题,是目前一种比较普遍的方式,具有3方面优势:

1) DRL算法是一种黑盒方法.在设计动作空间和奖励时,DRL代理只需要设置不同的网络决策任务和优化目标,无需精确可解的数学模型.而传统的白盒方法要求对基础网络进行假设和简化来建立问题的数学模型并针对优化问题进行求解.

推荐理由:这是一套记录家国变迁的纪实作品,本书透过400幅定格的经典瞬间,全景式展现了改革开放波澜壮阔的辉煌历程和中国人的生活百态和精神面貌。全书以十年为断限,分为四卷,每卷100幅经典照片,并配有精炼的解读文字。重温改革开放走过的路,彷徨、迷惑、拼搏、创新,尽在这40年400个难忘的瞬间。

2) DRL可以处理复杂的状态空间,如AlphaGo[43],与传统的强化学习相比具有一定优势.

3) DRL可以实时处理高度动态的时变环境.当网络状态更改时,DRL代理不需要再次收敛.训练好DRL代理后,通过矩阵乘法一步就可以计算出近似最优解;相反,启发式算法需要采取许多步骤才能收敛得到新结果,这将导致较高的计算时间成本[44].

在SDN中,控制器对交换机进行集中控制并下发决策.通常来说,SDN也像传统网络一样为一对源到目标节点分配路径.但如果让网络具有应用感知和多路径分组转发,那么这2个特性可用于对不同输入应用程序进行分类并根据其类别分配不同的路径,这将增加用户的体验质量(quality of experi-ence, QoE).文献[27]提出了一种融合机器学习和软件定义网络的基于应用识别和路径状态感知的多路径包转发机制,该机制首先利用SVM算法[28]对控制器捕获的流特征进行优先级划分,不同的应用流具有不同的优先级;同时利用YKSP算法[29]找到源到目的地的k条路径;最后控制器通过可用带宽和延迟等参数评估每个可能的路径特征,并根据它们所属类的优先级为流分配路径.这个方法为具有QoS需求的数据中心网络、电信数据网、校园网等大规模网络环境带来了一定好处.

Table 2 SDN Routing Optimization Methods Based on Reinforcement Learning表2 基于强化学习的SDN路由优化方法

5 总结与未来展望

5.1 总 结

本文通过从监督学习和强化学习2个方面论述了机器学习在路由优化中的应用研究进展,并对其算法优缺点进行小结,如表3所示.由表3得出结论:通过对强化学习相关算法的不断改进,实时地、自适应地进行路由决策,在优化网络运维管理过程中,强化学习是一种非常有效的方法.与传统的算法相比,无论从SDN路由机制的有效性还是网络运行时延吞吐量等相关性能方面都有不可替代的优势;与监督学习相比,强化学习不仅不需要标签训练数据,同时还可以根据网络管理需求,灵活地调整优化目标.后期我们应该将研究重点放在强化学习在路由优化方面的应用上.

5.2 未来展望

目前,寻找一种自适应的实时路由策略将成为互联网的研究热点之一,还有很多问题需要我们深入研究,下面对其未来研究重点和发展趋势进行探讨.

Table 3 Performance Analysis of ML Algorithm in SDN Routing Optimization表3 SDN路由优化中的ML算法的性能分析

1) 数据驱动认知路由

数据驱动网络(data-driven networking, DDN)[45]集成了过去的知识,可以更快、更高效地计算网络算法.它的主要作用是计算和处理大量可用的数据.

从绝对数值来看,长三角各地级市之间总体基本公共服务均等化水平较高。长三角总体基本公共服务的基尼系数在0.2上下波动,在2011年后接近于0.1。2011年后,各项基本公共服务的基尼系数逐渐下降,可见“十一五”期间长三角的基本公共服务均等化进程取得了成效。结合基本公共服务发展水平看,基本公共服务水平发展与均等化两者间是并行不悖的,在基本公共服务投入水平上升的同时,城市间均等化水平也在提高(见图1、图8)。

在基于DDN的控制循环中,通过实时收集的数据自动调整驱动算法,进行自动化决策.数据驱动的方法促进了有趣且快速的启发式,其性能可能优于现有的优化或近似算法.更重要的是,数据驱动的方法适应并优化了网络的实际状态,以网络观察数据为主要特征,而不是针对某些假设的最坏情况的网络状态[45-46].

随着互联网的飞速发展,网络业务需求不断增加,网络规模不断扩大,网络结构、网络管理、调度诊断等问题变得更加复杂,用户对网络的要求也越来越高,需要网络具有自适应、自管理、自学习和推理等功能,即具备认知功能[47].文献[48]在网络中引入知识平面,使网络可以通过认知技术,在复杂、不一致、动态和不断发展的环境中有效执行并评估和改进自身的性能.与此同时,基于数据驱动的人工智能近年来取得一定进步,由于在网络中积累了大量的数据,我们可以通过这些数据,再应用机器学习进行大量的训练,将数据转换成知识,在复杂不确定的环境中做出路由决策和优化.我们的目标是建立新一代网络,这个网络可以驱动自己的部署和配置,可以诊断自己的问题,并就如何解决问题做出合理的决定.如果成功,将大大简化日常网络管理任务.

2) 基于迁移学习的路由优化

迁移学习[49]的任务是从一个环境中学习知识和经验,并应用到新的任务中.换言之,迁移学习的目的就是从一个或多个源任务中抽取知识、经验,然后运用到目标领域中去.在大数据时代,每天都会产生大量的数据,如何合理地利用这些数据是迁移学习需要解决的问题.在SDN路由优化中,通过强化学习技术得到自适应路由路径,在训练收敛之前训练开销很大,且当新的应用服务出现时需要重新训练,这无疑对计算机网络性能带来一定弊端.如果将之前训练好的路由优化策略模型迁移到新的网络环境中,然后利用少量的数据进行训练即可快速收敛,这样当出现新的服务时也不用重头进行训练收敛,减少了训练开销.

3) QoE感知路由

目前,QoS是最广泛使用的服务度量标准,其评价指标主要包括丢包率、时延、抖动和吞吐量等.这些指标通常被网络运营商用来评估网络性能.根据1~4节对机器学习在SDN路由方面的研究调研,我们发现大多数研究都是以QoS为优化目标寻找一条合适的路由路径,以达到最小时延、丢包率等性能.但是从整个生态平衡的角度来看,不管是运营商还是整个生产链,再到最后的互联网公司都需要和用户打交道,他们都有共同的目标,就是为了更好的用户体验以及用户满意度.QoE[50-51]是用户对服务满意度的主观度量标准.典型的QoE度量有平均意见得分(mean opinion score, MOS),可以由真实用户根据主观评分确定,也可以根据对交付的商品(例如音频、视频或文件)的属性进行客观测量来预测.MOS将QoE的主观感受分为优、良、中、次、劣5个级别[52].由于QoE值一般以线性方式依赖于多个QoS指标[53],网络指标(如数据包丢失)会根据服务类型的不同影响此类服务的QoE,因此我们可以通过发现QoS参数和QoE值之间的相关定量性来实时获取QoE值.

文献[54]设计了一种基于蚁群优化的启发式算法,以QoE为中心路由,根据流量和网络需求为不同的多媒体服务类型及其流计算最佳可用路径,以使用户QoE最大化.受此启发,我们可以根据历史数据学习QoS参数和QoE值之间的关系,对QoE进行预测.利用机器学习对SDN路由进行优化,以QoE为目标,对网络进行灵活的配置,实现QoE感知路由,最大化网络性能和用户满意度.

6 结束语

对SDN路由功能的优化是时代发展的必然产物,也是用户对网络性能稳定性的一种要求.通过对网络路由的不断优化,提高对网络资源的利用率,保证网络信息的服务质量,不断优化计算机网络性能,从而为更多的网络用户带来更好的体验.