基于卷积神经网络的立体图像质量评价

张爽爽,周武杰

(浙江科技学院 信息与电子工程学院,杭州 310023)

立体图像的相关应用越来越多地出现在人们的日常生活中。在立体图像的收集、传输、处理和显示过程中,可能会发生多种失真。因此,建立一种高性能的立体图像质量评价方法具有重要的现实意义。立体图像质量评价分为客观评价方法和主观评价方法两种方式。由于主观评价方法耗时、费力,在实时场景中的应用成为一大难题,因此,客观评价方法的应用更加广泛,它包括全参考评价、部分参考评价和无参考评价3种主要方法。全参考评价方法利用原始参考图像与失真图像进行对比,从而获得它们之间的差异性;部分参考评价方法使用了部分未失真原始参考图像信息;无参考评价方法则完全没有使用未失真原始参考图像。由于未失真的原始参考图像在实际应用中很难得到,所以无参考评价方法具有更高的实际应用价值。

在对客观立体图像质量评价的研究中,Chen等[1]提出一种传统的立体图像质量评价方法,即使用二维图像拓展到立体图像的评价方法。随着深度学习方法的发展,Lv等[2]提出了一种传统算法与深度学习算法结合的方法——基于双目自相似性(binocular self-similarity,BS)和深层神经网络(deep neural network,DNN)的无参考立体图像质量评价方法;Zhang等[3]提出了一种基于深度学习端到端的网络框架进行训练测试。此外,还有一些比较经典的传统质量评价方法,如Sun等[4]基于双目视觉机制的质量评价方法;Jiang等[5]不仅利用双目相互作用作为图像质量评价特征,还利用非负矩阵因子分解的颜色视觉特征;Hachicha等[6]提出基于小波分解和统计模型联合的无参考立体图像质量评价方法;Yang等[7]提出基于梯度字典颜色视觉特征学习的立体图像质量评价方法。2019年立体图像质量评价领域依旧呈快速发展的状态[8-12],Wu等[8]提出了一种基于层级结构的无参考图像质量评价方法,一种从局部结构到深度语义的方法。为了准确评价多种失真图像质量,Jiang等[9]和Liu等[10]提出针对一种或多种图像失真的质量评价方法,前者通过学习单目和双目局部视觉基元(monocular and binocular local visual primitives,MB-LVPs)来表征视觉皮层的局部感受野特征,从而进行图像质量评价,后者提出了一种基于深度学习网络框架进行分类和预测的立体图像质量评价方法。

上述研究虽然在立体图像评价问题上取得了一定的成果,但均没有考虑通用性,也没有将图像显著性作为研究对象,而且很少虑及立体图像左右视点权重分配问题,因此,在上述研究的基础上本文提出了一种基于卷积神经网络的无参考立体图像质量评价方法,并通过试验分析验证了算法的有效性和鲁棒性。

1 理论基础

1.1 融合图生成原理

立体图像左右视点的融合图采用文献[1]中的方法,又叫中央眼图。融合图像的生成公式如下:

Merge(x,y)=WL(x,y)IL(x,y)+WR(x+d,y)IR(x+d,y)。

(1)

式(1)中:Merge为立体图像左右视点的融合图像;WL和WR分别为左右视点的权值;IL和IR分别为立体图像的左视点图像和右视点图像;(x,y)表示图像某一像素点位置;d为立体图像左右视点的视差值。WL和WR是由归一化Gabor滤波器幅值响应得到的,其公式如下:

(2)

(3)

式(2)~(3)中:GL和GR分别为立体图像左右视点的卷积响应和。滤波器的形式如式(4)所示,是一个复数Gabor滤波器:

(4)

式(4)中:σx和σy分别为椭圆高斯包络线x轴和y轴的标准差;ζx和ζy分别为x方向和y方向的空间频率;θ为滤波器方向;R1=xcosθ+ysinθ,R2=-xsinθ+ycosθ。

1.2 深度学习原理

深度学习是一种机器学习技术,教计算机执行人类与生俱来的活动:从示例中学习。在深度学习中,计算机模型直接从图像、文本或声音中学习执行分类任务或其他任务。深度学习模型可以达到相对最优的精确度,有时甚至超过人类的表现。该模型使用大量的标签化数据及包含许多层的神经网络架构训练得到。深度学习广泛应用于自动驾驶、航空、国防、医学、工业自动化、电子学等领域。大多数深度学习方法使用神经网络架构,这也是深度学习模型通常被称为深度神经网络的原因。深度一词通常是指神经网络中的隐藏层数。传统神经网络只包含2~3个隐藏层,而深度网络可能多达150个隐藏层。深度学习模型通过使用大量的标签化数据进行训练,而神经网络架构直接通过数据学习特征,不需要手动提取特征。卷积神经网络(convolutional neural network,CNN)是最流行的深度神经网络类型之一。CNN使用二维卷积层学习输入数据的特征,这样的方式很适合处理二维数据(例如图像)。CNN通过直接从图像提取特征来运作,这种自动化的特征提取使深度学习模型能够为计算机视觉任务(如图像质量评价)提供高精确度。

2 模型方法

基于卷积神经网络的图像质量评价方法整体结构如图1所示,将立体图像的融合图像输入质量图生成网络中,得到相应的质量评分,然后加权融合得到最终的质量评分。质量图生成模块和加权融合模块是基于卷积神经网络的图像质量评价方法的主要组成部分。

图1 基于卷积神经网络的图像质量评价方法的整体结构

2.1 质量图生成模块

质量图生成网络模型主要采用SegNet网络[13],其主要组成层为卷积层,在编码器部分,基本结构是两层卷积加一层池化作为一个小模块,输入失真图像的大小为w×h×3,输出质量图的大小为w×h,卷积核的大小都是3×3,激活函数采用线性修正单元(ReLU)函数。第l层具有C个滤波器的卷积层,其第i个滤波器的输出

(5)

网络中使用的监督标签是基于图像结构相似度(feature similarity,FSIM)的质量图,局部求FSIM质量图的效果要好于全局[14]。因此,本文中的FSIM质量图是局部映射矩阵。

2.2 加权融合模块

由于人眼对不同的立体图像的视觉关注度不一样,关注度越高的地方如果失真程度越大,则会严重影响立体视觉的整体质量,因此本文采用视觉显著的方法对质量图进行加权,得到最终的立体图像视觉质量

(6)

式(6)中:Qmap为立体图像融合视点图像的预测质量图;Smap为立体图像融合视点图像的视觉显著图;x为立体图像融合视点图像的尺寸。

3 试验结果与分析

3.1 试验数据库

将三维图像质量评价数据库LIVE Phase Ⅰ[15]和LIVE Phase Ⅱ[16]用于试验结果对比分析。

LIVE Phase Ⅰ:20对未失真的原始参考立体图像,365对失真立体图像;每个视点图像的大小为640 pixel×360 pixel;包含JPEG压缩失真、JPEG2000压缩失真、加性高斯白噪声(white noise,WN)失真、快速衰减(fast fading,FF)通道失真和高斯模糊(gaussian blur,GB)失真5种不同程度的失真;每对失真图像均为对称失真,且都有一个差分均值意见得分(different mean opinion score,DMOS)。

LIVE Phase Ⅱ:8对未失真的原始参考立体图像,360对失真立体图像;每个视点图像的大小为640 pixel×360 pixel;与LIVE Phase Ⅰ一样,包含5种不同程度的失真;针对每种失真类型,每对原始立体图像生成3组对称失真立体图像对和6组非对称失真立体图像对,非对称表示立体图像的左右视点为不同类型的失真或不同的失真等级;每对立体图像都有一个DMOS值。

3.2 试验训练阶段

试验在操作系统64位的计算机上实现,使用NVIDIA GTX 1080 TI显卡。深度融合网络框架是在以TensorFlow为后端的Keras深度框架上运行的。在训练深度神经网络时,使用的优化器是Adam。在迭代过程中,批量大小(batch size)为16,次数(epochs)为100,损失(loss)为均方误差(mean square error,MSE)。

3.3 试验结果分析

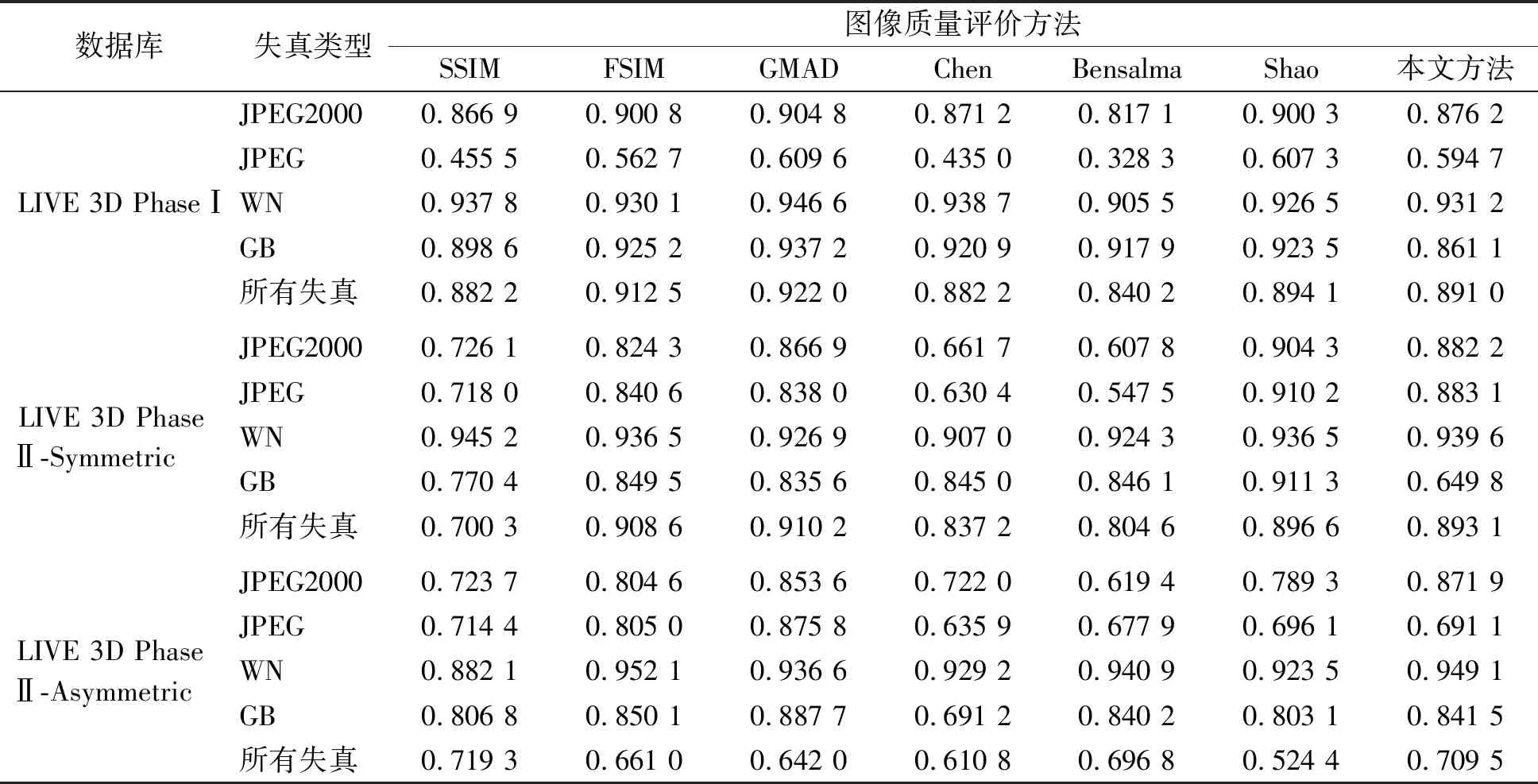

利用皮尔森线性相关系数(Pearson linear correlation coefficient,PLCC)、斯皮尔曼秩相关系数(Spearman rank order correlation coefficient,SROCC)、均方根误差(root mean square error,RMSE)3个评价指标对比模型的精确度。用PLCC度量模型的预测准确性,若PLCC相关系数的值越接近1,则说明该图像质量评价算法的性能越好。由于我们创建的平面数据库只包含JPEG、JPEG2000、WN和GB 4种失真类型,所以试验中只对这些失真进行测试分析。表1和表2分别为用PLCC和SROCC两个性能指标将本文方法与一些经典评价方法进行对比的结果。对比的6种方法分别是SSIM、FSIM、GMSD、Chen[1]、Bensalma[11]和Shao[12],前3种为平面全参考图像评价方法,后3种为立体图像质量评价方法。所有失真包含JPEG2000、JPEG、WN、GB 4种失真类型。PLCC系数显示,本文方法在整体上占优势;SROCC系数对比结果表明,本文方法应用于非对称失真立体图像会有更好的效果。由于本文为无参考评价方法,本文方法可能略低于全参考评价方法,但相比较于无参考方法,本文方法确实达到了一定的预期。

表1 本文方法与其他方法在PLCC评价指标上的结果对比

表2 本文方法与其他方法在SROCC评价指标上的结果对比

4 结 语

本研究基于自制的失真平面图像数据集提出了一种有效的立体图像质量评价方法。首先以自制平面图像数据集及其相应的高性能全参考图像质量评价方法求得的质量图为标签,对质量图生成网络进行训练,利用深度卷积神经网络能够较好地模拟人类视觉系统神经元的生理功能,使得网络的预测与人类主观得分保持高度一致;然后使用训练好的网络对融合视点进行质量图预测;最后经加权融合得到立体图像的质量得分。在此基础上,将本文方法在两个知名的三维LIVE质量评价数据库进行试验分析,结果表明我们提出的算法在一定程度上提高了图像质量评价的性能。