基于多模态信息融合的图像情感标注方法

唐智川,刘肖健,杨红春,卢纯福

(浙江工业大学 工业设计研究院,浙江 杭州 310014)

0 引言

随着信息技术的不断提升与发展,人们生活中的图像资源日益增多。在众多的图像资源以及图像数据库中,如何方便用户检索、提高用户搜索效率,已获得众多学者的关注,而图像标注是其核心基础问题[1-4]。情感作为图像的一个重要语义,是人们检索和选择图像的重要依据,因此对于图像进行情感标注显得至关重要[5-7]。

图像标注方法主要包括显性标注(explicit tagging)和隐性标注(implicit tagging)[8]。早期的显性标注方法需要用户手动地输入和内容相匹配的关键词[9]。当前一些主流社交媒体网站,如YouTube和Flickr,也鼓励用户对多媒体内容进行标注。但是,由于很多图像的信息相对隐晦,不同用户对相同图像的理解也是不同的,因此很难对这些图像进行描述,所标注的关键词也具有差异性[10]。从而导致大部分用户在图像检索时无法获得满意的检索体验。为进一步提升标注效果,基于图像内容的显性标注方法被提出,该方法提取图像的色彩、形状、纹理等图像低层信息,获取低层视觉特征,进行自动标注[11]。但是,通过算法获取低层特征进行图像标注只是对图像表层信息的解读,无法获得更深层次的高层情感语义信息。相对于显性标注方法,隐性标注方法是通过用户对图像自发行为、生理反应(如面部表情、眼睛注视、生理信号等)的分析,进行自动标注[9]。隐性标注方法无需用户关注标注的过程,并且直接面向高层情感语义。

本文结合脑电信号(隐性标注)和图像内容(显性标注),提出了一种基于多模态信息融合的图像情感标注方法。首先,提取EEG(electroencephalogram)频域特征和图像特征(颜色和纹理);其次,结合两者特征信息,基于两种融合策略(特征层和决策层),对两种情感维度(愉悦度和唤醒度)构建支持向量机分类模型,进行图像情感识别与标注。为了评估方法的有效性,本文使用国际情绪图片系统(International Affective Picture System, IAPS)公共数据集进行了实验验证,与单独使用EEG或图像内容的标注方法进行了比较。

1 相关研究综述

图像情感标注的研究对象是图像和用户,涉及到图像的物理空间、用户的生理空间和心理空间(即情感语义空间)这3个空间及其相互关系[5],如图1所示。图像的物理空间指的是相应的颜色、纹理等低层特征;用户的生理空间指的是用户在浏览图片时的生理和行为信号,用户的心理空间指的是用户对视频的情感评估。其中,情感的评估表示方法包括类别方式(如喜悦,惊奇,哀伤,愤怒,厌恶,恐惧等)[12-13]和维度方式(愉悦度,唤醒度和优势度)[14-15]两种。本文使用PAD维度方式进行情感识别与标注:愉悦度(P)表示个体情感状态的正负特性(积极或消极、喜欢或不喜欢);唤醒度(A)表示个体的神经生理激活程度(兴奋活跃的程度);优势度(D)表示个体对情感状态的主观控制程度[16]。用户在浏览图片时的主观评估,不仅与图片内容有关,还伴随着一定的生理反应和行为上的变化。图像的物理空间影响着用户的生理和心理反应,用户的生理反应进一步表征用户的心理反应。目前的显性标注研究侧重图片物理空间和用户心里空间之间的映射关系;隐性标注研究侧重用户生理空间和心里空间之间的映射关系[17]。

基于图像内容的显性标注方法一般先提取图像的颜色、纹理等低层特征,然后,采用机器学习的方法建立低层特征和用户情感语义之间的映射关系[11]。先前研究表明,颜色和纹理的组合变化能够引起用户不同的情感变化。Hayashi等[18]开发了一个情感词图像检索系统(Image Query system by Impression words, IQI)图像检索系统,通过使用神经网络构建情感词和图像特征之间的映射联系,并根据新的图片自动生成情感词;王伟凝等[19]通过描述色彩自然语义,将图像情感理解语义与色彩语义相关联,构建高层情感语义查询框架,实现图像情感查询;刘增荣等[20]根据图像不同特征对情感语义的影响不同,在提取出颜色、纹理和形状特征后通过加权融合为新的特征输入量,并采用支持向量机(Support Vector Machine, SVM)来实现情感语义的识别。相对于显性标注方法,研究者们已经开始关注基于自发行为、生理信息的隐性标注方法。这些自发的行为、生理信息与用户情感之间具有一定的映射关系。Money等[21]和Soleymani等[22]已经调查了多种生理信号(EEG、肌电信号、血压、心率、皮肤温度、呼吸等)与情感语义之间的隐性联系。其中,EEG是神经元生理活动在大脑皮层上的总体反映,体现了大脑活动情况[23]。EEG包含了大量的情感信息,在大脑皮层的不同区域随着情感的变化而发生改变[24]。刘洪霞[10]提取EEG情感特征和图像低层特征,使用机器学习算法构建两者之间的联系,实现了一种基于EEG的图像情感检索模型;Keil等[25]使用IAPS图片库中的图片作为视觉诱发刺激,从中挑选3种情感状态的图片(正性,中性和负性),设计出一个图片闪烁的实验,分析不同情感图片刺激对人的稳态视觉诱发电位的影响;而另两个研究组[9,26]则使用事件相关电位N400和P300探索隐性情感信息。

如上所述,情感的表达是多模式的,因此可以通过融合多模式信息进行情感的识别。多模态信息融合技术是将多个信息源获取的数据和信息在空间和时间上进行关联、互补和综合,以产生对观测对象更优化、更全面的解释和描述[27]。主要包括数据层、特征层和决策层3个层面的融合。数据层融合是对所采集的原始数据直接进行融合;特征层融合是在对原始数据进行处理后(特征提取),再对获得的不同特征信息进行融合分析和综合处理;决策层融合是通过关联处理每个传感器所建立的初步结论,获得联合推断的结果[28]。一些研究者已经开始关注多模态信息融合技术在多媒体情感标注中的应用。Wang等[17]构建了一个基于用户EEG和视频内容的混合方法在愉悦度和唤醒度两个维度进行视频情感标注;Soleymani等[29]通过EEG和面部表情对用户在观看视频时的愉悦度进行实时检测,并同时进行情感标注;Koelstra等[30]构建了一个多生理信号的DEAP情感分析数据库,并基于情感标签使用决策融合分类方法进行音乐视频检索。但是,仍少有文献基于信息融合技术使用EEG和图像内容进行图像情感标注。

2 方法

本文的方法框架如图2所示。首先,将采集到的EEG信号和图片进行数据预处理;其次,提取EEG频域特征和图像的颜色、纹理特征;最后,结合特征信息,基于两种融合策略(特征层和决策层),构建支持向量机分类模型,对两种情感维度(愉悦度,唤醒度)进行图像情感识别与标注。

2.1 数据预处理

对于原始图片,将其从RGB颜色空间转换到HSV(Hue,Saturation,Value)颜色空间[33]。HSV颜色空间更符合人的视觉感知。

2.2 特征提取

2.2.1 脑电信号特征提取

共同空间模式(Common Spatial Patterns, CSP)已广泛地应用于多元信号处理和二分类问题[34],该方法能够最大化获得两种状态类别下的方差差异。本文采用CSP方法对脑电信号进行特征提取。

每种频率段下输入矩阵M的标准化协方差矩阵表示为:

(1)

(2)

式中:ER为特征向量矩阵,λR为特征值矩阵。构造白化矩阵

(3)

(4)

其中SCL1和SCL2具有共同的特征向量U,可对两者进行特征值分解,分别为:

SCL1=UλCL1U+,SCL2=UλCL2U+。

(5)

其中λCL1+λCL2=I,I为单位对角矩阵。通过CSP滤波后的特征矩阵可表示为

Z=P+M。

(6)

其中P=U+W。矩阵Z中前m行和后m行特征向量的方差能最好的区分情感维度两个类别(本文选择m=3)[34],则每种频率段下第i个输入样本矩阵的特征向量可以表示为

(7)

2.2.2 图像特征提取

采用颜色直方图和颜色矩方法对图像颜色特征进行提取。颜色直方图是基于特定的彩色模型对图像中出现的各种颜色的占比和频数进行计算和统计[35]。首先进行颜色量化过程,将选定的彩色模型分为多个颜色区间,即颜色直方图中的不同的bin;其次计算图像中各颜色位于每个bin中的像素数量,构成颜色直方图向量:

His={h[C1],h[C2],…,h[Cn]|

(8)

式中h[Ck]为第k种颜色出现的频数,且0≤h[Ck]≤1。计算获得颜色直方图后,可通过提取图像H、S、V通道的一、二、三阶颜色矩进一步得到颜色的空间信息:

(9)

(10)

(11)

其中:μi、σi、si为i通道的一、二、三阶颜色矩;pi,j表示第i个颜色通道分量中第j个像素的值;m×n表示图像中的像素个数。图像颜色特征由颜色直方图向量与9个颜色矩向量构成。

图像纹理特征提取采用完全局部二值模式(Completed Local Binary Pattern, CLBP)算法[36-37]。CLBP由符号(CLBP_S)、幅度(CLBP_M)和灰度级(CLBP_C)3个描述子组成,

(12)

(13)

CLBP_C=t(gc,cl)。

(14)

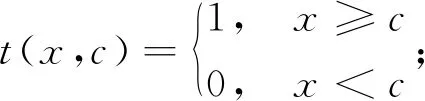

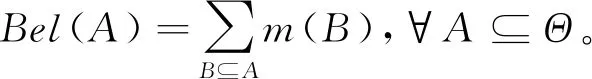

其中:P表示以中心像素点gc为中心、r为半径环形范围内所有像素点gp的个数;mp=|gp-gc|,p=1,2,…,P;cl为图像灰度级均值;c为阈值,若x≥c,则t(x,c)=1,若x 本文采用SVM分类器进行情感标注,其已广泛地应用于二元分类问题中,具有良好的分类性能和较高的准确率[38-39]。输入为EEG特征和图像特征,输出为1种情感维度的两个状态(两类),即正面(愉悦)和负面(不愉悦)的愉悦度,或高(兴奋)和低(冷静)的唤醒度。对于每个被试,随机选取80%的数据作为训练集进行各自的模型构建,剩余20%的数据作为测试集进行模型测试;其中,训练集的数据被随机分为10份进行十折交叉检验(9份为训练数据,1份为检验数据),以获得最优模型参数。首先,采用识别率(accuracy)和ROC曲线(receiver operating characteristic curve)对分类模型进行整体评估。accuracy是分类器正确分类的样本数与总样本数之比: (15) 式中:TP是将正类预测为正类的样本数,TN是将负类预测为负类的样本数,FP是将负类预测为正类的样本数,FN是将正类预测为负类的样本数;ROC曲线越靠近左上角边界,即曲线下面积(AUC)越大,表示分类器性能越好。考虑到正、负类样本数的不同,以及调研分类模型中不同情感类别的识别表现,因此采用精确率(precision)、召回率(recall)和F-score对分类模型进一步评估。precision反映了被分类器判定的正类中真正的正类样本的比例;recall反映了被正确判定的正类占总的正类样本的比例。两者的计算公式分别为: (16) (17) F-score是识别率的延伸,结合了precision和recall: (18) 本文通过两种信息融合策略(特征层和决策层)进行情感识别,并与单独使用EEG特征或图像特征的识别表现进行比较。 2.3.1 特征层融合 特征层融合是对获得的不同特征信息进行融合分析和综合处理。本文采用的特征层融合方式是将所有特征向量串联起来形成一个新的特征向量 [CLBP_S,CLBP_M,CLBP_C]}, (19) 然后输入给SVM分类器。 2.3.2 决策层融合 本文采用D-S证据推理作为决策层信息融合算法,作为一种决策理论,它可以很好地处理具有模糊和不确定信息的合成问题。首先,分别对EEG特征和图像特征进行模式预分类,构造两个二分类SVM分类器{S1,S2}。将本文中2类情感(待识别目标)构成的集合定义为识别框架Θ={CL1,CL2}。其次,将两个分类器的输出结果作为D-S证据推理的基本质量分配函数,分别获得两类情感的基本概率赋值(BPA)m(CL1)S1,m(CL2)S1,m(CL1)S2和m(CL2)S2,并通过正交规则进行融合: m(CL1)=m(CL1)S1⊕m(CL1)S2, (20) m(CL2)=m(CL2)S1⊕m(CL2)S2。 (21) 然后,计算每类的信任函数Bel(CL)。定义在Θ上的信任函数可以表示为 (22) 式中:Bel(A)为A的所有子集B的可能性度量之和,表示对A的总信任。故Bel(CL1)=m(CL1),Bel(CL2)=m(CL2)。最后,将类别判给具有最大绝对信度的命题: (23) 其中a为预先设定的阈值,本文a=0.5。 参与此次试验的健康被试共3名(2男1女,年龄范围:27~31岁)。所有被试均无脑部或神经性疾病,之前未参加过相关的脑电实验。被试在实验前被告知实验流程,并签署知情同意书。 表1 样本数量和标签 本文实验数据库使用IAPS[40]。作为一套国际通用的、标准化的情绪刺激图片系统,最新版本中共有高分辨率的彩色图片1 182幅,内容涉及动物、景观、人物、生活场景、运动、食物、灾难等。依据情绪维度理论,已用自我评定模型(Self-Assessment Manikin, SAM)对这些图片在愉悦度、唤醒度和优势度3个维度进行了评定。评定量表中的等级从1~9。根据评定等级,针对两种不同情感维度(愉悦度和唤醒度)分别将所有图片分为两类,即愉悦(等级大于5)和不愉悦(等级小于5),或兴奋(等级大于5)和冷静(等级小于5)。因此,每张图片具有两个标签(1个愉悦度标签和1个唤醒度标签),而愉悦度两种状态和唤醒度两种状态的分类模型是分开训练的,训练时分别用各自的标签。每类的样本数量和标签如表1所示。所有图片均已统一处理为大小1 024像素×768像素,分辨率72像素/英寸。 ActiveTwo32导脑电采集系统(荷兰BioSemi公司)被用来采集EEG信号。本实验中对设备脑电帽上所有32个通道的EEG信号进行采集。参考电极放置于左、右耳乳突处;接地电极为脑电帽上的CMS和DRL两个电极。在设备自带的ActiView采集软件中设置采样率为1 000 Hz、低通滤波为60 Hz、高通滤波为1 Hz[41]。安置脑电帽上的电极时,需使用医用导电膏降低阻抗,并关注软件中电极连接情况的提示信息。 实验中,被试需坐在采集室中的显示屏前根据提示进行脑电实验。被试被告知避免在EEG信号采集过程中进行无关的肢体运动,并尽量不要眨眼。 观察员坐在采集室外的观察室,进行实验的观察与控制。整体实验环境如图3所示。每个被试在整个实验中需完成1 182次(所有图片出现一次)情感感知试验(trial)。图4为单次trial的时序图。0~2秒屏幕空白;随后在2 s时伴随声音提醒在屏幕中出现一个十字,持续1 s,作为图片即将出现的提醒;3~8 s屏幕中的十字消失,随机出现一张情感图片,被试者进行情感的感知,这段时间采集到EEG数据被用作之后情感分类;8 s后情感图片消失,随机2~5 s的屏幕空白,以平复情绪。为防止持续试验带来的疲劳,每进行60次试验后安排4 min的休息时间。 图5显示了感知不同情感图片(愉悦度和唤醒度)时EEG原始数据(alpha频段),以被试1的两次试验为例。每次试验中3~8 s的EEG数据被用来调查EEG和情感等级的相关性。对theta(5~8 Hz)、alpha(8~13 Hz)和beta(13~29 Hz)3种频率段,分别通过目标功率(3~8 s)除以基准功率(1~2 s),得到3种频率段中相对功率的变化。通过计算功率变化和情感等级之间的相关性系数,可以观察到不同区域不同电极EEG的显著性变化。图6显示了alpha频段中EEG和愉悦度、唤醒度等级的平均相关性(所有被试)。白色代表正相关性,黑色代表负相关性。愉悦度展现了与EEG的正相关性,随着愉悦度等级的提高,额区和枕区区域的EEG功率不断增大。唤醒度与EEG呈负相关性,中心区域的EEG功率随着唤醒度等级提高而减小。 通过两种信息融合策略(特征层和决策层),对于每个被试,随机选取80%的数据进行各自分类模型的构建。同时,单独使用EEG特征或图像特征对同样的数据进行训练,获得的分类模型与之前的信息融合分类模型进行比较。图7为通过4种方法获得的分类模型分别对愉悦度、唤醒度测试集分类的平均含混矩阵图(所有被试)。矩阵灰色单元(主对角线)中的元素表示所有被试的平均正确率(正确识别的样本)和标准差;白色单元(非对角线)中的元素表示所有被试的平均错误率(错误识别的样本)和标准差。表2显示了每个被试在4种方法下对愉悦度、唤醒度测试集分类的识别率。图8为4种方法下愉悦度、唤醒度测试集分类结果的ROC曲线图(以被试1为例)。基于图7、图8和表2,可发现在对愉悦度的分类中,特征层融合方法(77.47%±2.36%)和决策层融合方法(81.02%±2.01%)的平均识别率高于EEG特征方法(69.04±2.56%)和图像识别方法(72.49%±2.23%);决策层融合方法获得最高的识别率,而EEG特征方法的识别率最低。在对唤醒度的分类中,信息融合方法(78.03%±2.23%,79.45%±1.89%)的平均识别率也高于单独特征方法(71.90%±2.14%,70.15%±2.58%)的识别率;决策层融合方法获得最高的识别率,而图像特征方法的识别率最低。且对于两种情感维度,信息融合方法的ROC曲线下面积也大于单独特征方法,即分类模型性能更好。 表2 每个被试在四种方法下对愉悦度、唤醒度测试集分类的识别率 续表2 所有被试在4种方法下对愉悦度、唤醒度中情感维度两个状态分类结果的precision、recall和F-score值如表3所示。三者的值越高则表示具有更好的分类表现。采用4(分类方法)×2(情感维度状态)的方差分析(ANOVA)评估分类方法和情感维度状态对分类结果的影响,以及分类方法和情感维度状态之间的交互作用。显著性水平为0.05。ANOVA结果显示,对于两种情感维度,分类方法对分类表现都具有显著影响(均p<0.001),而情感维度状态则对分类表现都不具有显著影响(均p>0.05);分类方法和情感维度状态之间无交互作用(p>0.05)。 表3 所有被试在四种方法下两类运动想象分类结果的精确率、召回率和F-SCORE 续表3 本文结合脑电信号和图像内容,提出了一种基于多模态信息融合的图像情感标注方法。首先,提取EEG频域特征及图像特征(颜色及纹理);其次,结合两者特征信息,基于两种融合策略(特征层和决策层),构建支持向量机分类模型,进行图像情感识别与标注。为了评估方法的有效性,使用IAPS公共数据集进行了实验验证。实验结果表明,信息融合方法(特征层融合或决策层融合)的平均识别率高于单独特征方法(EEG特征或图像特征)。本文提出的多模态信息融合图像情感标注方法可以有效地进行情感识别,并有助于缩小低层图像视觉特征和高层情感语义之间的语义鸿沟。2.3 情感分类(标注)

3 实验

3.1 被试

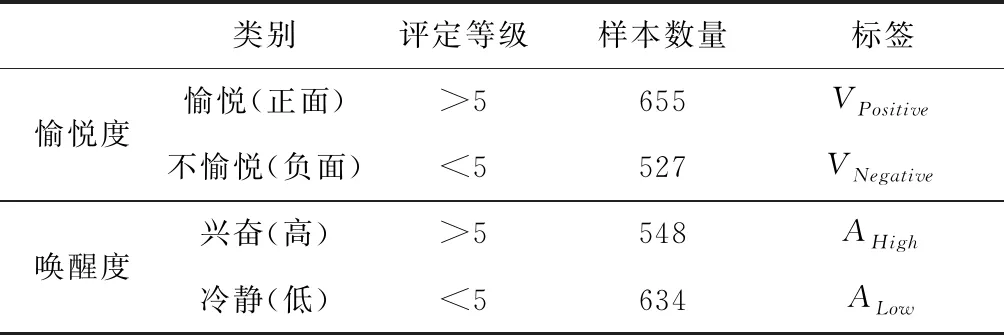

3.2 实验数据库

3.3 EEG数据采集

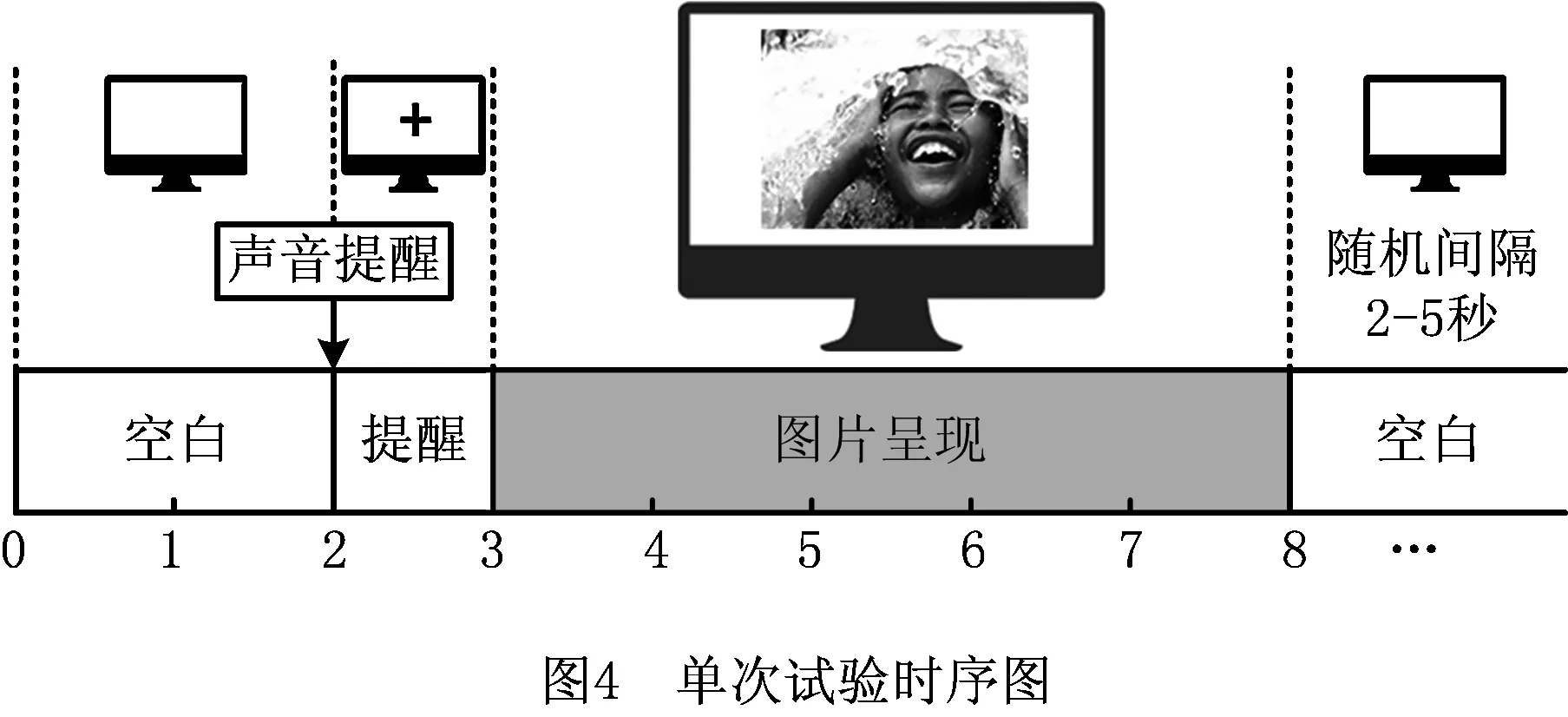

3.4 实验流程

4 结果分析及讨论

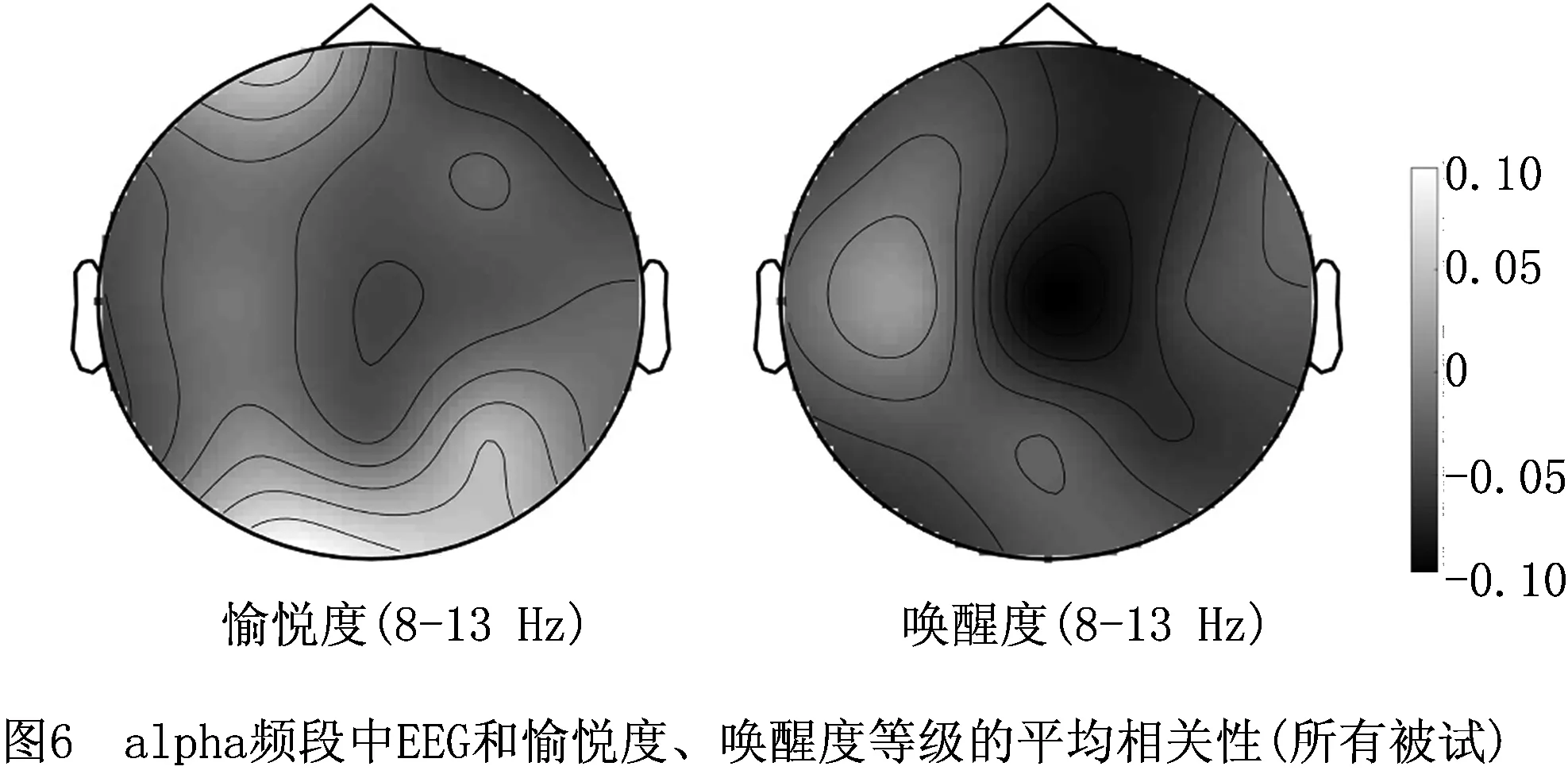

4.1 EEG和情感等级的相关性

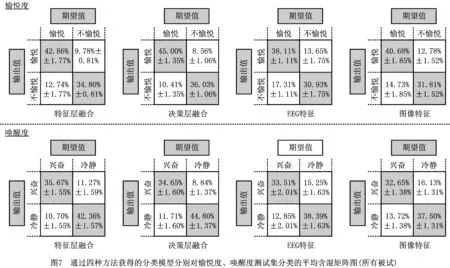

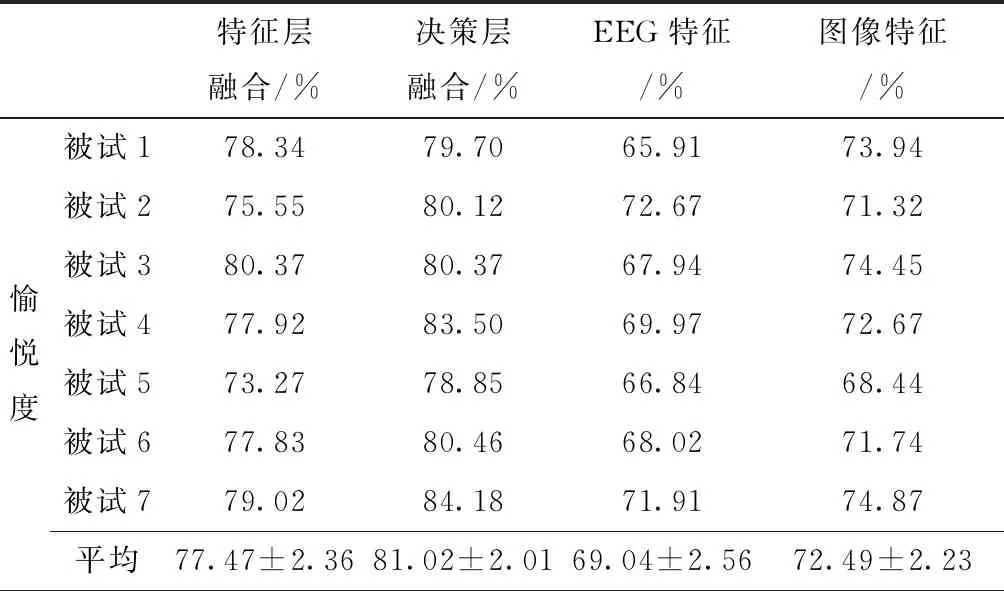

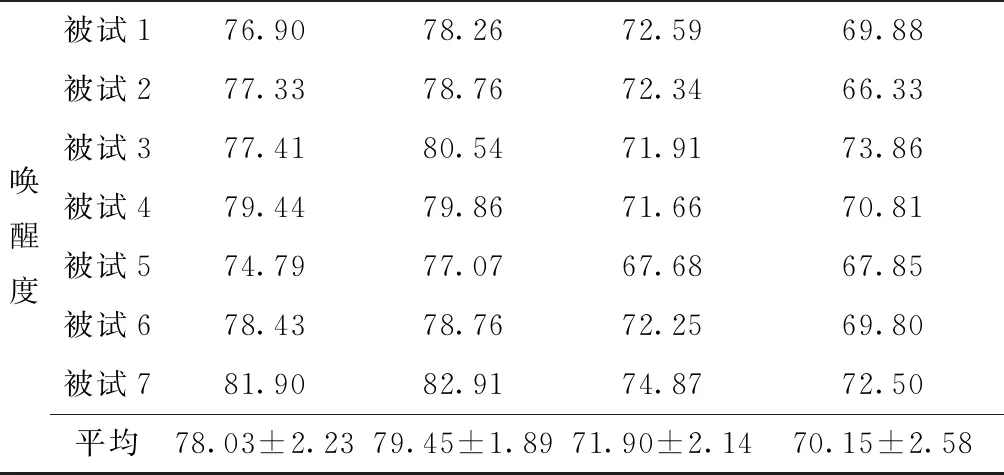

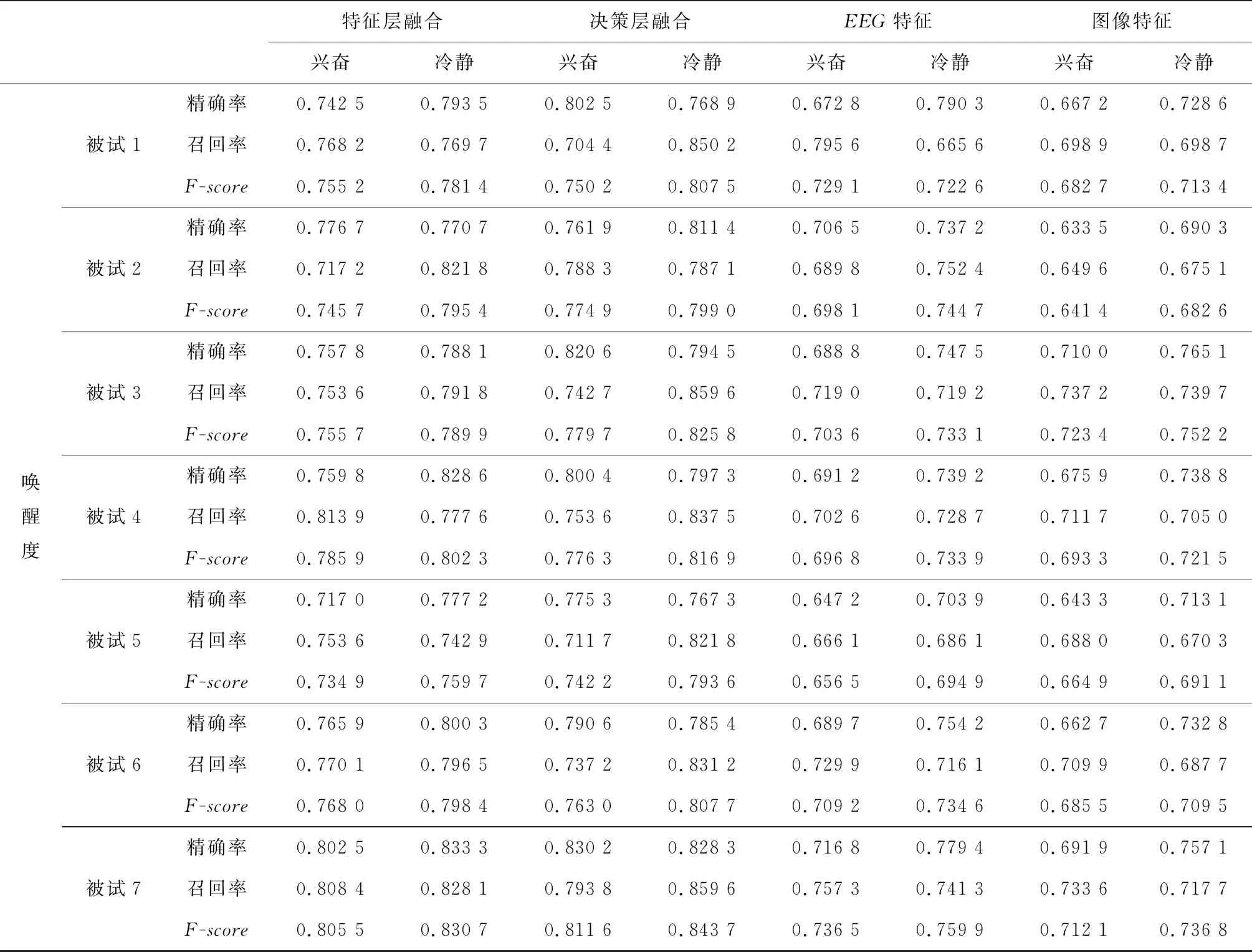

4.2 分类(标注)结果

5 结束语