基于PNP的多尺度目标视觉智能辅助降落系统

夏路 王琳 梁颖茜

摘要:小型无人机系统一般有气压计、陀螺仪、加速度计、光流计和GPS等机载传感器,由于飞行过程中机体结构产生的振动、建筑物遮挡和电磁干扰等因素,无人机的姿态和位置信息测量包含严重的测量噪声,无法满足精确降落要求,为保证无人机自主降落精度、实时性和安全性,利用计算机视觉技术和深度学习框架设计多尺度目标视觉智能辅助降落系统,针对GPS定位系统受到严重干扰情况,通过多尺度合作目标和PNP算法进行精确姿态和位置解算,从而向无人机系统提供精确的降落导航信息,在50Hz仿真条件下,视觉智能辅助降落系统在距目标20cm处能提供0.7cm/1.2°的定位精度,距目标15m处能够提供12cm/3°的定位精度,平均精度约为3cm/2°,能够满足无人机自主降落要求。

关键词:计算机视觉;深度学习;合作目标;自主降落

中图分类号:TP391.9文献标识码:ADOI:10.19452/j.issn1007-5453.2020.10.004

美国空军新版《科技战略》中为了提供有韧性的信息共享确立了基于视觉、天文和磁的替代导航的关键技术[1]。由于无人机驾驶员处于地面环境中,无法及时从飞行环境中获得多项直接的感觉输入,包括无人机周围环境的视觉信息、运动感觉等,所以需要无人机自主进行视觉导航[2]。无人机视觉导航技术是指无人机通过机载摄像机获取周围环境与目标的图像信息,然后通过分析处理图像来获取运动目标的信息,最后将视觉反馈信息作为无人机控制回路的输入,从而实现无人机的自主飞行。

国外科研机构和大学对无人机光学视觉辅助降落的研究较早。1991年,美国南加州大学研究人员利用机载相机和处理平台实现了无人机在预知环境条件下的自主降落[3]。2016年,德国航空航天中心的研究人员实现了固定翼无人机在75km/h汽车车顶的自主降落[4]。Tsai等[5]设计了T形的黑白图标合作目标辅助无人机着陆,用Hu不变矩识别T形目标,利用canny边缘检测以及hough变换提取T形中的特征。

国内对光学视觉辅助无人机降落的研究起步较晚。南京航空航天大学通过检测地平线和跑道线进行无人机位姿估算的方法,对固定翼无人机视觉辅助自主降落进行了研究[6];浙江大学基于双目立体视觉的信息,估算无人机的飞行参数,对无人机视觉辅助自主降落阶段的导航技术进行了研究[7]。南京航空航天大学徐贵力课题组[8-9]考虑到夜间着陆问题,选择波段为8~14mm的高发率粉体,制成黑色红外涂料,喷涂于T形合作目标表面,利用不变矩算法实现目标和特征的检测[10]。2016年,国内部分大学和研究机构逐渐由模型算法转向实体试验,如南京航空航天大学的无人机红外视觉自动降落引导系统和哈尔滨工业大学的无人机自主计算视觉定位方法等[11-12]。

图像处理技术以及摄像机硬件的发展使计算机视觉技术与无人机的导航问题相互关联。首先,依靠视觉所提供的实时信息可以与惯性导航和全球卫星定位系统信息进行融合,弥补后两者的缺陷,提高导航精度[13]。其次,摄像机相对传统传感器而言更善于捕捉运动信息,从应用的角度来看,视觉信号的抗干扰性能较强,而无线电和GPS信号则易受阻塞[14]。最后,摄像机属于被动传感器,利用的是可见光或者红外线这种自然信息,这在军事隐蔽侦察上尤为重要[15]。

目前无人机视觉导航主要有两种形式:一种是将机载摄像头拍摄的图像通过远距离图像传输模块发送回地面站,将数字图像处理与导航解算的工作放在地面站上运行,将解算得到的导航信息通过数据传输模块发送回无人机。这种方法的优点在于容易实现,且计算能力强大,缺点在于图像传输过程中会受到较大干扰造成图像失真,同时存在一定的时延,无法满足实时性要求。另一种方法则是采用机载运算模块进行图像处理,摄像头获取的数字图像直接通过串口传输给机载的图像处理模块,地面站只負责监视无人机飞行状态,保证安全。这种方法具有很高的独立性,能够脱离地面站独立工作,数据传输基本没有延时,但受到机载图像处理模块的性能限制,运算能力有限,并且增加了无人机的载荷。

近年来,计算机视觉技术飞速发展,目标检测作为计算机视觉中最基础和最重要的任务之一,诞生了很多性能良好的算法,如基于运动目标的帧差法与背景建模法、基于区域对准的模板匹配法、基于特征检测的SIFT算法以及基于深度学习的Yolo和SSD等检测算法[16]。

1系统总体设计

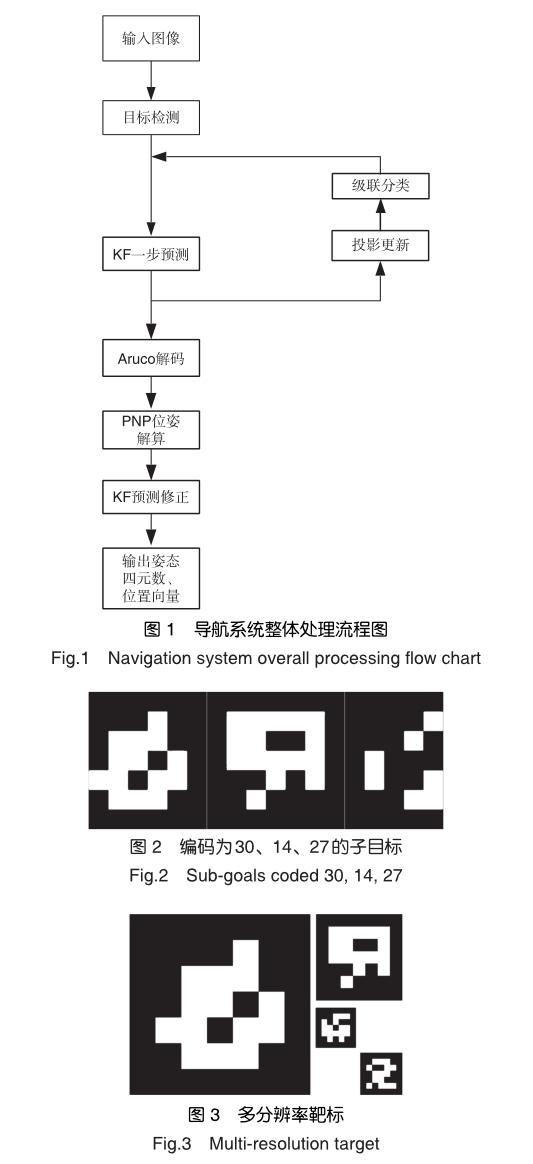

一般来说,任何降落导引系统都要满足三个要求:可靠性、完整性和准确性[17]。小型无人机系统视觉降落导航系统整体处理流程图如图1所示,摄像机安装于机腹云台并保持镜头始终竖直向下。相机将采集到的图像传输到机载电脑并由其进行实时处理,得到靶标相对于相机的空间位置及姿态信息。可选结合飞控回传的飞机GPS信息,输出降落目标的精确GPS位置,直接作为飞控的导航点使用。

1.1合作目标设计

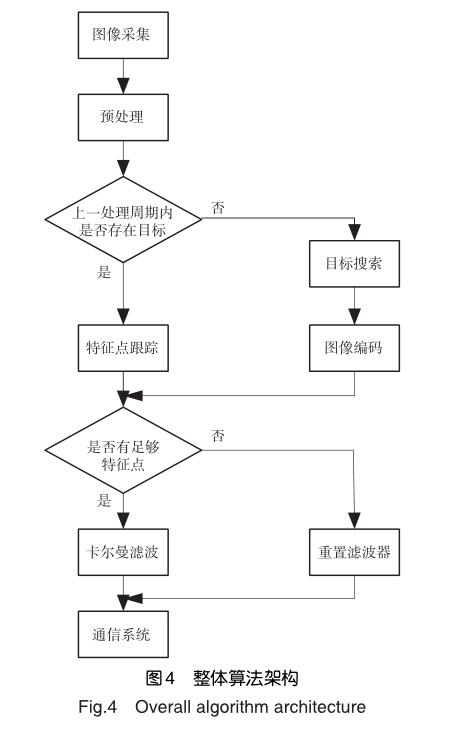

子目标按照Aruco协议进行设计,采用5×5分辨率25bits二维码,边缘留空一位作为识别边界,按照汉明码标准进行编制和奇偶校验,具有一定的容错能力。每个子目标在汉明码规则下拥有唯一的十进制编码,用于存在多个子目标时进行区分,如图2所示。

导航系统设计工作范围为15~0.3m,单个目标无法覆盖全段,因此需要使用多个不同尺寸目标进行引导。最终的合作靶标设计如图3所示。

1.2硬件设计

硬件平台选择NVIDIA Jetson TX2图形计算核心板,配合OV5640型摄像头、XCB-Lite-A04型机载底板,能够满足在油污、振动等恶劣环境下稳定工作的要求。

通信方面使用串口进行,保证了图像处理系统的适配性。机载图像处理系统在保证了处理实时性的同时减少了空地数据传输量,节省了机载硬件的功耗,保证了无人机的续航性能不受影响。

1.3软件总体架构

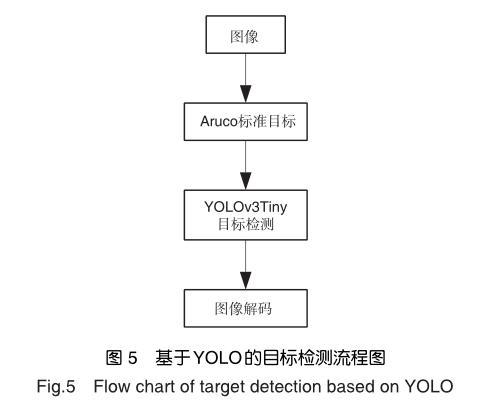

软件核心采用C++编写,使用开源深度学习架构Darknet和基于其构建的YOLOv3tiny;Intel公司的OpenCV开源计算机视觉处理库进行图像处理;Nvidia公司的CUDA库进行Tegra架构下的GPU加速;开源数学库Eigen进行数学运算加速。软件通信部分采用Python编写,单独创建线程保证通信稳定性。整体算法架构如图4所示。

2系统总体设计

2.1目标搜索策略

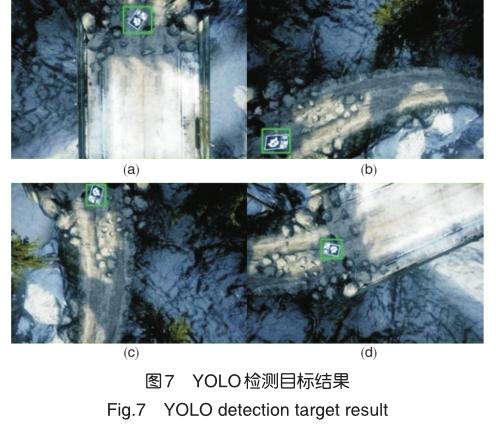

目标搜索策略的任务是在多种复杂视场下,从图像中搜索合作目标并提取其特征点的方法。由于级联分类器训练数据的特点,其对背景的泛化能力较弱,而且当目标在视野中尺寸很小时表现欠佳,需要一个能够较好处理小目标的检测机制。此外,无人机飞行环境复杂多变,干扰目标较多,需要一个环境适应性很强的目标检测算法。针对此要求,决定采用YOLO目标检测架构,如图5所示。

YOLO是由Joseph Redmon等于2016年提出的一种基于深度学习的目标检测算法[18]。该算法在目标分类准确率、运算速度和背景误检率上均取得了较大突破,但在目标位置准确度上表现较差。系统利用其高鲁棒性来处理复杂背景下的目标大致位置问题,将目标具体位置确定放置于后续步骤进行。作者给出了其基于darknet深度学习架构的开源工程,系统使用了该网络的小型化加速模型YOLOv3Tiny,并使用CUDA进行GPU加速,使其处理速度达到10ms以内,满足系统实时性要求。

2.1.1區域生长

由于合作目标主体颜色为白色,在阳光下呈现较高亮度,所以系统选择亮度最高点进行区域生长,确定白色主体的全部范围。区域生长具体算法如下:(1)图片全部标记为背景,选定当前点为生长原点,并将其压入边缘栈;(2)遍历边缘栈内所有点,将其8邻域范围内背景点压入待处理栈;(3)清空边缘栈;(4)计算前景区域的平均灰度;(5)遍历待处理栈,将和平均灰度差在阈值范围内的点加入前景区域,同时将该点压入边缘栈;(6)清空待处理栈;(7)重复步骤(2)直至边缘栈为空。

该算法优点为能够完整地保留目标边界,不受光照条件和阴影的影响;缺点是计算代价大,处理速度较慢。所以在实际过程中,系统会将图像分辨率压缩至720×555处理。

2.1.2像素级角点提取方法

角点提取使用了Shi-Tomasi算子,该算子为Harris算子的改进,具有筛选能力强、计算代价小、适应性强等特点,但精度只能达到像素级别,适合作为初步特征点提取方法使用。当一个检测窗口在图像上移动时,对于一个二值边缘图像有如下情况。当窗口处于平滑区域(见图6(a))时,窗口在各个方向上移动时没有变化;当窗口在边缘上(见图6(b))时,窗口在边缘方向上移动时没有变化,在垂直边缘方向上移动时具有变化;当处于角点(见图6(c))时,窗口在各个方向上移动均有变化。Shi-Tomasi和Harris角点检测均依据窗口在各个方向上的变化程度决定是否为角点。

2.1.3角点亚像素化

由于像素级角点并不能满足系统的精度要求,需要对其进行亚像素化处理,利用灰度梯度求得精确角点位置。具体方法为利用二次多项式来逼近角点响应函数R(x,y),找到其亚像素级极值相应位置,得到角点的亚像素级精确位置。

可直接解出角点的亚像素级坐标(x,y)。

YOLO检测目标的相关结果如图7所示。仿真结果表明,该视觉识别策略,可使无人机在复杂环境条件下,实现对目标图像的检测与识别,环境适应性较强。

2.2姿态解算

无人机的着陆过程中,如何获取高精度的无人机的位姿对于控制无人机准确安全着陆至目标点具有十分重要的意义[19]。姿态解算部分是从图像到空间坐标的映射环节,是保障导航系统精度的核心。其主要由图像解码和PNP姿态解算两步组成。其中图像解码部分负责提取图像特征点并判断识别有效性,PNP姿态解算负责由特征点像平面位置向空间位姿信息的映射。

由于合作靶标使用Aruco标准编码,该步骤可以使用开源库进行实现,简化了程序设计并减少了姿态解算环节造成的误差,便于后续滤波。

2.2.1图像解码

靶标大致位置确定后,对其进行自适应二值化,得到增强后的靶标图像(见图8)。检测图像中的候选靶标,并以其4个角点为每个靶标的特征参数进行下一步处理。

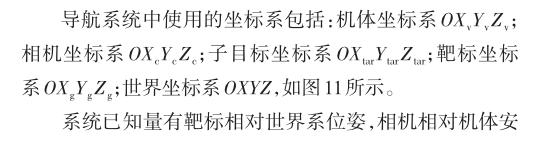

使用上一步提取到的4个角点,对靶标进行透视变换,转换为标准大小的正方形图形,再按照靶标位数划分正方形网格,统计每个网格内部一定范围内的白色像素数目,大于一定阈值认为该单元格值为1,否则值为0,如图9、图10所示。

接着按照汉明码规范对图像中二维码进行数据分类,奇数列为校验位,偶数列为数据位,将最终结果转换为十进制便可得到靶标的id值。

当确定完靶标id后,便开始对矩形靶标的4个角点进行亚像素细化,使用Shi-Tomasi算子进行亚像素迭代,获得精确的角点坐标。

2.2.2 PNP姿态解算

姿态解算部分的主要问题是根据特征点在像素坐标系下的位置和其在靶标固连坐标系下的位置,求解出相机坐标系和靶标固连坐标系间的姿态转化矩阵,进而和惯导联合解算,得到靶标的空间姿态和位置,用于进一步引导。

姿态解算为典型的PNP问题,由4个位于同一平面但不共线的已知坐标点可以解出两坐标系间唯一的旋转和平移矩阵。具体解决方案采于Levenberg-Marquardt optimization (LM)方法迭代求解位姿的最大似然估计。该算法最大的优点在于对噪声不是很敏感,在高斯噪声影响下也能够稳定输出姿态,平均误差为1.3°,3.4cm,位于可接受范围内。

算法流程为:(1)从点集中随机遍历n组每组4个不同点;(2)对每组运行PNP算法解得n组不同姿态解;(3)对每组解求全局误差,选择误差最小解作为迭代初值;(4)运行LM优化算法,迭代求解姿态最大似然估计直至误差小于阈值;(5)将姿态旋转矩阵转换为四元数和,输出四元数与平移矢量。

2.3滤波器设计

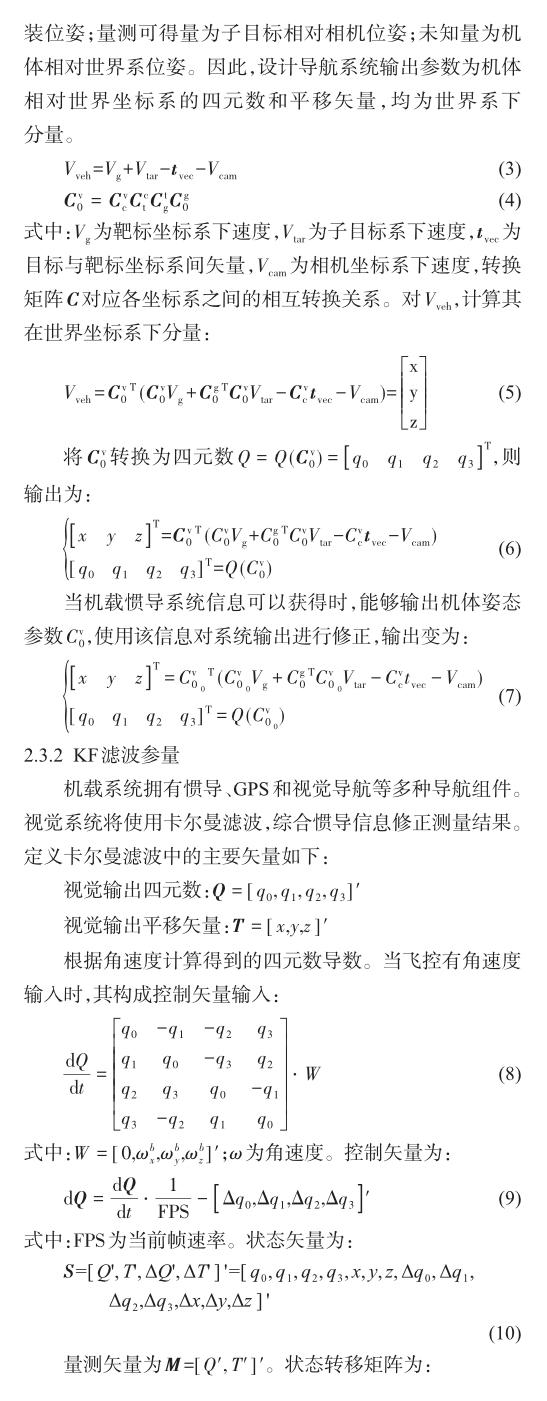

2.3.1坐标系定义

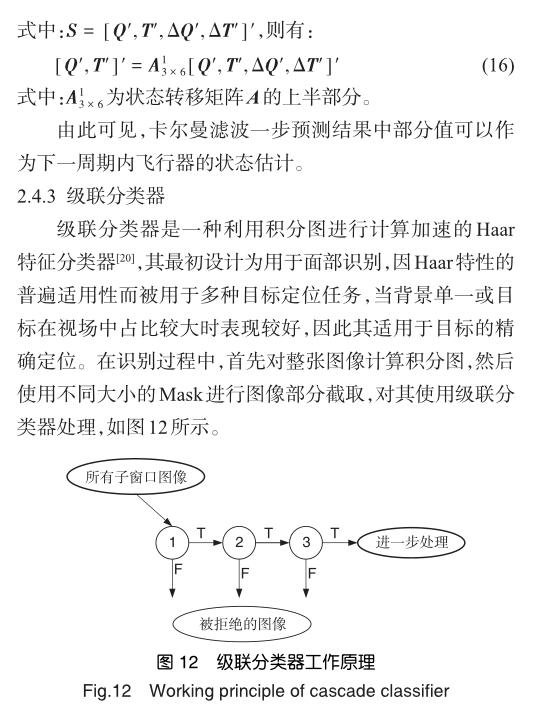

通過训练的多个强Haar分类器对上一级的有效输出进行处理,每一级都会输出有效和无效区域结果,只有通过全部级联分类的区域才会被作为最终的有效区域输出。当全部区处理完成后,对各个大小Mask的结果进行融合便可得到全图像的目标可能性图像。这种分类手段有效地保证了分类结果的稳定性,但当目标过小时可能会导致可能性图像中目标被过滤导致无法检测,因此使用级联分类器时应保证目标在视场中拥有足够的尺寸。

3仿真

对于全系统的仿真基于AirSim和Unreal3平台进行,如图13所示。AirSim为微软公司的开源仿真平台,其内部整合了动力学、导航与控制系统的完整仿真模型[21],基于Unreal3的图形处理引擎保证了其在进行视觉仿真时的真实性,因此选择其作为平台能够很好地完成仿真任务。本文进行仿真时,分别以无人机的第一和第三视角观测了无人机对目标识别后执行的自主降落行为。第三视角的无人机飞行状态如图14所示。第一视角下,无人机对目标的识别状态如图15所示。

仿真动画结果表明,无人机可在复杂环境条件下准确地对目标进行识别,能在对目标进行识别后实现自主降落。

对无人机视觉辅助降落过程进行实际飞行验证时,以第一视角得到的观测视频的部分截图如图16所示。

无人机在起飞至一定高度后,标识物进入机载相机视野,无人机开始自主降落。无人机对目标进行识别跟踪,实时修正自身速度,最终通过识别目标成功降落至目标区域。

视觉辅助自主降落任务完成后,将飞行日志导出整理,跟踪与降落过程中机体与地面目标之间相对距离如图17所示。由图17可知,无人机在高度25m处识别目标后,开始进行自主降落,在距目标5m处,出现轻微振荡波动。在此过程中,位置误差的散点图如图18所示。

由位置误差散点图可知,无人机在自主降落过程中存在较明显位置误差,但是由于误差较小,故而对最终降落结果影响较小,足以满足降落需求,但是仍需在后续工作中对其进行优化处理。

4结论

本文设计了一种基于PNP的多尺度目标单目视觉智能辅助降落系统,利用视觉拍摄目标地域实时环境信息,作为基础数据,经计算机技术和控制传感器运算处理,作为决策控制依据,引导无人机进行自主降落。针对GPS定位系统受到严重干扰情况,利用多尺度合作目标和成熟的PNP算法进行了精确姿态解算。通过算法优化和软硬件系统的实现,满足了无人机自主降落时对降落精度、实时性及安全性的要求。

参考文献

[1]袁成.美国空军新版《科技战略》提出新目标和新举措[J].航空科学技术, 2019,30(7):85-86. Yuan Cheng. The new version of the US Air Force Science and Technology Strategy puts forward new goals and new measures[J]. Aeronautical Science & Technology, 2019,30(7):85-86.(in Chinese)

[2]刘朝君,王亚龙,张立丰.基于飞控响应类型的无人机遥控驾驶技术研究[J].航空科学技术, 2019,30(6):62-67. Liu Chaojun, Wang Yalong, Zhang Lifeng. Research on drone remote control technology based on flight control response type[J]. Aeronautical Science & Technology, 2019,30(6):62-67.(in Chinese)

[3]Sharp C S,Shakernia O,Sastry S S. A vision system for landing an unmanned aerial vehicle[C]// IEEE International Conference on Robotics &Automation,2003.

[4]Jiskra P. Contact modeling and experimental validation for start and landing of VTOL UAVs[C]//DLR-Interner Bericht,2016.

[5]Tsai A C,Gibbens P W,Stone R H. Terminal phase visionbased target recognition and 3d pose estimation for a tailsitter,vertical takeoff and landing unmanned air vehicle[C]// Pacific-Rim Symposium on Image and Video Technology,2006:672-681.

[6]贾配洋.无人机高速移动降落技术研究[D].北京:中国科学院大学,2017. Jia Peiyang. Research on UAV high-speed mobile landing technology [D]. Beijing: University of Chinese Academy of Sciences , 2017.(in Chinese)

[7]张光富.基于合成视觉的3D重建技术研究[D].杭州:浙江大学,2008. Zhang Guangfu. Research on 3D reconstruction technology based on synthetic vision [D]. Hangzhou:Zhejiang University, 2008.(in Chinese)

[8]Xu G,Zhang Y,Ji S,et al. Research on computer visionbased for UAV autonomous landing on a ship[J]. Pattern Recognition Letters,2009,30(6):600-605.

[9]嵇盛育,徐贵力,冯文玲.基于红外视觉的无人机自主着舰合作目标的研究[J].红外技术,2007, 29(10): 593-597. Tong Shengyu, Xu Guili, Feng Wenling. Research on cooperative target of autonomous landing of UAV based on infrared vision [J]. Infrared Technology, 2007, 29 (10): 593-597.(in Chinese)

[10]魏祥灰.着陆区域视觉检测及无人机自主着陆导引研究[D].南京:南京航空航天大学,2019. Wei Xianghui. Research on visual detection of landing area and autonomous landing guidance of UAV [D]. Nanjing: Nanjing University ofAeronautics andAstronautics, 2019.(in Chinese)

[11]吴赛飞,王新华,贾森,等.基于红外视觉的固定翼无人机自动降落引导系统[J].电子测量技术,2016,39(3):131-135. Wu Saifei, Wang Xinhua, Jia Sen, et al. Automatic landing guidance system of fixed-wing UAV based on infrared vision[J]. Electronic Measurement Technology, 2016,39(3): 131-135.(in Chinese)

[12]樊珑.多旋翼无人机视觉引导降落研究[D].哈尔滨:哈尔滨工业大学,2016. Fan Long. Research on vision-guided landing of multirotor UAV[D]. Harbin: Harbin Institute of Technology, 2016.(in Chinese)

[13]Allen D W,Eric N J,Alison A P. Vision-aided inertial navigation for flight control [C]// AIAA Guidance,Navigation and Control Conference,2005:348-360.

[14]杨忠,方挺,樊琼剑,等.基于视觉传感器的UAV编队飞行[C]//第27届中国控制会议, 2008: 592-597. Yang Zhong, Fang Ting, Fan Qiongjian, et al. UAV formation flying based on vision sensor [C]// 27th China Control Conference, 2008: 592-597.(in Chinese)

[15]周立偉,刘玉岩.口标探测与识别[M].北京:北京理工大学出版社, 2002. ZhouLiwei,LiuYuyan.Spokenlabeldetectionand recognition [M]. Beijing: Beijing Institute of Technology Press, 2002.(in Chinese)