一种基于视频数据的服装显著性预测方法

石 敏,侯 明,刘亚宁,,毛天露 ,王兆其

(1.华北电力大学控制与计算机工程学院,北京 102206;2.中国科学院计算技术研究所,北京 100190)

视觉和心理学研究发现,人类视觉系统通过从外界获取图像信息传送入大脑,通过大脑对图像信息进行分析和理解,然后获得对外界信息的感知。视觉感知的敏感度不仅受到光强度、波长的影响,还与记忆与经验等更高层次的心理因素有关。人眼接受的信息量往往十分巨大,远超过大脑处理信息的能力。因此,人眼视觉注意机制会主动忽略一些“无关紧要”的信息,而保留部分重点关注的信息。视觉感知过程,能够选择性地将注意力集中于复杂环境中的某一小部分感兴趣的区域,而暂时忽视其他次重要的区域。例如,人观察在草地上奔跑玩耍的小孩时,视线会集中在小孩的身上,而不会过多关注草地等背景。

在进行服装运动建模时,已有的方法通常只考虑影响服装运动的第一要素,即物理世界中各种力的作用对服装变形的驱动,而完全忽略了人眼主观作用对服装变形感知逼真性的影响。事实上,受人眼分辨率以及注意度的影响,即使通过高精度建模可以使得布料面上更多的细节被模拟出来,但受视觉精度的限制,现实中的人眼也很难捕获到如此多的变形细节。

综上分析,研究人类视觉注意机制,并构建有效的服装显著性模型,可在后期用于指导更加有效的服装运动建模,提高模拟效率。本文通过对着装人体运动视频数据进行分析,构造了种类多样的视频样本,包括:真实场景和动画场景,简单场景和复杂场景。基于眼动仪采集人眼观看服装视频的注视数据,并采用高斯卷积生成显著图。在进行视频特征提取时,结合了底层图像特征、高层语义特征以及运动特征,共同构造特征向量和标签,并通过支持向量机(support vector machine,SVM)训练得到基于服装视频的显著性预测模型。

通过实验对比验证,本文方法的性能在服装视频显著性预测时,优于传统的显著性预测算法,具有一定的鲁棒性。本文方法的研究思路如图所示。

图1 服装视觉显著性预测模型研究思路

1 相关工作

目前,视觉注意机制[1]在广告、目标跟踪、视频分析、医学[2]等领域均有重要应用。视觉感知过程主要包括2种研究机制:底层特征驱动的自下向上的感知过程和主观任务驱使的自上而下的感知过程。前者会受到视觉系统所接受到的场景中色彩、明暗亮度、纹理方向以及对比度等特征[3]的影响。后者与主体的任务、目的、知识等主观因素息息相关,所以也被称作任务驱动的视觉感知[4]。ITTI模型[5]是最初的视觉显著模型,将各通道特征差异图进行跨尺度的融合,并进行归一化处理,形成该通道上的特征显著图,然后将上述特征显著图进行线性融合得到最终的显著图。HOU和ZHANG[6]提出了频谱残差(spectral residual,SR)模型,通过分析背景是否满足某种变换来提取背景,其余的是感兴趣的区域。GUO等[7]认为图像的视觉显著性信息包含在图像的相位谱中。因此,提出了仅使用傅立叶频谱的相位谱信息来计算图像的显著性的想法,提出了四元数傅里叶变换的相位谱(phase spectrum of quaternion Fourier transform,PQFT)模型。GUO等[8]提出了一种基于运动感知的快速视频显著性检测方法。首先分析光流场来获得前景先验,然后将外观对比、紧密度度量等空间显著性特征合并到一个多线索集成框架中,最后将不同的显著性线索组合在一起,实现时间一致性。

近年来,基于Deep Learning的视觉显著性预测模型构建方法开始大量涌现。LI和 YU[9]通过卷积神经网络(convolutional neural networks,CNN)来提取图像特征,并且根据多尺度深度特征(multiscale deep feature,MDF)构建显著性模型。KÜMMERER等[10]以AlexNet[11]框架为基础,提出了Deep Gaze框架来预测视觉显著图。LI等[12]提出了DeepSaliency模型,其是一种将分割任务和显著性目标检测任务相结合的多任务网络模型。ZENG等[13]根据数据集特点提出了一种针对 image-level标注的多源弱监督显著性预测模型。

已有工作未见针对服装运动视频的显著性预测的研究。本文通过分析着装人体运动视频数据,构造了种类多样的视频样本,并利用眼动技术采集真实人眼的注视数据。在进行视频特征提取时,结合了底层图像特征、高层语义特征以及运动特征,共同构造特征向量和标签,并通过SVM训练得到基于服装视频的显著性预测模型,并用以指导服装模拟的多精度变化。

2 眼动数据的采集和处理

2.1 眼动数据采集

2.1.1 实验样本

服装视频不同于其他数据,具有主体突出、背景相对简单的特点,实验人员的注意力更容易被着装人物所吸引。为了提高预测服装视频显著性的准确性以及鲁棒性,本文搜集了种类多样的服装视频数据用以进行数据采集,其中包括真实场景的视频以及虚拟场景的服装动画。数据样本如图2所示。

2.1.2 眼动实验过程

本文采用的是60 Hz遥测式Gazepoint眼动仪。受试者在采集眼动数据前需要进行注视点的校准。而校验准确性与校验点持续时间以及校验点个数密切相关。本文采用9个校验点,每个校验点持续1.5 s。校验完毕后,受试者应保持头部相对静止,避免晃动。在此状态下,稳定地采集观看服装视频的注视点信息。

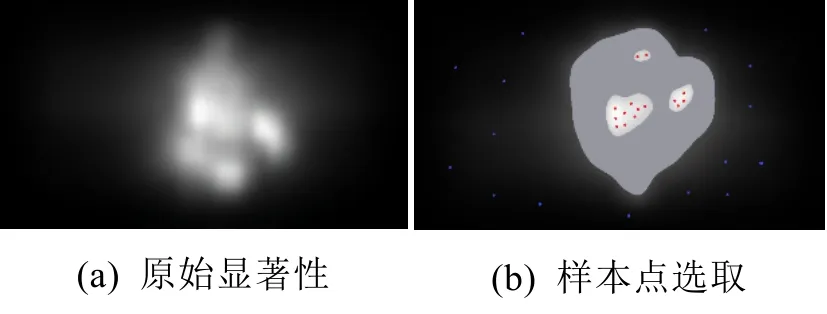

2.2 眼动数据处理

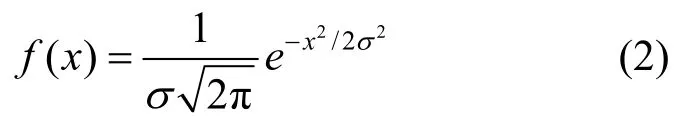

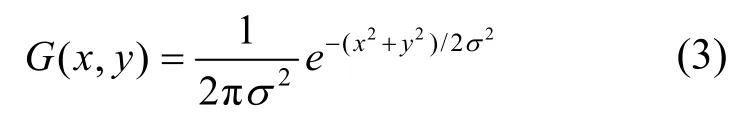

眼动数据是按照时间序列以文本的形式存储,首先删除无效的注视点数据,然后将每个视频祯的注视点叠加,产生焦点图。最后根据高斯卷积对叠加后的焦点图进行卷积操作生成平滑的视觉显著图,作为ground truth。视觉显著图如图3所示。其中,一维高斯函数公式为

其中,x为坐标值;σ为x的方差;μ为x的平均值。在实际计算中,以中心点作为坐标原点,因此平均值μ为0,可得

二维高斯函数可由上推导并计算每个点的权重,即

图2 采集样本展示

图3 由焦点图产生视觉显著图

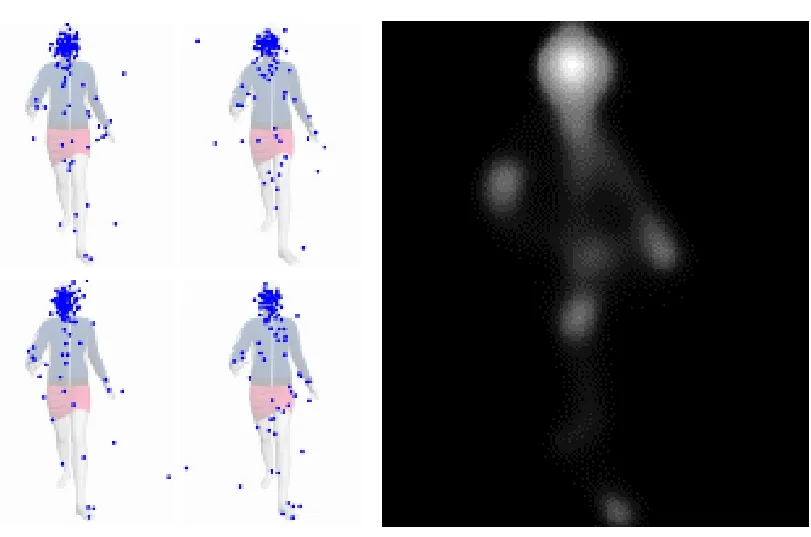

完成注视点的采集之后,需要对眼动数据预处理,即只保留落在服装区域上的注视点信息。经过高斯卷积生成相应的显著图后,采用摄像机模型,将二维显著图映射到三维服装模型上,从而获得三维服装模型顶点的显著值。结果如图所示。

图4 二维显著图映射到三维服装模型

3 特征提取

3.1 底层图像特征提取

3.1.1 亮度特征提取

计算视频帧图像的视觉显著性,亮度特征是不可或缺的。r,g,b分别对应图像的红、绿、蓝3个颜色通道。为了得到图像的亮度特征,求3个通道平均,使彩色图像转化为灰度图像,即

然后对图像高斯滤波以及下采样得到ITTI模型中的高斯金字塔,分别对应图像不同尺度的亮度特征图,计算出相邻像素点亮度的差异性。在高斯金字塔中,下一层的灰度图像大小为上一层的一半,总共具有 9个不同尺度的灰度图像,如图5所示。

图5 由高斯金字塔得到的9个不同尺度图像

得到高斯金字塔的灰度图像后,根据ITTI模型的“center-surround”算子对金字塔中的灰度图像跨尺度差值计算,得出2个不同尺度灰度图像的亮度差异图。需要注意的是进行差值运算时,需要将低分辨率的灰度图像上采样至与之运算的较高分辨率图像大小,即

其中,Θ 为“center-surround”算子;I(c)为“center”的灰度图像;I(s)为“surround”的灰度图像;I(c,s)为差值运算得到的亮度差异图,根据高斯金字塔将不同尺度的灰度图采用“center-surround”算子计算多个亮度差异图;I(σ)为高斯金字塔对应的 9个不同尺度亮度灰度,σ= 0,1,2,…,8 。本文中表示将高斯金字塔中编号为2,3,4尺度下的灰度图同与其相隔3,4个尺度的灰度图进行“center-surround”运算。最终计算出的不同尺度下的多个亮度差异图,代表跨尺度灰度图之间的差异性。

3.1.2 颜色特征提取

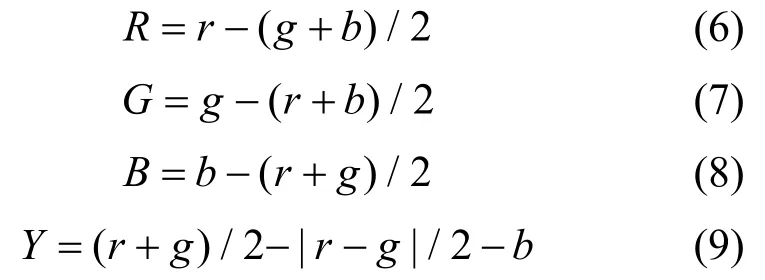

图像颜色也是能够影响视觉注意度的重要特征,本文采取红、绿、蓝和黄(R,G,B,Y)4种广义的颜色通道提取图像颜色特征,具体计算为

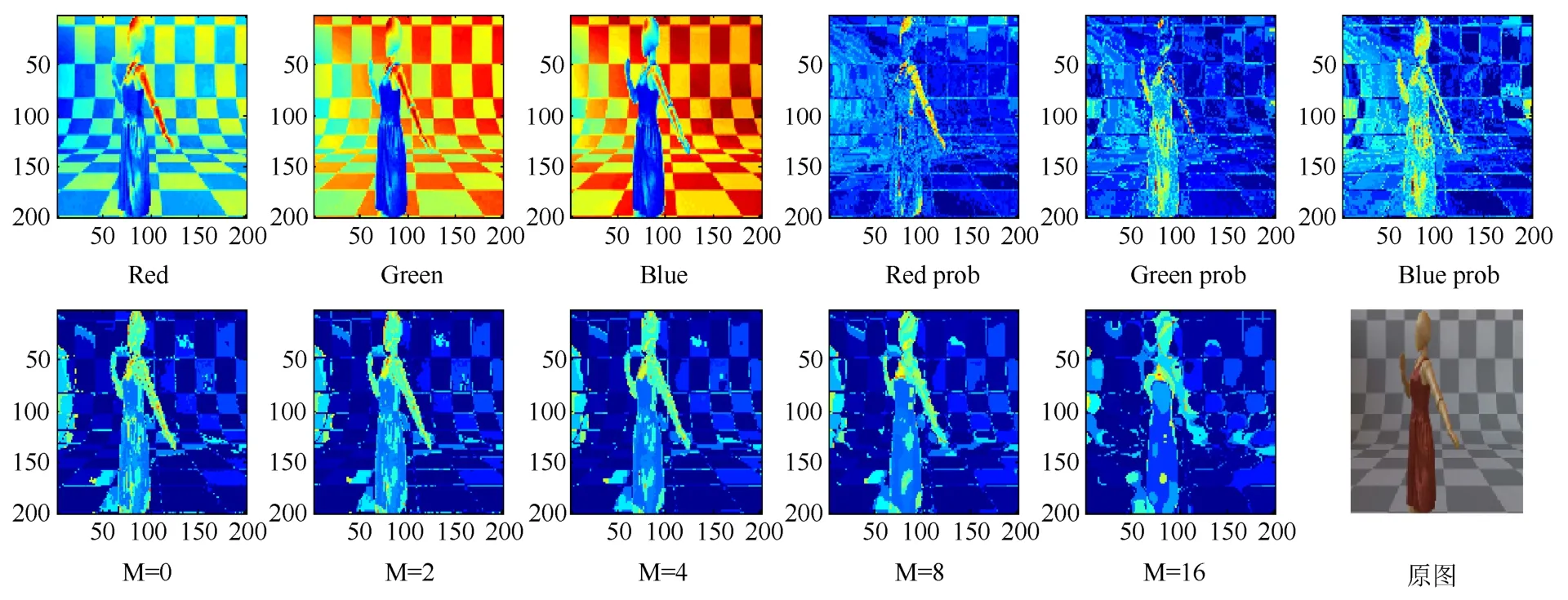

如图6所示,上方的6个颜色特征图像分别为R,G,B3个颜色通道值及R,G,B通道的概率值;下方的5个图像是采用中值滤波器滤波三维颜色直方图后得到的概率。

3.1.3 方向特征提取

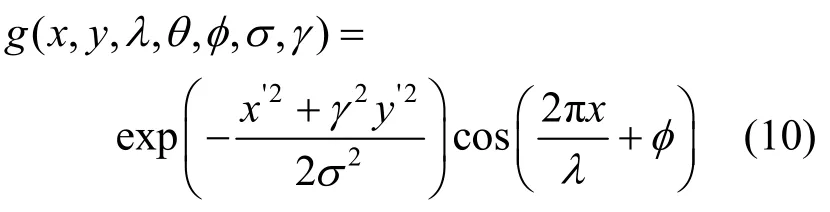

研究表明视觉皮层中某些细胞对特定方向的刺激有较强烈的反应。为了得到不同方向特征图像,本文使用 Gabor滤波器对亮度信息滤波,二维滤波函数包含一个余弦函数以及一个高斯核函数,即

图6 颜色特征图像

3.1.4 纹理特征提取

纹理信息描述了图像表面纹理特性及与周围的差异性,是图像的基本特征。纹理特征在视觉显著性预测方向被广泛采用。人眼视觉系统的不同通道之间具有位移不变、线性的特点。可控金字塔算法[14]能够检测出图像的边缘、奇异点以及纹理等特征,将图像分解为不同方向和尺度的子带特征图,其具有方向可控性与位移不变性的优点,因此可控金字塔算法常用于纹理特征的提取工作。如图7所示,将图像在4个方向以及3个尺度上分解为13个子带特征图。

图7 可控金字塔得到的子带特征

3.2 高层语义特征提取

视觉注意机制因为是由自上而下和自底向上2个视觉过程共同驱动的。而且基于任务的自上而下的视觉过程会使人有意识的决定视觉注意区域。因此,高层语义特征是显著性预测不可或缺的考虑因素。

3.2.1 中心偏向特征

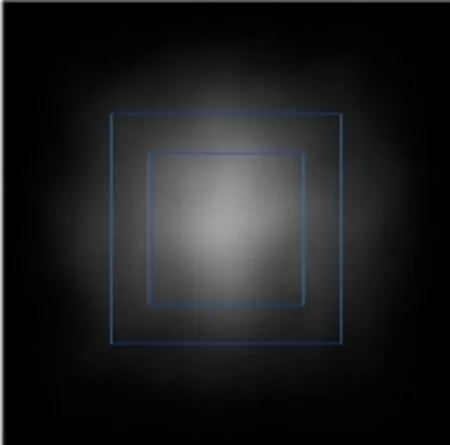

JUDD等[15]通过采集人眼注视点信息,分析论证了人眼在观察图像信息时,注视点往往集中在中心区域范围。将所有的视觉显著图融合求平均后,如图8所示,可以看出越趋近于中心的区域显著度越高。并且,显著区域大约集中于图像25%的区域范围内。因此,本文采用中心偏向的高层特征,表现越趋向于中心的区域显著度越高的特点。

图8 关注点

用欧式距离来衡量图像各个像素点与中心的距离,即

其中,center_dis为图像(x,y)坐标处像素点到图像中心的距离;(center_x,center_y)为图像中心位置坐标。

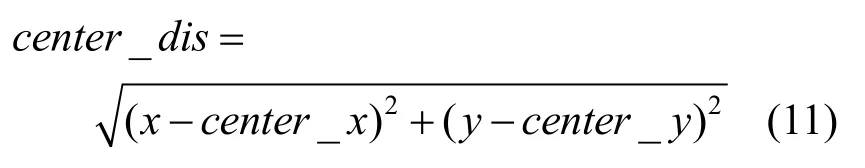

3.2.2 人的检测

通过分析人眼关注点数据,发现视觉系统非常关注有人出现的图像区域。本文使用RAMANAN等[16]人体目标检测算法,可以检测出游人体所在的区域。如图9所示,红色方框中所包含的区域是算法检测到的人体。本文将人体区域的显著度设置为1,而其余非人体部分显著度则设置为0。

图9 人体检测特征

3.3 运动特征提取

视频相较于图像最大的区别是具有运动特征,运动特征往往更容易吸引关注。光流法、全局运动补偿、块匹配法和帧差法等是目前运动特征提取的主要方法。本文使用光流法获取视频祯图像的运动特征,如图10所示。

图10 运动特征

4 服装显著性预测模型

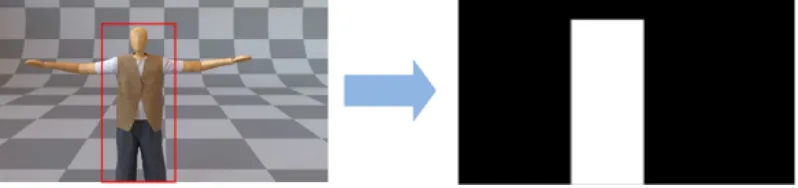

4.1 特征向量和标签

为了构造显著性预测模型的训练集以及测试集,首先提取图像的底层特征、高层语义特征以及根据帧差法提取的运动特征,得到30个特征图。然后根据眼动实验采集的注视点数据高斯卷积生成显著图,用来确定图像各像素的显著度大小。通过随机选取显著程度较高区域的N个像素点作为正样本,显著程度较低区域的N个像素点作为负样本,提取样本特征向量,并设置其对应的正负标签。

如图11所示,随机选取其显著程度在前30%区域内的 15个像素点作为正样本,随机选取显著程度最低的30%区域内的15个像素点作为负样本;然后提取样本点在各个特征图相应坐标位置的特征构成该点的特征向量,并将正样本标签置为+1,负样本标签置为-1。

图11 提取特征向量

4.2 视觉显著性模型训练

本文选用SVM进行模型构建。在设计的训练样本空间中寻找一个超平面将显著的正样本点和非显著的负样本点分隔开,并保证划分的正确率最高,即

其中,x为训练样本点,是一个30维向量;w为x中各个特征值的权重矩阵;wT为w的转置矩阵。

眼动采集所选取的实验样本种类丰富,有助于提高服装视频显著性预测模型的鲁棒性。在设计训练样本和测试样本时,本文将每段服装视频按照每秒 5帧截取视频帧图像。将视频帧图像缩放到200×200的大小,减少图像像素数目,增加计算效率。每段视频截取连续相同数目的训练视频帧图像和测试视频帧图像,并提取底层、高层以及运动特征并设置其标签,形成模型需要的训练样本集和测试样本集。本文采用的是线性核函数,运算速度快且适用于大规模数据的训练。训练完成后,SVM模型将学习到每个特征的权重,权重的大小反应特征对预测结果的影响大小。

5 实验结果和分析

为了对本文方法的性能进行验证,针对不同的视频背景与着装人体动画进行实验,将本文方法与ITTI,基于图形的视觉显著性(graph-based visual saliency,GBVS[17]),PQFT[7]方法进行对比,并应用受试者工作特征曲线(receiver operating characteristic curve,ROC)、曲线下面积(area under curve,AUC)和标准化扫描路径显著性(normalized scan-path saliency,NSS)等评价指标进行量化分析。实验选用的硬件环境为:CPU i5 8600K,8 G内存。

训练模型时,共选取 11段服装视频,并且每段服装视频随机选取连续的150帧图像作为训练样本,20帧图像作为测试样本。在每帧图像的显著图中,随机在显著度前30%区域选取15个正样本点,后30%区域随机选取15个负样本点。当继续增加每帧图像中样本点的数量时,并没有提高模型的性能。为了保证评价标准的准确性,在进行实验方法性能对比时,在每段服装视频中随机选取3段帧序列,每段帧序列包含 10张视频帧图像。然后应用ITTI,GBVS,PQFT和本文方法进行显著性预测,得到AUC和NSS,再对其求平均值。实验结果如下:AUC,NSS评价指标的对比情况见表1,各模型方法的时间消耗对比见表2,ROC曲线如图2所示。

由以上实验数据可知,本文提出的服装视频显著性预测模型相较于传统的经典模型,在 NSS和AUC评价指标上都优于其他3种方法,ROC曲线中右下角所包围区域更大,说明本文方法能够更准确地预测服装视频帧图像各区域的显著性。虽然本文方法在预测图像显著度的时间消耗上略高于传统方法,但运算速度依然比较快并低于1 s,并不会对模型性能产生较大影响。各模型预测结果如图13所示。

表1 各模型性能对比

表2 各模型时间消耗对比

图12 各模型ROC曲线对比

图13 各模型算法结果图

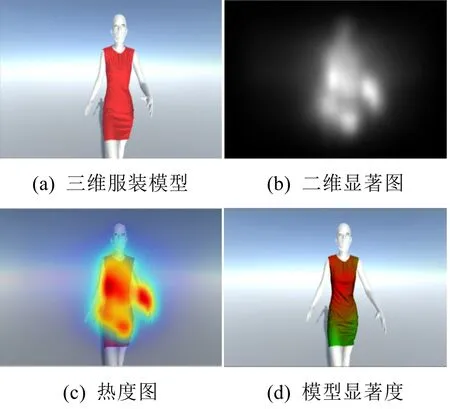

服装模型显著性可用于指导构建多精度服装模型,即对于服装模型的高显著性区域进行高精度建模,低显著性区域则采用粗化操作来降低模型精度,使得服装模拟的效果和效率达到平衡(图14)。

图14 服装多精度模型

6 结束语

本文对着装人体运动视频数据进行分析,构造了种类多样的视频样本,并利用眼动技术采集真实人眼的注视数据。在进行视频特征提取时,结合了底层图像特征、高层语义特征以及运动特征,共同构造特征向量和标签,在此基础上,通过训练得到SVM 的服装视频的显著性预测模型,可用于指导服装模型的多精度建模。由于本文方法面向服装动画任务提取的特征更为全面,并且根据真实眼动数据生成显著图指导模型训练,因此,与ITTI,GBVS,PQFT方法相比,有更好的显著性预测效果。

本文主要针对服装显著性模型进行样本选取,但底层特征、高层特征以及运动特征等图像特征中具有一定的通用性,因此可以启发其他视觉领域的应用,也可以将本文获取的样本数据推广用于其他的深度网络模型来进行显著性预测,但是否可以得到良好的训练结果,也取决于选定的网络结构以及对样本的需求量等。此外,由于本文将实验样本数据集限定在单人服装视频数据,因此会导致模型对多人场景下的显著性预测任务泛化能力有限。下一步将研究深度网络预测服装显著性问题,针对此研究,将加大样本数据采集以及多样化场景的样本选取,也包括多人着装动画场景的构建等。