欧盟个人数据匿名化治理:法律、技术与风险

张 涛

1 问题的提出

在全球范围内,数以百万计的电脑每时每刻都有数据注入,所有计算机上存储的数据总量约为3000EB,并正以每年28%的速度增加。我们已经进入“3V”数据时代:Volume(数据体量大)、Variety(数据类型多)和Velocity(处理速度快),即“大数据”(big data)时代[1]。有学者对大数据的特征进行了修正,增加一个“V”(Value),代表“数据的价值”,即组织可以通过新型的处理方式从大数据中获得洞察力和决策力[2]。正如《大数据时代》所指出的:“数据的真实价值就像漂浮在海洋中的冰山,第一眼只能看到冰山一角,而绝大部分则隐藏在表面之下。明白了这一点,那些创新型企业就能够提取其潜在价值并获得潜在的巨大收益”[3]。数据的这种“潜在价值”一般可以通过再利用(re-use)、重新组合等方式进行释放。如今数据已成为“生产原材料”,具有巨大的经济价值和社会价值。在商业领域,企业组织可以通过大数据分析各种不同的策略模式,为公司或机构创造新价值,如通过对消费者的购买记录进行大数据分析,生成结果可以预测消费者的购买喜好,从而提高营销的针对性和有效性。在公共领域,政府部门通过大数据分析,可以降低执法成本,提高行政效率,如通过对城市犯罪数据进行分析,可能推测出城市的犯罪热点,提高犯罪打击率。此外,“开放数据”(open data)运动在全球范围内兴起,使得越来越多的数据进入公共视野。对“开放数据”的最佳描述是:个人或组织可以接触到大量的公共数据,用于确立新的投资,寻找新的合作伙伴,发现新的发展趋势,作出基于数据处理的决策,并能解决复杂的问题[4]。“开放数据”不同于大数据,“开放数据”的宗旨是提供免费、公开、透明的数据信息,并能适用于我们需要的任何领域,它不仅可以监督政府的政策执行,促进政府运作透明化,而且还能创造巨大的商业机会。但是,“开放数据”与大数据又有所重叠,共性之一就在于挖掘个人数据(personal data)①的潜在价值。

由于个人是数据的重要“生产者”,个人数据又是数据的重要组成部分。因此,在数据挖掘或“开放数据”过程中,便产生了侵犯个人隐私的风险及隐忧。有鉴于此,如何在个人隐私保护与数据合理利用之间保持平衡,便成为个人数据保护的重要课题。目前在各国个人数据保护法制中主要将“匿名化”(anonymisation)或“去识别化”(de-identification)作为政策工具。一般而言,“匿名化”是指利用一定的技术,通过特定程序进行加工处理,使个人数据不再具有直接或间接识别性②。经过“匿名化”的个人数据称为“匿名数据”(anonymised data),对任何人而言,均无法采取任何合理可能的方法识别特定个人,也即意味着个人数据经过匿名化处理后,毫无保留连结的可能性[5]。在欧盟个人数据保护法制中,1995年《数据保护指令》(Data Protection Directive,DPD)对个人数据匿名化进行了原则性规定;2014年《第05/2014 号意见:匿名化技术》 (Opinion 05/2014 on Anonymisation Techniques)细化了技术标准;2016年《一般数据保护条例》(General Data Protection Regulation,GDPR)进一步加强了对个人数据匿名化的立法规定。我国《网络安全法》第42 条第1 款规定:“……未经被收集者同意,不得向他人提供个人信息。但是,经过处理无法识别特定个人且不能复原的除外。”这里的“无法识别特定个人且不能复原”可以看成是我国关于个人信息去识别化的法律依据[6]。然而,何为“无法识别”?何为“特定个人”?应该遵循何种判断标准?我国相关法律法规并未针对前述问题提出解决方案,在司法实践中,法院也尚未形成完整及确定的裁判标准。因此,我国个人信息去识别化(匿名化)议题仍有很大的讨论空间。

据此,本文利用比较分析、实证分析方法,通过对欧盟个人数据匿名化治理经验进行研究,为我国个人信息去识别化提供参考借鉴。本文主要研究以下问题:(1)欧盟个人数据匿名化在立法上是如何体现的?(2)欧盟个人数据匿名化主要采用了哪些技术,效果如何?(3)欧盟个人数据匿名化可能存在的风险是什么?(4)欧盟个人数据匿名化能为我国提供何种经验?

2 欧盟个人数据匿名化的立法内容及解读

“个人数据匿名化”有两个关键词:一是“个人数据”,二是“匿名化”,前者是后者的前提条件。如果某一数据(信息)不属于个人数据的范围,相关的行为就与个人数据保护法制没有关系,就更谈不上承担个人数据保护的责任。因此,本部分在对欧盟个人数据匿名化的立法内容进行阐述时,附带对欧盟有关“个人数据”内涵的立法内容进行解读。

2.1 《数据保护指令》对个人数据匿名化的规定

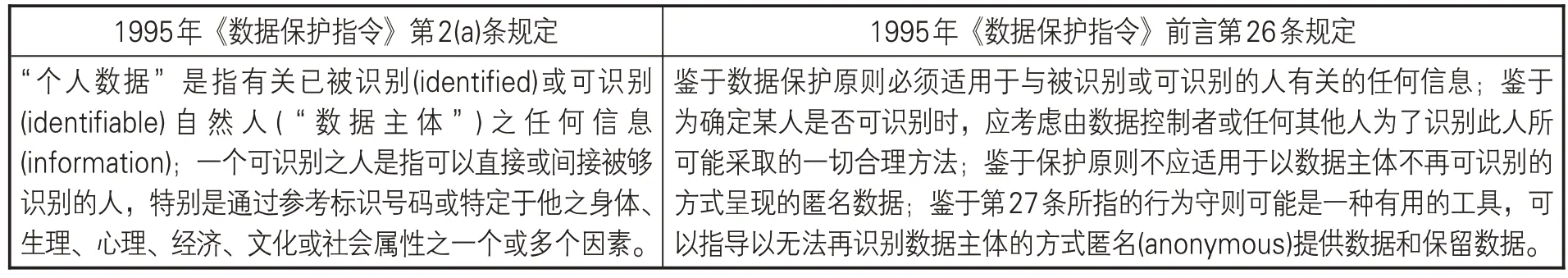

1995年10月,欧洲议会及欧盟理事会(European Parliament and Council)制定了《数据保护指令》,并对“个人数据”和“个人数据匿名化”进行了明确规定,详见表1。

表1 《数据保护指令》对个人数据匿名化的规定

从《数据保护指令》对“个人数据”的界定来看,“任何信息”“被识别或可识别”“直接或间接”的表述,足以反映立法者有广泛解释的意图。这可能是因为立法者认为,不宜对个人数据概念的解释作出不当限制,为避免存在灰色地带或漏洞,而尽可能地将与一个人有关的信息都包括在个人数据的概念内,以确保个人及其权利和自由得到实质性的尊重。欧盟委员会在原始提案建议中解释:“与《第108号公约》一样,采用宽泛的定义,以涵盖可能与个人有关的所有信息。”[7]在修改后的提案建议中,欧盟委员会指出,经修订的建议符合议会的愿望,即“个人数据”的定义应尽可能一般化,以便包括有关可识别个人的所有信息[8]。

尽管立法者在个人数据的概念中保持了相当程度的广泛性,但也通过数据处理方法等规定作出了限制,以便可以在数据主体、数据控制者及可能存在的公共利益之间取得适当的平衡。“个人数据匿名化”正是为了在“保护个人基本权利及自由”与“促进数据自由流动”之间保持平衡,正如《数据保护指令》所规定的“保护原则不应适用于以数据主体不再可识别的方式呈现的匿名数据”。如前文所述,个人数据的核心是“识别性”,那么匿名化的核心便是“去识别”。从《数据保护指令》对“个人数据匿名化”的规定来看,其强调在对个人数据进行匿名化处理时,必须充分去掉其中的所有重要元素,以使数据主体无法再识别。

笔者认为,《数据保护指令》前言第26条实际上是“风险预防原则”(precautionary principle)在个人数据保护中的体现,将“再识别风险”作为判断匿名化有效性的关键标准。为了确定个人数据是否(合法地)呈现为匿名,需要对数据控制者或任何第三方“使用所有合理可能的手段”(all the means likely reasonably to be used)进行评估或预测。尽管当且仅当“数据主体不再可识别”(data subject is no longer identifiable)时,个人数据才呈现为匿名(data is rendered anonymous),但由于匿名化过程的“可逆性”(reversibility)风险,这意味着该等数据不能永远处于个人数据保护法律的范围之外。

2.2 《第05/2014号意见:匿名化技术》对个人数据匿名化的规定

尽管《数据保护指令》早在1995年就对“个人数据匿名化”进行了规定,但欧盟未出台细则予以指导。直到2014年,欧盟“第29条工作小组”(Article 29 Working Party,Art.29 WP③)发布了《第05/2014号意见:匿名化技术》,对个人数据匿名化进行了全方位解读。

在《第05/2014 号意见:匿名化技术》中,欧盟“第29条工作小组”综合了“匿名化”的法律性与技术性。欧盟“第29条工作小组”概述了该领域的最新技术,并侧重于当前用于追求匿名化目标的技术。在实践中,匿名化技术主要包括数据随机化(Randomization)和数据概括化(Generalisation)两大类,具体又分为“噪音添加”(Noise addition)、“属性交换”(Permutation)、“差分隐私”(Differential privacy)等技术。《第05/2014 号意见:匿名化技术》详细分析了前述技术的原理、优缺点以及使用技术时的常见错误和失效情况。欧盟“第29条工作小组”还针对“再识别风险”提出了使用这些技术的建议,这有助于数据控制者设计匿名化过程。此外,欧盟“第29 条工作小组”还对“假名化”(pseudonymisation)与“匿名化”进行了区分,在实践中很多数据控制者都错误地理解和使用了“假名化”。虽然假名化处理降低了数据集与数据主体原始身份的关联性,但它只是一种较为初级的安全措施,并非匿名化的方法,假名化数据仍然受到数据保护原则的约束。

欧盟“第29条工作小组”还详细解析了匿名化的4个基本特征:(1)数据匿名化的目的在于防止识别数据主体的具体身份,且这种处理结果必须是“不可逆转的”(irreversible)。(2)考虑到匿名化技术的不断发展,不同的匿名化技术具有不同的适用情形,因而立法者并未在欧盟法律中制定统一的匿名化标准。(3)在数据匿名化过程中,必须重视情境因素(contextual elements),必须考虑数据控制者和任何第三方用于识别数据主体身份的“一切”“可能”“合理”之手段,尤其应该考虑在尖端科技中,哪些能成为“可能”“合理”的方法。(4)数据匿名化过程存在固有风险:在评估任何匿名化技术之有效性时,都必须考虑其中的风险因素,包括经某种技术“匿名化”的数据之可能用途,必须评估所致风险的可能性及其严重性[9]。

2.3 《一般数据保护条例》对个人数据匿名化的规定

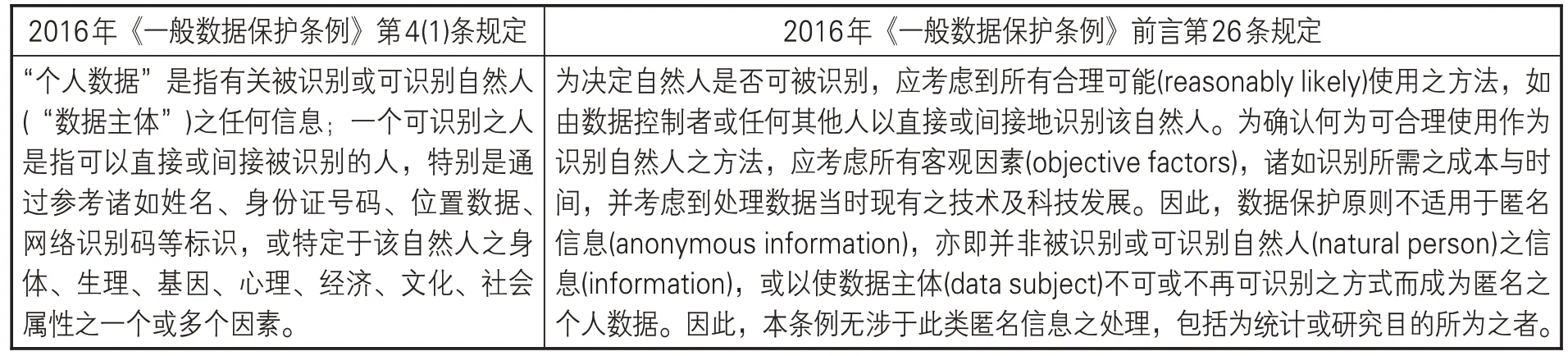

《一般数据保护条例》之目的在于确保对数据主体进行一致且高度的保护,并且排除数据在欧盟境内的流通障碍,全体成员国须一体适用。因此,有关个人数据保护的诸多议题都被纳入到一个强力保护框架之内,个人数据匿名化也不例外,详见表2。

表2 《一般数据保护条例》对个人数据匿名化的规定

在《一般数据保护条例》中,“个人数据”的定义基本上与《数据保护指令》相同,均指“有关被识别或可识别自然人之任何信息”。相比较于《数据保护指令》,《一般数据保护条例》只是在定义“可识别”的数据时,结合网络通信科技的发展,有略微详细的说明,如新增“姓名”“身份证号码”“位置数据”“网络识别码”“基因”等。在司法实践中,欧盟法院也通过一些典型判例对个人数据的内涵进行确定,试图通过判例建构一套个人数据的识别标准,这些都为个人数据匿名化奠定了坚实的基础。

就个人数据匿名化而言,《一般数据保护条例》秉承了《数据保护指令》的立法模式,亦即强调个人数据匿名化的结果,并且将匿名数据排除在个人数据之外。此外,《一般数据保护条例》还吸收了《第05/2014号意见:匿名化技术》的经验,在第4(5)条中将“假名化”予以明确,把“假名化”从“匿名化”中剔除,这实际上是缩小了“匿名化”的范围。从这个意义上看,《一般数据保护条例》为个人数据匿名化设定了一个更为严格的法律标准,可以称为“合理可能”(reasonably likely)标准,这个标准具体包括三个部分:一是主体标准,即“数据控制者或任何其他人”;二是识别手段标准,即“所有合理可能使用之方法”;三是识别方式标准,即“直接或间接地识别该自然人”。

此外,由于《一般数据保护条例》在使用“个人数据”这一概念时,本身就融入了一种动态理念,即“个人数据”的内涵是处于动态发展中的。因此,个人数据匿名化也天然的具有易变性。换言之,匿名数据与个人数据之间的界限并非泾渭分明,随着情境因素的变化,二者可能出现转换。正如《一般数据保护条例》中所规定的:“为确认何为可合理使用作为识别自然人之方法,应考虑所有客观因素,诸如识别所需之成本与时间,并考虑到处理数据当时现有之技术及科技发展。”

3 欧盟个人数据匿名化的关键技术及示例

个人数据匿名化并非单纯的法规遵循议题,尚涉及网络科技、信息管理等跨领域或学科的有效整合。从欧盟个人数据匿名化的立法内容来看,其最大的特点在于“技术设计”法制化,明文规定成员国应推动“通过设计保护隐私”(Privacy by Design)的重要理念,以使个人数据保护法制,不仅是企业违法后的处罚依据,借由“技术设计”入法,使相关数据控制者预先评估行为可能产生的风险,并使得隐私保护概念,自设计之初,便融入产品或服务的生产过程中,达到保护数据主体权益的目标[10]。个人数据匿名化是“技术设计”入法的重要体现,在欧盟法语境中,常见的个人数据匿名化技术主要包括以下两大类:一类是数据随机化;另一类是数据概括化。本部分主要对欧盟一些主要的个人数据匿名化技术进行概述,并举出相关例子予以说明。

3.1 数据随机化

“数据随机化”是修改数据真实性的技术,用于清除数据与个人之间的紧密联系,当数据不确定时,自然就不足以辨识特定个人。“数据随机化”本身不会降低每一项记录的单一性(singularity),因为各项记录本身就源自其独有的数据主体,这项技术能抵御攻击或阻挡风险,更能够与其他技术一起使用,提供更强的隐私保护。常见的“数据随机化”技术包括以下几类:(1)“噪音添加”(Noise addition)。如果数据集内包含的修改属性(modifying attributes)本身不一定准确,而且也保留了整体分布(overall distribution),属性也同时对个人产生严重的影响,那么就可以考虑噪音添加技术。(2)“属性交换”(Permutation)。这种技术首先打乱表格里面的属性数值,利用人为的方式使部分数值关联到不同的数据主体,但能够保留数据集中各个属性的准确分布(exact distribution)。(3)“差分隐私”(Differentialprivacy)。这种技术的好处是,当针对特定查询时,获得授权的第三方只会因此而取得数据集,而非将某一数据集公开。查询本身也可以被匿名化技术处理,包括噪音添加或替换,强化隐私保护[9]。本文主要以“属性交换”为例进行说明。

“属性交换”也称为“属性排列”(shuffling)或“属性置换”(swapping),这种数据匿名化技术之目的主要是重新排列数据集中的数据,使各个属性值仍然在数据集中得以保留,但通常与原始记录不对应。换言之,“属性交换”将确保数值的范围和分布保持不变,但数值与数据主体之间的关系将会改变。当后续分析只需要查看聚合数据,或者分析只是停留在内部属性层级(intraattribute level)时,可以考虑使用“属性交换”。在进行“属性交换”时,一般包括如下步骤:首先,确定要交换的属性。其次,将每一个属性值交换或重新分配给数据集中的任何记录。表3大致展示了“属性交换”前后的实例数据。

表3 “属性交换”前后的数据

3.2 数据概括化

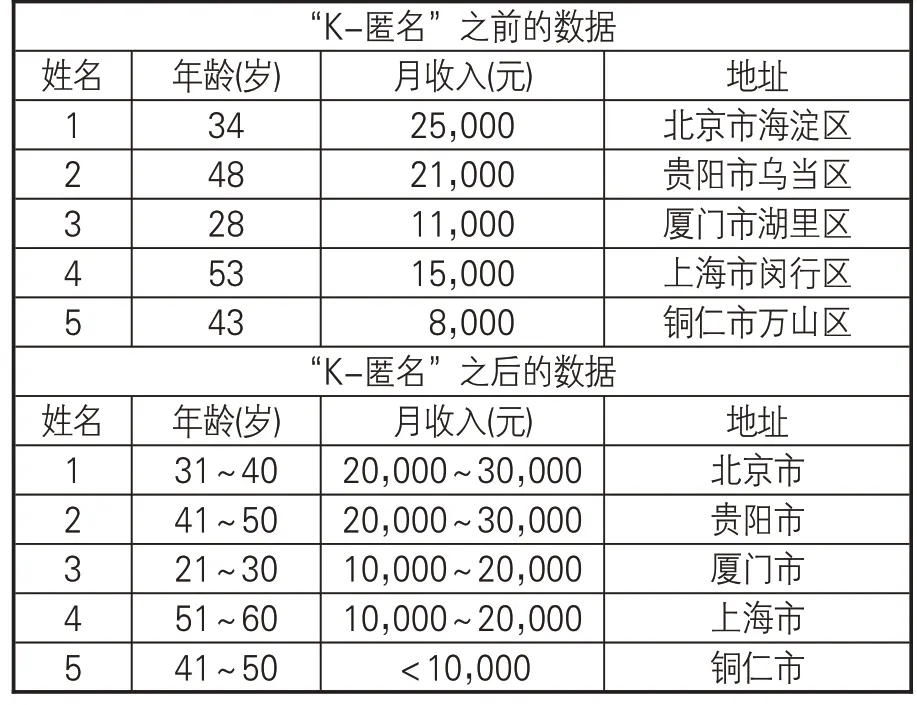

“数据概括化”是一种重要的数据匿名化技术,它主要是通过概括化(generalizing)或模糊化(diluting)数据主体的属性,修改数据的规模或强度排序(order of magnitude)[9]。当数据属性能够被概括,并且这些数据属性对于预期目的仍然具有价值时,可以考虑使用数据概括化技术。在使用“数据概括化”时,要注意设计适当大小的数据范围。新加坡个人数据保护委员会(Personal Data Protection Commission,PDPC )在《基本数据匿名技术指南》(Guide to Basic Data Anonymisation Techniques)中也指出,过大的数据范围意味着数据可能会被修改很多,而过小的数据范围可能意味着数据很难被修改,因此数据主体也很容易被再识别[11]。常见的“数据概括化”技术主要包括以下几类:(1)“数据聚合”(Aggregation)。这种技术是从一个或多个属性派生或合成一个或多个新的属性,这些新的属性能够最大限度阻隔与数据主体之间的关联,同时也能更好地用于实现数据分析的目标。(2)“K-匿名”(K-anonymity)。这种技术主要是防止数据主体从群体中被挑出,因而将数据主体与至少k个他人列为一组。(3)“L-多样性”(L-diversity)。这种技术改良了“K-匿名”技术,确保各个等价类(equivalent class)中的每一个属性均具有至少l个不同的数值,阻断决定性推断攻击(deterministic inference attacks)[9]。本文主要以“K-匿名”为例进行举例说明。

“K-匿名”的核心是故意降低数据的精确度,其目的是防止数据主体从群体中被“单独分离”,因此,在数据集中至少有k个他人与数据主体同为一组。为了实现“匿名化”目的,数据属性的具体数值将被概括化,例如将一个人的具体年龄转换为年龄范围,或者将精确的位置转换为不太精确的位置。表4大致展示了“K-匿名”前后的实例数据。

表4 “K-匿名”前后的数据

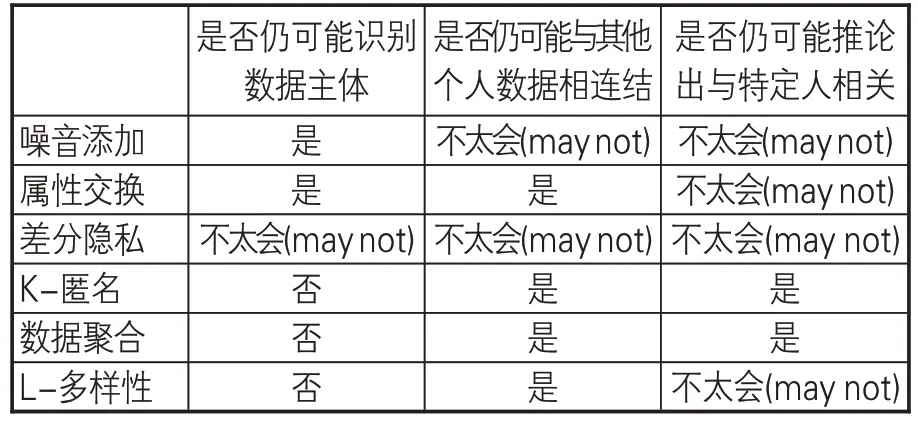

尽管欧盟在《一般数据保护条例》中并未对个人数据匿名化设立统一技术标准,但一般认为,要维持匿名化技术的稳健性(robustness),须满足3项要求:(1)是否仍可能识别数据主体;(2)是否仍可能与其他个人数据相连结;(3)是否仍可能推论出与特定人相关。由此可知,欧盟规定的“匿名数据”必须达到“完全无从再识别数据主体”的程度,如果仅仅是减少数据主体“再识别风险”,但仍有再识别的可能性,即不符合“匿名化”的要件。有学者据此认为欧盟将匿名化的可接受“再识别风险”定位为“零风险”,这在一定程度上给数据控制者造成了困扰[5]。因为任何匿名化技术都存在一定的剩余风险,正如一些研究者所指出的,匿名化技术作为一种新型技术,目前仍然处于起步阶段,还存在许多问题,主要表现在两个方面:一是对辅助知识的隐私侵犯;二是匿名化过程中大量信息损失[12]。比照前面3项技术标准,欧盟“第29条工作小组”对主要匿名化技术的有效性进行了评估,见表5[9]。

由表5可知,目前并没有任何匿名化技术能够达到完全无风险的匿名化,部分匿名化技术有其固有限制。因此,数据控制者在计划使用某种匿名化技术之前,必须仔细考量匿名化处理的各个细节,包括通过匿名化想要实现的目的、公布数据集时能否保护个人隐私,以及“攻击者”能否从公开的数据集中获取特定信息。为了能够最大限度地降低“再识别风险”,欧盟“第29条工作小组”认为良好的匿名化方案(good anoymisation practices)应该包括以下基本要素[9]:

表5 主要匿名化技术的有效性评估

第一,整体要素(in general)。在整体上不能依赖“释放”(release)以及“遗忘”(forget)。面对身份识别的“剩余风险”(residual risk),数据控制者应该注意以下几点:(1)定期评估是否存在新的风险,再鉴别各种剩余风险;(2)对于已经确定的风险,评估已采取的措施是否充分,并进行相应地调整;(3)监测和控制风险。

第二,背景要素(contextual elements)。数据控制者在识别风险上扮演了重要的角色,因此,应该清楚地说明匿名化所欲达到的目的,并且考量所有的相关背景元素。例如,原始数据的性质、现行的监管机制(包括限制查阅数据集的保护措施)、样本大小(量化特征)、可用公共信息的来源(取决于数据接收方)、接收数据的可能第三方等。此外,还需要同时考虑可能出现的攻击者,并建立相应的申诉机制。

第三,技术要素(technical elements)。在对个人数据进行匿名化处理时,数据控制者应公布单独或混合使用的匿名化技术,并从数据集中清除明显的个人特征或准标识符(quasi-identifiers)。例如,选择数据概括化处理时,即使是同样的数据属性,也不应受限于某一项数据概括化标准,换言之,应选择不同的位置细度(location granularities)或时间间隔(time intervals)。

4 欧盟个人数据匿名化的主要风险及评析

个人数据匿名化的主要目的在于平衡个人隐私保护与数据合理使用。早在20世纪70年代,隐私研究者就认识到“匿名化”需要谨慎对待。尽管“匿名化”的算法种类越来越多,技术也日趋复杂,但与此同时,各类“去匿名化”技术也迅速发展,对匿名化技术展开了强烈攻势。实践经验也表明匿名数据通常容易受到“去匿名化攻击”(de-anonymisation attacks)。匿名化作为一种概念和实践的价值不断受到质疑,最具代表性的是美国学者保罗·欧姆(Paul Ohm)提出的“打破隐私承诺”(broken promises of privacy)[13]。本部分对个人数据匿名化的主要风险——“简约化处理”进行阐述,这是实践中匿名化“失败”的主要原因,也是“反匿名化”(anti-anonymisation)观点的主要批判目标。

4.1 个人数据匿名化的主要风险:简约化处理

如前文所述,欧盟从《数据保护指令》到《第05/2014号意见:匿名化技术》再到《一般数据保护条例》,逐步为个人数据匿名化建构了一个非常严格的“合理可能”标准,即在检查个人数据是否匿名时必须考虑数据控制者和任何第三方用于识别数据主体身份的“一切”“合理”“可能”之手段。然而,立法政策在转化为实践时,难免会产生“漏斗效应”,对于个人数据匿名化而言,最直接的体现就是“简约化处理”或“简约化解读”。“简约化处理”的观点认为个人数据匿名化的基本原理,就是数据控制者设计一种“算法”(algorithm),并将之应用于个人数据,便能完全确保个人数据是匿名的,并且不存在再识别的可能性[14]。换言之,就是将用于进一步处理(如数据挖掘)的个人数据转换为“匿名信息”(anonymous information)。

关于“简约化处理”出现的原因,笔者认为,在某种程度上是由于立法者与数据控制者对于匿名化的价值追求不一致所导致的。一般认为,个人数据匿名化的目的有两个:一是保护数据的保密性和个人隐私;二是发挥数据的效用。对于立法者而言,个人隐私背后是人性尊严的维护,而数据效用更多体现为一种经济价值。因此,从利益衡量的角度看,个人隐私保护应该高于数据效用,当然能够维持个人隐私保护与数据有效利用的平衡是最好的。而对于数据控制者而言,其所看重的往往是数据的效用。分析数据集(特别是使用自动算法软件)所能获得的价值或知识是通过查找模式(基本上是链接数据点之间的关系)来最大化的。相比之下,匿名化旨在将这种数据点关系断开,因为在这些数据点关系中,它们与可以针对特定人员及其身份收集的信息相关,这就使得数据控制者面临一个困境:如何确保对其所拥有的个人数据进行有效匿名化,同时又保留该等数据的效用,以便将来向可能的第三方披露,并由第三方进一步处理[15]?在这种情况下,“简约化处理”便为数据控制者提供了一种“暂时性”策略,在形式上能够达到已经“匿名化”的效果,同时又保留数据的效用。

“简约化处理”在实践中主要体现为两种“版本”(version)或“变体”(variant):第一种版本称为“直接移除标识符”,即只要删除可能识别数据主体的敏感信息(sensitive information)就足够了,如姓名、出生日期、身份证号码、家庭住址、工作地点等。对于“直接移除标识符”,一般认为,在这种模式下数据主体再识别的风险最大。第二种版本称为“假名化”,即利用无法追溯到数据主体的“假名”(如一个随机生成的数字)替换具体的姓名,数据主体的不同信息可以链接到同一个“假名”,但是无法确定具体身份。如前文所述,对于“假名化”,欧盟《一般数据保护条例》将其与“匿名化”进行了区分,并于第4(5)条规定,“假名化”是指处理个人数据的方式,使该个人数据在不使用额外信息时,不再能够识别出特定的数据主体,且该额外数据已被分开存放,并以技术及组织措施确保该个人数据无法或无可识别出主数据主体。

从实践来看,由于匿名化技术的固有限制,再加上个案的特殊性在某种程度上会扩大这种固有限制。因此,即使是符合“合理可能”标准的匿名数据仍有“再识别风险”。“简约化处理”不仅成为了数据控制者的匿名化理念,而且成为了匿名化实践。由于“简约化处理”与“合理可能”标准之间在本质上存在很大的差距,因此,在实践中引发了许多问题,主要体现在两个方面:第一,“简约化处理”在客观上加剧了“再识别风险”。换言之,有些在形式上体现为匿名的数据实际上并没有被匿名,这就为“去匿名化攻击”提供了“便利”。美国学者拉坦娅·斯威尼(Latanya Sweeney)教授以1990年美国人口普查总数据进行实验。研究发现,有87%(2.48亿人口中的2.16亿)的美国人可以通过综合“邮编”“性别”“出生日期”这三个特征而被识别出来;有大约50%(2.48亿人口中的1.32亿)的美国人可以通过综合“地址”“性别”“出生日期”这三个特征被识别出来。拉坦娅·斯威尼教授最后得出结论,在一般情况下,只需要少数人口特征便能唯一地识别一个人[16]。第二,“简约化处理”弱化了数据控制者的责任。在“简约化处理”的实践中,个人数据处理的手段和目的往往是由数据控制者决定,其具有很大的自由裁量性。为了能够配合与支持当前的“大数据浪潮”,匿名数据不在欧盟数据保护法制范围之内,甚至世界上许多司法管辖区都将匿名数据排除在个人数据法律或隐私法律的范围之外。因此,匿名数据可以在不受个人数据保护法或隐私法约束的情况下共享,这使得匿名数据的传播模式变成了“释放后遗忘”,这意味着数据控制者不会去关注匿名数据“释放”后发生的情况。在这种背景下,数据控制者就通过“匿名”而回避了应该承担的诸多法律责任。美国学者保罗·欧姆认为个人数据匿名化已经失败了,假设攻击者很难破解匿名数据以及数据控制者能够完美的实施匿名化,这是非常天真的想法。对于个人隐私保护而言,个人数据匿名化是一张“空头支票”,它不应该成为一种规制目标(regulatory objective)[13]。

4.2 超越“简约化处理”:功能性匿名化

事实上,针对匿名化的“简约化处理”,欧盟个人数据保护法律已经给出了回应。如前文所述,虽然《数据保护指令》只对“个人数据匿名化”进行了原则性规定,但也基本确立了“合理可能”标准。此外,《第05/2014 号意见:匿名化技术》从技术层面对个人数据匿名化技术进行了详细阐述,并给出了针对性的建议。《一般数据保护条例》更是在“合理可能”标准之外增加了“假名化”规定,缩小了“匿名数据”的范围。更为重要的是,尽管匿名数据不在欧盟数据保护法律的范围之内,但是匿名化过程必须具备合法性。这里“合法性”主要体现在以下两个方面:第一,数据本身的收集和处理都必须符合适用的法律规定,且符合法律对于数据以可识别格式储存的规定。第二,“匿名化流程”,即经过匿名化处理将数据变成匿名数据,属于“后续处理”的一种。因此,该处理需要通过“相容性测试”(test of compatibility),并且必须符合“目的限制”(purpose limitation)原则的要求。

对“匿名化”与“反匿名化”之间的争论,艾拉·鲁宾斯坦(Ira S.Rubinstein)和伍德罗·哈茨佐格(Woodrow Hartzog)认为,围绕匿名化失败的辩论,印证了“隐私政策第一定律”(first law of privacy policy):没有灵丹妙药。我们不能指望技术专家或政策制定者单独给我们提供保护,我们需要一种整体性意识。我们应该把“再识别”看作是一个数据发布问题,健全的数据发布政策需要在多个方面保持谨慎的平衡:法律和技术、数据处理和数据控制、隐私和效用。两位学者进一步指出“基于过程的”(processbased)数据发布政策是因应个人数据匿名化失败的最佳方式,它是由平衡隐私保护和数据效用的策略驱动的,它具有整体性和综合性。最为重要的是,以“流程”为核心的数据发布政策具有很大的灵活性,它可以与相关的科学和实践经验一起发展[17]。笔者认为,前述学者的观点在一定程度上揭示了个人数据匿名化治理机制的核心,匿名化并非是“制度孤岛”,它需要与个人数据保护法制中的诸多规则(透明性、目的限制、告知同意等)相结合。此外,实施个人数据“匿名化”这一行为本身必须遵循一定的正当程序。

“基于过程的”的数据发布政策所体现的“整体性”思维给反思欧盟匿名化治理机制提供了启发。“合理可能”的匿名化标准本身没有任何问题,关键在于如何验证或实现这一标准。“简约化处理”之所以在形式上是符合“合理可能”标准的,原因在于其仅通过检查数据本身来确定是否实现匿名化。一个科学合理的验证方式或匿名化技术不仅必须考虑到数据本身,而且还必须考虑到数据所处的环境。英国学者马克·艾略特(Mark Elliot)等人将这种解决方案称为“功能性匿名化”(functional anonymisation):数据是否是匿名的(是否是个人的)取决于该等数据与其环境之间的关系。按照马克·艾略特等人的解释,“功能性匿名化”主要包括两个方面的要素:第一,数据环境(data environment)。数据环境通常由4个关键元素组成,对包含这4个元素的数据环境进行描述通常足以讨论、计划或评估原始数据集的功能性匿名化,具体包括“其他数据”“数据使用者”“治理流程”“基础设施”。第二,匿名化决策(anonymisation decision-making)。数据控制者在考虑如何在共享或发布数据时维护数据主体的秘密必须考虑如下因素:(1)描述目前的(预期)的数据情况;(2)明白自身的法律责任;(3)知道自身所拥有的数据;(4)明白使用范例;(5)履行自身的伦理义务;(6)确定评估披露风险所需的流程;(7)确定与自身的数据情况相关的披露控制流程;(8)确定利益相关者,并计划如何与他们沟通;(9)预测数据发布后可能发生的情况;(10)制定应急预案[18]。

尽管欧盟个人数据匿名化在理论上遭到诸多质疑,在实践中也存在一些困境。但是从保护个人数据的角度看,笔者认为,欧盟通过立法对个人数据匿名化设定严格标准,并通过相关的“意见”为实践提供指引,这种强化个人数据保护的立场是值得支持的。大数据时代,数据已经成为一种特殊的“资本”,它不会因为使用而枯竭,反而会不断释放潜在价值,为经济发展、技术创新提供原动力。个人数据匿名化在某种程度上会减损个人数据的效用或价值,但其背后所追求的是有关人性尊严的个人隐私。大数据时代的隐私权不再是消极地避免被知悉的信息防御权,而是信息自主决定权(right to information self-determination)。如果我们为了经济利益或技术进步而牺牲个人保护,这无疑是本末倒置,也必将得不偿失。

5 欧盟个人数据匿名化的经验

欧盟具有尊重个人隐私权利的传统,在很多重要的公约、法律中都凸显了个人隐私权的重要性。科学技术的快速发展也给欧盟个人隐私保护制度带来了很大的冲击。欧盟立法者审时度势,对新技术的发展进行了前瞻性思考,并形成了一套系统的个人信息保护制度,为全世界个人信息保护法制的发展提供了一个蓝本。大数据时代、人工智能时代的来临,数据的价值越来越受到世界各国政府的重视。一方面,通过大数据及数据开放,可以促使跨机关的数据流通,提升政府施政效能及透明度,满足社会公众需求,以强化社会监督政府的力量;另一方面,结合人工智能、云计算等技术,公共部门或私营部门可以利用数据进行无限创意,形成新的经济增长点,更好地促进社会的进步。2015年,国务院在《促进大数据发展行动纲要》中明确指出,到2020年要逐步实现交通、医疗、卫生、就业等相关领域的政府数据集向社会开放。然而,开放数据并非简单地将政府掌握的数据向社会公众释放,其必须经过一系列具体的流程,如盘点数据,对数据进行分类;检视数据权利完整性,对法规限制进行分析;选择数据开放范围,等等。在开放数据、数据共享的过程中,如何避免侵害个人隐私权益成为一个重要议题。当前,我国个人信息保护制度尚处于构建之中,很多制度尚未完全建立,需要吸取域外制度经验,实现制度的“本土化”。在我国个人信息保护法制背景下,就个人信息去识别化而言,笔者认为,欧盟个人数据匿名化治理经验可以为我们提供以下两个方面的借鉴。

5.1 立法层面:完善个人信息去识别化立法

从权力运行角度看,立法负有为执法提供依据或授权的职责,如果某一项制度在立法上缺失,那么执法就会因缺乏先关依据而带有很大的随意性,也就增大了侵犯公民权利的可能性。我国尚未制定《个人信息保护法》,有关个人信息保护的规定散见于各类法律法规中,如《民法总则》《网络安全法》《电信和互联网用户个人信息保护规定》等。新近出台的《十三届全国人大常委会立法规划》已经将《个人信息保护法》列入了“第一类项目:条件比较成熟、任期内拟提请审议的法律草案”中,这为完善我国个人信息去识别化提供了契机。

笔者认为,在《个人信息保护法》中需要对两个方面的内容进行明确:第一,明确个人信息的法律概念及分类。“个人信息”是个人信息去识别化的基础,如果个人信息的识别本身缺乏一个明确而统一的标准,那么有效的个人信息去识别化制度就变成了“无源之水,无本之木”。因此,需要在《个人信息保护法》中明确个人信息的概念,并在此基础上对个人信息进行分类,如一般的个人信息、敏感信息、不法行为信息等。从欧盟的经验来看,个人数据匿名化与个人数据都是同时在立法中予以明确,并且关联甚大。第二,明确个人信息“去识别化”的概念、性质及法律标准。对于个人信息去识别化的概念,应该围绕“个人信息”概念来进行。从目前我国已有的立法例以及司法实践来看,在认定“个人信息”时主要着重强调“识别性”。因此,“去识别化”可以界定为“经过一定程序的加工处理,使个人信息不再具有直接或间接识别性”④。对于个人信息去识别化的性质,笔者认为,去识别化行为应该定性为个人信息的“处理”,因此,必须遵循有关个人信息“处理”的基本原则及限制。对于个人信息去识别化的标准,笔者认为,在立法中不必规定统一的技术标准,但是必须规定一些核心要素(不可逆、不可识别等)或法律标准,如欧盟的“合理可能”标准。最为稳妥的办法是在《个人信息保护法》中明确“个人信息去识别化”的概念,同时授权个人信息保护专责机关制定去识别化的技术标准。目前欧盟、日本、新加坡、韩国、加拿大均采取了此种立法例。

5.2 执法层面:建构基于风险的去识别化治理

需要指出的是,此处所指的“执法”并不仅仅是指公共部门层面,尤其是在“自我规制”(self-regulation)改革的背景下,这里的“执法”泛指所有“信息控制者”;此处所指的“治理”(governance),既涉及公共部门,也包括私人部门(private sector)。对个人信息去识别化治理而言,除了立法要提供法律依据或授权外,尚需要“执法”将这些立法政策转化实践,落到实处。信息控制者作为个人信息去识别化的实际实施者,其治理机制是否有效直接关系到去识别化的效果。

如前文所述,笔者认为,个人信息去识别化本身就是“风险预防原则”的一种体现。因此,信息控制者需要将“风险管理”(risk management)融入到个人信息去识别化的治理机制中,建构“基于风险的”(risk-based)去识别化治理机制,具体应该注意以下几点:第一,个人信息关系到个人隐私,甚至是人性尊严,因此,无论是收集、使用或披露个人信息时,都应该尊重个人的基本权利。第二,不论因个人信息处理而产生的风险程度高或低,都应该尊重个人信息保护法赋予信息主体的权利。第三,应该建立风险评估机制。风险评估机制应该具备整体性,主要包括以下两类:(1)事前风险预防机制。在个人信息去识别化开始之前,应该对个人信息进行整体性风险影响评估,综合考量个人信息类型、敏感程度、对外提供信息的方式、引发他人再识别的意图等因素,并根据风险评估的结果计算设定风险阀值,进而判断去识别化的技术类型或程度。(2)事后风险评估机制。对于个人信息去识别化之后或去识别化个人信息发布以后,应该定期对个人信息进行风险评估。一方面,检测已有的风险预防措施是否仍然适当或有效;另一方面,检测是否出现新的风险。

6 结语

大数据时代,既可能是“最好”的时代,也可能是“最坏”的时代。一方面,个人信息的潜在价值被不断释放;另一方面,个人隐私权也受到前所未有的挑战。新技术收集更多有关我们日常生活习惯和愿望这些看似无伤大雅的数据,信息处理技术的进步使政府、企业和犯罪分子更容易分析和解释这些数据,从而绘制我们的个人特征[19]。在数据开放、数据共享成为必然趋势的情况下,个人信息去识别化是维持个人隐私权益、企业经济利益与社会公共利益之间平衡的重要手段。

欧盟对个人数据匿名化治理已经积累了多年的立法经验,值得我国参考。欧盟通过正式的“法律”明确了个人数据匿名化的法律标准,同时又通过非正式的“意见”细化了个人数据匿名化的技术标准,为个人数据匿名化的实践提供全方位指导。与此同时,我们也应该认识到,个人数据匿名化在欧盟实践中也面临“简约化处理”的困境,难以最大限度发挥作用,导致某种程度上的“制度空转”。

我国应该审慎对待欧盟的经验,要注重制度“本土化”的基础及效果。在立法层面,我国应当尽快制定《个人信息保护法》,明确个人信息的内涵及去识别化的法律标准,同时还应该制定与个人信息去识别化有关的细则,设定去识别化的技术标准。在“执法”层面,个人信息控制者应该建立“基于风险的”去识别化治理机制,加强对去识别化各个阶段中风险的识别、预防及处理。

注释

①“personal data”是欧盟法中通用的法律术语,国内一般将其译为“个人数据”,其规范内涵大致与我国法律语境中的“个人信息”对应。为了保持欧盟法律制度本身之独特性,本文统一采用“个人数据”这一用语。

③欧盟“第29条工作小组”是根据《数据保护指令》第29条之规定,于1995年成立的咨询机构,它是由各欧盟成员国的数据保护机构、欧盟数据保护监督员、欧盟委员会的代表组成的。2018年5月25日,《一般数据保护条例》正式实施以后,“第29条工作小组”已被“欧洲数据保护委员会”(European Data Protection Board,EDPB)所取代。

④我国台湾地区的“法律事务主管部门”在关于“去识别化”的函释见解中将“非个人资料”解释为:“如公务机关将保有的个人数据运用技术去识别化而呈现方式已无从直接或间接识别特定个人,即非属个人资料。”