多通道深度可分离卷积模型实时识别复杂背景下甜菜与杂草

孙 俊,谭文军,武小红,沈继锋,芦 兵,戴春霞

多通道深度可分离卷积模型实时识别复杂背景下甜菜与杂草

孙 俊,谭文军,武小红,沈继锋,芦 兵,戴春霞

(江苏大学电气信息工程学院,镇江 212013)

针对实际复杂田间环境下杂草与作物识别精度低和实时性差的问题,为减少弱光环境对分割识别效果的影响,实现甜菜与杂草的实时精确分割识别,该文首先将可见光图像进行对比度增强,再将近红外与可见光图像融合为4通道图像;将深度可分离卷积以及残差块构成分割识别模型的卷积层,减少模型参数量及计算量,构建编码与解码结构并融合底层特征,细化分割边界。以分割识别精度、参数量以及运行效率为评价指标,通过设置不同宽度系数以及输入图像分辨率选出最优模型。试验结果表明:本文模型的平均交并比达到87.58%,平均像素准确率为99.19%,帧频可达42.064帧/s,参数量仅为525 763,具有较高分割识别精度和较好实时性。该方法有效实现了甜菜与杂草的精确实时识别,可为后续机器人精确除草提供理论参考。

作物;图像分割;卷积神经网络;深度学习;甜菜;杂草;实时

0 引 言

杂草是影响作物生长的重要因素之一,会与作物争肥争水,增加病虫害的传播,故及时去除杂草对于保证作物高产具有重要意义[2]。传统除草一般是人工除草,通过人力挖除或者喷药实现除草,但需要耗费大量人力。另外喷药产生的农药残留不仅对人类健康产生巨大威胁,而且容易破坏生态环境[1]-[2]。随着绿色农业的概念提出,为了提高作物产量、减少环境污染,实现智能化除草,解决杂草与作物实时精确识别问题就显得尤为重要[3-6]。

机器视觉在农业中应用广泛[7-8],目前大多数杂草与作物识别研究也是基于机器视觉技术,通常包含特征提取与模式识别两个步骤。何东健等[9]提取植物叶片形状、纹理等特征并提出了一种多特征融合的方法,最后通过支持向量机(support vector machine,SVM)建模识别杂草。赵川源等[10]将多光谱图像转换为Lab颜色空间,提取叶片多种特征,并采用C4.5算法对杂草进行识别。Pulido等[11]计算图像灰度共生矩阵(gray-level co-occurrence matrix,GLCM),然后使用支持向量机分类器区分杂草与蔬菜。以上文献均是先提取特征然后通过分类器实现杂草识别,虽然在特定环境下取得较好效果,但是实际杂草识别中,识别效果容易受光照、遮挡、以及图像采集质量等因素的影响,所以提高杂草识别方法的鲁棒性在传统机器视觉中仍然是一个难以解决的问题。

深度学习[12]是机器学习的一个分支,其中的卷积神经网络(convolutional neural network,CNN)成为了图像处理中一个研究热点。近些年,卷积神经网络在图像识别[13-16]、语义分割[17-18]、目标检测[19-20]中取得重大突破,由于其对图像特征表征能力强,所以越来越多学者将卷积神经网络应用在农业领域。王璨等[21]以幼苗期玉米及杂草为研究对象,构建卷积神经网络模型,提取图像高斯金字塔多尺度特征,并结合超像素分割避免杂草识别中重叠问题。孙俊等[22]提出了一种空洞卷积与全局池化相结合的多尺度特征融合卷积模型,有效的识别多种杂草。Tang等[23]采用K-means学习的图像特征,并将其参数替换卷积神经网络的随机初始化参数,最后通过微调模型参数的方法提高杂草识别精度。上述文献均是采用基于分类思想实现杂草识别,为了更精确定位杂草与作物位置,Milioto等[24]采用基于语义分割的模型实现端到端的图像像素点分类,提取传统图像特征并按通道进行像素级叠加从而构建14通道的输入图像,获得了较好分割识别效果。

以上文献表明将卷积神经网络模型应用于杂草识别是可行的,且能避免传统机器视觉方法中特征提取过程带来的主观性,提高了杂草识别精度。但是,由于实际环境下除草机器设备配置低,因此如何在有限硬件环境配置下节省资源消耗,达到实时精确的识别效果是需要解决的一个关键问题。为解决上述问题,本文以甜菜为对象,通过获取田间甜菜的近红外以及可见光图像,构建了4通道输入图像,并提出了一种编码与解码型轻量级卷积神经网络结构,通过加入深度可分离卷积减少模型参数量与计算量。本文最后通过试验研究模型参数优化选择,为后续智能除草机的研制提供理论依据。

1 试验数据

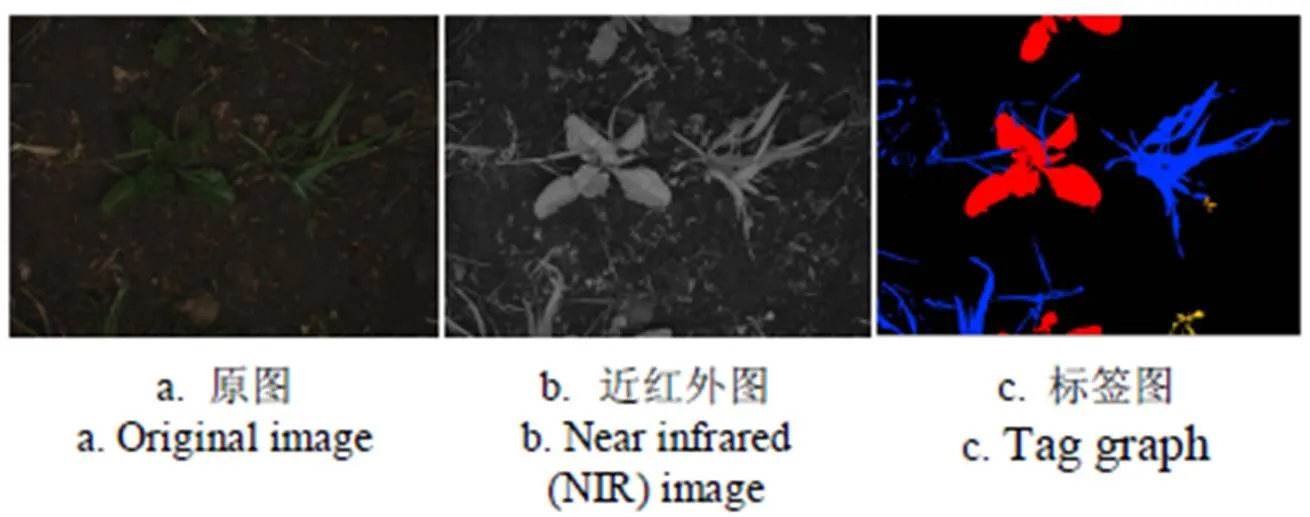

本文采用2016年德国波恩大学采集的甜菜与杂草图片作为数据集[25],该数据集在德国波恩的农场采集,数据集涵盖了不同生长阶段的甜菜图片。采集图片的机器人上配备JAI AD-130 GE摄像头,可以同时获取RGB图片和近红外(near infrared,NIR)图片。由于像素级别的图片标注难度大,故该数据集中带标签的图片较少,共283张。数据集样例如图1所示,图片包含甜菜和其他各类杂草,其中标签的红色区域表示甜菜,其他颜色区域表示杂草。

图1 数据集示例

深度学习是数据驱动的自动特征学习方法,通常深度学习语义分割模型的输入图片是RGB三通道图片。由于已标注图片数量过少,训练一个鲁棒性较好的深度学习模型难度较大,一方面,浅层次模型难以拟合复杂背景图片,另一方面,设计深层模型对数据量要求高,容易发生过拟合现象。针对上述问题,Milioto等[24]在论文中提出增加额外特征图作为卷积神经网络模型的输入,其试验结果证明了特征融合的方法确实可以提升模型的精度。本文参考该论文的方法,与其不同的是,本文先对原始RGB图像进行对比度增强,然后将图像增强后的图片与NIR图片进行融合,构成4通道输入图像,避免原始图片特征冗余和减少计算量。随机选取226张图片作为训练集,剩余57张作为测试集。

2 甜菜与杂草分割识别模型

2.1 深度可分离卷积