场景对面孔情绪探测的影响:特质性焦虑的调节作用*

李婉悦 韩尚锋 刘 燊 杨亚平 张 林 徐 强

场景对面孔情绪探测的影响:特质性焦虑的调节作用

李婉悦韩尚锋刘 燊杨亚平张 林徐 强

(宁波大学心理学系暨研究所, 宁波 315211) (中国科学技术大学人文与社会科学学院, 合肥 230022)

本研究采用面孔情绪探测任务, 通过状态−特质焦虑问卷筛选出高、低特质性焦虑被试, 考察场景对不同情绪效价以及不同情绪强度的面部表情加工的影响, 并探讨特质性焦虑在其中所发挥的作用。结果发现:(1)对于不同情绪效价的面部表情, 场景对其情绪探测的影响存在差异:对于快乐面部表情, 在100%、80%和20%三个情绪层级上, 在场景与面孔情绪性一致情况下, 被试对面孔情绪探测的正确率显著高于不一致情况; 对于恐惧面部表情, 在80%、60%、40%和20%四个情绪层级上, 均发现一致条件比不一致条件有着更高的情绪探测正确率。(2)对于高特质性焦虑组, 一致条件和不一致条件中的面孔情绪探测正确率并没有显著差异, 即高特质性焦虑组并未表现出显著的场景效应; 而低特质性焦虑组则差异显著, 即出现显著的场景效应。该研究结果表明:(1)对于情绪强度较低的面部表情, 快乐与恐惧面孔情绪探测都更容易受到场景的影响。(2)相比于中等强度快乐面孔, 场景更容易影响中等强度恐惧面孔情绪的探测。(3)特质性焦虑的个体因素在场景对面孔情绪探测的影响中发挥调节作用, 高特质性焦虑者在情绪识别中较少受到场景信息的影响。

场景; 面部表情; 特质性焦虑; 场景效应; 调节作用

1 引言

在社会交往过程中, 面部表情是表达个人感受、了解他人心理活动的重要渠道, 也是情绪传播的主要媒介。面部表情的加工受到研究者的广泛关注。其中, 基于情绪类别理论(categorical theory of emotion), 研究者认为面孔所表达的情绪意义与某一面部构型(facial configurations)特征有着稳固的联系, 面部构型特征是影响面部表情识别的主要因素(Ekman, 1993)。因此, 以往研究大多集中探讨个体对独立面部表情的加工(e.g., Walentowska & Wronka, 2012; Dodd, Vogt, Turkileri, & Notebaert, 2017)。然而, 在现实社会交往过程中, 面孔通常伴随着场景(sence)而出现。场景所包含的语义信息和情绪意义, 对面部表情的识别发挥重要的作用(e.g., Hassin, Aviezer, & Bentin, 2013; Aviezer, Ensenberg, & Hassin, 2017)。此外, 情绪的表达、传播不仅基于面部表情自身的构型特征, 而且与个体的情绪加工能力相关(Rigon, Voss, Turkstra, Mutlu, & Duff, 2016; Damjanovic, Meyer, & Sepulveda, 2017; Liu et al., 2017)。有研究发现, 特质性焦虑的个体因素影响面部表情加工(Bourne & Vladeanu, 2011; Park, Vasey, Kim, Hu, & Thayer, 2016)。因此, 本研究主要探讨面孔情绪探测过程中场景信息的影响, 以及特质性焦虑在该过程中所发挥的作用。

近年来, 场景对面部表情加工的影响受到研究者的广泛关注。场景效应(scene effects)指来自场景的情绪信息对面部表情加工的影响, 具体表现为当场景与面孔情绪一致时促进面部表情的加工, 反之则抑制加工(Righart & de Gelder, 2006; Barrett & Kensinger, 2010; 徐强, 杨亚平, 张恩涛, 张锋, 2014; 胡治国, 刘宏艳, 2015)。Righart和de Gelder (2008b)的一项行为学研究发现, 当面孔与场景同时呈现时, 如果场景与面孔情绪类型一致, 场景信息会促进面部表情的识别, 反之, 则会阻碍面部表情的识别。来自事件相关电位(event-related potentials, ERPs)的研究也为面部表情加工的场景效应提供了证据支持。例如, Hietanen和Astikainen (2013)的研究采用情绪启动范式, 探讨作为启动刺激的情绪性场景对面部表情辨别的影响。该研究的行为结果发现, 当场景与面孔的情绪一致时, 面部表情识别的速度更快、正确率更高; ERP结果发现, 与面孔早期知觉编码相关的N170成分表现出了显著的场景情绪启动效应:场景和面孔情绪一致条件下诱发的N170波幅显著大于不一致条件。研究者认为, 场景情绪性信息影响面孔的早期知觉编码过程。此外, 有研究发现, 当场景情绪信息与面部表情相冲突时, 诱发更大的额中区(frontal-centro) N2波幅, 该效应反映了场景与面部表情之间情绪性冲突的监控(Xu et al., 2015)。以上来自行为和事件相关电位的研究探讨了面部表情加工过程中的场景效应, 但上述研究均采用固定情绪强度的面部表情刺激图片, 场景信息对不同情绪强度面部表情加工的影响是否具有不同模式尚不清楚。

在日常生活中, 个体觉知的面部表情并非固定不变, 面部表情从出现到消失伴随着情绪强度的不断变化。Palumbo和Jellema (2013)的研究发现, 变化的面部表情会影响个体对面孔情绪的辨别。具体地, 当面部表情从快乐或愤怒逐渐变为中性表情时, 被试更容易将中性表情误判为略微愤怒或略微愉快; 而当面部表情从中性开始逐渐变化为快乐或愤怒表情时, 这种情绪判断偏差消失了。另外, 个体对面部表情的辨别还会受到呈现顺序的影响, Fayolle和Droit-Volet (2014)发现在对一系列面部表情进行辨别的任务中, 先前呈现的面部表情影响个体对当前面部表情的分类, 具体可表现为同化效应和对比效应两种分类偏差。一项ERP研究发现, 动态呈现的消极面部表情比起动态呈现的积极和中性面部表情诱发更大的LPC波幅; 另外, EPN和LPC波幅均随着动态面部表情强度的增加而增大(Recio, Schacht, & Sommer, 2014)。以上研究表明, 在连续变化的面部表情识别过程中, 对表情类别的判断有着明显的类别界线, 另有研究者进一步指出, 来自个体特质或者场景信息的影响都可能使该界线发生偏移(邱方晖, 罗跃嘉, 贾世伟, 2015)。此外, Lee, Choi和Cho (2012)初步探讨了场景信息对不同情绪强度面部表情识别的影响。他们的研究发现, 当经过渐变处理的恐惧面部表情嵌入场景中呈现时, 面孔情绪意义越模糊, 被试越容易依据场景信息对面孔情绪进行判断。研究者认为, 场景信息影响了个体对面孔情绪知觉的阈限:相比于中性场景, 在消极场景下被试对面孔恐惧情绪的知觉阈限更低, 积极场景则使被试对面孔恐惧情绪的知觉阈限提高。然而, 该研究仅关注消极面部表情(恐惧面孔), 积极面部表情的加工与消极面部表情的加工存在质性区别。因此, 本研究也将探讨场景信息对不同情绪效价以及不同情绪强度的面部表情加工的影响是否具有相似性。

此外, 有研究者发现, 个体的人格特质因素, 如特质性焦虑同样会影响面部表情的加工(Bourne & Vladeanu, 2011; Park et al., 2016)。焦虑是一种由外在刺激引发的内心不安或恐惧的消极情绪体验, 也是一种具有进化意义的情绪, 适度的焦虑有利于个体更好地完成认知任务, 病态的焦虑则会损害人的认知功能(Hartley & Phelps, 2012)。Spielberger (1966)将焦虑分为状态性焦虑与特质性焦虑。前者是一种随着时间和情境而变化的短暂的情绪状态, 后者则是一种比较稳定的人格特质。高特质性焦虑个体在没有特别的焦虑事件诱发情况下, 也保持着较高的焦虑水平, 从而较易形成认知偏差而损害认知能力和行为表现。Sadeh和Bredemeier (2011)发现, 在高认知负荷任务中, 相比于低特质性焦虑的个体, 高特质性焦虑个体更难抑制对任务无关刺激的注意。该结果表明焦虑影响了个体的认知加工, 从而损害了任务绩效。有研究者认为, 焦虑情绪对认知功能的损害是因为对刺激信息的归因偏向, 倾向于将模糊刺激知觉为威胁性刺激, 具体可以表现为特质性焦虑影响个体对面孔情绪的解释。例如, Park等(2016)研究发现, 在一项面部表情分类任务中, 高特质性焦虑者更容易将中性面部表情或歧义面部表情(如惊讶)识别为负性面部表情, 而低特质性焦虑者则没有出现这种偏向。另一种观点则认为, 焦虑改变了个体对负性刺激的感受性。高特质性焦虑者对负性情绪刺激的觉察过于敏感, 即表现在对情绪性刺激的加工中, 高特质性焦虑者存在较强的负性情绪刺激的注意偏向。例如, Dodd等(2017)在一项视觉搜索任务中, 分析了特质性焦虑分数与注意偏向指数的相关性, 结果发现二者存在显著的正相关。该结果表明, 高特质性焦虑个体将更多的注意资源集中于负性情绪面孔, 对愤怒、恐惧等面孔情绪的探测过于敏感。另外, 针对场景信息加工的研究发现, 先前呈现的恐惧面部表情会影响高特质性焦虑者对当前场景信息的威胁性评估, 研究者认为, 高特质性焦虑者存在对恐惧面部表情的过度关注, 从而影响其对后续呈现场景的解释(Longin, Rautureau, Perez-Diaz, Jouvent, & Dubal, 2013)。综上, 以往基于孤立面孔的研究证据表明, 特质性焦虑的个体因素在面部表情加工过程中发挥着作用, 高特质性焦虑者对负性情绪面孔存在加工偏向。另外, 面孔情绪也可以影响高特质性焦虑个体对场景信息的判断。那么, 当场景先于面孔呈现时, 高特质性焦虑的个体是否会因为对负性情绪面孔的过度关注而忽略场景的影响?这也是本研究将要探讨的问题之一。

本研究采用情绪启动范式, 以积极、消极场景图片和快乐、恐惧情绪强度渐变的面孔图片为实验材料, 通过状态−特质焦虑问卷(Spielberger, Gorsuch, Lushene, Vagg, & Jacobs, 1983)筛选出高、低特质性焦虑被试, 采用面孔情绪探测任务, 考察先前呈现的场景对面孔情绪探测的影响, 以及特质性焦虑在其中的作用。本研究假设:(1)在场景与面孔情绪一致条件下, 个体对场景信息的加工会促进面孔情绪的探测; 反之则起到阻碍作用; (2)场景信息对不同情绪强度面部表情加工的影响存在差异; (3)场景效应会受到特质性焦虑的个体因素的调节, 高、低特质性焦虑者在面孔情绪探测中具有不同的表现模式。

2 方法

2.1 被试

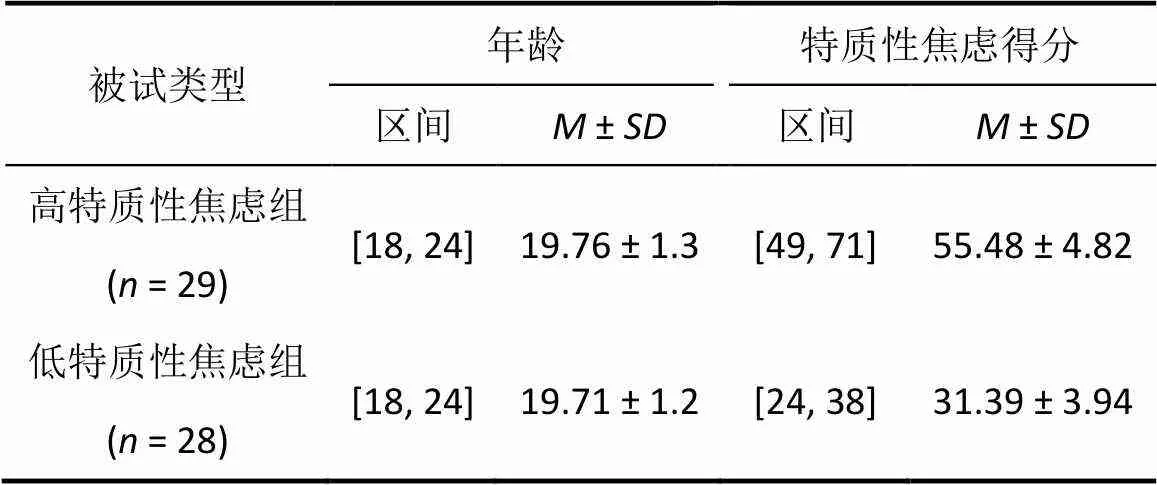

使用Spielberger状态−特质焦虑问卷(State- Trait Anxiety Inventory, STAI) (Spielberger et al., 1983) 对随机选取的436名大学生被试进行特质性焦虑的评定。依据特质性焦虑得分高低以27%为标准进行被试筛选。在得分前27%的被试中选取高特质性焦虑被试29人(男性9人, 女性20人, 年龄18~24岁, 平均年龄为19.76 ± 1.3岁); 在得分后27%的被试中选取低特质性焦虑被试28人(男性11人, 女性17人, 年龄18~24岁, 平均年龄为19.71 ± 1.2岁)。两组被试的特质性焦虑得分(总分在20~80之间)存在显著差异(高特质性焦虑组= 55.48,= 4.82; 低特质性焦虑组= 31.39,= 3.94;(55) = 20.62,< 0.001)。两组被试的基本情况见表1。所有被试视力或矫正视力正常, 无色弱色盲, 均为右利手, 无精神病史。实验前, 所有被试均阅读和签署了实验知情同意书。

表1 高低特质焦虑组被试基本情况

2.2 实验刺激

本研究所使用的面孔图片(4人, 男女各半, 即在图片库中编号为01、06、28和36的四名模特)选自于NimStim面部表情图片库(the NimStim Set of Facial Expressions) (Tottenham et al., 2009), 其中, 呈现典型快乐、中性以及恐惧表情的面孔图片各4张。去除这些面孔图片的头发和其他饰物, 仅保留面孔内部特征, 并调整为灰度一致的黑白图片, 使用Morph技术进行情绪强度的渐变处理。具体地, 将恐惧面部表情(100%) vs.中性面部表情(0%)以及快乐面部表情(100%) vs.中性面部表情(0%)按照20%的增量进行morph处理, 以此构建渐变情绪面孔, 为了避免口部特征(特别是牙齿)对恐惧和快乐面部表情识别的不均等影响, 所有面孔图片均未露出牙齿(具体见图1)。所有场景图片的大小、明度和对比度保持一致。

为了进一步验证morph处理之后面孔材料的有效性, 招募了未参加过类似实验的38名被试(男19人, 女19人), 年龄在18~21岁之间(= 19.12,= 0.84), 对实验材料的情绪强度进行9点评分(1表示非常弱的快乐/恐惧, 9表示非常强的快乐/恐惧)。结果表明, 对于快乐和恐惧面孔的情绪强度评分, 均表现出不同情绪层级上差异显著(快乐面孔:(5, 33) = 76.42,0.001, partial η= 0.87; 恐惧面孔:(5, 33) = 33.68,0.001, partial η= 0.78)。事后多重比较发现, 除了100%与80%情绪层级以外, 其他情绪层级均表现出显著差异, 即较高层级情绪强度评分显著高于较低层级(s < 0.05), 这表明被试能够区分不同层级的面部表情强度。

另外, 本研究所使用场景图片均来自于国际情绪图片系统(International Affective Pictures System, IAPS) (Lang, Bradley, & Cuthbert, 2008), 其中与快乐相关的积极场景(如鲜花盛开)20张, 与恐惧相关的消极场景图片(如车祸现场)20张。积极和消极场景图片的效价(1 = 非常消极, 9 = 非常积极)存在显著差异(积极M = 7.55, SD = 0.41; 消极M = 2.73, SD = 0.40; t (38) = 37.56, p < 0.001), 唤醒度(1=非常平静, 9=非常紧张)的差异不显著(积极M = 5.58, SD = 0.30; 消极M = 5.82, SD = 0.59; t (38) = −1.65, p = 0.107)。所有场景图片的大小、明度和对比度保持一致。

图1 不同情绪强度的面孔刺激样例

2.3 实验设计

采用2(特质性焦虑:高, 低) × 2(场景类型:积极, 消极) × 2(面孔情绪序列:恐惧序列, 快乐序列) × 6(面孔情绪层级:0%, 20%, 40%, 60%, 80%, 100%)的混合设计。其中特质性焦虑因素为组间变量, 其它因素均为组内变量。因变量为面孔情绪的探测正确率。

2.4 实验程序

由于0%情绪层级的快乐和恐惧面孔均为同一中性面孔, 实验中积极场景+0%恐惧面孔、消极场景+0%恐惧面孔、积极场景+0%快乐面孔、消极场景+0%快乐面孔四种实验条件实际设置为积极场景+中性面孔、消极场景+中性面孔两种实验条件。因此, 本实验过程中实际包括22种条件, 每种条件重复20次, 总共440个试次。所有实验条件完全混合随机呈现。刺激呈现在屏幕中央, 背景为灰色。所有刺激呈现顺序是:首先呈现注视点“+” (500 ms), 注视点之后呈现场景图片300 ms, 间隔100 ms之后呈现面孔图片200 ms, 要求被试对面孔情绪性进行判断(恐惧/中性/快乐), 待被试按键反应后, 随机间隔600~800 ms, 开始下一个试次(见图2)。实验过程中, 被试双手放在键盘上, 左手食指放在F键上, 右手食指放在J键上, 双手大拇指放在空格键上。判断为快乐则左手食指按F键, 判断为恐惧则右手食指按J键, 判断为中性则双手大拇指按空格键。快乐和恐惧的按键在被试间进行平衡。正式实验之前安排被试进行适当练习以熟悉实验任务, 练习阶段所用刺激材料不在正式实验阶段出现。正式实验中, 每40个试次后被试休息一次, 休息完毕后按空格键继续实验。实验总时长约30分钟。

实验在照明舒适的隔音房间内进行, 计算机屏幕与被试双眼的距离为70cm。刺激材料均在计算机屏幕中央呈现。面孔图片的呈现视角为2.87° ×3.31°, 场景图片的呈现视角为16.37° ×12.28°。

3 结果

以面孔情绪探正确率指标为因变量, 进行2(特质性焦虑:高, 低) × 2(场景类型:积极, 消极) × 2(面部表情序列:恐惧序列, 快乐序列) × 6(面孔情绪层级:0%, 20%, 40%, 60%, 80%, 100%)的重复测量方差分析, 其中特质性焦虑因素为组间变量, 其它均为组内变量。

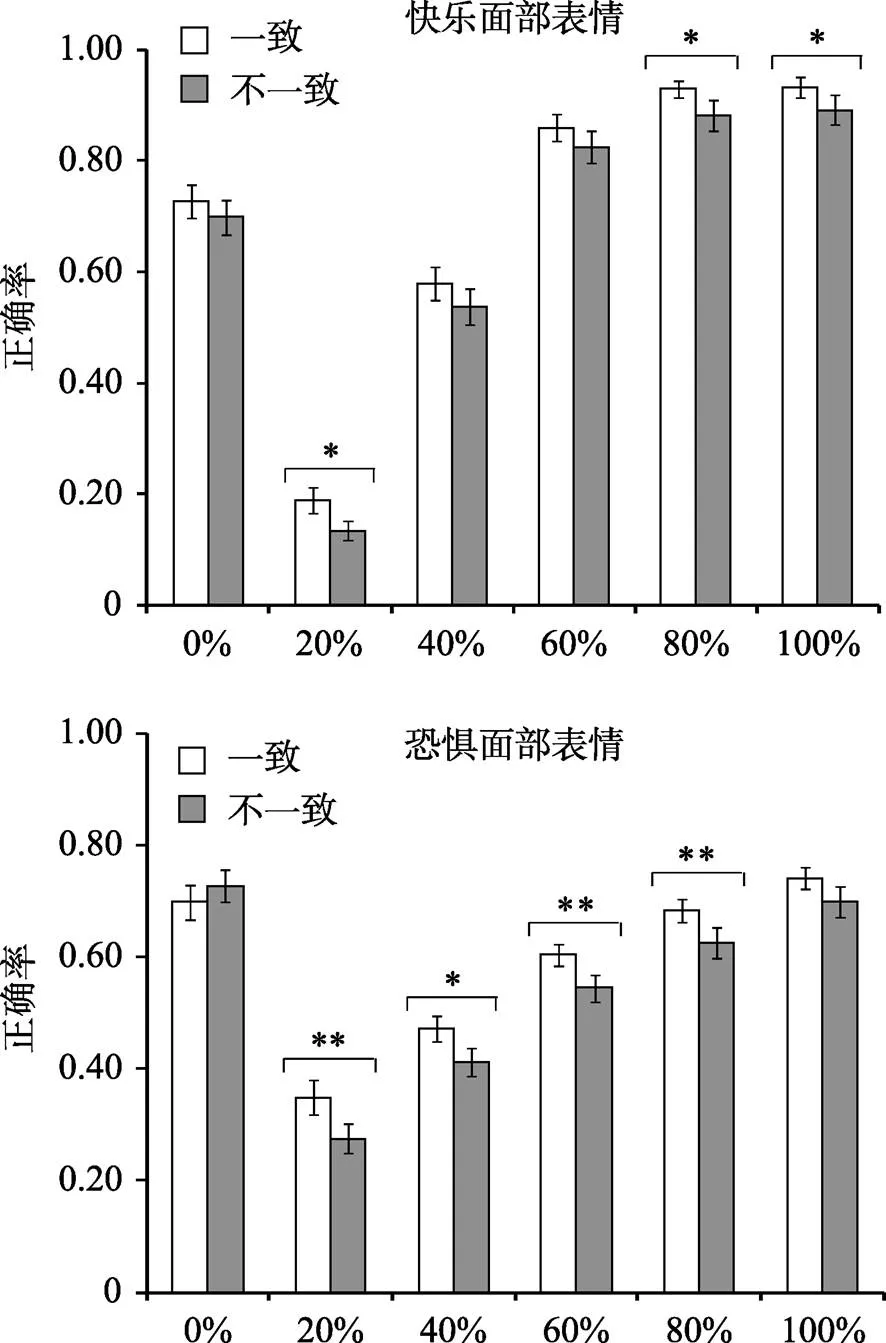

方差分析结果表明, 面部表情序列主效应显著,(1, 55) = 31.69,0.001, partial η= 0.37; 面孔情绪层级的主效应显著,(5, 51) = 121.66,0.001, partial η= 0.92; 场景与面部表情序列的交互作用显著,(1, 55) = 12.75,0.01, partialη= 0.19; 更重要的是, 场景、面部表情序列和面孔情绪层级的交互作用显著,(5, 51) = 2.88,0.05, partial η= 0.22。针对该交互作用的进一步简单效应检验发现, 对于快乐面部表情, 在100%、80%和20%三个情绪层级上, 一致条件(即积极场景与快乐面部表情相继呈现)比不一致条件(即消极场景与快乐面部表情相继呈现)有着更高的情绪探测正确率(100%: 一致条件M = 0.93, SE = 0.020 vs. 不一致条件M = 0.89, SE = 0.03, p = 0.03; 80%: 一致条件M = 0.93, SE = 0.02 vs. 不一致条件M = 0.88, SE = 0.03, p = 0.01; 20%: 一致条件M = 0.19, SE = 0.02 vs. 不一致条件M = 0.14, SE = 0.02, p = 0.013)。另外, 对于恐惧面部表情, 除了100%和0%两个情绪层级外, 在80%、60%、40%和20%四个情绪层级上, 均有一致条件(即消极场景与恐惧面部表情相继呈现)比不一致条件(即快乐场景与恐惧面部表情相继呈现)有着更高的情绪探测正确率(80%: 一致条件M = 0.68, SE = 0.02 vs. 不一致条件M = 0.63, SE = 0.03, p = 0.008; 60%: 一致条件M = 0.60, SE = 0.02 vs. 不一致条件M = 0.55, SE = 0.02, p = 0.008; 40%: 一致条件M = 0.47, SE = 0.02 vs. 不一致条件M = 0.41, SE = 0.03, p = 0.014; 20%: 一致条件M = 0.35, SE = 0.030 vs. 不一致条件M = 0.28, SE = 0.03, p = 0.001), 具体见图3。

图2 实验流程图

此外, 特质性焦虑、面部表情序列和场景的交互作用显著,(1, 55) = 4.37,0.05, partial η= 0.07。进一步的简单效应检验发现, 对于高特质性焦虑组, 无论是快乐面部表情还是恐惧面部表情, 一致条件(即场景与面孔的情绪性一致)和不一致条件(即场景与面孔的情绪性不一致)中的面孔情绪探测正确率均并没有显著差异(快乐面部表情:一致条件= 0.71,= 0.02 vs. 不一致条件= 0.69,= 0.03,0.267; 恐惧面部表情:一致条件= 0.57,= 0.02 vs. 不一致条件= 0.56,= 0.03,0.411); 然而, 对于低特质性焦虑组, 无论是快乐面部表情还是恐惧面部表情, 一致条件的面孔情绪探测正确率显著高于不一致条件(快乐面部表情:一致条件M = 0.69, SE = 0.021 vs. 不一致条件M = 0.63, SE = 0.03, p = 0.001; 恐惧面部表情:一致条件M = 0.61, SE = 0.02 vs. 不一致条件M = 0.54, SE = 0.03, p < 0.001), 即高特质性焦虑组并未表现出面部表情加工的场景效应, 而低特质性焦虑组表现出显著的面部表情加工的场景效应, 具体见图4。

图3 不同情绪强度的面部表情在不同场景中的探测正确率

注:误差线表示标准误, *< 0.05, **< 0.01

图4 特质性焦虑高组和低组对不同场景中快乐和恐惧面孔情绪的探测正确率

注:误差线表示标准误, *< 0.05, **< 0.01, ***< 0.001

以面孔情绪探测反应时指标为因变量, 剔除错误反应以及超出各实验条件平均数上下三个标准差的数据, 进行2(特质性焦虑:高, 低) × 2(场景类型:积极, 消极) × 2(面部表情序列:恐惧序列, 快乐序列) × 6(面孔情绪层级:0%, 20%, 40%, 60%, 80%, 100%)的重复测量方差分析, 其中特质性焦虑因素为组间变量, 其它均为组内变量。

方差分析结果表明, 面部表情序列主效应显著,(1, 55) = 7.64,0.001, partial η= 0.12; 面孔情绪层级的主效应显著,(5, 51) = 34.81,0.001, partial η= 0.40; 面部表情序列和面孔情绪层级的交互作用显著,(5, 51) = 4.67,0.001, partial η= 0.31。进一步简单效应分析发现, 在100%、80%和60%情绪层级上, 均表现出快乐面孔反应时显著快于恐惧面孔(100%层级:快乐面孔= 776.75 ms,= 32.49 vs. 恐惧面孔= 877.93 ms,= 30.75; 80%层级:快乐面孔= 779.05 ms,= 27.72 vs. 恐惧面孔= 891.98 ms,= 31.85; 60%层级:快乐面孔= 857.27 ms,= 36.09 vs. 恐惧面孔= 946.56 ms,= 41.92,s0.05), 在其他情绪层级上则差异不显著(s > 0.05)。

4 讨论

本研究探讨场景对面孔情绪探测的影响, 以及特质性焦虑的调节作用。实验中先后呈现场景和不同情绪强度的面部表情图片, 分析高、低特质性焦虑组在面孔情绪探测任务中的正确率。结果发现:对于不同情绪效价的面部表情, 场景对其情绪探测的影响存在差异:对于快乐面部表情, 在100%、80%和20%三个情绪层级上, 一致条件(即积极场景与快乐面部表情相继呈现)比不一致条件(即消极场景与快乐面部表情相继呈现)有着更高的情绪探测正确率; 对于恐惧面部表情, 除了100%和0%情绪层级外, 在80%、60%、40%和20%四个情绪层级上, 均有一致条件(即消极场景与恐惧面部表情相继呈现)比不一致条件(即快乐场景与恐惧面部表情相继呈现)有着更高的情绪探测正确率。特质性焦虑的个体因素在面孔情绪探测过程中起到调节作用:对于高特质焦虑组, 一致条件和不一致条件中的面孔情绪探测正确率并没有显著差异, 即高特质焦虑者并未表现出显著的场景效应; 而低特质焦虑组在探测正确率上则差异显著, 即出现显著的场景效应。

本研究发现场景信息影响个体对面孔情绪的探测。具体表现为, 场景与面孔情绪一致条件下个体对面孔情绪的探测正确率显著高于情绪不一致时的面孔情绪探测正确率。当场景的情绪信息与面部表情一致时, 场景促进了个体对面孔情绪的探测, 反之, 则起到阻碍作用, 即面部表情加工的场景效应。该结果与以往使用单一情绪强度的面部表情刺激图片, 探讨面部表情加工场景效应的研究相一致(e.g., Righart & de Gelder, 2008a, 2008b; Xu, Yang, Tan, & Zhang, 2017)。

本研究进一步发现, 针对不同情绪强度的面部表情, 场景对面孔情绪探测的影响存在差异。在面孔情绪强度较弱的20%情绪层级, 无论快乐还是恐惧, 场景对面孔情绪探测均存在显著影响。该研究结果与Lee等人(2012)的观点一致, 当面孔的面部构型信息不能够清晰表达情绪状态时, 个体更容易依据面孔所处的场景信息对面孔情绪进行判断。此外, 影响面孔表情识别的背景因素还包括身体姿态、语言文字信息, 以及声音、气味等跨通道信息(胡治国, 刘宏艳, 2015; 徐强等, 2014)。Aviezer, Trope和Todorov (2012)的研究发现, 当面孔与身体姿态同时呈现时, 对模糊的极端情绪状态的判断更多地依赖身体姿态而非面孔。一项以语言文字信息为背景的功能磁共振成像(fMRI)研究发现, 相比与积极语言线索匹配呈现, 当情绪意义模糊的惊奇面孔与消极语言线索匹配呈现时诱发杏仁核(amygdala)更强的活动(Kim et al., 2004)。本研究探讨场景对面孔情绪探测的影响, 同样发现个体对先前呈现场景信息的加工显著影响了低强度情绪面孔的探测。

另外, 个体对快乐和恐惧面孔情绪探测的场景效应表现不同。对于恐惧面部表情, 在40%和60%的情绪层级上, 面孔与场景情绪一致条件下(消极场景与恐惧面部表情相继呈现)的正确率显著高于不一致条件(积极场景与恐惧面部表情相继呈现)。这说明场景信息影响中等强度恐惧面部表情的识别, 即在先前呈现的消极场景启动条件下, 个体更容易察觉面孔中的恐惧情绪。Lim和Pessoa (2008)向被试呈现两种颜色的面孔, 在呈现其中一种颜色的面孔时对被试进行厌恶性电刺激。将面孔颜色与引起恐惧情绪的电刺激建立联系后, 要求被试对从中性到恐惧的渐变面部表情进行情绪探测。结果发现, 相比于没有伴随电击的面孔, 被试对将伴随电击中等强度水平(40%~60%)的恐惧面孔判断为“恐惧”的频率显著增加。该研究采用情绪学习的方法操控面孔颜色背景的情绪性经验, 而本研究采用更为直接和自然的场景图片刺激, 同样发现场景促进了个体对中等强度恐惧面部表情的识别。另外, 80%、100%层级的快乐面孔仍然存在显著的场景效应, 100%情绪层级的恐惧面孔上场景效应不显著。个体对于快乐和恐惧面孔情绪识别存在不同的加工方式, 有研究者认为在对面孔进行结构化编码过程中, 与恐惧情绪相关的突显刺激会被快速的提取(Adolphs, 2002; 张丹丹, 罗文波, 罗跃嘉, 2013)。也有研究者认为快乐面孔的构型更容易被识别, 个体对快乐面孔的探测反应时更短(Dodd et al., 2017)。Terasawa, Moriguchi, Tochizawa和Umeda (2014)的研究同样发现内感受性敏感的个体更容易识别快乐面部表情。本研究中, 不同面孔情绪探测中的场景效应存在差异, 说明面孔情绪识别的特异性与个体对场景信息的加工有关。

对于高、低特质性焦虑组的面孔情绪探测正确率分析发现, 特质性焦虑作为面孔观察者内部个体因素对场景效应起调节作用。具体表现为, 低特质性焦虑被试在面孔情绪探测中表现出显著的场景效应, 而在高特质性焦虑被试中则并未发现该场景效应。高特质性焦虑者在进行面孔情绪探测过程中较少受到场景信息的影响, 而更多关注面孔本身的情绪信息。有研究者认为, 高特质性焦虑个体对负性面部表情, 如恐惧面部表情, 存在加工上的偏向 (Walentowska & Wronka, 2012)。然而, 本研究所发现的高特质性焦虑者对伴随面孔呈现的场景背景信息的忽略不仅表现在恐惧面孔上, 也表现在快乐面孔上。以往有研究采用ERPs或fMRI技术探讨了外周信息对面孔情绪识别的影响, 如来自听觉、嗅觉、视觉的背景信息对面孔情绪识别的影响(de Groot, Smeets, Kaldewaij, Duijndam, & Semin, 2012; Li et al., 2015)。并且, Zhang, Li, Gold和Jiang (2010)发现, 在极短的刺激间隔中, 场景情绪与靶子词的情绪一致性效应同样会发生, 具体表现为情绪冲突条件下N400更大的波幅。此外, 面孔情绪的观察者内部存在的个体差异, 如年龄、文化背景、人格特质等, 同样会影响面孔情绪识别以及场景效应(Aviezer et al., 2017; Calder, Ewbank, & Passamonti, 2011; Noh & Isaacowitz, 2013)。例如与年轻人相比, 老年人在面孔情绪识别过程中更易受到场景信息的影响, 在面孔与场景情绪不一致时表现出更显著的场景效应(Noh & Isaacowitz, 2013)。本研究中, 低特质性焦虑组的被试存在显著的场景效应, 高特质性焦虑组则不显著, 同样表明面孔观察者内部个体因素, 如特质性焦虑程度, 影响了个体对面孔情绪的识别以及场景效应的表现。

此外, 本研究在实验过程中采用场景和面孔图片刺激相继呈现的方式探讨场景对面孔情绪探测的影响。由于场景刺激出现在面孔刺激之前, 个体对先前呈现的场景的加工会引发对后续呈现面孔刺激的期待, 从而影响面孔情绪的探测。因此, 本研究中场景对面孔情绪探测的影响体现的是场景与面孔继时性加工的结果。在一项ERP研究中, Hietanen和Astikainen (2013)同样使用场景和面孔刺激相继呈现的方式, 发现情绪性场景和面部表情的一致性效应, 即当场景和面部情绪一致时诱发更大的N170波幅。另外, 有研究者在实验过程中采用场景和面孔图片刺激同时呈现的方式, 即向被试呈现场景和面孔的整合刺激(Righart & de Gelder, 2006, 2008a, 2008b)。在该呈现方式中, 个体对场景与面孔信息的加工是并行的, 在这一过程中场景和面孔的心理表征是同时发生的, 因此, 该研究中场景对面部表情加工的影响体现的是场景与面孔并行加工的结果(Davenport, 2007; Demiral, Malcolm, & Henderson, 2012; Xu et al., 2015)。与同时呈现场景与情绪面孔的研究相似, 本研究结果发现, 在相继呈现场景和面孔的实验条件下同样存在场景对面部表情加工的影响, 且不同情绪强度的面孔具有不同表现。

尽管如此, 本研究还存在一些不足有待改进。(1)在本研究中, 我们使用从中性到快乐以及从中性到恐惧的渐变情绪面孔作为探测刺激, 不同情绪强度的面孔刺激以静态方式呈现, 难于考察场景对连续变化的面部表情加工的影响。因此, 在将来研究中, 有必要进一步动态呈现面孔刺激, 以期更加全面和生态化地考察场景对不同情绪强度的面部表情识别的影响以及特质性焦虑这一人格特质因素所发挥的作用。(2)本研究使用了不同情绪效价(积极和消极)的场景刺激, 探讨场景对快乐和恐惧面孔情绪探测的影响, 未来的研究有必要使用情绪意义分类更加明确的场景刺激, 以及恐惧面孔以外的其它负性面部表情作为实验材料, 更加全面地探讨场景情绪性信息对面部表情识别的影响。(3)本研究中选取的高低特质性焦虑被试在性别上存在一定的数量差异, 而性别差异是影响面部表情加工的因素之一, 后续的研究需要进一步平衡被试性别以期获得更加稳定的实验结果。另外, 还可以增加被试抑郁、恐惧等状态的评估, 进一步控制其它个体状态性因素的影响, 使结果更加完整、更具说服力。

5 结论

本研究得出以下结论:

(1)对于低情绪强度面部表情, 无论快乐还是恐惧, 在对面孔情绪探测过程中均更易受到场景影响, 即存在显著的场景效应。(2)场景更容易影响中等强度恐惧面孔的情绪探测, 但对中等强度快乐面孔的影响不显著。(3)特质性焦虑的个体因素在场景对面孔情绪探测的影响中起调节作用, 高特质性焦虑者较少受到场景情绪性信息的影响, 低特质性焦虑者则存在显著的场景效应。

Adolphs, R. (2002). Neural systems for recognizing emotion.(2), 169–177.

Aviezer, H., Ensenberg, N., & Hassin, R. R. (2017). The inherently contextualized nature of facial emotion perception.,, 47–55.

Aviezer, H., Trope, Y., & Todorov, A. (2012). Body cues, not facial expressions, discriminate between intense positive and negative emotions.(6111), 1225–1229.

Barrett, L. F., & Kensinger, E. A. (2010). Context is routinely encoded during emotion perception.(4), 595–599.

Bourne, V. J., & Vladeanu, M. (2011). Lateralisation for processing facial emotion and anxiety: Contrasting state, trait and social anxiety.,(5), 1343–1349.

Calder, A. J., Ewbank, M., & Passamonti, L. (2011). Personality influences the neural responses to viewing facial expressions of emotion.(1571), 1684–1701.

Damjanovic, L., Meyer, M., & Sepulveda, F. (2017). Raising the alarm: individual differences in the perceptual awareness of masked facial expressions., 1–10.

Davenport, J. L. (2007). Consistency effects between objects in scenes.(3), 393–401.

de Groot, J. H. B., Smeets, M. A. M., Kaldewaij, A., Duijndam, M. J. A., & Semin, G. R. (2012). Chemosignals communicate human emotions.(11), 1417–1424.

Demiral, Ş. B., Malcolm, G. L., & Henderson, J. M. (2012). ERP correlates of spatially incongruent object identification during scene viewing: Contextual expectancy versus simultaneous processing.(7), 1271–1285.

Dodd, H. F., Vogt, J., Turkileri, N., & Notebaert, L. (2017). Task relevance of emotional information affects anxiety-linked attention bias in visual search.,, 13–20.

Ekman, P. (1993). Facial expression and emotion.,(4), 384–392.

Fayolle, S. L., & Droit-Volet, S. (2014). Time perception and dynamics of facial expressions of emotions.,(5), e97944.

Hartley, C. A., & Phelps, E. A. (2012). Anxiety and decision-making.(2), 113–118.

Hassin, R. R., Aviezer, H., & Bentin, S. (2013). Inherently ambiguous: Facial expressions of emotions, in context.(1), 60–65.

Hietanen, J. K., & Astikainen, P. (2013). N170 response to facial expressions is modulated by the affective congruency between the emotional expression and preceding affective picture.,(2), 114–124.

Hu, Z. Q., & Liu, H. Y. (2015). Influence of emotional context on facial expression recognition and the underlying mechanism.(5), 1087–1094.

[胡治国, 刘宏艳. (2015). 情绪背景对面部表情识别的影响及其作用机制.,(5), 1087–1094.]

Kim, H., Somerville, L. H., Johnstone, T., Polis, S., Alexander, A. L., Shin, L. M., & Whalen, P. J. (2004). Contextual modulation of amygdala responsivity to surprised faces.(10), 1730–1745.

Lang, P. J., Bradley, M. M., & Cuthbert, B. N. (2008).: Gainesville, FL: The Center for Research in Psychophysiology, University of Florida.

Lee, T-H., Choi, J-S., & Cho, Y. S. (2012). Context modulation of facial emotion perception differed by individual difference.,(3), e32987.

Li, Y., Long, J., Huang, B., Yu, T., Wu, W., Liu, Y., Liang, C., Sun, P. (2015). Crossmodal integration enhances neural representation of task-relevant features in audiovisual face perception.(2), 384–395.

Lim, S-L., & Pessoa, L. (2008). Affective learning increases sensitivity to graded emotional faces.,(1), 96–103.

Liu, X., Hildebrandt, A., Recio, G., Sommer, W., Cai, X., & Wilhelm, O. (2017). Individual differences in the speed of facial emotion recognition show little specificity but are strongly related with general mental speed: Psychometric, neural and genetic evidence., 149

Longin, E., Rautureau, G., Perez-Diaz, F., Jouvent, R., & Dubal, F. (2013). Impact of fearful expression on danger processing: The influence of the level of trait anxiety.,(5), 652–657.

Noh, S. R., & Isaacowitz, D. M. (2013). Emotional faces in context: age differences in recognition accuracy and scanning patterns.(2), 238–249.

Palumbo, L., & Jellema, T. (2013). Beyond face value: Does involuntary emotional anticipation shape the perception of dynamic facial expressions?,(2), e56003.

Park, G., Vasey, M. W., Kim, G., Hu, D. D., & Thayer, J. F. (2016). Trait anxiety is associated with negative interpretations when resolving valence ambiguity of surprised faces., 1164.

Qiu, F. H., Luo, Y. J., & Jia, S. W. (2015). Categorical perception of facial expression and its individual differences.(6), 946–958.

[邱方晖, 罗跃嘉, 贾世伟. (2015). 面部表情的类别知觉及其个体差异.,(6), 946–958.]

Recio, G., Schacht, A., & Sommer, W. (2014). Recognizing dynamic facial expressions of emotion: Specificity and intensity effects in event-related brain potentials.,(1), 111–125.

Righart, R., & de Gelder, B. (2006). Context influences early perceptual analysis of faces—an electrophysiological study.(9), 1249–1257.

Righart, R., & de Gelder, B. (2008a). Rapid influence of emotional scenes on encoding of facial expressions: An ERP study.,(3), 270–278.

Righart, R., & de Gelder, B. (2008b). Recognition of facial expressions is influenced by emotional scene gist.,(3), 264–272.

Rigon, A., Voss, M. W., Turkstra, L. S., Mutlu, B., & Duff, M. C. (2016). Relationship between individual differences in functional connectivity and facial-emotion recognition abilities in adults with traumatic brain injury., 370–377.

Sadeh, N., & Bredemeier, K. (2011). Individual differences at high perceptual load: the relation between trait anxiety and selective attention.,(4), 747–755.

Spielberger, C. D. (1966). Theory and research on anxiety. In C. D. Spielberger (Ed.),. New York: Academic Press.

Spielberger, C. D., Gorsuch, R. L., Lushene, R., Vagg, P. R., & Jacobs, G. A. (1983).. Palo Alto, CA: Consulting Psychologists Press.

Terasawa, Y, Moriguchi, Y, Tochizawa, S, Umeda, S.(2014). Interoceptive sensitivity predicts sensitivity to the emotions of others.,(8), 1435–1448.

Tottenham, N., Tanaka, J. W., Leon, A. C., Mccarry, T., Nurse, M., & Hare, T. A., … Nelson, C. (2009). The NimStim set of facial expressions: judgments from untrained research participants.(3), 242–249.

Walentowska, W., & Wronka, E. (2012). Trait anxiety and involuntary processing of facial emotions.,(1), 27–36.

Xu, Q., Yang, Y., Tan, Q., & Zhang, L. (2017). Facial expressions in context: Electrophysiological correlates of the emotional congruency of facial expressions and background scenes., 2175.

Xu, Q., Yang, Y., Zhang, E., Qiao, F., Lin, W., & Liang, N. (2015). Emotional conflict in facial expression processing during scene viewing: An erp study.,, 138–146.

Xu, Q., Yang Y. P., Zhang, E. T., & Zhang, F. (2014). The influence of context on facial expression processing: Retrospect and prospect.(3), 252–262.

[徐强, 杨亚平, 张恩涛, 张锋. (2014). 背景因素影响面部表情加工的研究: 现状与展望.(3), 252–262.]

Zhang, D. D, Luo, W. B., & Luo, Y. J. (2013). Single-trial ERP evidence for the three-stage scheme of facial expression processing.(08), 643–656.

[张丹丹, 罗文波, 罗跃嘉. (2013). 面孔表情加工三阶段模型的单试次ERP证据.(8), 643–656.]

Zhang, Q., Li, X., Gold, B. T., & Jiang, Y. (2010). Neural correlates of cross-domain affective priming., 142–151.

Scene effects on facial expression detection: The moderating effects of trait anxiety

LI Wanyue; HAN Shangfeng; LIU Shen; YANG Yaping; ZHANG Lin; XU Qiang

(Department and Institute of Psychology, Ningbo University, Ningbo 315211, China)(School of Humanities and Social Sciences, University of Science and Technology of China, Hefei 230022, China)

Facial expressions are fundamental emotional stimuli. They convey important information in social interaction. Most previous studies focused on the processing of isolated facial expressions. However, in everyday life, faces always appear within complex scenes. The emotional meaning of the scenes plays an important role in judging facial expressions. Additionally, facial expressions change constantly from appearance to disappearance. Visual scenes may have different effects on the processing of faces with different emotional intensities. Individual personality traits, such as trait anxiety, also affect the processing of facial expressions. For example, individuals with high trait anxiety have processing bias on negative emotional faces. The present study explored whether previously presented visual scenes affected the identification of emotions in morphed facial expressions, and whether the influences of visual scenes on the identification of facial expressions showed differences between individuals with high and low trait anxiety.

Using the Spielberger State-Trait Anxiety Inventory (STAI), we placed 29 participants who scored in the top 27% in the high trait anxiety group (9 men and 20 women; mean age 19.76 ± 1.3 years) and 28 participants who scored in the bottom 27% in the low trait anxiety group (11 males and 17 females, mean age 19.71 ± 1.2 years). The images of faces (4 models, half male and half female) used in this study were selected from the NimStim Set of Facial Expressions. The face stimuli showed typical happy, neutral, and fearful expressions. Facial expressions were morphed to create a series of graduallyvaried images of facial expressions. Specifically, fearful face (100%) versus neutral face (0%) and happy face (100%) versus neutral face (0%) were morphed in 20% increments. In addition, 40 surrounding scene images were used, with 20 positive scenes and 20 negative scenes. In the face-emotion detection task, participants were asked to determine whether the emotion from the faces presented after the scenes were fearful, happy, or neutral.

For the repeated measure ANOVA of the accuracy for facial expression detection, the results showed scene effects on the identification of emotions in facial expressions. The scene effects were varied between the different intensity of face emotion: for the emotionally vague faces, the detection of happy and fearful expression showed significant scene effects; for the faces with moderate emotional intensity, only the detection of the fearful faces showed significant scene effects; for the intense emotions on faces, there was a significant effect on happy and neutral faces but not on fearful faces. Trait anxiety as an individual factor was found to play a moderating role in the identification of facial expressions. For the high trait anxiety group, there were no significant differences in the accuracy of emotional detection between congruent and incongruent conditions. This means that the high trait anxiety group did not show significant scene effects. The low trait anxiety group showed a significant difference in the accuracy of identification of emotions in facial expressions between congruent and incongruent conditions, i.e., significant scene effects.

In summary, the present study demonstrated that, for facial expressions with low emotional intensity, the identification of happy and fearful faces was more likely to be affected by visual scenes than the identification of neutral faces. Visual scenes were more likely to affect the identification of moderately fearful faces than moderately happy faces. Trait anxiety played a moderating role in the influence of visual scenes on emotional detection of facial expressions. Specifically, individuals with high trait anxiety were less affected by surrounding visual scenes and paid more attention to facial expressions.

visual scenes; facial expressions; trait anxiety; scene effects; moderating effects

2018-01-27

* 国家教育部人文社会科学研究项目/青年基金项目(18YJC190027, 15YJC190024)、国家自然科学基金(31540024, 71874170)、国家社会科学基金(12BSH055)、浙江省教育科学规划课题(2018SCG098)资助。

李婉悦和韩尚锋同为第一作者。

徐强, E-mail: xuqiang1117@163.com; 张林, E-mail: zhanglin1@nbu.edu.cn

B842