基于兴趣点统计特征的双人交互行为预测算法

姬晓飞,谢 旋

(沈阳航空航天大学 自动化学院,辽宁 沈阳 110136)

1 概 述

基于视频的双人交互行为识别与理解是图像处理与计算机视觉领域中备受关注的前沿方向,它利用视频分析技术从包含人的图像序列或视频中检测、跟踪、识别人体及动作对象,并对其行为进行理解和描述[1-3]。目前大部分研究关注的都是对发生行为的事后检测,而在很多现实场景中,需要系统能够对正在执行的、未完成的行为进行提早的预测。人类动作预测与动作分类不同,动作预测系统需要在动作执行过程中做出“哪些动作行为发生”的决定。双人交互行为预测具有重大的现实意义,如:在两个人的打架行为恶化之前对其进行检测,将使视频监控系统具有阻止犯罪行为发生的能力,使视频资源发挥更大的作用。

Ryoo[1]率先提出动态BoW(bag of word)的概率统计方法解决双人交互行为的预测问题,采用时空特征的整体直方图形式对动作进行表示,而后有效的建模特征随时间变化的分布情况实现动作预测。该方法不仅简单易行,并且提供了双人交互行为预测基本框架。在此基础上,Yu等[4]提出了一种时空隐式形状模型(spatial-temporal implicit shape model,STISM)表示局部时空特征的时空结构,并采用多类平衡的随机森林方法匹配实现双人交互行为预测。Li等[5]通过监测运动速度,将长时间活动分解编码成有意义的行动单元序列,然后引入概率后缀树(probabilistic suffix tree,PST)表示动作单元之间的马尔可夫依赖关系;最后利用预测累积函数(predictive accumulative function,PAF)描述各种活动的可预测性。以上均是采用传统的概率模型统计的方法,识别与预测的准确率均不是很高。近些年,基于卷积神经网络(convolutional neural network,CNN)的方法开始被应用到双人交互行为预测领域。Ke等[6]从部分序列的连续视频帧计算光流图像,以分别捕获每个RGB帧和每个光流图像对全局和局部上下文的依赖性,然后利用长时短期记忆(long short term memory,LSTM)网络学习包括空间和时间信息的结构模型,最后引入排名分数融合方法预测交互类别。但是最佳权重的选择具有随机性。Ke等[7]将CNN应用于视频流编码图像以学习人类交互预测的时间信息,利用几个连续的光流图像的特征来学习随时间变化的规律。但是这种方法只利用了时间特征,缺乏人体姿态的空间特征信息描述,并且需要学习大量的样本,计算复杂度相对较高。

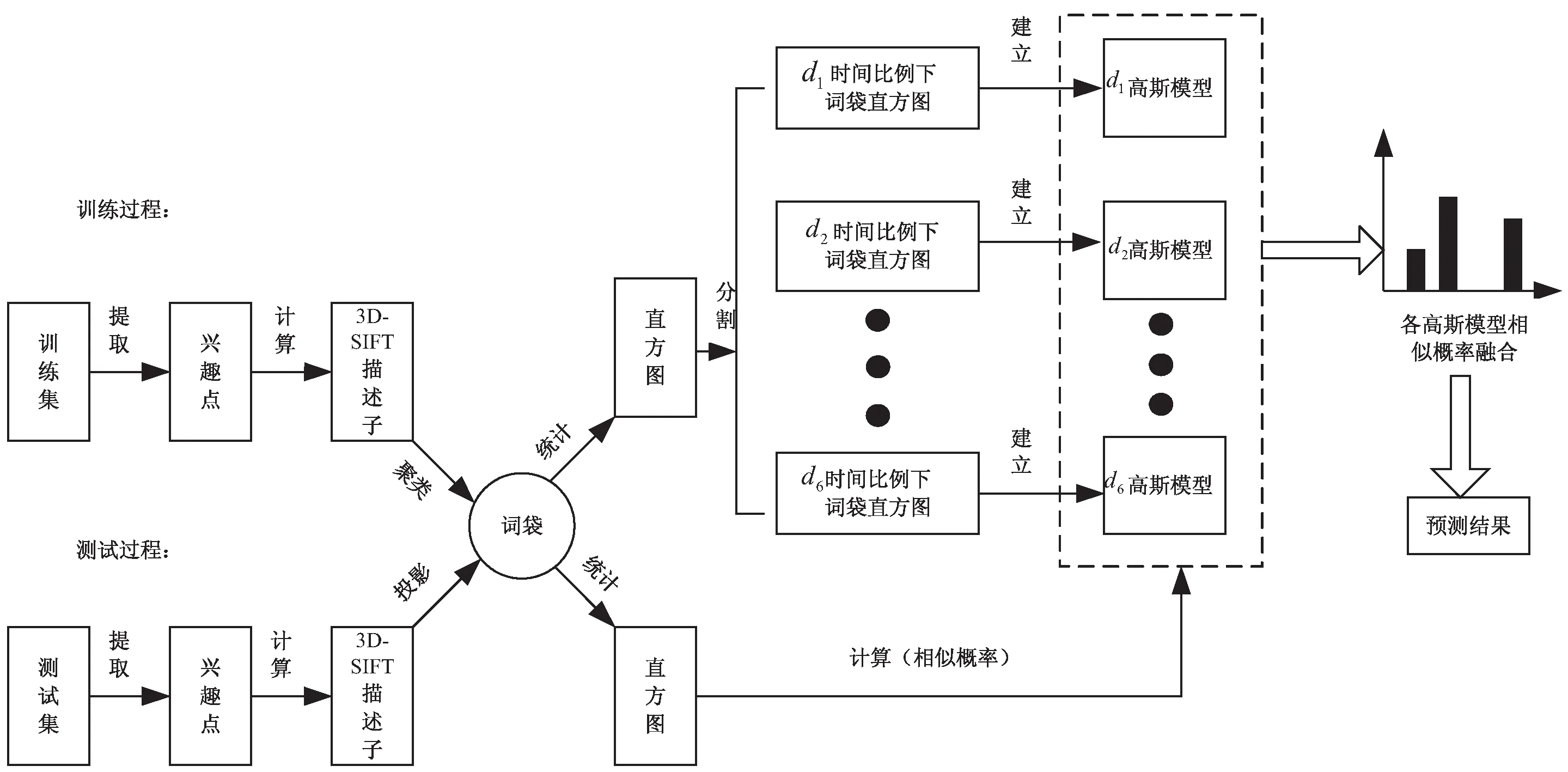

基于以上分析,文献[1]提出的方法简单有效,且可实现性强,其不足之处是实现双人交互行为预测与识别一体化效果不理想,预测与识别准确率较低。文中在文献[1]的基础上,提出了词袋模型与多时间比例动作模型概率融合的方法,以实现双人交互行为预测与识别一体化。文中算法的具体流程见图1。

图1 算法流程

首先,训练集视频进行兴趣点提取和3D-SIFT特征描述[8];然后将训练数据分割成不同时间比例数据,并用词袋方法得到在不同时间比例下的视频直方图表示;最后,利用高斯模型建立各不同时间比例数据下的动作模型。当给定未知长度测试视频,进行特征描述后形成一个词袋直方图表示,计算其与训练好的不同时间比例下各高斯模型的相似概率,判别测试视频所属动作类别。通过大量实验验证,该方法在保证一定预测准确率的同时,也得到了较好的识别效果。

2 兴趣点特征提取与描述

局部特征具有可以描述具有显著变化运动信息的优点[9],兴趣点是目前比较常用的一种局部特征[10],因此文中采用其作为基础特征。通过对兴趣点的邻域进行有效描述,能够得到代表此图像序列的局部信息特征[11]。3D-SIFT描述算子是一种三维时空梯度方向直方图,能准确地捕捉到视频数据的时空特性的本质[12]。为了充分利用上下文的运动信息,文中对整个视频采集兴趣点,然后进行3D-SIFT特征描述,即:在兴趣点邻域内建立3D球形体积块,在每个体积块里进行梯度累积。

3 动作预测模型的建立

兴趣点特征与词袋模型[13]相结合可以方便地得到动作视频的词袋直方图表示。通常采用k-means方法对训练数据的所有局部特征表示进行聚类形成词典,然后将一个动作视频的所有局部特征向词典投影,最终统计词典中视觉单词在视频中出现的频率,形成动作视频的统计直方图表示。该方法已广泛用于人体动作识别。为了将此框架运用于双人交互行为预测,将训练视频按照一定比例分割成不同时间长度的子训练集,即将兴趣点3D-SIFT描述的训练数据,按照不同时间比例分割成不同时间长度的子训练数据,每个子训练数据用一个词袋直方图表示。令Ol表示动作视频,di表示其时间比例,hdi(Ol)表示di时间比例下Ol的子训练数据直方图。vw表示第w个视觉单词,则每一个特征直方图hdi(Ol)的第w个词袋的值为:

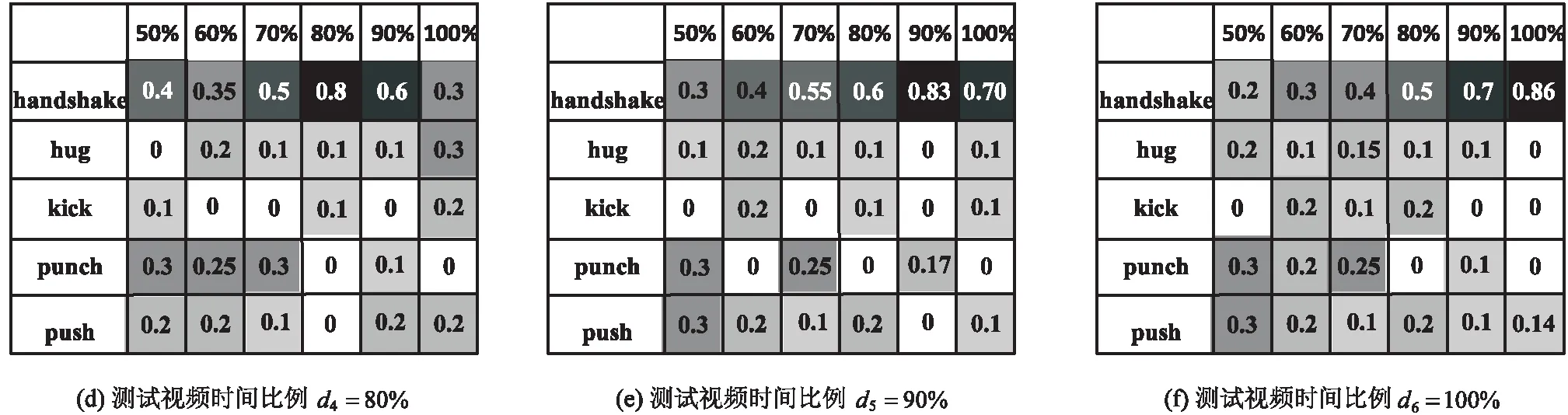

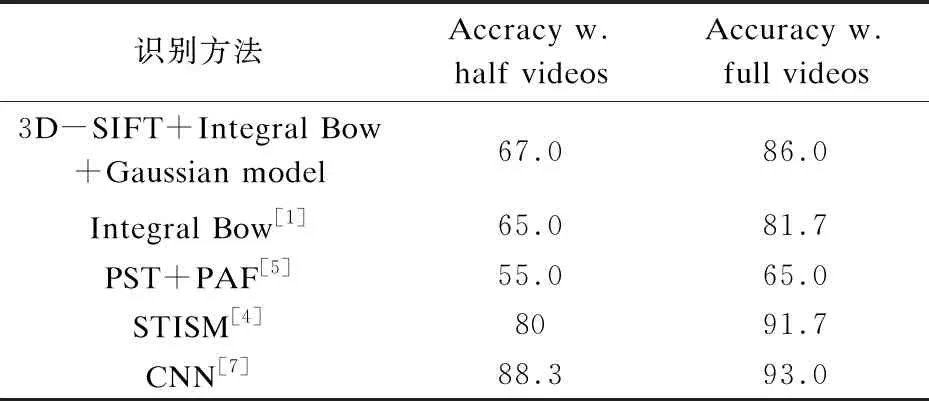

hdi(Ol)[w]=|{f|f∈vw∧tf (1) 其中,f表示视频Ol提取的特征;tf表示其时间位置。 每一个hdi(Ol)描述了时间比例为di的时空特征直方图随时间变化的分布情况,示例如图2所示。 图2 握手动作整体直方图变化趋势 经大量实验数据发现,同类别动作视频在相同时间比例下的词袋直方图符合一定参数下的高斯分布。因此可以采用高斯模型建立不同时间比例下同类别动作模型,该模型可以较好地反映某种动作执行到某个时间节点时,其词袋直方图的表现形式。 文中将训练视频按不同时间比例d1,d2,…,d6分割,并对分割后的训练视频分别建立高斯模型。记h(1,d),h(2,d),…,h(A,d)分别为当前时间比例为d的第A类动作的高斯模型,当给定一未知动作视频Otest时,计算Otest与当前时间比例d下各个动作高斯模型的似然概率,即:p(Otest|h(1,d)),p(Otest|h(2,d)),…,p(Otest|h(A,d))。 (2) 其中,d为训练视频的当前时间比例;A为d时间比例下动作模型类别数;h(a,d)为动作a的直方图对应的高斯模型;h(Otest)为未知动作视频Otest的直方图高斯模型;σ2描述的是动作a在时间比例d下高斯模型的相同变量。 给定一时间长度为t的测试视频Otest(t未知),计算Otest与各类动作在不同时间比例下高斯模型的相似概率,依据概率值大小判别测试视频与训练集中各类动作的相似程度。最终将未知动作判别为与其相似度最高的动作模型所属类别。即: (3) 其中,d为当前视频的时间比例;a为d时间比例下当前动作模型类别。 文中采用词袋模型与多时间比例高斯模型相结合的预测方法,原理上,这种方法可以对未知双人交互行为动作进行基本的预测。本次实验采用的数据库来自于UT-interaction数据库[14],该数据库广泛用于双人交互行为识别与预测算法研究中。实验在主频为2.40 GHz,内存2 GB,32位win7操作系统下Matlab 2014a软件平台上完成。实验中采用留一交叉验证对数据库进行测试,聚类觉单词k=800,d1,d2,…,d6分别为50%,60%,70%,80%,90%,100%。由于双人交互行为预测需要丰富的行为信息,所以数据库中除去“指”动作,如图3所示。 图3 UT-interaction数据库图例 在本次实验中,利用UT-interaction数据库对词袋结合多时间比例高斯模型的方法进行了测试。以handshake测试视频为例,示例如图4所示。 由图4的实验结果可以看出,随着测试视频时间比例的逐渐增大,同类别动作相似概率值逐渐增大,进一步验证提出的方法可以实现双人交互行为预测与识别一体化。通过对大量不同时间比例的测试视频实验,得到的实验预测结果如表1所示。 图4 handshake测试视频在不同时间比例下相似概率混淆矩阵 表1 不同时间比例测试视频最终预测结果 表2给出了近年来在公开数据库中进行双人交互行为预测与识别结果,将文中提出的方法与其他作比较。结果表明,采用的方法预测与识别率均高于文献[1]和文献[5],虽然文献[4]和文献[7]预测与识别率较高,但是算法复杂度很高并且需要大量学习样本。而提出的词袋与多时间比例模型结合的方法并不需要建立复杂的预测模型,处理速度可达到15 fps,且预测与识别准确率较高。 表2 不同方法的识别结果 % 提出的基于兴趣点统计特征的方法,实现了对不同交互行为动作的预测。从特征描述与多时间比例模型概率预测的角度出发,采用词袋与高斯模型相结合的方法,很好地处理了对于未知时间长度的未知动作的预测和识别问题。该方法实现简单,满足实时性要求,具有较好的应用背景。但是,对于具有相似动作区间的动作预测存在一定的误差。因此,下一步的研究重点将放在预测模型优化上,以提高双人交互行为的预测率。

4 概率预测策略

5 实验结果与分析

5.1 数据库

5.2 概率预测结果

5.3 不同预测方法比较

6 结束语

——为小提琴与钢琴而作