绿色空调技术在数据中心里的运用

崔剑锋, 芦 岩, 刘 亮, 宋 宁

(中国建筑科学研究院, 北京 100013)

依据《北京市公共机构绿色数据中心评价标准(征求意见稿)》的定义,数据中心是主要用于电子信息处理、存储、交换和传输设备的安装和运行的建筑空间,包括服务器机房、网络机房、存储机房等功能区域。

1 数据中心的RAS指标

数据中心近年来在我国的发展和建设相当迅速,全国各地建成的不同规模和不同等级的数据机房也不计其数。数据中心的建设对于RAS要求非常高——可靠性(Reliability)、可用性(Availability)和可服务性(Serviceability)。由于IT设备空调制冷系统造成的宕机,会引起服务的局部瘫痪和中断。国外某调研机构曾有一组数字说明不同行业关键业务中断带来的金钱损失:大型数据中心的服务器宕机1 min,平均会使运输业损失15万美元,银行业损失27万美元,通信业损失35万美元,制造业损失42万美元,证券业损失45万美元……这直接从经济效益的角度解释了稳定性和可靠性对数据中心多么的重要。数据中心为了达到RAS的高标准,配备的很多设备和线路(包括空调系统)都设计有冗余,而这不仅带来投资、占地的加大,也造成了技术实施、运行管理的复杂性。

2 数据中心的能效指标

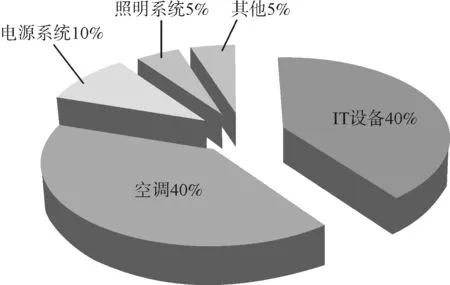

数据中心能耗的一般构成如图1所示。实际由于项目的不同,图中各项能耗的分配占比也对应有所变化。

图1 数据中心能耗构成示意

为引导和规范全球IT行业的节能,国际组织(Green Grid)提出PUE(Power Usage Effectiveness)和DCiE(Date Center Efficiency)能效指标。

PUE反映的是机房的总体能源使用效率,即:为满足IT设备的供电要求,机房的总供电率,PUE值越小越好,PUE的最小值趋近1;而DCiE反映的是机房IT设备占机房总能耗的比率,即IT设备的能耗占机房总能耗的比例,DCiE值越大越好,DCiE的最大值趋近1。依据PUE的能效指标来衡量,目前中国在网运行的大部分机房,其PUE值在2~3之间。根据最新的产品技术水平和机房设计水平,PUE值能提高至1.6~1.8的水平,而Google则在试验PUE为1.2的机房。

2.1 能耗分析

目前,数据中心能耗考察指标PUE的概念已深入人心,但是如何根据项目本身特点,有效降低PUE,不同的数据中心项目的建设措施却是各有千秋。众所周知,数据中心PUE降低的关键在于空调能耗的降低,而如何经济有效地降低其能耗,研究和推广数据中心的绿色空调技术就显得十分重要。

数据中心空调的特点:由于数据中心的发热量很大,且要求在特定一个允许的温湿度范围内长期连续运行,因此能适合其使用的空调系统要求可靠性高(一般设计都有N+1或N+2的冗余备机)、制冷量大、小温差和大风量。

一般说来,大型数据中心的IT负荷从开始到满载也需要较长的时间(可能好几年)。由于受到室外全年气温变化的影响,以及IT负载的能耗和网络访问量或运行状态相关。比如,游戏服务器在早上的负载和能耗都比较低,但在晚上就比较高;视频服务器在遇到重大事件时的负载和能耗就比较高(表1)。数据中心虚拟化的发展,使得数据中心IT设备在不同时间和不同空间上的运行发热量都是变化的,因此数据中心的空调设计和运营,必须与之相适应。

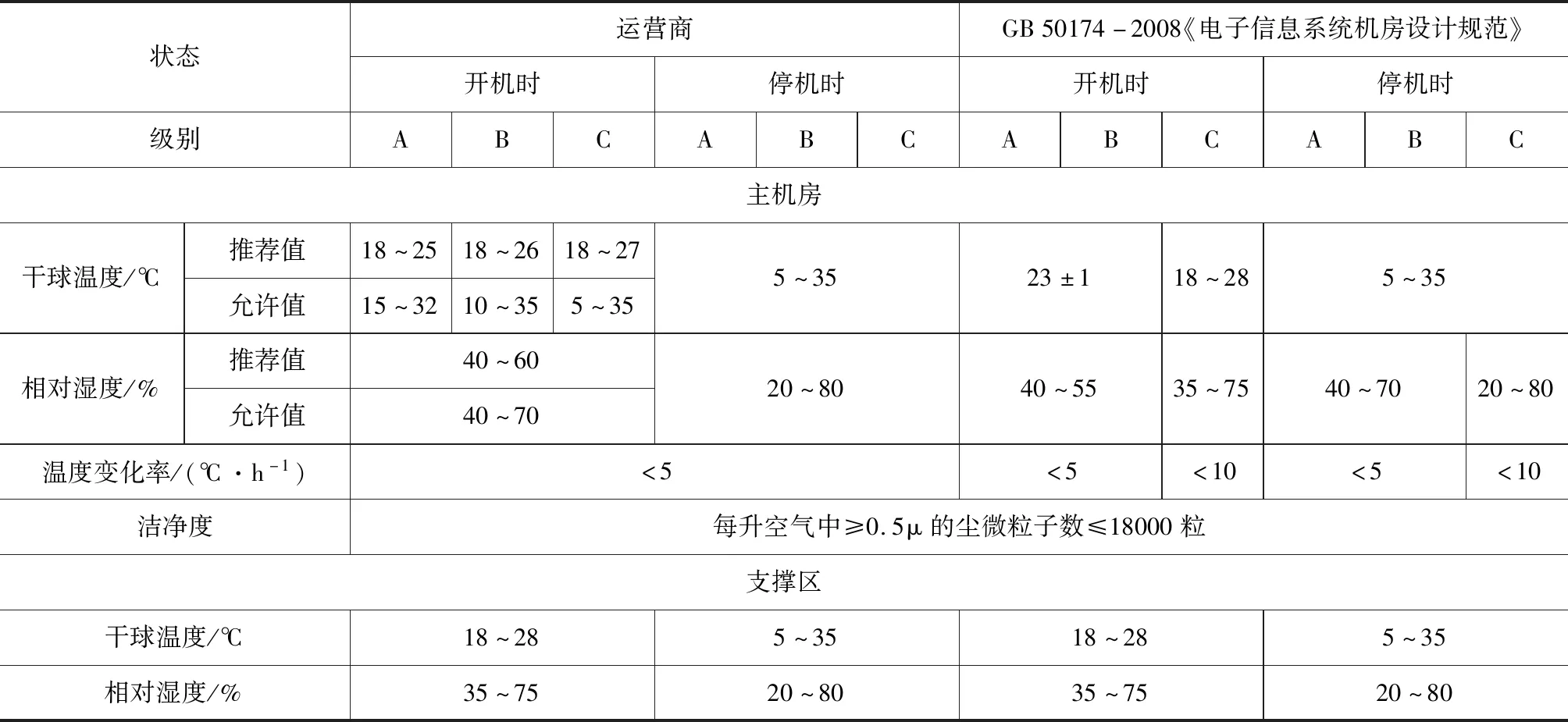

根据中华人民共和国国家标准GB 50174-2008《电子信息系统机房设计规范》,A类和B类机房的主机房温度要求保持在23±1 ℃,也就是22~24 ℃之间(设计标准目前正在修编之中)。ANSI/TIA-942-2005《Telecommunications Infrastructure Standard for Data Centers》中规定冷通道温度为华氏68~77 °F,也就是20~25 ℃之间。美国采暖制冷与空调工程师学会(ASHRAE)2008年新的机房冷通道温度,已经从2004年的20~25 ℃提高到2011版本的18~27 ℃,同时对室内相对湿度的要求,也放宽到露点温度5.5~15 ℃。从而大幅减少了机房内因需要严格控制温湿度范围,而在制冷、加热、除湿、加湿空调处理过程中带来的额外能耗。

表1 数据中心主要功能房间温、湿度设计参数

“恒温恒湿”是许多人以前对数据中心空调认识的一个误区,从表1可以看出,其实数据中心内的环境温、湿度并非很严苛的精度控制要求。这将会带来数据中心建筑热工设计以及空调设计观念上的重要变化。例如气候温和地区的主机房不一定非得设置在数据中心建筑的内区;在考虑到围护结构内表面的“防结露”措施后,不要过多地加厚机房区外墙的绝热层。尽量利用温、湿度独立分控的方式调节IT设备区域的温湿度,提高冷却水温去除机房内IT等设备散发的大量显热,仅对维持室内正压洁净及人员卫生需求的新风,施之以必要的温湿度处理,从而极大地降低了传统冷机为获取低温而采取较低蒸发制冷温度(7~12 ℃)除湿带来的制冷设备高能耗,以及为了维持室内相对湿度再进行加湿处理(通常使用电极或电热式)额外的高能耗。

另外,数据中心里空气处理的洁净度,对于机房内的IT设备正常使用也是至关重要。利用“风侧免费制冷”是有严苛条件的,它不仅要求室外空气温度低,而且要求湿度适宜、洁净度必须很高。数据中心的空调系统通常仅设置初效和中效两级过滤,当周边空气中带有粉尘、硫化物、酸碱性物质的低品质空气直接进入数据中心,将腐蚀IT设备,甚至带来设备短路。如果要对这样的空气进行过滤、干燥、净化灯处理,又将大大增加空调系统的处理能耗,与利用“水侧免费制冷”相比,反而会得不偿失。

2.2 空调冷源系统形式

数据中心的常规空调冷源系统形式主要有:

(1)风冷型机房空调。较适用于中、小型数据中心,以及严寒或寒冷地区或者缺水地区。

(2)水冷型机房空调。较适用于非严寒或寒冷地区的大、中型数据中心,但不大适合缺水地区。

(3)风冷/水冷的双冷源型精密空调。结合了水冷制冷效率高以及风冷无需担心结冻的风险,增强了地域的适应性,但也相应增加了设备投资及运行费用。

(4)下送风上回风的IT机房空调气流组织形式;精密空调常规的送风方式有多种,典型的气流组织包括“下送风上回风”和“上送风下回风”。下送风上回风的方式有几方面明显的优势:下送风方式,可将强、弱电线缆在机架上方分层铺设,地板下不走线,仅作通风用途,既保障了机房防火的安全,又保障了冷风远程传送的顺畅;上送风下回风的气流组织不适用于高发热量IDC,相比之下制冷效率较低下。

(5)水冷机房空调主机结合开放式冷却塔与板式换热器在过渡季节及冬季供冷。

(6)闭式冷却塔供冷(严寒、寒冷地区循环接至采用防冻液)的机房空调系统。

后面两种实际是较常见的,利用 “水侧免费制冷”的一种方式(冷源系统仅循环水泵耗电)。当室外空气湿球温度在4 ℃以下时可以满足完全自然冷却(此时无需额外启动制冷设备高耗能的压缩机),在湿球温度4~10 ℃之间可是实现部分自然冷却。在北京,一年内平均有5个月左右可以实现完全自然冷却,有2个月左右可以实现部分自然冷却,节能效果会非常明显的。

3 绿色空调技术

低碳、绿色是数据中心建设的发展潮流。所谓的绿色数据中心,则是指在全寿命周期内,最大限度地节约资源(节能、节地、节材)、减少温室气体排放,提供适用和高效的信息技术服务,与自然和谐共生的数据中心。在机房建设中引入绿色IT理念,以建设绿色节能机房为目标,将低碳经济、节能减排理念引入新机房的建设,促进降低能源消耗水平,减少二氧化碳等温室气体的排放。

该评价标准的控制项对于绿色数据中心PUE的考察指标为:大型数据中心PUE值不高于1.8。中小型数据中心PUE值不高于2.0。制定的目标适中,其实达到该要求并不难,但如果追求真正极致的数据中心“绿色空调技术”,还是十分不容易的。

评价标准对于数据中心的空调制冷系统达到绿色目标的重点规划如下。

3.1 一般项

(1)能耗采集方式为自动采集,PUE值根据采集电量测算,定期统计、计算分析PUE等指标。

(2)数据中心规划以“重点冷却IT设备”为原则。

(3)未出现局部过冷或过热现象。

(4)采用自然冷却技术。

(5)室内外温差超过10 ℃时,自然冷却空调机组能效比(EER)应不小于8.0。

(6)定期统计、计算分析PUE等指标。

(7)将数据中心绿色节能纳入本单位考核指标。

3.2 优选项

(1)制冷设备采用智能控制管理技术,应通过空调机组群控软件,实现对空调系统的节能控制,根据每列机架的实时散热量,动态调节空调的制冷量。

(2)采用机柜级冷却设计。

(3)对自身产生的热量进行再利用。

(4)向业界公开绿色节能最佳实践,促进节能技术的推广。

3.3 绿色空调技术

(1)采用具备过渡季节和冬季自然冷却功能的风冷空调机组;该类型空调机组比较适合位于我国严寒或寒冷地区数据中心,同时需要考虑到冬季防冻的问题。

(2)间接蒸发冷却且具备自然冷却功能的水冷型空调机组;该类型空调机组比较适合位于我国气候比较干燥的西北地区,或者室外年平均相对湿度不太高的“夏热冬冷”地区的数据中心,位于寒冷或严寒地区不常见,其蒸发循环水是特制的防冻液。

(3)完善气流组织,为了能达到满意的制冷效果,一方面需要根据机架的出风开口面积与风量需求设定合适的出风压力(即气流的静压流速);另外也需要根据机架的不同功率密度情况设置相应的约束气流措施:低功率密度(P≤4 kW):可单纯采用下送风方式,此方式下要求机架前方有效出风口面积不小于机架截面的20 %(约0.12 m2),当功率大于中功率密度(4 kW≤P≤8 kW)时且机架进风面积无法满足时,可以在机架顶安装风量和风压相当的风机,以形成有效的约束气流和满足热交换条件。

封闭冷、热通道的下送上回空调系统,优先提高IT设备的冷却效率,避免机房内冷热气流掺混,影响机柜高区的散热以及机房空调的制冷效率,减少机房无谓的冷损失;通常机房空调设备正面与每排IT设备垂直布置,与热流通道对齐,会使得空调送、回风的流动路径最短,减少空调送风机的能耗。

(4)热管空调:热管是利用温差、工质相变、重力与吸附原理的高效传热技术产品,其空调制冷高效且安全可靠,通常有分布式与顶置式系统。集装箱数据中心和高功率密度的IT柜背板有强制对流换热(水、液态氟利昂或CO2),通过高效的热管冷凝器交换热量后,再通过冷媒系统进入室外的中、高温冷水机组或者风冷机组制冷,并可以利用室外的“风侧免费制冷”。

冷媒相变的温度设计通常为12~18 ℃,已经高于该处空气的露点温度,完全不会除湿,也就不需要加湿。冷却末端直接靠近热源,避免了中、高热密度机柜出现局部的热点而宕机。

(5)冷机压缩机变容量控制、送风的风量或风压智能控制、夜间制冷等。

(6)为了避免临时停电带来的制冷系统全面停止工作,在利用UPS以及柴油发电机对必要空调设备供电的情况下,采用蓄冷(水蓄冷较多)设施,保证不低于20 min的空调供冷时间,满足数据中心IT设备在临时停电期正常工作的需要。

(7)利用机房空调系统的持续排热,为数据中心相邻的办公等辅助用房进行采暖或空调供热,提供能源利用率。

(8)LPG/NPG在气化过程中的大量释冷,用来冷却数据中心设备的发热,而气化后的LPG/NPG,可以在CCHP“冷热电三联”供循环中为数据中心提供持续可靠的电力以及冷却所需的补充冷量,使得备用性更高。

(9)太阳能、风能、水力发电等可再生能源,直接供应到数据中心。

(10)风墙(FAN WALL):将外部的冷空气输送入数据中心,无需经过常规的、最大消耗电能的空调制冷环节,带走热量,这就要求自然冷却的出入通风口要设计合理。让冷空气能够经过散热的设备,并将热量送向出风口。由于进入的冷空气温度时高时低,避免温度的变化对运行的设备造成影响,空调系统还是要做调节,进行辅助调温,空调系统可以处于半工作状态,也能达到部分节能,让数据中心内部的温度在2 ℃以内波动,这样对数据中心设备的影响最小。空调系统时时启到数据中心内部环境的监控作用。

(11)降低IT设备的能耗,采用智能布线系统以减少空调能耗。绿色机房的布线应该更多的考虑采用光纤布线而不是铜缆,因为环保光线在传输距离和功耗上都优于铜缆。对布线系统各个方面的节约,降低整个IT设备的消耗和排放。而盲板是安装在机柜内用于阻隔机柜中的空闲空间,起到美观与分隔机柜内冷、热空气的作用,盲板的安装同样能降低机房的制冷能耗。

3.4 科学运营维护,节约能源

(1)因为系统运行要求的连续性,冷冻水的进水和回水管道都要设计成环路,大型数据中心可能设计成二级或三级环路,这样在局部冷冻水管道或阀门发生故障时可以关闭相邻的阀门进行在线维护和维修。为了便于日后的维护、维修、更换和扩展,需要安装设计相当多的阀门。冷冻水管和冷 却水管不允许经过机房区域。在水管经过的区域需要设置下水道和漏水报警设备。为了节能和防止冷凝水,冷冻水管和冷却水管都要采取严格的保温措施。

(2)大型数据中心通过运营维护可以大大提高空调系统的节能效率。常用的运营维护措施包括以下方面:人走关灯和关闭大屏幕显示器,减少照明产生的能耗以及相应增加的制冷量。尽量减少运行新风系统。在机房无人时关闭相应区域的新风系统。建议冷通道的温度不低于25 ℃。定期检查冷通道的温度以免过度制冷造成能源浪费。定期检查地板,防止各种方式的漏风。 冷通道必须完全封闭,机柜上没有设备的区域必须安装盲板,没有负荷的机柜区域不能安装通风地板。每次设备变更,都要进行检查。

(3)在能够满足制冷的条件下尽可能提高空调冷水的温度,最高为12~18 ℃。在气象环境满足的条件下,尽量使用全自然或半自然的免费制冷。

(4)定期核对数字采集数据和模拟显示仪表的数据是否一致,若发现数据存在误差,立即更换有关采集设备或仪表。

(5)对于还没有使用的独立机房区域,关闭所有机电设备,包括冷冻水管道的阀门。

(6)定期检修和清洗冷冻机组内的铜管和冷却塔,确保其工作在最佳状态。

(7)对于低负荷的机房,如果精密空调没有EC风机,就要关闭相应的空调,如果是EC风机,要通过实践摸索出更节能空调运行方式。

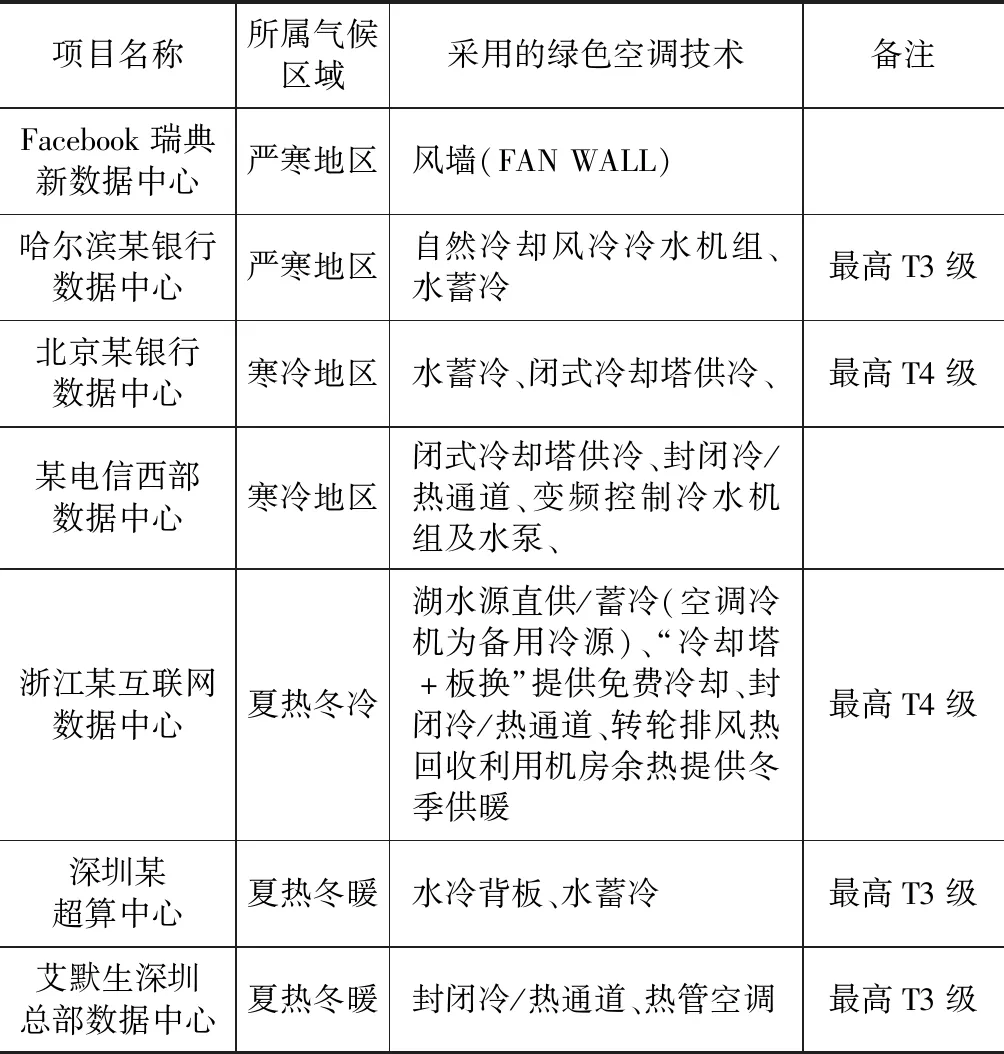

表2是国内、外某些PUE较低的知名数据中心,采取的绿色空调技术。

表2 国内外表某些知名数据中心空调技术一览表