多特征融合的尺度自适应KCF人脸跟踪

刘康 赖惠成

摘 要: 针对传统核相关滤波(KCF)跟踪算法在人脸跟踪中无法处理尺度变化、严重遮挡等问题,提出一种多特征融合的尺度自适应KCF人脸跟踪算法。该算法先对肤色与HOG特征进行融合来表征人脸,通过多通道相关滤波器定位人脸位置;学习一个一维的尺度滤波器来估计人脸的最优尺度;采用线性插值的方式对滤波器系数和人脸外观模型进行更新。实验结果表明,改进后的算法能明显提高跟踪的性能。通过定量与定性分析该算法对尺度变化、严重遮挡等问题有很好的鲁棒性,跟踪速度在36.7 f/s时达到实时应用的要求,优于近几年一些优秀的跟踪算法。

关键词: 核相关滤波; 多特征融合; 尺度自适应; 线性插值; 模型更新; 人脸跟踪

中图分类号: TN820.4?34; TP391.41 文献标识码: A 文章编号: 1004?373X(2019)10?0182?05

A scale adaptive KCF human face tracking algorithm based on multi?feature fusion

LIU Kang, LAI Huicheng

(College of Information Science and Engineering, Xinjiang University, Urumqi 830046, China)

Abstract: Since the traditional kernel correlation filtering (KCF) tracking algorithm cannot handle the problems of scale variation and heavy occlusion during human face tracking, a scale adaptive KCF face tracking algorithm based on multi?feature fusion is proposed. In the algorithm, the human face is represented by fusing the skin color with HOG features. The human face position is located by using the multi?channel correlation filter. The optimal scale of human face is estimated by learning a one?dimensional scale filter. The linear interpolation mode is adopted to update the filter coefficient and facial appearance model. The experimental results show that the improved algorithm can significantly improve tracking performance, has good robustness for problems of scale variation and heavy occlusion by means of quantitative and qualitative analysis, and can meet the real?time application requirement at the tracking speed of 36.7 f/s, which is superior to some excellent tracking algorithms in recent years.

Keywords: kernel correlation filtering; multi?feature fusion; scale adaptive; linear interpolation; model update; human face tracking

0 引 言

人臉跟踪是计算机视觉中一个经典问题,其应用在很多重要领域,如视频跟踪、人机交互及表情识别等[1]。虽然近些年人脸跟踪取得了很大的进步,但多数跟踪算法还是很容易受光照、遮挡、尺度变化等方面的影响从而导致性能的退化,因此实现精确的人脸跟踪仍然很具挑战性。

跟踪算法根据外观模型可以分为两种:生成式模型[2]与判别式模型[3]。生成式模型通过在线学习建立人脸模型,使用模型搜索重建误差最小的区域来完成定位。判别式模型将人脸跟踪任务看作一个二值分类问题来处理,通过提取背景与人脸信息来训练分类器进而将人脸从复杂背景中提取出来,相比之下在现有跟踪算法中更有优势。目前,基于相关滤波的判别跟踪方法[4]在目标跟踪基准数据库OTB[5]上表现出很好的跟踪性能与计算效率。BOLME D S等首次将相关滤波引入到跟踪框架中提出误差最小平方和滤波器(MOSSE),其用图像的原始灰度信息来训练分类器[6]。之后,HENRIQUES J等用HOG特征来表征人脸,引入平移和尺度集得到一个核化模型来区分人脸与背景[7]。DANELLJAN M等用颜色属性(CN)来改善人脸特征模型,都取得了不错的跟踪效果[8]。尽管KCF有很多优点,但仍有三个主要问题需要解决:第一,仅用单一的HOG特征表征人脸忽略其他重要特征,如肤色特征;第二,固定的跟踪窗口无法解决跟踪过程人脸尺度的变化;第三,仅用当前帧对模型和分类器参数进行更新容易导致局部最优。

为解决上述问题,本文首先将HOG、肤色这两个互补特征进行融合来提高算法的判别能力。同时训练位置滤波器与尺度滤波器来对人脸进行位置与尺度的估计,最后根据前面所有帧采用线性插值的方式自适应的对人脸模型及分类器参数进行更新来提升跟踪的性能。实验结果显示改进算法在成功率和精度上都有很大提高,算法运行满足实时性要求。同时在各方面的干扰情况下都有非常好的稳定性。

1 核相关滤波跟踪器

KCF[9]类似于其他相关滤波跟踪器,当人脸外观模型与训练数据相近时通过寻找最优滤波抽头使得响应值最大,其通过解决简单的岭回归来处理跟踪问题。假设循环移位Xi作为训练样本,i∈{0,1,2…,M-1}×{0,1,2,…,N-1},用一个高斯向量y表示训练输出。通过引入正则化最小二乘与核函数,分类器模型可通过式(1)训练得到:

[minωiφΧi,ω-yi2+λω2] (1)

式中:[φΧi]是将训练样本映射到希尔伯特空间的函数;常数[λ]是一个控制过拟合的正则化参数。定义核函数[κΧ,Χ′=φΧ,φΧ′],求解式(1),可以得到[ω=iαiφΧi]。其中滤波器系数[α]满足[Fα=YHΧ+λ], F(·)表示离散傅里叶变换,[Y=Fy,HΧ=Fhx]。对于单通道灰度图像集[Χ],这里采用高斯核[κΧ,Χ′=exp-1σ2Χ-Χ′2]进行计算,因此可以得到:

[hgaussΧ=exp-1σ2Χ2+Χ′2-2F-1X*X′] (2)

式中:[X=FΧ;X′=FΧ′;F-1]表示离散傅里叶变换的逆变换;[σ]为高斯核参数。对于新的检测区域,分类器的输出结果通过式(3)进行计算:[y=ωΤΖ=iαiκΧi,Ζ],根据循环结构可以同时计算Z所有的循环移位的输出响应:

[y=MhΖΤα] (3)

式中,[MhΖ]表示[hΖ]通过移位得到的矩阵。因为是一个滤波操作,所以其可以在频域中更有效地计算:

[Y=HΖFα] (4)

式中:[Y=Fy;HΖ=FhΖ]。新一帧中人脸位置通过最大响应值来得到。

2 多特征融合的尺度自适应人脸跟踪

KCF跟踪器利用循环结构的核函数计算候选区域与样本之间的相似性,整个过程在频域进行,避免了复杂的卷积计算,提高了运行效率。然而传统跟踪算法采取单一特征表征人脸,仅运用当前帧固定大小的训练样本来训练分类器和模型的更新,难以对人脸运动过程中出现的尺度变化进行相应的处理,最终导致分类器误差累计,跟踪人脸漂移。为此,通过肤色与HOG特征共同表征人脸,提出一种改进的自适应算法。

2.1 多特征融合

跟踪过程中人脸特征的提取与表示会对跟踪效率产生重要影响。从KCF跟踪器中了解到,相关滤波可以扩展到多维特征表示。假设多通道特征表示为一个向量[Χ=Χ1,Χ2,…,ΧC],那么式(2)可以写为:

[hgaussΧ=exp-1σ2Χ′2+Χ2-2F-1C=1CX?C⊙x′C] (5)

因此可以使用更强的特征来代替原始灰度像素,而且不同的互补特征可以进行特征融合。本文用较强的YCgCr空间肤色特征以及HOG特征进行融合来表征人脸。

在RGB颜色空间中人脸肤色的检测效果较差,而由图1可知,YCgCr在CgCr子空间的肤色聚类能力较好,因此选择YCgCr空间进行肤色特征表示,在颜色空间中建立高斯模型[10],从而得到人脸肤色特征归一化直方图。

YCgCr颜色空间与RGB颜色空间的转换公式如下:

[YCgCr=16128128+ 65.418128.553 24.966-81.085112-30.915112-93.786-18.214RGB] (6)

HOG计算机视觉的一个重要特征为通过将图像分为小的元胞,在每个元胞里累加计算出一维的梯度(或边缘方向)直方图,接着把这些直方图联合起来,进而生成特征描述子。由于HOG是在图像的局部方格单元上进行了归一化操作,所以极大地减少了光照和形變因素的影响。

图1 肤色在颜色空间中的分布

肤色与梯度方向直方图这两类特征互补,肤色提供了人脸区域的全局表观特征,而HOG强调了局部梯度特征。因此,在决策层将两种特征融合可以更有效的表征人脸,同时应用PCA降低特征维数提高了运算效率。

2.2 多特征的位置滤波器

本文使用一个二维相关滤波来估计人脸位置,通过训练样本集的所有循环移位得到一个分类器。假设人脸被提取的所有多通道特征向量被表示为[Χk:k=1,2,…,t],k表示第k帧,通过最小化回归误差来训练分类器:

[minωk=1tρkiφΧki,ω-yi2+λω2] (7)

式中,[yi]是高斯型的期望输出;[ρk]是第k帧的加权系数。根据核映射函数[ω=iαiφi],式(7)的解为:

[αt=k=1tρkYkHkΧk=1tρkHKΧHKΧ+λ] (8)

式中,[HKΧ=FhkΧ],[hkΧ]通过式(7)计算得到。则分类器的输出可以表示为:

[yt=F-1Y=F-1HΖαt] (9)

[α=αtNαtD],将分子[αtN]与分母[αtD] 分别进行更新。因此,分类器的系数[αt]按式(10)、式(11)进行更新:

[αtN=1-μαt-1N+μYtHtΧ] (10)

[αtD=1-μαt-1D+μHtΧHtΧ+λ] (11)

人脸外观模型用式(12)更新:

[Χt=1-μΧt-1+μΧt] (12)

2.3 尺度估计

根据第2.2节提出的位置相关滤波器,提出尺度估计策略,通过学习一个尺度相关滤波器来估计人脸尺度变化。首先,提取由位置滤波器检测出来的人脸位置周围不同尺寸的训练样本,用这些样本训练一个尺度滤波器,根据最大的尺度相关响应值来估计人脸的尺度变化。假设跟踪窗i的大小为二维向量Si,原始人脸尺度为S0。定义尺度池[s=α1,α2,…,αN],[s=s0αi],i=1,2,…,N,通过尺度池获得不同尺度的搜索窗口,通过训练得到的相关滤波器计算置信值,计算滤波的相应输出,最大响应值就是尺度估计的结果。同时尺度滤波模型用式(10)、式(11)进行更新。

2.4 改进算法框架

改进后的算法通过分别学习一个位置和尺度相关滤波器来有效地对人脸的位置和尺度进行估计。该算法流程为:

输入:前一帧人脸位置pt-1和尺度st-1;

输出:计算得出当前帧的人脸位置pt和尺度st;

1.从当前帧提取位置样本[Ζttrans];

2.用式(9)计算响应输出[yttrans];

3.找到使响应值[yttrans]最大的位置[pt];

4.从第t帧([pt,st-1])提取尺度样本[Ζtscale]

5.用式(9)计算响应输出[ytscale];

6.找到使响应值[yttrans]最大的人脸尺度[st];

7.用式(10)~式(11)更新[αt],用式(12)更新[Χt]。

3 实验结果分析

3.1 实验环境与参数

所有实验在Matlab R2014a Intel[?] Core(TM) i5?4590 3.30 GHz CPU 4 GB RAM下实现。在改进算法中正则化参数[λ]=0.03,模型更新中学习率?=0.065(位置模型),?=0.035(尺度模型),s=27,尺度增量因子[α]=1.02。

3.2 评价标准

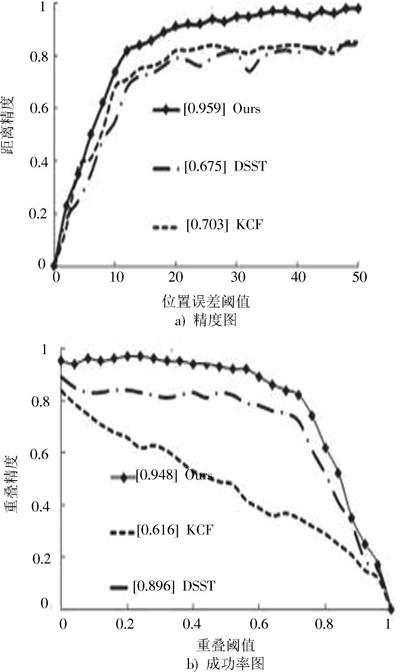

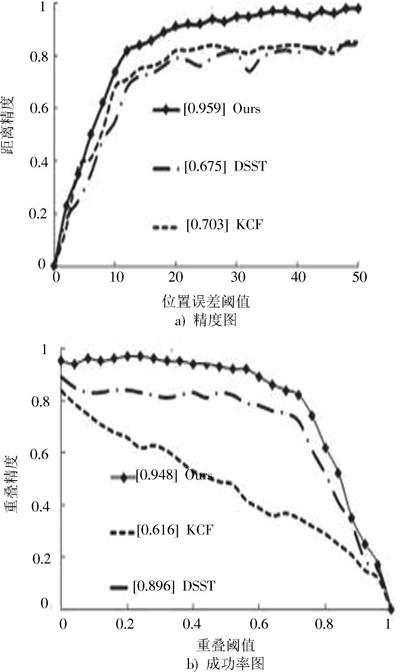

为了定量评估改进算法的性能,采用文献[11]中的OPE(One?Pass Evaluation)进行跟踪结果的评估。中心位置误差(CLE)定义为跟踪人脸的中心位置与实际的中心位置之间的平均欧氏距离。CLE越小性能越好,反之亦然。对于视频序列,所有帧平均CLE用来描述跟踪的整体性能。距离精度(DP)表示CLE值小于阈值所占视频总数的比例。实验中阈值选定为20 pixel。DP值越高,算法精度越好。重叠率(OP)表示重叠率大于阈值的帧数占视频总帧数的比例,OP值越高跟踪成功率越高。结果用精度图与成功率图显示,如图2所示,另外,给出了所有跟踪算法的FPS。

图2 精度与成功率曲线

3.3 对比实验

对本文的跟踪算法与当前几种比较优秀的算法如DSST[12]、KCF[13]进行比较,得到不同跟踪算法的主要差别,如表1所示。

实验中,选了几个经典的视频序列,在图3中显示了不同跟踪器的定量比较,图3a)中有明显的尺度变化。KCF由于跟踪窗口尺寸固定无法准确估计多尺度变化的人脸,DSST可以跟踪不同的尺度但受尺度漂移的影响,文中提出的方法可以精确地估计出人脸的位置与最佳尺度。在图3b)中,人臉受到了部分遮挡和全部遮挡。KCF和DSST无法解决全遮挡影响,所以产生了跟踪漂移;而改进后的方法可以精确估计位置在尺度估计上也要优于DSST。在图3c)中,人脸受光照变化、相似背景的干扰,但改进算法仍然能够很好地跟踪目标。在图3d)中,目标发生了旋转,该文算法可以精确地定位人脸位置,而其他算法则跟踪失败。另外,图2显示了本文算法在精度与成功率上的有效性。表1给出了几种跟踪方法的平均定量结果,最好的结果用黑体显示。从定量分析,本文方法在鲁棒性与精确性上优于其他跟踪器,运行也满足实时性。

图3 不同跟踪方法对测试视频的跟踪结果

总体来说,从定量与定性评估中可知,改进算法对尺度、遮挡、光照等方面的干扰表现出很好的稳定性。实验结果清楚地表明该算法极大提高了人脸跟踪的性能。

4 结 论

本文根据导致KCF跟踪失败的主要因素提出一种改进的算法。首先,将人脸肤色与HOG特征进行融合来表征人脸;其次,通过学习一个独立的尺度滤波器对人脸最优尺度变化进行估计,解决了传统核相关滤波跟踪算法无法自适应处理尺度变化的缺陷;最后,采用线性插值的方式更新人脸的外观模型与滤波器系数。对4组测试视频进行实验,结果表明改进算法对尺度变化、严重遮挡等问题有很好的鲁棒性,跟踪速度在36.7 f/s达到了实时应用的要求,优于近几年一些优秀的跟踪算法。

注:本文通讯作者为赖惠成。

参考文献

[1] SMEULDERS A W M, CHU D M, CUCCHIARA R, et al. Visual tracking: an experimental survey [J]. IEEE transactions on pattern analysis and machine intelligence, 2014, 36(7): 1442?1468.

[2] JIA X, LU H, YANG M H. Visual tracking via adaptive structural local sparse appearance model [C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Providence: IEEE, 2012: 1822?1829.

[3] HARE S, SAFFARI A, TORR P H S. Struck: structured output tracking with kernels [C]// Proceedings of IEEE International Conference on Computer Vision. Barcelona: IEEE, 2011: 263?270.

[4] HENRIQUES J, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking?by?detection with kernels [C]// Proceedings of 12th European Conference on Computer Vision. Berlin: Springer, 2012: 702?715.

[5] WU Y, LIM J, YANG M H. Object Tracking Benchmark [J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(9): 1834?1848.

[6] BOLME D S, BEVERIDGE J R, DRAPER B A, et al. Visual object tracking using adaptive correlation filters [C]// Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco: IEEE, 2010: 2544?2550.

[7] HENRIQUES J, CASEIRO R, MARTINS P, et al. High?speed tracking with kernelized correlation filters [J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(3): 583?596.

[8] DANELLJAN M, KHAN F S, FELSBERG M, et al. Adaptive color attributes for real?time visual tracking [C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Columbus: IEEE, 2014: 1090?1097.

[9] LI Y, ZHANG Y F, XU Y L, et al. Robust scale adaptive kernel correlation filter tracker with hierarchical convolutional features [J]. IEEE signal processing letters, 2016, 23(8): 1136?1140.

[10] GHAZALI K H B, MA J, XIAO R. An innovative face detection based on YCgCr color space [J]. Physics procedia, 2012, 25: 2116?2124.

[11] TANG M, FENG J Y. Multi?kernel correlation filter for visual tracking [C]// Proceedings of IEEE International Conference on Computer Vision. Santiago: IEEE, 2015: 3038?3046.

[12] DANELLJAN M, H?GER G, KHAN F S, et al. Accurate scale estimation for robust visual tracking [C]// Proceedings of 2014 British Machine Vision Conference. Nottingham: BMVA Press, 2014: 1?11.

[13] MONTERO A S, LANG J, LAGANI?RE R. Scalable kernel correlation filter with sparse feature integration [C]// Proceedings of IEEE International Conference on Computer Vision Workshop. Santiago: IEEE, 2015: 587?594.

[14] ZHANG K, ZHANG L, LIU Q, et al. Fast visual tracking via dense spatio?temporal context learning [C]// Proceedings of European Conference on Computer Vision. Cham: Springer, 2014: 127?141.