基于卷积神经网络的中国绘画图像分类

杨冰 陈浩月 王小华

摘 要:绘画图像分类为绘画管理与使用提供了便利。传统图像分类大多依靠人工提取形状、颜色等特征,由于绘画图像分类需要更专业的知识背景,从而使人工提取特征的过程繁琐且复杂。基于此,提出一种基于卷积神经网络的中国绘画分类方法,并在此基础上结合SoftSign与ReLU两种激活函数的优点,构造一种新的激活函数。实验结果表明,基于改进后激活函数构造的卷积神经网络,可以有效提高分类准确率。

关键词:深度学习;卷积神经网络;中国绘画;激活函数;图像分类

DOI:10. 11907/rjdk. 181736

中图分类号:TP301文献标识码:A文章编号:1672-7800(2019)001-0005-04

Abstract:The classification of painting images facilitates the management and use of paintings. Different from traditional image classification, features such as artificial extraction of shapes and colors are required. Classification of painting images requires a more professional knowledge background, which also makes the process of manually extracting features increasingly complicated. Based on this, a Chinese painting classification method based on convolutional neural network is proposed. Based on this, it combines the advantages of two activation functions including SoftSign and ReLU to construct a new activation function. Experimental results show that the convolutional neural network constructed based on the improved activation function can effectively improve the classification accuracy.

Key Words: deep learning; convolution neural network; Chinese painting; activation function; image classification

0 引言

随着数字化图像的发展,图像分类成为图像领域的研究热点之一。作为中国传统文化的重要组成部分,对中国绘画分类[1-2]的研究有助于更好地继承与发扬传统文化。中国绘画历史源远流长,流派与艺术风格众多,且中国画以写意为主,与自然状态下的图像相差较大,所涵盖的内容也更加抽象,所以在特征提取方面需要更多专业知识。传统图像分类方法大多是基于浅层结构的学习算法,虽然可以提取一定图像特征,但在某些特征提取过程中容易导致特征丢失,且特征提取方法的泛化性较差。因此,中国绘画的图像分类存在诸多障碍。

受Hubel & Wiesel对于猫视觉皮层电生理研究的启发,卷积神经网络由此诞生。Yann Lecun首次将卷积神经网络用于手写数字识别[3-4];Krizhevsky等[5]提出经典的卷积神经网络结构AlexNet,并在图像识别任务上获得重大突破。近年来CNN在多个领域发展迅速,其在解决图像分类[6]与目标检测[7-8]等多方面问题上都表现出色。卷积神经网络结构是对真实生物神经网络进行仿真,权值共享降低了网络复杂性,而图像能够直接输入神经网络的特点可避免特征提取与分类过程中数据重建的复杂性。与传统复杂的特征提取方法诸如提取边缘、纹理等特征[9]提取方法相比,卷积神经网络显得尤为高效。在绘画图像领域,文献[10]提出一种基于混合稀疏卷积神经网络的方法,对不同风格作者的笔触特征进行分析;文献[11]基于水墨的色彩与色调,提出一种基于风格的水墨自动识别方法;文献[12]应用边缘检测定位局部区域并检测绘画笔划,以实现基于直方图的特征提取及重要线索捕获,以反映不同艺术家风格。

深度学习为计算机视觉领域的发展作出了卓越贡献,其中一个重要因素是激活函数的不断创新。神经网络中激活函数提供了网络的非线性建模能力,使神经网络具有分层的非线性映射学习能力。因此,激活函数是神经网络的重要组成部分。2006年Hinton通过采用新型激活函数ReLU,使深度网络的直接监督式训练成为可能,但ReLU激活函数也同时存在神经元死亡等问题。

卷积神经网络在多个领域应用广泛,表现出极强的泛化性,因此本文在卷积神经網络基础上研究图像分类,并进一步研究激活函数对图像分类准确率的影响,提出一种线性与非线性结合的函数作为激活函数,并在中国绘画数据集与通用数据集上进行实验。实验结果证明,改进后的激活函数提高了分类性能。

1 卷积神经网络设计

1.1 卷积神经网络

卷积神经网络是一种前馈神经网络,与普通神经网络结构不同,卷积神经网络主要由卷积层与下采样层组成特征提取器。卷积层通常包含若干特征平面,每个特征平面由若干个神经元排列成矩形,同一特征平面上的神经元共享权值,共享权值称为卷积核。权值共享的优点是能够减少神经元之间的连接数量,同时降低过拟合风险;下采样可被认为是一种特殊的卷积过程,能够减少计算维度,提高模型泛化能力。卷积与下采样大大简化了模型复杂性,并减少了模型参数。卷积神经网络训练过程主要包括前向传播和后向传播,训练过程中卷积层与下采样层交替出现。

前向传播的目的是进行特征提取,主要由卷积操作与下采样操作实现。图像由输入层进入卷积层,再通过激活函数得到输出值。

1.2 卷积神经网络结构

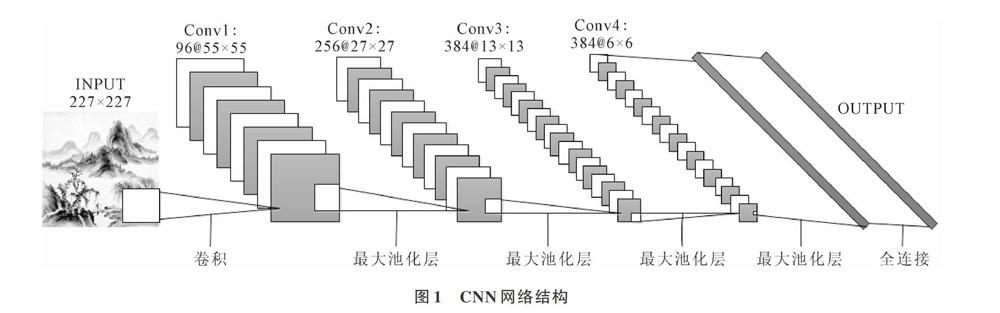

本文的卷积神经网络结构如图1所示,输入层是227[×]227的图像,由17层组成,卷积、下采样交替4次,后接两层全连接层。其中第一个与第二个池化层之后接局部响应归一化层(Local Response Normalization,LRN)[14],其模仿生物神经系统的侧抑制机制,对局部神经元的活动创建竞争机制,使响应较大的值相对更大。第一个全连接层后接dropout[15],利用dropout消除或减弱神经元节点间的联合适应性,让一个神经元的出现不依赖于另一个神经元。每次dropout后,网络模型都可看成整个网络的子网络,相当于实现了模型的平均。LRN与dropout技术同时提高了模型泛化能力。

2 激活函数

2.1 激活函数发展

近年来神经网络尤其是卷积神经网络技术取得了巨大进展,主要是由于几个关键因素如卷积神经网络宽度[16]与深度[17]增加、数据集的扩增、显卡等高性能硬件的支持、Batch Normalization[18]层设计等,都在一定程度上提高了模型精度。其中,激活函数是卷积神经网络发展的关键技术。

传统神经元模型使用的激活函数是Sigmoid,其数学形式为:[f(x)=1/(1+exp(-x))]。Sigmoid是使用范围较广的一类激活函数,具有指数函数形状,其在物理意义上最接近生物神经元。此外,(0,1)的输出还可被表示为概率,或用于输入的归一化,代表性的有Sigmoid交叉熵损失函数。然而,它有一个严重问题即容易产生饱和效应,也称为梯度弥散效应。一般而言,Sigmoid 网络在5层之内即会产生梯度消失现象。

TanH函数是Sigmoid函数的变形,其数学形式为:[f(x)=(1-exp(-2x))/(1+exp(-2x))]。TanH函数克服了Sigmoid函数非零均值输出的缺点,容错性好,同时延迟了饱和期,但仍未解决梯度消失问题。

SoftSign[19]函数类似于双曲正切函数,其数学形式为:[f(x)=x/(1+abs(x))]。SoftSign激活函数相较于双曲正切函数具有更为平滑的渐近线,并且相比于双曲正切函数,SoftSign激活函数的激活值在网络层数1~4层之内并未过饱和。实验证明,SoftSign激活函数与双曲正切函数相比,在图片分类准确率上具有更好的效果。

ReLU函数[20]的出现极大地推动了神经网络发展。ReLU是一个分段线性函数,其正半轴输入与输出保持一致,负半轴输入恒为零,该形式可以缓解梯度消失现象。但随着训练的逐渐推进,落入硬饱和区输入值的对应权重将无法更新,由此出现神经元死亡现象。ReLU的另一个突出问题是输出会出现偏移,即输出均值恒大于零。因此,本文考虑综合几个激活函数的优点对其进行改进。

2.2 改进的激活函数

神经网络选择激活函数时,需要注意两点:①避免激活函数过饱和;②避免激活函数过度线性化。相比于ReLU,SoftSign函数使神经网络具有非线性特点,能够更好地进行学习;相比于SoftSign,ReLU函数在网络训练过程中发挥了更大优势,可缓解梯度消失现象,且收敛速度更快。结合SoftSign与ReLU函数的优点,构建一个新的激活函数,命名为SReLU。该激活函数定义如下:

式中,[yi]是第i个激活函数f的输入,当激活函数层的输入大于0时取ReLU函数值,反之,小于0时取双曲正切函数值。与PReLU[21]类似,下标c表示图片颜色的不同通道,[ac]则表示不同颜色通道的取值,控制负半轴输入。如果[ac=0],SReLU则退化为ReLU。与ReLU相比,SReLU具有负值,使激活的平均值更接近于0。非零均值输出能够加快学习速度,因为其梯度更接近自然梯度[22]。SReLU激活函数如图2所示。

SReLU激活函数的参数[ac]可以进行反向传播,从而得到优化,参数更新遵循链式求导法则,[ac]梯度优化公式如下:

其中[ε]代表目标函数,[?f(yi)?ac]代表当前层梯度。SReLU当前层的梯度计算方式如下:

3 实验结果与分析

由于中国绘画缺乏通用数据集,所以本文实验的绘画数据集来自“红动中国”等网站,按绘画类别将其分为花鸟、山水、人物3个类别,每类样本各800幅,训练数据700幅,测试数据100幅。

3.1 激活函数实验对比

将本文激活函数SReLU分别与TanH、SoftSign、ReLU、Leak ReLu 4种激活函数进行对比。其中,本文实验中将激活函数负半轴参数[ac]的值初始化为1时可取得最佳效果,Leak ReLu的负半轴系数也根据经验初始化为1。实验结果如表1所示。

由表1可以看出,TanH激活函数的准确率最低,SoftSign激活函数的实验结果优于TanH,ReLU激活函數具有较高准确率,Leak ReLu激活函数略高于ReLu,而本文激活函数SReLU取得了最高的准确率95.67%,相比于ReLU函数提高了2%,从而证明了本文激活函数应用于中国绘画数据集的有效性。

值得注意的是,在相同模型参数下,Sigmoid激活函数对中国绘画数据集的分类效果很差,所以本实验未将Sigmoid函数的实验结果考虑在内。

3.2 通用数据集实验比较

为验证本文激活函数不仅在中国绘画数据集分类上具有一定优势,在其它数据集上依然具有可行性,所以将本文提出的激活函数应用于其它通用数据集进行实验。实验的通用数据集来源于牛津大学的Visual Geometry Group,本文选择其中5类图像进行实验,分别为宠物、花、飞机、房子与吉他,每类训练数据800幅,测试数据200幅。实验结果如表2所示。

由表2可以看出,本文激活函数在通用数据集上的效果明显优于TanH和SoftSign激活函数,同时相比于ReLU激活函数,准确率也提高了1.4%,而在本次实验中,Leak ReLu并未显示出相较于ReLU的优势。由此可进一步证明本文提出激活函数的有效性,且该激活函数具有一定泛化性。

4 结语

深度学习是机器学习领域一个全新的发展方向,并广泛应用于多个领域。本文利用卷积神经网络的优势提取中国绘画特征并对其进行分类,取得了较高准确率。激活函数为卷积神经网络模型带来了非线性因素,增强了模型表达能力。本文提出一种改进的激活函数,综合考虑了激活函数非线性与梯度弥散改善问题,以及激活函数参数在图像不同颜色通道上的初始化及参数更新问题,分别在中国绘画数据集和通用数据集上与改进前的激活函数进行实验对比,结果表明卷积神经网络的图像分类准确率得到了相应提高。

参考文献:

[1] 高峰, 聂婕, 黄磊,等. 基于表现手法的国画分类方法研究[J]. 计算机学报, 2017, 40(12): 2871-2882.

[2] 鲍泓. 基于视觉感知的中国画图像语义自动分类研究[D]. 北京:北京交通大学,2012.

[3] LECUN L,BOTTOU L,BENGIO Y,et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE,1998,86(11):2278-2324.

[4] 赵志宏,杨绍普,马增强. 基于卷积神经网络LeNet-5的车牌字符识别研究[J]. 系统仿真学报,2010,22(3):638-641.

[5] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]. International Conference on Neural Information Processing Systems. Curran Associates Inc. 2012:1097-1105.

[6] XIAO T, XU Y, YANG K, et al. The application of two-level attention models in deep convolutional neural network for finegrained image classification[C]. IEEE Conference on Computer Vision and Pattern Recognition. Columbus:IEEE CVPR, 2014:842-850.

[7] HE K, ZHANG X, REN S, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis&Machine Intelligence,2014,37(9):1904-1916.

[8] GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C].IEEE Conference on Computer Vision and Pattern Recognition,2014:580-587.

[9] LIU C, JIANG H. Classification of traditional Chinese paintings based on supervised learning methods[C]. IEEE International Conference on Signal Processing,Communications and Computing,2014:641- 644.

[10] SUN M J,ZHANG D,REN J C,et al. Brushstroke based sparse hybrid convolutional neural networks for author classification of Chinese ink-wash paintings[C]. IEEE International Conference on Image Processing,2015:626-630.

[11] SHENG J C. An effective approach to identify digitized IWPs (ink and wash paintings)[C]. International Congress on Image and Signal Processing, 2013:407-410.

[12] SHENG J, JIANG J. Style-based classification of Chinese ink and wash paintings[J]. Optical Engineering, 2013, 52(9): 093101.

[13] 高學,王有旺. 基于CNN和随机弹性形变的相似手写汉字识别[J]. 华南理工大学学报:自然科学版, 2014 (1) :72-76.

[14] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]. International Conference on Neural Information Processing Systems,2012:1097-1105.

[15] KRIZHEVSKY A,SUTSKEVER I,HINTON G E. ImageNet classification with deep convolutional neural networks[J]. Advances in Neural Information Processing Systems,2012,25(2):1097-1105.

[16] SZEGEDY C,LIU W,JIA Y Q, et al. Going deeper with convolutions[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2015:1-9.

[17] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. http://papers.nips.cc/paper/8424-imagenet-classification-with-deep-convolutional-neural-netwonet.pdf,2014.

[18] IOFFE S,SZEGEDY C. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]. Proceedings of the 32 nd International Conference on Machine Learning,2015:448-456.

[19] GLOROT X, BENGIO Y. Understanding the difficulty of training deep feedforward neural networks[C]. International conference on artificial intelligence and statistics,2010:249-256.

[20] NAIR V, HINTON G E. Rectified linear units improve restricted boltzmann machines[C]. Proceedings of the 27th International Conference on Machine Learning (ICML-10),2010:807-814.

[21] HE K, ZHANG X, REN S, et al. Delving deep into rectifiers: surpassing humanlevel performance on ImageNet classification[C]. The IEEE International Conference on Computer Vision (ICCV). 2015:1026-1034.

[22] CLEVERT D A,UNTERTHINER T,HOCHREITER S. Fast and accurate deep network learning by exponential linear units (ELUs)[DB/OL]. arXiv:1511.07289, 2015.

(責任编辑:黄 健)