液冷与动态自然冷却的综合运用技术探讨

肖新文

液冷与动态自然冷却的综合运用技术探讨

肖新文

(世图兹空调技术服务(上海)有限公司 上海 201108)

介绍了数据中心二次侧集中循环直接接触冷板式液冷系统及动态自然冷却空调系统的组成,提出了两者综合运用的制冷散热系统架构。以位于北京的某样本高密度数据中心为例进行方案配置,并假设数据中心满负载的情况下对散热系统进行年运行功耗计算,通过计算得出该样本数据中心的pPUE值仅为1.09,可实现数据中心高效节能运行,指出采用冷板散热占比大的服务器,降低自然冷却空调系统的干冷器功率可进一步提高综合运用系统的能效。

数据中心;直接接触冷板式液冷;动态自然冷却;综合运用;节能

0 引言

伴随着云计算、大数据、5G网络建设将带来众多巨通量计算业务,如高通量的大数据处理、5G交互式增强AR等。故服务器芯片的散热正受到严重挑战:如8核CPU的热耗从第1代的70 W 提高到第4代的150W,平均每代复合增长率28.9%;芯片热封装壳温由第1代的64℃提高到第4代的67℃,平均每代复合增长率5.0%。同时风冷产品散热能力及服务器的噪声遭遇瓶颈:整机功率密度已逼近40 W/L,对应的单机柜最大噪声已达到112.4dB(A),常温噪声也已达到了78dB(A)[1]。而人工智能的快速发展需要大量使用GPU,每个GPU的功耗可高达300W,假设每台服务器可装载8块GPU,则每台服务器的功耗将高达2.4kW,那么每机柜的功耗可高达数十千瓦。面对如此高的功率,传统的风冷技术将无法实现如此高密度的机柜散热[2]。在这一趋势下,数据中心高密度服务器的散热及其耗能问题日益凸显。高密度服务器散热的技术发展经过强制定点送风、通道封闭[3,4]、行级空调[5]、水冷背板[6]及分布式冷却系统[7]等历程后,芯片液冷成为业界新一轮的热点。液冷散热热容量大,液体(同体积)比热容为空气的3000倍。同时热传导更快,液体导热性能是空气的15~25倍。液冷技术分为直接冷却和间接冷却。直接冷却可以采用直接将电子设备浸入冷却介质或者电子器件的发热部分与冷却介质接触(如液体喷射冷却、液体喷雾冷却)来散热,受热升温的液体介质流动到其他低温部位再将热量散出去。间接冷却指热源不直接与冷却介质接触,而是通过冷板装置间接进行热交换,如循环管路散热冷却、微通道液体冷却和热管冷却[8]。目前数据中心服务器采用的液冷方式主要有冷板、浸没和喷淋三种技术路线。浸没式和喷淋式等接触式液冷,其稳定可靠性还有待进一步的验证,液体和IT部件之间的兼容性,IT部件长期浸泡在相关液体中,是否会对其功能和性能带来影响尚需要关注和验证[9]。而二次侧集中循环直接接触冷板式液冷系统同其他液冷方式相比在初投资、可靠性、维护便利性及使用寿命等方面上均具有优势。由于二次侧集中循环直接接触冷板式液冷服务器除主要芯片通过冷板完全冷却外尚有部分非集中散热电子元气件需要风冷冷却,此部分通常占服务器整个散热的15%~30%左右,而动态自然冷却空调系统与液冷技术的综合运用可进一步降低制冷系统功耗,使数据中心制冷系统向零机械压缩制冷逼近。

1 液冷与动态自然冷却的综合运用技术方案简述

1.1 直接接触冷板式液冷系统

直接接触冷板式液冷系统通常由一次侧(室外)设备及二次侧设备(室内)组成。一次侧设备主要包括一次侧循环泵及室外散热设备,室外散热设备通常是干冷器或者闭式冷却塔。二次侧设备包含换热模块、分歧管模块及芯片散热冷板,依据芯片散热冷板中是否含微型泵分成二次侧分散循环系统及二次侧集中循环系统,由于含微型泵冷板的尺寸普遍较大无法满足不同服务器的要求,所以数据中心通常采用换热模块中集成循环泵的二次侧集中循环系统。

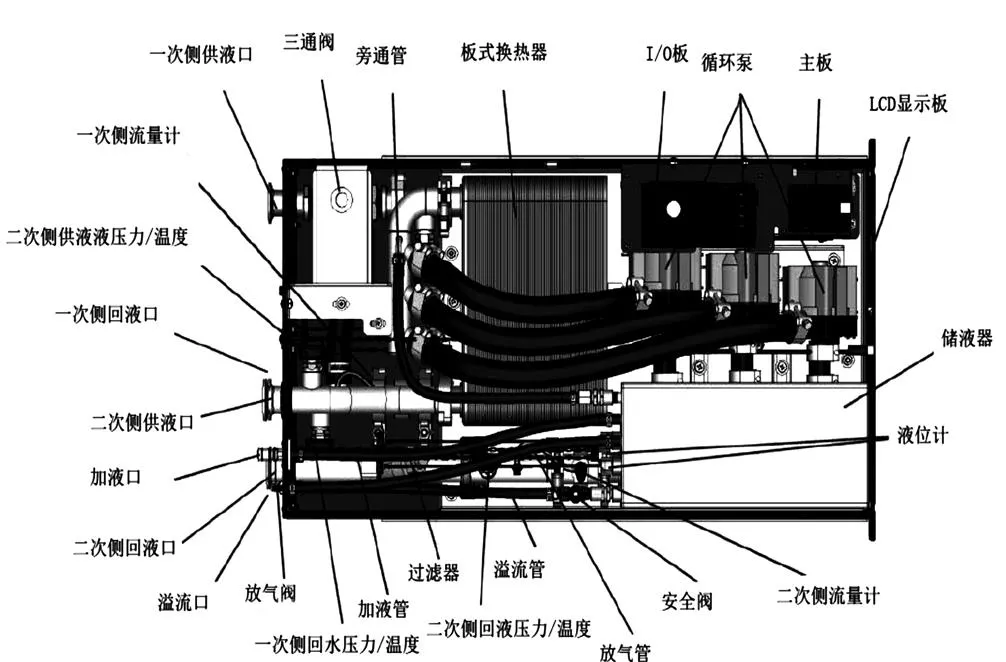

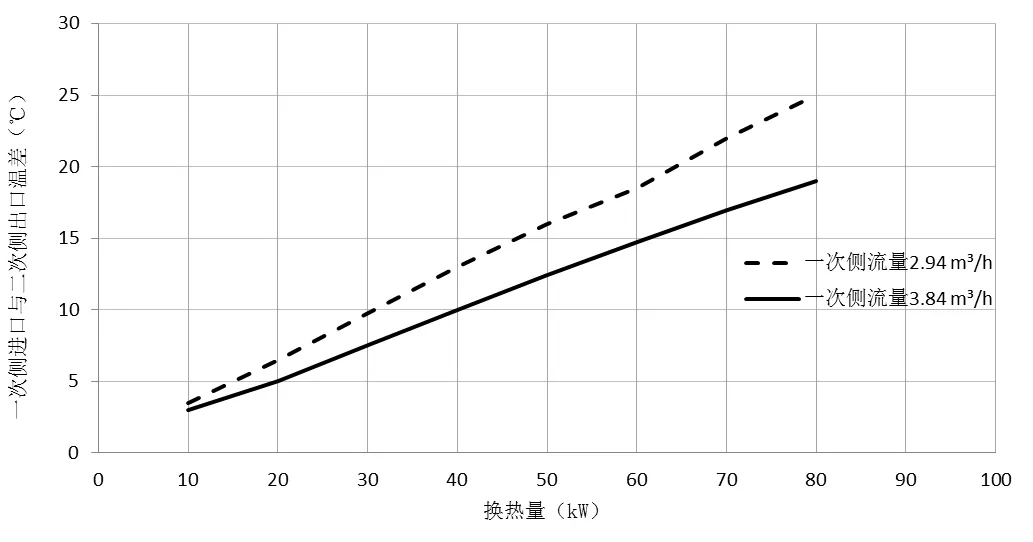

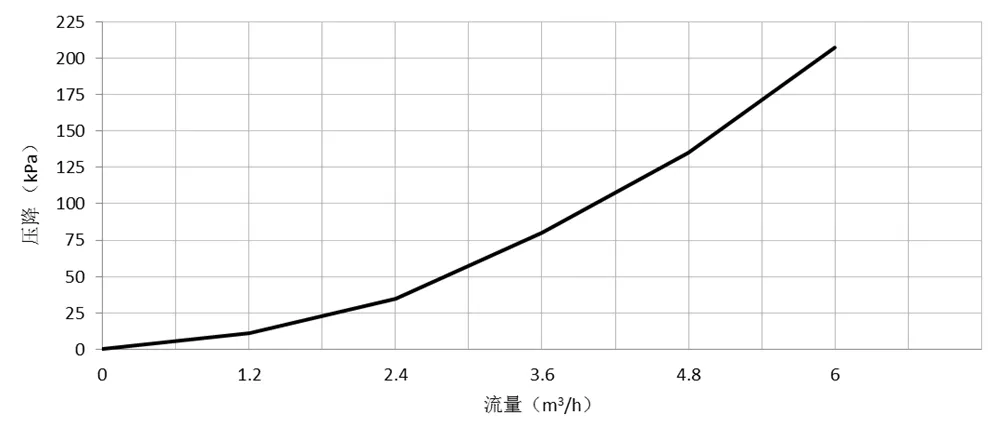

换热模块最基本的功能是实现一次侧及二次侧的换热,同时实现冷却液温度的精准控制。如图1所示,其主要由板式换热器、电动比例阀、二次侧循环泵、膨胀罐、安全阀、进出水管专用接头、控制器及其面板等组成。换热模块在不同的流量及温差下性能差异明显,如图2所示为某款换热模块的换热量曲线,而图3是其一次侧流量及压降性能曲线图。所以实际工程应依据设计工况合理应用。

图1 某款换热模块结构示意图

图2 某款换热模块换热量曲线图

图3 某款换热模块一次侧流量及压降性能曲线

芯片散热冷板通常采用铜板,采用微通道架构实现独特的分流设计来降低压降,增大冷却液流量,确保低温的冷却液首先冷却芯片最热区域。作为散热冷板本身无任何运动部件,可靠性高。

分歧管分配经过热交换模块冷却的冷却液均匀有序地进入芯片散热冷板,防止不同路径的芯片散热冷板出现欠流或者过流情况。

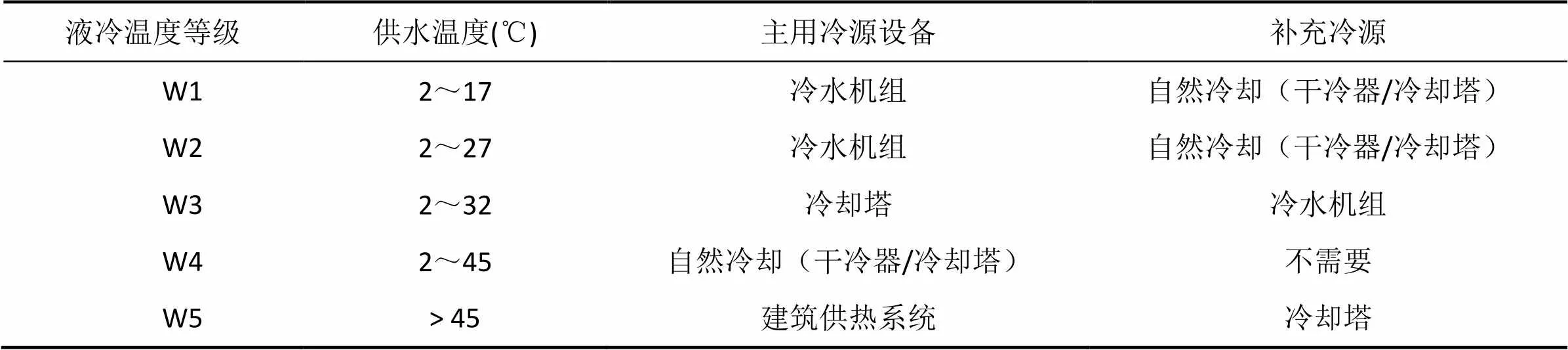

ASHRAE—TC9.9对不同液冷温度等级的推荐冷源如表1所示[10],该液冷系统适用于W3~W5液冷温度等级,其不仅可实现完全无机械压缩制冷运行,甚至还是建筑供热来源。

表1 ASHRAE—TC9.9对于不同液冷等级推荐冷源表

1.2 动态自然冷却空调系统

间接动态自然冷却空调系统主要由机房内的间接自然冷却室内机组,室外的干冷器(闭式冷却塔)机组、变频水泵、连接管路及其辅件等组成。间接自然冷却室内机组的结构是在水冷机房空调内机蒸发盘管的基础上加一套自然冷却冷水盘管及两通水量调节阀组成。干冷器(闭式冷却塔)冷却后的循环水可通过自然冷却两通阀进入自然冷却盘管直接冷却室内回风,也可以通过冷却水两通阀控制进入板式水冷冷凝器冷却压缩机制冷系统的散热。因为压缩机制冷循环独立于自然冷却水循环,所以该系统可实现自然冷却及机械压缩同时运行。

动态自然冷却空调系统通常具有如下制冷运行模式:

机械制冷模式:当室外温度高于压缩机制冷模式预设值时,该系统此时与常规水冷机房空调系统无异,系统采用压缩机制冷。该模式室外温度预设值通常低于室内回风温度3℃左右。

混合制冷模式:过渡季节室外温度较低时,干冷器(闭式冷却塔)提供的部分冷水流向自然冷却冷水盘管首先冷却室内回风,另一部分冷水流经板式换热器带走机械压缩制冷循环的散热,被自然冷却冷水盘管预冷的室内回风由机械压缩制冷补冷冷却至设计的送风温度。此时机械制冷压缩机卸载运行,整个空调系统开始节能。

自然冷却制冷模式:当室外温度进一步降低,干冷器(闭式冷却塔)提供的冷水温度足够低从而可直接将室内回风降至要求的送风温度,此时压缩机完全不运转,节能效果显著。

上述三种模式随着室内负载及室外环境温度动态变化,负载率下降,自然冷却时间延长。

1.3 综合运用系统架构

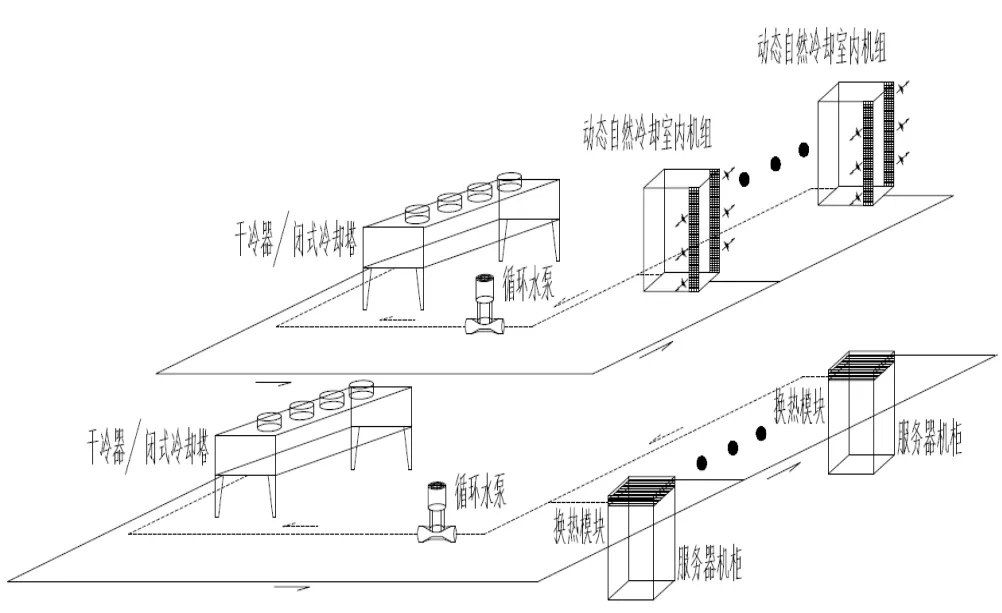

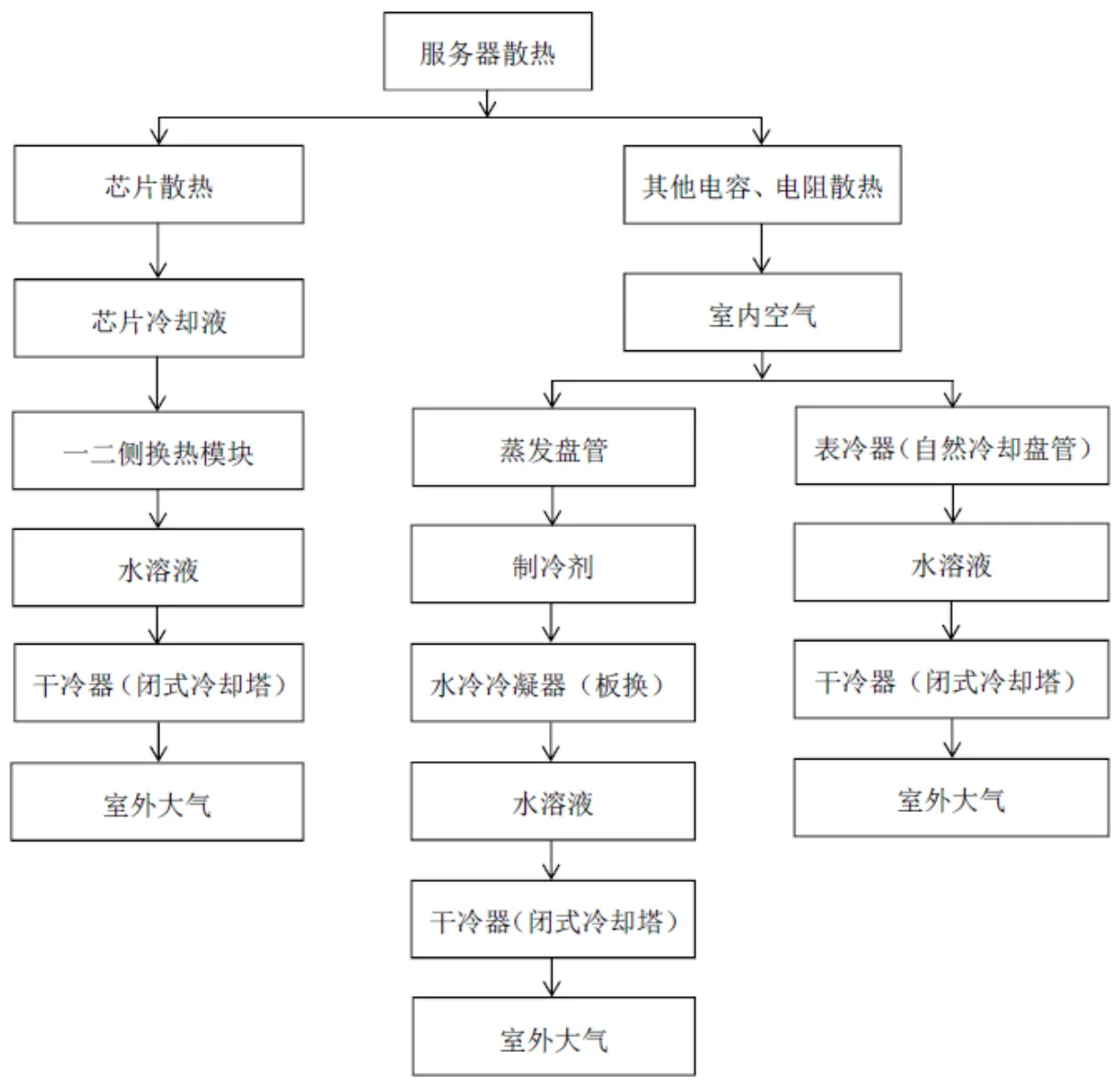

利用直接接触冷板式液冷系统集中冷却服务器芯片,同时搭配动态自然冷却空调系统对服务器的其他发热元器件进行风冷散热,此时数据中心的制冷系统架构示意图如图4所示,室内的散热终端是直接接触式冷板、动态自然冷却室内机组的蒸发盘管及表冷器,而室外散热设备为干冷器(闭式冷却塔),此时服务器散热流程图如图5所示。

图4 液冷与动态自然冷却综合运用散热系统架构示意图

图5 服务器热量散发途径示意图

作为室外散热设备干冷器工作过程没有水的消耗,通过管外室外空气来冷却管内液体,降低管内液体温度,达到冷却的目的,其降低了系统对水资源的依赖程度,具有更广的普适性,故本文的室外散热设备以干冷器作为分析依据。目前业界干冷器通常是模块化设计,一个规格覆盖一定的散热区间,干冷器的选型通常按照要求的换热量、室外温度及进出水温依据传热方程计算出匹配换热面积及风量从而确定具体机型。传热方程式为:

=Δt(1)

式中:为换热量,kW;为传热系数,kW/(m2·℃);为换热面积,m2;Δt为对数平均温差,℃。

而在不同的实际运行环境温度及进出水温运行工况下,则是在已选机型即固定换热面积的前提下通过调整风机的风量来实现的,所以配置无极调速EC风机的干冷器不仅通过调整风机转速可以精确控制出水温度,而且依据可实现节能运转。风机的风量、功率与转速之间的关系如式(2)所示:

式中:0为标准状态或者性能表中风机风量;0为标准状态或者性能表中风机转速;0为标准状态或者性能表中风机功率;1为标准状态或者性能表中风机风量;1为工作状态点风机转速;1为工作状态点风机功率。

2 综合运用系统技术方案节能分析

2.1 数据中心制冷方案简述

位于北京的某样本数据中心面积为100m2,内部布置机柜20台,单台机柜整体发热为27.8kW,其中芯片液冷散热20kW,风冷散热为7.8kW,风冷散热占比28%,服务器散热平均热负荷高达5.56kW/m2。根据GB 50174—2017《数据中心设计规范》对A级机房环境要求:冷通道或机柜进风区域的温度18℃~27℃,冷通道或机柜进风区域的相对湿度和露点温度要求露点温度为5.5℃~15℃,同时相对湿度不大于60%[11],空调的送风温度按照22℃进行设计,数据中心的回风温度为35℃,建筑围护结构、照明装置散热、新风负荷等其他负荷精确计算为11.5kW,本数据中心的总制冷负荷为567.5kW。采用液冷及动态自然冷却综合散热系统配置的主要设备表如2所示,为了保证数据中心的长期可靠稳定运行,表中机组选型配置均以室外极端温度考虑。

表2 液冷及动态自然冷却综合散热系统主要设备表

注:(1)动态自然冷却空调系统循环水泵按照混合模式最大流量进行选取;(2)水泵功率已考虑35%乙二醇溶液密度的影响。

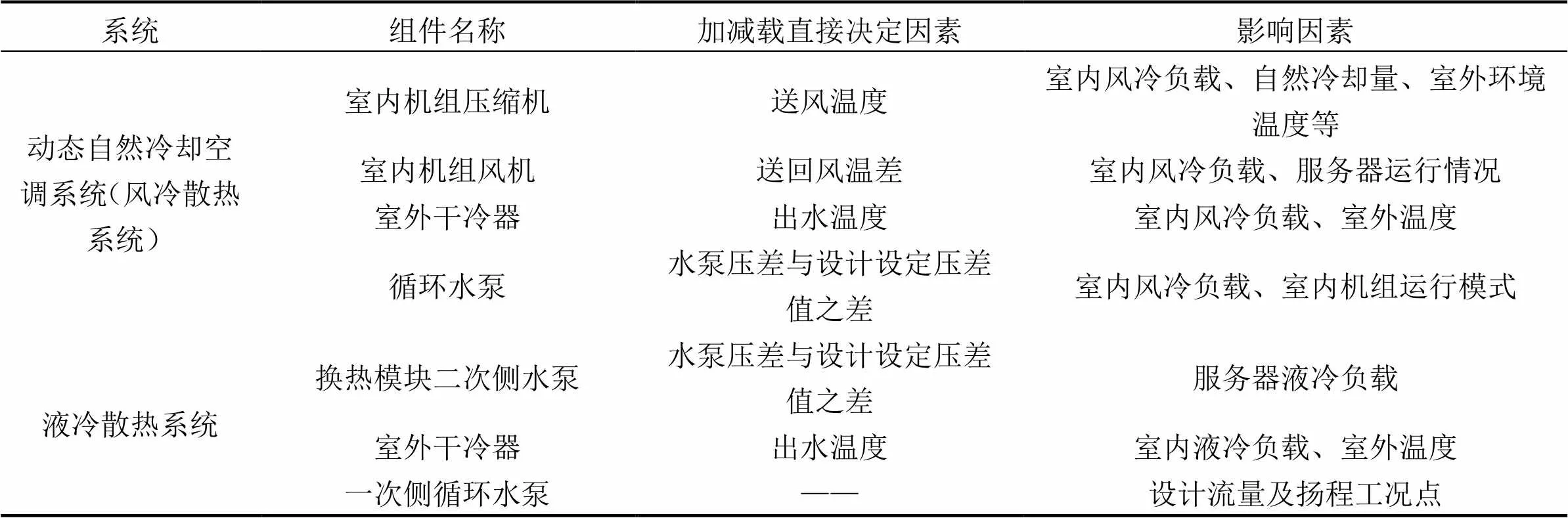

为了最大程度利用自然冷却,本例风冷散热系统干冷器的出水温度设定为环境温度-3℃,随着室外温度的降低最终将出水温度恒定在9℃(环境温度6℃及以下时),而液冷散热系统的干冷器出水温度恒定为45℃。为了精准控制液冷系统换热模块的换热量及二次侧出液温度,一次侧采用三通阀控制进入板式换热器的流量,故对于既定系统,其液冷系统的一次侧循环泵的运行状态点为定值。依据本综合制冷散热系统特点,系统耗能组件加减载影响因素如表3所示。

表3 液冷及动态自然冷却综合散热系统组件加减载影响因素表

2.2 节能分析

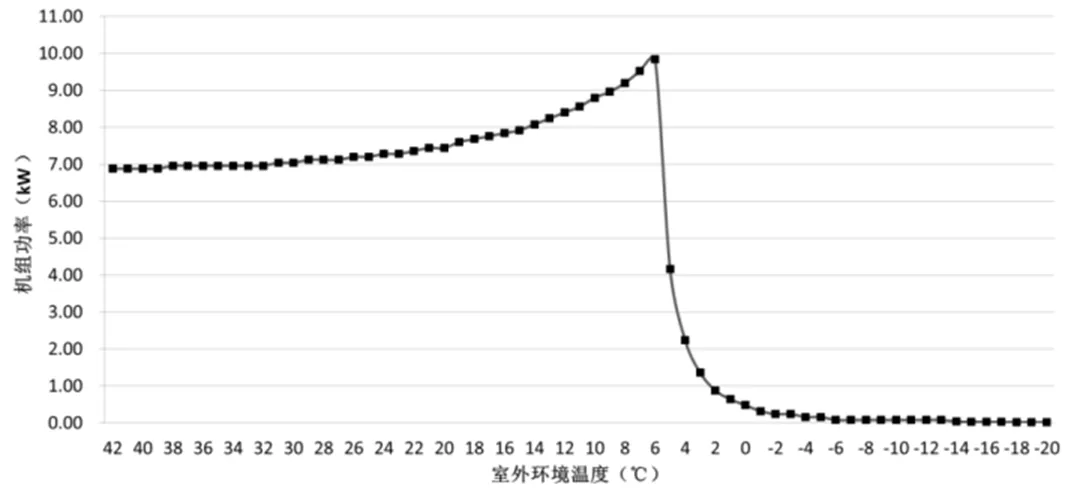

本文以数据中心满负载状况做节能计算分析,由上述方案简述可知,散热系统各个耗能组件运行状态随着室外环境温度变化而异。依据选型室内机组在不同进水温度自然冷却盘管的制冷能力及出风温度,计算出机械压缩制冷系统在此工况下需要承担的制冷能力及功率,满负载下本例单台室内机组运行功率曲线如图6所示。结合干冷器配置风机的风量与功率具体数值在不同室外环境温度下通过传热方程式进行数值计算,得出液冷系统及动态自然冷却空调系统的单台干冷器运行功率曲线分别如图7、图8所示。

图6 动态自然冷却室内机组功率与机组进水温度曲线图

图7 动态自然冷却空调系统单台干冷器功率曲线图

图8 液冷系统单台干冷器功率曲线图

由于动态自然冷却空调系统循环水泵的流量依据室内机组运行模式动态变化,为简化计算过程:混合模式均按照水泵标称功率进行计算,而计算自然冷却制冷模式及机械制冷模式下水泵功率时,仅考虑室内机组机械制冷时的标称流量,不考虑需求扬程下降的影响;液冷的一次侧循环泵及换热模块均以标称功率进行计算。按照DeST能耗软件中的气象参数,汇总北京全年室外温度状态点的具体时间,按照干球温度为整1℃区间的平均数据汇总时间,逐温依据上述图表确定各个耗能组件的运行功率,可计算出不同室外温度下系统的运行功耗。如北京年室外温度为0℃时间为243.6小时,这个温度点上液冷干冷器功率仅为0.01kW,而此时动态自然冷却系统干冷器出水温度恒定在9℃系统运行在自然冷却模式下,干冷器功率为0.48kW,水泵功率为6.6kW,单台室内机组功率仅为1.1kW,则液冷年功耗为4265kWh,动态自然冷却系统年功耗为3064kWh。统计汇总系统的年运行功耗如表4所示,整个制冷散热系统的理论计算pPUE值仅为1.09,节能效果显著,若该数据中心的其他系统性能同样出色的话,则数据中心的PUE值远低于工信部在《关于数据中心建设布局的指导意见》中对新建数据中心的PUE为1.5的控制值。

表4 液冷及动态自然冷却综合散热系统年运行功耗汇总表

3 结论

(1)无论是直接接触冷板式液冷还是动态自然冷却空调系统的pPUE值都非常低,两者技术的综合运用可实现高密度数据中心高效节能运行。

(2)尽管动态自然冷却空调系统的pPUE已经很低,但相对于液冷系统还有一定差距,所以在采用直接接触冷板式液冷的数据中心配置服务器时,应尽量选用冷板散热占比大的服务器,减少依靠风冷散热的负载。

(3)从最终室外散热设备而言,由于液冷系统一直在高进出水温下运行且干冷器按照极端气温选型散热面积大故液冷系统的干冷器风机年运行功耗极低,而为了尽可能减少室内机组压缩机的运行动态自然冷却空调系统的干冷器风机在系统进入完全自然冷却制冷模式前一直高速运转其年运行功耗相对较高。降低这一部分功耗可进一步提高综合系统的能效。

上述分析选取位于北京的模块化高密度数据中心进行,分析计算的数值不能代表非上述数据中心散热负载及方案的情况,具体实际项目因方案中具体选型不同会有差异。作为数据中心两种先进节能的制冷技术,直接接触冷板式液冷及动态自然冷却空调系统的综合运用有利于打造真正的绿色数据中心。

[1] 孙志刚,秦振.中兴未来电信IT设备应对5G时代巨通量计算[N].通讯产业报,2018-3-19(18).

[2] 郭涛.2018数据中心市场发展看点[N].中国计算机报,2018-3-19(016).

[3] 刘芳,王志刚.某数据中心室内空调气流组织的模拟研究[J].建筑节能,2016,44(10):11-17.

[4] 陈杰.数据机房冷通道封闭技术应用及模拟分析[J].暖通空调,2015,44(6):37-40.

[5] 龚伟力.某数据中心空调系统设计分析[J].制冷空调与电力机械,2011,32(2):45-49,71.

[6] 陈延钧.高热密度数据中心水冷解决方案[J].智能建筑与城市信息,2008,(7):23-26.

[7] 田浩,李震.数据中心分布式冷却系统研究[J].暖通空调,2015,45(9):42-48.

[8] 周海峰,邱颖霞,鞠金山,等.电子设备液冷技术研究进展[J].电子机械工程,2016,32(4):7-10,15.

[9] 郭亮,李洁,液冷.数据中心制冷变革大幕开启[N].人民邮电,2018-3-15(007).

[10] ASHRAE TC 9.9—2011, Thermal Guidelines for Liquid Cooled Data Processing Environments Whitepaper prepared by ASHRAE Technical Committee (TC) 9.9 Mission Critical Facilities, Technology Spaces, and Electronic Equipment[S].

[11] GB 50174—2017,数据中心设计规范[S].北京:中国计划出版社,2017:34.

On Integrated Application Technology of Liquid Cooling and Dynamic Free Cooling Air Conditioning System in Data Center

Xiao Xinwen

( Stulz Air and Technology Shanghai Co., Ltd, Shanghai, 201108 )

The compositions of secondary centralized pumping direct contact liquid cooling (DCLC) system and dynamic free cooling (DFC) air conditioning system are introduced, and the structure of integrated application of the two systems is put forward. Cooling proposal of a sample high heat density data center located in Beijing is provided. The annual operation power consumption of the integrated system is calculated under the assumption that the data center is full of load, and the pPUE value of the data center is only 1.09. The result shows the data center can achieve efficient operation. It is pointed out that more efficient operation can be achieved when the servers which the heat rejection percent of cold plate is larger are chosen and more energy saving dry coolers of DFC System are selected.

Data center; direct contact liquid cooling (DCLC); dynamic free cooling(DFC); integrated application technology; energy saving

1671-6612(2018)06-636-07

TU831

A

肖新文(1980.8-),男,硕士研究生,工程师,E-mail:xiaoxinwen11@126.com

2018-07-02