融合似物性前景对象与背景先验的图像显著性检测*

郭鹏飞,金 秋,刘万军

(辽宁工程技术大学软件学院,辽宁 葫芦岛 125105)

1 引言

人类视觉系统可以对不同场景基于视觉注意机制获取感兴趣区域。每幅图像中都包含一个或多个显著目标,显著性检测[1]则是模仿视觉注意机制获取图像中重要信息,以提高图像处理的效率与准确性。图像显著性检测在图像标注与检索[2]、目标识别[3]、图像自动剪裁[4]、图像压缩等领域均有广泛的应用,是计算机视觉研究的热点之一。

从视觉注意机制出发,显著性检测可分为自底向上的检测模型和自顶向下的检测模型[5]。自底向上模型主要是由颜色、纹理、边缘等底层特征数据驱动的显著检测过程。自顶向下模型不仅涵盖了自底向上模型的处理过程,还需要基于目标驱动来调整选择准则,过程更为复杂,因此基于数据驱动的自底向上模型应用较为广泛。随着显著性研究的发展,显著检测模型从处理单元的选择上可分为基于像素点的显著性检测模型和基于对象的显著性检测模型。早期的显著性检测模型多为基于像素点的显著检测。如Itti等人[6]提出一种基于生物学启发的视觉注意机制模型,使用中心-周边算子,在高斯金字塔结构中计算各尺度的底层特征并实现跨尺度对比计算显著性。Ma等人[7]使用局部对比度差值计算显著图,并利用模糊增长的方式确定显著区域。Zhai等人[8]提出使用全局对比度改善局部对比度存在的显著区域不连续情况,利用特征直方图对像素点进行分类,再使用距离公式计算显著性。

基于像素点的显著性检测方法往往缺少结构化信息,导致区域稠密性不够。因此,研究者从像素点的显著性检测模型出发,提出以区域块为处理单元的检测方法。Achanta等人[9]提出算法结合多尺度空间思想,在不同大小的像素块下,以像素块均值作为特征值计算局部对比度。Cheng 等人[10]提出的算法采用Grab-cut方法分割图像,并结合空间关系以区域为单位计算全局对比度。Liu等人[11]学习条件随机场模型,利用模型将局部、区域和全局三个层面获取的特征映射图进行融合得到显著图。Yan等人[12]提出在不同大小的分割图像块上,构建树形结构,利用多尺度分析方法得到显著图,减少高纹理区的干扰。Jiang 等人[13]基于统计学习思想,先利用图论对图像过分割处理,并在分割区域上进行多特征描述,再采用随机森林方法学习特征映射,最后在多层次上融合显著特性。Li等人[14]提出的基于密集和稀疏重构的算法,基于边界处的超像素构建背景模板,结合稀疏表示与主成分分析法,由重构误差获取显著值。钱生等人[15]受Li的启发,由背景模板进行稀疏重构获取边界信息,并与其它特征信息在条件随机场框架下融合获取粗糙显著图,然后利用Grab-cut实现显著区域精确检测。

以上显著性检测模型在显著特征的提取上,其处理单元或为像素点,或为过分割形成的区域块。这些点和区域块单独存在时并没有对象性的意义,缺少完整的对象性信息,在复杂背景下易受背景噪声干扰,无法均匀覆盖整个显著区域。尤其是当图像中存在多个显著目标时,往往不能将多个对象独立区分出来。

另一种显著性检测方法为基于对象性的显著性检测方法,即似物性检测。这一类方法通常利用窗口,结合不同显著特征的选择,实现显著性检测。Lu等人[16]为每一个超像素基于其轮廓生成凹弧,为每个凹弧外接矩形,形成凹面上下文窗口,统计窗口包含显著对象的概率。Alexe等人[17]以窗口为处理单元,将中心窗口与周围窗口的局部对比度、超像素跨度、边缘密度等特征利用贝叶斯框架融合,得到每个窗口的显著概率。

对象性检测方法的目标是利用矩形框找到图像中最有可能包含完整对象的区域并给出这个窗口包含对象的概率,即目标得分。这种方式保证了目标对象的完整性,但对于显著性检测来说,仍存在两个问题。其一,若窗口检测不够精确,包含过多背景元素会影响准确度;其二,仅仅得到对象窗口无法找到目标对象的准确轮廓。

针对两种方式各自的优缺点,本文综合利用对象性和显著性,提出一种结合似物性与显著特征的显著性检测算法OFOBP(Objectness Foreground Object and Background Prior)。该算法并不是直接利用似物性检测得到的窗口产生显著对象,而是将窗口信息作为一种对象性描述,融入到前景显著特征的计算中,描述前景对象,并结合背景先验特性得到最终显著对象。

2 OFOBP显著性检测算法

本文算法主要包括三个部分,分别为融合似物性与显著性的前景对象获取、基于背景先验知识的显著计算以及显著特征融合。OFOBP算法流程图如图1所示,首先从目标对象角度,利用似物性检测算法获取目标对象窗口,并结合超像素颜色空间分布特征,重新寻找窗口边界,优化窗口;再利用窗口特征与超像素特征的对比结果,重新计算超像素特征,完成图像的前景对象预测;同时,从背景角度,利用改进后的背景模板,计算超像素的稀疏重构误差,得到背景先验显著值;最后融合两种显著图,得到最终的显著检测结果。

Figure 1 Flow diagram of the OFOBP algorithm图1 OFOBP算法流程图

2.1 融合似物性和显著性的前景对象

这一部分包括三个计算模块,分别为超像素颜色空间分布特征计算、似物性窗口优化以及前景对象获取。

(1)超像素颜色空间分布。

一种颜色存在的范围越广,那么这种颜色属于显著区域的可能性越小。根据这一思想,Liu等人[18]提出一种基于中心加权的颜色空间分布模型,该模型能够有效描述一幅图像的显著特征,但其处理方式是基于单个像素点,缺少结构化信息,处理速度也慢。

为了保留颜色特征的同时引入结构信息,本文首先利用SLIC(Simple Linear Iterative Clustering)[19]对原图像进行超像素分割,得到M个超像素。引入高斯混合模型计算每个像素点对应于第c种颜色成分的概率p(c|Ix)[18],超像素si对应于第c种颜色的概率函数表示为:

(1)

超像素的颜色空间分布表示为:

(2)

(2)目标候选窗口的优化。

似物性检测产生的目标窗口数量和质量对算法的效率都有直接影响。传统的似物性评估的位置数量过多(1 000~10 000不等)且位置生成时间太长。为了解决这个问题,Cheng等人[20]提出了一种二进制梯度归一化BING(BInarized Normed Gradients)的似物性检测方法,引入一个64维的梯度幅值特征,以先验阈值进行二值化处理。再利用二进制的样本图像训练二级级联的支持向量机,得到按照目标得分从高到低排序的目标窗口。BING仅产生1 000~2 000个目标窗口,实现了搜索空间的缩小,从而提高了检测效率。

(3)

(4)

(3)前景对象的获取。

计算窗口的显著均值Uj,作为窗口特征。

(5)

其中,c(x,y)为窗口内像素点的颜色空间分布特征值,等于其所属的超像素颜色空间分布特征值。m′×n′为优化后窗口中像素个数。将超像素的显著值与所有窗口的特征均值进行对比,如果大于某个窗口均值,则表示超像素相对于当前窗口属于前景区域。将原窗口的目标得分赋予对应的新窗口,对多窗口得分叠加处理,超像素属于目标对象的概率越高,则得到的窗口目标得分越多,表示其显著值越高,由此更新超像素显著特征,实现前景对象的获取。超像素的前景对象特性定义为:

*fS(si,I)

(6)

其中,fS(si,I)由公式(2)计算,表示超像素的颜色空间分布特征,goalj为第j个窗口的目标得分。融合似物性和显著性特征的前景对象提取方法既考虑到了似物性检测获取目标对象的完整性,又考虑到了显著特性对区域的有效描述。

2.2 背景先验

前景对象模型主要考虑的是区域作为显著对象的概率,但实际上图片中的背景部分同样能为显著性检测提供有效信息。稀疏重构误差利用超像素与图像边界特征的差异性来表示超像素的显著性,差异越大,超像素为显著区域的概率越高。将这种差异性作为背景先验结果可以有效地描述显著区域。

这一部分包含两个计算模块,分别为背景模板的建立与预处理以及稀疏重构误差的计算。

(1)背景模板的建立与预处理。

1.2.3 出血护理患者每次进餐前要进行漱口,以1次/2h为宜,护理人员要指导患者进行冲击性漱口,使患者黏膜皱劈部位能够和漱口液充分接触。护理人员建议患者使用软毛牙刷不要用使用牙签剔牙,以免受到外力撞击对皮肤粘膜进行保护,一旦牙龈口腔出血,可以使用棉棒蘸生理盐水进行擦拭,口腔局部涂抹止血药。鼻出血可以给予填塞法或是局部冷敷法。拔针后注射部位加压数分钟,一旦出现渗漏现象或是局部红肿应当立即用50%的硫酸镁对局部湿敷,或是在血管的上方外敷新鲜马铃薯片,可以使局部的肿痛现象减轻[3]。

超像素的特征sfi描述为其所含像素的平均LAB和RGB颜色特征以及位置信息,即sfi={l,a,b,r,g,b,x,y},其中,l,a,b为LAB颜色空间的颜色分量,r,g,b为RGB颜色空间的颜色分量,x,y为超像素位置。提取图像边界处超像素的D维特征(D=8)组建图像的背景模板,记作BG={Bg1,…,Bgi,…,BgL},L表示背景模板中的超像素个数。

对多个公开图像集中的图像进行研究分析,发现图像的边界在不同方位上有不同程度的相似性。为了使背景模板中的超像素更具代表性,本文对模板中的超像素进行一次预处理。

(2)稀疏重构误差。

以BG′的特征矩阵作为稀疏字典,利用超像素si与BG′之间的差异性,计算稀疏重构误差。误差计算公式为:

(7)

其中,sfi为超像素si的特征描述;αi为稀疏系数,表示为:

(8)

其中,λ为拟合约束参数。由稀疏重构误差得到超像素的背景先验特性Fb(i)=εi。

2.3 显著融合

本文提出的似物性前景对象图与背景先验显著图存在互补关系,将二者加权融合得到最终的显著检测结果。

Ffinal(i)=β1*Fp(i)+β2*Fb(i)

(9)

其中,β1和β2为加权系数,控制两种显著图的重要程度。

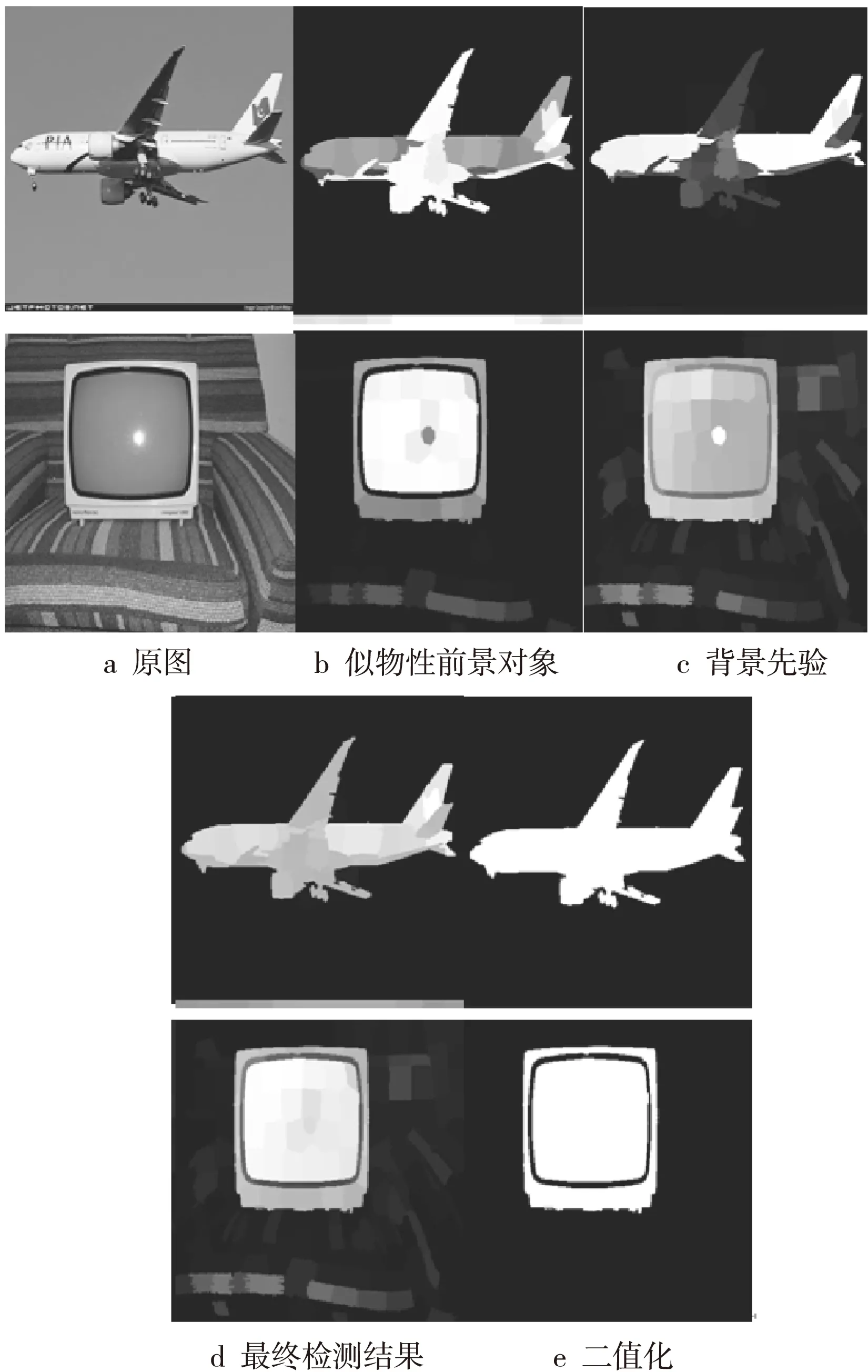

图2为OFOBP算法各部分的检测结果。图2a是原图,图2b和图2c分别是似物性前景对象图和背景先验显著图,图2d是融合后的显著检测结果,图2e是二值化处理后的显著图。背景先验有效抑制了背景干扰,但是对显著对象的提取不够完整;似物性前景对象的获取将对象信息融入到前景显著特征中,有效凸显了显著对象。二者的融合突出了各自优势,显著检测效果更好。

Figure 2 Test results of each part of the OFOBP algorithm图2 OFOBP算法各部分检测结果

3 实验结果与分析

3.1 实验数据集说明

为了验证本文算法的有效性,分别从MSRA10k和VOC2007公开数据集上选取图片进行实验。在MSRA10k数据集中选取500张图片作为实验测试图片并配有相应的地值图。VOC2007数据集中包含的图片更符合人类视觉对目标对象的观测需求。对VOC2007数据集中提供的目标对象类分割图进行二值处理,得到实验所需的地值图。由于BING训练时使用的图片为VOC2007中的2 501幅图片,因此在实验时从训练之外的图片中选取1 500张,与MSRA10k中选取的500张共同组成实验数据集,以供算法测试使用。

3.2 评价指标的选定与算法参数的设定

本文采用准确率、召回率、F-measure和MAE(Mean Absolute Error)四个评价指标来衡量算法检测效果。准确率和召回率之间存在相互影响,因此常常用F-measure指标衡量算法的整体性能。F-measure的计算公式为:

(10)

其中,Precision为准确率;Recall为召回率;α为准确率的权重参数,该权重参数体现出准确率在公式中的重要程度,α2取值为0.3。

MAE表示平均绝对误差,反映显著预测值与真实值之间的误差情况,计算公式如下:

(11)

超像素分割的个数越多,过分割情况会越严重,越少则无法找到图像全部边界,本文将超像素分割个数设置为M=200。θ为自适应阈值的控制参数,取值为0~1。θ越大,阈值越大,最终的窗口就会越小。本文通过反复实验将控制参数设置为θ=0.2,以获取最优窗口。β1和β2为前景对象与背景先验融合的加权系数,系数越大,相应显著特征在融合中的比重越大。本文将加权系数设置为β1=β2=0.5,表明两显著特征在融合时的比重相同。

3.3 像素级别和超像素级别的颜色空间分布特征对比

图3为两种处理单元上的颜色空间分布对比结果。图3a为原图,图3c为SLIC超像素分割结果。由图3可以看出,文献[18]中像素级别的颜色空间分布图缺少区域结构信息,导致区域稠密性不够,如图3b所示;本文采用的基于超像素的颜色空间分布,将超像素具有的高边界贴合度融合到颜色特征分布中,使得颜色空间分布更具结构化特点,区域内部稠密性更高,如图3d所示。

Figure 3 Comparison of color spatial distribution between pixel level and superpixel level图3 像素级别与超像素级别颜色空间分布对比

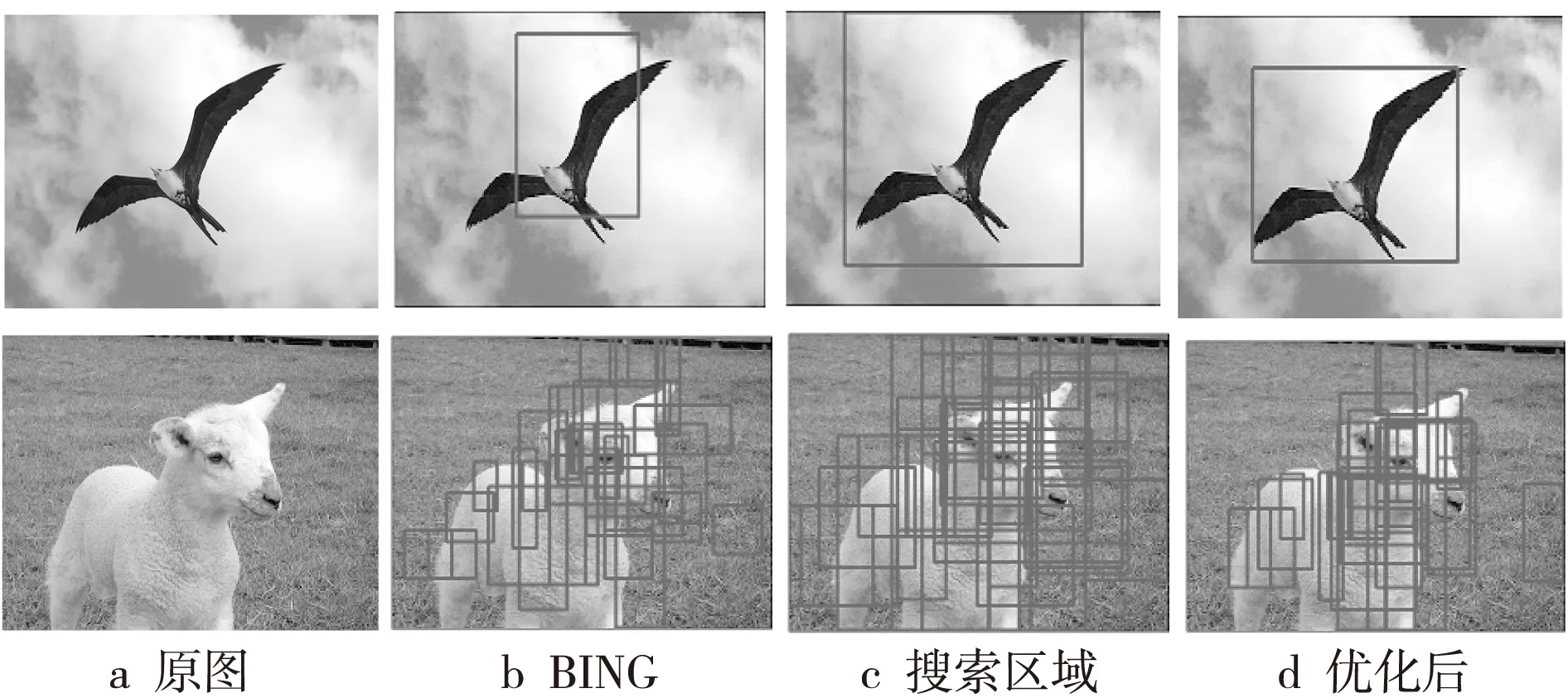

3.4 原BING目标窗口与优化后的目标窗口对比

图4为目标窗口的优化过程,展示了目标窗口优化前后的对比结果。图4中第1行为选取的BING中一个窗口的优化流程示例,第2行为选取的BING中10%~20%的有效窗口同步优化的流程示例。图4a为原图,图4c为搜索区域,图4b和图4d分别为BING目标窗口和优化后的目标窗口。由图4可以看出,图4d中的窗口共同锁定的目标对象更准确,减少了背景干扰。

Figure 4 Process of window optimization图4 窗口优化流程

3.5 似物性前景对象与视觉显著特征对比

图5展示了本文提出的似物性前景对象预测方法与仅采用颜色空间分布这一视觉显著特征的显著图对比结果。图5a为原图,超像素颜色空间分布特征如图5b所示,似物性前景对象如图5c所示。

Figure 5 Comparison between objectness foreground object and salient feature 图5 似物性前景对象与显著特征对比

由图5可以看出,图5c中采用似物性特征与显著特征的融合得到的显著对象比图5b中的显著对象更加完整,能够均匀地突出显著区域,增强了显著区域与背景区域的对比度。同时多窗口特征的加入实现了多个目标对象的有效检测。

3.6 本文算法与其它算法对比实验

为了验证本文算法的有效性,在两个数据集上与11种算法进行对比,11种算法分别为SR[24]、SUN[25]、FT[26]、SEG[27]、RC[10]、SWD[28]、CA[29]、COV[30]、GR[31]、DSR[14]和RBD[32]算法。SR是剩余谱算法,从图像的幅度谱中除去代表先验知识的幅度谱即可得到显著部分的幅度谱。SUN是一种自底向上的显著检测方法,利用了自然统计的显著性贝叶斯检测框架。FT算法利用颜色特征的中央-周边算子计算显著图。SEG算法以窗口为单位,计算每个像素点属于窗口中心和窗口边界的概率,从而得到像素点的显著性。RC是一种基于全局对比度的显著检测算法。SWD是基于空间加权向异性的,在降维空间计算区域的差异性。CA是一种基于上下文感知的显著检测算法。COV算法是以区域协方差计算显著性的。GR算法同时考虑图正则化理论、对比度及中心先验知识计算显著特征。DSR算法同时计算重构误差和稀疏重构误差,并结合贝叶斯计算显著图。RBD是一种以背景作为参考的显著性检测算法。

Figure 6 Comparison of saliency maps图6 显著图对比

图6为OFOBP算法与其中近5年较流行的7种算法在视觉上的显著图对比。SWD与OFOBP都与窗口有关,前者是将窗口作为处理单元,计算像素点的显著性,而OFOBP则是将目标窗口作为对象信息,与显著特征融合。SWD仅采用滑动窗口作为处理模块,并未考虑窗口本身具有对象性,而OFOBP充分利用了这一点。DSR与OFOBP均使用了重构误差,由于DSR同时使用了两种重构方式,其背景抑制效果更好,但OFOBP引入了窗口对象信息,在对象完整性上更为优越。从图6整体来看,前4行选取的是VOC2007数据集上的实验结果,后4行选取的是MSRA10k数据集上的实验结果。从实验对比结果可以看出,OFOBP可以较为完整地检测到图像的显著对象,背景抑制的效果更好。同时,VOC2007数据集中的图片存在多个显著对象,从图6中的第3行和第4行图片可以看出,图片中均存在两个显著对象,多数方法并未检测出第二显著特征,而OFOBP成功地将两个特征检测出来了,而且区分了每一个目标,表明多窗口对象信息与显著特征的融合有效提高了显著性检测的准确性。

图7是OFOBP算法与11种算法在MSRA10k数据集上的评价指标结果。

Figure 7 Evaluation results on MSRA10k data set图7 MSRA10k 数据集上评价结果

从图7的P-R曲线以及平均准确率、平均召回率和F-measure结果可以看出,OFOBP在三个评价指标上优于大部分其它算法。OFOBP与DSR和RBD在准确率上水平相当,但Recall和F-measure更高,其中Recall达到81.7%,F-measure达到87.1%。召回率代表了待测图像的查全率情况,召回率的提高说明OFOBP算法能够较好地保留显著区域的完整性。F-measure的提高表明算法整体性能优良。从P-R曲线图来看,OFOBP算法的曲线更加平滑,三个性能指标均较高。

为了进一步验证OFOBP算法的有效性,实验选择了更具挑战性的数据集VOC2007。图8为OFOBP与11种算法在VOC2007数据集上的评价指标结果。从实验结果来看,OFOBP算法在准确率上优于其它算法,达到88.1%。同时,在Recall和F-measure值上有明显的优势,其中Recall达到83.6%,F-measure达到87%。VOC2007数据集包含的图片多数具有两个或两个以上的显著对象,召回率的提高表明OFOBP采用的多窗口融合方式在多个对象检测上有较好的效果。

Figure 8 Evaluation results on VOC2007 data set图8 VOC2007 数据集上评价结果

表1为OFOBP算法与对比的11种算法在平均绝对误差(MAE)这一评价指标上的结果。从表1可以看出,本文的误差值低于其它10种算法,只略高于DSR算法的误差值。说明OFOBP具有一定的有效性。

表2为OFOBP算法与其它11种算法在两个数据集上的运行时间对比结果。从运行时间上来看,较早时间的显著性检测算法,如SR、FT,其运行时间短,但如果结合P-R曲线和MAE评价指标来看,可以看出这些算法的性能指标较低;RC算法采用的编码方式是C++,因此其运行时间与其它算法不太有可比性;OFOBP与近几年较为流行且效果较好的CA、COV、GR、DSR、RBD相比,OFOBP的运行时间介于它们之间,如果结合其它评价指标和直观的对比图来看,OFOBP在显著性检测方面具有一定优势。

Table 1 Mean absolute error MAE表1 平均绝对误差MAE

Table 2 Comparison of running time表2 运行时间对比 s

4 结束语

基于像素点或区域块的显著检测方法往往仅计算点或块的显著特征,而忽略了显著区域的对象性。本文提出一种同时结合似物性与显著特征的显著性检测算法OFOBP。该算法利用似物性检测获取对象性信息,设计一种前景对象获取方式,将其融合到显著特征中,优化前景显著特征;同时与背景先验特征融合,实现显著性检测。与传统基于显著性特征的算法相比,该算法不仅保留了显著特征对目标对象的有效描述,同时还融入了似物性特征,解决了对象完整性问题。分别在MSRA10k数据集和VOC2007数据集上进行评估,由实验结果可知,OFOBP算法在各项检测指标上均取得了良好的效果,算法有一定的有效性。

此外,OFOBP算法虽然在显著性检测上取得了一定的效果,但是仍然存在问题。比如对于颜色分布过于均匀、前景与背景噪声均过大的图片,算法的检测效果有所下降,有待进一步提高。